基于Swin Transformer和Style-based Generator的盲人脸修复

2023-04-29向泽林楼旭东李旭伟

向泽林 楼旭东 李旭伟

盲人脸修复任务是从低质量的图像(例如模糊、噪声和压缩图像)中恢复高质量的图像.由于事先不知道低质量图像的退化类型和退化参数,因此盲人脸修复是一个高度病态的问题,在修复过程中严重依赖各种先验指导.然而,由于面部成分和面部标志等面部先验通常是从低质量图像中提取或估计的,可能存在不准确的情况,这直接影响最终的修复性能,因此难以有效利用这些先验知识.此外,目前的主流方法基本都是依赖ConvNets进行特征提取,没有很好地考虑长距离特征,导致最终结果缺乏连续一致性.本文提出了一种改进的StyleGAN模型,命名为SwinStyleGAN,应用在高级视觉任务上表现出色的Swin Transformer来提取长距离特征,并通过改进后的类StyleGAN合成网络逐步生成图像.本文设计了一个空间注意力转换模块SAT来重新分配每个阶段特征的像素权重,以进一步约束生成器.大量实验表明,本文提出的方法具有更好的盲人脸修复性能.

盲人脸修复; ConvNets; Swin Transformer; StyleGAN; 空间注意力转换模块

TP391A2023.032003

收稿日期: 2023-02-16

基金项目: 国家重点研发项目(2020YFC0832404)

作者简介: 向泽林(1975-), 男, 四川资阳安岳人, 讲师, 主要研究领域为图像处理、故障诊断.E-mail: xiangzelin@cisisu.edu.cn

通讯作者: 李旭伟.E-mail: lixuwei@scu.edu.cn

Blind face restoration based on Swin Transformer and Style-Based Generator

XIANG Ze-Lin1, LOU Xu-Dong2, LI Xu-Wei2

(1.Chengdu Institute Sichuan International Studies University, Dujiangyan 611844, China;

2.College of Computer Science, Sichuan University, Chengdu 610065, China)

Blind face restoration is the process of restoring a high-quality image from a low-quality image (e.g., blurred, noisy, or compressed image). Since the degradation type and degradation parameters of the low-quality image are unknown, blind face restoration is a highly ill-posed problem that heavily relies on various facial prior such as facial components and facial landmarks during the restoration process. However, these facial priors are typically extracted or estimated from low-quality images, which may be inaccurate, directly affecting the final restoration performance. The current mainstream methods mostly use ConNets for feature extraction and do not consider long-distance features, resulting in a lack of continuous consistency in the final results.The authors propose an improved StyleGAN model named SwinStyleGAN, which uses Swin Transformer to extract long-distance features and gradually generates images through an improved StyleGAN synthesis network.Addtionally, the authors design a Spatial Attention Transformation (SAT) module to reassign pixel weights of each stage feature to further constrain the generator. Experiments show that the proposed SwinStyleGAN in this paper has better blind face restoration performance.

Blind face restoration; ConvNets; Swin Transformer; StyleGAN; Spatial attention transformation

1 引 言图像修复是计算机视觉中一项至关重要且具有挑战性的任务,其主要目的是从低质量退化图像重建高质量清晰图像,如图像修复[1,2]、图像去模糊[3,4]、图像重构[5,6]、图像去噪和图像超分辨率(SR)[7,8]等任务.

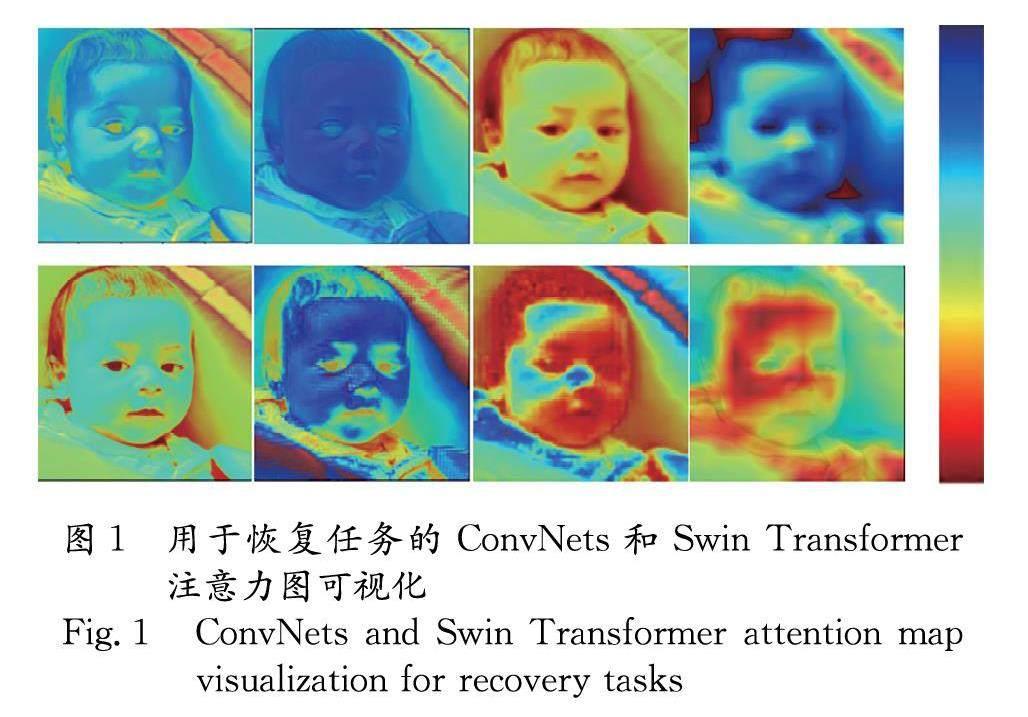

现有的图像修复方法大多是基于卷积神经网(ConvNets)[9-13]设计的.由于卷积的设计是局部连接的,在处理图像信息时该方法无法捕捉到图像的远距离依赖信息,有研究表明其实际感受也远小于理论感受,不利于充分利用上下文信息进行特征捕获.虽然可以不断堆叠更深的卷积层,但会导致模型过于臃肿和计算量过大.我们随机选择了几层特征并将他们可视化,如图1所示.图1中,第一行是ConvNets;第二行是Swin Transformer.注意力热图从左至右分别来自第1、2、4、6层编码器.显然,Transformer的attention范围要比Convolution大很多.也有不少研究[5,14,15]在面部修复中利用了面部的先验知识,并验证了这些先验面部特征对于恢复精确面部细节的重要性.

然而,这些先验知识是从低质量图像中提取的,其准确性受到原始输入图像质量的限制.为解决卷积网络无法捕捉到图像的远距离依赖信息这一问题,本文有效地引入了Transformer[16-21]来替代常用的用于特征提取的卷积网络.Transformer依靠自注意力机制来捕获上下文之间的全局交互,并在计算机视觉上显示出较好的性能.对于无法充分利用面部先验知识等问题,我们使用改进的StyleGAN[22,23]来生成具有先验信息的逼真图像.改进后的类StyleGAN生成器并没有经过预训练,但实验表明这并不影响最终结果的有效性.

本文提出一种SwinStyleGAN的盲人脸修复模型,可被视为一种编码器-解码器结构.其主要由三部分组成,Swin Transformer特征提取模块、改进后的类StyleGAN[22,23]生成模块、判别器模块.与卷积和ViT[21]相比,Swin Transformer[20]具有更强大的全局特征提取能力、参数和计算量大幅度减少等优点.大量研究[17,18,20,21]表明,无论是在图像分类还是其他下游任务中,全局特征都优于局部特征,文中实验也证实了这一点.本文将Swin Transformer[20]的结构引入到StyleGAN中以提高其稳定性.在StyleGAN生成过程的每一步,都会将其输出为RGB图像,并通过金字塔重构损失来进一步规范生成过程,使修复的图像效果更加逼真.此外,空间注意力转换(Spatial Attention Transformatio, SAT)模块可以进一步约束StyleGAN.最后,我们设计了一个鉴别器来区分真实图像和生成图像,进一步增强了生成模型的能力.

本文工作的主要贡献有:(1) 引入Swin Transformer作为特征提取模块,以提取图像的全局特征,从而有效地提高图像语义描述的性能;(2) 从Transformer中抽象出一个双阶段的跳过连接的一种通用架构,用来改进StyleGAN的基于样式的生成器模块,以增强StyleGAN的生成能力,并使训练过程更加稳定; (3) 与一般图像恢复任务设计的重建损失不同,在生成过程中为每个分辨率设计了一个重建损失,称为金字塔重构损失.

2 相关工作

图像修复主要包括超分辨率[7,8]、图像修复[1,2]、重构[5,6]和去模糊[3,4].盲人脸修复最常用的模型是基于ConvNets的.事实上,ConvNets在图像特征提取方面的效果是相当有效和显著的.Yang等人[26]提出了可以逐渐填充面部细节的HiFaceGAN.Li等人[27]介绍了GRFNet,可以学习用于盲人脸修复的扭曲指导.Chen等人[5] 提出了PSFRGAN,使用渐进式语义感知样式转换和类似于StyleGAN[22,23]的渐进式生成方法来修复盲人脸.Wang等人[6,25]提出了退化去除模块和预训练的人脸生成器,用于盲人脸修复.然而,基于CNN的方法主要关注小的判别区域,难以关注图像的整体信息.此外,CNN中的下采样操作(如池化和步幅卷积)会降低输出特征图的空间分辨率,导致CNN提取的特征缺失了一些信息.幸运的是,最近兴起的Transformer[16,20,21]可以弥补CNN的这些不足.Liang等人[24]提出了基于Swin Transformer[20]的图像恢复任务SwinIR,并取得了非常好的结果.本文也使用Swin Transformer进行特征提取,也取得了不错的效果

3 实现方法

针对基于卷积网络无法捕捉到图像的远距离依赖信息和无法充分利用面部先验知识这两个问题,本文提出了SwinStyleGAN模型.接下来将对SwinStyleGAN模型的网络结构和构成进行详细描述.

3.1 SwinStyleGAN模型

SwinStyleGAN模型的网络结构如图2所示.输入损坏的低分辨率图像,经过该模型处理后,可以输出清晰的修复图像,并尽可能接近基准(Ground Truth)图像的像素.SwinStyleGAN模型包含三个模块:(1) Transformer特征提取模块,由多个Swin Transformer块组成;(2) 基于StyleGAN[22-23]改进的人脸重建模块;(3) 判别器模块.这三个模块之间按顺序连接,此外,我们还增加了一个空间注意力转换(Spatial Attention Transformation, SAT)模块,其工作方式类似于U-Net[28],目的是将编码器的特征引入到解码器中,用以提升结果的保真度.

3.2 基于Transformer的特征提取模块

编码器-解码器的对称结构在多个图像处理任务中展示了其强大的功能.本文设计了一个类似U-Net的网络结构,并使用Swin Transformer进行特征提取.在encoder的每一阶段,经过两个连续的Swin Transformer Block和patch merging层后,token的数量会减少,特征维度的数量会增加.特征提取方法定义如下式.

Fswin,Flatent=SwinILQ (1)

其中,Swin·是基于Swin Transformer的特征提取模块;ILQ是SwinStyleGAN的低质量输入;Fswin,Flatent是从该模块中提取的特征,Flatent是类StyleGAN生成器在归一化和映射网络之后的样式输入,并且Swin特征Fswin用于在空间注意力转换模块之后调制StyleGAN特征.

3.3 空间注意力转换模块

大量研究表明,网络的浅层特征对于各种计算机视觉任务非常重要.本文保留了Swin Transformer提取的多阶段特征,作为类StyleGAN生成器的输入之一来控制生成.考虑到特征在不同阶段和不同像素点的重要性是不同的,本文设计的空间注意力转换模块,可以使模型在训练过程中,自动判断特征的重要性.如图2所示,SAT是一个倒置的瓶颈结构,其隐藏层的维度比输入维度宽4倍,虽然该结构与MobileNetV2[29]类似,但本文进行了多项改进.首先,在激活函数的选择上,使用GELU[30]代替ConvNets中常用的ReLU[31].受限于显存,本文实验的batch size较小,而batch size的大小对BatchNorm的效果有较大的影响.当batch size较小时,Batch Norm的效果可能会受到噪声数据的影响,导致性能下降.Transformer中常用的LayerNorm(LN)[32]更简单,从而能在不同的应用场景下获得更好的性能.在实验中,由于batch size比较小,所以选择使用LN而不是BN.空间注意力转换模块的具体操作定义如下式.

B=SATFswin(2)

3.4 改进的StyleGAN类生成器模块

StyleGAN的生成能力极其强大,几乎可以生成人眼无法分辨真假的图像.一般来说,StyleGAN会从当前分辨率开始稳定地训练,然后逐渐过渡到下一个更高分辨率的阶段.在初始阶段,网络主要专注于低分辨率图像,在训练过程中逐渐将注意力转移到更高分辨率的图像上.

在使用原始StyleGAN结构进行训练时,我们发现网络非常不稳定,恢复结果中的一些细节与原始图像相差甚远.文献[33,34]的研究表明,Transformer的强大之处不仅在于Self-attention机制的使用,还在于其结构框架(双层残差连接)的设计.因此,我们将Transformer的结构与StyleGAN的合成网络相结合,尝试使用残差连接来改善训练不稳定的问题,并使用相同的风格特征多次调制该分辨率下的生成特征.虽然高斯随机噪声可以丰富生成图像的多样性,但该特征也会给图像复原带来一定程度的误差,因此我们使用SAT模块处理后的特征来代替高斯随机噪声,以降低其随机性,具体结构如图3所示.模块的整体生成过程如下式所示.

Iout=StyleGANMLPFlatent,B(3)

其中,StyleGAN·是生成模块,主要由一系列上采样和调制卷积组成,其输入为SAT模块处理的特征B和由多层感知器MLP·生成的样式特征;Iout为修复后的图像.

3.5 损失函数设计

除了最基本的重构损失和GAN中引入的对抗损失外,我们还引入了感知损失和风格损失.整体模型损失函数定义如下.

Ltotal=λpyrLpyr+λadvLadv+λperLper+λstyleLstyle(4)

损失函数的超参数设置如下:λper=3.0,λadv=0.1,λper=1.0,λstyle=50.0.式(4)中包括了金字塔重构损失、对抗损失和风格损失等4种损失.

(1) 金字塔重构损失.为了使图像在每个生成阶段都接近所需的GT,我们将GT重塑为从8×8到512×512的多个分辨率大小,并将每个阶段的特征卷积为三通道的RGB图像,然后分别与相应分辨率大小的GT图像计算重建损失.称其为金字塔重构损失,采用L1计算,公式如下.

Lpyr=∑y︿i-yi1(5)

其中,y︿i和yi分别表示在第i阶段通过特征卷积得到的RGB图像和对应分辨率大小的GT图像.本文共设计了7层金字塔.

(2) 对抗损失.GAN[29]的对抗损失Ladv可以指导生成器生成更加自然的图像,同时产生更加逼真的纹理,生成器定义如下式.

Ladv=Euclid Math TwoEA@y︿~Euclid Math TwoPA@gDy︿-Euclid Math TwoEA@y~Euclid Math TwoPA@rD(y)(6)

其中,D(·)表示鉴别器; y︿和y分别表示输出图像和真实图像.

(3) 感知损失.为了捕获更多上下文特征信息,引入了感知损失,用于度量特征空间中的距离.为了获得特征图,我们使用19层的预训练VGG[35]网络,并使用卷积后的前五个特征图.感知损失定义如下.

Lper=φy︿-φy1(7)

其中,φ·是19层的预训练VGG网络,y︿和y分别代表输出图像和真实图像.

(4) 风格损失.Liu等人进一步提出了风格损失,类似于感知损失,使用Gram矩阵计算特征之间的相关性,可以有效地捕获纹理信息.我们分别从输出图像和真实图像中提取特征并计算特征相关性.计算公式如下.

Lstyle=Grimφy︿-Grimφy1(8)

其中,Grim·用于Gram矩阵特征提取.

4 实验与结果

4.1 数据集和实现细节

SwinStyleGAN的训练集为FFHQ数据集[36],该数据集包含70 000张分辨率为1024×1024的HQ人脸图像.我们将所有图像的分辨率大小调整为512×512.为了构建LQ-HQ图像对来训练我们的模型,使用以下退化模型从FFHQ中的HQ图像合成退化人脸,合成方式如下.

ILQ=IHQk↓s+nδJPEG↑s (9)

上述过程已经在多篇论文[5,27,37,38]中使用过.其中,IHQ是高质量图像,它与模糊内核k卷积,然后进行下采样操作(比例因子为s).向图像添加高斯噪声nδ,再进行质量因子为q的JPEG压缩操作.最后,将压缩图像调整为原始大小.对于每个HR图像,我们分别从{1∶8}{0∶15}{6∶100}中随机抽样s,δ和q.

在整个训练期间,我们设置的Batch Size为4,采用Adam作为模型的优化器[39],共进行1 M次迭代,学习率设置为2e-5.使用PyTorch框架和单个RTX 3090 NVIDIA GPU训练我们提出的SwinStyleGAN.

4.2 方法比较和评估指标

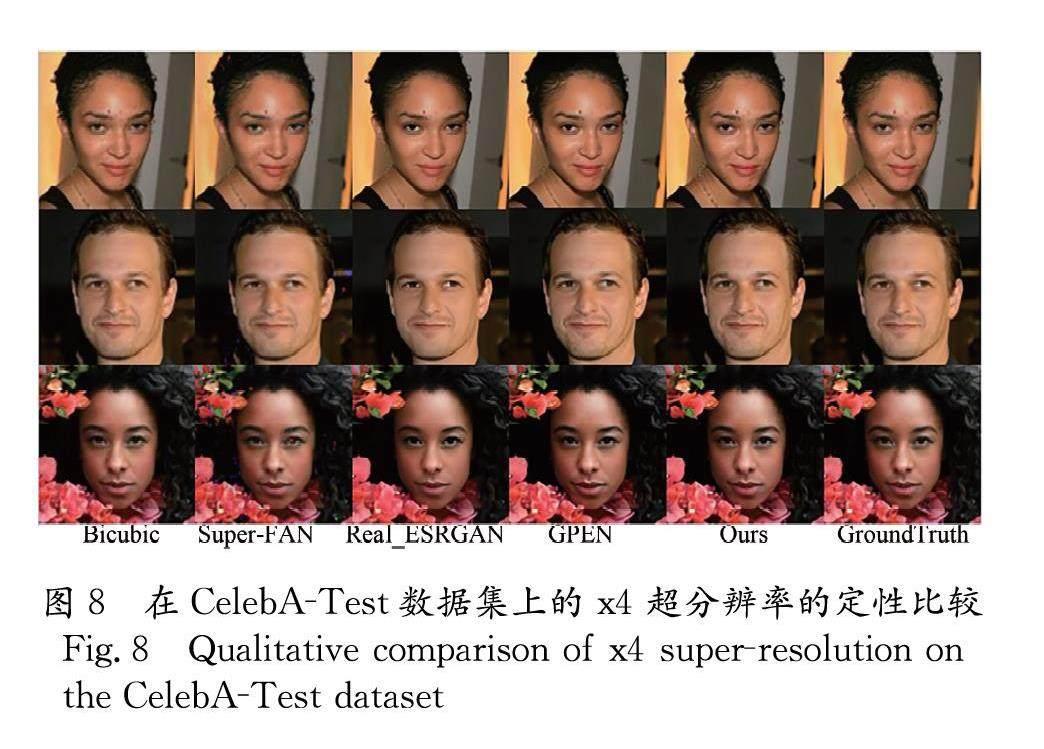

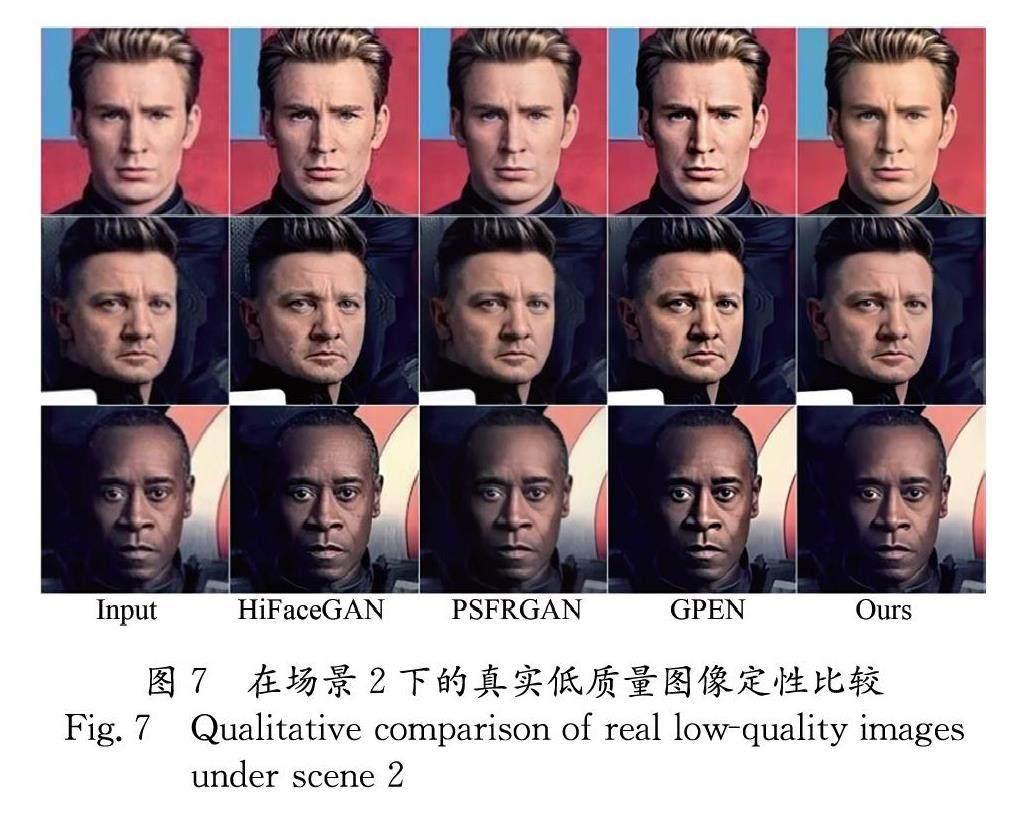

我们将SwinStyleGAN方法与几种较先进的盲人脸修复方法进行了比较,分别是DeblurGANv2[3]、HiFaceGAN[26]、PSFRGAN[5]、PULSE[40]和GPEN[25].同时,我们还将SwinStyleGAN方法与其它图像超分辨率方法Bicubic、Super-FAN[41]、Real-ESRGAN[8]和GPEN[25]进行了比较.我们对CelebA-Test和VGGFace-Test进行与训练集相同的退化处理.在基于真实情况的评估方面,采用了广泛使用的像素级指标:PSNR和SSIM,这两个指标都是基于对应像素点之间的误差,没有考虑到人眼的视觉特性.因此,评价结果往往与人的主观感受不一致.相比之下,基于学习的感知相似性度量更符合人类感知.因此,我们还采用了感知度量评价指标LPIPS[42]和FID[43].

4.3 合成图像与真实图像的比较

除了对两个合成数据集和两个真实的低质量数据集进行盲人脸修复比较之外,还在CelebA-Test数据集上进行了x4超分辨率比较,其对比结果验证了SwinStyleGAN的有效性.定性结果如图4 ~图8所示,从展示的复原结果来看,除了一些细节外,SwinStyleGAN的修复效果是令人满意的,能够生成更接近人眼主观感受的修复图像.虽然PULSE[40]方法具有较好的图像修复效果,且符合人眼的主观感知.但很明显,其生成的图像与输入图像之间存在巨大差异,即保真度低下,并丢失了一些原始特征.

每种方法的定量结果如表1~表3所示,表3中,粗体表示最佳性能.SwinStyleGAN实现了最低的LPIPS[42],表明本文提出的SwinStyleGAN模型在感知上更接近真实情况.此外,SwinStyleGAN在FID[43]上也取得了更好的结果,表明其输出结果与真实人脸分布的距离更加接近.

4.4 消融实验

为了更好地理解SwinStyleGAN各个模块的作用,我们做了几组对比实验.实验结果如表4所示,粗体表示最佳性能,可以发现,移除任何一个模块都将导致性能下降.(1) 用卷积代替Transformer.我们尝试用卷积替换原来的Transformer作为模型的特征提取模块.虽然整体效果令人满意,但部分细节不是很完整,人脸的一些局部位置缺乏一定的连续性.FID和LPIPS指标分别上升了1.31和0.0331.(2) 删除空间注意转换.为了验证SAT模块的有效性,将其移除后进行训练,并对结果进行定量分析.去除SAT模块后,FID和LPIPS指标分别上升了3.39和0.0689,说明SAT可以提升模型效果.(3) 去除金字塔重构损失.金字塔恢复损失可以增强对现实世界中复杂退化的恢复能力.如果没有这个模块,后续调制的多分辨率空间特性可能仍然会下降,从而导致性能下降.此外,我们在训练中发现,该模块还可以使训练过程更加稳定,起到一定的加速训练的效果.(4)使用原始的StyleGAN.我们同时使用原始StyleGA生成模块和改进后的StyleGAN生成模块进行训练,对比实验结果如表4所示.FID和LPIPS分别上升0.39和0.002 7,说明改进后的StyleGAN是有效的.此外,在模型的训练过程中,我们发现经过改进后的StyleGAN在训练时变得更加稳定,速度也有所提升.

5 结 论

本文提出了一种渐进式人脸恢复网络SwinStyleGAN模型,该模型使用Swin Transformer进行特征提取,并使用修改后的StyleGAN对潜在代码进行从粗到细的重构.由于采用Swin Transformer替换了广泛使用的CNN,解决了卷积无法整合长距离信息的问题.利用提取的全局特征上的空间注意力转换(SAT)模块来调制StyleGAN生成的特征,可以严格约束和控制StyleGAN的生成过程.同时,为了解决StyleGAN训练的不稳定性和生成结果与输入不一致的问题,我们将Transformer的框架结构引入到StyleGAN中,充分利用两者的优势.大量实验表明,SwinStyleGAN无论是在盲人脸修复还是人脸超分辨率方面都具有很高的可靠性和鲁棒性.在实际场景中具有较高的应用价值.

参考文献:

[1] Qin J, Bai H, Zhao Y. Multi-scale attention network for image inpainting [J]. Comput Vis Image Und, 2021, 204: 103155.

[2] Xiao Z, Li D. Generative image inpainting by hybrid contextual attention network[C]//Proceedings of the MultiMedia Modeling: 27th International Conference on MMM. Prague:Springer International Publishing, 2021: 162.

[3] Kupyn O, Martyniuk T, Wu J, et al. Deblurgan-v2: Deblurring (orders-of-magnitude) faster and better[C]//Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2019.

[4] Kupyn O, Budzan V, Mykhailych M, et al. Deblurgan: Blind motion deblurring using conditional adversarial networks [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 8183.

[5] Chen C, Li X, Yang L, et al. Progressive semantic-aware style transformation for blind face restoration[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Kuala Lumpur:IEEE, 2021: 11896.

[6] Wang X, Li Y, Zhang H, et al. Towards real-world blind face restoration with generative facial prior [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Kuala Lumpur: IEEE, 2021: 9168.

[7] Wang X, Yu K, Wu S, et al. Esrgan: Enhanced super-resolution generative adversarial networks[C]//Proceedings of the European Conference on Computer Vision (ECCV) Workshops. Munich: Springer, 2018.

[8] Wang X, Xie L, Dong C, et al. Real-esrgan: Training real-world blind super-resolution with pure synthetic data [C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 1905.

[9] Ma N, Zhang X, Zheng H T, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design [C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich: Springer, 2018: 116.

[10] Sandler M, Howard A, Zhu M, et al. Mobilenetv2: Inverted residuals and linear bottlenecks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. California: IEEE, 2018: 4510.

[11] Tan M, Le Q. Efficientnet: Rethinking model scaling for convolutional neural networks[C]//International Conference on Machine Learning. California: PMLR, 2019: 6105.

[12] Tan M, Le Q. Efficientnetv2: smaller models and faster training[C]//International Conference on Machine Learning. Long Beach Convention Center, Long Beach: PMLR, 2021.

[13] Zhang X, Zhou X, Lin M, et al. Shufflenet: An extremely efficient convolutional neural network for mobile devices [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 6848.

[14] Kim D, Kim M, Kwon G, et al. Progressive face super-resolution via attention to facial landmark[J]. IEEE Signal Proc Let, 2019, 26: 1859.

[15] Yu X, Fernando B, Ghanem B, et al. Face super-resolution guided by facial component heatmaps[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich: Springer, 2018: 217.

[16] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Adv Neur Inf Process Syst, 2017, 30: 5998.

[17] Wu H, Xiao B, Codella N, et al. Cvt: Introducing convolutions to vision transformers[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Virtual Event: IEEE, 2021: 22.

[18] Wang W, Xie E, Li X, et al. Pyramid vision transformer: a versatile backbone for dense prediction without convolutions[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Virtual Event: IEEE, 2021: 568.

[19] Wang W, Xie E, Li X, et al. Pvt v2: Improved baselines with pyramid vision transformer[J]. Comp Visual Media, 2022, 8: 415.

[20] Liu Z, Lin Y, Cao Y, et al. Swin transformer: Hierarchical vision transformer using shifted windows[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Canada: IEEE, 2021: 10012.

[21] Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: Transformers for image recognition at scale [J]. [EB/OL].[2022-05-10]. https://arxiv.org/abs/2010.11929.

[22] Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 4401.

[23] Karras T, Laine S, Aittala M, et al. Analyzing and improving the image quality of stylegan [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington: IEEE, 2020: 8110.

[24] Liang J, Cao J, Sun G, et al. Swinir: Image restoration using swin transformer [C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal, Canada: IEEE, 2021.

[25] Yang T, Ren P, Xie X, et al. Gan prior embedded network for blind face restoration in the wild [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Kuala Lumpur: IEEE, 2021: 672.

[26] Yang L, Wang S, Ma S, et al. Hifacegan: Face renovation via collaborative suppression and replenishment [C]//Proceedings of the 28th ACM International Conference on Multimedia. New York:ACM, 2020: 1551.

[27] Li X, Liu M, Ye Y, et al. Learning warped guidance for blind face restoration [C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich: Springer, 2018.

[28] Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation[C]//Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention-MICCAI. Munich: Springer International Publishing, 2015.

[29] Sandler M, Howard A, Zhu M, et al. Mobilenetv2: Inverted residuals and linear bottlenecks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Seoul: IEEE, 2018: 4510.

[30] Hendrycks D, Gimpel K. Gaussian error linear units (gelus) [C] //Proceedings of the IEEE International Conference on Learning Representations (ICLR).[S.l.:s.n.], 2016.

[31] Glorot X, Bordes A, Bengio Y. Deep sparse rectifier neural networks[C]//Proceedings of the 14th International Conference on Artificial Intelligence and Statistics. Fort Lauderdale: [s.n.], 2011.

[32] Ba J L, Kiros J R, Hinton G E. Layer normalization [EB/OL].[2023-04-01]. https://arxiv.org/abs/1607.06450.

[33] Yu W, Luo M, Zhou P, et al. Metaformer is actually what you need for vision[C]//Proceedings of the IEEE/CVF Conference on Computer vision and Pattern Recognition. New Orleans: IEEE, 2022: 10819.

[34] Liu Z, Mao H, Wu C Y, et al. A convnet for the 2020s [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. [S.l.:s.n.],2022: 11976.

[35] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]//Proceedings of the International Conference on Learning Representations (ICLR). [S.l.:s.n.], 2015.

[36] Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. [S.l.:s.n.], 2019: 4401.

[37] Li X, Chen C, Zhou S, et al. Blind face restoration via deep multi-scale component dictionaries [C]//Proceedings of the 16th European Conference on Computer Vision-ECCV. Glasgow: Springer International Publishing, 2020: 399.

[38] Xu X, Sun D, Pan J, et al. Learning to super-resolve blurry face and text images [C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 251.

[39] Kingma D P, Ba J. Adam: a method for stochastic optimization [EB/OL].[2023-04-01]. https://arxiv.org/abs/1412.6980.

[40] Menon S, Damian A, Hu S, et al. Pulse: self-supervised photo upsampling via latent space exploration of generative models [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 2437.

[41] Bulat A, Tzimiropoulos G. Super-fan: integrated facial landmark localization and super-resolution of real-world low resolution faces in arbitrary poses with gans [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 109.

[42] Heusel M, Ramsauer H, Unterthiner T, et al. Gans trained by a two time-scale update rule converge to a local nash equilibrium [J]. Adv Neur Inf Process Syst, 2017, 30: 6626.

[43] Zhang R, Isola P, Efros A A, et al. The unreasonable effectiveness of deep features as a perceptual metric [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 586.

引用本文格式:

中 文: 向泽林, 楼旭东, 李旭伟. 基于Swin Transformer和Style-based Generator的盲人脸修复 [J]. 四川大学学报: 自然科学版, 2023, 60: 032003.

英 文: Xiang Z L, Lou X D, Li X W. Blind face restoration based on Swin Transformer and Style-Based Generator [J]. J Sichuan Univ: Nat Sci Ed, 2023, 60: 032003.