语言学视角下ChatGPT带来的机遇与挑战

2023-04-29何伟

何伟

摘 要:对话生成预训练模型ChatGPT(Chat Generative Pre-trained Transformer)因其高超的对话能力,一经发布便吸引了工业界和学术界的广泛关注,成为历史上增长最快的消费者应用程序,在发布后两个月内就吸引了1亿注册用户,带动了数据、算法、算力、应用等人工智能板块的产业研发热潮。本文立足语言学的视角,围绕ChatGPT是否已经具备语言理解和推理能力,可否提高大语言模型的可解释性,以及能否预示着知识工程的新方向三个核心问题,探讨ChatGPT带来的机遇和挑战。

关键词:ChatGPT;大语言模型;知识工程;人工智能

中图分类号:G209/H09 文献标识码:A 文章编号:1672-335X(2023)06-0094-10

DOI:10.16497/j.cnki.1672-335X.202306009

对话生成预训练模型ChatGPT(Chat Generative Pre-trained Transformer)因其高超的对话能力,一经发布便吸引了工业界和学术界的广泛关注。它可以回答后续提问,拒绝不当请求,挑战错误前提,并承认自己错误。[1]它获得许多涌现能力,如高质量对话、复杂推理、思维链、零/少样本学习(语境学习)、跨任务泛化、代码理解/生成等。[2]这是首次在大型语言模型(large language model,LLM)内很好地解决如此多样的开放任务。[3]ChatGPT成为历史上增长最快的消费者应用程序,在发布后两个月内就吸引了1亿注册用户。[4]

与此同时,很多学者围绕着ChatGPT及其影响发表了不同观点和看法。著名语言学家、哲学家诺姆·乔姆斯基与伊恩·罗伯茨、杰弗里·瓦图穆尔共同在《纽约时报》发表了题为《ChatGPT的虚假承诺》的文章。[5]乔姆斯基强调,人工智能和人类在思考方式、学习语言与生成解释的能力,以及道德思考方面有着极大的差异,并提醒读者如果ChatGPT式机器学习程序继续主导人工智能领域,那么人类的科学水平和道德标准都可能因此降低。对此,斯坦福大学教授、自然语言处理领域著名学者克里斯托弗·曼宁表示,乔姆斯基的批评不是在针对ChatGPT的某种算法错误,而是针对所有机器学习算法,且说法有些夸张。认知语言学家阿黛尔·戈德堡则认为乔姆斯基的文章并未提出令人信服的论据。[6]我国计算语言学家冯志伟教授也撰文指出,人工智能借由人机对话深入地介入了语言生活,这一发展过程中,语言学和语言学家在不同时期有所介入,但总体而言并不多。随着人机对话性能的飞速提升,语言学和语言学家需要正视冲击,并进行反思。[7]

本文将在语言学的视角下,围绕ChatGPT是否已经具备语言理解和推理能力,可否提高大语言模型的可解释性,以及能否预示着知识工程的新方向三个核心问题,探讨ChatGPT带来的机遇和挑战。

一、ChatGPT是否已经具备语言理解和推理能力?

乔姆斯基认为“ChatGPT在推理和语言使用上和人类有巨大差别”。[5]但是,很多ChatGPT的使用者都被ChatGPT的像人程度惊艳过,甚至开始担忧自己作为人会被ChatGPT所代替。香港中文大学语言处理实验室团队以ChatGPT作为“被试”,让其完成12个经典的心理语言学实验,然后再和人类的实验结果做对比。这12个实验囊括了从语音、词汇、句法、语义再到语篇、对话等与语言能力相关的多个方面。其中10项实验结果表明,ChatGPT的语言使用能力很大程度上和人类接近,这有可能为研究人类的语言使用和习得提供借鉴。[8]

在语音方面,ChatGPT和人类一样,能够根据单词的发音来判断单词所指物体的形状,比如“takete”或“kiki”可能表示尖的物体(因为听起来比较尖锐),而“maluma”或“bouba”则表示圆的物体;也能够根据名字的发音来判断性别,比如,英语中的女性名字多以元音结尾,而男性名字则多以辅音结尾。

在词汇和句法方面,ChatGPT像人类一样倾向于使用前面出现过的多义词词义和句法结构。例如,多义词“post”主要意思是“邮件”,次要意思是“工作”,当上文出现句子“The man accepted the post in the accountancy firm(那个人接受了会计师事务所的职位)”之后,ChatGPT会像人类一样把其后出现的“post”也理解为“工作”。同样,如果前面出现了介宾结构“The racing driver gave the torn overall to his mechanic(赛车手把撕裂体交给了他的机械师)”,后面再看到“The patient showed…(病人显示……)”时会更多续写成介宾结构,而非双宾结构。这说明,ChatGPT像人一样,能够根据最近的输入来更新形式—意義间的映射。

在语义方面,ChatGPT可以像人类一样将不合理的句子合理化,例如对一个不合理的句子“The mother gave the candle the daughter(妈妈把女孩给了蜡烛)”,通过增加“to”的方式将其理解成“The mother gave the candle to the daughter(妈妈把蜡烛给了女孩)”。 ChatGPT也会像人类一样产生语义错觉从而注意不到句子中的明显错误,例如,这个带有错误的句子“During the biblical flood,how many animals of each kind Moses take on the ark(在圣经大洪水中,每个动物摩西带了几只上方舟)”,人们通常难以察觉到不是摩西而是诺亚将动物们带上方舟的,这种现象被称为语义错觉。

在语篇层面,ChatGPT能像人类一样判断出动词中隐含的因果关系,例如,对于句子“A scared B”,是A的某些特质让B害怕,因此A是刺激,B是经历者;相反地,对于句子“A feared B”,则认为是B的某些特质让A害怕,因此A是经历者,B是刺激。ChatGPT也能够像人类一样连接两个句子的信息从而进行推理,如句子“While swimming in the shallow water near the rocks,Sharon stepped on a piece of glass.She called desperately for help,but no one around to hear her(Sharon在礁石附近游泳的时候踩到了一块玻璃。她绝望地呼救,但是周围没有人听到她)”,人们更容易通过连接“Sharon stepped on a piece of glass(Sharon踩到了一块玻璃)”和“She called desperately for help(她绝望地呼救)”这两个信息推理出“She cut her foot(她割破了脚)”这个可能性。

在对话层面,ChatGPT能够像人一样根据对话者的身份来理解相应的单词意思,即在对话者为美国人的情况下更多理解为美式英语中的意思,例如,“bonnet”这个词,在英式英语中表示“汽车的阀盖”,而在美式英语中则是“帽子”的意思。ChatGPT也能够像人一样根据对话者的身份来使用相应的单词,即在对话者为美国人时更多使用美式英语回答。

在尚未达到人类水平的2项实验结果中,一个是在高预测性语境下,ChatGPT还不能像人类一样选择使用更短的单词。例如,同样是表示“数学”意思的词“maths”和“mathematics”,在预测性较高的语境下“Susan was very bad at algebra,so she hated…(Susan代数很不好,所以她恨……)”, 人类倾向于选择短的“maths”,而在预测性较低的语境下“Susan introduced herself to me as someone who loved…(Susan将自己介绍为是一个喜欢……)”,人们则倾向于选择长的“mathematics”。

另一个是ChatGPT还不能利用前面的语境消解句法歧义,例如,在只有一个“偷猎者”的语境中,人们通常将句子“The hunter killed the poacher with a rifle”理解为“猎人用一把来复枪杀死了偷猎者”,即介词短语“with a rifle”用来修饰动词短语“killed the poacher”,而在有两个“偷猎者”的语境中,人们会将句子“The hunter killed the poacher with a rifle”理解为“猎人杀死了带着一把来复枪的偷猎者”,即介词短语“with a rifle”用来修饰名词短语“the poacher”。

东南大学知识科学与工程实验室团队测试了ChatGPT在回答复杂问题时的推理能力,并和其他大型语言模型(LLM)以及知识库问答系统(KBQA)进行了对比。[9]论文归纳出了8个“推理类型”标签,包括集合操作、条件过滤、计数、极值/排序、单跳推理、多跳推理和星型事实推理。论文采用了与维基百科相关的6个英语数据集和2个多语数据集作为测试数据集。论文得出的结论主要有:1、在WQSP和GraphQuestions数据集上超越了传统模型的当前最佳水平,在其他数据集上ChatGPT的表现仍然显著劣于传统模型。2、ChatGPT的大多数表现优于其他大型语言模型,但在回答数字或基于时间的问题时表现并不是最佳的。此外,在涉及多跳或星型事实推理的问题时,其表现也不如GPT3.5 V3。3、大型语言模型无法准确回答各种基于事实的问题。这在需要数值、因果和时间答案的测试集中尤为明显,所有大型语言模型都表现不佳。4、在多语言测试中,ChatGPT对于回答低资源语言问题表现更为优秀,然而中文测试得分较低,无法确定是由于“中文资源不足”还是“资源质量不佳”造成的。5、ChatGPT在知识库问答方面存在一些限制。最小功能测试结果显示,ChatGPT不擅长回答只涉及一种类型推理的问题。不变性测试结果表明,与传统模型相比,ChatGPT在处理相似或几乎相同的输入时不够稳定。定向期望测试显示,ChatGPT并不总是对正确提示提供积极反馈。当面对修改后的测试样本时,其输出的变化并不总是符合我们的预期。6、使用CoT(思维链)提示来引导ChatGPT逐步回答问题是有用的,特别是针对需要使用计数推理来获取答案的问题。

基于上述论文的实验结果可知,增强大型语言模型的语境理解能力是一项挑战,可以考虑如何通过构造恰当的提示学习来告诉ChatGPT当前的语境信息。大型语言模型在事实类问题上的表现不佳,很大原因是受限于自身的训练语料。因此,与搜索引擎或者知识图谱的结合可以扩展大型语言模型的知识来源。使用CoT(思维链)提示,将问题分解成多个步骤,能有效提升大型语言模型表现不佳的计数推理能力。这其中蕴含的语言逻辑值得进一步研究。

二、可否提高大语言模型的可解释性?

大型语言模型 (LLMs) 是具有大量参数的深度学习模型,以无监督方式对大量文本进行训练。大型语言模型的可解釋性是构建安全、可靠、可信的大型语言模型发展道路上亟待解决的重要问题。四位人工智能伦理和政策专家撰文指出,大型语言模型和生成式人工智能工具的构建和部署及其在科学探索中的应用必须被视为解释性成就,这些成就应该嵌入科学哲学家所称的“发现背景”中。[10]

在理想情况下,严谨的数学符号—逻辑规则是最好的解释。然而,人工神经网络的“黑箱”特性极大地阻碍了大型语言模型的可解释性。ChatGPT对应的GPT3底座约有1750亿个神经元连接权重参数,不到人脑的万分之四,但也大到无法采用严谨的数学符号—逻辑规则进行解释。神经网络的可解释性工作按照解释力从高到低大致有决策树解释、神经元解释、特征权重解释和样例解释,[11]决策树等透明模型难以解释复杂的神经网络,因此大语言模型的可解释性工作主要集中在神经元解释上。

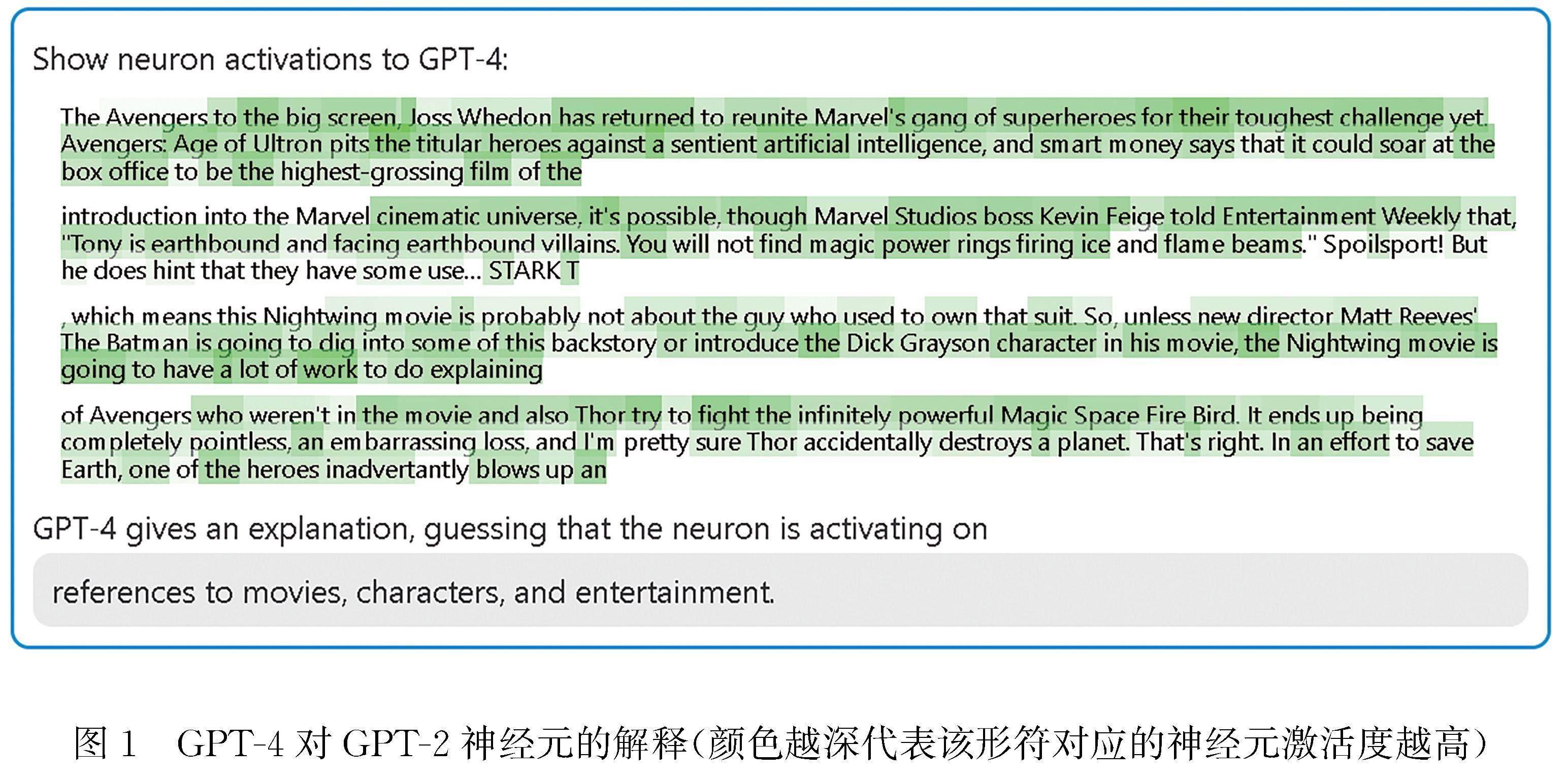

推出ChatGPT的OpenAI公司采用大型语言模型GPT-4来解释架构更简单的语言模型GPT-2上神经元的行为。[12]其过程分为三步。第一步:使用GPT-4生成解释,首先找一个GPT-2的神经元,并向GPT-4展示相关的形符(token)和对应的神经元激活度(activation)。然后,让GPT-4根据这些行为,生成一个可能的解释。例如,在图1的例子中GPT-4就认为,这个神经元与电影、人物和娱乐有关。

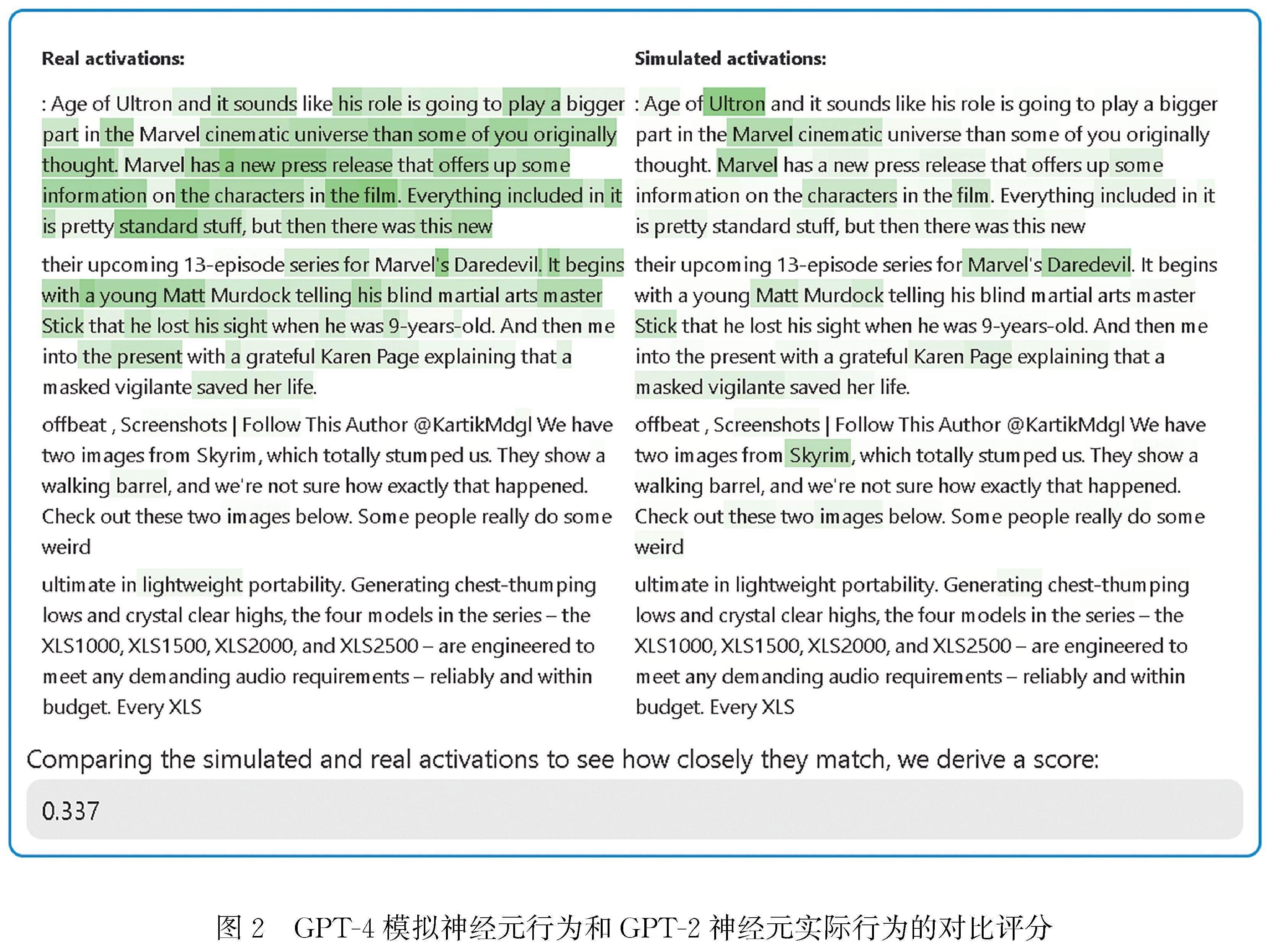

第二步:使用GPT-4进行模拟,让GPT-4根据自己生成的解释,模拟以此激活的神经元会做什么。第三步:对比打分,最后将模拟神经元(GPT-4)的行为与实际神经元(GPT-2)的行为进行比较,看看GPT-4究竟猜得有多准。在图2的例子中,左边是GPT-2神经元的实际行为,右边是GPT-4模拟的神经元行为,下方给出的评分为0.337。

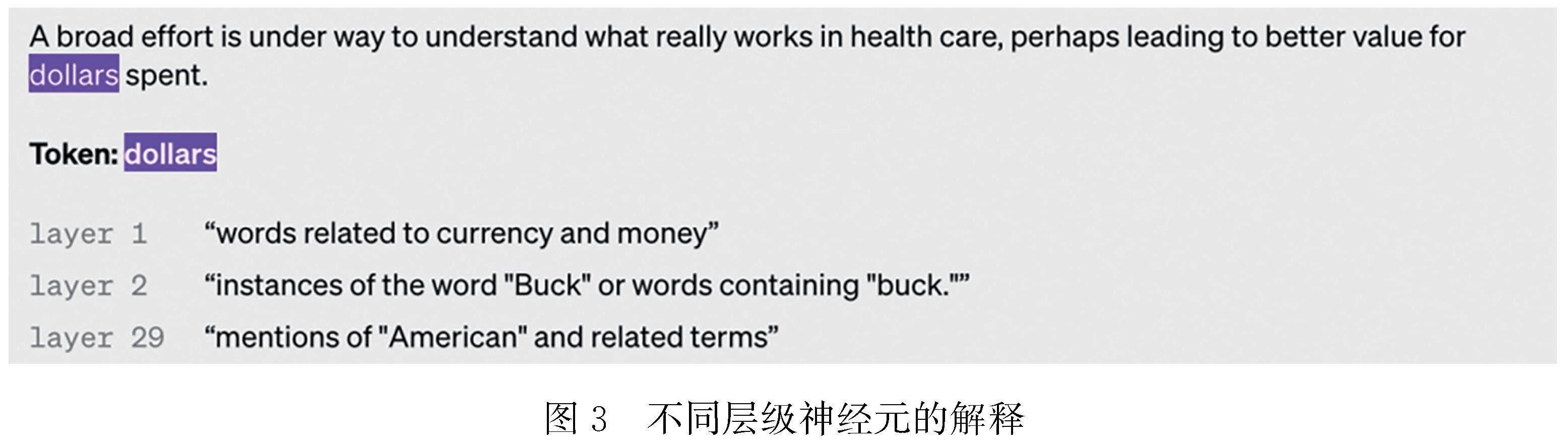

目前,绝大多数解释评分都很低,但可以通过迭代解释、使用更大的模型、更改所解释模型的体系结构等方法,来提高分数。研究也发现,神经元层级越高,GPT-4的解释就越抽象。如图3中的例子,形符“dollars”在第1层神经元中被解释为“货币相关的单词”,在第2层神经元中被解释为“美元词语的实例”,在第29层神经元中被解释为“美国的关联物”。

研究中还发现了一些有趣的神经元,比如一个模式破坏神经元,它会对正在进行的列表中打破既定模式的形符(token)进行激活,如图4所示,每一行最后一个形符(token)都与之前的形符模式不同,此时模式破坏神经元就会被激活。目前,这些神经元的行为依然缺乏足够的解释,但有可能许多神经元编码了以特定输入为条件的输出分布的特定微妙变化。

Anthropic公司发布了“Transformer通路项目”, [13]通过逆向工程的方式对大型语言模型采用的Transformer架构进行机械可解释性研究,并为研究项目创造了网站,以可视化、可交互的形式来显示其研究成果。机械可解释性研究认为,神经网络并不是不可解释的黑匣子,而是学习了一些人类可解释的算法,并通过对神经网络逆向工程反编译为可理解的算法。目前,该项目的研究表明了对于任何规模的Transformer模型,“归纳头”现象都是模型一般情境学习的来源,负责模型中大部分的上下文学习。此外,该项目也证实了神经元的叠加是一种真实、可观察到的现象,让模型可以表示额外的特征,并且额外特征的数量随着稀疏度的增加而增加。“神经元叠加假设”是指人们认为网络通过神经元的叠加赋予了模型识别比维度更多特征的能力,它们利用高维空间的特性来模拟具有更多神经元的模型, 在无法采用严谨的数学符号—逻辑规则进行解释的情况下,对神经元的语义解释成为大语言模型可解释性的突破点,语言学应该在这方面发挥作用,特别是将人工神经网络理解语言的过程和人脑理解语言的过程进行类比研究非常重要。大型语言模型的上下文学习能力让人印象深刻, 以“归纳头”现象为代表的注意力机制在其中的作用值得进一步探究,人类理解语言时的归纳能力也应该加强研究。“叠加假设”是不是与大型语言模型的“涌现能力”相关?神经元的叠加机制以及对更多特征的表示能力也需要更深入的研究。

三、能否预示着知识工程的新方向?

知识工程涉及设计和构建基于知识的系统的过程。当前以知识图谱为代表的知识工程范式受到极大冲击。传统的知识图谱从构建到上层的应用都需要将文本任务切分成各个子任务场景来解决,例如知识发现、知识挖掘、知识表示、知识推理、知识应用等任务,涉及非结构化数据清洗和抽取、分词、语义角色标注、实体抽取、关系分类、实体消歧、语义匹配、图谱查询和图谱推理等任务,与人类完全从端到端的知识网络构建流程有所出入,需要耗费大量人力、物力和时间,其场景化的落地应用也离不开精细的微调,阻碍了知识图谱的大规模泛化应用。

ChatGPT本身就是知识工程的一个具体的结果呈现。ChatGPT是一种大规模预训练语言模型LLM(Large Language Model),需要学习大量的知识。这些知识通常来自互联网上公开可用的数据、文本、源代码等语料,如GPT-3.5的语料库由8000亿单词、45TB文本数据规模的语料构成。ChatGPT类的大语言模型依靠大规模参数量,及高质量人类反馈学习机制能够很好地模擬人类,让模型初显通用人工智能的能力。大型语言模型可以凭借其涌现能力以及强大的常识、推理和交互能力,基于统一范式处理大部分的自然语言处理下游应用,且生成效果逐步接近真实世界,非领域专业人士甚至很难辨明内容真伪。

基于大型语言模型的知识工程围绕着常识蒸馏和外部知识获取两个方向。常识是一种隐性知识,大型语言模型本身内含较多常识,可以通过生成常识数据集蒸馏出大语言模型中的常识。哥伦比亚大学的研究团队提出一种通过提示大型语言模型来生成包含常识的对话数据集方法。[14]论文使用一小组专家编写的对话作为上下文示例,通过提示生成社交对话数据集,如图5所示,左边是用于提示大语言模型的示例,包括对话的话题(蓝色文字)、背景(红色文字)和话轮,右边是大语言模型根据提示生成的契合主题和背景的对话数据。论文证明了这种提示方法可从两方对话推广到多方对话,并且与人工收集的多方对话相比,利用大语言模型生成的多方对话在所有测量维度上的评分都更高。大语言模型生成的常识对话数据集可以被各种定制。例如,首尔国立大学团队通过人机协作框架创建了一个增强道德感的数据集,并利用该数据集生成了常识性社会规范准则。[15]

也可以通过让大型语言模型显式地输出隐含在言语句中的常识来蒸馏出大型语言模型中的常识。南加州大学的研究团队提出了一种先思考后说话的方法,首先将隐含的常识知识外化(思考),然后使用这些知识生成响应(说话)。[16]如图6所示,根据用户输入,从概念图谱ConceptNet中找出最符合这段话的概念,将这个概念和与其相关的关系显式地表达出来,这样就将句子中隐含的常识显性地表达出来,即花和妻子都能隐含爱情,而其中的代表则为玫瑰,并将显性化的常识知识通过提示学习来训练响应生成器。实证结果表明,论文所提出的模型在大多数自动指标上优于端到端和知识增强的神经响应生成器基线模型,能够生成具有更多信息、更具体和符合常识的响应,大型语言模型可以通过搜索互联网或者知识库获取外部知识。亚马逊研究团队提出了一种端到端面向文档的外部知识获取方法。[17]假设对话以主题文档为中心,并且需要外部知识来产生响应,如图7所示,跟踪当前以主题文档DT为中心的对话并实时生成对话的嵌入表示,然后到外部知识库里面找具有相似嵌入表示的文档,召回以后当作外部文档来辅助对话响应的生成。

语言模型可以通过结合使用模块化和检索来生成更多的事实响应。Facebook研究团队将互联网搜索作为一个模块获取实时的外部知识,提出了一种基于模块化搜索和生成的大语言模型外部知识获取方法,[18]将单个语言模型连续应用于三个模块化任务:搜索、生成知识和生成最终响应,如图8所示,系统根据用户输入生成显式的查询语句并在互联网上找到相应知识,依据该知识生成响应。实验表明,论文所提出的方法在真实性和话题性方面优于大语言模型 GPT2和 GPT3,适用于主题提示补全应用。

大型語言模型将促使知识工程范式发生极大改变,甚至有学者将以ChatGPT为代表的生成智能(Generative AI)理解为人类最新的知识新媒介,[19]它不仅生成新的知识,更重要的是,人类的获知与求知模式(mode of knowing)本身因其发生重大改变。论文提出的主要观点包括:1、知识生产:从前台的“发现”或然率到后台的“生产”或然率,互联网“或然率资料库”主要表现为前台“发现”的或然率,例如通过搜索引擎或推荐算法获得知识发现的不同概率;以ChatGPT为代表的生成智能则将“发现”的或然率隐藏于后台,其“生产”的或然率更为隐蔽,也更容易被忽略;2、知识调用:首次嵌入日常生活的大规模自然语言交互,ChatGPT与以往的“本质性资料库”和互联网“或然率资料库”均不同,它首次以嵌入日常生活的大规模自然语言交互,创造了人类知识调用和提取的新模式;3、知识流通:从个体知识到公共知识,首先ChatGPT通过“或然率资料库”的生产重构知识流通与扩散逻辑,其次ChatGPT已经展现出从个人知识向公共知识传播演化的过程。

提问与指令对于知识调用至关重要,成为“生成智能时代”人类需要的新能力。ChatGPT高度依赖用户准确、深入、持续、交互地提出具体需求,这恰是源于ChatGPT作为新型“或然率资料库”的统计语言模型特征,微妙的提问与指令变化就会带来迥异的回答。因此,在ChatGPT的知识调用过程中,“Prompt”(提示指令)的写作成为一种新的核心能力,如何提问、如何提出任务本身成为一种新的重要知识。“提示工程师”也可能成为新的职业。从这个意义上说,ChatGPT既是人类知识调用的一次简化回归,又带来新的挑战和要求,因此可能造成新的“知识沟”——“知识调用沟”。

ChatGPT对以知识图谱为代表的知识工程范式的冲击,实质是数据驱动范式对专家主导范式的冲击。当下,大型语言模型与知识图谱的结合,通用知识与行业知识的结合是备受关注的研究热点。按照ChatGPT的预测,约25年后就会产生统一的知识标示框架,语言是知识的载体,在构建人类知识框架这一远大目标上语言研究可以大有作为。

四、结语

以ChatGPT为代表的大型语言模型已经到来并不可避免地带来巨大的机遇与挑战,语言学研究理应抓住机遇,对挑战做出回应。在提高大型语言模型的语言理解和推理能力方面,可以通过构造恰当的提示学习和思维链技术来增强大型语言模型的语境理解能力和逻辑推理能力。通过对人工神经网络理解语言的过程和人脑理解语言的过程进行类比研究,可以对神经元的行为进行语义解释,从而增强大型语言模型的可解释性。尤其重要的是大型语言模型预示着新的知识工程范式,在知识融合和知识框架构建上,语言学理应做出自己的贡献。

参考文献:

[1] Schulman J,Zoph B,Kim C,et al.ChatGPT:Optimizing Language Models for Dialogue[EB].https://openai.com/blog/chatgpt.

[2] Wei J,Tay Y,Bommasani R,et al.Emergent Abilities of Large Language Models[EB].Published in Transactions on Machine Learning Research,08/2022,https://arxiv.org/abs/2206.07682.

[3] Zhou J,Ke P,Qiu X,et al.ChatGPT:Potential,Prospects,and Limitations[EB].Front Inform Technol Electron Eng.https://doi.org/10.1631/FITEE.2300089.

[4] Hu K,(2023).ChatGPT Sets Record for Fastest-growing User Base-analyst Note[EB].https://www.reuters.com/technology/chatgpt-sets-record-fastest-growing-user-base-analyst-note,2023-02-01.

[5] Chomsky N,Roberts I & Watumull J.The False Promise of ChatGPT[EB].https://www.nytimes.com/2023/03/08/opinion/noam-chomsky-chatgpt-ai.html,March 8,2023.

[6] 机器之心.终于乔姆斯基出手了:追捧ChatGPT是浪费资源[EB].https://baijiahao.baidu.com/s?id=1759963 403251109370&wfr=spider&for=pc,2023-03-11.

[7] 冯志伟,张灯柯,饶高琦.从图灵测试到ChatGPT——人机对话的里程碑及启示[J].语言战略研究,2023,(2).

[8] Cai Z G,Haslett D A,Duan X,Shuqi W & Pickering M J.Does ChatGPT Resemble Humans in Language Use? PsyArXive [Preprint] [EB].https://psyarxiv.com/s49qv/.

[9] Tan Y,Min D,Li Y,Li W,Hu N,Chen Y & Qi G.Evaluation of ChatGPT as aquestion answering system for answering complex questions[J].ArXiv,abs/2303.07992.

[10] Birhane A,Kasirzadeh A,Leslie D,et al.Science in the Age of Large Language Models[EB].Nat Rev Phys 5,277-280.https://doi.org/10.1038/s42254-023-00581-4.

[11] Zhang Yu, et al. Asurvey on Neural Network Interpretability[EB].IEEE Transactions on Emerging Topics in Computational Intelligence 5 (2020):726-742.

[12] Bills et al.Language Models can Explain Neurons in Language Models[EB].https://openaipublic.blob.core.windows.net/neuron-explainer/paper/index.html.

[13] Anthropic.Transformer通路項目[EB].https://transformer-circuits.pub/,2023.

[14] Chen M,Papangelis A,Tao C,Kim S,Rosenbaum A,Liu Y,Yu Z & Hakkani-Tür D Z.PLACES:Prompting language models for social conversation synthesis[EB].ArXiv,abs/2302.03269.

[15] Kim H,Yu Y,Jiang L,Lu X,Khashabi D,Kim G,Choi Y & Sap M.Prosocial Dialog:A Prosocial Backbone for Conversational Agents[EB].Conference on Empirical Methods in Natural Language Processing.

[16] Zhou P,Gopalakrishnan K,Hedayatnia B,et al.Think before you speak:Using self-talk to generate implicit commonsense knowledge for response generation[J].2021.DOI:10.48550/arXiv.2110.08501.

[17] Tuan M.Lai,GiuseppeCastellucci,Saar Kuzi,Heng Ji and Oleg Rokhlenko.External Knowledge Acquisition for End-to-end Document-oriented Dialogue Systems,Proc[EB].The 17th Conference of the European Chapter of the Association for Computational Linguistics (EACL2023).

[18] Shuster K,Komeili M,Adolphs L,et al.Language models that seek for knowledge:Modular search & generation for dialogue and prompt completion[J].2022.DOI:10.48550/arXiv.2203.13224.

[19] 周葆华.或然率资料库:作为知识新媒介的生成智能ChatGPT[J].现代出版,2023,(2):21-32.DOI:10.3969/j.issn.2095-0330.2023.02.003.

Opportunities and Challenges Brought by ChatGPT from the Linguistic Perspective

Abstract:The Chat Generative Pre-trained Transformer (ChatGPT) model has attracted widespread attention from both industry and academia due to its excellent dialogue ability. It has become the fastest-growing consumer application in history, attracting 100 million registered users within two months of its release, driving a wave of industrial investment in artificial intelligence sectors such as data, algorithms, computing power, and applications. Based on the linguistic perspective, this article explores the opportunities and challenges that ChatGPT brings, focusing on three core issues: whether ChatGPT already possesses language comprehension and reasoning abilities, whether it can improve the interpretability of large language models, and whether it can predict new directions in knowledge engineering.

Key words: ChatGPT; large language model; knowledge engineering; artificial intelligence