ChatGPT:像人,更胜似人?

2023-04-04凌川儿

凌川儿

人工智能聊天机器人ChatGPT在全球持续走红,让自启蒙阶段到象牙塔的教育行业受到了极大震动。

单单就日常操作而言,它就能帮助人类学生写作业、做翻译甚至撰写学术论文—已经有来自北美地区的一项调查显示,在参与调查的美国学生中,有超过一半用ChatGPT写过作业,甚至有人因此拿了高分。

在另一边,察觉到ChatGPT威胁的校方和教师系统,开始对它做出回应和防备。继法国巴黎政治大学要求所有师生禁用ChatGPT等一切基于AI的工具,以防学术欺诈和剽窃后,美国不少大学亦将“使用AI”列入了作弊手段。

“模仿即为智能”

新的一轮关于学术不端的恐慌潮因此而起。普林斯顿大学已经出台了一款名为GPTZero的人工智能检测软件,来确定师生们提交的文章是否为ChatGPT所编写的;而斯坦福大学的研究团队所开发的检测工具DetectGPT,则号称准确率高达95%。

普林斯顿大学推出人工智能检测软件GPTZero,判定师生文章是否由ChatGPT编写

但相比學生借助ChatGPT抄袭、作弊引发的学术诚信问题,面对人工智能聊天机器人如此出色的搜集、整合资料能力和文本编写能力,我们不得不承认,传统的师道“授业解惑”行为将经受更为严峻而久远的挑战:以知识传递为核心的教育模式,在将来是否还有存在的价值?

换句话说,在极端条件下,当未来有比ChatGPT更出色的数字生命体出现,它几乎能回答所有学生提出的问题,也因此能根据学生所掌握知识的薄弱点,来做到因材施教,那么人类教师应该教些什么?反过来,当这些知识能被如此便捷地获取后,人类学生从启蒙阶段花费十几年的时间,进行学习、做题究竟有没有意义?学生又应该学习什么内容,才是最为迫切需要的呢?

思维的本质就是计算,因此人的心理过程就是一个计算执行的过程。

关于创造性教育和记忆力训练的关系,一件为人们所津津乐道的轶事是:1921年,当爱因斯坦访问美国的时候,有记者问这位当年的诺贝尔物理学奖得主,声音的速度是多少—爱因斯坦拒绝回答,而是转移话题称,这可以在任何一本物理书中查到答案,并说出了一句名言:大学教育的功能,不在于记住已有的事实,而在于训练大脑如何去思考。

早在ChatGPT横空出世之前,我们就已熟知,人工智能会应用机器学习、深度学习及自然语言处理等技术,来提升自己并解决实际问题。在这样的学习过程中,它就是通过大量地识别和记忆,来完成已有的知识积累。

也正因如此,在像ChatGPT这般表现优异的生成式强人工智能诞生后,人们似乎越来越确信,AI具备拟人的思考和学习能力,以致我们可以放心地让渡出部分决策权和重复劳动,来迎接一场新的技术革命的到来。但实际上,关于“机器真的能思考吗?”的争论,从上世纪50年代伴随着人工智能出现后,就由来已久—这也是当我们在讨论人工智能对于人类教育的冲击时,必须先思考的问题。

1950年,英国数学家、计算机科学家阿兰·图灵在《思想》杂志上,发表了一篇名为《计算机与智慧》的论文。正是在这篇著名论文里,他提出了“机器能否思考”的问题。

为了回答这个问题,阿兰·图灵在论文中给出了他所认为的一台计算机是否具有智能的判断标准,即后世广为流传的图灵测试。简单来说,在该测试中,他假设了这样的场景:一位自然人测试者身处黑暗的屋子里,与一台机器或一个人进行对话,倘若测试者无法分辨出与其对话的是人还是机器,那么就可以称机器通过了图灵测试。

计算机在不和人接触的情况下与人交流,让后者无法判断对方是人还是机器,那么它就拥有了智能。这一测试使得阿兰·图灵与其后计算主义的追随者们相信,“思考的机器”是可能的—他们认为,人脑能做到的一切,机器都能模仿;更进一步,人的心智和计算机程序具有一样的工作原理,思维的本质就是计算,因此人的心理过程就是一个计算执行的过程。

关于阿兰·图灵的传记电影《模仿游戏》

换句话说,在阿兰·图灵眼里,无所谓计算机内部的活动是如何开展的,它的实际行为表现即是唯一证明;只要计算机能在这场“模仿游戏”里通过,那么它就具备和人一样的智能(这正是2014年上映的关于阿兰·图灵的传记电影《模仿游戏》片名的来源)。

“理解”与“执行”的差异

但在哲学界,始终有反对的声音存在。对于“机器可以具有真正智能”的所谓强人工智能观点,它们认为,机器所表现的这种智能,只是一种模拟的“智能”,即使某台计算机通过了图灵测试,也不能排除实际上,它对问题没有任何理解的可能性;因此,计算机不可能具备真正意义的智能。

经典的图灵测试在人工智能的“强弱”上,不能作为智能意识产生的推演依据。

用纯粹的观点语言来阐述反对派的观点,兴许有些抽象,不妨来看一个相对具象的思想实验:在上世纪80年代,美国哲学教授约翰·塞尔勒在“图灵测试”的场景基础上,于其著作《意识的大脑与程序》中,提出了“中文屋论证”,来对强人工智能观点发起质疑。

在中文屋实验里,想象同样是一个孩子坐在一间被反锁的屋子里,他只通晓英文,对中文一点也不懂。在屋内,有一盒中文卡片和一本用英文编写的规则手册。假设每当屋子外有写了中文问题的纸条递进来后,这个人都能按照规则手册的操作,来将屋内的中文卡片组合成词句,来完美回答被送进来的问题,那么这个人就通过了“理解中文”的图灵测试—尽管这个人本身仍然不懂中文。

塞尔勒通过这个实验认为,计算机所运行的程序是形式化的句法实体,但人所拥有的智能却是具有语义性的,“理解”不仅仅是机械的翻译和句法的转换,而且还在于其体现了主体的意向性。

回到图灵测试的黑屋背景里,塞尔勒想表达的意思是,就算机器能够模拟人的行为与对话,也不能够认定其具有人的意识或者思维,这无非是在完美规则下的固定回应罢了。值得玩味的是,在现代教育面临AI冲击的今天,被灌输知识的人类学生,屡屡被比作是“中文屋”里操作卡片的孩子,这隐约更加符合在信息爆炸的新世紀,人们关于赛博格等后现代宣言“不可知论”的担忧。

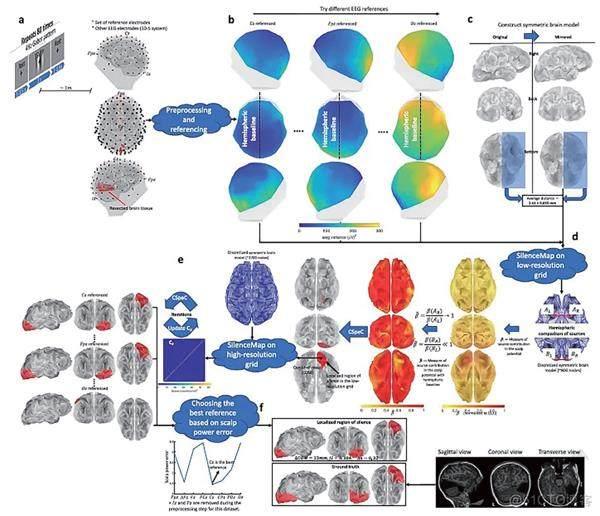

2015年,美国卡内基·梅隆大学利用核磁共振脑成像技术,记录人脑理解概念的神经活动

大规模的数据积累

塞尔勒所抓住的最有力反击点,是所谓的“理解”和“执行”之间尚且存在着差异。有趣的是,曾经被认为是无法被看到的理解过程,也随着科学的发展变为了现实。

2015年,美国卡内基·梅隆大学利用核磁共振脑成像技术,第一次将人脑理解概念的神经活动,以视频方式表现了出来:志愿者学习不同的新知识的时候,会将其存储到不同的脑区。

然而,这只是一次对人体生理反应的成功捕捉。人脑理解语义和概念的具体过程还有待揭秘,是故科学家也暂时做不到用机器模拟人脑的理解机制。

可事实上,人们对于数据积累,有着更加简单粗暴的办法:在ChatGPT吸引了全球目光之后,就已经有媒体曝出,为了训练这个聊天工具,其背后的公司OpenAI在肯尼亚雇了时薪还不到2美元的外包劳工。他们需要在9小时的工作时间内,阅读并标注最多20万个单词,还必须在工作中观看儿童性虐待、谋杀等一系列引发心理和生理不适的内容,来减少ChatGPT的有毒内容。

从包括特斯拉在内的自动驾驶研发公司所招募的大批数据标记员,到机器人在线客服背后的真人员工,在更广阔的行业应用里,人工智能所带来的自动化变革,依然在底层依赖着大量的廉价劳动力,即使“阿尔法狗们”已经在穷举规则的道路上走得更远,已经学会预测,并具备模拟人脑神经网络架构的雏形了。

可以说,目前的人工智能,仍然是对人类思维、行为的模仿,它尚且停留在工具和机械范畴,并不是真正意义上的人格实体与道德实体;经典的图灵测试在人工智能的“强弱”上,也不能作为智能意识产生的推演依据。

但我们不应忘记,计算机科学家阿尔文·纳拉亚南在设计机器人时,提出需要遵循“图灵红色警戒”的建议:机器人的定位应当是机器人,而不是人甚至超越人。

责任编辑谢奕秋 xyq@nfcmag.com