这个法官非人类

2023-04-04荣智慧

荣智慧

能说会道的聊天机器人ChatGPT,带火了背后的大语言模型GPT-3。有道是为人不识GPT-3,纵称AI(人工智能)也枉然。

建立在GPT-3上的应用“AI律师”,2月份打算在美国出庭。人类律师认为此举违反法律,齐心协力“搞走”AI同行,顺手把AI律师背后的公司“不给钱”(DoNotPay)也告了。

AI律师出庭难

大语言模型GPT-3,由美国人工智能研究实验室OpenAI研发。AI律师应用程序,和正流行的聊天机器人程序ChatGPT“师出同门”,都用GPT-3进行训练。

本来,2月某天,AI律师要协助两位违例泊车的当事人出席听证会。上场前,它已经学习了法庭记录、法律文件,以及输入的275宗案件。然而人类律师同仇敌忾,指出AI律师不合法,后者只能偃旗息鼓。

“不给钱”公司的行政总裁约书亚·布劳德(Joshua Browder)1月9日发布推特,掷下100万美元,邀请在最高法院出庭的被告或人类律师,给AI律师一个出庭的机会。届时,被告人或人类律师只需戴上AirPods,根据AI律师的指示进行辩护,就算合作达成。

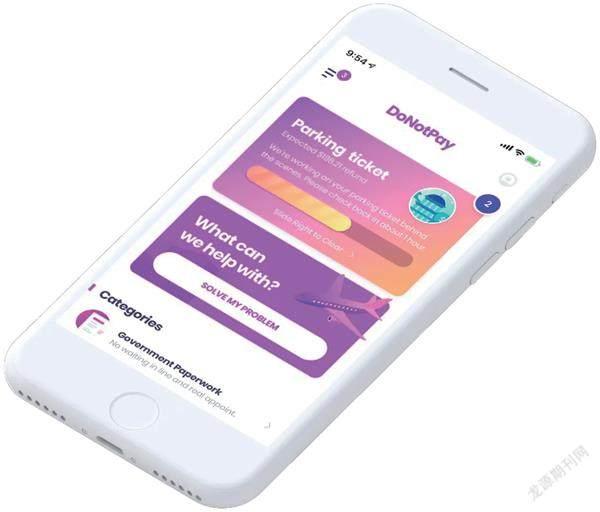

2015年,“不给钱”公司创立,靠一个小聊天机器人起家,后来逐渐可以处理医疗费用纠纷,还能跟美国大型有线电视及网络服务供货商讨价还价。

公司之所以起“不给钱”这么个名字,不是耍无赖,而是有志于改变美国高昂的律师费用。因为普通人聘请律师,真的是要咬紧牙关才能掏出钱包。

美国律师采取小时收费制。假如某律师每小时收费100美元,为此工作了5个小时,顾客就得支付500美元。《美国法律杂志》2014年数据显示,美国律师平均收费为349美元每小时,律所合伙人律师收费为604美元每小时。同时,律师助理所花的时间也包含在内—每小时50~100美元,有些甚至多达150美元。

另外,工作类型不同,收取的费用也不同,法律事务调查和出庭就是不一样的价格。

总体而言,美国的民事诉讼流程长,往往在一年以上;每个流程都有收费步骤,总费用动辄几万美元。普通人很难利用这套专业性极强的手段保护自己的权益。

人工智能技术的普及,有望达成法律普惠。布劳德放出豪言壮语:“我的目标是普通消费者再也不用聘请律师。”目前,该公司有15万付费用户,申诉或索赔信函的成功率达80%。

AI律师目前卡在进法庭这一步。根据美国法院规定,任何电子设备都不能带进法庭,戴上AirPods的人类律师也不行。布劳德曾表示,法院有无障碍条例,有些特殊人士可以在法院使用电子产品,说不定能找到豁免的机会。

布劳德放出豪言壮语:“我的目标是普通消费者再也不用聘请律师。

“不给钱”公司的行政总裁约书亚·布劳德

“ 不给钱”的APP界面

AI助理多快好省

执着于进法庭辩护的AI律师不多。

在司法行业,AI应用已经很普遍:数据检索、数据分析、确定与案件相關的建议和结论,都可以几分钟搞定,为律所节省大量时间,协助律师提高服务质量。

伦敦刑法律师萨丽·霍布森接手了一桩案情复杂的谋杀案,需要查阅、分析的卷宗有一万多份。她请了个AI助手Luminance,帮她整理材料、提取证据,最后比自己操作提前四个星期完工,节省5万英镑。Luminance可以使用80种语言,受雇于全球55个国家300多个律所。

比Luminance更高阶的是以色列的Litigate软件,后者能设计辩护方案、搜索可引用的司法判例—如果说前者干的是实习生的活儿,后者干的可是高级助理的活儿了。

2018 年1月9日,美国拉斯维加斯,IBM Wat son 在消费电子展上为观众提供了智能交互体验

据悉,导入案件概要和要求,Litigate可以很快检索出关键人物,找出其间的关联,列出重要事件时间表,并给出它的分析和解释。有人干脆总结:“它在帮助律师思考。”

Litigate有一个竞争对手叫ROSS,后者的内核是IBM的AI技术“华生”(Watson)。华生曾经在《大富豪》游戏竞赛中击败人类选手,夺得世界冠军。

ROSS本质上是一款法律研究工具,能识别理解自然语言,检索法律信息数据库,然后给出答案。而且,它也具有学习功能,会密切跟踪法律界的最新动态,在实践中不断自我完善。数据显示,它能替代传统律师七成的工作。

从国别来看,美国的AI法律服务,或者叫法律科技(Legal Tech),起步最早,应用广泛。除了大名鼎鼎的ROSS,还有Relativity公司与AI创业公司Veritone合作,将AI用于分析影音证据、自动翻译、客户管理等,省去大半人力成本。

日本的大企业常涉讼于欧美国家,近年也十分关注法律科技领域。据悉,幅锐态科技公司(FRONTEO)提供AI服务,涉及咨询及律师平台。2016年,其更利用IBM“华生”日语版着手开发法律案件问答程序,成为日本首个开发此类服务的公司。

从“互联网+”概念风行开始,中国法律界也开始涉足人工智能服务,像“无讼”提供法律咨询服务、会员交流、聊天机器人等多种业务。在刑事案件预测系统“法狗狗”上,用户可以通过选定犯罪相关参数,获取所涉法条、预测刑期和类似案例。

法官不是人?!

过去,“法官不是人”是句骂人话。如今,“法官不是人”更可能是一句事实。

英格兰首席大法官理查德·萨斯坎德(Richard Susskind)认为,30多年前,人们视为荒诞的“AI法官”现在已绝非科幻。他目前就在一个人工智能咨询委员会当主席。

AI法官具有“因袭性”—严格按照前例“审判”。

他表示,AI法官最有可能的应用场景之一,是案件积压极其严重的法庭。比如,巴西全国有1亿多宗积压待审诉案,光靠人力根本无法消化。如果有一款AI法官辅助软件,可以通过运算预测裁决结果,准确率达到95%或更高,无疑为减少诉案积压提供了希望。

爱沙尼亚一马当先,计划让AI法官上岗。

爱沙尼亚的AI法官将处理少于7000欧元的小额民事诉讼案件。原告方在程序中输入诉讼对象、金额、提告理由,AI系统调动学习储备来解析法条,从而做出判决。举例就是,同事恶意摔坏你的苹果手机,你一纸诉状告到法院,AI法官判罚同事赔你一台手机或折价金额。同事要是不服,可以上诉,届时人类法官再出面审理。

听起来非常便利,但操作起来十分复杂。

2013年,美国威斯康星州法院参酌COMPAS风险指标,判处被告埃里克·卢米斯六年徒刑。卢米斯不服,上诉到最高法院,指责AI系统裁决是一种“秘密审判”,要求说明机器学习系统如何演算判断出他的危险值。

2019年3月26日,日本东京,幅锐态科技公司的总裁守本正宏在讲解A I技术

英格兰首席大法官理查德·萨斯坎德

在美国地方的司法体系里,COMPAS基于一系列復杂的历史数据,包括年龄、性别和已有的犯罪记录,预测案件行为人(或被告)被再次逮捕的概率,得出一个1到10分之间的“危险值”,供法官参考。但这一类采取机器学习的AI,背后都是算法黑箱,并不能告诉被告这个数值是怎么算出来的。

在民主法治国家,审判必须公开透明运作,而披上法袍的AI法官不能说明判决理由,势必挑战现行的法院体制,也将稀释透明、公开、负责的司法价值。

如果在“黑箱操作”之外,AI法官还充满偏见呢?

有报告利用公开数据,分析了佛罗里达州布劳沃德县1.8万人的COMPAS分数和犯罪记录,得出了惊人的发现:尽管COMPAS的正确预测率达到了61%,但在它的系统里,黑人与白人的分数分布却明显不同。黑人更有可能被误判,即被预测为高风险却没有再犯,白人则更有可能被漏判,即被预测为低风险却再次犯罪。

报告总结,不同种族间的误判和漏判率的差距可以高达50%。

COMPAS如此动摇“法本”,统计学家蜂拥而上,迅速找到它的问题根源:COMPAS与该报告衡量“公平”的标准存在冲突。二者的公平定义类似,但用来训练模型的数据差异很大,导致最后呈现在统计学意义上的“公平”无法兼容。

更值得思考的是,AI法官具有“因袭性”—严格按照前例“审判”,这会弱化、压缩法律肩负的时代性。

责任编辑谢奕秋 xyq@nfcmag.com