基于级联视觉检测的樱桃番茄自动采收系统设计与试验

2023-03-31李兴旭陈雯柏王一群吴华瑞赵春江

李兴旭,陈雯柏,王一群,杨 顺,吴华瑞,赵春江

基于级联视觉检测的樱桃番茄自动采收系统设计与试验

李兴旭1,2,陈雯柏1,王一群1,杨 顺3,吴华瑞2,赵春江2※

(1. 北京信息科技大学自动化学院,北京 100192;2. 国家农业信息化工程技术研究中心,北京 100097;3. 北京中科原动力科技有限公司,北京 100085)

樱桃番茄串生长姿态多样、果实成熟度不一,采摘机器人进行“粒收”作业时,常面临果梗干涉末端执行器、成熟度判断错误等问题,导致采摘效率低下、难以有效实现分级采收。针对上述问题,该研究提出一种级联视觉检测流程,包括采收目标检测、目标果实特性判别、果实与果梗位置关系判断3个关键环节。首先根据农艺要求按成熟度将番茄果实分为4个等级,引入YOLOv5目标检测模型对番茄串和番茄果实进行检测并输出成熟度等级,实现分期采收。然后对果实与果梗的相对位置进行判断,利用MobileNetv3网络模型对膨胀包围盒进行果实与果梗相对位置关系判断,实现末端执行器采摘位姿控制。日光温室实际测试结果表明,本文提出的级联检测系统平均推理用时22 ms,在I(intersection over union)阈值为0.5的情况下,樱桃番茄串与果实的平均检测精度达到89.9%,满足采摘机器人的视觉检测精度和实时性要求,相比末端执行器以固定角度靠近待采目标的方法,本文方法采收效率提升28.7个百分点。研究结果可为各类果蔬采摘机器人研究提供参考。

机器人;目标检测;日光温室;樱桃番茄;YOLOv5

0 引 言

国内鲜食果蔬采摘的人力成本逐年递增[1-2],推动了采摘机器人的快速发展[3-5]。樱桃番茄串中果实成熟时间并不一致,为追求鲜食品质和经济收益,通常要求分期、分级采收成熟果实。为实现自动化的樱桃番茄分期采收,需要采摘机器人不仅能够精准识别、定位每一颗番茄[6],还要求其能够分析番茄成熟度[7],同时规避果梗遮挡等,对机器人的视觉检测系统提出了巨大挑战。

采摘机器人的首要任务是学习农作物的特征信息,发现环境中的目标并完成定位[8-9]。机器视觉算法提供信息的准确性、效率和丰富程度,影响着采摘机器人的决策系统设计和收获效率[10-11]。JUN等[12]使用YOLOv3模型[13]检测番茄,利用深度相机和机械臂完成了实验室条件下的番茄单果采收实验。张勤等[14-15]通过YOLOv4目标检测算法[16]识别番茄串和可采摘果梗的区域,利用深度、颜色等特征信息获得串番茄果梗采摘点,完成了樱桃番茄串采收试验。近年来,为实现分期采收,学者们对番茄成熟度视觉检测方法展开研究。WANG等[17]利用Otsu二值化算法和椭圆模板法自动识别成熟番茄。李天华等[18]将YOLOv4和HSV相结合,以实现自然环境下成熟期番茄的准确识别。BENAVIDES等[19]通过颜色识别与分割获取果梗区域和番茄采摘点位置。单纯通过颜色信息对果实进行成熟度判断,方法简便可行,但颜色阈值设定需要丰富的农业先验知识且单一阈值通常难以应对采摘现场复杂的光照条件。ZHANG等[20]研究了一种改进的深度学习方法,通过少量训练数据即可完成对番茄成熟度判断。AFONSO等[21]采用Mask R-CNN模型[22]检测温室内成熟和未成熟番茄果实,准确率分别达到95%和94%。龙洁花等[23]使用改进的Mask R-CNN完成了温室环境下不同成熟度番茄的分割,在温室种植环境中具有较好的鲁棒性,但Mask R-CNN模型尺寸大、实时性仍有提一定升空间。

收获效率较低是采摘机器人难以迈向商业化的一个因素[24]。国内外学者针对各类番茄的视觉检测方法、机器人采摘应用做了大量研究,然而针对实际生产场景的果实成熟度快速区分相关研究较少,末端执行器执行单果采收时应当如何靠近待采目标也鲜有研究。为更好地完成分期采收、进一步提高串番茄粒收的采摘效率,本文提出一种级联视觉检测流程,包括采收目标检测、目标果实特性判别、果实与果梗位置关系判断环节,并搭建了适配实际生产场景的采摘机器人在日光温室中对樱桃番茄进行自动分期采收试验。

1 基于视觉引导的樱桃番茄采摘流程

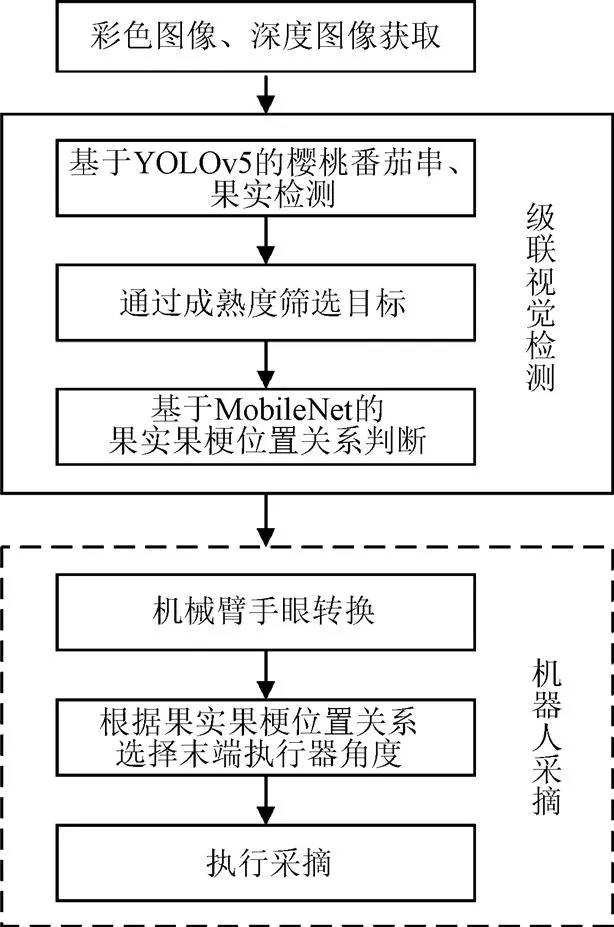

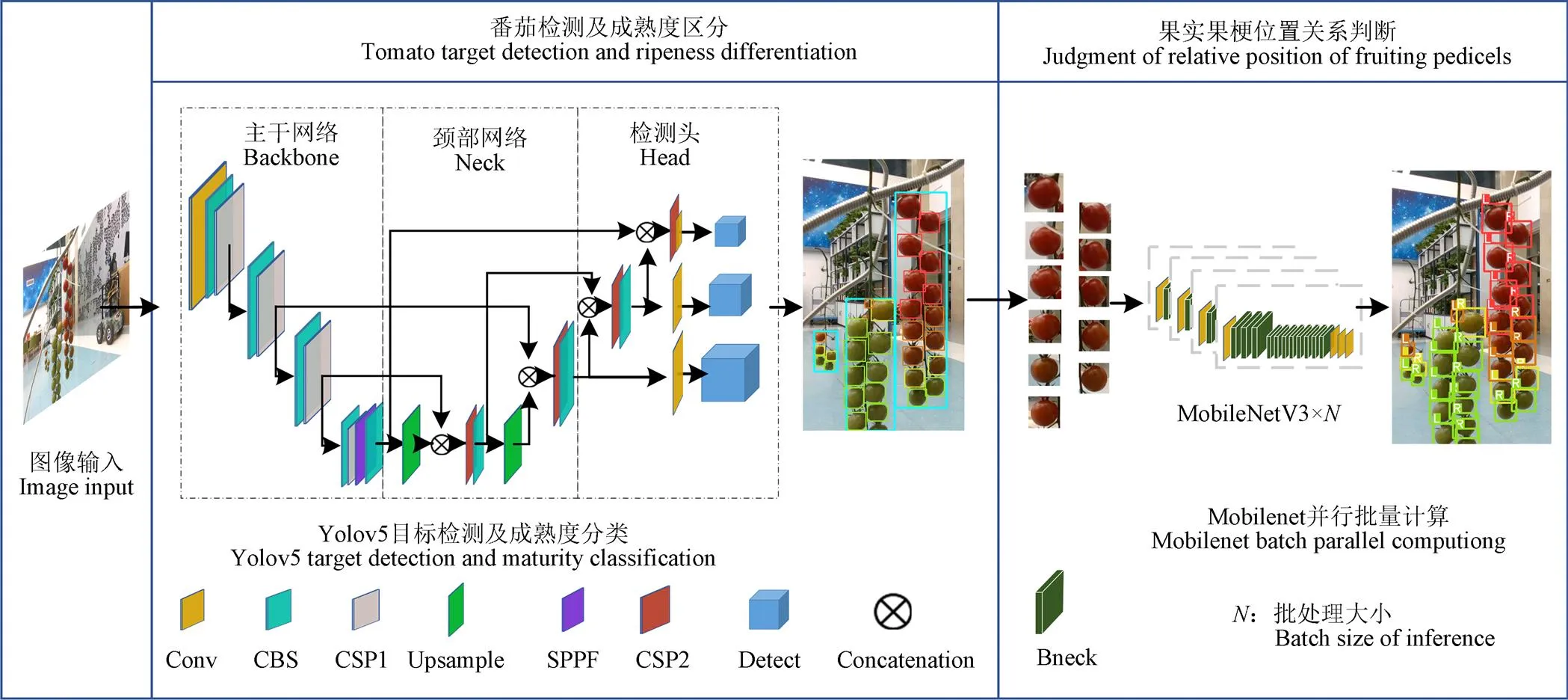

为实现分期采收、提高粒收作业效率,本文提出包括待采目标检测、目标特性判别和果实果梗位置关系判断的检测流程,并设计相应的基于视觉引导的采摘系统,技术流程如图1所示。樱桃番茄果实众多,考虑到机器人检测实时性要求,引入高效的YOLOv5检测模型对樱桃番茄果实进行检测,并输出成熟度信息。根据成熟度、距离等条件完成待采目标筛选后,引入MobileNetv3网络模型进行果实果梗位置关系进行快速判断,为采摘机器人选择接近果实的方向提供依据。

图1 基于级联视觉检测的樱桃番茄自动采收技术流程

2 样本采集与数据集构建

2.1 数据集样本采集

训练集图像采自北京海淀某日光温室番茄培育园中国外某品牌代号“72-008”的樱桃番茄品种。图像采集设备为Intel Realsense D435i深度相机。将两个相机固定于采摘机器人不同位置处,提供多种视野条件。机器人沿导轨匀速移动,相机以固定频率采集RGB图像。数据集中部分图像见图2。

图2 训练集中不同拍摄视角下的样本示例

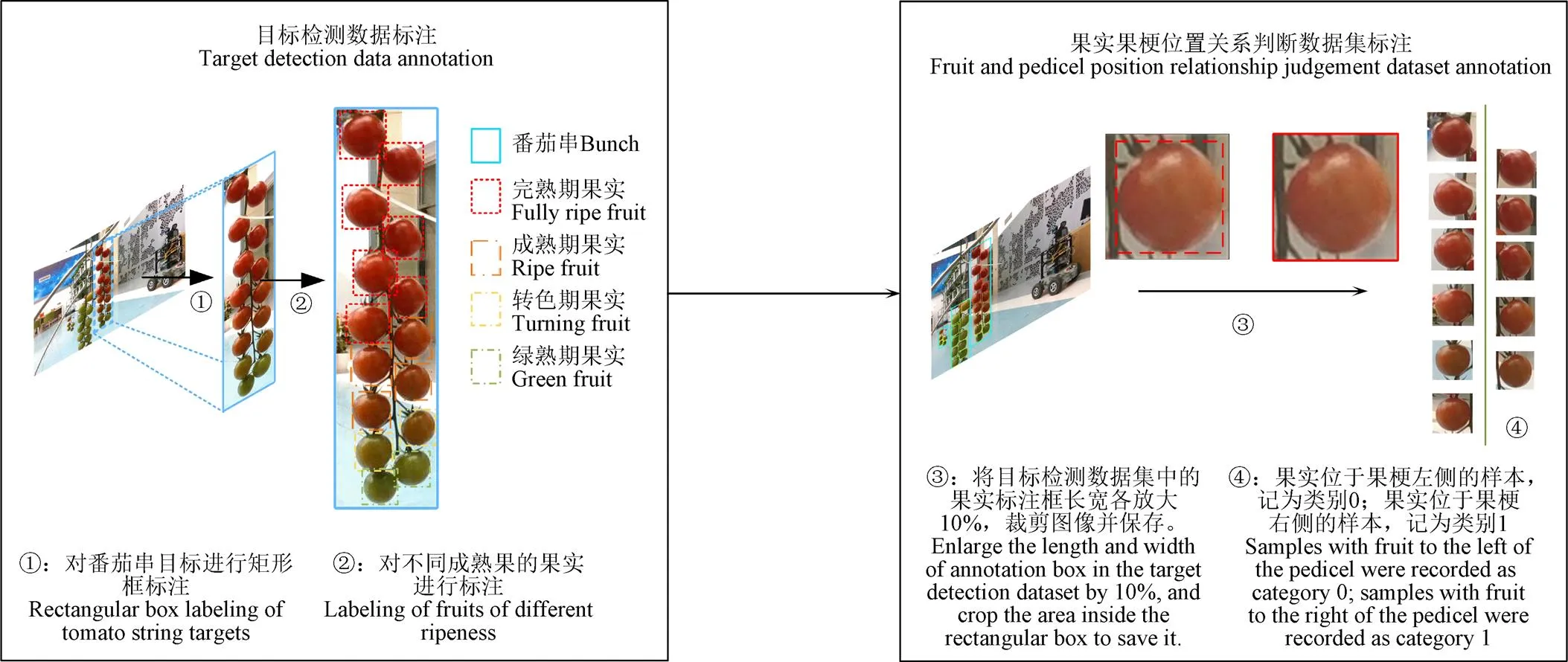

为实现番茄的检测和成熟度快速输出,参考农艺要求将目标分为番茄串和4种不同成熟度[25]的果实,分别为果实充分膨大但果皮为白绿色的绿熟期、果实顶端由白变红的转色期、果实超过四分之三面积为红色或黄色的成熟期以及果实表皮完全变红的完熟期,共5种目标。不同颜色的标注框所代表的目标类型如图3所示。其中绿熟期和转色期果实不是常规意义下的采摘目标,只有成熟期和完熟期的果实需要被采摘。

图3 目标标注和数据集构建流程

2.2 樱桃番茄检测数据集构建

2.2.1 目标检测数据集构建

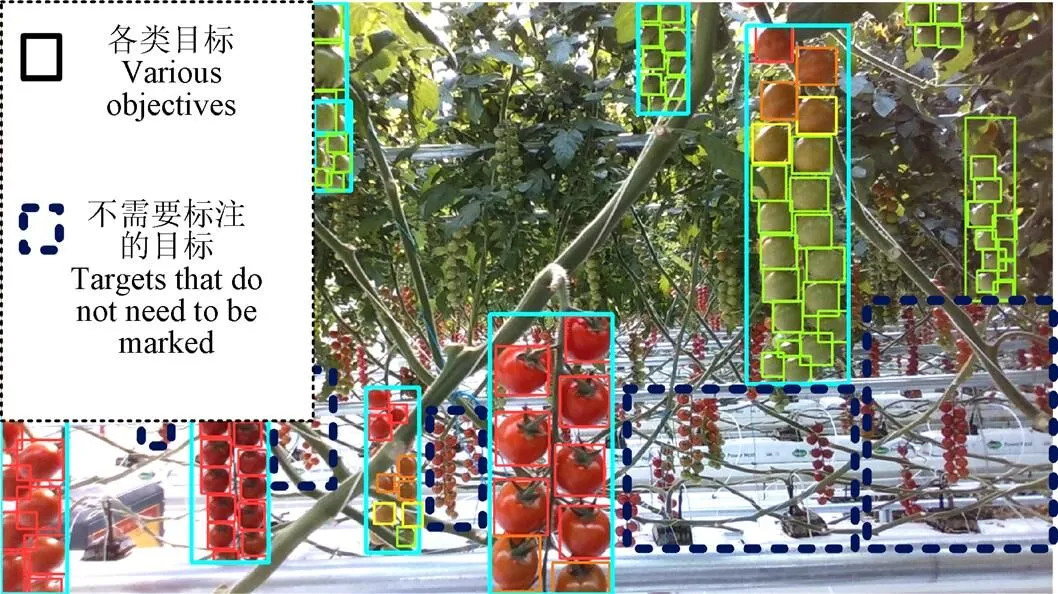

机器人受臂长以及结构限制,仅能采摘当前位置两侧培养架上的番茄,无法“跨垄”采摘。生长在其他培养架上的番茄,如图4中虚线框中的部分所示,在标注阶段无需进行标注。经过挑选和数据清洗,以1 320张图像作为目标检测数据集,包括不含任何目标的背景图像50张,各类目标共计71 123个,平均单张图片包含目标56个。

图4 标注结果展示

2.2.2 果实果梗位置关系判断数据集构建

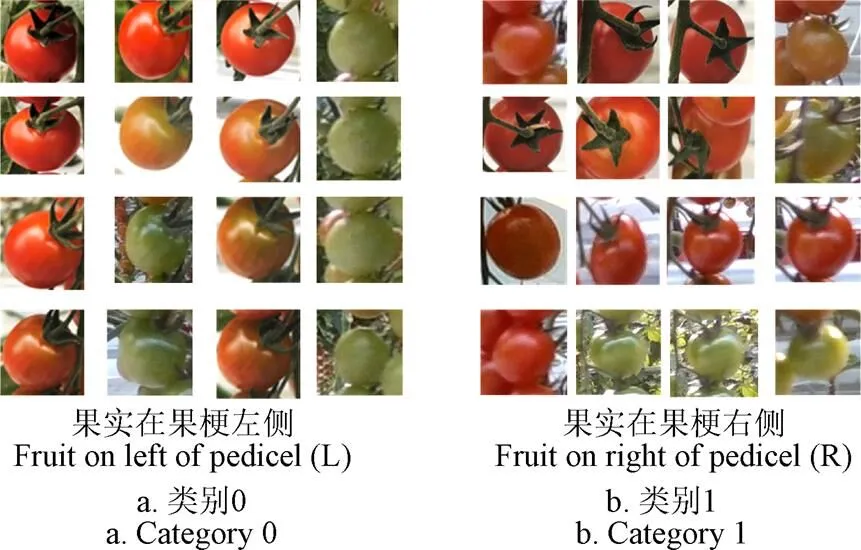

为提高采摘效率,引导末端执行器以合适角度靠近待采目标,需要建立一个果实果梗位置关系判断数据集。利用目标检测数据集中已经完成的果实标注边界框,将长和宽均放大10%,使得目标周围果柄、果萼、果梗等利于判断的关键信息纳入框内,如图3中③所示。裁剪框内图像,构建果实果梗位置关系分类数据集。番茄生产中,工人会去作多余花序和幼果。经过人工“疏花疏果”操作后的果实大多生长于果梗两侧,极少数会成簇生长。为简化后续试验,忽略特殊情况,将位置关系分为2类:果实在果梗左侧记为类别0,如图5a所示;果实在果梗右侧的样本记为类别1,如图5b所示。

图5 果实果梗位置关系分类数据集

3 级联视觉检测方法

3.1 番茄检测与成熟度分析

从画面中检测并识别果实及其成熟度,是实现机器人自动采摘的前提,也是影响采摘效率的重要环节,本文引入YOLOv5目标检测算法一次性快速输出番茄串和果实的目标检测、成熟度水平信息。

3.1.1 基于YOLOv5番茄串和果实目标检测模型框架

YOLO(you only look once)系列目标检测模型是一种单阶段检测模型,相比Mask R-CNN等两阶段检测网络更加轻量、高效,在各类采摘机器人上应用广泛[26-29],易于部署与测试。YOLOv5目标检测模型系列,包括YOLOv5s、YOLOv5m、YOLOv5l等多个在深度、宽度有区分的模型,相比YOLOv3和YOLOV4等作做出了许多工程化应用上的改进,保证精度的同时,提高了推理速度。

YOLOv5模型可以分为主干网络(Backbone)、颈部网络(Neck)和检测头(Head)3个部分,如图6。输入主干网络前,图像被缩放至固定的640×640(像素)大小。主干网络完成特征提取,待进一步丰富特征并转换之后,由检测头部分输出80×80、40×40和20×20三种不同尺度的特征图,在多个特征图上进行边界框预测。经过非极大值抑制部分(non-maximum suppression,NMS)完成对检测框信息的合并、筛选,输出预测框的中心点坐标(,)、高宽(,)、类别()、置信度(C)的预测结果。YOLOv5损失值由3个部分组成,分别为类别损失、置信度损失、定位损失。

3.1.2 基于多任务学习的检测方法改进

多任务学习旨在利用不同任务之间的相似性,同时解决多个不同的任务。与之对应的概念是单任务学习,即将复杂的系统或问题分解为简单且独立的子问题并逐一解决。通常情况下,多任务学习相比单任务学习有着学习效率高、过拟合风险更小的优势。

YOLOv5模型对预测框位置、高宽、类别的学习,属于多任务学习。主干网络对于目标检测任务所提取的轮廓、颜色、大小等特征与成熟度判断任务所需的特征存在重合,为仅使用YOLOv5模型一次完成番茄的检测和成熟度判断提供了理论条件。不同成熟程度的番茄颜色、大小不同,按照各生长阶段特点和农艺要求将果实进行成熟度标注,相比将所有果实均列为一类目标,前者类内差异较小、类间差距大,有利于识别和降低过拟合风险。经过此项改进,YOLOv5模型能够在检测串与果实的同时,输出果实的成熟度分级信息。

另外,采摘机器人仅能对所处轨道两侧的目标进行抓取,无法跨垄采摘,如图7。完成番茄目标检测后,需要滤除生长在其他培养架上的非目标番茄。已知成熟果实可以近似看做赤道直径和极直径为2.5 cm左右的椭球体,培养架垄间距在1.55 m左右,培养架宽0.75 m左右。网络模型输入图像分辨率为640×640(像素)条件下,根据相机针孔模型进行计算和标注结果统计,处于其他培养架上的樱桃番茄单果目标(无法采摘的目标)在输入画面中的像素大小小于10×10(像素)。相机针孔模型描述如下式:

图6 樱桃番茄的级联视觉检测方法示意图

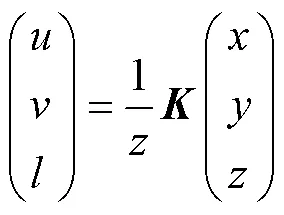

式中(,)为目标像素点在画面中像素位置;(,,)为目标像素点在相机坐标系下的空间位置;为相机的内参数矩阵。

对于这类小目标,即便使用80×80(像素)的大尺寸特征层(即感受野为8×8(像素))仍难以检测。为减少网络对这类不必要的目标计算,可以去掉网络检测头尺寸为80×80(像素)及以上的特征层。在数据标注阶段,无需标注画面中不属于当前培养架上的非待采目标,进一步减少果实样本类内差距的同时,节省大量标注人力(如图4中所示,画面中不属于机械臂工作空间内的番茄(虚线区域内)均未被标注)。

图7 采摘机器人工作空间示意图

3.2 基于MobileNet的果实果梗位置关系判断

樱桃番茄串生长状态各异,面对采摘机器人的角度并不固定。采摘机器人末端执行器以固定角度执行采摘作业面临因果实、果梗干涉导致采摘失败或效率低的问题。如图8a,末端执行器以垂直于培养架的固定角度执行采摘任务,经常与其他果实发生干涉,导致整串番茄发生偏移,需要多次采摘才能成功。在图8b中,使用错误的角度进行采摘,待采果实与末端执行器之间存在果梗遮挡,导致失败。图8c中,末端执行器以合适的角度接近目标,顺利完成果实采摘。因此,在检测阶段应当获取待采摘目标的和果梗的位置关系,指导末端执行器以选择合适角度靠近待采目标,以此提高采摘成功率、效率。

图8 末端执行器方向选择及结果

谷歌MobileNet系列网络作为轻量化网络中的佼佼者,被广泛应用于工业界作为主干网络分类、检测、语义分割等任务。MobileNetv3[30]于2019年发表,综合了MobileNetv1[31]和MobileNetv2[32]的优点,是利用NAS(Network architecture search)方法对网络配置进行调优获得的产物,保持精度的同时进一步提升了速度,适合部署在采摘机器人上。在果实果梗位置关系数据集中训练MobileNetv3网络,使之能够对果实相对果梗的位置做出判断,为机械臂选择接近目标的角度提供依据(如图6中果实果梗位置关系判断环节所示)。

4 基于视觉引导的樱桃番茄机器人采收方法

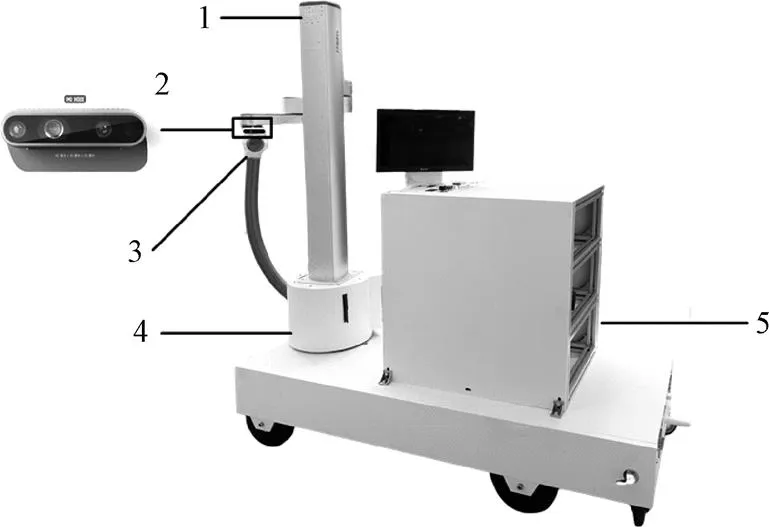

4.1 樱桃番茄采摘机器人系统

为试验搭建的采摘机器人系统如图9所示,该系统由移动平台、机械臂、末端执行器、深度相机和控制器组成。机械臂采用针对温室番茄种植设施高度定制的Z-Arm四轴协作机械臂,最大负载3.5 kg,重复定位精度±0.05 mm,相比六轴机械臂操作更为简便。末端执行器采摘方式为负压吸入,对视觉系统中产生的误差有更好的容错性,采摘同时完成果实收集,存储在移动平台后方的置物箱中。深度相机选择Intel Realsense D435i RGB-D相机,该相机体积小巧、配套资源完备,在20~60 cm范围内能够提供60帧/s的高精度深度信息。控制器安装在移动平台,采用的GPU为NVIDIA Geforce GTX 1050Ti,搭配显示器用于实时关注检测结果。

1.机械臂 2.深度相机 3.末端执行器 4.运动底盘 5.控制器

4.2 目标手眼转换

获得目标在机械臂坐标系下的位置后,驱动机械臂携带末端执行器接近目标在空间中的位置,并执行采摘动作。

5 自动采收系统性能试验

5.1 检测模型训练及性能对比

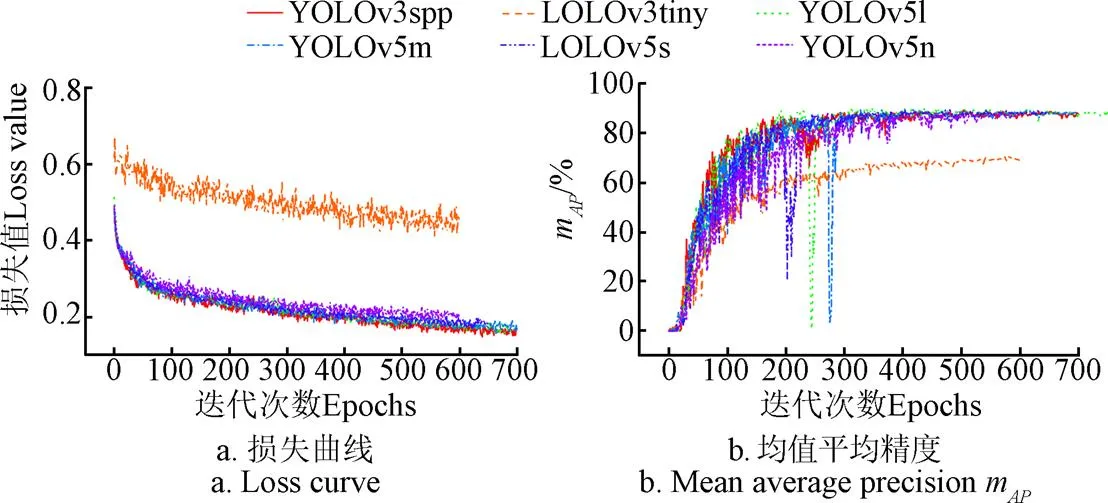

1)网络训练

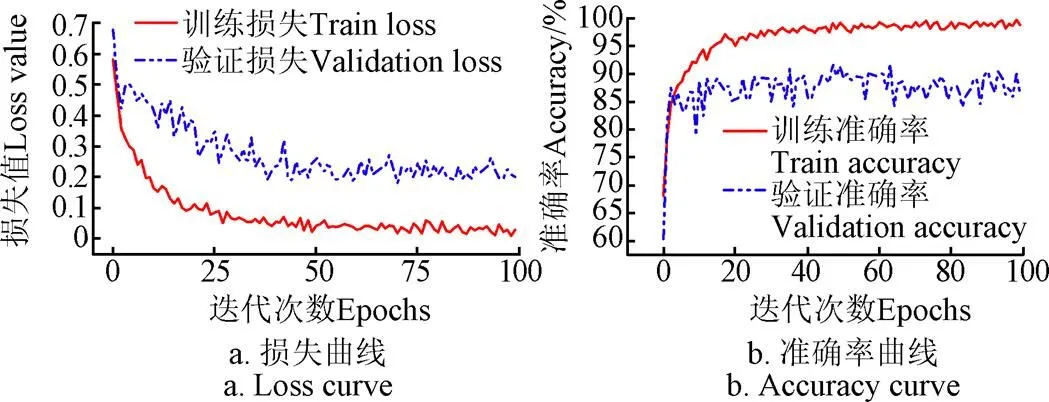

按照8∶2的比例划分樱桃番茄数据集为训练集和测试集,将不同深度的YOLOv5系列模型及YOLOv3系列模型在数据集中进行训练。考虑到不同深度、宽度网络的参数量、浮点运算次数(floating point operations, FLOPs)和占用显存不同,为方便后续对比试验,统一设定批大小为32。根据网络深度和参数量的不同设置初始学习率为0.01,动量设置为0.937,惩罚项设置为0.000 5,迭代最大次数设置为600~700轮。训练期间各网络模型损失变化曲线及均值平均精度m变化曲线如图10a和图10b所示。各模型在前200次迭代中m迅速增加,各项损失迅速减小。大约400次迭代之后,网络各类损失值、m趋于稳定,此时认为各网络模型已完成收敛。

图10 各网络模型在训练集上损失和均值平均精度曲线

2)最优模型选择

为避免信息泄露对模型性能造成影响,拍摄50张独立于训练数据集的图像(包含各类目标共3 753个),作为独立验证集用于检验不同深度和类型网络模型的检测性能,使用准确率、召回率、均值平均精度和1得分量化结果。在Pytorch、TensorRT框架中加载各模型并运行在GPU型号为NVIDIA 2060、GPU1050Ti的工控机中,测试各模型在硬件上的平均推理时间。

各网络模型在验证集上的性能表现如表1所示。YOLOv5n在YOLOv5系列中网络深度最小,在验证集中精度最差。在I阈值为0.5的情况下,YOLOv5n与YOLOv3-tiny与同属于轻量化模型,在验证集中均值平均精度和1值与YOLOv3-tiny相比高2.23个百分点。从训练集上损失曲线图10a中可以发现YOLOv3-tiny相比其他网络损失值更高,意味着无法更深入地拟合目标数据,和验证集中该网络效果最差的结果相吻合,精度过低无法被当前采摘机器人应用场景所接受。YOLOv3系列模型中精度表现最优的YOLOv3-SPP模型[18],在验证集中的表现处于YOLOv5s与YOLOv5m之间,但在所有被测模型之中推理速度最慢。

表1 各网络在验证集的性能测试结果

随着网络深度的加深,网络对目标特征的提取能力和识别能力逐步上升,从网络深度最浅的YOLOv5n到所试验的模型中网络深度最深的YOLOv5l,均值平均精度和1值都在逐步上升。如I阈值为0.5与0.95情况下,YOLOv5s在验证集中的识别均值平均精度较YOLOv5n分别高4.85个和4.92个百分点。但从目前验证集中测试结果来看,网络深度加深和性能提升并不是线性关系,客观存在一个性能瓶颈。如YOLOv5l的计算量为YOLOv5m的2倍以上,但验证集中的精度表现差异较小,仅高0.24个百分点(I阈值为0.5)。推测是因为樱桃番茄单果及串目标特征相对简单,并不需要过于复杂的主干网络即可完成对目标特征的提取。樱桃番茄体积较小,遮挡严重的目标很难被识别,也是导致模型检测结果出现瓶颈的重要原因之一。

由此可以看出,在当前场景YOLOv5s模型相比所提到的YOLO系列其他模型有着计算量更小、精度较高的综合优势,满足采摘机器人对实时性、精度的综合需要,因此本文选择YOLOv5s网络模型作为后续研究和应用的主要模型。

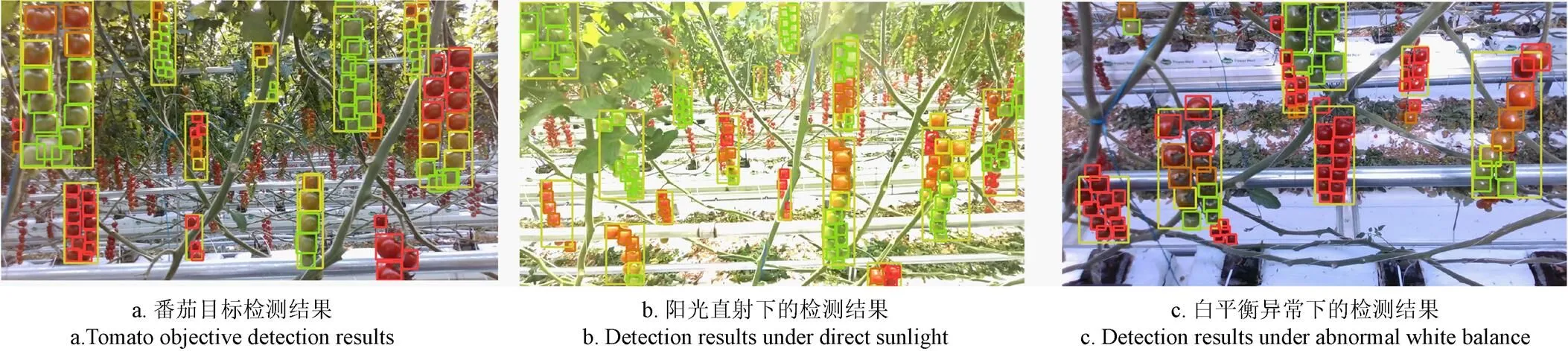

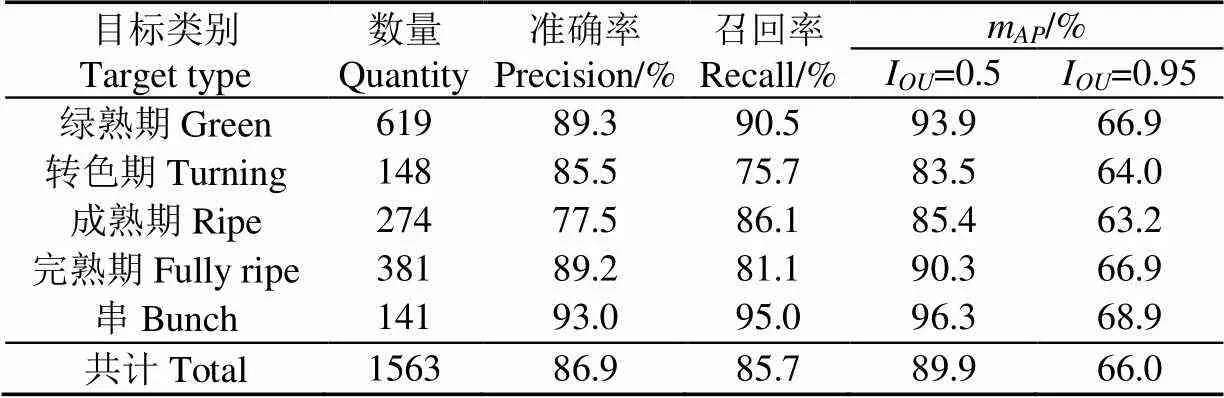

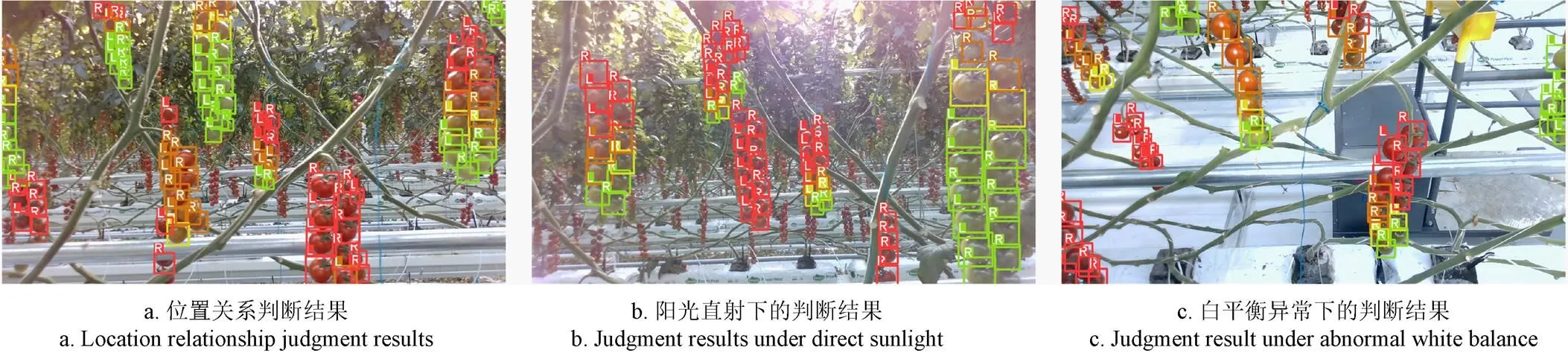

5.2 YOLOv5樱桃番茄及成熟度检测准确率测试

目标检测试验在北京海淀某温室日光樱桃番茄园中进行,采摘机器人在轨道上匀速移动并对待采番茄进行检测。不同光照条件及不同形态樱桃番茄检测结果,如图11所示。可以看出所得模型在常见光照条件及阳光直射、白平衡变化等异常光照条件下对各目标均有着良好的识别效果稳定。同时,检测结果中未包含处于机器人工作空间范围外的无关目标,起到了过滤、筛选的作用。

图11 实际检测结果展示

保留20帧采摘机器人工作时的输入图像,人工标注、统计各类目标的数量及网络模型预测正确率,结果记录在表2。由表2可知,经过调整后得到的YOLOv5s检测模型,在实际场景中,对各成熟度番茄单果和串目标均值平均精度达到89.9%,有着良好的识别效果,单帧推理时间11.5 ms左右(I阈值0.5,GPU 1050Ti,TensorRT7库部署的情况下测得)。

表2 多任务学习思路下改进后的检测模型测试结果

表2表明,经多任务学习思路改进后的YOLOv5目标检测方法能够完成樱桃番茄的检测、成熟度识别与非待采目标过滤。此项改进快捷且有效,在所需要的标注量大幅减少、无需修改网络结构的情况下,模型检测精度得以提升、并能输出高准确率的成熟分级信息,适合采摘机器人运用。

5.3 MobileNetv3判断果实果梗位置关系测试

在果实与果梗位置关系数据集中训练模型并测试网络性能。用于判断果实与果梗相对位置MobileNetv3分类网络损失和准确率曲线,如图12a和图12b所示。迭代25轮后模型的损失值趋于稳定,在验证集中模型准确率处于85%附近。取精度为85%的模型作为在采摘机器人中实际部署的模型,判断结果展示在图13中。改进YOLOv5和MobileNetV3级联模型的单帧推理时间平均为22 ms(MobileNetV3的批处理大小为8,其他参数同5.2节)。其中,“L”代表果实在果梗左侧,末端执行器应当从番茄串左侧进行果实采摘,“R”代表果实在果梗右侧。

5.4 基于视觉引导的采摘对比实验

图14中展示了机器人视角下番茄的几种常见生长姿态。图14a,相机能够直接观察到每一粒果实、果梗、果蒂和果萼,定义为“正面面对(正对)”相机。图14b和图14c中仅能看见部分果梗、果萼,果实之间存在前后遮挡。图14d,此时无法观察到果梗、果萼、果蒂等部分,定义为“背面相对(背对)”。

图12 MobileNetv3网络训练中损失与准确率曲线

图13 果实与果梗位置关系判断结果展示

在以往的研究中,完成对目标位置的获取后,机械臂携带末端执行器以垂直培养槽的固定角度靠近果实,执行采摘动作,完成采摘或进行下一次尝试(方法1)。为避免末端执行器与果实发生摩擦、干涉,通过视觉方法获取果实与果梗的位置关系后,选择从左或从右,更大角度地靠近目标(方法2)。

试验中,设定同样的机械臂速度,约8 s完成一次“机械臂移动-末端执行器动作-保持-机械臂收回”的流程,使用方法1与方法2分别尝试采摘图14中4种不同姿态的番茄,作为对比试验。如果一颗番茄尝试采摘5次均未成功,则认为存在无法采摘的目标,其尝试次数也将计入测试结果中。人工摘除这颗“无法采摘”的番茄,以便机器人继续进行测试。以采摘效率(采摘成功次数与动作次数之比值)和是否存在无法采摘的目标作为评价指标,采摘结果如表3。

由表3可知,串姿态为“背对”情况的樱桃番茄串相对容易被采摘,两种视觉检测引导采摘方法的采摘效率均在85%左右;串姿态为“完全侧对”的樱桃番茄串,方法1的采摘效率最低,仅有16.6%,主要是因为处于串另一侧的果实因果梗阻挡末端执行器无法采摘(情况类似图8b),尝试次数过多导致。方法2因获得果实与果梗的相对位置,能够一定程度上绕开果梗,从果梗对侧方向完成采摘。对于串姿态为“正对”、“轻微侧对”的樱桃番茄串,方法1虽然能够完成采摘,但因缺少目标与果梗的位置关系,采摘过程中末端执行器以固定角度多次干涉果梗或其他果实导致当次采摘失败,效率相比方法2更低。

图14 机器人相机视角下樱桃番茄串的不同姿态

表3 两种视觉引导方式采摘结果对比

末端执行器以固定角度执行采摘,综合效率为47.5%,平均单颗收获时长约为16.8 s;经过判断果梗与果实位置关系后选择方向对目标进行采摘,综合效率为76.2%,平均单颗收获时长10.4 s,相比末端执行器以固定角度采摘的方法,采摘效率高出28.7个百分点,平均单颗收获用时少6.4 s,且不存在“无法采摘”的目标。试验结果表明,本研究提出的基于级联视觉检测的番茄采收方法,在一定程度上减轻末端执行器与樱桃番茄串干涉的情况,提升了采摘效率,有效完成了分期采收。

6 结 论

本研究面向樱桃番茄采摘机器人果实单颗采收的应用场景,提出“采收目标检测-目标果实成熟度判别-果实与果梗位置关系判断”的级联视觉检测流程,并搭建机器人系统,在日光温室场景中进行检测、采摘试验,主要结论如下:

1)基于多任务学习的思路,在数据标注环节进行改进,对樱桃番茄目标按成熟度进行了分类标注、不标注画面中属于机器人工作空间外的樱桃番茄目标。相比常规方法,本方法有着无需修改检测网络结构、所需标注量大幅减少的优势。使用YOLOv5s作为检测网络测试模型,在该项改进下,对绿熟期、转色期、成熟期、完熟期的樱桃番茄和樱桃番茄串5类目标的均值平均精度(I阈值为0.5)值达到89.9%,实现了采摘机器人对樱桃番茄的快速检测、成熟度判断,可为各类基于果蔬成熟度水平进行作业的采摘机器人提供参考。

2)针对采摘过程中,末端执行器容易与樱桃番茄串果梗产生干涉,导致采摘效率、收获率低下的问题,在机器人常规采摘流程中加入果实与果梗位置关系判断环节。试验中,使用正确率为85%的MobileNetv3果实果梗位置关系判断模型的情况下,采摘机器人采摘效率约为76.2%,相比机械臂以固定角度靠近目标执行采摘的方法采摘效率高出28.7个百分点,平均单颗采摘用时为10.4 s,满足采摘机器人对提升抓取效率、分期采收效果的要求,具有一定实用价值。

[1] 朱光磊,裴新伟. 中国农民规模问题的不同判断、认知误区与治理优化[J]. 北京师范大学学报(社会科学版),2021,288(6):127-138.

ZHU Guanglei, PEI Xinwei. The scale of chinese farmers : different judgments, cognitive misunderstandings and governance optimization[J]. Journal of Beijing Normal University (Social Sciences), 2021, 288(6): 127-138. (in Chinese with English abstract)

[2] 蒋和平,王克军,杨东群. 我国乡村振兴面临的农村劳动力断代危机与解决的出路[J]. 江苏大学学报(社会科学版),2019,21(1):28-34.

JIANG Heping, WANG Kejun, YANG Dongqun. Labor crisi and solution in the revival of rural china[J]. Journal of Jiangsu University(Social Science Edition). 2019, 21(1): 28-34. (in Chinese with English abstract)

[3] 刘成良,贡亮,苑进,等. 农业机器人关键技术研究现状与发展趋势[J]. 农业机械学报,2022,53(7): 1-22,55.

LIU Chengliang, GONG liang, YUAN Jin, et al. Current status and development trends of agriculture robots[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(7): 1-22, 55. (in Chinese with English abstract)

[4] ZHOU H, WANG X, AU W, et al. Intelligent robots for fruit harvesting: Recent developments and future challenges[J]. Precision Agriculture, 2022, 23(5): 1856-1907.

[5] Kootstra G, WANG X, BLOK P M, et al. Selective harvesting robotics: Current research, trends, and future directions[J]. Current Robotics Reports, 2021, 2: 95-104.

[6] 王海楠,弋景刚,张秀花. 番茄采摘机器人识别与定位技术研究进展[J]. 中国农机化学报,2020,41(5):188-196.

WANG Hainan, YI Jinggang, ZHANG Xiuhua. Research progress on recognition and localization technology of tomato picking robot[J]. Journal of Chinese Agricultural Mechanization, 2020, 41(5): 188-196. (in Chinese with English abstract)

[7] 伍蓥芮,张志勇,韩小平,等. 基于图像处理技术的番茄成熟度检测研究[J]. 农业技术与装备,2021,376(4):50-51,54.

WU Yingrui, ZHANG Zhiyong, HAN Xiaoping, et al. Research on Tomato Maturity Detection Based on Image Processing Technology[J]. Agricultural Technology & Equipment, 2021, 376(4): 50-51, 54. (in Chinese with English abstract)

[8] 岳有军,孙碧玉,王红君,等. 基于级联卷积神经网络的番茄果实目标检测[J]. 科学技术与工程,2021,21(6): 2387-2391.

YUE Youjun, SUN Biyu, WANG Hongjun, et al. Object detection of tomato fruit based on cascade RCNN[J].Science Technology and Engineering, 2021, 21( 6): 2387-2391. (in Chinese with English abstract)

[9] TANG Y, CHEN M, WANG C, et al. Recognition and localization methods for vision-based fruit picking robots: A review[J]. Frontiers in Plant Science, 2020, 11: 510.

[10] 郑太雄,江明哲,冯明驰. 基于视觉的采摘机器人目标识别与定位方法研究综述[J]. 仪器仪表学报,2021,42(9):28-51.

ZHENG Taixiong, JIANG Mingzhe, FENG Mingchi. Vision based target recognition and location for picking robot: Areview[J]. Scientific Instrument, 2021, 42(9): 28-51. (in Chinese with English abstract)

[11] 李天华,孙萌,娄伟,等. 采摘机器人分割与识别算法的研究现状[J]. 山东农业科学,2021,53(10):140-148.

LI Tianhua, SUN Meng, LOU Wei, et al. Research status of picking robot segmentation and recognition algorithms[J]. Shandong Agricultural Sciences, 2021, 53(10):140-148. (in Chinese with English abstract)

[12] JUN J, KIM J , SEOL J, et al. Towards an efficient tomato harvesting robot: 3D perception, manipulation, and end-effector[J]. IEEE Access, 2021, 9: 17631-17640.

[13] REDMON J, FARHADI A. YOLOv3: An incremental improvement[EB/OL]. arXiv preprint arXiv:1804.02767, 2018.

[14] 张勤,陈建敏,李彬,等. 基于RGB-D信息融合和目标检测的番茄串采摘点识别定位方法[J]. 农业工程学报,2021,37(18):143-152.

ZHANG Qin, CHEN Jianmin, LI Bin, et al. Method for recognizing and locating tomato cluster picking points based on RGB-D information fusion and target detection[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 143-152. (in Chinese with English abstract)

[15] 张勤,刘丰溥,蒋先平,等. 番茄串收机械臂运动规划方法与试验[J]. 农业工程学报,2021,37(9):149-156.

ZHANG Qin, LIU Fengpu, JIANG Xianping, et al. Motion planning method and experiments of tomato bunch harvesting manipulator[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(9): 149-156. (in Chinese with English abstract)

[16] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: Optimal speed and accuracy of object detection[EB/OL]. arXiv preprint arXiv: 2004.10934, 2020.

[17] WANG L L, ZHAO B, FAN J W, et al. Development of a tomato harvesting robot used in greenhouse[J]. International Journal of Agriculture and Biological Engineering, 2017, 10(4): 140-149.

[18] 李天华,孙萌,丁小明,等. 基于YOLO v4+HSV的成熟期番茄识别方法[J]. 农业工程学报,2021,37(21):183-190.

LI Tianhua, SUN Meng, DING Xiaoming, et al. Tomato recognition method at the ripening stage based on YOLO v4 and HSV[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 183-190. (in Chinese with English abstract)

[19] BENAVIDES M, CANTÓN-GARBÍN M, SÁNCHEZ- MOLINA J A, et al. Automatic tomato and peduncle location system based on computer vision for use in robotized harvesting[J]. Applied Sciences, 2020, 10(17): 5887-5908.

[20] ZHANG L, JIA J, GUI G, et al. Deep learning based improved classification system for designing tomato harvesting robot[J]. IEEE Access, 2018, 6: 67940-67950.

[21] AFONSO M, FONTEIJN H, FIORENTIN F S, et al. Tomato fruit detection and counting in greenhouses using deep Learning[J]. Frontiers in Plant Science, 2020, 11: 571299-571311.

[22] HE K M, GKIOXARI G, DOLLAR P, et al. Mask R-CNN[C]. Proceedings of 2017 Conference on Computer Vision (ICCV). Venice: IEEE, 2017: 2980-2988.

[23] 龙洁花,赵春江,林森,等. 改进Mask R-CNN的温室环境下不同成熟度番茄果实分割方法[J]. 农业工程学报,2021,37(18):100-108.

LONG Jiehua, ZHAO Chunjiang, LIN Sen, et al. Segmentation method of the tomato fruits with different maturities under greenhouse environment based on improved Mask R-CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 100-108. (in Chinese with English abstract)

[24] JIA W, ZHANG Y, LIAN J, et al. Apple harvesting robot under information technology: a review[J]. International Journal of Advanced Robotic Systems, 2020, 17(3): 1-16.

[25] 章永年,张任飞,孙晔,等. 局部按压对不同成熟度番茄机械损伤的影响[J].农业工程学报,2021,37(11):292-298.

ZHANG Yongnian, ZHANG Renfei, SUN Guoxiang, et al. Effects of local compression on the mechanical damage of tomato with different maturity[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(11): 292-298. (in Chinese with English abstract)

[26] TANG Y, ZHOU H, WANG H, et al. Fruit detection and positioning technology for aC. Abel orchard based on improved YOLOv4-tiny model and binocular stereo vision[J]. Expert Systems with Applications, 2023, 211: 118573.

[27] 刘芳,刘玉坤,林森,,等. 基于改进型YOLO的复杂环境下番茄果实快速识别方法[J]. 农业机械学报,2020,51(6):239-248.

LIU Fang, LIU Yukun, LIN Sen, et al. Fast recognition method for tomatoes under complex environments based on improved YOLO[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(6): 239-248. (in Chinese with English abstract)

[28] 闫彬,樊攀,王美茸,等. 基于改进YOLOv5m的采摘机器人苹果采摘方式实时识别[J]. 农业机械学报,2022,53(9):28-38,59.

YAN Bin, FAN Pan, WANG Meirong, et al. Real-time Apple picking pattern recognition for picking robot based on improved YOLOv5m[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(9): 28-38, 59.(in Chinese with English abstract)

[29] TIAN Y, YANG G, WANG Z, et al. Apple detection during different growth stages in orchards using the improved YOLO-V3 model[J]. Computers and Electronics in Agriculture, 2019, 157:417-426.

[30] HOWARD A, SANDLER M, CHU G, et al. Searching for mobilenetv3[C]. Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, 2019: 1314-1324.

[31] HOWARD A G, ZHU M, CHEN B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Hawaii: IEEE, 2017: 1704-1712.

[32] SANDLER M, HOWARD A, ZHU M, et al. MobileNetV2: Inverted residuals and linear bottlenecks[C]. IEEE. IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City: IEEE, 2018: 4510- 4520.

Design and experiment of an automatic cherry tomato harvesting system based on cascade vision detection

LI Xingxu1,2, CHEN Wenbai1, WANG Yiqun1, YANG Shun3, WU Huarui2, ZHAO Chunjiang2※

(1.,,100192,; 2.,100097,; 3..,.,100085,)

Cherry tomatoes are a small variety of tomatoes with a shape size of not large than 2.5 cm and mostly grow in bunches. Furthermore, the bunches of cherry tomatoes also grow in variable postures. These growth conditions have posed a great challenge to the harvesting robot at a fixed angle. Once the robots automatically perform single-fruit harvesting operations, the stems can be found to usually interfere with the end-effectors, resulting in low picking efficiency. The reason may be that the picking robots cannot move towards commercialization. Particularly, not all fruits in a tomato bunch grow and ripen simultaneously. It is very necessary to pick the ripe fruits on time, in order to ensure a fresh taste with high economic profits. Therefore, a robotic vision system is highly required to rapidly and accurately identify fruit ripeness. In this study, a cascaded vision detection approach was proposed to harvest the single tomatoes from the robotic spikes. The processing procedure included three key aspects: the detection of the harvesting target, the determination of target maturity, and the fruit-stalk position relationship. Firstly, the YOLOv5 model of target detection was introduced to detect the tomato fruits and bunches. The tomato fruits were labelled into four categories using agronomic growing and harvesting requirements, including green, turning, ripe, and fully ripe fruit. It was totally difference from the simply classified ripeness than before. Among them, the ripe, and fully ripe fruit were targeted for robotic harvesting. The overlap of visual features was then fully considered for ripeness determination and target detection. The original YOLOv5 was improved for ripeness detection using multi-task learning. The robot was confined to only picking the tomatoes on both sides of the culture rack, due mainly to the structure of the greenhouse facility. The target detection was then filtered out for the targets beyond the execution range of the robot. The distance was also set as 1.55 m between the culture racks in this case. The region of interest (ROI) of the target fruit was then approximated as an ellipsoid with an equatorial diameter and a polar diameter of approximately 2.5 cm. The pinhole camera model was used to calculate the ROI picking range. Specifically, the tomatoes growing on the incubator outside the working range of the robot were mostly smaller than the 10 pixel×10 pixel region in the 640 pixel×640 pixel RGB image. At the same time, a large number of feature layers were cropped to choose the unlabeled targets in the annotation stage. As such, better performance was achieved to reduce the labor cost, particularly when filtering the targets without being captured. This end-to-end approach was required without post-processing. It was much more adaptable to real scenarios, compared with the traditional approach of filtering targets by the threshold setting. The field experiments show that the fruit stalk interfering with the end-effector was a major cause of robot picking failure or low efficiency. Correspondingly, the optimal angle was one of the most important parameters for the harvesting action. After the screening of targets to be picked, the target rectangle detection box was enlarged by 10% in length and width, in order to contain the peripheral information, such as pedicels and calyces. The expanded image block was then input into the Mobilenetv3 network model, in order to evaluate the relative position relationship between the target fruit and the fruit stalk. As such, the input was provided for the end-effector to change the picking position, and then choose the direction favorable for the fruit picking, in order to approach the fruit and then perform the action using the pose of the string. A harvesting robot system was also built consisting of a depth camera, a four-degree-of-freedom robot arm, a chassis, and a negative-pressure end-effector. The harvesting system was tested in the greenhouses at different times of the year, particularly for object detection, the prediction of the position relationship between fruit stalks, and fruit harvesting. The results showed that the average detection accuracy of cherry tomato bunches and fruits with different ripeness reached 89.9% with the Intersection over the union threshold of 0.5. The average inference time was 22 ms in the cascade detection system. Furthermore, the harvesting efficiency was improved by 28.7 percentage points, compared with targeting to be picked at a fixed angle. The average time was 10.4 s per fruit for harvesting fruits, indicating the better performance of the improved system. This finding can also provide a strong reference for fruit and vegetable harvesting robots.

robot; object detection; greenhouse; cherry tomato; YOLOv5

10.11975/j.issn.1002-6819.202210099

TP391.4

A

1002-6819(2023)-01-0136-10

李兴旭,陈雯柏,王一群,等. 基于级联视觉检测的樱桃番茄自动采收系统设计与试验[J]. 农业工程学报,2023,39(1):136-145.doi:10.11975/j.issn.1002-6819.202210099 http://www.tcsae.org

LI Xingxu, CHEN Wenbai, WANG Yiqun, et al. Design and experiment of an automatic cherry tomato harvesting system based on cascade vision detection[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(1): 136-145. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202210099 http://www.tcsae.org

2022-10-13

2022-12-26

财政部和农业农村部,国家现代农业产业技术体系(CARS-23-D07);科技创新2030“新一代人工智能”重大项目(2021ZD0113600)

李兴旭,研究方向为智能农业机器人。Email:lixx@nercita.org.cn

赵春江,研究员,研究方向为农业信息技术与精准农业技术体系。Email:zhaocj@nercita.org.cn