基于U-ResNet的机场视频图像能见度检测

2023-03-29王兴隆陈仔燕

王兴隆,陈仔燕

(中国民航大学空中交通管理学院,天津 300300)

1 引言

随着我国高速路网、航空领域的不断发展,国家对于保障人民正常出行、安全出行的需求日益激增,为了更好地保障人民的生命财产安全,保证人们的正常交通出行,对于能见度检测的研究成为了保证高速公路安全行车、航班正常起降不可或缺的一环。目前能见度检测的主要方法有传统检测方法、基于场景深度的方法和基于深度学习的方法,所采用的图像数据,主要来源于相机或视频获取到的图像。

采用传统的图像处理或机器学习等方法进行能见度检测近年来有不少进展。例如,姚镇海等人[1]将高速公路视频图像利用图像灰度值均方差与能见度观测值建立计算模型。孟颖等人[2]将监控视频帧转为灰度图像并结合自适应导向滤波算法和四叉树图像分割算法,提取图像中的空气透射率及大气光值等特征参数,然后依据设备与物的实际距离等估测能见度。郜婧婧等人[3]利用高速公路视频数据,采用霍夫变换提取道路兴趣域,根据亮度对比检测人眼可分辨最远像素点作为标点,最后基于暗原色先验原理求取目标点的透色率,以此得到能见度值。张琼雄等人[4]先是利用Canny算子提取图像的边缘信息特征,然后利用基于边缘存量的神经网络进行能见度的检测,平均误差为9.6%。虽然传统的图像处理和机器学习等方法,对于特定场景的能见度检测有一定的效果,但泛化性较差,不能满足实际应用需求。

若已知拍摄相机或图像内物体位置等数据时,可用基于景深等方法对能见度进行检测。例如,周凯等人[5]利用暗通道估计大气透射率并计算景深信息,再结合最小图像熵计算得出能见度值。徐敏等人[6]首先对图像进行特征提取、阈值分割和形态学处理,然后利用大气退化模型和暗通道原理估计透射率,再利用同一场景不同角度两幅图像的像素突变点和摄像机内部参数估计景深得到大气消光系数,以此估计图像的能见度。基于景深的方法与相机的位置或图像中物体的位置有着明确的依赖关系(依赖摄像机内部参数等),计算起来也相当复杂,且不利于场景转换的能见度检测。而且大部分设备(例如激光能见度仪)存在检测能见度方面对团雾检测精度不高、检测范围小、覆盖成本高的问题。

近年来,深度神经网络[7-11]已经成功地应用于图像识别、目标检测、语音识别、机器翻译、自动汽车驾驶、目标追踪和生物信息学等多个领域[12],越来越多的研究人员开始认识到深度学习的强大性能和优势。例如,厍向阳等人[13]基于改进的残差网络(Residual Network,ResNet)对小型车辆目标进行检测,并表现出了良好效果。但是,国内外学者较少地将深度学习应用于机场能见度检测。

为了解决传统方法泛化性差、场景深度计算方法的设备费用高等问题,和利用深度神经网络的强大学习能力,本文基于气象光学视程提出了一种基于U型深度残差网络(U-ResNet)的机场能见度检测模型。U型网络可以有效融合图像的不同尺度的特征信息图。ResNet不仅能够加速超深神经网络的训练,而且可以大幅提升深度网络的准确率[12]。本文利用U-ResNet得到带有能见度信息的特征图,再与Koschmieder定律相结合计算能见度值。这种方法能够将深度学习模型与理论定律方法有效地结合起来,提高能见度检测的准确率。利用机场视频图像数据多次迭代训练模型后得到一个良好的能见度检测模型。最后,将该模型用于自定义的视频图像上进行机场能见度的检测,取得了不错的效果。

2 相关理论与方法

2.1 能见度检测原理

气象光学视程(Meteorological Optical Range,MOR)是指色温为2700K的白炽灯发出的平行光束的光通量在大气中衰减降低到它起始值的5%的距离[14],并且MOR可以根据Koschmieder定律[15]计算得到。Koschmieder定律如下

F=F0e-σz

(1)

式中,F为背景于目标物体的相对亮度差,以此体现观测的光照强度。F0表示入射的光照强度,为常数。σ为衰减系数,与雾的厚度有关。σ越大,表示雾越浓。z为观测员距离目标物的距离,可表示为MOR。则

(2)

由此可见,MOR的估计关键在于求得衰减系数σ。

2.2 U型网络

U型网络(U Network,U-Net)[16]是比较早使用全卷积网络进行语义分割的算法之一。U取自于该模型包含压缩路径和扩展路径的对称U形结构,如图1所示。

图1 U型网络架构[16]

网络输入一张572×572的图像,输出为388×388的分割结果图。具体地,输入图像经过多层下采样卷积模块得到尺度为28×28的特征图,然后由多层上采样反卷积模块恢复图像特征维度的同时提取特征信息。图中灰色箭头称为跳跃连接(Skip Connection),每次下采样都会有一个跳跃连接与对应的上采样进行级联,这种不同尺度的特征融合对上采样恢复像素大有帮助。原因是高层(浅层)下采样倍数小,特征图具备更加细致的图特征,底层(深层)下采样倍数大,信息经过大量浓缩,空间损失大,但有助于目标区域判断,当高层与底层的特征进行融合时,感受野效果往往会非常好。因此,结合U-Net网络结构优势,设计本文模型最后输出带有能见度信息的特征图。

2.3 残差网络

残差网络(ResNet)由何恺明等人[11]在2015年提出,ResNet的基本组成部件为残差单元(ResNet Unit),解决了过拟合、梯度爆炸或消失等一系列深度学习重要问题,影响至今。

图2 残差单元

如图2所示,ResNet Unit分为两类,但都由卷积(Convolution,Conv)核、批处理归一化(Batch Normalization,BN)和线性整流函数(Rectified Linear Unit,ReLU)堆叠而成。设第n个ResNet Unit的输入为xn,则当前ResNet Unit的输出xn+1由式(3)计算得到:

xn+1=f(F(xn,Wn)+xn)

(3)

其中,F(xn,Wn)为残差函数;Wn是F(xn,Wn)对应的权值参数;f(·)是非线性激活函数ReLU。对于图像深层特征的提取与保留,ResNet有着非常好的效果。

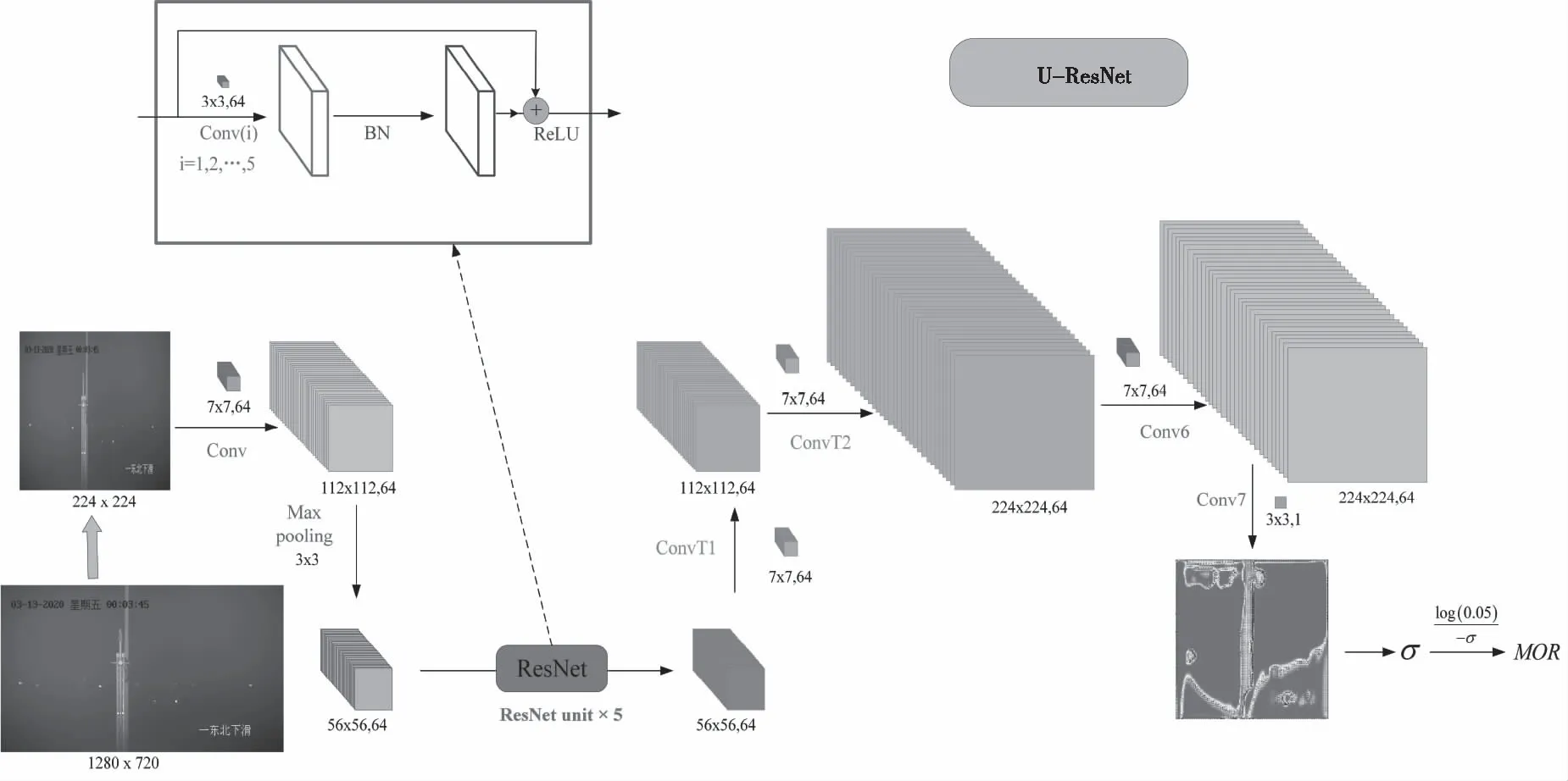

3 U-ResNet

3.1 基本思想

对于能见度检测问题,由于传统的图像处理和机器学习等方法的泛化性差,和场景深度计算方法的设备费用高等问题,本文提出了一种简单而有效的U型残差网络模型(U-ResNet)模型用于机场视频图像的能见度检测。如图3所示,U-ResNet减少了原有U-Net网络中过多的上、下采样,并在提取特征保持维度的部分采用ResNet的残差模块,通过残差学习模块避免卷积神经网络过深而导致模型退化问题,从而寻求最优的深度卷积神经网络模型。U-ResNet输出的是带有能见度信息的特征图,再与Koschmieder定律相结合即可计算得到MOR。

图3 U-ResNet网络结构

3.2 网络架构

能见度检测属于回归性任务,而U-Net主要用于图像分割,ResNet被用作目标分类、检测等任务图像特征提取的骨干网络,Koschmieder定律是被大家认可的用于计算MOR的理论方法,本文所提出的U-ResNet模型有效地将这4者融合到了一起。总的来说,本文以U-Net为基础框架进行改进对机场视频图像进行下采样和上采样(逆卷积,Transposed Convolution,ConvT)提取图像特征和输出带有能见度信息的特征图;网络深层图像特征提取部分采用了5个ResNet Unit,用于深入挖掘图像中各种特征信息。ResNet Unit中以跳跃特征层的方式连接不同感受野的特征图,这样可以简化网络结构并更加均匀化,从几何角度理解就是设计了一个更为优化的平直的流行,使得网络收敛性更好,从而能够避免网络优化时发生退化和爆炸等问题;此外,5个堆叠式的ResNet Unit设计,可以线性增强网络提取到的特征信息;U-ResNet输出带有能见度信息的特征图,并采用平均池化(Average Pooling)方法得到σ为衰减系数,最后根据Koschmieder定律可以计算得到机场的气象光学视程(MOR)。U-ResNet是有较强学习能力的全卷积网络和公认的Koschmieder定律的有效结合,可以根据不同场景的视频图像数据学习到不同的网络参数,可以实现端到端学习,该网络泛化性强,成本低,不依赖高精度的相机设备。

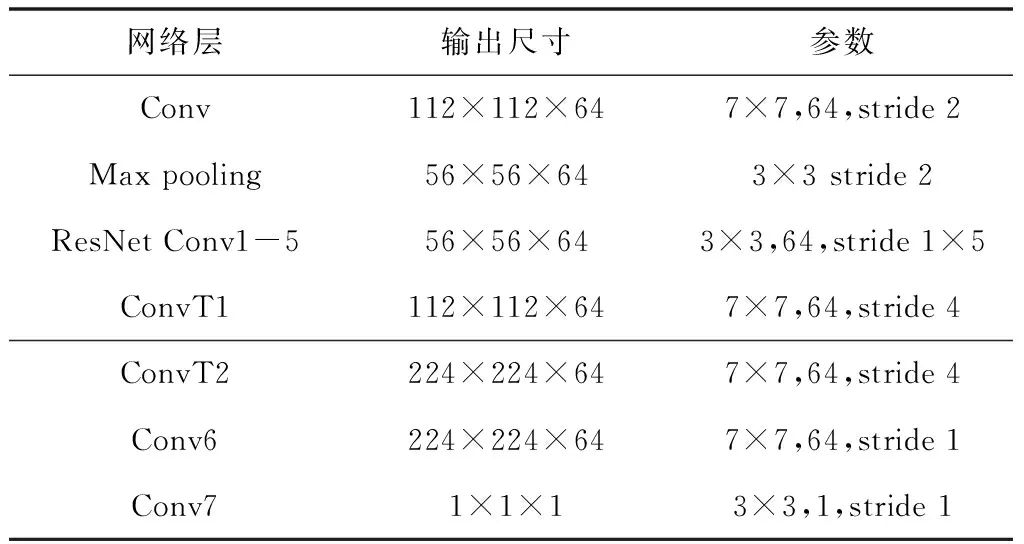

表1 U-ResNet详细信息

U-ResNet模型架构细节如表1所示。首先,将原始图片大小为1280×720的灰度图像,转换成224×224维度的RGB图像。将图像的输入像素点作为矩阵的元素,可以构建一个224×224的矩阵T(i,j),i,j=1,2,…,224。再将待处理图像经过Conv卷积模块得到64张112×112维度的特征图。通过最大池化(Max Pooling)将特征图维度压缩到56×56。然后,经过下采样得到的特征图作为ResNet的输入,ResNet由5个相同的残差单元(ResNet Unit)组成。ResNet Unit中Conv1-5卷积核大小均为3×3,采用ReLU作为非线性激活函数。ResNet的输出经过两次反卷积模块ConvT1和Conv2,64个特征图维度会恢复到224×224,并且再利用Conv6卷积模块进行特征的保留与提取。最后,维度为224×224×64的特征图被Conv7卷积模块提取特征并压缩成1×1×1带有能见度信息的特征图。通过带有能见度信息的特征图F,定义如下公式可求得衰减系数σ

(4)

再根据式(2)可以计算得到MOR的能见度估计值MOR′。U-ResNet网络的损失函数采用MOR′与真实值MOR差值的绝对值,如式(5)所示。以降低损失函数值为目的,优化器选择Adam[17],通过梯度下降来不断优化模型参数,使模型估计越来越准确。

(5)

其中,n为一批图像数量(Batch Size)。

3.3 度量指标

机场能见度检测估计属于回归任务,为了验证模型得到的能见度估计值的精度,本文采用决定系数R2作为评估能见度精度的度量指标,来判断U-ResNet的能见度检测估计值与真实值的拟合程度,如式(6)所示。

(6)

此外,本文仍采用平均相对误差ε来体现U-ResNet对于机场能见度检测估计的好坏情况,如式(7)所示。

(7)

其中,N为机场视频图像样本的总数量。ε值越小说明U-ResNet的能见度检测结果越接近真实值。

4 实验结果与分析

本文在一个机场视频数据集上对所提出的U-ResNet模型的性能进行了实验评估。首先给出了数据集的介绍,然后提供了模型的实验设置等情况,最后利用度量指标来衡量模型的实验结果。

4.1 实验环境与数据集

本文所使用的视频数据是某机场利用R06气象观测站架设的高清视频监控设备在雾天天气所采集到的,时间为2020年3月13日00:00:26开始至11:47:48。由于07:59:45后没有标签(没有MOR真实值),本文将2020年3月13日00:00至07:59时间段的数据作为实验数据。首先,将机场视频提取为一帧一帧的图像。然后,本文将这个时间段的图像数据按照8:2比例分为训练集和测试集,采用式(5)优化模型,使用决定系数R2验证模型并保留最优的模型参数。具体数据集划分情况如表2所示。实验参数设置如表3所示。实验环境如表4所示。

表2 实验数据划分情况

表3 实验参数设置

表4 实验环境

4.2 机场能见度检测结果与分析

经过视频取帧处理后,本文选取北京时间2020年3月13日0:00至3月13日7:59的1474张机场视频图像作为训练集样本,369张作为测试集样本,对基于视频数据的U-ResNet模型进行训练和测试。U-ResNet网络训练过程的损失函数loss值如图4所示。

由图4可知,损失函数loss值随着迭代次数逐渐减小,偶尔存在少许的波动。损失值逐渐减小的趋势表明U-ResNet模型在不断优化。如图5所示,是U-ResNet对于测试集机场能见度检测的衰减系数σ值。如图6所示,是MOR真实标签值与U-ResNet检测估计值的对比。

图4 U-ResNet训练时的loss值

图5 测试集的衰减系数σ

图6 MOR真实标签值与U-ResNet检测估计值

由图5、6分析可知,基于U-ResNet模型机场能见度的估计值与样本数据真实值变化趋势一致且偏差很小,并且衰减系数σ的变化趋势与能见度的估计值和真实值的趋势相一致,σ的变化趋势满足Koschmieder定律。由此可以说明基于视频数据的U-ResNet模型的能见度估计的效果趋势是可靠的。为了验证U-ResNet模型估计的能见度精度情况,本文对测试集计算了决定系数R2和平均相对误差ε,结果如表4所示。

表5 U-ResNet能见度估计的度量指标

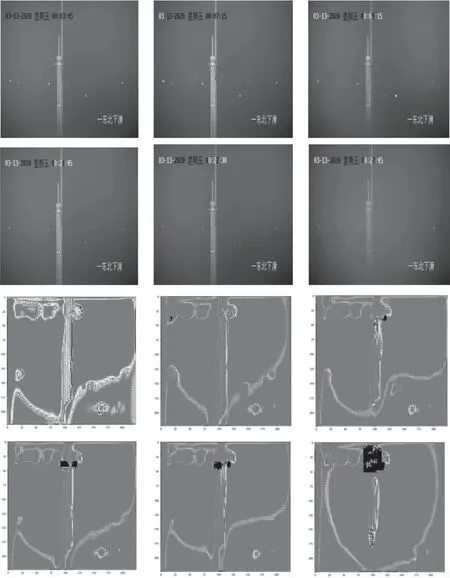

决定系数R2值在0.98左右,平均相对误差ε在0.08,说明U-ResNet对于机场能见度检测估计值与真实标签值非常接近,体现出了模型精度的优异性能。此外,本文随机选取了6张MOR不同档次(1600、1000、900、500、450、40)的机场视频图像,并用训练好的U-ResNet模型输出带有能见度信息特征图,如图7所示。

图7 带有能见度信息的特征图可视化

由图7可知,随着时间的推移,能见度越来越低。第一张图中可以看到机场信号塔柱的轮廓,随着能见度加重,能见度则越来越低,物体的轮廓也越来越模糊。此外,随着时间的推移,图中黑色的阴影部分越来越大,在原图中对应着时间的位置,说明U-ResNet模型能够感知到时间与能见度信息的相关变化,综合了图像能见度信息特征和时间序列信息的多模态信息特征。

5 结论

本文提出了基于U-ResNet的机场视频图像能见度检测模型,避免了传统方法和场景深度方法所带来的泛化性差、精度不高、成本较高等问题,并且能够有效解决从视频图像数据到气象光学视程(MOR)不同模态结合的端到端学习。实验结果表明,本文所提模型在跨度较大的MOR情况下有较好的检测估计表现,带有能见度信息的特征图、衰减系数估计值等体也现出了U-ResNet模型中间环节的性能情况。