区域增强和多特征融合的X光图像违禁品识别

2023-02-21韩萍杨慧方澄

韩萍,杨慧,方澄

中国民航大学智能信号与图像处理天津市重点实验室,天津 300300

0 引 言

X光安检机广泛应用于机场、火车站、地铁站等交通运输和各种大型公共活动场所,是维护公共安全和运输安全的重要设施。旅客行李通过X光机扫描并实时产生安检图像,安检员通过检查安检图像判断行李中是否存在违禁品,从而保障公共安全(Mery等,2017)。然而,人工检查机制存在漏检和错检的风险(侯彦伊,2018)。对X光安检图像中的违禁品进行智能识别具有重要的现实意义。

X光安检图像违禁品的识别旨在判断X光图像中是否存在违禁品及违禁品的类别。随着深度学习的发展,违禁品智能识别多依赖于基于深度学习的智能识别算法,Akça等人(2016)将卷积神经网络(convolutional neural networks,CNN)应用于安检图像研究,采用迁移学习和视觉词袋模型(bag of visual word,BoVW)(Batan 等,2011)检测含有枪支的安检图像取得了较好结果。该研究表明,卷积神经网络方法明显优于传统方法。随后出现了更多的采用深度学习方法进行检测的研究(Jaccard等,2017;Zhao等,2018;Morris等,2018)。Caldwell等人(2017)研究了卷积神经网络在不同X光数据集训练模型的泛化能力。首先用X光货物数据集训练网络,然后用X光包裹数据集测试,但效果并不理想,当采用两个数据集的样本训练时,模型性能得到很大改善。该研究表明,CNN很难识别与训练数据来源不同的目标数据。近期,一项较有影响力的研究公开了大规模安检图像数据集SIXray(Miao等,2019),并针对数据集类别极不平衡和背景复杂的特点提出了类不平衡分层细化(class-balanced hierarchical refinement,CHR)的方法,该方法提高了模型的精度与速度,有效缓解了数据类别不平衡导致的识别性能下降问题。

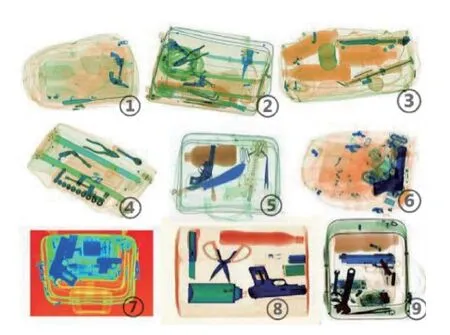

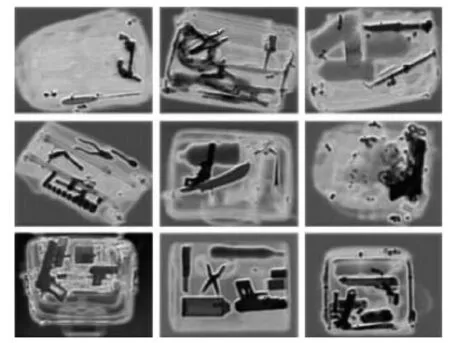

智能识别模型需要在大量有标注的X光图像训练集上学习得到,然后根据模型在测试集上的表现验证识别性能,当前的识别模型仅适用于测试集与训练集保持同一分布的数据(何彦辉 等,2021)。本文在实验中发现,当测试集中出现与训练集图像颜色分布不一致的含有违禁品的X光图像时,即便是人工很容易识别的违禁品,模型都难以正确识别。实际上,数据集不同分布的情况在实际应用场景下表现得更为突出,安检设备采用双能量X射线成像技术,使扫描可以根据物体的有效原子序数呈现不同颜色。例如,金属显示为蓝色,有机物显示为橙色等,随着技术的发展,安检设备不断更迭,各站点使用的安检设备都不完全相同,由于不同安检设备应用不同的图像处理方法,采集到的图像颜色分布存在较大差异。如图1所示,①和⑤均含有手枪类违禁品,在X光扫描后呈现蓝色,但二者的蓝色存在一定差异。同时,旅客行李中物品种类繁多,所成X光图像颜色丰富,由图像颜色分布差异引起的识别性能下降问题对安检系统的智能化造成挑战。因此智能识别模型应既能适用于各种设备采集的X光安检图像,又能利用安检图像的多彩颜色特征,解决混乱复杂导致图像中的违禁品易与相同材质的其他物品混淆的问题。

图1 不同颜色分布安检图像样例

针对以上问题,本文提出一种区域增强和多特征融合模型(region enhanced multi-feature fusion model,REMF),融合了颜色和边缘等更多元化的信息,实现了对物品杂乱的X光行李图像中的违禁品进行识别。本文主要贡献如下:1)定义了一种区域增强特征。特征提取器应用注意力机制的思想通过学习训练集样本的整体分布,将注意力集中在图像中的违禁品部分。区域增强特征可消除颜色分布不同的影响,保留图像几何结构并对违禁品区域进行增强,突出违禁品的形状信息,提高模型对不同颜色分布的X光图像的泛化能力。2)采用多特征融合策略。安检人员检查X光行李图像通常是在颜色信息的基础上通过观察物品呈现的形状轮廓进行判断,因此图像的颜色、形状和轮廓信息都具有重要意义。本文将彩色特征、边缘特征和区域增强特征进行集中式融合,并且在3种特征上增加可调权重参数,使不同特征发挥各自优势,得到更加丰富的特征信息,提高模型在图像中物品混乱复杂情况下的鲁棒性。3)根据本文方法多特征的特点引入一种三元损失函数,引导特征自适应融合。三元损失函数由融合损失、边缘损失和区域增强损失组合而成,通过设置3种损失的权重,引导模型通过调整特征权重参数更好地进行特征融合。

1 相关基础理论

1.1 注意力机制

注意力机制(attention mechanism)是深度学习领域中广泛应用的一种思想(Xiao等,2015;Vaswani 等,2017;Wang等,2017),借鉴了人类在感知事物过程中的思维方式。人眼在扫过视野范围时可以迅速获取需要关注的目标区域,极大提高视觉信息的处理效率及准确性。注意力机制通常以加权的方式实现,其计算式为

A=F(X)

(1)

XA=A⊗X

(2)

式中,X∈RW×H×C表示输入特征图,F(·)为由神经网络构成的注意力模块,A为注意力权重,⊗表示将权重赋予输入特征图的操作,包括矩阵数乘或点乘,XA表示输出特征图。

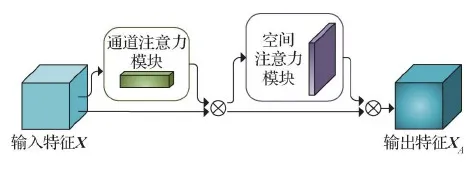

注意力机制按照特征的不同维度可以分为通道注意力和空间注意力(刘可文 等,2020),CBAM(convolutional block attention module)方法(Woo等,2018)将通道注意力与空间注意力串联起来,相比于仅关注通道域,CBAM可以达到更好的效果,其框架如图2所示。

图2 CBAM结构图

通道注意力模块和空间注意力模块的处理过程为

FC(X)=σ(MLP(fAvgPool(X))+MLP(fMaxPool(X)))

(3)

FS(X)=σ(Conv([fAvgPool(X);fMaxPool(X)]))

(4)

两个注意力模块在训练中学习寻找输入特征中需要关注的部分,输入特征X在经过注意力模块加权后得到输出特征XA,XA相较于X在通道和空间维度的关键部分增强,噪声与其他无意义信息减弱,注意力机制的引入提高了模型的学习效率。

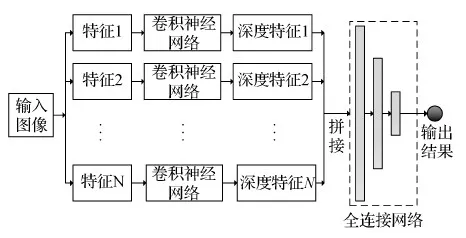

1.2 多特征融合

生活中的图像较为复杂,仅依赖某种特征进行判断往往无法达到很好的效果,需要将蕴含各种信息的特征融合,发挥其优势,提升模型性能。特征融合分为分布式融合和集中式融合。分布式融合先根据不同的特征集指定个体决策,然后将其组合到一个决策中。集中式融合先将不同的特征进行同化处理后集成到一个决策中,再根据任务需求进行特征选择。对于不同表现方式的特征,集中式融合方法既不会在融合过程中损失或破坏原有的特征信息,又能将不同特征的优势结合起来。Liu 等人(2019)提出的回归模型采用了集中式融合方法,其结构如图3所示。首先,对输入图像进行不同特征的提取,得到N种不同表现方式的特征,记为特征i,然后将其送入卷积神经网络提取相应的深度特征,记为深度特征i,将深度特征i进行拼接后送入全连接网络进行特征分析与选择,最后根据任务需求得到输出结果。

图3 集中式融合结构图

2 本文方法

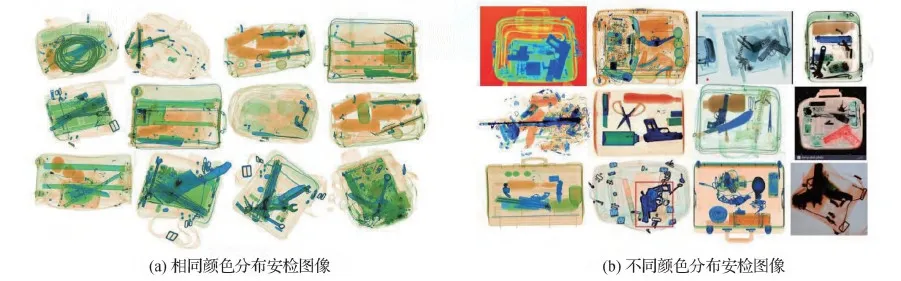

不同安检机生成的图像颜色分布存在偏差,如图4(b)所示。当出现与训练集颜色分布不同样本时,智能检测效果会受到影响,意味着当前的智能方法在识别违禁品时过多依赖了颜色信息。因此在设计违禁品智能识别算法时,需加强能够区别违禁品与其他物品除颜色以外的特征。安检人员检查X光图像时,通常根据颜色信息判断物体材质,并在此基础上通过观察物品的形状轮廓来判断物品类别。因此,颜色、形状和轮廓都是违禁品识别的重要信息。基于上述分析,本文提出了区域增强和多特征融合模型REMF,应用注意力机制设计一种像素级的区域增强特征,消除图像颜色分布差异的影响,增强违禁品区域信息,在保留图像几何结构的同时凸显违禁品的形状,将彩色特征、边缘特征和区域增强特征进行集中式融合,通过三元损失函数对特征融合进行优化。

图4 相同颜色分布和不同颜色分布安检图像样例

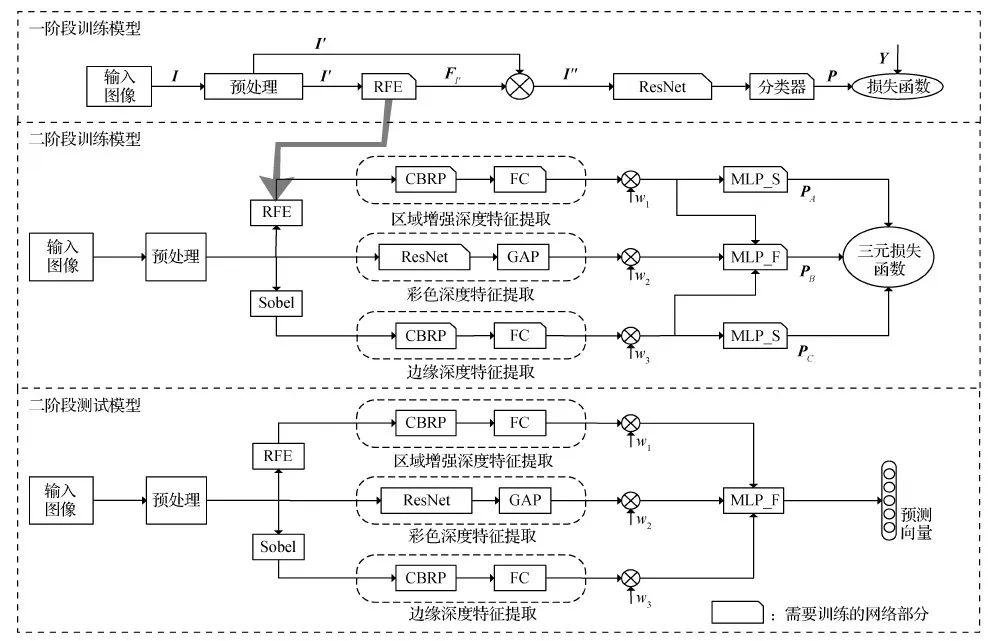

本文方法分为两个阶段,一阶段模型的训练可以得到区域增强特征提取器(region-enhanced feature extractor,RFE),二阶段模型融合了多种特征并完成违禁品识别任务。本文方法的实现分为训练过程和测试过程。训练时需训练一阶段模型和二阶段模型;测试时仅需将图像输入二阶段模型中进行违禁品识别。REMF方法结构如图5所示。

图5 REMF方法框图

2.1 一阶段模型

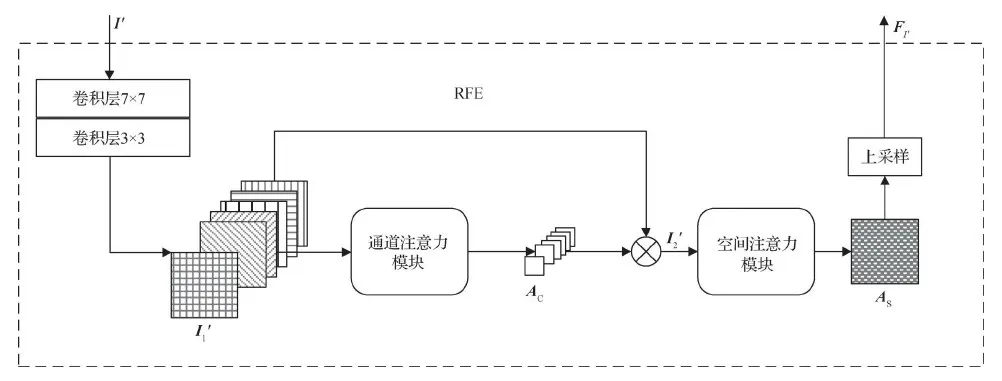

2.1.1 RFE模块

RFE模块采用CBAM的注意力结构,如图6所示。通过归一化和标准化预处理后的输入图像I′∈RW×H×3(W和H分别为I′的宽和高),通过两层卷积操作,得到尺寸为W/2×H/2、通道数为32的特征图I′1,将其输入通道注意力模块,得到尺寸为1×1、通道数仍为32的通道注意力掩码AC,表示各个通道特征的权重系数;将AC与I′1按照对应通道相乘得到新的特征I′2。将I′2输入空间注意力模块,得到尺寸为W/2×H/2、通道数为1的空间注意力掩码AS,采用双线性插值的方法对其进行上采样,使之与输入图像尺寸相同,得到区域增强特征FI′。

图6 RFE模块结构图

区域增强特征的本质为输入图像的注意力分布掩码,每个数值表示图像中对应像素的重要程度,图7为图1的可视化区域增强特征图。与图1对比可以看出,区域增强特征图消除了颜色分布不同的影响,可以很好地保留图像的几何结构,违禁物品区域相较于背景和其他物品得到明显增强。

图7 不同颜色分布的安检图像区域增强特征样例

2.1.2 一阶段模型结构

在一阶段模型中,输入图像I通过预处理后得到I′,将I′送入RFE模块进行特征提取,得到像素级区域增强特征FI′∈RW×H×1,将FI′与I′的每个通道按照对应位置相乘得到I″。将I″送入ResNet模型(He等,2016)进行深度特征提取,后接全连接分类器得到预测向量P,即每类违禁品存在的可能性。标签向量Y表示该图像中每类违禁品是否存在,采用交叉熵损失函数(Rubinstein,1999)计算预测向量P与标签向量Y的损失,通过反向传播更新模型参数进行训练,当损失不再下降时终止训练。一阶段模型的训练调整了RFE模块的参数,使之能够找到图像中与识别结果重要相关的区域。由于第2阶段模型结构中RFE模块不再对输入图像进行加权,为防止第2阶段模型的训练对RFE模块的性能产生影响,训练结束后将RFE模块中的参数进行冻结,在第2阶段直接使用该模块提取区域增强特征。

2.2 二阶段模型

2.2.1 二阶段模型结构

二阶段模型是多特征融合的模型,将图像的彩色特征、边缘特征以及区域增强特征用神经网络模块进行深度特征提取并融合用于识别图像中的违禁品。如图5所示,输入图像经过图像预处理后进入3个并行的网络分支,从上到下依次是区域增强特征提取网络、彩色特征提取网络和边缘特征提取网络。

在彩色特征分支中,将预处理后的RGB三通道彩色图像送入卷积神经网络模型进行深度特征提取,选择基础的残差网络ResNet作为图像彩色特征的提取器,图像进入网络模型后,经过4个残差层提取到7 × 7大小的特征图,通过全局平均池化(global average pooling,GAP)操作,得到1 024元1维特征向量。

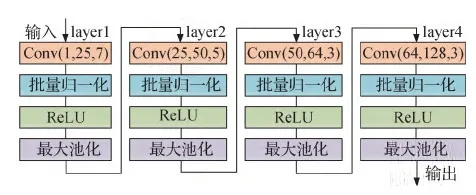

对信息量更少的单通道区域增强特征和边缘特征,使用层数较浅的CBRP(convolution batchnormal relu pooling)卷积模块,CBRP卷积模块的结构如图8所示,由layer1—layer4堆叠而成,每层包括卷积、归一化、激活和池化操作。

图8 CBRP卷积模块结构图

在区域增强特征分支中,先将预处理后的图像送入RFE模块提取区域增强特征,将其输入CBRP模块进行深度特征提取,最后将深度特征通过全连接(fully connected,FC)层映射为1 024元1维特征向量。在边缘特征分支中,先用sobel算子对预处理后的图像进行边缘提取,后接CBRP卷积模块进行深度特征提取,FC层后得到从边缘特征中提取到的1维特征向量。

由于3种特征在不同违禁品识别场景下对最终决策的重要程度不同,在3种特征向量上分别增加了可调权重参数w1、w2和w3。权重参数可在训练过程中自适应调整,使3种特征发挥不同程度的作用,更好地进行融合。图5中的MLP_F模块采用集中式融合方法完成特征融合任务,将3种1维特征向量拼接后输入两层全连接网络,最终输出每类违禁品的得分。全连接网络融合方法的本质是对3种特征提取出的1维特征向量进行特征选择,通过激活函数选择对识别违禁品任务有意义的特征表现,最后综合特征表现判断图像中是否含有违禁物品。

2.2.2 三元损失函数

实验中发现,若仅采用MLP_F模块输出预测分数计算损失进行训练,模型在相同分布图像上的性能虽有提升,但对于不同颜色分布的图像,模型的识别情况没有明显提高。寻找问题时发现此训练方式会使区域增强特征与边缘特征分支的权重w1和w3过小,意味着在特征融合时,彩色特征在网络的学习过程中被更多地依赖,而其他特征只发挥了微小的作用。

为了加强标签信息对于被弱化特征的监督作用,本文分别在边缘特征和区域增强特征后连接了由两层全连接层构成的MLP_S模块,输出仅由单一特征得到的预测向量,因此在训练过程中模型的输出为PA,PB,PC,分别代表边缘特征、融合特征和区域增强特征的预测向量,每个输出向量对应一个交叉熵损失函数,即LA、LB和LC。本文构建了一种三元损失函数,计算为

Loss=α×LA+β×LB+γ×LC

(5)

式中,α、β和γ为3个输出向量对应损失函数的系数,且α+β+γ=1。实验时,根据网络表现设置3个系数的值,引导网络在训练过程中更好地进行特征融合。

交叉熵损失函数计算为

L(P,Y)=-[Y×log(PT)+(E-Y)×log(E-P)T]

(6)

Y=[y1,y2,…,yn]1×n

(7)

P=[p1,p2,…,pn]1×n

(8)

E=[1,1,…,1]1×n

(9)

式中,P表示模型输出的预测向量,Y表示样本的标签向量,n为违禁品类别数量,若样本图像中含有第i个类别的违禁品,则yi=1,反之yi=0。

通过损失函数引导特征权重参数w1、w2和w3动态调整的解决方案既不会固定权重参数,失去特征自适应融合的意义,也不会使参数在自适应调整过程中失去控制,而是在给定学习方向的情况下寻找参数的最优值。

3 实验及分析

为了对上述方案进行验证,先通过对比实验与其他方法进行比较,测试该方案的整体性能及泛化能力,即对不同颜色分布安检图像的识别性能,然后通过消融实验检测各部分对分类性能的影响。

3.1 数据集构建及参数设置

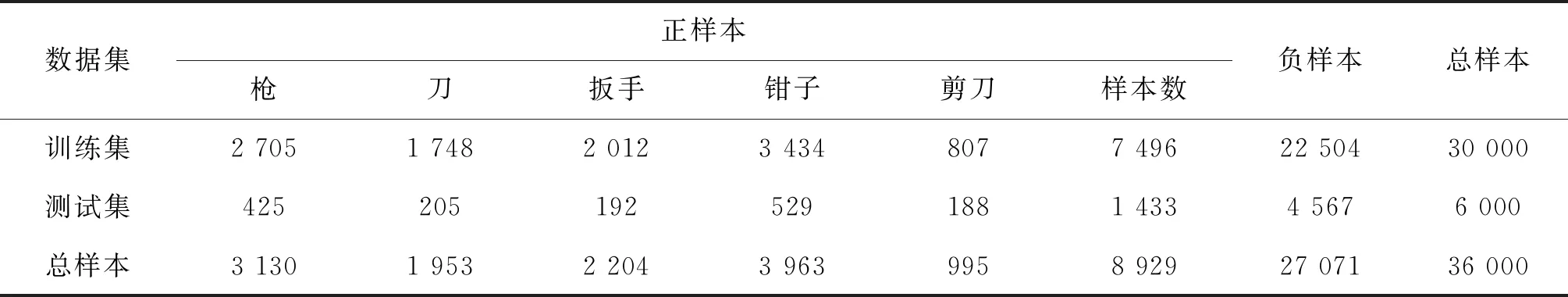

实验采用SIXray公开数据集。该数据集是目前公开的规模最大的X光安检图像数据集,已广泛用于违禁品检测研究(Hassan等,2021;Zhang等,2021;Akcay和Breckon,2022),共1 059 231幅X光安检图像,采自不同地铁站的安检设备。实验时,将含有违禁品的图像定义为正样本,反之为负样本。正样本共8 929幅,包含枪支、刀具、扳手、钳子和剪刀等5种违禁品,且单幅图像中可包含1种或多种违禁品,负样本共1 050 302幅。SIXray数据集包含3个不平衡程度不同的子数据集SIXray10、SIXray100和SIXray1000。从SIXray10子数据集中进行采样得到子数据集SIXray_sub。SIXray10子数据集由训练集和测试集构成,SIXray_sub中的训练样本与测试样本分别来自SIXray10中的训练集与测试集,且正负样本比约为1 ∶3。SIXray_sub子数据集的信息如表1所示。在观察数据集的过程中,发现正样本中编号从P08828到P08929的101幅图像明显与其他图像颜色分布不同,将其设为子数据集SIXray_last101,用于验证模型的泛化性能测试。SIXray_sub中的测试集包含SIXray_last101子数据集。

表1 SIXray_sub子数据集设置

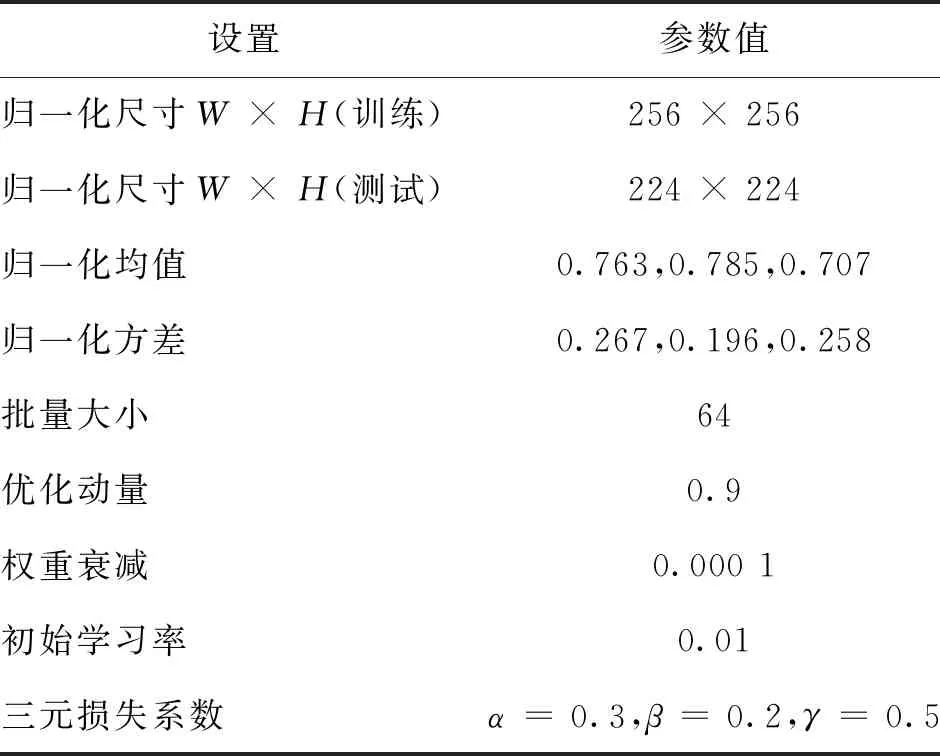

实验采用的软硬件环境为深度学习框架 Pytorch,ubuntu16.04 系统,GPU(graphics processing unit)显卡型号为 Tesla M60。参数设置如表2所示。

表2 参数设置

预处理操作中归一化采用的均值和方差参数由该数据集计算得到,表2中均值和方差的3个参数值分别对应RGB的3个通道。训练过程中采用随机梯度下降(stochastic gradient descent,SGD)优化方法,学习率随训练情况衰减,当损失不下降时停止训练。针对第2.2.2节提到的过多依赖彩色特征、需减弱彩色分支的权重,以及需加强区域增强特征以提高模型泛化能力,将三元损失系数设置为α=0.3,β=0.2,γ=0.5。

3.2 对比实验

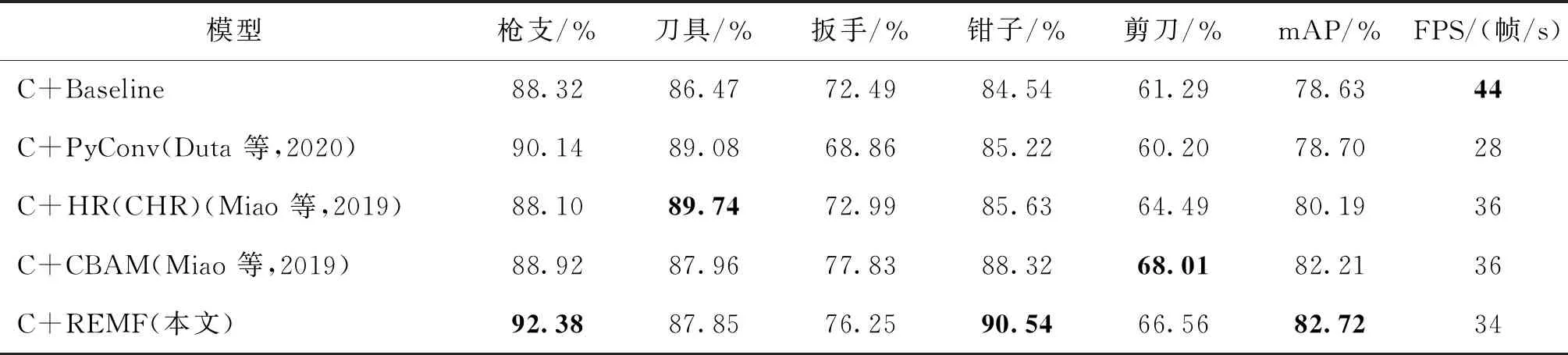

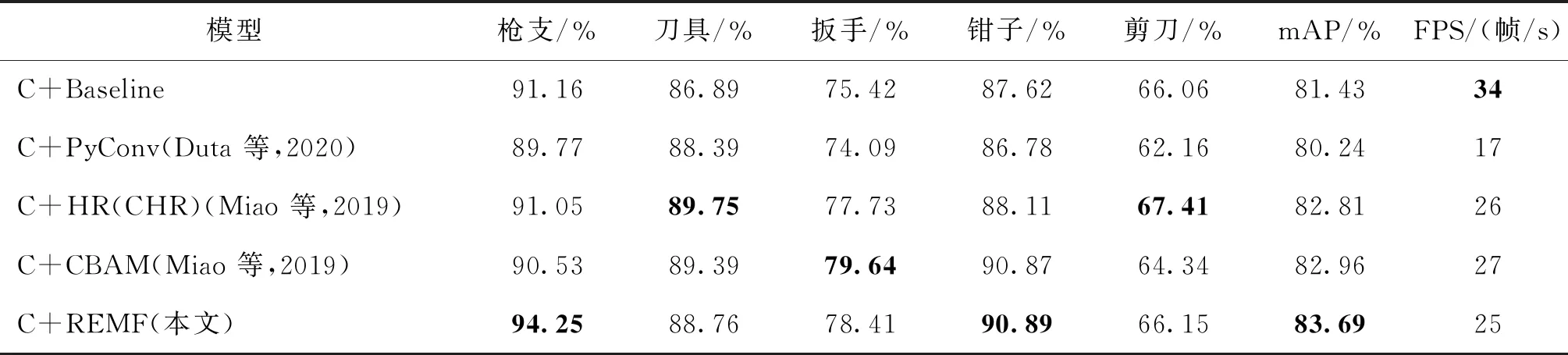

对比实验分为整体性能对比和泛化能力对比两部分。整体性能对比实验主要验证本文方法在颜色分布相同的数据集上对各类违禁品识别性能的表现,该实验在SIXray10数据集上进行,将ResNet18和ResNet34网络作为实验的基础模型,对比方法为采用多尺度卷积与组卷积的金字塔卷积(pyramid convolution, PyConv)(Duta等,2020)融合高中低3层特征并采用高层监督低层的分层细化方法(hierarchical refinement,HR)(Miao 等,2019)、将通道注意力与空间注意力串联的卷积注意力方法(CBAM)(Woo等,2018)以及本文提出的区域增强和多特征融合模型(REMF)。由于SIXray10数据集为类不平衡数据集,为了缓解数据的不平衡程度,该实验在所有方法上均增加类平衡处理(class-balanced,C)(Miao等,2019)。采用平均精度(mean average precision,mAP)作为评估分类性能的指标(尉婉青 等,2021),将每秒帧率(frame per second,FPS)即每秒可处理图像数量作为评估识别效率的指标。各方法在ResNet18和ResNet34模型上的表现如表3和表4所示。可以看到,在整体的识别效果上,本文方法相较于基础模型分别提升了4.09%和2.26%,相较于其他3种方法也有所提升。在单类的识别效果上,本文方法在5类违禁品的识别效果上均高于基础模型,尤其在枪支类的识别效果上有明显优势,相对于其他方法最少提升了2.24%和3.09%,并且在钳子类的识别效果上优于其他方法。在识别效率方面,本文方法可达到实时处理的效果。

表3 不同方法在ResNet18模型上的整体性能对比

表4 不同方法在ResNet34模型上的整体性能对比

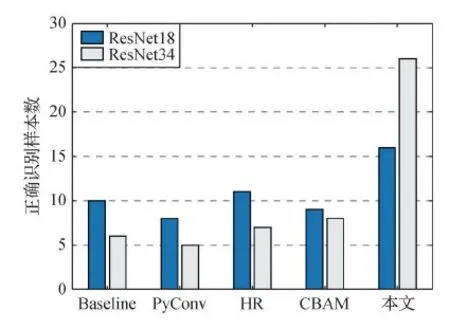

泛化能力对比实验主要验证本文方法在不同颜色分布图像上的泛化能力。将已经训练好的表3和表4中模型在SIXray_last101数据集上进行对比,由于SIXray_last101数据中都含有枪支类违禁品,因此实验可以通过比较正确识别的枪支样本数量(correct number/total number,CN/TN)进行泛化能力对比,实验结果如图9所示。

图9 泛化能力对比实验结果

从图9可以看出,由于在训练模型过程中,训练样本的颜色符合同一分布,当模型面对与训练样本颜色分布不一致的SIXray_last101测试集时,很难表现出好的效果。ResNet18模型能正确识别10幅含有枪支的安检图像,而ResNet34的性能低于ResNet18,仅能正确识别6幅,在PyConv、HR和CBAM方法上也看同样的规律。本文提出的REMF方法在泛化能力方面相较于其他方法有所提升,并且在ResNet34上效果更加明显,以ResNet34为基础的REMF可以正确识别26幅含枪支违禁品的图像。图10为REMF方法相较于其他方法额外识别出来的部分图像,尽管对于全部的测试样本,本文方法只识别出了一小部分,但相对于基础模型提升了4.3倍,表明本文方法提升了在不同颜色分布图像上的泛化能力,与理论分析保持一致。

图10 仅REMF方法正确识别的图像

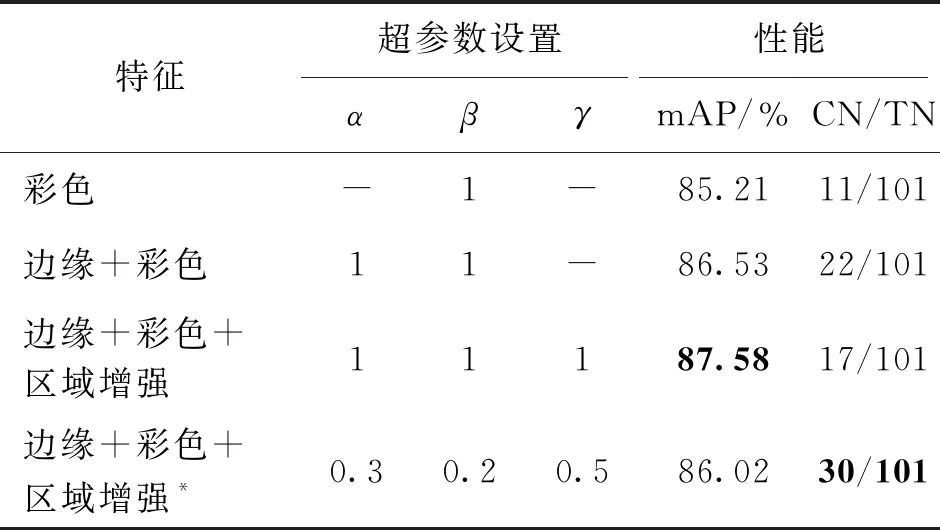

3.3 消融实验

为了更加直观地检验不同特征以及超参数设置对模型性能的影响,实验选择ResNet34网络为基础模型、SIXray_sub为实验数据进行消融实验。实验结果如表5所示。

表5 消融实验结果

第1组实验为基础模型,仅采用彩色特征分支进行预测;第2、3组实验增加边缘特征和区域增强特征,并采用自适应方式进行融合,即超参数默认为1。第4组实验引入三元损失函数进行引导式融合,即对超参数进行设置,减弱彩色特征分支权重,增强区域增强特征分支权重。

从表5可以看出,边缘特征和区域增强特征使整体识别性能分别提升了1.32%和1.05%,由于训练样本单一的颜色分布,多特征的自适应融合会提升模型在同样颜色分布图像上的性能,但面对不同颜色分布的图像,训练得到的自适应参数并不完全适用,因此模型在泛化性能的表现并不稳定。三元损失函数的引入提升了模型的泛化性能,基础模型仅能识别出11幅颜色分布不同的含枪支违禁品的图像,自适应融合可以正确识别17幅含枪样本,引导式融合可正确识别出30幅含枪样本。尽管整体识别性能相对于自适应融合方法有所欠缺,但相较于只提取彩色特征的基础模型仍然有所提高。

4 结 论

本文根据X光安检图像颜色丰富且分布不同以及物品混乱复杂的特点,提出一种区域增强和多特征融合模型。引用注意力机制的思想并依据数据的整体特征分布训练得到区域增强特征,可以消除颜色差异的影响并增强违禁品区域信息。根据安检员进行安全检查关注的色彩、形状和轮廓细节等信息,采用多特征融合策略,并提出一种三元损失函数优化融合效果。在公开的来自不同安检设备的实测数据集上进行实验,结果表明本文方法提升了模型识别违禁品的性能,并缓解了图像颜色分布不同引起的识别性能下降问题,验证了本文方法的有效性及鲁棒性。本文方法相较于实验中的其他方法,在整体识别性能和泛化性能方面均有所提升。但本文方法的多分支结构增加了模型计算量,因此在识别效率方面没有明显优势。未来将进一步优化网络结构,在保证识别效果的情况下减小模型的计算量,提高模型的识别效率。