结合显微视觉和注意力机制的毛羽检测方法

2023-01-14唐嘉潞杨钟亮张凇毛新华董庆奇

唐嘉潞,杨钟亮,张凇,毛新华,董庆奇

(1.东华大学 机械工程学院,上海 201620;2.曼彻斯特大学 科学与工程学院,英国 曼彻斯特 M139PL;3.北京中丽制机工程技术有限公司,北京 101111;4.浙江双兔新材料有限公司,浙江 杭州 201620)

我国是世界第一的化纤生产大国,2020 年我国化纤产量为6 126.5 万吨,同比增长4.1%,出口化纤产品总量466.06 万吨,已成为国民经济的重要支柱。化纤丝饼由丝束在卷绕机控制下绕纸筒卷装形成[1]。毛羽是衡量化纤质量的重要指标之一,其成因通常包括机械原因造成的毛羽以及浮游毛羽[2]。过多的毛羽导致化纤质量下降,从而影响织物的强度、外观光洁度、手感滑爽程度等。

丝饼出库前的质检主要通过工人使用手电筒照亮丝饼肉眼观察,并根据瑕疵数量进行丝饼质量分级。目前,人工检测存在一些问题:1)质检员评价标准存在主观差异,影响了检测的准确率[3];2)车间环境噪声大、温度和湿度高,不适宜工人长期工作[4];3)检测过程需要反复弯腰、蹲起、转动手电筒,质检员易产生疲劳,从而引起误检[5];4)疫情导致劳动力成本不断增加、招工难度进一步加大[6]。可见,在工业4.0 时代,人工检测丝饼的方式难以满足化纤生产企业智能制造的发展需求。因此,亟待一种更加智能、高效的瑕疵检测方法,使得丝饼瑕疵在流水线中就能被快速、准确地识别,大幅提高生产效率,节省成本。

目前,毛羽智能检测面临以下两个难点:1)细小的毛羽特征属于微米级,普通相机很难抓取到毛羽图像,易导致漏检;2)毛羽和断线不易分辨,易造成错检。针对以上问题,本文提出一种基于工业显微相机的图像获取方法,以及结合注意力机制、特征融合和CenterNet 的毛羽目标检测算法CenterNet-CBAM。通过与CenterNet、YOLOv4、Faster R-CNN、SSD 四种目标检测算法的实验结果相比,验证了该方法在区分毛羽和断线方面具有更好的效果。

1 相关工作

1.1 图像处理的织物瑕疵检测现状

瑕疵检测是涤纶丝饼生产过程中必不可少的环节。长期以来相关企业和科研机构针对传统图像识别方法进行了大量研究,取得了可观的研究成果。但是基于图像处理的瑕疵检测方法仍存在以下问题:1)在对图片进行预处理的过程中,由于图片背景会随着背景纹理的变化而发生改变,导致算法需要针对特定应用场景重新开发,系统通用性、鲁棒性较差;2)在提取特征时,如纱线表面纤维的方向等[7]难以直接被观察到的抽象变量,通常利用Gabor 滤波[8]、双边滤波[9]等方法进行处理,给开发过程带来困难,进而对检测的准确性产生影响;3)选择图片特征时,需要针对不同的瑕疵类型对图片中的尺寸、形状、纹理等多种缺陷特征进行人工提取,工作量较大[10]。

1.2 毛羽瑕疵目标检测现状

目标检测的任务是找出图像中所有需要被检出的对象,确定其类别和位置。Ren 等[11]提出的two-stage 算法Faster R-CNN 是瑕疵检测任务中的典型算法;车翔玖等[12]采用Faster R-CNN 调整区域推荐网络在布匹瑕疵检测中取得了良好效果。Redmon 等[13]提出分类和定位在一个步骤中完成的YOLO 算法;唐有赟等[14]将深度可分离卷积与YOLO 模型相结合,织物瑕疵识别准确率达到95.8%。布匹瑕疵与毛羽瑕疵相似,可以将Faster R-CNN和YOLO 应用到丝饼表面毛羽的检测中。

丝饼表面瑕疵主要包括毛羽、油污、绊丝、成型不良等,而断线是未捻入丝饼的丝束尾端,不属于表面瑕疵。为了实现丝饼表面瑕疵的智能检测,王泽霞等[15]利用最大池化层代替全连接层对AlexNet 网络进行轻量化改进,检测对象集中在油污等特征明显的瑕疵上,未对微小的毛羽瑕疵进行检测。针对这一问题,张君扬等[16]在SSD[17]中加入反卷积和特征融合对丝饼各类毛羽瑕疵检测,但未区分毛羽和断线。

1.3 显微视觉

显微视觉系统是借助显微镜或者显微镜头构成的视觉系统[18]。经过显微镜头放大后,显微相机采集的图像称为显微图像。显微镜放大倍数高,采集图像清晰,能够有效观察微观结构,常应用于医学[19]、IC 制造、微机电系统装配等领域。在纤维检测领域,路凯等[20]结合显微视觉鉴别羊毛和羊绒,识别正确率为86%。

毛羽锚框尺寸小,且长宽差距大,通用的锚框尺寸不能适应,是典型的小目标检测任务[21]。小目标检测是目标检测中的关键挑战之一[22]。文献[23]将低分辨率图像反卷积至高分辨率,获得了更多的细节;文献[24]提出了视觉空间注意网络VSA-Net,通过加入检测目标所在环境提升小物体检测准确率,增加上下文信息实现特征的补充;文献[25]通过4 个尺度的特征层进行融合提升整体目标的检测准确率,避免随着网络加深造成的细节特征丢失,增加浅层细节信息便于小物体检测。2019 年,Zhou 等[26]提出的CenterNet 算法采用无先验框的检测方法,只负责预测物体的中心点,所以没有尺寸限制,在抽雄期玉米雄蕊、糖尿病视网膜病变[27]等小物体检测上展现优势。通过CenterNet 检测毛羽等小目标,可为化纤丝饼表面瑕疵检测提供新的途径。

1.4 注意力机制

经典卷积主要集中在空间局部特征提取上,未对全局及通道图像信息进行筛选。为了在捕获画面中更重要特征信息的同时避免信息过载,提高任务处理的效率和准确性,许多国内外学者[28]利用神经网络产生注意力,突出重点信息并弱化次要信息,逐渐在图像领域成为研究热点。

机器视觉中的注意力机制分为两种,软注意力机制和强注意力机制。其中,软注意力机制通过神经网络梯度计算得到注意力的权重,主要有两种:一种是空间注意力机制,另外一种是通道注意力机制,以SE 模块(squeeze-and-excitation module)[29]为代表。空间与通道注意力机制结合的CBAM(convolutional block attention module),能够提高网络的学习效果。在热轧钢板表面缺陷检测[30]和织物疵点检测[25]中,嵌入CBAM 注意力机制能有效提升图像分类的效果,经消融实验显示,加入CBAM 的ResNet50 网络Top-1 Error 下降约2%。如果将CBAM 与目标检测算法相结合,有望进一步提升毛羽瑕疵检测的准确率。

2 本文方法

2.1 显微视觉检测平台

2.1.1 视觉检测系统设计

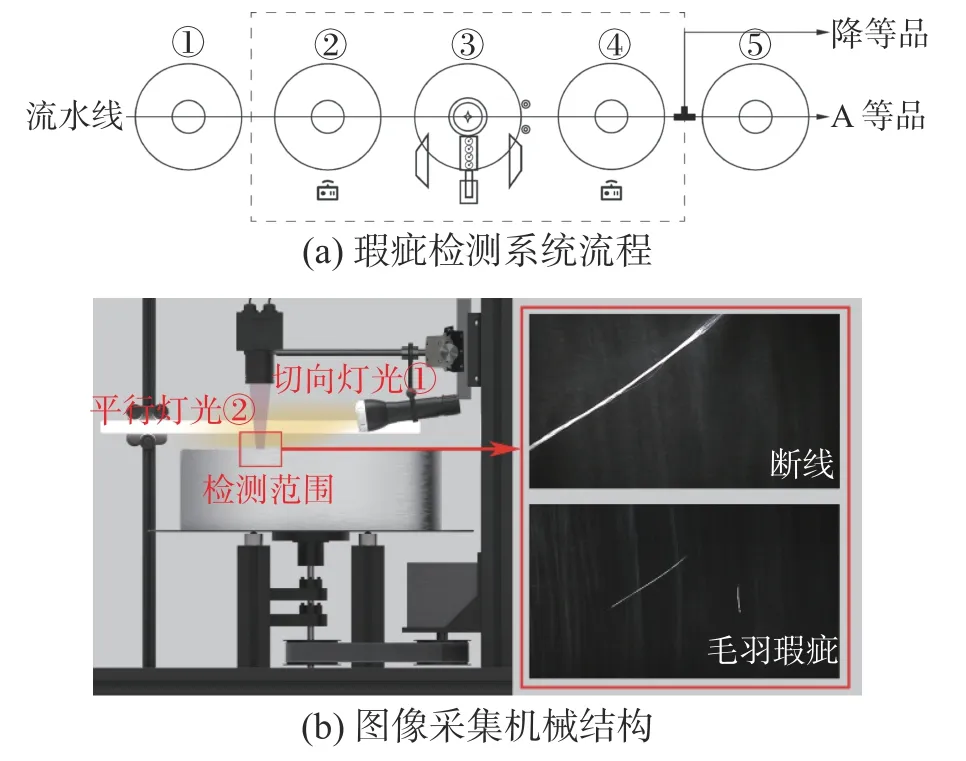

开发了表面缺陷检测系统,将丝饼放置于流水线上,共分为5 个状态,如图1 所示。

图1 图像采集实验平台Fig.1 Image acquisition experimental platform

状态1:丝饼在流水线上,处于待检测状态。

状态2:丝饼进入检测机构,激光传感器检测到丝饼,止动气缸弹出。

状态3:丝饼停在检测位,底部电机旋转,工业显微相机开始检测,丝杆在前后方向上进行调节,改变拍摄范围,最终覆盖丝饼表面。

状态4:激光传感器检测到丝饼后,分流气缸根据丝饼瑕疵检测结果进行分流,分为A 等品和降等品。

状态5:A 等品随流水线进入包装环节。

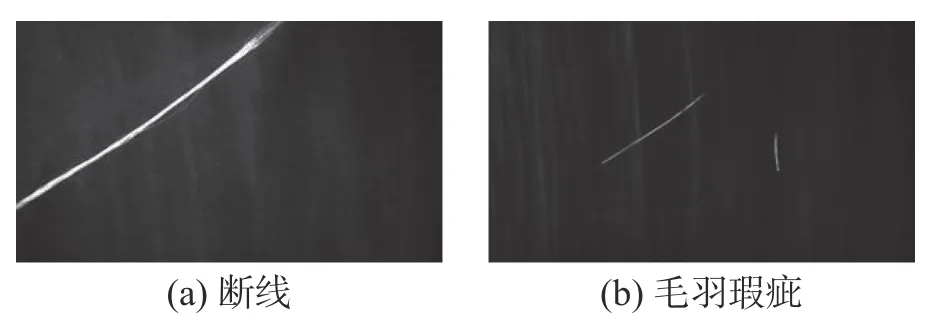

在特定角度提供光源照亮毛羽瑕疵,弱化丝饼表面反光对缺陷特征产生的影响,获取如图2所示特征亮、背景暗的图片。下面将通过实验确定最佳相机安装位置及机器视觉光源配置。

图2 被采图像Fig.2 Acquired images

2.1.2 显微相机

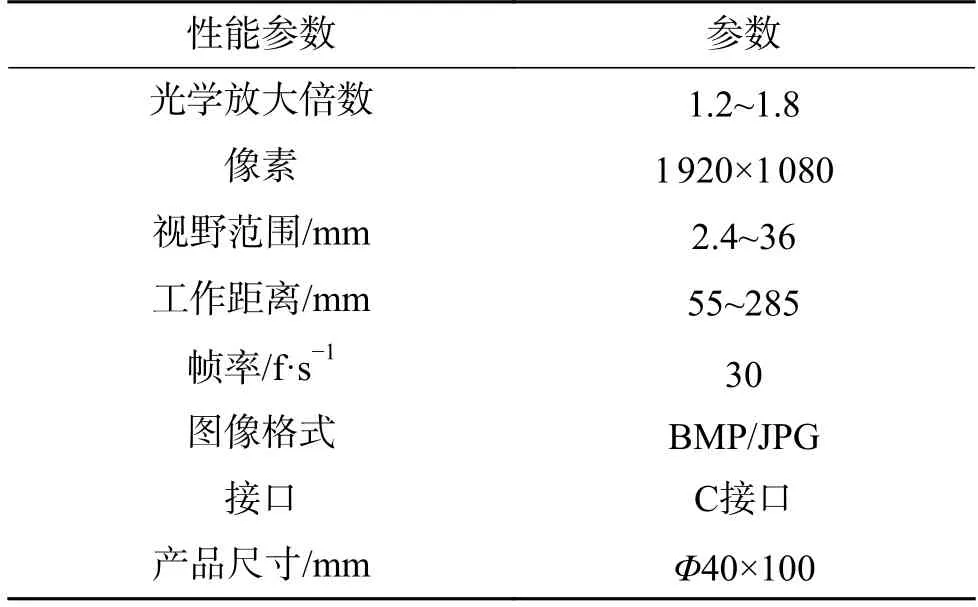

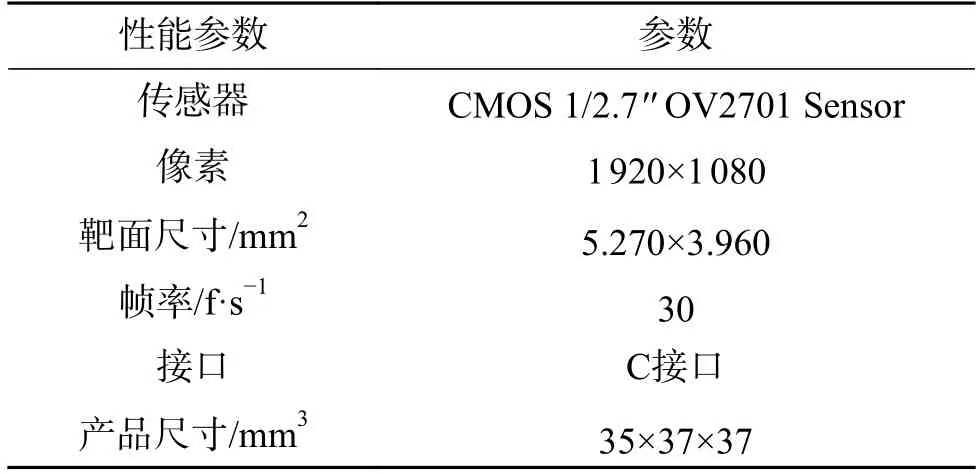

选择焦距f=60 mm 的显微镜头,画面大小控制为可拍摄到瑕疵的最大画幅。根据表1 所示镜头参数,表2 所示相机参数调节拍摄距离,改变拍摄视野。

表1 显微镜头参数Table 1 Microscope lens parameters

表2 CMOS 相机参数Table 2 CMOS camera parameters

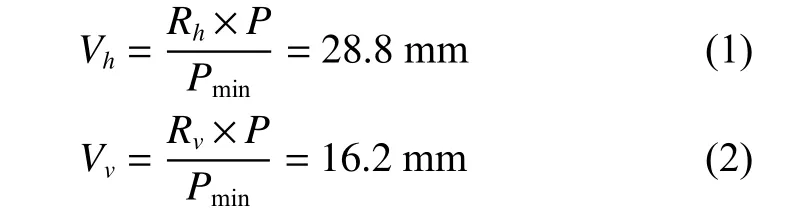

目标检测过程中要求检测的毛羽直径为3 μ m,经灯光照射后特征放大,实际尺寸为30 μm。将最小检测像素数Pmin设为2。水平和竖直方向的最大检测尺寸如式(1)、(2)所示:

式中:Vh、Vv分别为水平视野和竖直视野,表示画面所拍摄的尺寸;Rh、Rv分别为水平和垂直视野分辨率;P为像素。物距u和像距v的算法如式(3)、(4)所示,由此可知被检瑕疵的物距为387.89 mm。

式中:f为焦距;Ch为COMS 设备的高度。电子、光学、显示器放大倍率计算公式为

式中:Md为电子放大倍率,表示COMS 设备连接至15.6 寸显示屏上成像后的放大倍率;Mo为光学放大倍率,表示芯片尺寸与视野尺寸的比值;Mm为显示器放大倍率,表示被拍物体通过镜头和相机成像后显示在显示器上的放大倍数。

2.2 瑕疵检测算法模型

2.2.1 瑕疵检测算法框架

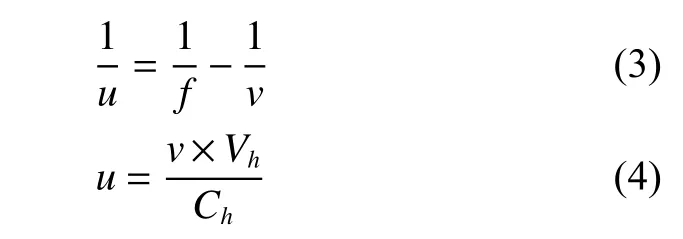

本文提出的CenterNet-CBAM 模型框架如图3所示。断线和毛羽的特征为中间粗,两边细,与CenterNet-CBAM 的热力图识别机制相对应,即中心点特征明显,边缘特征较弱。图像传入卷积网络得到热力图,热力图峰值点即中心点,通过中心点和宽高预测,准确定位中心点位置和预测框的大小。

图3 CenterNet-CBAM 模型框架Fig.3 CenterNet-CBAM framework

本文提出的CenterNet-CBAM 算法特点如下:

1) 无损图像预处理。本次任务属于小目标检测,目标物体所占用的像素为2,原图尺寸为1 920×1 080×3,经各项同性缩放生成与原图近似的图像1 920×1 088×3 输入特征提取网络,使图片在卷积操作过程中能够取整。

2)加入注意力机制和特征融合的卷积特征提取。使用Resnet50 特征提取网络,通过5 次的卷积操作将图片中的信息转化为特征数组,为避免随着网络加深造成的细节特征丢失,将上采样特征与下采样特征融合,实现将底层的目标位置信息引入高层神经网络结构。在conv1 的最大池化层后和Resnet50 特征提取网络conv5 后引入CBAM 模块。

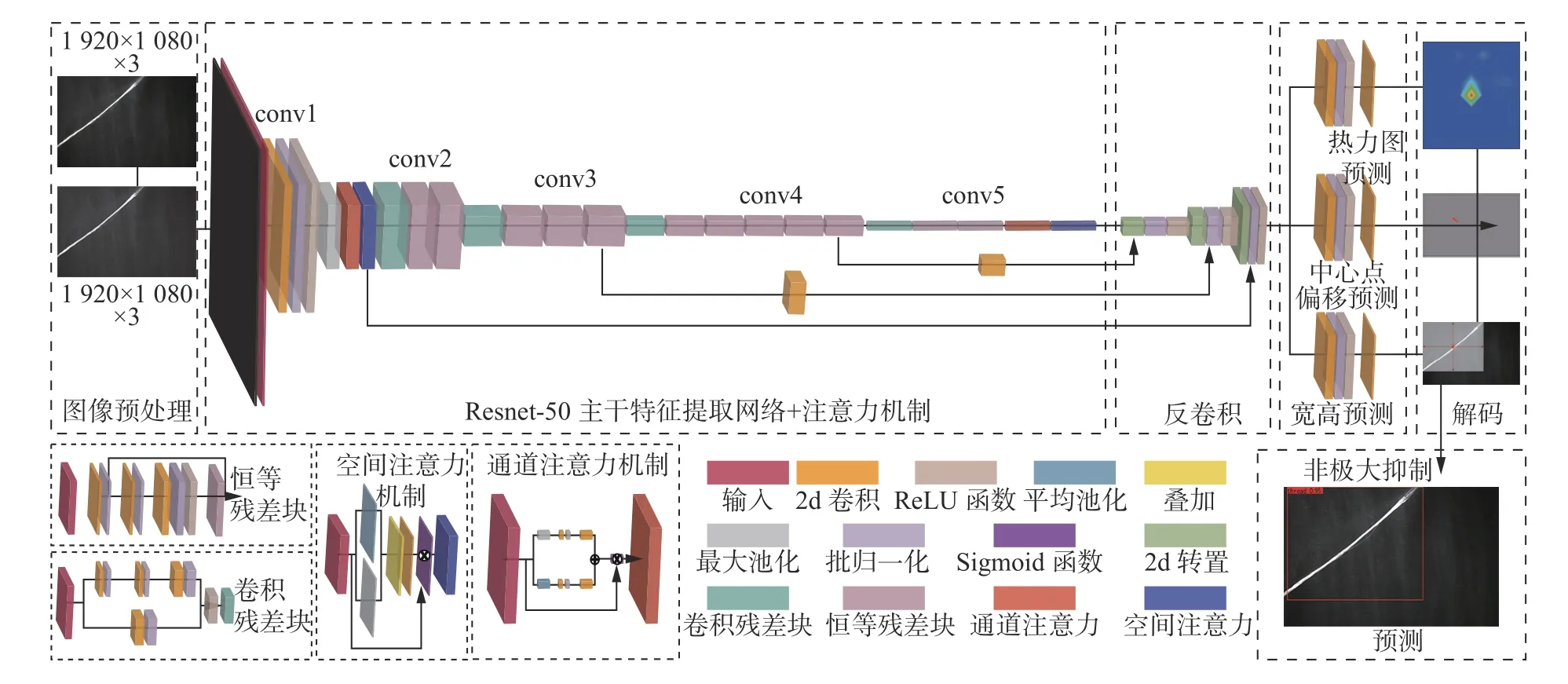

3)加入NMS 的二次特征解码。CenterNet 的非极大抑制选取特征点与其周围的8 个点之间最大值,本次目标为线状特征,容易产生多个中心点效果,如图4 所示,后处理过程加入NMS,防止同一目标的复检。

图4 毛羽特征中心点预测结果Fig.4 Results of key-point heatmap of hairiness

2.2.2 瑕疵检测算法流程

1)将尺寸为1 920×1 080×3 图像输入Resnet50网络结构中,经过conv1 和conv2 的最大池化层,输出作为特征图F。

2)经通道注意力模块,特征图F经过平均池化(AvgPool)、最大池化(MaxPool)和激活函数相加接sigmoid 得到MC(F),如式(5)所示:

3)将新特征图F′′经conv2、conv3 得到240×136×512 的特征层;经conv4 得到120×68×1 024 的特征层;经conv5 得到60×34×2 048 的特征层;最后接入CBAM 模块,计算过程如式(6)、(7)、(8)所示,输出后特征尺寸保持不变。

4)利用初步特征获得高分辨率特征图,通过3 次反卷积进行上采样,尺寸分别为120×68×256、240×136×128、480×272×64,分别与特征提取过程中的输出特征F、F′、F′′进行特征融合。

5)从提取特征中获取预测结果,这个特征层相当于将整个图片划分成480×272 个区域,每个区域存在一个特征点,如果某个物体的中心落在这个区域,那么就由这个特征点来确定。

6)利用特征层进行3 次卷积获得热力图预测、中心点预测和宽高预测结果。

7)预测结果解码,热力图预测,输出尺寸为480×272×2,其中最后一维代表断线和毛羽两类瑕疵,预测是否有物体存在以及物体的种类;中心点预测结果为480×272×2,代表物体中心距离热力点偏移的距离;宽高预测输出结果为480×272×2,代表当前这个特征点对应的预测框的宽和高。

2.2.3 损失函数

损失计算分为3 个部分,最终损失值为

式中:Ldet为CenterNet 的损失函数;Lk为热力图损失;Lsize为宽、高损失;Loff为中心点偏移量损失;λsize和λoff为常数,分别为0.1 和1。

2.2.4 评价指标

本文采用精确度(precision)、召回率(recall)、AP 值和mAP 值作为模型的评价指标:

式中:P为精确度;R为召回率;TP 为正确检测框;FP 为误检框;FN 为漏检框;psmooth(R)为对P-R曲线进行平滑处理;dR表示用积分的方式计算平滑P-R曲线下方的面积;mAP 代表断线和毛羽两个类别的AP 均值。

3 毛羽瑕疵的显微视觉检测实验

待检测丝饼外径为425 mm,内径为140 mm,厚度为123 mm,丝束缠绕在纸筒上,产品材质为预取向丝,是拉伸丝和变形丝的基础原料。表面光滑高亮,主体颜色为白色。由于毛羽、断线瑕疵属于高反光物体,对光源敏感,通过光源照射,被测产品瑕疵部分会产生高亮,与背景环境差异明显。为避免拍摄环境中的杂光和倒影,搭建了全黑拍摄的图像采集实验平台。

3.1 显微视觉光源实验

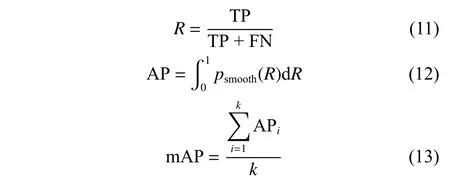

在控制其他条件不变情况下,对比不同光照下的产品照明效果,如图5 所示。

图5 光照强度对比Fig.5 Comparison of light intensity

经对比处理后的二值化图像可以得出,产品在高亮灯光照射下拍摄效果更好,目标瑕疵更加清晰。当灯光过亮时,背景中形成亮点,导致图像均匀性差。当灯光较弱时,瑕疵特征不明显,不利于检测。

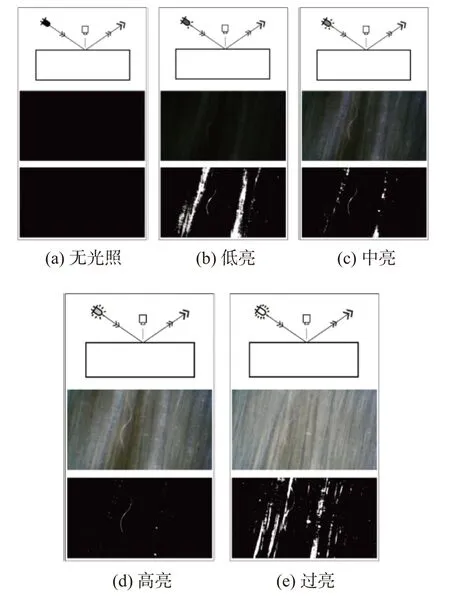

对比不同颜色灯光对照射效果的影响,3 种色彩下调节RGB 通道阈值形成的二值化图像差别不明显。产品表面为白色,当使用彩色灯光照亮物体时,产品表面反射了所有的彩色光而呈现统一的颜色,瑕疵特征对色彩影响不敏感,由此可知光源波长对检测效果产生影响不显著,如图6 所示。

图6 光照色彩对比Fig.6 Comparison of lighting colors

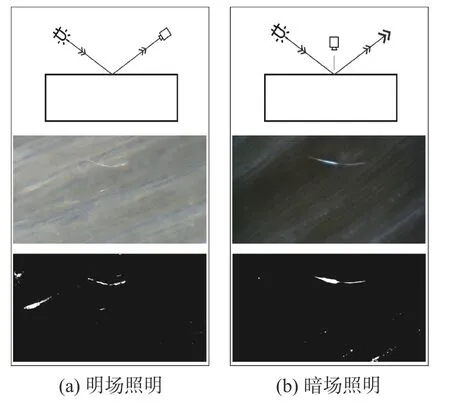

对比两种照明方式对成像效果的影响,明场照明需要用光源直接照射被测物,暗场照明则是通过被测物反射或者衍射的光线来观测。光照的目的是提高对比度,突出目标对象,以便提取出其轮廓等物理特征。由于暗场入射光束有较大的倾斜角,当在黑暗的视野照明,即使很细的磨损也很容易识别,如图7 所示。

图7 照明方式对比Fig.7 Comparison of lightening mode

灯光数量对于瑕疵成像的影响,单向光照亮的毛羽范围有限,毛羽特征连贯性差。加入垂直于切线的新灯光后,照亮范围变大,毛羽整体更加连贯,边缘更加明显,如图8 所示。

图8 灯光数量对比Fig.8 Comparison of number of lights

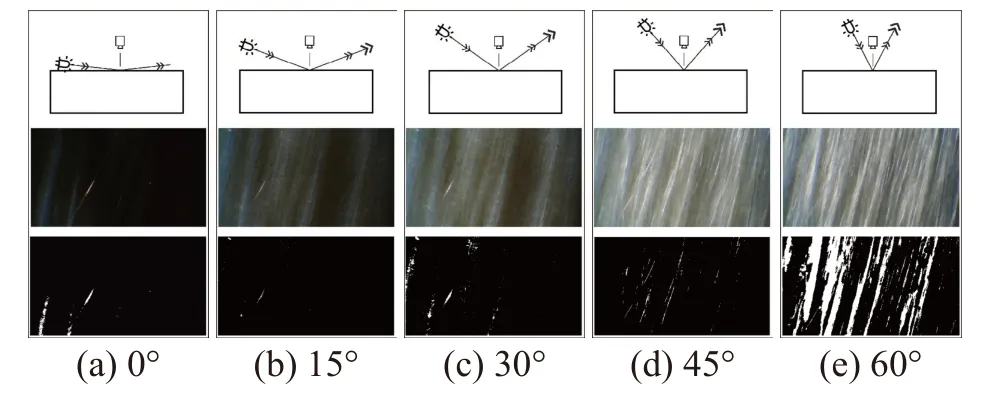

通过不同角度下的打光效果对比,二值化图像处理,发现光源在15°位置的照射效果最佳,如图9 所示。

图9 光照角度对比Fig.9 Comparison of lighting angles

结合上述实验,组合出最佳的拍摄条件。在黑色背景下,结合两个白色光源进行打光时成像效果最优。光源1 即白色LED 光源沿与丝饼表面夹角15°的方向打光,打光位置在显微镜正下方,照亮与丝线方向垂直的毛羽;侧面的白色LED 光源2 照亮与丝线方向平行的毛羽,如图10 所示。在这种情况下,被测丝饼成像轮廓更清晰,特征突出,对比度更高。

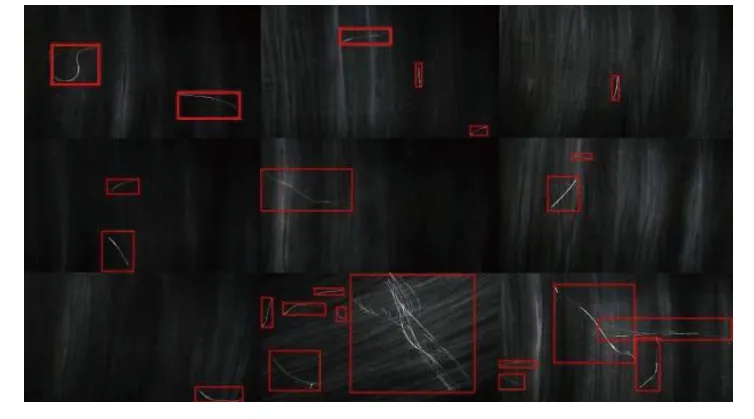

图10 毛羽标签图像Fig.10 Hairiness image labeling

毛羽图像经过人工标注,将瑕疵类别划分为断线、毛羽两种,分类标准根据被检瑕疵直径确定。标注完毕后,选择Pascal VOC 导出形式。

按照丝饼的瑕疵类型,将工业显微相机采集的图像进行筛选,除去失焦、过曝等成像不良的样本,将最终的有效图像划分为3 种,分别为带有断线、毛羽和无瑕疵的图像,合计1 614 张,如表3所示,选择8∶1∶1 的训练集、验证集、测试集配比。

表3 采集图像数量Table 3 Number of images acquired 张

3.2 算法对比实验

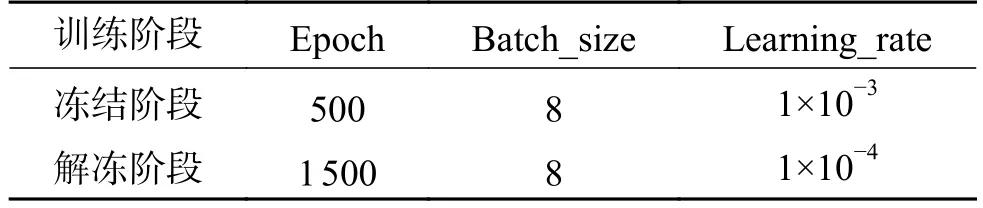

实验对比了CenterNet、YOLOv4、Faster R-CNN、SSD 四种网络选出最优算法,均使用预训练模型,训练参数如表4 所示。

表4 4 种算法训练参数Table 4 Training parameters of four algorithms

针对最优的CenterNet 进行优化,在Resnet50网络中加入CBAM 模块和特征融合。训练参数如表5 所示。

表5 CenterNet-CBAM 训练参数Table 5 CenterNet-CBAM training parameters

这些网络模型均在Ubuntu(9.3.0)系统上进行训练,使用GPU 加速。系统硬件为Intel(R) Core(TM) i5-10600KF CPU @ 4.10 GHz 和 32 GB RAM,NVIDIA GeForce RTX3090 24 GB。编程语言为 Python3.6,主要使用pytorch 平台。

4 结果与讨论

4.1 CenterNet-CBAM 识别结果

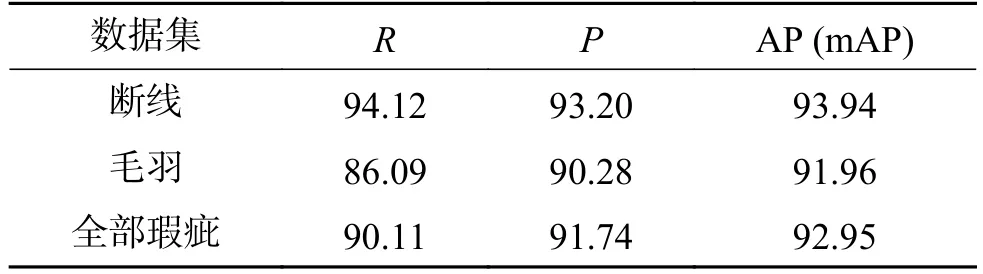

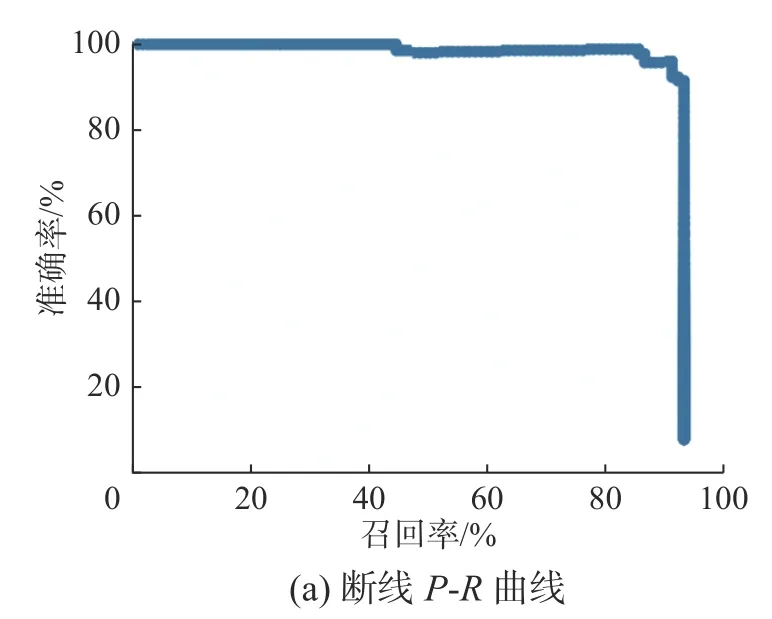

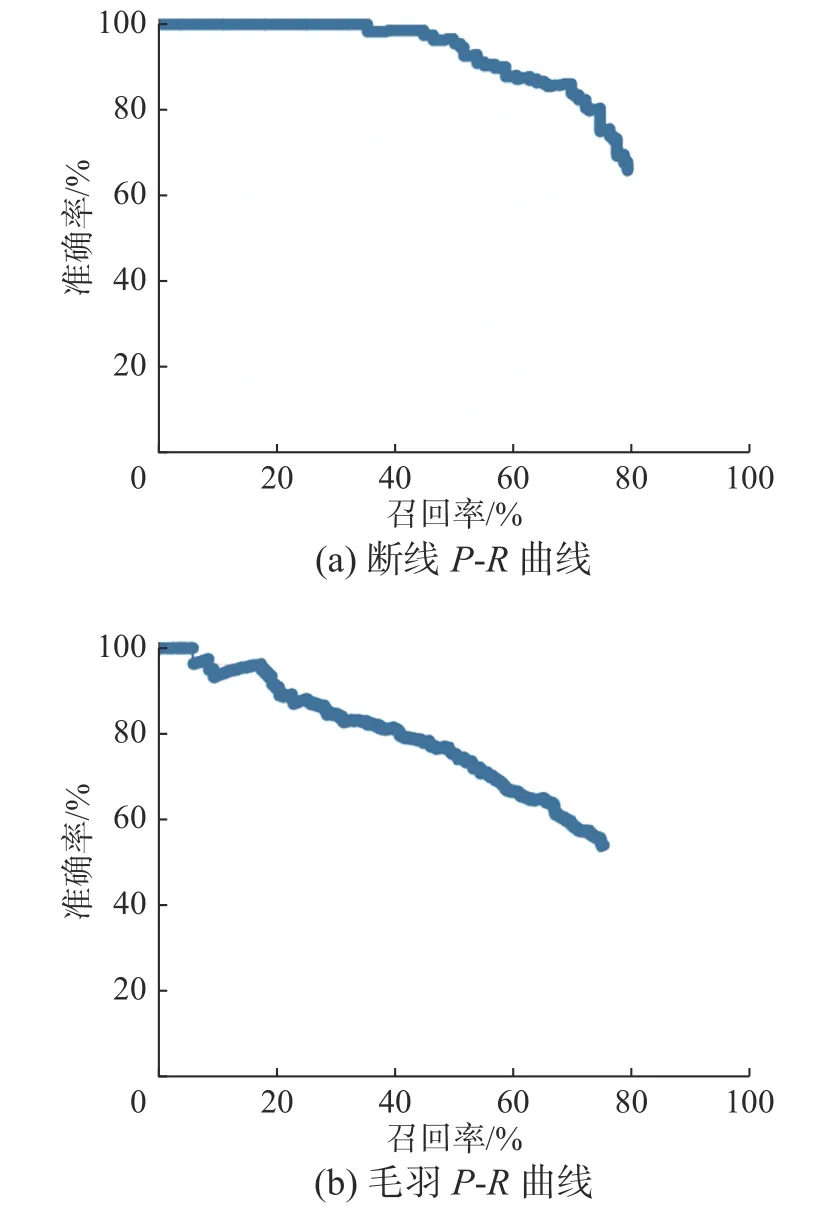

CenterNet-CBAM 的实验结果如表6 所示,mAP 为92.95%,如图11 所示。随着召回率的提高,毛羽和断线的准确率下降不明显。

表6 CenterNet-CBAM 模型的识别结果Table 6 Identification results of CenterNet-CBAM %

图11 CenterNet-CBAM 模型的识别结果Fig.11 Identification results of CenterNet-CBAM

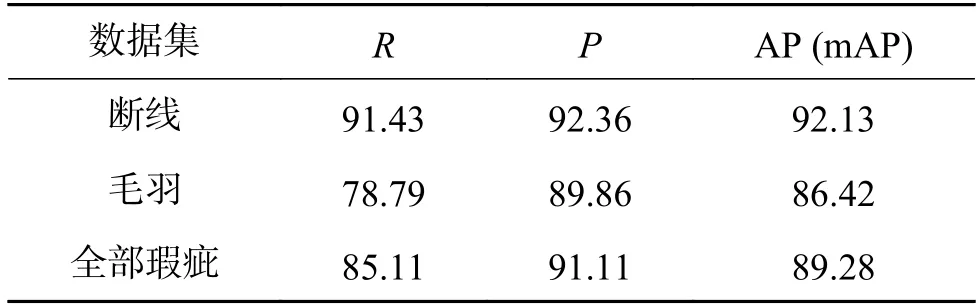

4.2 CenterNet 的识别结果

CenterNet 的实验结果如表7 所示。模型中断线AP 值最高,为92.13%,毛羽特征识别准确率略低。准确率随召回率下降速度慢,如图12 所示。结合断线和毛羽的特点,CenterNet 检测目标选框的中间特征明显,边缘特征稀疏,取得了较好的识别效果。

表7 CenterNet 模型的识别结果Table 7 Identification results of CenterNet %

图12 CenterNet 模型的识别结果Fig.12 Identification results of CenterNet

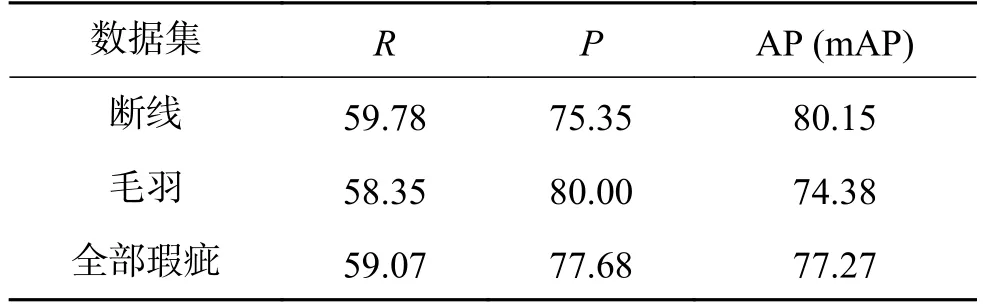

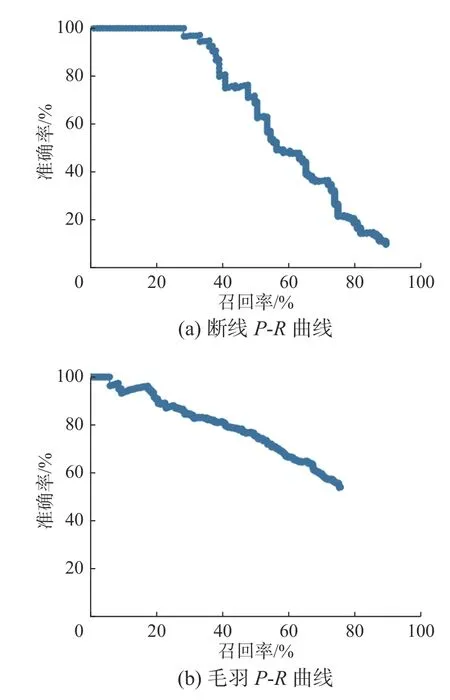

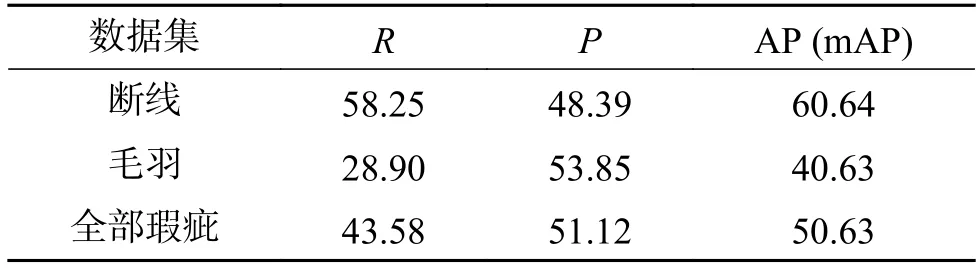

4.3 YOLOv4 识别结果

YOLOv4 实验结果如表8 所示,毛羽召回率对准确率变化敏感,如图13 所示。YOLO 采用了预定义候选区的方法,通过将图片划分为网格,在此实验中难以完整地覆盖整个画面,在小目标识别的召回率上表现不佳。

表8 YOLOv4 模型的识别结果Table 8 Identification results of YOLOv4 %

图13 YOLOv4 模型的识别结果Fig.13 Identification results of YOLOv4

4.4 Faster R-CNN 识别结果

Faster R-CNN 实验结果如表9 所示,随着召回率的上升,算法的精确率下降较快,召回率最大值为76.41%,如图14 所示。此实验中,该算法在特征提取完成后,目标特征图高度抽象,特征信息较少。定位目标时使用固定目标框,对于毛羽、断线这类形态不规则小物体效果不佳。

表9 Faster R-CNN 模型的识别结果Table 9 Identification results of Faster R-CNN %

图14 Faster R-CNN 模型的识别结果Fig.14 Identification results of Faster R-CNN

4.5 SSD 识别结果

SSD 实验结果如表10 所示,SSD 模型对断线和毛羽的识别率较低,断线的精确率随着召回率的上升快速下降,如图15 所示。需要人工设置预选框的最大值、最小值和宽高比值。而对于毛羽、断线这类识别目标来说,比例和位置都有较强的随机性。

图15 SSD 模型的识别结果Fig.15 Identification results of SSD

表10 SSD 模型的识别结果Table 10 Identification results of SSD %

4.6 实验结果讨论

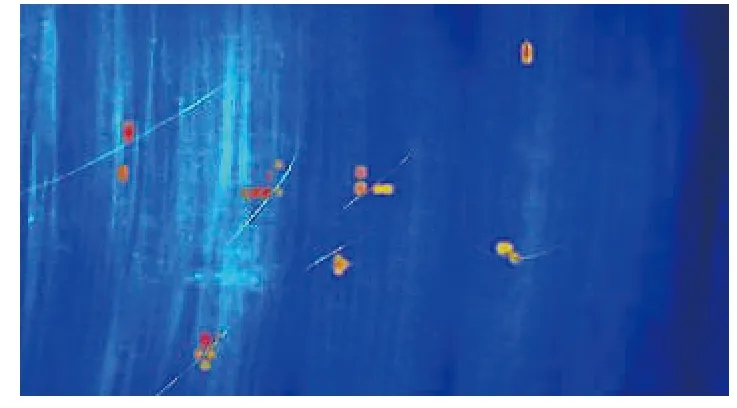

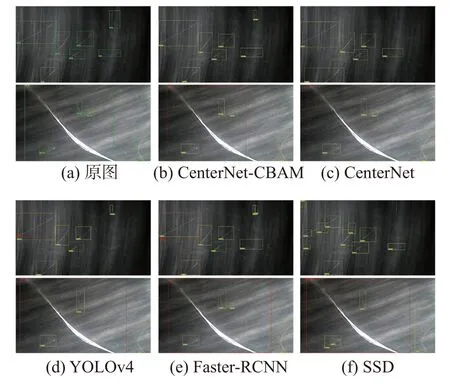

在被检测的两类目标中,断线由于特征更加明显,在准确率和召回率、AP 值上均优于毛羽,YOLOv4、Faster R-CNN 和SSD 算法目标检测算法使用先验框,即先在图片上设定大量的先验框,网络的预测结果会对先验框进行调整获得预测框,受到被检物体尺寸的限制,对小物体检测效果不佳。CenterNet-CBAM 得到的瑕疵置信度和IOU 值都较高;CenterNet 中出现了部分目标未被检出的情况;YOLOv4 对于毛羽瑕疵出现了错检的情况,部分毛羽被检测为断线;Faster R-CNN的识别结果出现了错检和复检的情况;而SSD 的识别置信度较低,且有漏检问题。综合比较过后发现CenterNet-CBAM 算法识别效果最佳,如图16所示。

图16 不同算法毛羽检测效果对比Fig.16 Detection effect comparison of different algorithms

在CenterNet-CBAM、CenterNet、YOLOv4、Faster R-CNN、SSD 五种算法中,mAP 值最高的是CenterNet-CBAM 算法,达92.95%,如图17 所示。CenterNet 网络中加入CBAM 后,加强提取任务相关的特征,抑制任务无关的特征,重新定义每个通道和空间特征的重要性,以较小的开销达到提升网络性能、提高模型识别率和加快模型收敛速度的效果。通过加入特征融合,强化了特征图的细节信息,提高了小目标检测能力。实验结果表明,嵌入CBAM 注意力机制和特征融合的CenterNet 算法在准确率和召回率上有提升,相较于其他算法,本算法有更高的识别率,可以为化纤丝饼生产提供精准的检测服务。

图17 算法性能对比直方图Fig.17 Algorithm performance comparison histogram

本文实验也存在一定的局限性:1)单个相机的拍摄范围有限,后期选用多相机阵列式组合可以提高采样率;2)实验后可以将毛羽进行进一步分类,通过更加精细的分类,有助于丝饼的分级工作,出现频率较高的瑕疵类型归因为设备故障,克服了传统的人工检测方式具有的滞后性,准确及时地根据缺陷类型来排除生产故障;3)后续研究将进一步更新模型,使用目标检测中的非卷积算法ViT (vision transformer)等进行计算。

5 结束语

本文提出面向丝饼微小毛羽的检测方法,通过搭建图像采集平台构建丝饼瑕疵数据集,使用放大镜头检测微小物体特性,获得新的丝饼瑕疵图像。将注意力机制加入丝饼检测算法当中,mAP 值达到92.95%,对比多种算法检测结果后,验证CenterNet-CBAM 在准确率、召回率上均有更好的表现,验证了所提出的智能视觉检测系统的有效性。