基于注意力与多尺度特征遥感图像建筑物分割

2022-12-30刘全德

刘 艳,刘全德,3+

(1.大连大学 信息工程学院,辽宁 大连 116622;2.大连大学 大连市环境感知与智能控制重点实验室,辽宁 大连 116622;3.山东港口科技集团日照有限公司,山东 日照 276800)

0 引 言

近年来,随着城市化进程的不断加快,高分辨率遥感影像建筑物提取在城市规划、人口估算和智慧城市三维重建等方面越来越重要。作为像素级分割问题,特征提取是关键,常用方法有两大类[1]:一是人工提取特征,二是基于深度学习自动提取特征。人工提取方法只利用目标浅层特征,未涉及复杂建筑物深层的多尺度特征,提取精度低[2]。Alshehhi等[3]用卷积神经网络图像块分类方法自动学习和提取道路及建筑物特征,分割中块状区域会产生模糊锯齿状边缘[4],全连接层使批处理过程存在大量冗余计算,占用内存大。Sun等[5]采用全卷积神经网络FCN语义分割架构,用卷积层代替网络中的全连接层,减少冗余计算,用反卷积进行语义分割,消除图像块分割中块状区域带来的锯齿状边缘,但空间信息损失严重,对图像细节不敏感。Ronneberger等[6]提出一种U-Net架构,在FCN基础上增加跳跃连接拼接深层和浅层图像特征,解决网络信息损失严重问题,但仅关注恢复特征图的分辨率,忽略了深层次特征获取和不同层次特征之间的语义鸿沟问题。Zhou等[7]优化原U-Net网络结构,设计嵌套密集跳跃连接,构建新U-Net++网络,减小深层和浅层特征之间语义鸿沟,但无法精确提取深层特征。Chaurasia等[8]为提取深层次特征,在传统U-Net中引入ResNet18连接编码器与解码器,构建了实时轻量级网络LinkNet,但忽略了图像多尺度信息。Zhou等[9]提出D-LinkNet模型,在LinkNet基础上加入并联空洞卷积层,执行道路提取任务,在不损失分辨率的同时增大感受野,提高挖掘全局上下文信息能力,但易错误分割且分割连续性差。大量研究表明[10],上述编码-解码器网络在遥感图像分割中对小建筑物分割效果并不理想,未考虑建筑物集群间的边界粘连问题。

本文基于U-Net网络提出融合注意力机制与多尺度特征增强的语义分割模型FAME-Net。优化编码器网络,融合其通道和空间维度注意力机制,提高对小型建筑物特征提取能力;在网络中增设锚点特征增强C-ASPP模块;解码阶段进行多尺度特征融合,引入平均损失函数,有效利用多尺度特征。在Inria遥感影像数据集上验证本方案的有效性和实用性。

1 FAME-Net网络结构

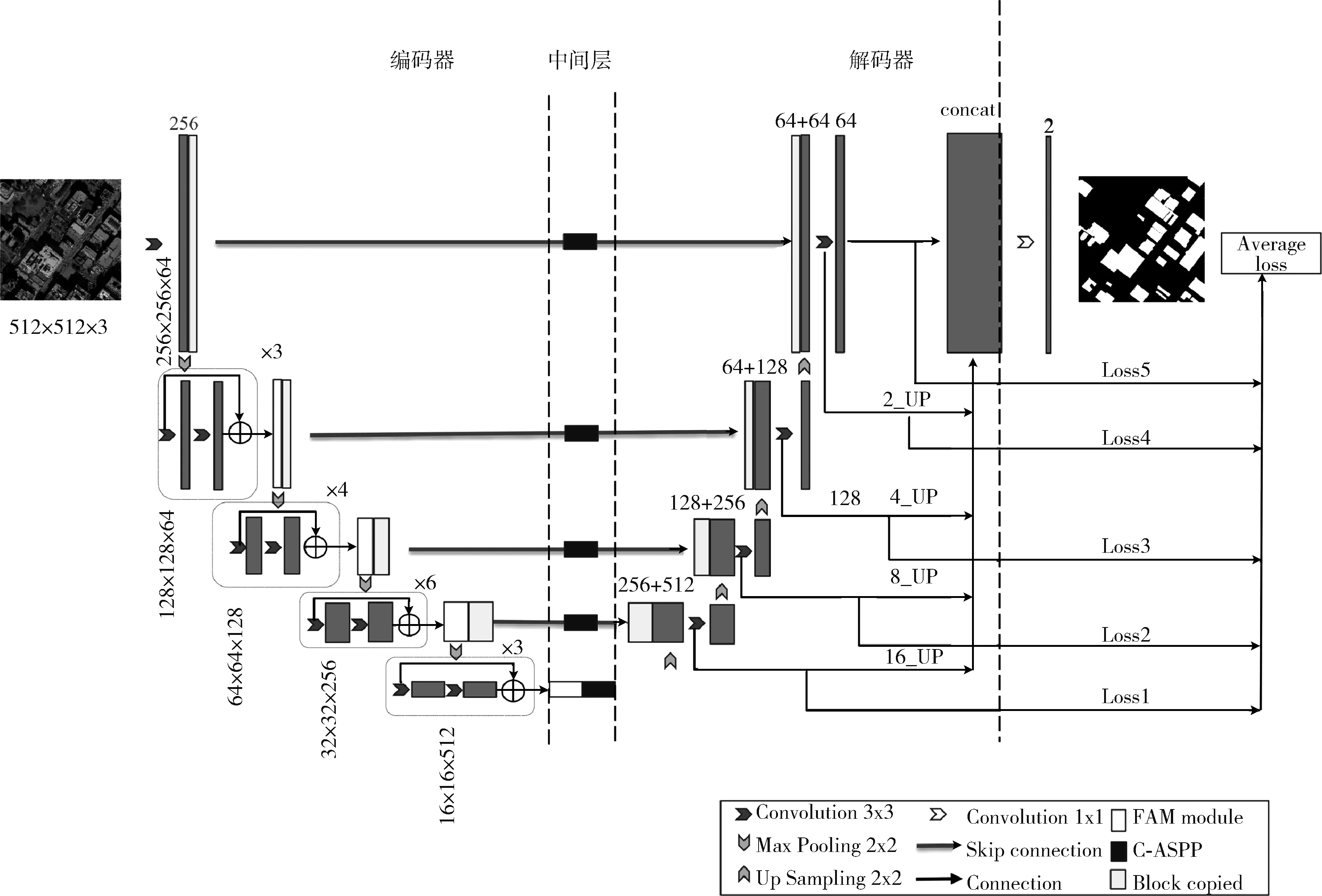

传统U-Net模型网络较浅,无法提取深层次特征;上采样和下采样操作中存在信息丢失问题;不具备小目标和集群边界粘连分割能力。因此,本文构建一个端到端的语义分割网络模型FAME-Net。结合恒等映射残差网络,优化传统U-Net网络结构,在编码器中用残差网络取代编码器原有网络结构,解决遥感影像细节空间深层次特征的提取问题,保证模型不退化,同时在残差网络中融合了通道和空间注意力机制,使模型专注于学习建筑物特征,有效抑制无关信息干扰,改善中小型建筑物分割精度。增设中间层—空间金字塔池化层C-ASPP,重新整定空洞卷积扩张率,平衡模型对大小目标的敏感度;引入拉普拉斯算子,优化卷积核锚点权重系数,提高建筑物边缘轮廓的描述能力。在解码器中添加特征融合机制,通过设计平均损失函数,提高不同尺度的特征信息利用率。本方案FAME-Net模型由编码器、中间层、解码器三部分组成,如图1所示。

图1 FAME-Net特征增强网络结构

1.1 融合注意力机制的残差网络

编码器特征提取能力对图像分割的结果影响很大。卷积神经网络越深所提取的特征越抽象,语义信息越多,传统U-Net网络分割方法网络层数较少,无法有效提取遥感图像深层次特征,图像细节描述能力不足,增加编码器网络层数则会出现梯度消失和梯度爆炸模型退化问题[11]。

为此,本文在编码器中用恒等映射残差网络获取深层次特征,同时规避模型退化问题。考虑残差网络全连接层带来的参数冗余,本文设计了一个不含全连接层的ResNet33残差网络,如图2所示。

图2 ResNet33残差网络

增加残差网络深度能提升特征表达能力,但获取的深层次特征缺乏语义信息,会对建筑物分割造成干扰,不能从根本上解决小目标分割和边界粘连问题。为此,本文引入注意力机制捕获全局关键语义信息,加大建筑物区域权重,提高模型对建筑物的分割能力。常用的挤压和激励(squeeze-and-excitation)SE通道注意力[12]模块缺乏空间位置信息,降维操作对小目标分割效果不佳[13]。受卷积块注意力模块CBAM(convolutional block attention module)[14]和高效通道注意力ECA(efficient channel attention)[13]模块的启发,本文在编码器中对通道注意力机制和空间注意力机制进行级联融合,设计了如图3所示的融合注意力机制(fusion attention mechanism,FAM),其中,σ代表Sigmoid激活函数,W,H,C分别代表特征图的宽、高和通道数。

图3 融合注意力机制

为获取不同通道信息,捕获信息的跨通道交互,提高小型建筑物的提取能力,本文在通道注意力机制SE基础上,提出一个改进的通道注意力机制CAM,如图3所示。首先,用不降维方法取代降维方法,对特征图U进行通道级全局平均池化GAP(global average pooling),获取不同通道信息,实现挤压操作;其次,取消全连接层,使用卷积核大小为kyw的快速一维卷积捕获跨通道局部交互信息,用Sigmoid激活函获取通道权值,得到高效通道依赖关系,减少参数量,降低模型计算复杂度,kyw由通道附近参与注意力预测的通道数C自适应确定,式(1)中的 |.|odd表示最近奇数,β=2,b=1。最后,将通道权值与输入特征图点乘,进行权重分配,得到不同重要程度的通道特征图,提升网络对主要特征的敏感度,抑制无用特征的干扰空间注意力模块SAM先经过全局最大池化GMP(global maximum pooling)[15]获取当前空间感受野下的细节信息,经1×1卷积,Sigmoid激活函数获取空间维度的加权特征图。为有效获得通道下精确的空间位置特征信息,将CAM与SAM进行级联,加大建筑物区域权重,增强目标区域有效特征。

(1)

融合注意力机制的输入输出尺寸与每层残差网络的输入输出保持一致,为获取每一层目标区域特征,如图4所示,将融合注意力机制添加至每层残差单元后,保证有效获取建筑物关键位置有效特征,屏蔽树木、道路等环境因素干扰。

图4 融合注意力的残差网络结构ResNet33

1.2 锚点特征增强的空间金字塔池化

在遥感图像特征提取过程中,编码器网络为增大感受野,图像尺寸每经过一次池化层的下采样操作被缩小到1/4,使得3/4的像素信息被丢失,这些像素信息在上采样时无法重建,导致特征提取效率下降,影响建筑物分割的准确性。为此,本文在编码器和解码器之间引入了空洞空间金字塔池化层ASPP,在减少分辨率损失的基础上,增大感受野获得多尺度的信息。

在卷积神经网络中,卷积核尺寸和扩张率决定了感受野的大小[16],如式(2)所示,式中RF为感受野大小,r为扩张率,kkd为空洞卷积核大小

RF=kkd+(kkd-1)(r-1)

(2)

不同尺度感受野对比如图5所示,大小感受野对不同尺度的目标识别能力是不一样的,图5(b)、图5(c)中,小感受野提取大建筑物会导致采样信息丢失,大感受野提取小建筑物会引入不必要的周围环境干扰信息,如树木、道路,合适的感受野能保证建筑物的分割准确度。

图5 不同尺度感受野对比

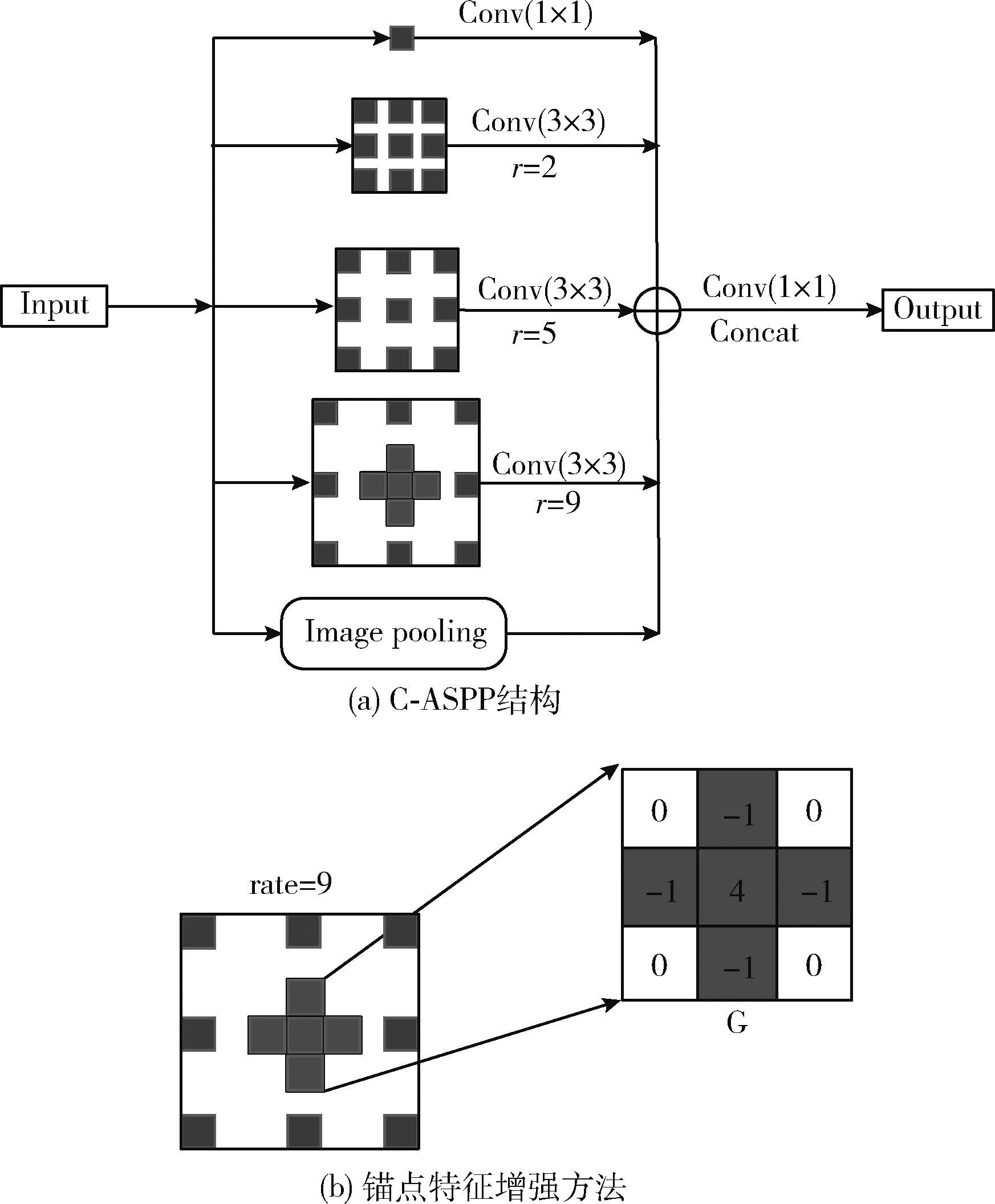

由式(2)知,空洞空间金字塔ASPP中扩张率为1,6,12,18的卷积核的感受野分别是1×1,13×13,25×25和37×37,其中25×25和37×37感受野较大,导致远距离卷积得到的信息无相关性[17],对小目标敏感度降低,不利于遥感图像中微小物体的分割。ASPP中3×3卷积核的扩张率全为偶数且有公约数6,仍会导致像素之间信息不连续,存在一些空洞,使一些像素被遗漏,从而产生局部信息丢失[18]。

为平衡模型对大小目标的敏感度,本文借鉴混合空洞卷积(HDC)[18]的思想,优化扩张率过程中引入式(3)所示的约束条件,将扩张率设计为锯齿状结构,满足大目标小目标的分割要求。式(3)中,ri是第i层的扩张率,Mi是第i层的最大扩张率

Mi=max[Mi+1-2ri,Mi+1-2(Mi+1-ri),ri]

(3)

为规避棋盘效应,减少信息丢失,根据遥感图像特征图尺寸和感受野需求,本文使用奇偶混合扩张率法对卷积核进行扩张,鉴于HDC要求叠加卷积的扩张率不能有大于1的公因数,采用式(3)重新整定ASPP扩张率为1,2,5,9,覆盖了图像上的每个像素点,避免信息丢失,扩张率整定后卷积核的感受野分别减小为1×1,5×5,11×11,19×19,解决了小目标的提取问题,有效平衡了模型对大小目标的敏感度。

ASPP采用的是4个并行不同扩张率的空洞卷积,即使用多个感受野提取图像特征,随着扩张率的增大,非零采样点占比快速下降,卷积核锚点位置信息权重被弱化,影响模型对遥感图像建筑物边缘轮廓的描述能力。

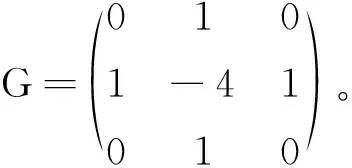

在高斯权重的基础上,引入感受野大小,得如式(4)所示的卷积核锚点位置权重PW计算式,其中, (x,y) 为卷积核的坐标位置,PSD为该坐标位置的标准差。由式(4)知,扩张率2,5,9卷积核锚点位置权重分别为0.064、0.013、0.004,显然扩张率为9的卷积核对边缘轮廓的描述能力被严重弱化

(4)

为此,本文设计的锚点特征增强的C-ASPP结构如图6所示,仅针对最大扩张率的卷积核锚点进行特征增强,图6(a)中在扩张率为9的卷积核中引入了拉普拉斯算子[19],进行锚点权重系数优化,构建锚点特征增强的空间金字塔池化C-ASPP模块。为增强特征图中心区域的权重信息,如图6(b)所示,用拉普拉斯边缘检测算子G替换卷积核锚点及其4邻域的值,将锚点及其4邻域作为有效点一同提取特征,在拉普拉斯边缘检测算子构成的3×3卷积中,利用局部空间特征信息提取新的锚点边缘特征信息权重IW,卷积过程如式(5)所示,卷积输出结果作为锚点的特征信息

图6 锚点特征增强的C-ASPP结构

X*G=IW

(5)

1.3 多尺度特征融合与平均损失函数

浅层特征和深层特征在空间和语义表达能力方面有着不同的优势,浅层特征虽然感受野较小,但包含了丰富的空间结构信息,适合处理小目标;深层结构虽然感受野较大,适合大目标分割,但空间几何特征细节缺乏,不适合小目标的处理。为提升FAME-Net小目标分割性能,如图1所示,本文在解码器中使用融合层策略设计一个多尺度特征融合模块,将浅层特征和深层特征进行融合。为求取N层特征图的多尺度损失,设计了如下平均损失函数LFinal

(6)

由图1可知,N=5,式中复合损失函数LBCE-Dice由二值交叉熵损失函数LBCE和Dice系数损失函数LDice表述,λ用于平衡两个损失函数,λ值由损失函数超参数权重实验获取,在此取为0.1

LBCE-Dice=λLDice+LBCE

(7)

LBCE由式(8)计算,其中P表示预测值,GT表示真实值,w和h分别代表图像的宽度和高度,gtij和pij代表真实值和预测值的每个像素点

(8)

LBCE对类别不平衡图像中正样本像素类别特征学习困难且易陷入局部最优,导致训练出的模型鲁棒性不佳[20],为此,本文引入LDice[21]用于提高模型鲁棒性,其定义如下

(9)

为规避U-Net解码器使用双线性插值逐层上采样造成的信息丢失问题,特征融合中将不同层次的特征图进行16倍、8倍、4倍、2倍的上采样直接还原成原有特征图尺寸。利用通道维度Concat方法将不同尺度特征进行拼接,充分利用多尺度的特征信息。

2 实验与结果分析

为验证所提方案对小型建筑物多尺度遥感图像的分割性能,基于Inria遥感影像公开数据集[22],将本文所提模型与U-Net、Link-Net、D-LinkNet和U-Net++在模型精度、小型建筑物识别和边界粘连分割等方面进行对比实验,验证所提方法有效性。

2.1 Inria遥感影像数据集

2.2 实验配置与训练

2.2.1 实验平台

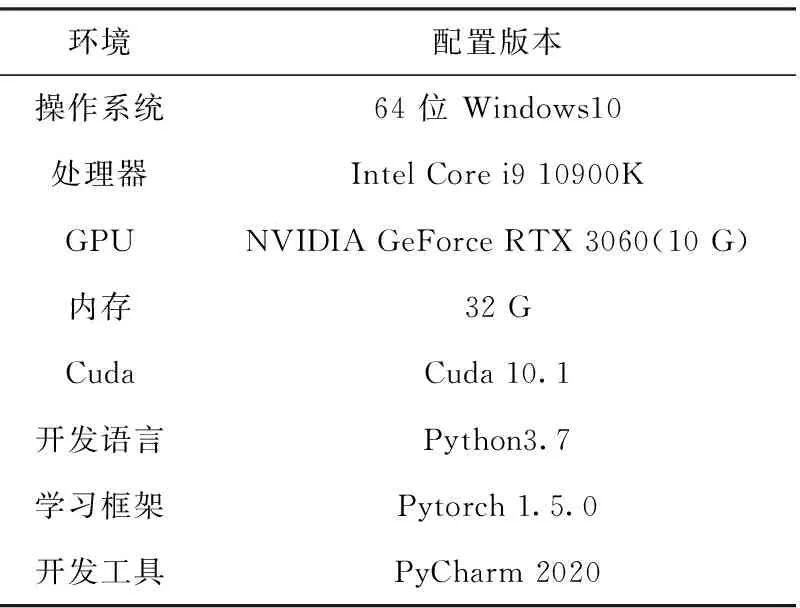

为验证本文所提算法的优越性,建立对比实验,本文所有实验的软硬件环境配置均保持一致,见表1。

表1 实验环境配置

2.2.2 实验设计

本文模型训练采取交叉验证的方法,每次训练随机选择验证集批量数据计算损失和精度,并优化模型的训练。由于GPU显存限制,每个batch由乱序的4张图片组成,Batchsize设置为4。

训练时,一个批次包含4幅512×512×3的RGB图片,模型预测输出与输入图片标签进行比较,计算训练损失,评估训练网络拟合能力。为使网络快速收敛,自适应调节学习率,使用带动量的Adam算法[23]作为优化器,初始学习率设为0.0001,动量为0.9。所有训练数据在每一轮迭代结束后用验证集数据再次对模型拟合能力进行评估,保存最佳权重参数,迭代1000次。

预测阶段,利用评价指标在Inria遥感影像数据集上对最佳权重模型进行性能测试与分析。在相同的实验条件下,分别对U-Net、Link-Net、D-LinkNet、U-Net++和本文所提的FAME-Net模型在迭代性能、模型精度和图像分割性能进行预测分析。

2.2.3 评价指标

为量化评价遥感图像建筑物分割性能,本文分别采用式(10)、式(11)所示的平均交并比(mean intersection over union,mIoU)和F1分数(F1 score)作为评价指标,F1分数是计算精确率和召回率的调和均值,mIoU和F1的取值均介于[0,1],mIoU越接近1分割结果越精确,F1分数越接近1模型鲁棒性越高。实验中,正确判断为建筑物的样本记为TP,错误判断建筑物的样本记为FP;正确判断背景的样本记为TN,错误判断背景的样本记为FN

(10)

(11)

2.3 性能测试与结果分析

2.3.1 迭代性能与模型精度分析

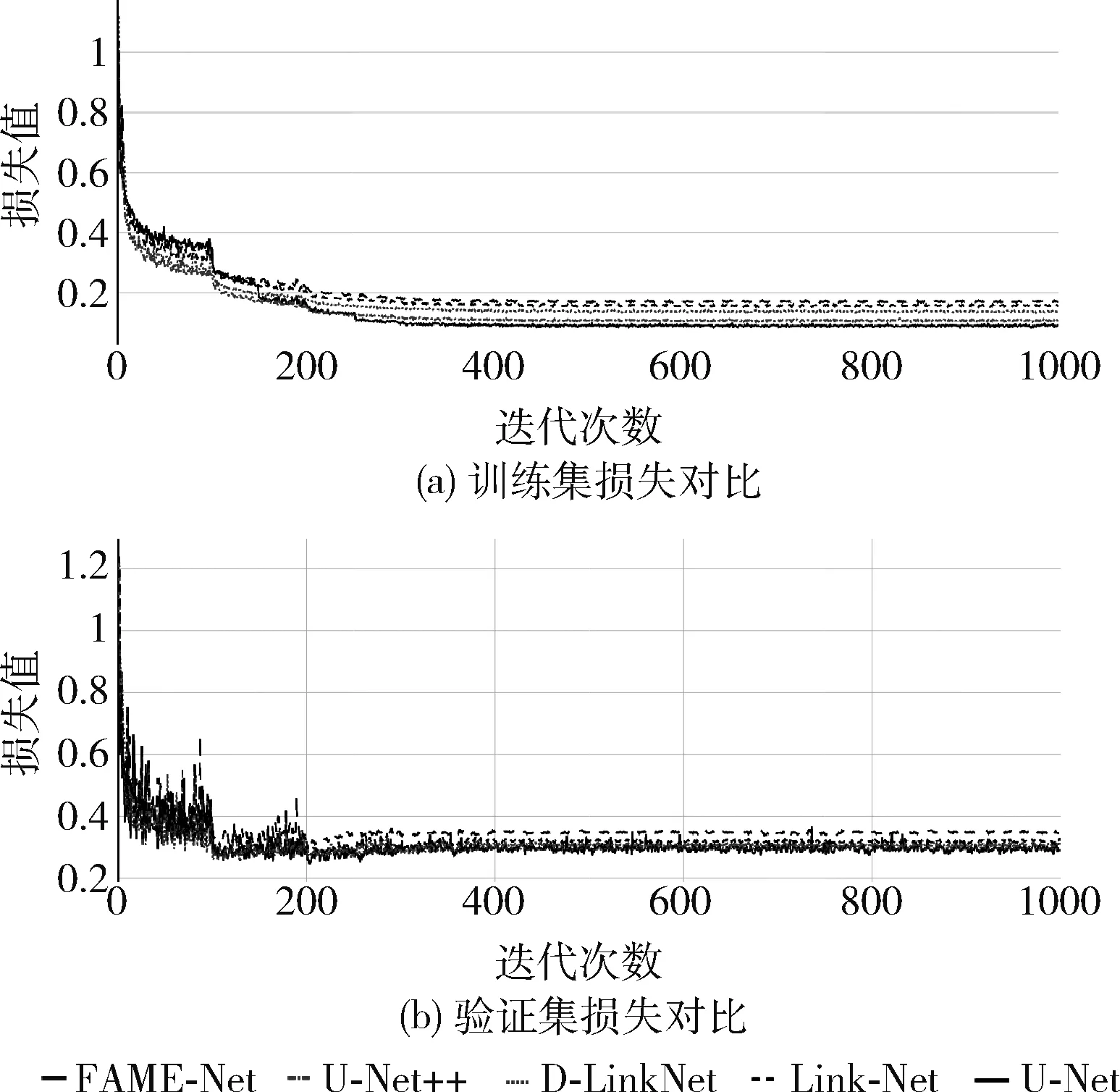

经过1000次迭代,U-Net、Link-Net、D-LinkNet、U-Net++和本文所提FAME-Net模型损失和精度对比如图7和图8所示。横坐标Epoch表示迭代次数,图7纵坐标表示损失值,图8纵坐标为平均交并比。训练损失和验证损失分别衡量模型在训练集和测试集上的拟合能力,损失值越小表示预测结果和真实结果越逼近,模型的拟合度越好。由图7(a)可以看出,经过迭代200次U-Net、Link-Net、D-LinkNet、U-Net++网络趋于收敛,上述网络前期拟合速度较快,迭代300次左右5个网络均收敛,FAME-Net损失值小于0.01,明显小于其它模型,且无过拟合现象。由图7(b)看出,受GPU显存限制,实验中Batchsize取值偏小,导致验证损失曲线震荡较剧烈,但与训练损失基本一致,模型整体训练较好。

图7 不同模型损失对比

图8 平均交并比

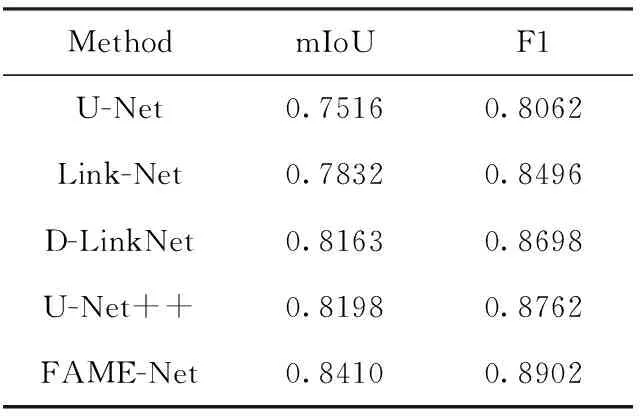

由图7可知,所有测试模型在迭代300时基本收敛,由图8和表2可以看出,训练模型收敛时,在平均交并比方面,U-Net、Link-Net、D-LinkNet和U-Net++分别为75.16%、78.32%、81.63%、81.98%,本文FAME-Net模型为84.10%,均高于其它网络模型,比U-Net高出近9%;在F1分数方面,U-Net为80.62%,Link-Net 为84.96%,D-LinkNet为86.98%,U-Net++为87.62%。本文FAME-Net模型为89.02%,比D-LinkNet和U-Net++网络高出近3%。综上表明,FAME-Net模型在遥感图像建筑物提取任务中具有较好的分割精度,同时拥有更加平衡的精确度和召回率,模型鲁棒性高。

表2 各个模型的评价指标

2.3.2 小型建筑物识别结果分析

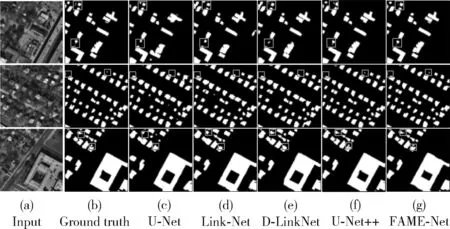

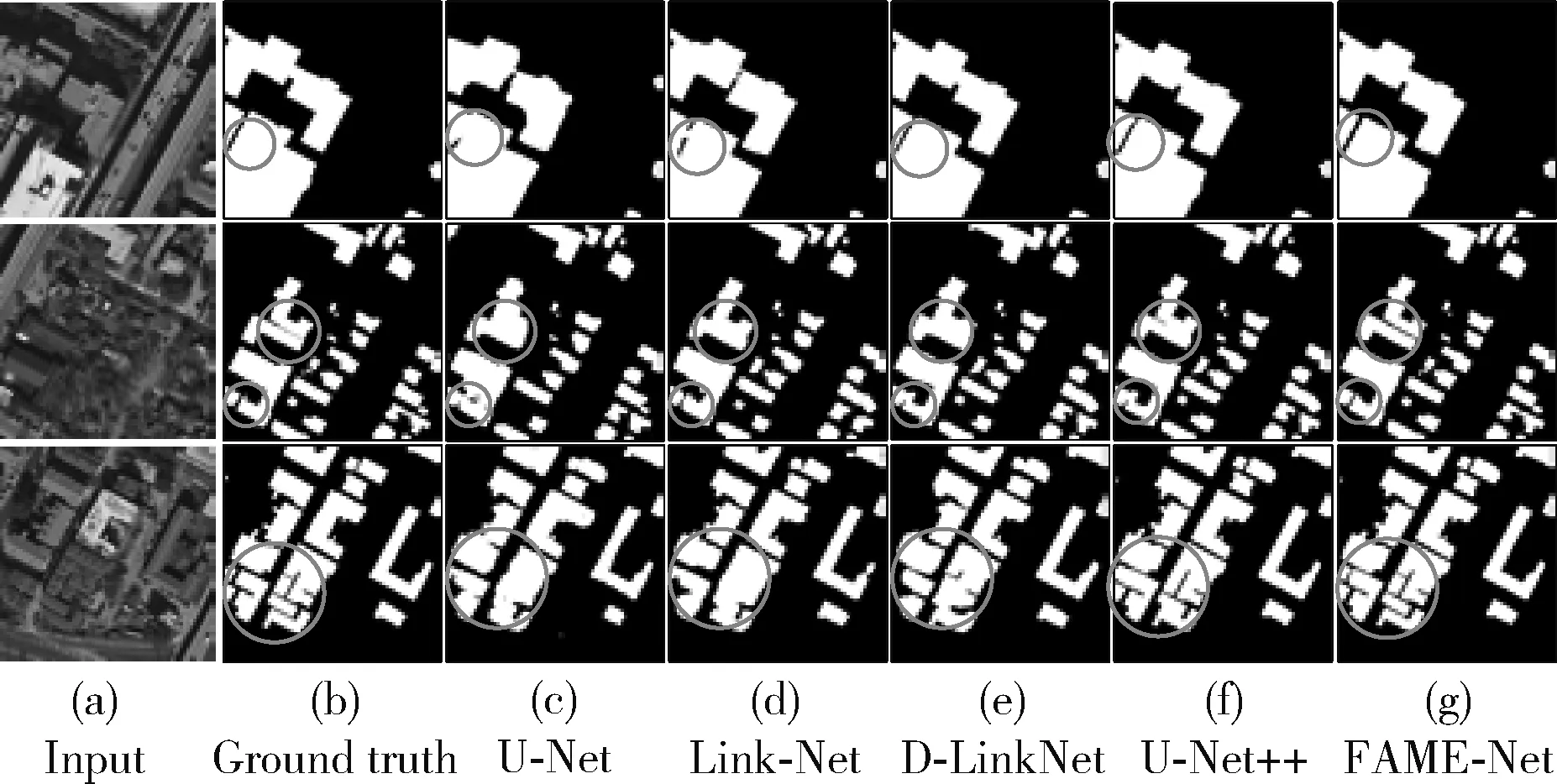

为验证FAME-Net对小型建筑物目标提取和建筑物集群边界粘连分割性能,本文随机选择了6幅包含小型建筑集群区域的数据集进行测试,该区域建筑物排列错综复杂,形状、大小、屋顶颜色都各不相同。图9和图10分别展示了对比方法和本文所提方法在Inria遥感影像数据集上对建筑物的分割结果。图中黑色代表背景,白色代表建筑物,其中图(a)为RGB三通道的遥感图像,图(b)为建筑物真实标签,图(c)~图(g)分别为U-Net、Link-Net、D-LinkNet、U-Net++和FAME-Net模型分割结果。

注:□为标记的小型建筑物分割情况图9 小型建筑物提取结果

注:○为标记的建筑物集群粘连分割情况图10 建筑物集群边界粘连分割结果

由图9实验结果可知,图9(c)和图9(d)在分割与地面和植被颜色无差别的建筑物时均存在漏分、错分现象,主要原因在于池化操作导致的信息丢失较多;图9(e)和图9(f)由于分别引入空洞卷积和新设计跳跃连接,增大了全局感受野,对不同尺寸建筑物信息比较敏感,一定程度上弥补了丢失的细节信息,相比于图9(c)~图9(d)的误分问题明显减少;图9(g)对不同尺寸的建筑物分割效果均优于图9(c)~图9(f),主要原因在于C-ASPP模块重新调整的扩张率和多尺度特征融合结构对不同尺度的目标具有很好的适应性,增强了不同尺度特征之间的关联性,使模型对不同尺寸建筑物提取性能明显提升。从图9(c)~图9(g)方框处对比可知,U-Net、Link-Net和D-LinkNet模型,对像素较小的建筑物提取能力均较差,第一行和第二行的小建筑物未识别出来,第三行将距离过近的小建筑物识别为一个整体,FAME-Net模型与其它3种模型相比,对小型建筑物的识别较为准确,分割准确率明显提升,并未出现整个建筑物的漏分割,仅存在小部分建筑物由于遮挡过重导致预测不完整情形,原因在于FAME-Net的不降维级联融合注意力机制既能抑制道路、树木、车辆等无关信息的干扰,又能准确获取小型建筑物关键的空间信息。

2.3.3 建筑物集群边界粘连分割结果分析

建筑物集群的边缘分割结果如图10所示,图10(c)~图10(f)圆圈处由于树木、道路等外物的干扰,且相邻建筑物距离过近,训练中难以准确提取其边缘特征,存在较为明显的边界不连续和粘连问题,图10(g)相同位置处的建筑物边界分割存在着明显的改善,克服了复杂背景影响,有效地保留了建筑物边界信息,建筑物轮廓清晰、完整,未出现较为明显的误预测,主要原因在于本文设计的锚点增强空间金字塔池化C-ASPP模块,引入拉普拉斯算子,将锚点及其4邻域作为有效点一同提取特征,在级联融合注意力机制屏蔽无关信息干扰情况下,对建筑物边缘轮廓特征进行增强。

3 结束语

针对目前遥感影像分割存在边界不清楚、小目标分割难等问题,本文提出一种FAME-Net语义分割模型。在编码阶段使用ResNet33作为主干网络并在空间和通道上融合注意力机制,提高了模型对小型建筑物能力。编码器和解码器中间设计了中心空间金字塔层C-ASPP,重新整定扩张率,平衡了模型对大小目标的敏感度;引入拉普拉斯算子,增强了模型对建筑物边缘的学习能力。在解码阶段对多尺度信息进行融合,设计特征融合的平均损失函数,有效利用了多尺度特征。在Inria遥感影像数据集上与主流模型进行了对比实验,结果表明,本文提出的FAME-Net模型能有效解决遥感图像建筑物小目标分割和边界粘连分割问题,模型迭代性能良好,分割准确率高。