基于注意力模型和轻量化YOLOv4的林业害虫检测方法

2022-11-30孙海燕陈云博封丁惟王通蔡兴泉

孙海燕,陈云博,封丁惟,王通,蔡兴泉

基于注意力模型和轻量化YOLOv4的林业害虫检测方法

孙海燕,陈云博,封丁惟,王通,蔡兴泉*

(北方工业大学 信息学院,北京 100144)(∗通信作者电子邮箱xingquancai@126.com)

针对当前林业害虫检测方法检测速度慢、准确率较低和存在漏检误检等问题,提出一种基于注意力模型和轻量化YOLOv4的林业害虫检测方法。首先构建数据集,使用几何变换、随机色彩抖动和Mosaic数据增强技术对数据集进行预处理;其次将YOLOv4的主干网络替换为轻量化网络MobileNetV3,并在改进后的路径聚合网络(PANet)中添加卷积块注意力模块(CBAM),搭建改进的轻量化YOLOv4网络模型;然后引入Focal Loss优化YOLOv4网络模型的损失函数;最后将预处理后的数据集输入到改进后的网络模型中,输出包含害虫种类和位置信息的检测结果。实验结果表明,该网络的各项改进点对模型的性能提升都有效;相较于原YOLOv4模型,新模型的检测速度更快,平均精度均值(mAP)更高,并且能有效解决漏检和误检问题。新模型优于目前的主流网络模型,能满足林业害虫实时检测的精度和速度要求。

林业害虫检测;轻量化网络;注意力模型;损失函数

当前,林业病虫害的威胁在逐年增加,很大程度上阻碍了林业的发展。林业是维护生态平衡的重要基础,我国经济的发展也离不开林业资源的支持。高效、准确地检测并判别出害虫种类是害虫测报和合理防治的重要前提。

传统林业害虫检测方法主要有人工检测法和诱捕法[1],这些方法依靠个人的专业经验进行辨别,效率较低,实时性较差,且主观性较强。因此,本文主要研究高效自动的林业害虫识别检测方法,在保证检测精确度的基础上,提升检测速度,为林业虫害的发生提供及时的预警。

1 相关工作

为了实现高效的林业害虫检测,已经有一些学者开始研究智能化林业害虫检测方法,主要分为基于传统机器学习的方法和基于深度学习的方法。

基于传统机器学习的林业害虫检测方法主要针对不同害虫单独设计并提取包括颜色、形状、纹理等的害虫图像特征,然后送入训练好的分类器进行分类[2];但是此类方法需要手工提取特征,特征提取过程繁琐且存在害虫特征设计的局限性。

随着计算机视觉技术和深度学习的飞速发展,基于深度学习的林业害虫检测方法逐渐发展起来。基于深度学习的方法避免了手工设计特征的繁琐过程,能够让计算机自动学习害虫特征,具有速度快、精度高等优点,逐渐成为研究热点。当前,深度学习目标检测网络主要分为两大类,即单阶段目标检测网络和双阶段目标检测网络。双阶段目标检测网络代表性网络模型有Fast‑RCNN(Fast Region‑based Convolutional Neural Network)[3]、Faster‑RCNN(Faster Region‑ based Convolutional Neural Network)[4]、R‑FCN(Region‑based Fully Convolutional Network)[5]和特征金字塔网络(Feature Pyramid Network, FPN)[6]。双阶段目标检测需要进行两步操作:首先用候选区域算法在输入图像中生成建议目标候选区域,然后将所有的候选区域送入分类器进行分类。双阶段目标检测算法的检测精度较高但检测速度较低。相比较而言,以YOLO(You Only Look Once)[7-10]和SSD(Single Shot multibox Detector)[11]为代表的单阶段目标检测算法更注重检测精度和速度的平衡,在人脸识别、自动驾驶、医疗诊断和安防等领域得到了广泛的应用。因此,本文主要研究单阶段目标检测方法。

苗海委等[12]提出了一种基于深度学习的粘虫板储粮害虫图像检测算法,通过改进SSD的目标框回归策略、损失函数和特征提取网络结构,实现了放置在粮仓表面粘虫板诱捕的六类害虫的定位和识别;但是由于模型不够轻量化,训练速度和检测效率不高。候瑞环等[13]提出了一种基于YOLOv4‑TIA的林业害虫检测方法,通过改进YOLOv4模型结构和优化损失函数,实现了对特定类别的林业昆虫的检测;但是模型复杂度有所增加,检测速度较慢。袁哲明等[14]提出了一种轻量化深度学习模型的田间昆虫自动识别与分类算法,通过对YOLOv3进行一系列轻量化改进,实现了田间昆虫自动识别与分类;改进后的模型参数量大大减小,但检测精度没有明显提高,平均识别正确率只有70.98%。

李启运等[15]指出模型压缩和轻量化模型设计是加速模型的重要手段,因此以SqueezeNet[16]、MobileNet[17-19]和ShuffleNet[20-21]为代表的轻量化网络模型受到越来越多的关注和应用。Han等[22]在2020年提出了GhostNet轻量级神经网络。为了减少计算量,Ghost模块将原始的卷积层分成两部分:先生成少量内在特征图,然后通过一系列线性变换生成更多特征图。MobileNetV3[19]集合了MobileNetV1[17]和MobileNetV2[18]的优点,并在它们的基础上做了进一步改进,大大减少了参数量,提升了速度且避免了精度损失。另外,在神经网络架构中引入卷积块注意力模块(Convolutional Block Attention Module, CBAM)[23],能够在不增加过多计算开销的情况下,给网络性能带来实质性的提升。受这些文献研究的启发,本文主要研究基于注意力模型和轻量化YOLOv4的林业害虫检测方法。

2 本文方法

针对当前林业害虫检测方法模型参数量大、检测速度慢、准确率较低和存在漏检误检等问题,本文主要研究基于注意力模型和轻量化YOLOv4的林业害虫检测方法。主要步骤包括:预处理数据、改进YOLOv4网络模型、引入Focal Loss优化损失函数和利用YOLO‑Head输出检测结果,详细介绍如下。

2.1 数据预处理

为提升模型的性能,在提取图像特征之前,需要对数据集进行预处理。首先,收集林业害虫图像,构建数据集;然后,对构建的数据集图像进行几何变换、随机色彩抖动和Mosaic处理,增强数据集;最后,划分增强后的数据集,完成数据集的预处理。

2.1.1构建数据集

本文以北京林业大学公开的林业害虫数据集(https://aistudio.baidu.com/aistudio/datasetdetail/34213/0)为基础,该数据集出自百度飞桨与北京林业大学合作开发的AI识虫比赛,共计2 183张图像,全部为白色单一背景,包含7种类别的林业害虫。在实际应用场景中,林业害虫所处的自然环境多为复杂背景。为了符合林业害虫检测的实际需求,本文以此数据集为基础,通过网络爬取等方法,收集林业真实条件下、具有复杂背景的这7种害虫图像,进一步扩充数据集。最终,收集整理得到7种类别、共计3 233张图像,每张图像包含至少一种类别的害虫。至此,数据集的构建完成。每类害虫样本数量的统计结果如表1所示。

表1 每类害虫样本的数量统计

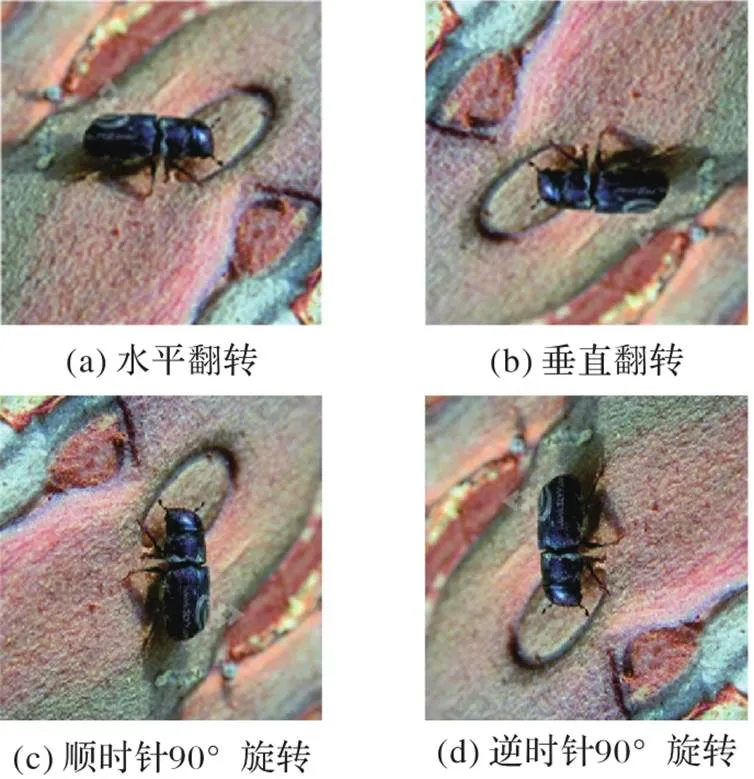

2.1.2几何变换图像

害虫的种类与它在图像中的位置、角度无关,对图像进行翻转或旋转等几何变换操作能够有效扩充数据集。本文采用在线增强方法,在输入到网络之前,对数据集中的图像进行随机水平翻转、垂直翻转、顺时针90°旋转和逆时针90°旋转,得到四种数据增强后的图像,如图1所示。

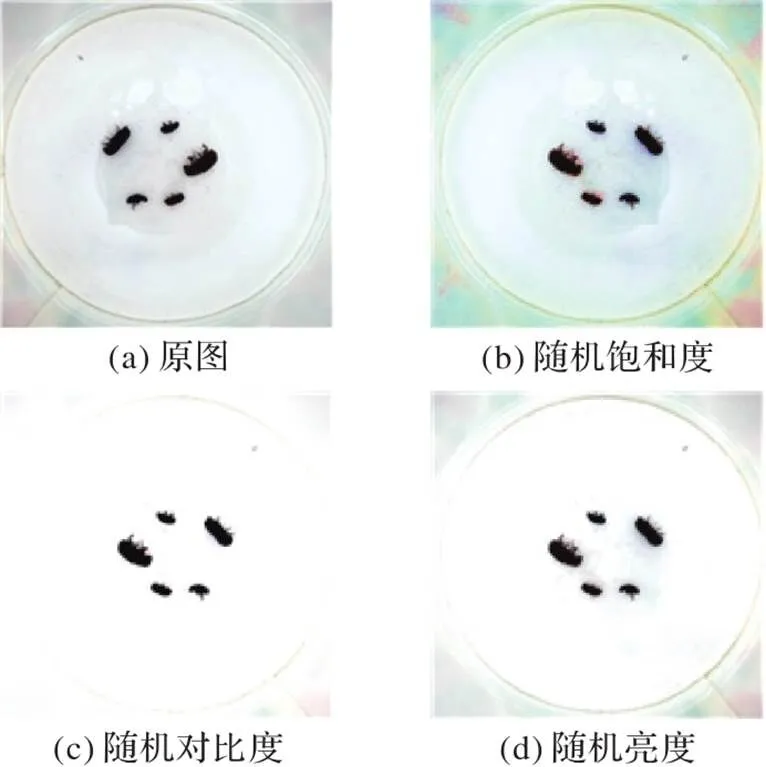

2.1.3随机色彩抖动图像

在实际自然环境中,由于拍摄环境和拍摄设备等客观因素的影响,同种害虫图像可能会具有不同的色彩信息。为了降低客观因素的干扰,本文使用随机色彩抖动的数据增强方法,得到具有不同色彩信息的害虫图像,增强模型的鲁棒性,更符合实际应用的需求。在图像数据输入到网络之前,随机抖动图像的饱和度、对比度和亮度,饱和度抖动的范围为50%,对比度抖动的范围为50%,亮度抖动的范围为20%。经过随机色彩抖动处理,得到的三种数据增强后的图像如图2所示。

图1 几何变换增强的图像示例

图2 随机色彩抖动增强的图像示例

2.1.4Mosaic数据增强

为了丰富数据集图像的背景,本文采用Mosaic数据增强方法进一步增强数据集。首先,随机选取四幅图像;然后,通过几何变换、随机色彩抖动等方式增强四幅图像;最后,将增强后的四张随机裁剪,并拼接成为一张新的图像。经过Mosaic数据增强处理得到的图像如图3所示。

图3 Mosaic数据增强图像示例

至此,利用数据增强技术扩充了本文构建的数据集,按照8∶1∶1的比例将数据集划分成训练集、验证集和测试集三个部分,为后续提取图像特征做准备。

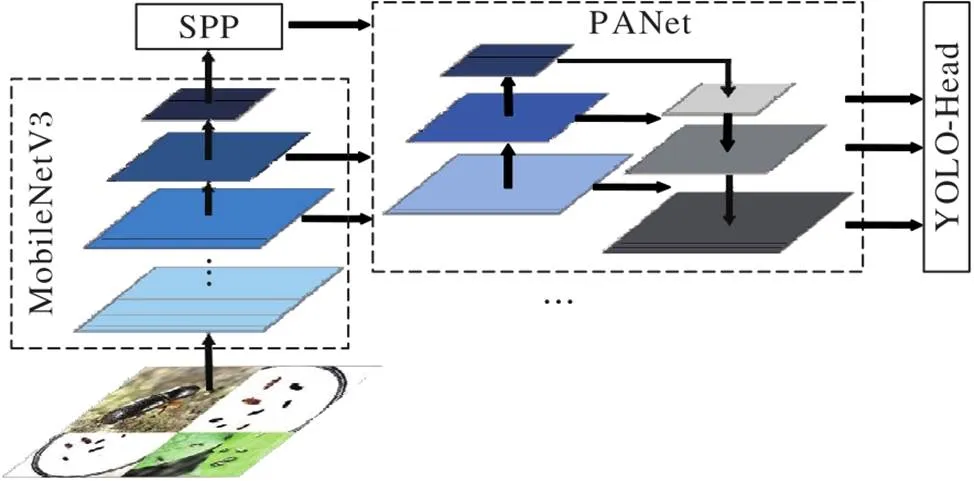

2.2 搭建改进的YOLOv4网络模型

预处理数据集后,需要搭建改进的YOLOv4网络模型以提取害虫图像中的特征。首先,搭建MobileNetV3网络提取初步特征;然后,搭建空间金字塔池化结构(Spatial Pyramid Pooling, SPP)和PANet提取深层特征,并进行特征融合;接着,在PANet中添加CBAM,以得到包含更多关键信息的特征图;最后,将得到的特征图输出,为后续害虫种类和位置的检测做准备。

2.2.1搭建MobileNetV3网络提取初步特征

为了降低参数量、提高模型的检测速度,本文采用轻量化模型MobileNetV3替换CSPDarkent53作为YOLOv4网络模型的主干网络,提取图像的初步特征。MobileNetV3主要由CBH(Conv2D‑BN‑h‑swis)卷积模块和bneck(bottleneck)卷积模块构成,如图4所示。

图4 MobileNetV3网络结构

1)搭建CBH卷积模块。首先,输入尺寸为416×416×3的原图像;然后,使用引入了h‑swish激活函数的CBH模块进行卷积操作;最后,输出尺寸为208×208×16的特征图。h‑swis激活函数如式(1)所示。

2)搭建bneck卷积模块。首先,使用1×1的CBH提取特征;然后,使用3×3的深度可分离卷积块进行卷积操作;接着,添加SE模块;最后,进行1×1的卷积操作,调整通道。

3)输出初步特征图。本文去掉MobileNetV3模型最后阶段的全连接层和Softmax层,输出最后三层卷积得到的三个不同尺寸的特征图,即52×52的特征图fm1、26×26的特征图fm2和13×13的特征图fm3。

至此,利用MobileNetV3提取得到害虫图像的初步特征图,缩小了模型体积,提升了特征提取能力,为后续提取深层特征做准备。

2.2.2搭建SPP模块和轻量化PANet提取深层特征

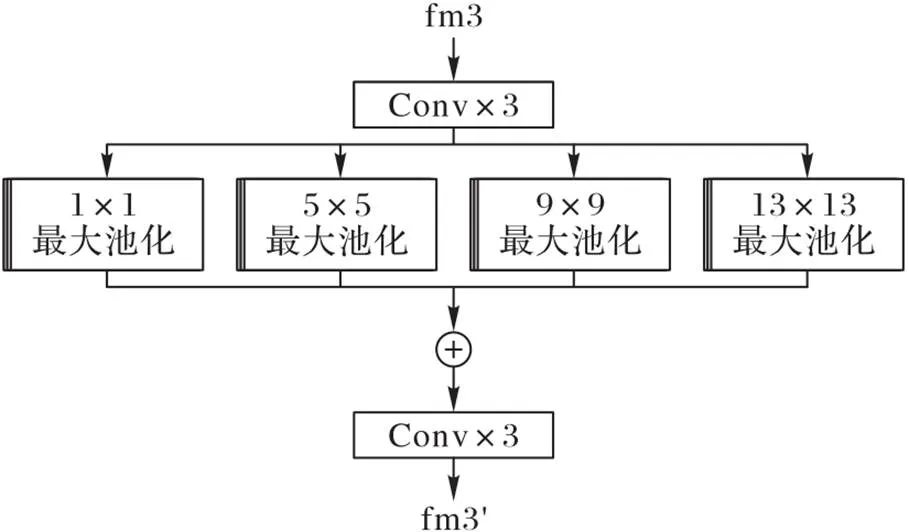

得到三个不同尺寸的初步特征图后,需要进一步提取深层特征并进行特征融合,为后续检测分类做准备。首先,搭建SPP模块,融合特征图fm3的多尺度特征,得到特征图fm3';然后,利用改进的轻量化PANet进行多次上采样、下采样和特征融合操作,得到特征图fm1、fm2和fm3'的深层特征;最后,将得到的深层特征图输出。

1)搭建SPP模块。为了有效缓解过拟合,本文利用SPP模块提取多尺度融合特征。首先,对输入的特征图fm3进行连续三次的卷积操作,提取特征;然后,进行1×1、5×5、9×9和13×13四种尺度的最大池化处理,得到多尺度特征;接着,将四种尺度的特征图进行融合;最后,经过三次卷积操作,输出尺度为13×13的特征图fm3'。SPP模块的结构如图5所示。

图5 SPP模块结构

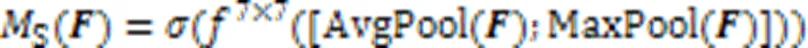

2)搭建轻量化PANet。PANet中使用多个3×3的普通卷积操作,参数量极大,计算比较复杂。为了降低PANet的参数量,本文搭建轻量化PANet提取深层特征。首先,使用深度可分离卷积块替换PANet中所有的普通卷积块,得到轻量化PANet;然后,将特征图fm1、fm2和fm3'输入到改进后的轻量化PANet;接着,进行多次上采样、下采样和特征融合操作;最后,输出三个不同尺寸的深层特征图。

至此,经过SPP模块和轻量化PANet的提取,得到三种尺寸的害虫图像深层特征图,有效缓解过拟合,扩大网络的感受野,提高网络对大目标的检测效率和准确率。

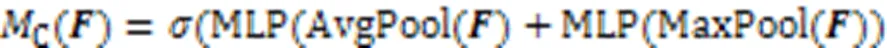

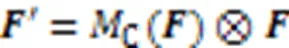

2.2.3添加CBAM

为了提升PANet提取关键信息的能力,本文在PANet中添加轻量级CBAM,得到包含更多关键信息的特征图。CBAM结构如图6所示。添加CBAM的具体步骤如下:

至此,将CBAM添加到PANet中,输出包含更多关键信息的特征图,为后续害虫种类和位置的检测做准备。添加CBAM后的PANet如图7所示。

图7 添加CBAM的PANet结构

2.3 输出检测结果

在添加CBAM并得到包含更多关键信息的特征图之后,需要对其进行回归分类预测,得到最终的检测结果。本文首先优化损失函数,然后控制迭代计算,尽可能最小化损失值,最后利用YOLO-Head进行检测,输出包含害虫种类和位置的检测结果。

2.3.1优化损失函数

由于林业害虫所处的自然环境复杂多变,所拍摄的害虫图像背景往往也很复杂,害虫形态各异,且会有遮挡等问题,导致负样本数量过大,正负样本的类别不均衡,因此,本文优化损失函数,控制迭代计算,提升模型检测分类效果。具体步骤如下:

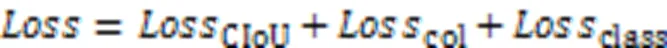

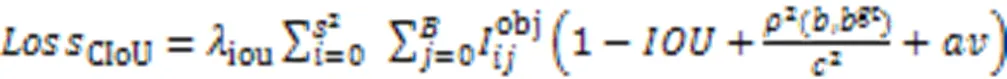

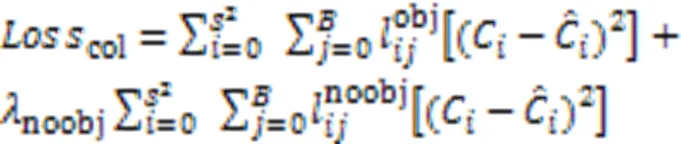

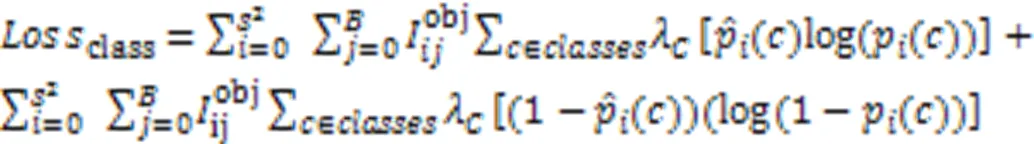

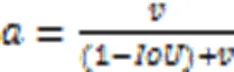

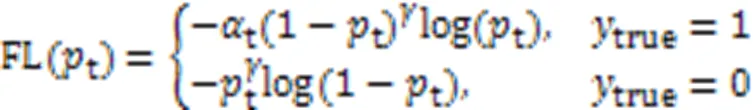

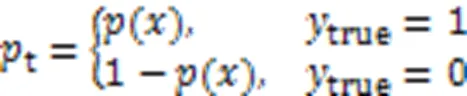

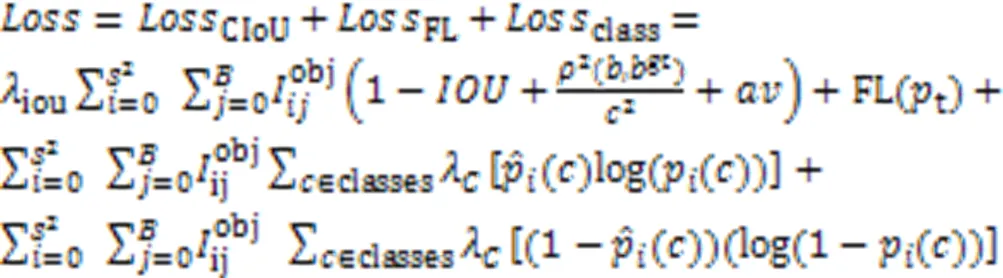

1)计算边界框回归损失、置信度损失和类别损失。控制YOLOv4迭代计算的损失函数由三部分构成,即边界框回归损失、置信度损失和类别损失,如式(6)所示。其中:YOLOv4使用CIoU(Complete‑IoU)损失函数控制边界框回归损失计算,如式(7)所示;置信度损失如式(8)所示;类别损失如式(9)所示。

2)引入Focal Loss优化损失函数。Focal Loss的计算如式(12)所示:

3)优化损失函数。使用Focal Loss控制置信度损失,得到优化后的损失函数如式(14)所示:

至此,完成损失函数的优化,解决了正负样本不平衡的问题,有效提高了本文方法的检测效果。

2.3.2YOLO‑Head输出检测结果

优化损失函数后,需要根据输出的预测结果与真实标签之间的误差计算模型损失值,通过迭代训练确保损失值最小化。本文利用YOLO‑Head检测头输出害虫的种类和位置信息。

最终,经过数据集预处理、改进的轻量化YOLOv4网络提取特征、注意力模型加强关键信息和YOLO‑Head回归分类,实现高效的林业害虫检测。本文方法的完整网络模型结构如图8所示。

图8 本文方法的网络模型结构

3 实验结果与分析

为了验证本文方法的可行性和有效性,利用2.1.1节所述方法构建的数据集与原YOLOv4模型进行对比实验。实验在Intel Xeon Silver 4110 CPU @2.10 GHz处理器,32 GB内存,NVIDIA GeForce RTX 2080Ti显卡的环境下进行,采用Windows 10操作系统,开发语言为Python,利用的深度学习框架为Pytorch,开发环境为Pycharm 2019。

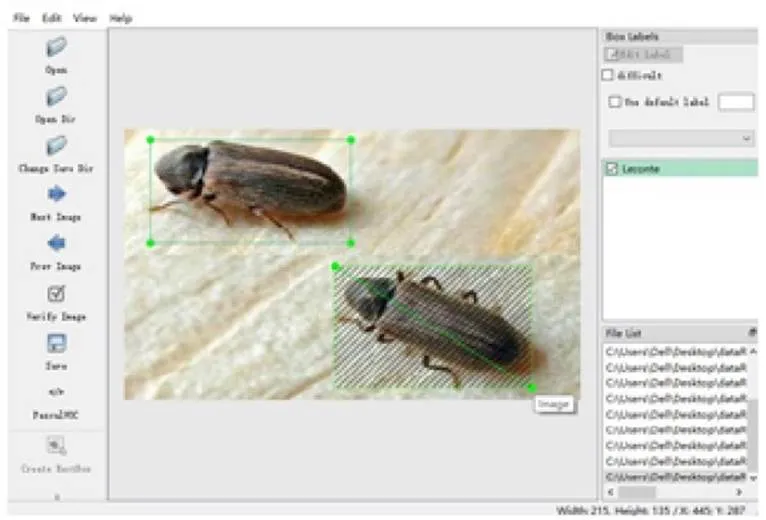

3.1 构建数据集

本文最终构建的数据集包含7种常见林业害虫,合计3 233张图像样本。在整理害虫图像时,对害虫进行标注,如图9所示。

图9 标注害虫图像

3.2 评价指标

为了评测模型的实时性,本文使用帧率,即每秒可预测图像的帧数(Frames Per Second, FPS)作为衡量检测速度的指标。当帧率大于25 FPS时,人眼认为是实时的。帧率越大,检测速度越快。

3.3 本文方法可行性实验

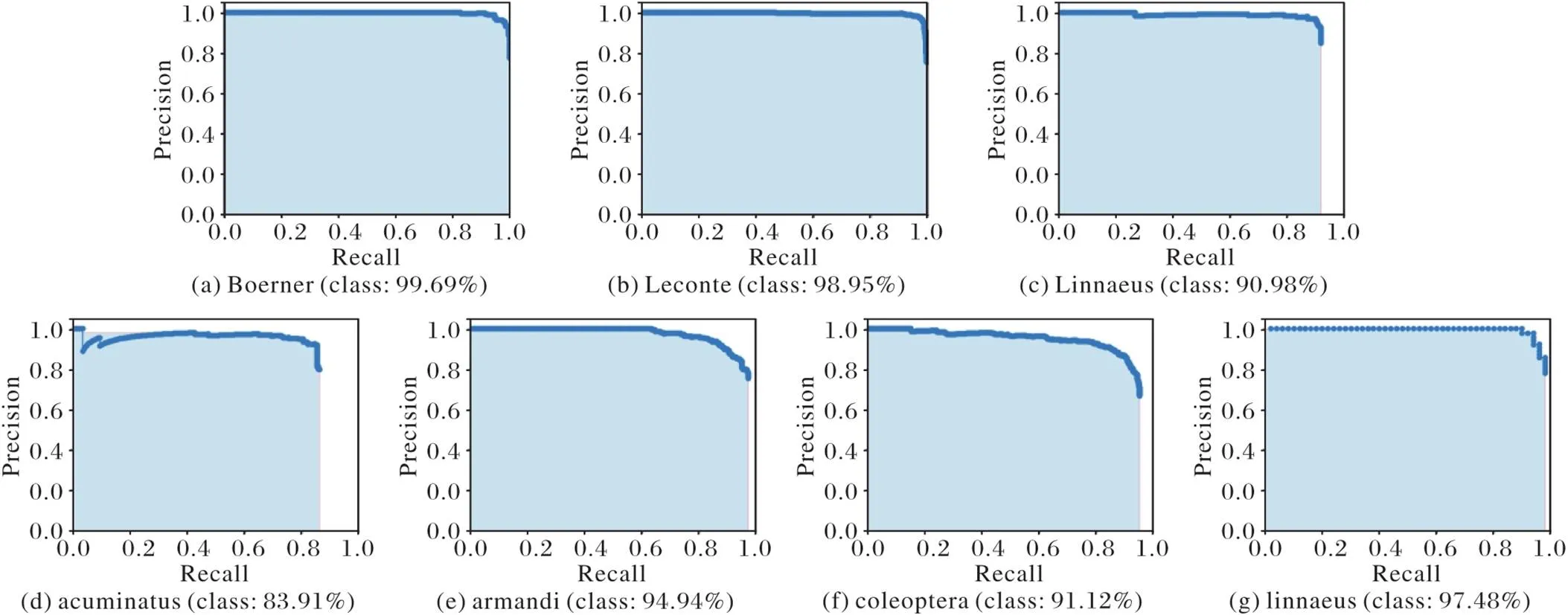

在训练时,首先输入尺寸大小为416×416的害虫图像,设置训练批次大小为8,初始学习率为0.001;然后冻结主干网络,进行50个轮次的预热训练;最后,训练批次大小调整为8,学习率调整为0.000 1,将解冻后的整体网络再训练50个轮次。经过训练之后,绘制得到7种害虫的PR曲线,如图10所示。

图10 7种害虫的PR曲线图

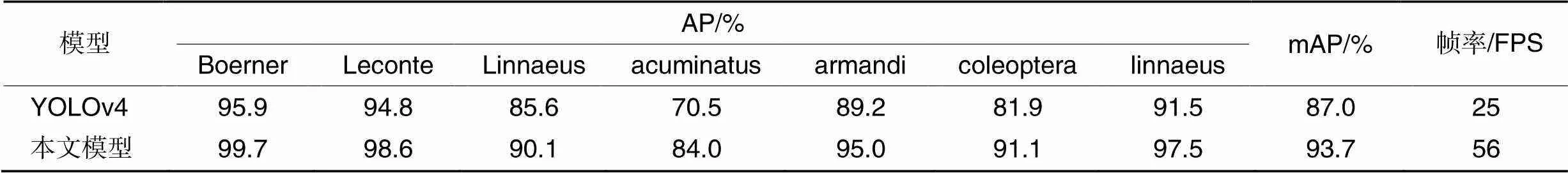

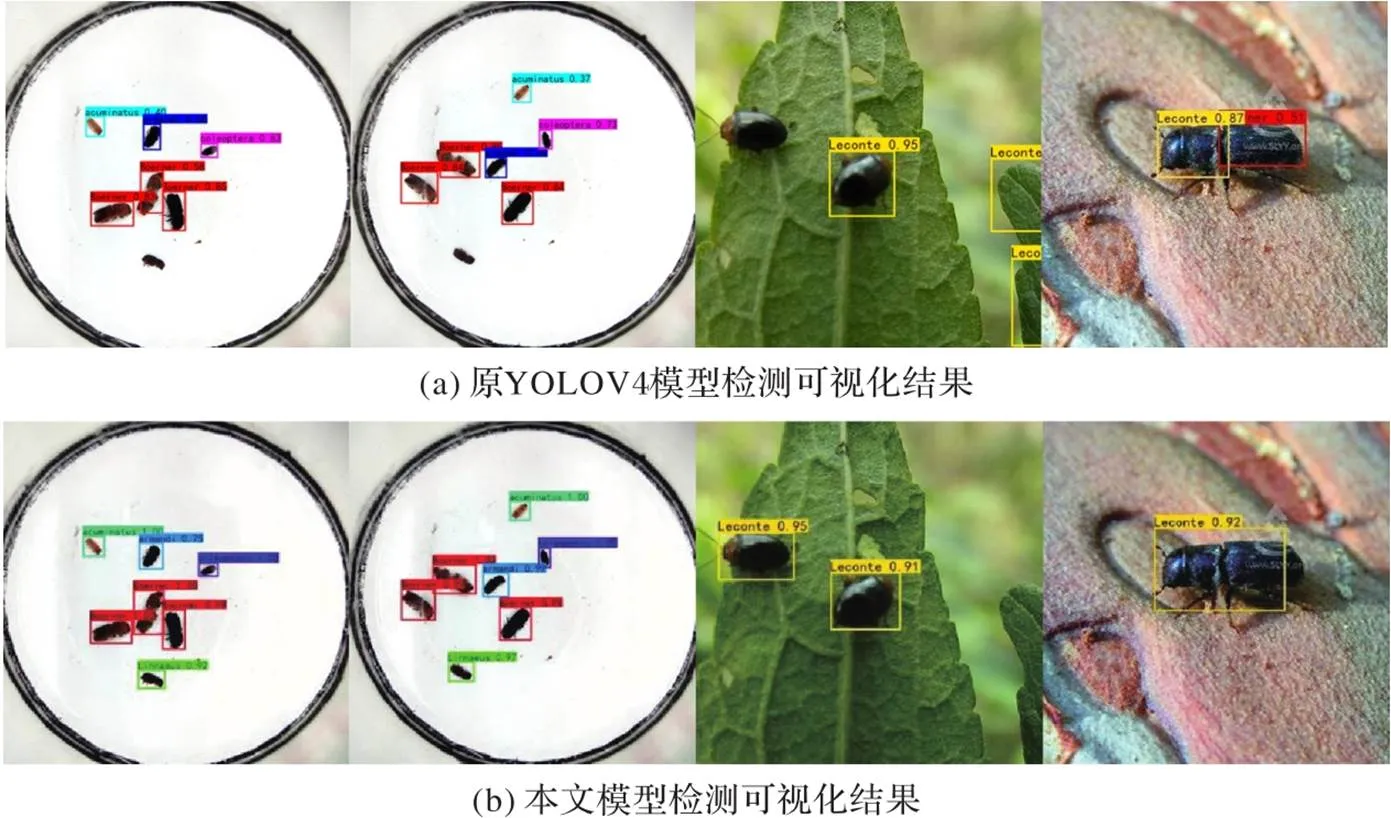

3.4 本文网络模型与原YOLOv4网络模型对比实验

为了验证本文改进的轻量化YOLOv4网络模型的有效性,本文设计并实现了与原YOLOv4模型的客观数据对比实验和可视化效果对比实验。

客观数据对比实验结果如表2所示。由表2可以看出,在检测精度上,与原YOLOv4模型相比,改进后的模型的mAP提升了6.7个百分点,最高AP达到99.7%;在检测速度上,经过本文一系列的轻量化改进,改进后的模型检测速度大幅提高,比原YOLOv4模型快一倍。综合分析,本文改进的模型提升了检测精度,提高了检测速度,更好地满足了林业害虫实时检测的性能要求。

可视化效果对比实验结果如图11所示,可以看出,在单一背景下或复杂背景下,原YOLOv4网络模型在检测时均存在漏检、误检和错检的问题,而本文方法模型能够准确和全面地检测到图像中的每一个害虫,有效地解决了此问题,而且本文网络模型对每种害虫的检测准确率都要高于原YOLOv4网络模型。

表2 本文模型与原YOLOv4模型的客观数据对比

图11 本文模型与原YOLOv4模型的可视化效果对比

综上分析,本文改进的轻量化YOLOv4网络模型能够有效地降低参数量,提升检测精度,提高检测速度,解决漏检、误检和错检的问题,提升了模型的综合性能,能更好地满足了林业害虫实时检测的性能要求。

3.5 消融实验

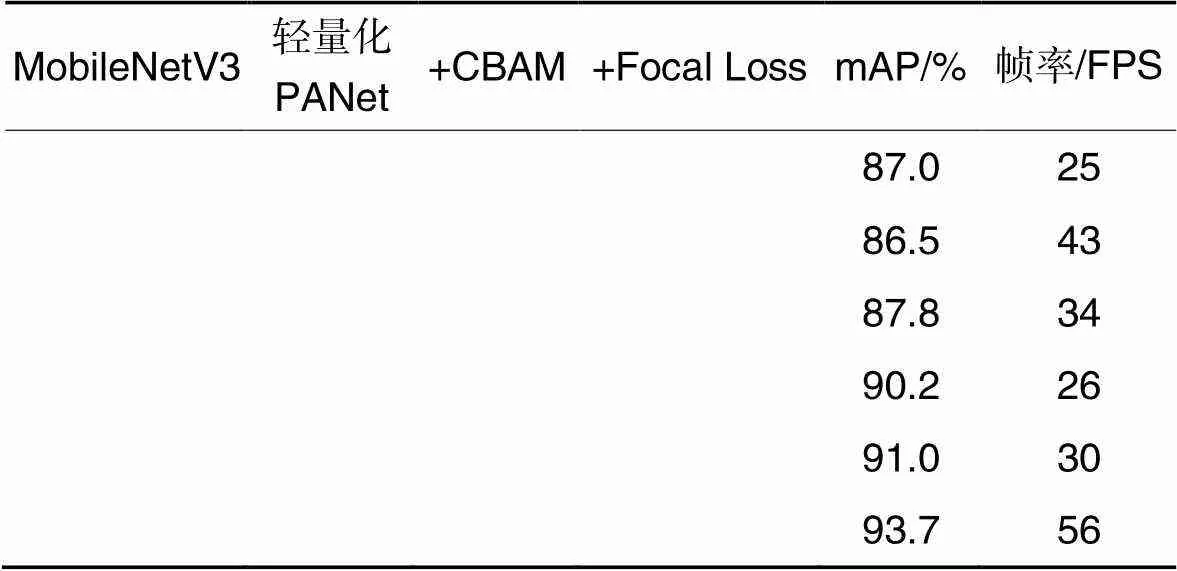

为了验证本文的各项改进均能有效提升网络模型的性能,设计并实现了消融实验。消融实验包括使用MobileNetV3作为主干网络、轻量化PANet、添加CBAM和引入Focal Loss。基于各个改进点的算法精度和速度对比情况如表3所示,其中:表示在网络中添加该改进点。

表3 消融实验的结果

由表3可以看出,对于MobileNetV3作为主干网络,可以牺牲一定的精度来提升模型的预测速度,模型精度虽然下降0.5个百分点,但模型速度提升了18 FPS;在PANet中使用深度可分离卷积替代普通卷积来实现轻量化PANet后,模型精度不仅没有降低,反而提高了0.8个百分点,表明深度可分离卷积相较于普通卷积在特征提取和降低参数量上具有优越性;添加CBAM后,模型仅在增加微量开销的情况下,精度提高了3.2个百分点,同时,检测速度几乎不受影响,这说明CBAM能够显著增强网络的特征提取能力,提高网络的整体性能;在损失函数中引入Focal Loss函数,降低了大量负样本在训练中所占的权重,解决了正负样本不平衡的问题,大幅提高了检测准确率,mAP较改进前模型高了4个百分点,检测速度提高5 FPS。

最终,通过使用MobileNetV3替换原主干网络、轻量化PANet、添加CBAM和引入Focal Loss,本文方法模型在林业害虫数据集中的准确率较改进前的原YOLOv4模型提高了6.7个百分点,检测速度提高31 FPS,实现了网络模型整体性能的提升。因此,消融实验中各项指标的结果验证了本文网络各项改进点的有效性,对算法模型的性能提升都有一定的贡献。

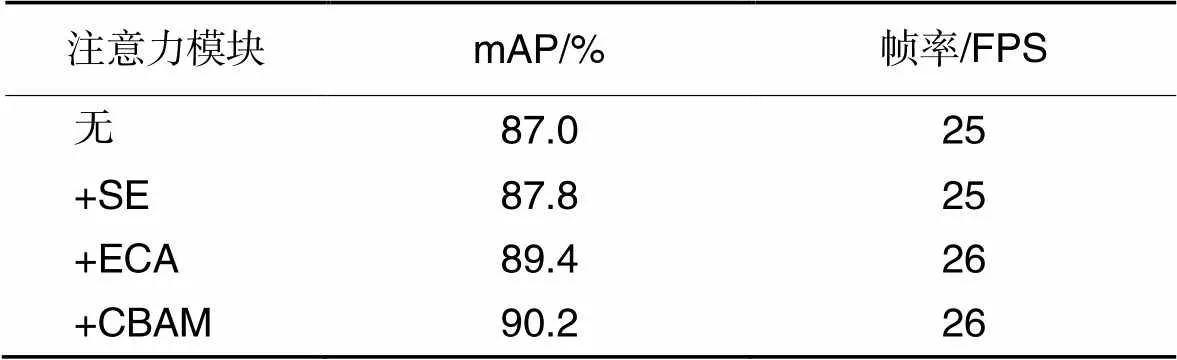

3.6 注意力机制对比实验

为了验证在PANet中添加CBAM能够有效提高模型的精度,本文设计了添加不同注意力机制的对比实验,结果如表4。从表4可以看出,不添加注意力模块时检测精度为87%,而在添加注意力模块后检测精度都有不同程度的提升。分析原因是数据集图像会存在遮挡、光照变化和背景干扰等因素的影响,引入注意力机制可以使网络关注重要信息,抑制背景噪声,提高检测能力。其中,添加CBAM时效果最优,mAP为90.2%。分析原因是,相较于SE和ECA只关注通道信息的综合,CBAM汇总并综合了空间和通道两方面的注意力信息,从而能够获得更加全面和可靠的注意力信息,提高模型的检测精度。而在提升模型检测精度的同时,注意力模块因为其轻量的特征,仅极少地增加了网络的参数量,整体的检测速度也几乎保持不变。因此,在PANet中融合CBAM能够显著提高网络的特征提取能力,在不过多增加网络负担的情况下,大幅提高网络的检测准确率和整体性能。

表4 不同注意力机制的对比

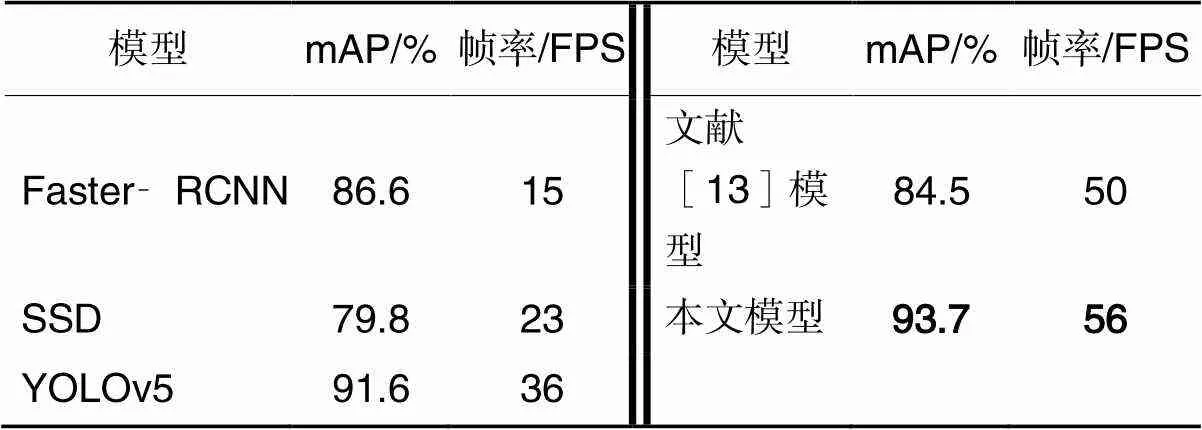

3.7 本文模型与其他模型对比实验

为了验证本文方法模型的有效性,使用本文训练集对Faster‑RCNN、SSD、YOLOv5、文献[13]模型及本文方法模型进行网络训练,使用测试集数据对它们的mAP和帧率进行对比,结果如表5所示。由表5可以看出,本文方法模型取得了最高的精度93.7%和最高的检测帧率56 FPS。

表5 本文模型与其他模型的对比

综合分析,在检测精度方面,本文通过引入注意力机制和改进损失函数等来改进YOLOv4,使得改进后的模型具有更加优越的特征提取能力和对抗正负样本不平衡的能力,从而获得检测精度的大幅提高,相较于Faster‑RCNN、SSD、YOLOv5和文献[13]模型具有更强的检测性能,更能满足林业害虫区域定位识别的需求。在检测速度方面,本文模型经过一系列轻量化改造,使得网络计算负担大大降低,检测速度大大提升,明显优于两阶段目标检测的代表性模型Faster‑RCNN,同时也比SSD和最新的YOLOv5更快。因此,本文模型能够在具有复杂背景的林业数据集的情况下,保持较高的精度和较快的检测速度,实现精度和速度的平衡。

4 结语

针对当前林业害虫检测方法存在模型参数量大、检测速度慢、准确率较低和漏检、误检和错检等问题,本文提出一种基于注意力模型和轻量化YOLOv4的林业害虫检测方法。实验结果表明,与原YOLOv4模型相比,无论是在单一背景还是复杂背景下,本文模型的最高检测精度达到99.7%,检测速度比原YOLOv4模型快了一倍。从可视化效果对比实验可以看出,本文模型解决了原YOLOv4模型存在的漏检、误检和错检问题,而且检测准确度更高。消融实验结果验证了本文网络各项改进点对算法模型的性能提升都有贡献.通过注意力机制对比实验验证了CBAM能够明显提高网络的特征提取能力,在不过多增加网络负担的情况下,大幅提高网络的检测精度和整体性能。通过与其他主流网络模型进行对比实验,本文方法模型具有最高的平均精度和检测速度,验证了本文方法模型的有效性和适用性。下一阶段工作将研究把本文方法模型部署到移动端设备和嵌入式设备中,实际应用到林业害虫检测场景中。

[1] 刘汉生. 陷阱式储粮害虫信息采集终端及其系统的研究与实现[D]. 北京:北京邮电大学, 2018.(LIU H S. The research and implementation of the trap based information acquisition terminal and information system for stored grain pests[D]. Beijing: Beijing University of Posts and Telecommunications, 2018.)

[2] 竺乐庆,张大兴,张真. 基于韦伯局部描述子和颜色直方图的鳞翅目昆虫翅图像特征描述与种类识别[J]. 昆虫学报, 2015, 58(4): 419-426.(ZHU L Q, ZHANG D X, ZHANG Z. Feature description of lepidopteran insect wing images based on WLD and HoC and its application in species recognition[J]. Acta Entomologica Sinica, 2015, 58(4): 419-426.)

[3] GIRSHICK R. Fast R‑CNN[C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015: 1440-1448.

[4] REN S Q, HE K M, GIRSHICK R, et al. Faster R‑CNN: towards real‑time object detection with region proposal networks[C]// Proceedings of the 28th International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2015:91-99.

[5] DAI J F, LI Y, HE K M, et al. R‑FCN: object detection via region‑based fully convolutional networks[C]// Proceedings of the 30th International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2016: 379-387.

[6] LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 936-944.

[7] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real‑time object detection[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 779-788.

[8] REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6517-6525.

[9] REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL]. (2018-04-08)[2021-12-10].https://arxiv.org/pdf/1804.02767.pdf.

[10] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL]. (2020-04-23)[2021-11-05].https://arxiv.org/pdf/2004.10934.pdf.

[11] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multiBox detector[C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9905. Cham: Springer, 2016: 21-37.

[12] 苗海委,周慧玲. 基于深度学习的粘虫板储粮害虫图像检测算法的研究[J]. 中国粮油学报, 2019, 34(12): 93-99.(MIAO H W, ZHOU H L. Detection of stored‑grain insects image on sticky board using deep learning[J]. Journal of the Chinese Cereals and Oils Association, 2019, 34(12): 93-99.)

[13] 候瑞环,杨喜旺,王智超,等. 一种基于YOLOv4‑TIA的林业害虫实时检测方法[J]. 计算机工程, 2022, 48(4): 255-261.(HOU R H, YANG X W, WANG Z C, et al. A real‑time detection methods for forestry pests based on YOLOv4‑TIA[J]. Computer Engineering, 2022, 48(4): 255-261.)

[14] 袁哲明,袁鸿杰,言雨璇,等. 基于深度学习的轻量化田间昆虫识别及分类模型[J]. 吉林大学学报(工学版), 2021, 51(3): 1131-1139.(YUAN Z M, YUAN H J, YAN Y X, et al. Automatic recognition and classification of field insects based on lightweight deep learning model[J]. Journal of Jilin University (Engineering and Technology Edition), 2021, 51(3): 1131-1139.)

[15] 李启运,纪庆革,洪赛丁. FastFace:实时鲁棒的人脸检测算法[J]. 中国图象图形学报, 2019, 24(10): 1761-1771.(LI Q Y, JI Q G, HONG S D. FastFace: a real‑time robust algorithm for face detection[J]. Journal of Image and Graphics, 2019, 24(10): 1761-1771.)

[16] IANDOLA F N, HAN S, MOSKEWICZ M W, et al. SqueezeNet: AlexNet‑level accuracy with 50x fewer parameters and< 0.5 MB model size[EB/OL]. (2016-11-04)[2021-11-22].https://arxiv.org/pdf/1602.07360.pdf.

[17] HOWARD A G, ZHU M L, CHEN B, et al. MobileNets: efficient convolutional neural networks for mobile vision applications[EB/OL]. (2017-04-17)[2021-12-08].https://arxiv.org/pdf/1704.04861.pdf.

[18] SANDLER M, HOWARD A, ZHU M L, et al. MobileNetV2: inverted residuals and linear bottlenecks[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 4510-4520.

[19] HOWARD A, SANDLER M, CHEN B, et al. Searching for MobileNetV3[C]// Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2019: 1314-1324.

[20] ZHANG X Y, ZHOU X Y, LIN M X, et al. ShuffleNet: an extremely efficient convolutional neural network for mobile devices[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 6848-6856.

[21] MA N N, ZHANG X Y, ZHENG H T, et al. ShuffleNet V2: practical guidelines for efficient CNN architecture design[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11218. Cham: Springer, 2018: 122-138.

[22] HAN K, WANG Y H, TIAN Q, et al. GhostNet: more features from cheap operations[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 1577-1586.

[23] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 3-19.

Forest pest detection method based on attention model and lightweight YOLOv4

SUN Haiyan, CHEN Yunbo, FENG Dingwei, WANG Tong, CAI Xingquan*

(,,100144,)

Aiming at the problems of slow detection speed, low precision, missed detection and false detection of current forest pest detection methods, a forest pest detection method based on attention model and lightweight YOLOv4 was proposed. Firstly, a dataset was constructed and preprocessed by using geometric transformation, random color dithering and mosaic data augmentation techniques. Secondly, the backbone network of YOLOv4 was replaced with a lightweight network MobileNetV3, and the Convolutional Block Attention Module (CBAM) was added to the improved Path Aggregation Network (PANet) to build the improved lightweight YOLOv4 network. Thirdly, Focal Loss was introduced to optimize the loss function of the YOLOv4 network model. Finally, the preprocessed dataset was input into the improved network model, and the detection results containing pest species and location information were output. Experimental results show that all the improvements of the network contribute to the performance improvement of the model; compared with the original YOLOv4 model, the proposed model has faster detection speed and higher detection mean Average Precision (mAP), and effectively solves the problem of missed detection and false detection. The proposed new model is superior to the existing mainstream network models and can meet the precision and speed requirements of real‑time detection of forest pests.

forest pest detection; lightweight network; attention model; loss function

This work is partially supported by Beijing Social Science Foundation of China (20YTB011).

SUN Haiyan, born in 1980, Ph. D., lecturer. Her research interests include virtual reality, deep learning.

CHEN Yunbo, born in 2001. Her research interests include virtual reality, deep learning.

FENG Dingwei, born in 1997, M. S. candidate. His research interests include virtual reality, deep learning.

WANG Tong, born in 1996, M. S. candidate. His research interests include virtual reality, deep learning.

CAI Xingquan, born in 1980, Ph. D., professor. His research interests include virtual reality, human‑computer interaction, deep learning.

TP391.9

A

1001-9081(2022)11-3580-08

10.11772/j.issn.1001-9081.2021122164

2021⁃12⁃24;

2022⁃03⁃14;

2022⁃03⁃17。

北京市社会科学基金资助项目(20YTB011)。

孙海燕(1980—),女,山东济宁人,讲师,博士,主要研究方向:虚拟现实、深度学习;陈云博(2001—),女,河南郑州人,主要研究方向:虚拟现实、深度学习;封丁惟(1997—),男,山东青岛人,硕士研究生,主要研究方向:虚拟现实、深度学习;王通(1996—),男,山西大同人,硕士研究生,主要研究方向:虚拟现实、深度学习;蔡兴泉(1980—),男,山东济南人,教授,博士,CCF高级会员,主要研究方向:虚拟现实、人机互动、深度学习。