融合门控自注意力机制的生成对抗网络视频异常检测

2022-11-18刘成明薛然石磊李英豪高宇飞

刘成明,薛然,石磊,李英豪,高宇飞

郑州大学网络空间安全学院,郑州 450002

0 引 言

视频中的异常检测是指识别监控视频中不符合预期的行为事件(Li等,2014)。异常行为检测在智慧安防、智能家居和医学康复等领域广泛应用,有着重要的研究意义和研究价值。由于在视频异常检测中,异常行为的种类繁多难以全部列举,同时异常事件发生的概率较小,异常行为特征难以被全部学习,所以用一种方法处理异常事件几乎是不可行的。

传统的视频异常行为检测方法需人工提取视频中目标对象的表观轮廓、运动信息和轨迹等特征,如梯度直方图(histogram of oriented gradient,HOG)可表示目标对象表观轮廓的特征信息(Li 等,2015),通过光流特征图可捕捉目标对象的运动信息特征(Li 等,2015);通过轨迹可提取运动目标的轨迹特征(Ahmed 等,2019)。但此类方法在表示形式上较为单一且无法学习预期之外事件的特征,同时处理海量视频数据能力较弱,已较难得到新的突破。

基于深度学习的方法越来越多地应用于视频异常行为检测,可通过自动从海量数据集中学习数据本身的分布规律来提取出更加鲁棒的高级特征,已取代基于人工构建行为特征的传统方法。目前,基于深度学习的监控视频异常行为检测方法主要分为重构判别和未来帧预测两类。

基于重构判别的方法认为,通过模型训练学习正常样本在样本空间服从的分布,符合该分布的正常样本都能较好地重构,重构误差大的样本属于异常样本(胡海洋 等,2020)。Hasan等人(2016)利用卷积自编码器(convolution auto-encoder,CAE)对目标帧进行误差重构来检测视频中的异常行为; Luo等人(2017)通过利用卷积长短期记忆自编码器(convolution long-short term memory auto-encoder,Conv LSTM-AE)重构目标对象的外观信息和运动信息进行异常行为检测,提出将稀疏编码映射到堆叠的循环神经网络(stacked recurrent neural network,sRNN)框架中重构异常行为。但由于深度学习方法具有强大的学习能力,对正常事件和异常事件的重构结果是相似的,此类方法并不能保证对异常事件的重构误差一定很大。因此,几乎所有基于重构误差的方法都不能保证准确检测出异常事件。

基于未来帧预测的方法假设正常行为是有规律的且是可预测的,而视频中异常行为事件由于其不确定性不可预测。该类方法可通过生成未来目标帧的预测帧,将其与对应的视频真实帧进行对比来判断该视频中是否包含异常行为。目前,生成对抗网络(generative adversarial network,GAN)在视频异常检测领域已取得突破性进展,其网络架构可很好地用于预测。Liu等人(2018)提出基于U-net的条件生成对抗网络进行异常行为检测,同时加入Flownet光流网络对运动特征约束;Dong等人(2020)在此基础上提出基于对偶生成对抗网络模型,利用双生成器和双鉴别器的对偶结构分别对外观和运动信息进行异常判别;Nguyen等人(2019)提出采用卷积自编码器学习空间结构,将空间特征输入U-net中与运动信息相关联从而进行异常检测。

基于生成对抗网络的视频异常行为检测方法通过生成器U-net的良好性能捕获了训练样本空间特征,但仍存在一定的局限性(马钰锡 等,2019),主要表现为:1)虽然已能够检测出视频中的异常行为,但如何有效建模空间维度信息和时间维度信息提高异常检测的精度仍是目前研究领域的重难点;2)针对目标对象的空间特征的提取,基础的U-net无法建立长距离依赖性,不能将特征信息进行有效连接;3)除数据样本的空间特征外,时间信息也是视频的一个重要特征。现有大多数工作对视频的时间信息特征利用不够充分。

为了更好地解决此问题,本文提出一种融合门控自注意力机制的生成对抗网络方法,在U-net生成器部分中逐层引入门控自注意力机制来更好地学习视频样本的空间维度信息,同时采用LiteFlownet网络来对视频样本的时间维度信息进行更好地提取。但该模型易受噪声影响,需同时加入强度损失函数、梯度损失函数和运动损失函数加强模型检测的稳定性以实现对异常行为的检测。

本文的贡献主要有以下3个方面:1)考虑视频序列帧之间的时间和空间2维关系,提出一种改进的异常行为检测模型。利用生成对抗网络中的生成模块对视频中的空间特征进行提取,利用LiteFlownet光流网络对运动信息的时间特征进行提取,引入门控自注意力机制对特征图进行加权处理,实现了视频序列之间时空特征更有效的表达。2)引入门控自注意力机制,逐层对U-net采样过程中的特征进行加权计算。该自注意力机制在视频帧的单层特征中对远距离且具有空间相关性的特征进行建模,可自动寻找图像特征中的相关部分,提高对视频帧中时间和空间两个维度的特征响应。3)选用LiteFlownet光流网络对运动信息进行提取,得到视频帧之间的时间关联,进一步提高了该模型的检测性能。

1 相关工作

1.1 U-net网络

U-net网络采用经典的编码器—解码器(encoder-decoder)结构,左右两侧对称,网络结构像字母“U”,因此称为U-net(Ronneberger 等,2015)。U-net前半部分用于下采样,在结构上与VGG(Visual Geometry Group)网络(Russakovsky 等,2015)相似;后半部分用于上采样。每个上采样层的特征与其对应的同分辨率的下采样层的特征进行连接,作为下一个上采样层的输入。这种跳连结构使网络将浅层特征图的信息通过特征通道与更高层次的特征图进行结合,保证了上下文信息的完整性。

U-net最初应用于医学成像领域,如今大量应用于计算机视觉任务(Ronneberger 等,2015),在视频预测方面也有很大优势,由于视频场景的背景通常是相似的,模型需提高对复杂前景的响应。而U-net通过跳连结构可实现特征信息的跨层传输,不需考虑输入帧和其相应的输出帧的共同特征,可专注于不同的特征信息用于进一步训练,提高了对视频帧内容的学习能力。

1.2 注意力机制

注意力机制作为学习区域权重的方法之一,在图像分割和图像生成等方面也取得了很好效果。基本的注意力机制分为硬注意力机制和软注意力机制两类(朱张莉 等,2019),硬注意力机制(朱张莉 等,2019)在某一时刻只关注一个位置的特征信息,每个位置的注意力权重只可以设为0或1两个选项来表明该位置是否被选中,其训练依赖于蒙特卡洛采样方法,导致其训练的难度相对很大;软注意力机制(朱张莉 等,2019)是概率性的,为每一个特征分配一个0~1之间任意值的权重,可使用标准的反向传播,无需蒙特卡洛采样训练模型。例如,加法注意力机制应用于机器翻译领域(Bahdanau 等,2014),后应用于图像分类(Fei 等,2017)。进一步地,自注意力机制(Wang 等,2017)用来解决图像分类中对外部门控信息的依赖,采用非局部的自注意力机制建立图像中两个长距离像素点的依赖关系,提高了图像分类性能的准确性。本文为加强U-net对视频帧中差异特征的学习能力,通过跳连结构进行特征融合时,引入基于网格特征图分配权重的门控自注意力机制(Oktay 等,2018),实现对视频帧特征权重的分配,进一步提高对时空信息的建模能力。

1.3 基于生成对抗网络的异常行为检测

基于生成对抗网络的视频异常检测方法因性能优异得到越来越多的关注。生成对抗网络由生成网络和对抗网络两部分组成,通过对抗训练来学习训练集的数据分布,从而学会生成图像的分布。Isola等人(2017)提出一种生成对抗网络结构实现图像翻译任务,生成网络采用U-net网络,对抗网络采用马尔可夫判别网络。在此网络框架基础上,Liu等人(2018)提出一种基于未来帧预测的生成对抗网络异常行为检测方法,通过训练前几帧来实现对目标帧的预测。该方法总体结构模型简单,性能优异。此外,该方法实现了较高的异常检测精度。因此,选择该模型框架作为本文的基本框架。

2 方 法

融合门控自注意力机制的生成对抗网络模型包括4部分,即生成模块、损失约束模块、对抗训练模块和异常判别模块。其中,生成模块利用引入门控注意力机制的U-net模型(attention gates U-net,AGs U-net),判别器采用马尔可夫判别器(Patch GAN)进行训练,两者通过对抗学习进行优化。

将含有连续t-1帧的正常视频帧作为训练视频I1,I2,…,It-1按时间顺序堆叠起来,输入生成器网络AGs U-net用来预测其下一帧。其中,预测帧记为I′t,真实帧为It。为了更好地预测正常行为下一帧,建立强度损失和梯度损失函数进行空间约束。此外,用更快速且平滑的LiteFlownet光流网络(Hui 等,2018)来强化相邻帧之间的运动特征相关性,得到可以准确预测正常行为的生成对抗网络模型。

当有异常行为样本输入时,模型按正常模式输出的预测帧的分数与实际的真实值误差较大,得出的异常分数则会下降,表明该事件样本即为异常事件。本文模型的整体框架如图1所示。

2.1 生成模块

为获取编码中的低层次细节信息,U-net将编码块的低层次粗粒度特征图直接与相应解码块的前一层输出的特征图相拼接作为下一层解码块的输入(Ronneberger 等,2015),但直接拼接的方式存在浅层特征利用率低的问题。与Liu等人(2018)将U-net作为生成对抗网络的生成器的方法不同,本文在生成对抗网络的U-net生成器中引入门控自注意力机制,在解码段逐层加入注意力门控机制,将基于底层的视觉特征自底向上与融合门控注意力机制的U-net提取的特征进行逐层合并。该融合模型通过U-net结构优势抑制了输入视频帧中与异常检测任务不相关背景区域的特征表达,突出了视频异常检测任务中视频帧的有效特征。同时,利用门控自注意力机制缩小了U-net编码块中低级粗粒度特征与U-net解码块中高级细粒度特征之间的差距。生成器AGs U-net的网络结构如图2所示。

图1 模型整体框架Fig.1 Overall framework of the model

图2 AGs U-net网络结构Fig.2 The network structure of AGs U-net

为了解决U-net对注意力门控信息的依赖问题,本文模型的门控机制采用基于网格特征图分配权重的门控自注意力机制,结构示意图如图3所示。其中,门控信号g表示解码器的前一层提取的输入特征信息(Fg×Hg×Wg×Dg),xl表示上采样层的上一层的特征信息(Fl×Hl×Wl×Dl),将调整权重后的xl与g进行相加拼接,相加得到的特征图将通过一组参数θatt,包括1×1×1卷积线性变换运算、ReLU激活函数、sigmoid激活函数的非线性变换和resampler重采样等一系列过程,得到注意力门控系数α。加法注意力计算为

(1)

(2)

(3)

门控自注意力机制在U-net进行跳连操作时,首先对当前层的下采样过程的特征图进行一个权重分配,通过卷积运算、激活和重采样等一系列操作,每个门控自注意力机制学会关注目标结构的一个子集。来自背景区域的梯度在向下传播的过程中被向下加权确保每个注意力单元对视频序列前景内容的响应,提取并融合浅层特征和深层特征的互补信息,从而定义U-net跳连结构的输出。

图3 注意力门控结构示意图Fig.3 Schematic diagram of attention gating structure

2.2 损失约束模块

2.2.1 强度损失

为了使预测值更接近真实值,在模型中添加强度损失Lint,减少预测值I′t与其真实值It之间的距离,强度损失保证图像空间中所有像素的相似性,具体为

(4)

2.2.2 梯度损失

加入梯度损失Lgd用来保证生成图像的锐度,梯度损失的定义为

(5)

式中,i,j表示视帧的空间坐标。

2.2.3 运动损失

强度损失考虑的是视频帧强度的差异,梯度损失保证梯度差异的最小化,两者保证了预测值与真实值尽可能一致,但不能保证视频序列帧之间的连续性。本文利用LiteFlownet光流网络模型捕获异常检测中视频片段的运动信息,使用L1距离损失计算运动损失。光流的损失函数可表示为

(6)

式中,F′t为t时刻的预测值,Ft为t时刻的真实值,F表示已训练好的LiteFlownet光流网络。

2.3 对抗训练模块

(7)

(8)

式中,i,j表示空间索引,t表示视频序列的第t帧。

生成网络和判别网络通过对抗学习进行优化。本文将生成网络的目标函数定义为

LG=λintLint(I′t,It) +λgdLgd(I′t,It)+

λofLof(I′t,It)+λadvLadv(I′t,It)

(9)

本文中,判别网络使用的是马尔可夫判别器,判别网络的目标函数为

(10)

2.4 异常判别模块

假设正常事件的视频帧可以被准确预测,模型利用预测帧与真实值的差值进行异常事件判定,若差值较小则视为正常事件,否则为异常事件。峰值信噪比(peak signal to noise ratio,PSNR)是一种评估图像质量的有效方法(Li 等,2014),表达为

(11)

式中,max表示求点颜色的最大数值,PSNR值越高,代表生成器生成的图像质量越好,其预测帧的值越接近地面真实值,表明该帧更可能为正常事件,否则视为异常事件。

将每个测试视频中所有帧的峰值信噪比归一化到[0,1]范围内,计算每帧的规则分数,具体计算为

(12)

根据帧得分S(t)来预测该帧是正常还是异常。

3 实验结果及分析

3.1 实验数据

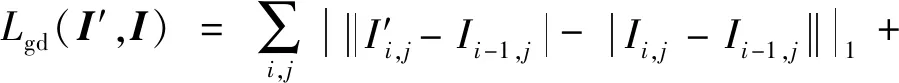

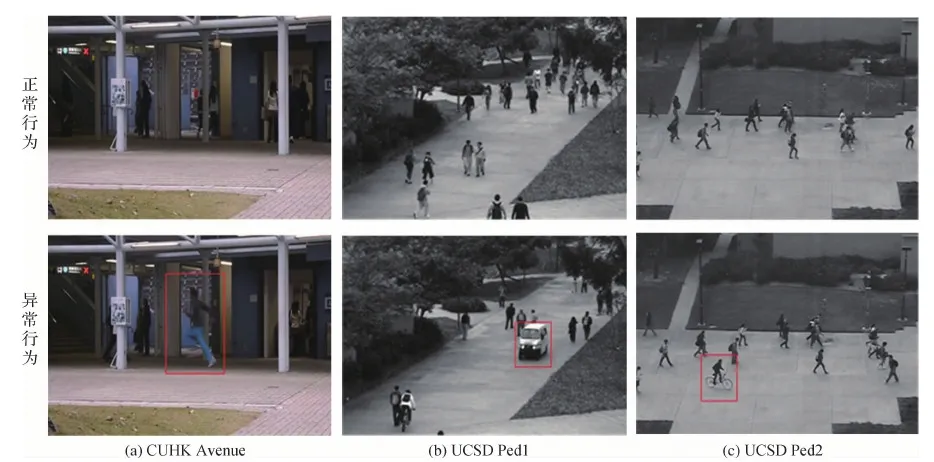

本文模型在视频异常检测公共数据集CUHK (Chinese University of Hong Kong)Avenue(Lu 等,2014)、UCSD(University of California, San Diego) Ped1和UCSD Ped2(Mahadevan 等,2010)进行训练和测试。CUHK Avenue数据集包含16个训练视频和21个测试视频,视频场景为校园内的行人区域,其中包含的异常行为类型主要是行人的异常动作、错误移动方向以及异常物体的出现等。UCSD数据集包括UCSD Ped1和UCSD Ped2两个数据子集。UCSD Ped1数据子集包含34个训练集视频和36个测试集,视频场景是垂直于摄像机方向的行人区域,其中包含的异常类型主要有行人的异常行为和非人类物体的出现,如骑自行车和汽车闯入等。UCSD Ped2数据子集包含16个训练集和12个测试集,视频场景是与摄像机镜头方向平行的行人区域,其异常类型主要有行人投掷物体和突然跑步等。

实验数据的训练集中只包含正常行为,用于训练模型对正常事件分布的学习能力;测试集中存在异常行为,用于对模型性能进行测试。使用的数据集是异常检测领域中较常用的数据集,部分示例如图4所示。可以看出,视频中行人较多且异常事件种类并不单一,因此针对这些数据集进行异常行为检测具有一定的挑战性。

图4 异常数据集部分行为示例Fig.4 The examples of partial behavior in datasets((a)CUHK Avenue;(b)UCSD Ped1;(c)UCSD Ped2)

3.2 评价指标

采用AUC(area under curve)(Mahadevan 等,2010)和峰值信噪比(PSNR)作为评价指标。

AUC是接收者操作特征曲线(receiver operating characteristic curve,ROC)下的面积。使用AUC对本文网络模型性能进行定量评价。参照先前的视频异常检测领域的评价方法,本文模型同样在帧级别上对异常行为进行评价。帧级标准是一种检测视频异常行为的标准,只考虑当前的视频帧。如果在当前视频帧中发现异常行为,则该帧即为异常帧。一般来说,ROC曲线越接近左上角,则AUC分数的得分越大,表明此模型的检测性能越佳。因此,采用帧级AUC指标对本文模型的性能进行评估。

峰值信噪比(PSNR)是衡量通过生成网络得到的生成图像的质量指标,单位为dB(佟雨兵 等,2006)。PSNR分值越大,代表生成图像质量越好。PSNR值高于40 dB时,说明图像质量极好,最接近原始图像;PSNR值介于30 dB与40 dB之间,说明图像质量较好,图像失真但可以接受;PSNR值介于20 dB与30 dB之间,说明图像质量差;PSNR值低于20 dB,说明图像不可接收。

3.3 实验设置

3.3.1 实验环境

硬件环境为Intel®Xeon®E5-2600处理器,图形处理器(graphics processing unit,GPU)为GeForce RTX 2080Ti(X4),实验在Ubuntu 18.04系统上使用Pytorch1.8.0框架实现本文的深度网络模型,编程环境为python3.6,CUDA10.1,CUDNN7.6.5。

3.3.2 参数设置

首先对异常检测视频数据集进行预处理,将视频每帧尺寸设为256×256像素。设置批量大小t为4,使用连续4帧视频帧作为输入数据,利用第5帧真实值与生成预测值进行异常判别。实验采用基于Adam的随机梯度下降法对网络模型的参数进行优化(Kingma和Ba,2014)。对灰度数据集,生成器学习率设为0.000 1,判别器学习率设为0.000 01;对彩色数据集,生成器的学习率设为0.000 25,判别器学习率设为0.000 025。对实验中不同的视频数据集,λint、λgd、λof和λadv别设置为1.0、1.0、2.0和0.05。

3.4 实验结果分析

3.4.1 检测性能评价

为验证本文算法的性能,分别与现有的视频异常检测方法中基于重构误差思想的典型算法和基于未来帧预测思想的方法进行比较。其中,基于重构误差思想的典型算法包括卷积自编码器(Conv-AE)(Hasan 等,2016)、卷积长短期记忆自编码器(Conv LSTM-AE)(Luo等,2017)和堆叠的循环卷积神经网络(sRNN)(Luo等,2017),基于未来帧预测思想的方法包括基于双鉴别器的生成对抗网络(dual descriminators)(Dong 等,2020)和条件生成对抗网络(conditional generative adversarial nets,CGAN)(Liu 等,2018)。AUC结果对比如表1所示。可以看出,本文方法在3个数据集上的准确性优于其他算法,特别是在CUHK Avenue数据集上,本文算法的AUC高达87.2%,证明了本文模型在视频异常检测中的有效性。

本文模型与基于条件生成对抗网络(Liu 等,2018)的基准模型相比,在3个数据集上的AUC分数较先前工作有明显提升,说明本文模型在提取视频中的时间信息和空间信息两个维度特征上都是有效的。

以CUHK Avenue数据集中的AUC为例,基于重构思想的3种典型方法Conv-AE、Conv LSTM-AE和sRNN的AUC相对较高。该类方法通过重建误差进行异常行为检测,由于深度学习模型较强的泛化能力,导致正常行为和异常行为重建误差较小,基于重建误差的方法难以准确区分正常行为与异常行为。

在生成对抗网络框架中,通过本文模型与基于双判别器的生成对抗网络的方法(Liu 等,2018)和基于条件生成对抗网络的方法(Dong 等,2020)等基于未来帧预测思想的方法进行对比,可以看出异常检测性能的重点主要在对视频帧中时空信息的有效提取。基于双鉴别器的生成对抗网络(Dong 等,2020)与基准模型(Liu 等,2018)相比,AUC几乎持平,说明鉴别网络的叠加并不能保证对特征的有效提取,对检测结果的影响不大。

3.4.2 PSNR结果分析

本文模型在实验过程中实时计算每帧生成图像的PSNR值,针对PSNR值对当前行为是否包含异常事件进行定量分析。正常事件的分数保持稳定且不会出现较大波动,当生成图像的PSNR分数出现较大波动突然降低时,表明该事件的预测帧与真实帧分数相差较大,则当前视频中发生异常事件。

当视频在正常事件状态时,本文模型算法的生成图像的质量极好,PSNR峰值高于40 dB;当视频中出现异常行为时,PSNR值会突然变化呈下降趋势,这是因为已经训练好的生成器不能很好地预测异常帧的出现,生成的预测帧图象质量较差,从而导致PSNR分数下降。图5展示了视频序列帧的PSNR分数的结果,当检测到行人投掷书包、突然加速跑等异常行为时,PSNR分数发生突然下降的变化,表明该帧是异常行为。

图5 PSNR分数结果可视化Fig.5 Visualization of PSNR score results

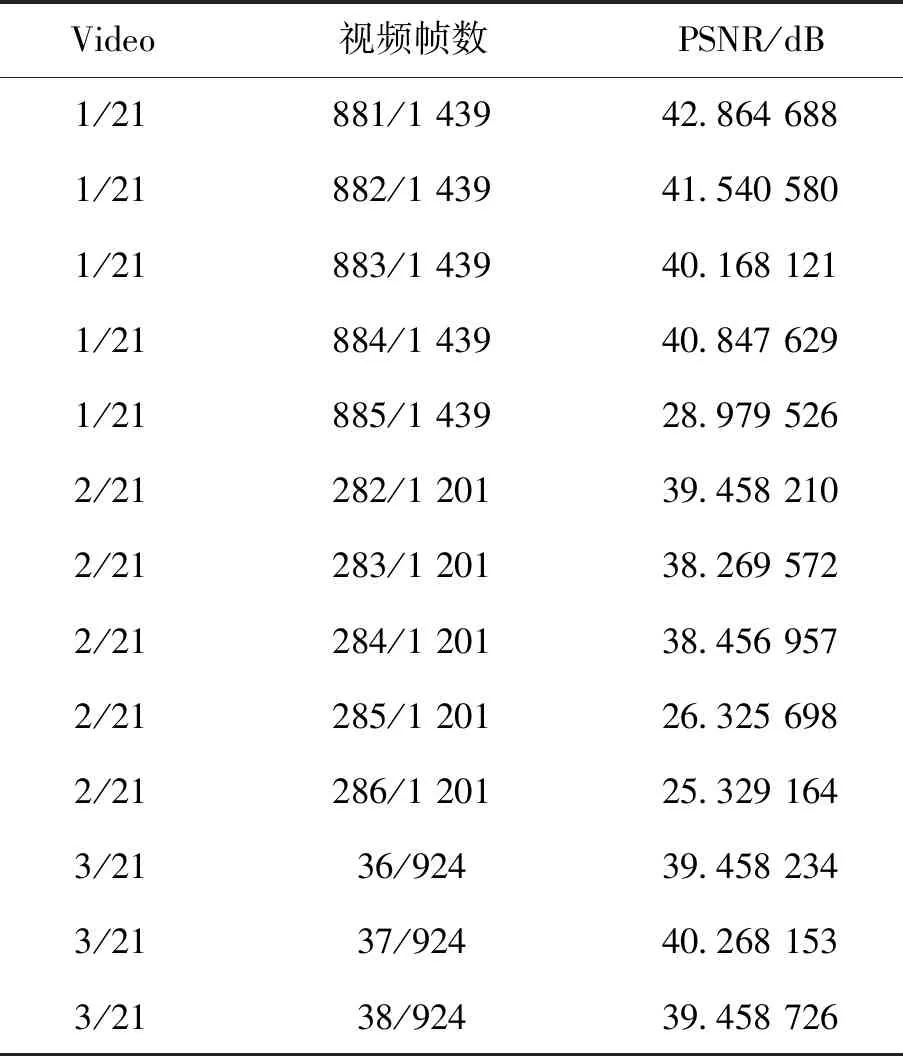

表2是在CUHK Avenue数据集中的几组测试结果。其中,Video表示CUHK Avenue测试数据分组,1/21表示第21个视频流的第1组测试;Frames表示视频帧数,每个测试文件分割帧数不同,随机选取其中的几组进行展示。881/1 439表示该组1 439帧测试文件中的第881帧。在第2组测试文件的第285帧图像中,其PSNR值分数突然降低,连续2帧的分数在30 dB以下水平,其对应的真实图像如图6所示,视频中行人出现突然加速奔跑的异常行为。

表2 在CUHK Avenue数据集中几组生成帧的PSNR值Table 2 PSNR values for several groups of generated frames in CUHK Avenue dataset

图6 CUHK Avenue中的一组(连续两帧)异常行为Fig.6 Abnormal behaviors (two frames in a row) on CUHK Avenue

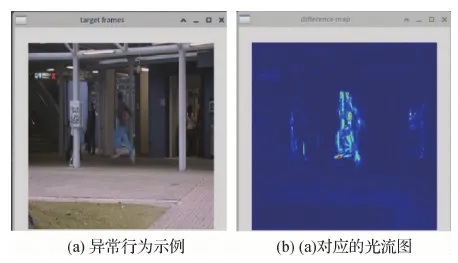

在视频异常检测CUHK Avenue数据集异常示例中,行人突然加速进行奔跑,如图7(a)所示。本文方法通过已训练好的LiteFlownet光流网络得到光流特征图,从而得到连续视频帧之间的时间运动信息特征。

图7 CUHK Avenue中异常行为示例及对应的光流图Fig.7 An example of abnormal behavior in CUHK Avenue and the corresponding optical flow diagram((a)example of abnormal behavior;(b)behavior in (a) corresponds to optical flow diagram)

3.4.3 消融实验

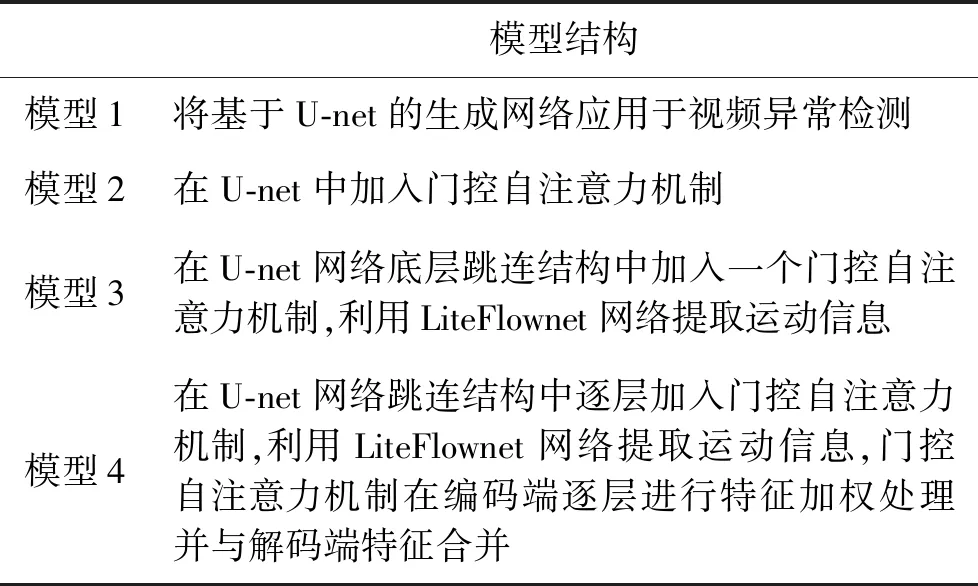

1)有效性比较。以CUHK Avenue数据集为例,在模型生成部分进行消融实验验证本文方法的有效性。通过逐一增加本文模型的重要模块来验证有效性,消融实验中不同的模型结构如表3所示。

表3 消融实验中不同的模型结构说明Table 3 Description of different model structures in ablation experiments

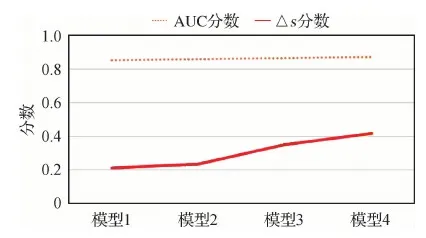

针对4个消融实验,首先计算正常帧与异常帧的平均得分之间的差距,用Δs表示,然后分别在CUHK Avenue数据集上比较模型1、模型2、模型3和模型4的结果。Δs的分值越大,则模型区分正常和异常模式的效果越好。将4种模型方法在CUHK Avenue数据集上进行AUC比较,结果如图8所示。可以看出,本文方法获得了比其他3种消融模型方法更大的Δs和更高的AUC,表明本文模型更适合于视频异常行为检测。因此,本文模型采用引入门控自注意力机制的U-net结构作为预测网络。

图8 4种消融模型的AUC分数和Δs分数结果Fig.8 AUC score and Δs score of four ablation models

2)不同损失函数结果比较。如表4所示,在CUHK Avenue数据集上进行强度损失、梯度损失和运动损失对异常检测模型性能的消融实验分析通过逐步消融不同的损失函数,得到模型加入损失函数的AUC分数的性能结果,如表4所示。实验结果表明,在生成对抗网络输入损失的基础上增加强度损失、梯度损失和运动损失后,AUC值有明显提高。因此,不同的约束条件对模型性能的提升有影响,且模型加入更多的约束条件后可获得更高的AUC。

表4 CUHK Avenue数据集上不同损失函数的表现Table 4 Performance of different loss functions on CUHK Avenue dataset

3.5 本文方法失败的案例

本文模型在异常检测数据集上的整体表现较好,但仍存在检测失败的例子。失败的情况主要表现为:1)当视频中出现新事物时,就会被认定为有异常行为出现。例如,当小朋友出现在镜头前时,由于模型在训练时没有小朋友空间特征样本,在检测时便认定新事物小朋友的出现为异常行为,出现误检情况。2)对于环境复杂场景下的判断仍然不稳定。当行人与摄像机镜头较近时,由于镜头中人物大小不一致,离镜头较近的行人的正常行走行为也会被定义为异常行为。3)由于背景前景的高度相似性,样本的时间特征和空间特征过于复杂,仍存在检测结果不完整等漏检的情况。

4 结 论

现有的生成对抗网络算法存在着时空特征提取不充分、识别准确率不高等问题,为了解决这些问题,本文融合门控自注意力机制和生成网络U-net的优势,首先在U-net框架的跳连结构之后逐层加入门控自注意力机制,通过构建生成对抗网络AGs U-net对视频流的时空维度特征信息进行更充分地提取。其次采用更快更平滑的LiteFlownet光流网络提取视频流中的运动特征,保证视频行为事件的连续性。最后在模型中加入强度损失函数、梯度损失函数和运动约束函数,保证模型的稳定性。实验结果表明,本文模型与之前的工作相比,更好地提取视频流中的时间维度特征和空间维度特征,更适合视频异常行为检测,且进一步提高了视频异常行为检测模型的稳定性和准确率。但本文模型仍存在对视频流时空特征的内在关联性解决不彻底的问题。

未来的异常行为检测工作将从两方面展开。1)在视频流特征提取部分,设计更有效更充分的特征提取算法;2)在视频流特征时空融合方面,考虑将时间特征与空间特征进行进一步关联,对视频特征的利用达到更大化,这将对异常行为检测具有重要意义。