距离选通成像在无人机识别分类中的应用

2022-11-12范有臣刘宝林秦明宇郭惠超王明乾

范有臣,刘宝林,秦明宇,郭惠超,王明乾

(航天工程大学,北京 101416)

1 引 言

无人机的开发应用广泛,诸多行业对无人机的需求与日俱增,在农业监测、协助救援、考古监控等领域发挥不可替代的作用,带来极大社会价值的同时也有很多负面问题和隐患,为了更好地发挥无人机的正面作用,全天时全过程快速准确识别无人机非常重要。旋翼无人机体积小、成本低、操作简单、稳定性高[1],随着技术越来越成熟,带动了无人机产业的整体飞速发展,促使消费级和工业级无人机的使用门槛逐渐降低,民用无人机市场呈现出迅猛增长态势,在航拍测绘、电力巡检、交通监测、监控安保、物流配送、救灾救援等领域[2]应用广泛。无人机经常是超低空飞行,起飞随意性大,不容易被探测,处置上较为困难,给各行各业带来便利的同时,易被敌对分子和恐怖分子用在非法测绘、恐怖袭击等非法行动[3],引发各类安全事故多发频发,有的已经造成了严重的危害。为了更好的发挥无人机的正面作用,全天时全过程快速准确识别无人机非常重要。

目前,无人机识别的手段主要有声学传感器、无线信号、有源雷达和计算机视觉等[4]。基于声学传感器是基于无人机的声学特性[5],需要建立无人机的声学数据库并使用模式匹配,但该方法易受环境噪声的干扰,很难在嘈杂的环境中识别无人机。基于有源雷达是利用雷达截面来检测无人机[6],该方法受雷达截面的影响较大,但无人机的雷达截面一般较小,所以基于有源雷达的方法不稳定。基于无线信号利用无线电设备实时采集无人机电磁发射方向[7],从而识别无人机,但基于无线电的探测设备造价高昂,难以普及。基于计算机视觉[8]主要针对可见光、红外传感器和激光传感器等手段获取的无人机视频和图像进行识别。

基于计算机视觉的目标检测算法可分为one-stage和two-stage两类。two-stage算法主要通过一个卷积神经网络来完成目标检测过程,其提取的是CNN卷积特征,进行候选区域的筛选和目标检测两部分。网络的准确度高、速度相对较慢,代表网络有Fast R-CNN[9]、Faster R-CNN[10]等。One-stage的算法直接通过主干网络给出目标的类别和位置信息,没有使用候选区域的筛选网路,这种算法速度快,但是精度相对two-stage目标检测网络降低了很多,代表网络有SSD[11]和YOLO[12]系列算法。YOLO方法将待检测图区分若干个格子,如果对象的中心落在一个格子,由该格子预测目标,在同一卷积网络中完成特征提取、候选框边界回归和分类,因此YOLO相比于SSD算法拥有更好的全局感受野。同时,YOLO相比传统目标检测方法的最大优势在于模型结构简单、速度快,较好的满足了实时检测需求,基于此,本论文选用最新的YOLOv5[13]算法来识别无人机。

2 距离选通成像原理

激光作为照明所使用的激光波长比普通微波雷达短,可应用于目标的探测识别。激光主动成像因为成像质量不高,后来发展成距离选通成像,使激光主动成像系统工作于距离选通模式,以到达成像探测器的时间先后区分不同目标的回波信号,利用精准的延时和选通门控制,接收目标距离景深范围内的反射信号,把目标距离以外的散射信号物理隔绝在成像的范围外[14-15]。距离选通成像是克服激光主动成像后向杂散波的有效方法,激光器发射高单脉冲能量的信号,可以提高系统的有效作用距离,获得有效作用距离上的高分辨率图像。不同距离上目标反射图像是通过设定不同的时间延迟得到的。

激光距离选通成像原理(蓝绿激光雷达海洋探测,距离选通水下激光成像作用距离简化核算方法)如图1所示,高峰值功率脉冲激光器向目标发射激光脉冲,脉冲时间比激光往返成像探测器所用的时间短得多,在激光往返于目标与成像器件之间时,有用信号会被空气中杂散粒子后向散射光淹没,成像探测器接收光饱和,图像信噪比很大,探测器选通门关闭,隔绝了后向散射;目标反射回波达到成像探测器,高精度门控电路控制快门开启,保持选通时间(一般为纳米量级),面阵成像探测器接收目标距离的反射光,选通时间越短条件下对背景噪声的抑制效果越好,图像信噪比越高,但越短的时间,探测器接收的反射光越少,会影响到成像的质量。激光在往返目标期间,探测器快门的关闭状态有效抑制背景噪声及大气散射噪声的干扰,提高远处暗小目标的识别能力。图像与距离切片相对应,通过这些序列切片得到图像的距离信息。

图1 激光距离选通成像原理Fig.1 Laser distance gated imaging principle

对远距离的目标进行探测时,后向散射杂波随机分布增大了探测器接收的信噪比,距离选通技术对脉冲时间和选通门的宽度有很高的要求,控制延迟时间、选通门的开启时间点这两个时间的准确性是距离选通成像系统的关键,这两个时间宽度越短,精准的延时控制信号使接收系统只收到目标附近的反射光,避免其他杂散光进入选通门中,将有用信号和杂波信号在时间上分开,选通门宽要大于或等于激光器脉宽,确保接收到全部目标回波信号。

3 YOLOv5框架

YOLO是通过回归思想检测目标的位置和类别,有着良好的性能和较短的检测时间,是目前用于目标检测最流行的深度卷积模型之一。2020年发展到了YOLOv5,其在识别分类上精度最高。YOLOv5网络分为四种模型,其中s模型最小,m、l和x的模型大小递依次增,特征提取能力也更强。YOLOv5权重大小比YOLOv4小近90 %,YOLOv5更方便在手机、无人机等嵌入式设备中使用。YOLOv5网络分为输入端、Backbone、Neck、预测端四个部分[16]。

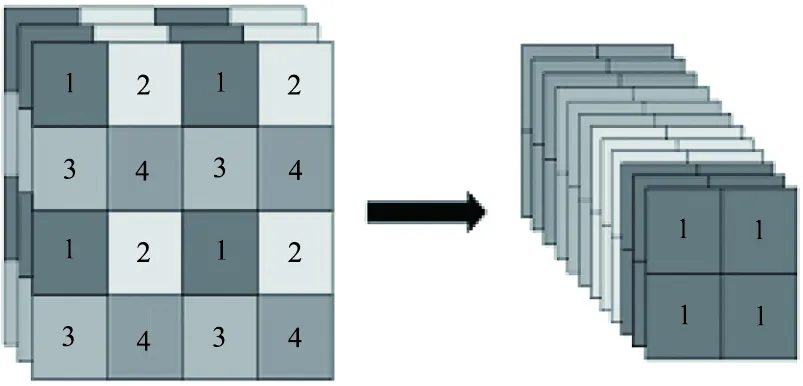

(1)输入端

输入端采用Mosaic对数据增强,4张图像的缩放、裁剪、分布都以随机完成,并随机拼组在一起。随机缩放增加了目标数量,充实了数据集,减小占用GPU内存量,提高了鲁棒性和训练速度。算法的锚框长宽对不同的数据集都有确定的先验值,网络在初始锚框基础上计算预测框与真实框的差值,然后通过反向更新迭代网络参数。

(2)Backbone

有切片操作功能的Focus结构被用在了主干网络中,切片示意如图2所示,图像大小4×4×3的切片为2×2×12的特征图后,对图像进行特征提取。CBL由Conv、Bn和Leaky_relu激活函数三者组成。YOLOv5中包括了CSP1_X、CSP2_X结构,两种结构分别应用于Backbone和Neck中。网络通过CSPDarknet提取图像中的信息特征,CSPNet从开始到结尾将梯度变化集成到特征图中,降低了模型的FLOPS数值和参数数量,既确保了推理速度和准确率,又可以把模型的规模减小。CSPNet把基础层的映射特征图复制后,用Densblock把副本发给下一阶段,分离了基础层的特征映射图。SPP实现多尺度融合,用了1×1,5×5,9×9,13×13的最大池化的方式。

图2 切片操作示意图Fig.2 Schematic diagram of slicing operation

(3)Neck

特征金字塔是识别系统的基本组成部分,用于检测尺度不同的目标。Neck模块用来生成特征金字塔,实现提取融合特征能力。普遍认为PANET适合YOLO特征融合网络,YOLOv5中采用了特征金字塔(Feature Pyramid Networks,FPN)和路径聚合网络(Path Aggregation Network,PAN)的结构,为了改进低层特征传播,增强网络向前的路径,在特征提取层采用新的FPN结构。CSP2结构应用在Neck中,提高了特征融合能力。

(4)预测端

检测目标通常包括分类损失和回归损失两类函数,预测端采用可解决相交情况不同的GIoU Loss作为Bounding box的损失函数,使用了加权非极大值抑制(Non Maximum Suppression,NMS)的方式,比较重叠面积时,NMS操作按照推测的置信度赋予不同的权值计算。

YOLOv5的优点是用了Pytorch这种简练高能的框架,相比YOLOv4使用Darknet框架,YOLOv5可方便训练自己的数据集。模型代码易读,可快速训练模型,可在视频输出端口对图像批量处理。

4 图像数据集

YOLOv5分类识别的前提是对数据集进行训练,目前还没有无人机的激光图像数据集,为了实现对无人机的分类识别,需要采集无人机激光图像数据集,本节利用采集的五种无人机激光图像数据集进行训练和类型的识别。

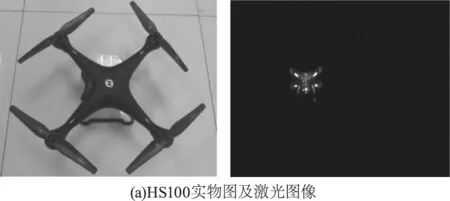

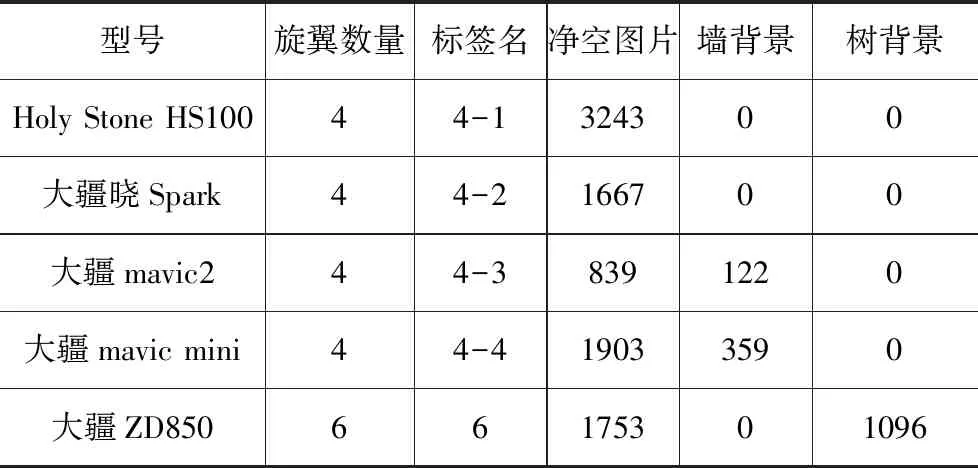

为了满足实验的需要,采集了4种四旋翼无人机、1种六旋翼无人机激光成像视频,分别提取成图片,作为激光图像的数据集。5种无人机激光图像标注总数为9886张。无人机图像和激光图像如图3所示,数据集情况如表1所示。

图3 五种无人机图像及激光图像Fig.3 Five types of drone images and laser images

表1 标注数据集情况Tab.1 Annotate the data set situation

5 实验分析

实验是在安装Window10的服务器上完成,服务器的CPU:Intel(R)Xeon(R)Silver 4116 CPU @2.1GHz 2.1GHz(2处理器),内存32GB,显卡NVIDIA GeForce RTX-3090 32 GB,cuda11.1.0_456.43_win10,cudnn-11.1-windows-x64-v8.0.4.30,Aanconda3-2020.02-Windows-x86_64版本搭建Pytorch1.7,python 3.7.6,pycharm-community-2020.1.3 x64。初始学习率为0.01,类别数量为1,最终学习率为0.1,权重衰减为0.001,动量Momentum为0.95,batch-size为24。

5.1 数据集的训练

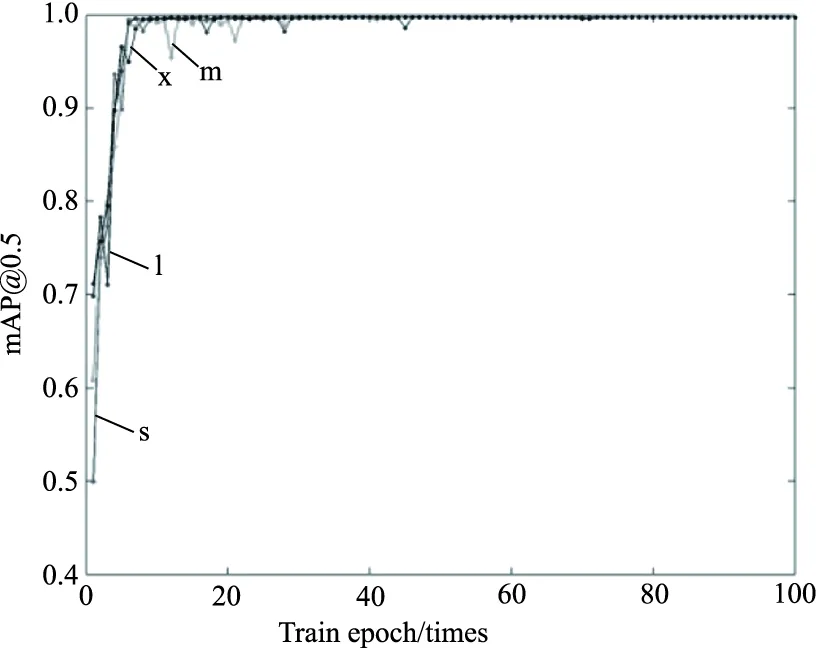

选择五种无人机净空背景数据集,按比例6∶2∶2划分训练集、验证集和测试集,分别用YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x四种模型训练,初始学习率为0.01,类别数量为5,最终学习率为0.1,权重衰减为0.001,动量Momentum为0.95,batch-size为4,epoch为100,得到YOLOv5的四种模型对无人机数据集训练准确率及损失率曲线如图4所示。

(a)准确率

从四种模型对数据训练结果可以看出,四种模型训练100个epoch的准确率都是99.73 %,对无人机类别检测识别效果比较理想。四种模型epoch的损失率分别为0.008106、0.007744、0.007598、0.00752,损失率都在1 %以内。对识别无人机来说,训练100个epoch得到的权重参数已经能够满足检测识别的要求。其中YOLOv5s模型最小,检测速度快,因此选用YOLOv5s模型训练结果对激光图像检测。

5.2 无人机的分类识别

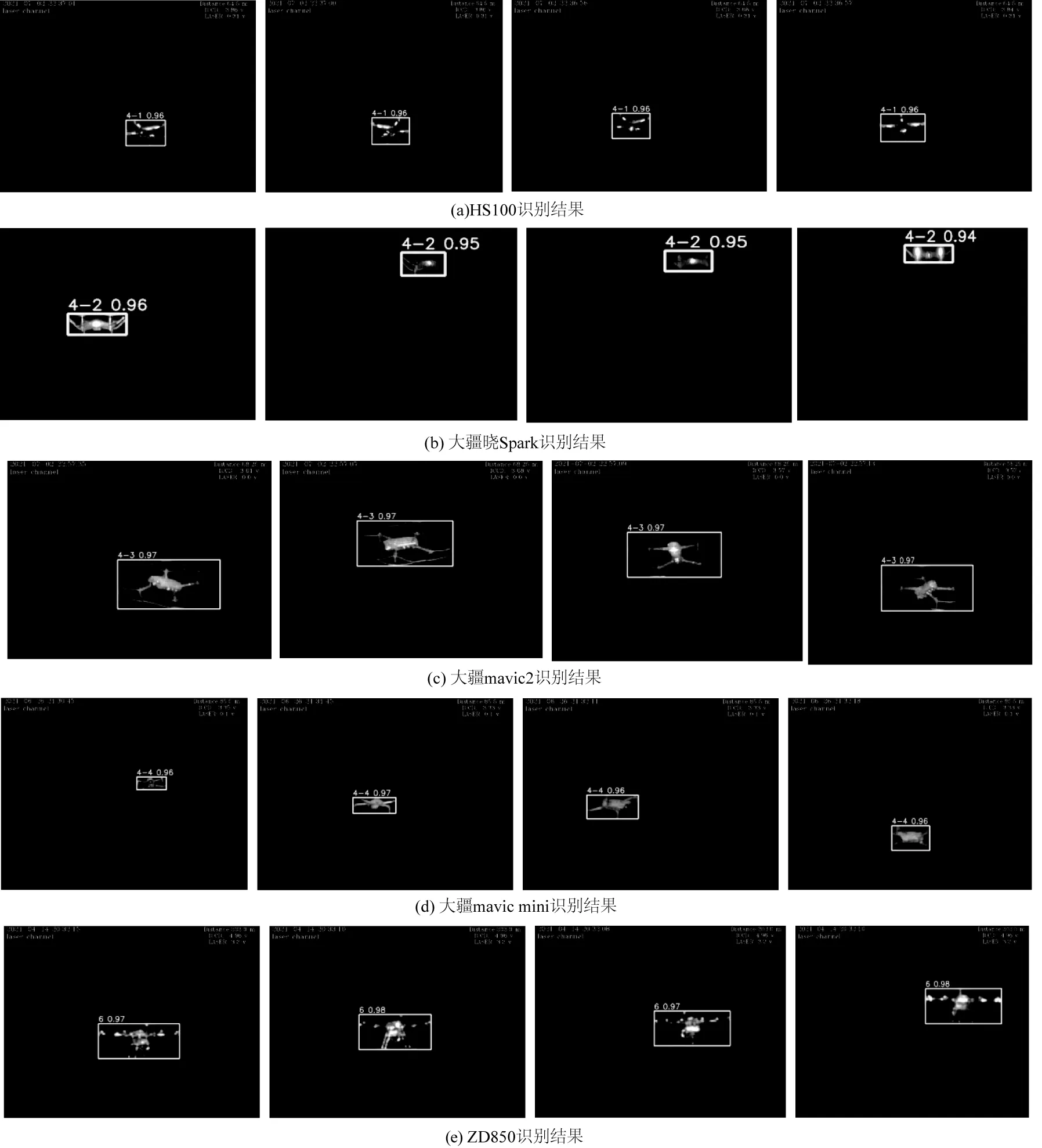

采用YOLOv5s权重,对数据训练100个epoch,并且设置置信度为0.20,识别五种无人机测试图像,部分识别结果如图5所示。

图5 无人机识别结果Fig.1 UAV recognition results

五种无人机测试数量分别为648、333、168、380、350帧,识别的数量分别为622、315、160、364、334帧,平均识别率为96 %、94.6 %、95.2 %、95.7 %、95.4 %,识别准确率较高,未识别的原因是目标运动模糊带来特征改变。没有背景干扰的测试集无人机特征明显,检测网络对无人机识别效果较好。

6 总结与展望

本文采用基于YOLOv5的网络模型对夜间无人机进行分类识别,达到了较好的识别准确率。同时针对无人机激光图像没有公开数据集的情况,使用距离选通成像器件对五种型号的无人机拍摄,拍摄环境为简单无背景的黑夜,构建五种无人机数据集,并对五种无人机使用labelImg进行标注。然后使用YOLOv5四种模型对数据进行训练,识别分类准确率较高,未识别的原因是目标运动模糊带来特征改变。

夜间无人机的分类检测研究是一个新的研究热点,夜间无人机激光图像难以获得是研究的难题,通过距离选通成像系统,对无人机的激光图像获得提供了一条新的道路。除了净空背景以外,无人机所处的环境千变万化,有树木遮挡,建筑遮挡等问题。所以下一步的研究重点将会放在复杂背景下无人机激光图像的识别。