基于无人机红外影像的森林火灾燃烧点检测方法

2022-09-26戴颖成陈知明李建军吴若南

戴颖成,陈知明,刘 峰,李建军,吴 毅,吴若南

(中南林业科技大学 计算机与信息工程学院,湖南 长沙 410004)

森林是宝贵的自然资源,它不仅提供木材和多种林副产品,而且在保护环境、维持生态平衡方面起着极为重要的作用[1-2]。然而火灾是危害森林安全的最大灾害之一,由于森林火灾的快速对流传播和长燃烧周期,森林火灾检测方法对发现和遏制森林火灾尤为重要[3]。传统的森林火灾检测方法包括建立瞭望塔、在高海拔地区建立视频监控与定期使用直升机对森林区域进行巡护等。但瞭望塔受限于地形因素的影响,覆盖面积有限;高山视频监控的机动性差,具有视觉盲区;直升机巡护的开销大,且受山地上空气流影响严重,具有安全隐患。近年来,研究者们针对传统森林火灾检测方法的局限性提出了一种基于无线传感器网络的物联网(Internet of Things)检测系统[4-9],但这类网络部署范围有限,在区域辽阔的森林中使用开销过高,只适用于森林中人群集中的区域。因此,基于计算机视觉的森林火灾检测方法受到了广泛关注,如各种基于光学影像的颜色空间检测方法,以及融合火焰的颜色和闪烁跃动特征的检测方法[10]等。虽然人们对火焰燃烧点的检测进行了许多研究,但受森林区域性大和复杂背景的限制,基于计算机视觉的森林火灾检测仍旧面临许多挑战。近年来,随着人工智能技术的发展,各种基于影像数据的目标检测方法的准确度和精度逐步上升。特别是随着无人机(UAV)的普及,基于无人机影像的目标检测技术受到了全世界的关注,同样也被广泛应用于森林火灾检测与预防[11-13],结合无人机与人工智能技术的森林火灾检测是目前国内外最普遍的方法之一[14-15],有效地结合了森林火灾检测在尺度、效率、开销与机动性上的各个优势。

在基于影像数据的森林火灾检测领域中,主流的方法大致分为两类:一是基于图像分类技术,采集大量的林火图像数据,对图像进行二分类编码,让模型对输入图像进行火灾与非火灾的二分类判别[16-18]。这种方法的优势在于从视图的全局特征出发,在特定或基本不变的森林环境背景下准确性较好,但是模型的泛化能力有限,天气及背景变化也会对模型判别产生巨大的干扰,只适用于固定不变的高山视频监控,灵活性较差。二是基于实时视频的目标检测技术,对森林火灾图像中的燃烧点进行小范围的标注,将带有像素位置信息的燃烧点送入模型训练,从而让模型找到火灾燃点在图像上的位置[19-21]。这种方法强调火焰的局部特征,受背景变化的影响小,可以跟随检测载具进行快速移动,具有很强的灵活性,更适用于无人机森林火灾检测系统。

虽然无人机森林火灾检测方法优势显著,但仍旧会带来许多问题,一是无人机巡检中可能出现由于飞行高度过高导致的森林燃点过小、像素信息不足等问题。其解决方案一般是增加巡护无人机所搭载摄像头的分辨率,但像素的增加,对图形的计算设备负担增大,从而导致检测速率降低,实时的检测延迟过长。二是高大的树木或燃烧的烟雾会对无人机拍摄视角下森林火灾燃点进行遮挡,这会导致森林火灾检测系统的检测丢失。有学者提出了一种针对森林火灾的烟雾检测模型[22-24]用以解决燃烧点遮挡问题,但在不同阶段的森林火灾或不同角度和距离的无人机拍摄视角内,烟雾特征相差较大,对训练数据要求过高,且云雾对检测的干扰严重。

本研究提出一种基于无人机红外影像数据的森林火灾检测方法。一方面通过无人机载具提升森林火灾检测的敏捷性和灵活性;另一方面通过深度学习提升无人机森林火灾检测的准确度与效率。通过无人机采集森林巡护的红外影像画面,将画面数据传输回地面站后,在地面站使用配置的计算机进行实时检测。

1 材料与方法

无人机已成为一种高效的森林火灾检测任务的载具,对比于传统的森林火灾检测方法,无人机在检测尺度、检测范围与检测效率上都有突出表现。使用无人机进行森林火灾检测的过程如图1所示。

图1 无人机森林火灾检测的过程Fig.1 The process of forest fire detection of UAV

1.1 数据源

中国河北省张家口市崇礼区位于中国北部温带亚干旱地区,年降水量小,常年平均气温约为10℃,冰雪覆盖周期较长,为了确保训练出来的模型能很好地适应当地环境,试验模拟了森林火灾早期阶段的场景并实地采集了当地的无人机森林巡护数据。数据的内容包含三个不同的季节,跨度超过了6个月的时间尺度。

本实验数据来自于国家冬奥会森林防护工程项目,所获取的森林火灾模拟数据无法支撑建立起有效的森林火灾检测模型,为了解决这一问题,从美国北亚利桑那大学(Northern Arizona University)迁移部分背景极为相似的森林火灾无人机巡护数据进行融合。在数据的选取中,尽可能涵盖更多的森林背景和气象环境(不同种类森林与不同天气下的森林火灾场景),增强检测模型的抗干扰能力与泛化性能。数据包含高清光学影像数据与红外影像数据(图2)。

图2 试验采集数据Fig.2 Collected data

1.2 数据预处理

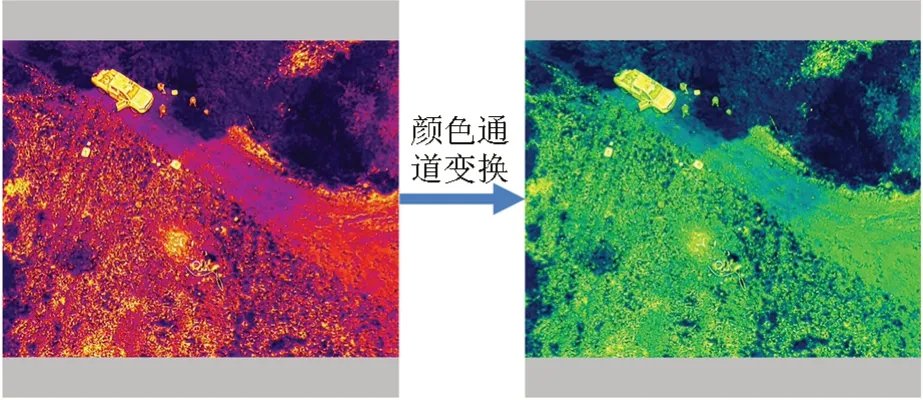

1.2.1 红外影像的通道变换

对于红外影像,迁移数据与本地采集数据设备不同,导致形成的红外影像的能量在不同的颜色通道聚集,因此需要对崇礼地区采集到的热红外数据进行一次颜色通道变换,让其与迁移数据在颜色通道上具有一致性。通道变换效果如图3所示。经过以上处理后,将两类图像中的森林燃烧点进行标注并以8∶2的比例进行训练数据与测试数据的划分。

图3 图像颜色通道变换Fig.3 The results of channel transpose in image data

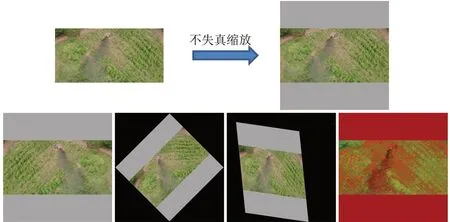

1.2.2 图像数据的增广

训练数据集不能完整包含所有可能的森林火灾信息,因此需要通过图像数据增广的方式让模型有效地从大量已知的图像中学习到更多的森林火灾特征,增加模型应对未知森林火灾场景的能力。具体操作是对选取的图像进行水平翻转、图像旋转、图像仿射以及图像色域变换,效果如图4所示。

图4 数据增强后的效果Fig.4 The results after data augmentation

1.3 无人机影像的特征提取

影像数据或图像数据表现为取值在0到255之间的三维像素矩阵(Width, Height, Channel),其中Width和Height表示图像的宽度和高度,Channel代表三原色(红,绿,蓝)通道,在这个形状的像素矩阵内,数值越大,则颜色越深。引入图像的卷积特征对森林火灾检测进行研究,提升森林火灾检测模型的检测性能。图5展示了对不同种类的森林和不同年龄段的森林图像在一个卷积核中进行一次卷积特征提取的效果。可以发现,在卷积特征提取中,所保留的信息直观且易于模糊掉无用的复杂背景信息。

图5 使用一种卷积核提取的图像特征Fig.5 Image features extracted by a convolution kernel

在一个深度卷积神经网络的主干网络中,卷积核的总数量可达到数十万至数百万个,将这些卷积核提取的特征送入模型中进行判别映射,可以有效地保证模型对图像的判别效果。

1.4 Faster R-CNN

对于森林火灾检测日益增长的需求而言,森林火灾检测模型不仅需要对图像中是否发生火灾进行判别,还需要一个更直接的可视化需求,即在画面中,准确地将森林火灾的区域标注出来,用以支持后续阶段的工作。尤其是在无人机对森林进行巡护的过程中,无法在第一时刻锁定燃烧区域,可能需要无人机在大范围区域盘旋,会大量损耗无人机的续航能力。基于Faster R-CNN的森林火灾检测在实时视频传输中与检测速度上都更具有优势,并且能够更直观地在视频中定位森林火灾的位置,更适用于森林火灾的后续观察和扑救指挥。对比于其他的森林火灾检测方法,它兼顾了方便性、可视化等特点。

1.4.1 Faster R-CNN检测原理

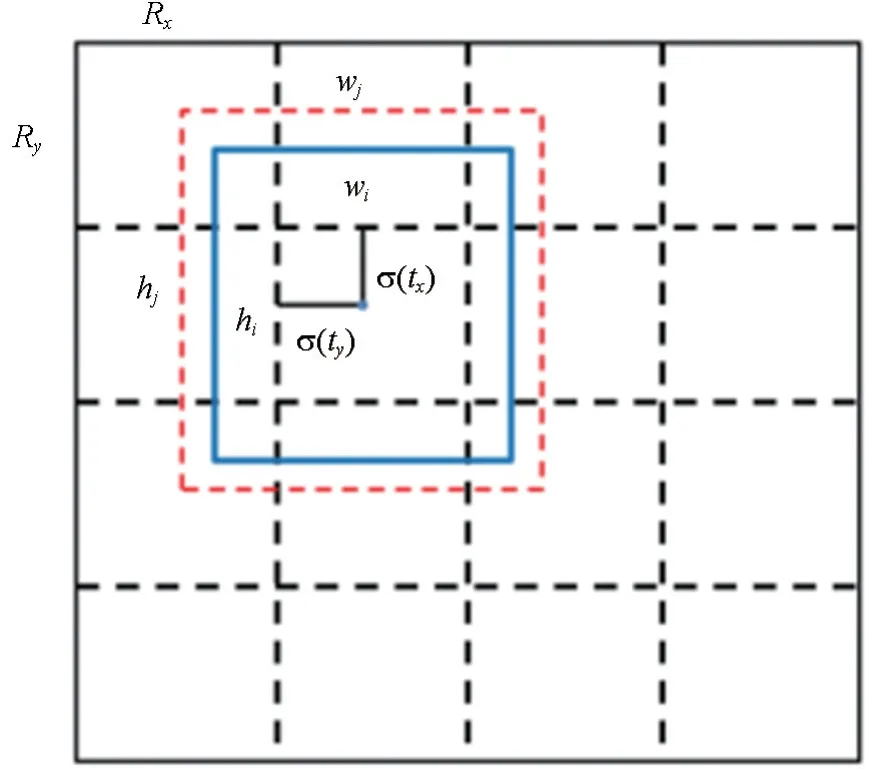

目标检测任务中的检测框预测机制来源于Faster R-CNN的区域提案网络(Region proposal network, RPN)。它通过预先对数据进行聚类[29],从而设置每个区域锚框的数量和锚框的长度和宽度。再根据全卷积网络计算得到的区域偏移值,从而确定区域内锚框的中心点位置(图6)。每张图像被划分为N2个区域,对每个区域编码,可以得到从1至N2的每个区域所在的位置。每个区域有K个锚框,每个区域所包含的向量长度就为K×6,其中6代表6个偏量(offset),分别表示为区域中是否有目标、区域中目标的类别、锚框的两个偏置量(tx、ty由全卷积网络计算得到)、锚框的长度和宽度偏量(tw、th也通过全卷积网络计算得到)。因此,对于一张图像而言,它通过目标检测模型后就可以得到一个长度为N2×K×6的向量。至此,通过训练后的区域提案网络就可以得到一张图像内各种不同的目标的位置信息。

图6 每一个单元区域的一个先验框所包含的信息Fig.6 The information of each box of each unit cell

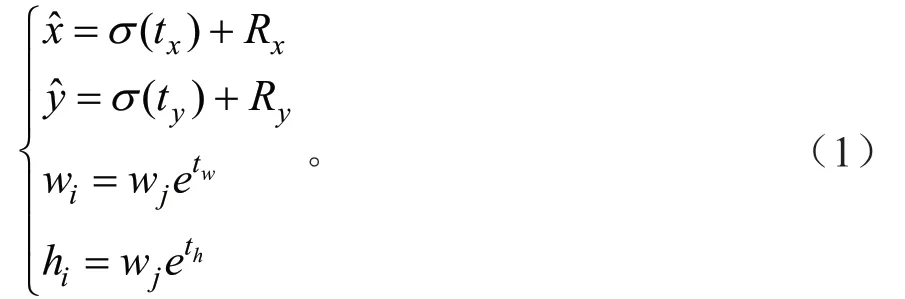

1.4.2 交并比与损失函数

在区域提案网络中,最终可以得到6个与预测框相关的变量,将这些变量进行特定的变换后,根据每个锚框的位置信息,获得最合适的预测框,然后通过这个最合适的预测框信息与真实标签构建损失函数,就可以回归出预测框的基本信息。因此,需要对全卷积网络计算出的6组变量分别做特定的变换。其中Object量需要进行Sigmoid变换,得到一个是否有目标的置信度θ。对于tx与ty也需要进行Sigmoid变换,将区域内的偏置量限定在0至1之间。对于tw与th则进行基于锚框的指数变换。对class进行Softmax变换(若有3种类别,则分别得到三个类别的概率,取概率值最大的类别作为预测的类)。其变换原理如图7所示,变换公式如式(1)所示。

图7 检测框的计算Fig.7 Conversion relationship of detection frame

式中:wj代表区域的第j(0<j<K)个锚框的宽度;hj代表区域的第j个锚框的高度;σ()·代表Sigmoid运算,通过区域编码,就可以知道每个区域在全图中的x坐标和y坐标上的平移量,从而得到Rx和Ry。

得到上述变量后,再根据交并比(Intersection over Union)自动回归,就可以找到最适合的边界框[30-34]。交并比的原理如图8所示。计算公式如式(2)所示。

图8 交并比的计算原理Fig.8 The calculation principle of the Intersection-over-Union

式(2)中:GT代表训练数据中真实标注的目标框;Prej表示基于第j个锚框计算得到的预测框。此时,对于每个区域而言,都可以根据真实标签计算得到K个预测框的交并比IoU的置信度用于回归模型。

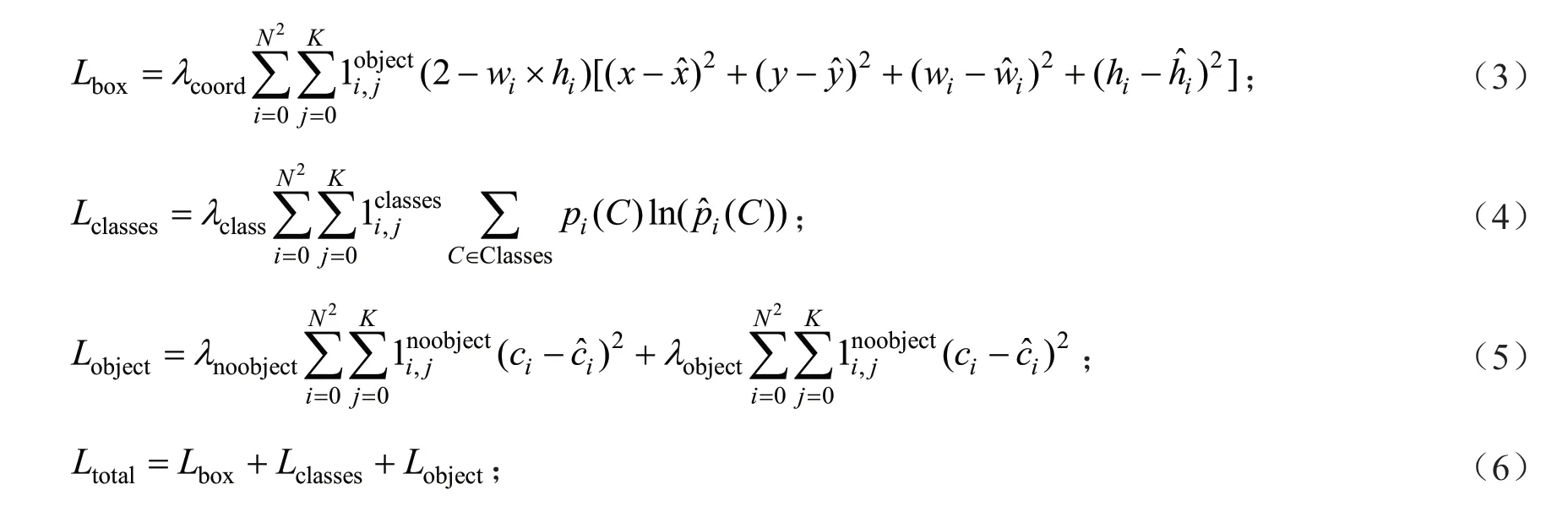

最后,根据预测框中的信息,与真实的标签框构建3种类型的损失函数,将这三者统一起来,就可以得到最终的损失函数,分别如公式(3)~(6)所示。

式(3)~(6)中:x与y表示真实标签框的中心点位置; ˆx、 ˆy代表锚框的中心点位置;Lobject表示置信度θ超过设定的阈值时为1,否则为0。

1.5 CSPNet-34与PANet

基于深度学习的森林火灾检测模型主要分为两个部分,一是作为主干网络的特征提取层,二是对特征进行检测与处理的输出层。主干特征提取网络由CSPNet-34与PANet组成,对特征进行提取后,将提出来的三层特征图像进行特征堆叠,因此,在PANet结构中采用了FNP(Feature Network Pyramid)[25]。

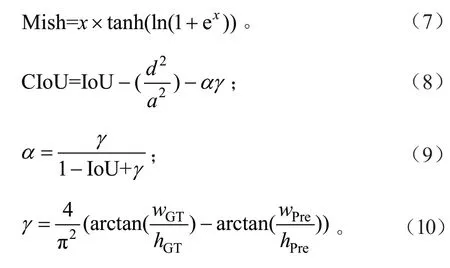

CSPNet-34的最基本单元为CBM(Convolution,Batch Normalization, Mish)。CBM单元对输入的数据依次执行卷积、批量标准化和非线性激活函数映射[26-27]。其中Mish激活函数如公式(7)所示。另一个组件单元残差块(Residual)是由两个CBM单元构成。此外,CSPNet-34在特征堆叠部分引入SPP模块,它分别利用3个不同尺度的池化核对CSPNet-34的最后一个输出进行最大池化,然后进行堆叠,池化核大小分别为13×13、9×9、5×5。它们的结构如图9所示。CSPNet-34的整个网络由这些单元结合堆叠而成,其网络结构如图10所示。

图9 CSPNet-34的基本单元结构Fig.9 The structure of basic unit of CSPNet-34

图10 CSPNet-34与PANet的结构Fig.10 The structure of CSPNet-34 and PANet

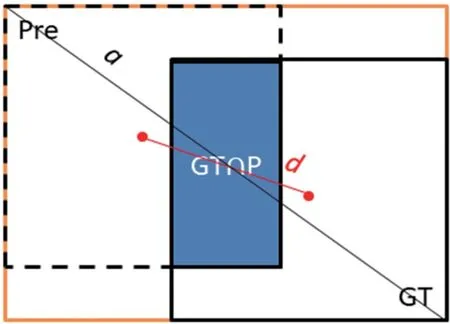

PANet负责对特征进行逐层提取,在完成特征金字塔从下到上的特征提取后,还实现从上到下的特征提取,实现了浅层特征和深层特征的有效融合,并且在整个目标判定过程中,使用CIoU的概念替换了IoU,使得预测框的框选更接近真实值。CIoU原理如图11所示,公式如式(8)~(10)所示。

图11 CIoU的原理Fig.11 The principle of CIoU

式(7)~(10)中:d代表预测框与真实框的中心点的欧几里得距离;a代表的是能够同时包含预测框与真实框的最小矩形空间的对角线距离;wGT代表真实框的宽;hGT代表真实框的高;wPre代表预测框的宽;hPre代表预测框的高。

2 结果与分析

2.1 试验环境与参数

本研究试验环境为:操作系统Windows 10 CPU Inter Core i9-7920X CPU @ 2.90GHZ,16 GB内存,NVIDIA GeForce RTX 2080Ti,64位系统。编程语言为Python3.7,编译框架为Pytorch1.7.1,OpenCV0.4.0,GPU 加速库为CUDA10.1。采用的光学图像与红外图像的数据量都为1 000张。在训练过程中,使用迁移学习的方法,从基于CSPNet-34的COCO数据集检测模型中迁移初始权重后,再使用本试验整理的数据对模型进行训练,初始学习率为0.005,batch-size数为16,总共训练了200个epoch,IoU置信度取值为0.95。

本研究采用了冻结训练的操作,可节省一部分实践,在训练前70个epoch时,对网络内的浅层(前17层)参数进行冻结,然后在第70个epoch开始解冻浅层的网络参数。这样可以将更多的计算资源赋予深层的网络结构,极大地提高资源利用效率。在预测过程中,经过多次测试,非极大抑制的IoU抑制阈值为0.3时,能够有效地解决显示中出现的统一目标多框,或两个目标共用一个检测框的问题。

2.2 试验结果与分析

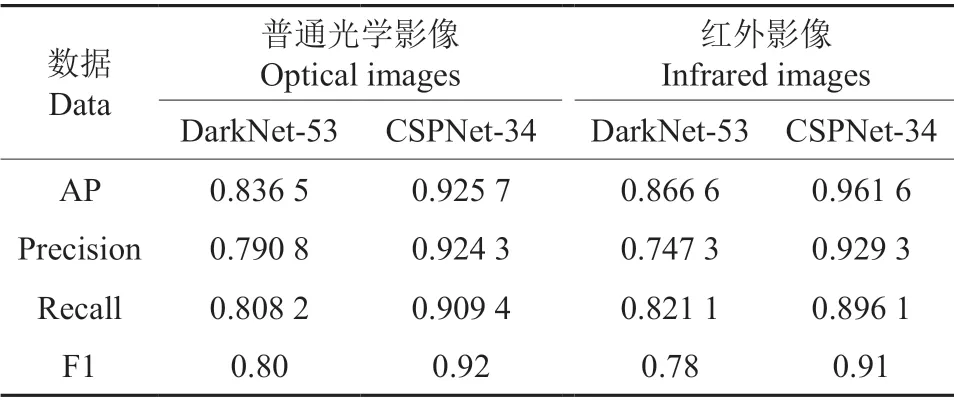

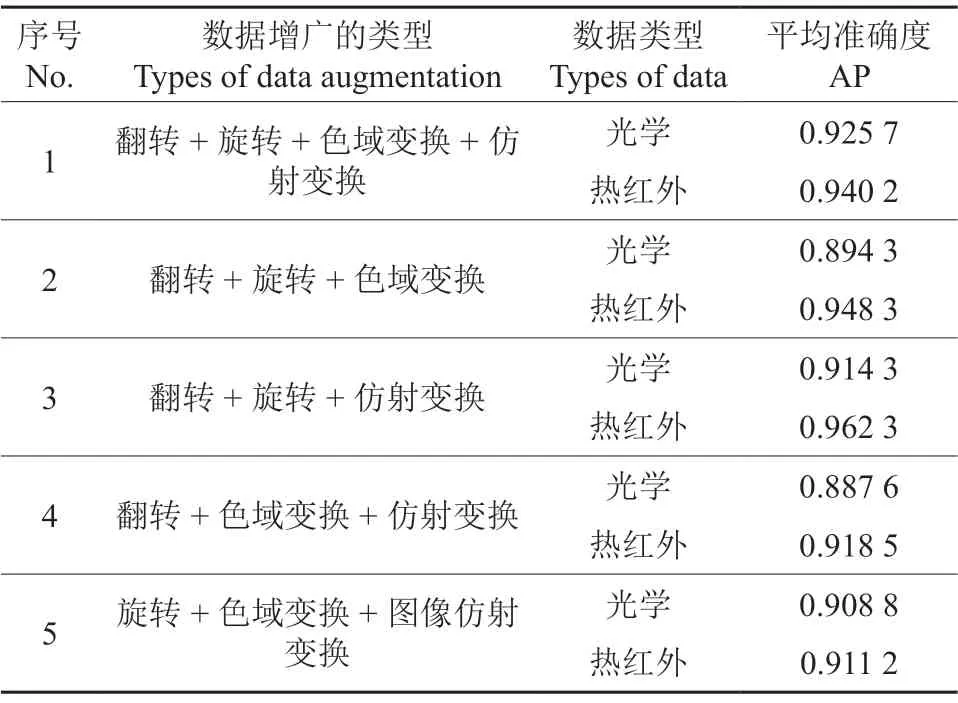

在两种不同的主干特征提取网络中,不同的森林火灾图像数据的表现各不相同(表1)。在两种数据视频的检测测试中,可以得到其检测的FPS(表2)。在试验中对CSPNet-34的SPP结构采用不同大小的池化测试,对比结果如表3所示。数据增广方法的消融试验对模型的性能影响如表4所示。

表1 不同数据下2种主干特征提取网络的检测性能Table 1 Comparison of two backbone feature extraction networks under different data

表2 2种森林火灾检测模型的检测速度对比Table 2 Comparison of detection speed of two forest fire detection models in different data

表3 CSPNet-34模型在2种SPP池化状态下的表现Table 3 Performance of the CSPNet-34 under the two SPP pooling states

表4 CSPNet-34在两类数据中的消融试验Table 4 Ablation experiment of CSPNet-34 in two types of data

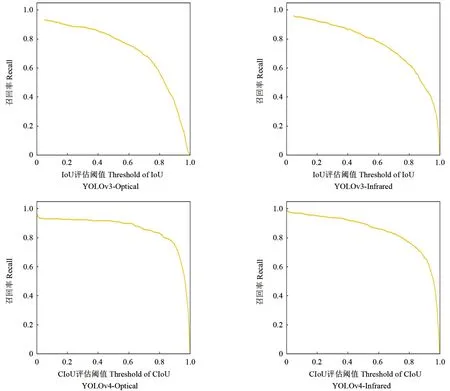

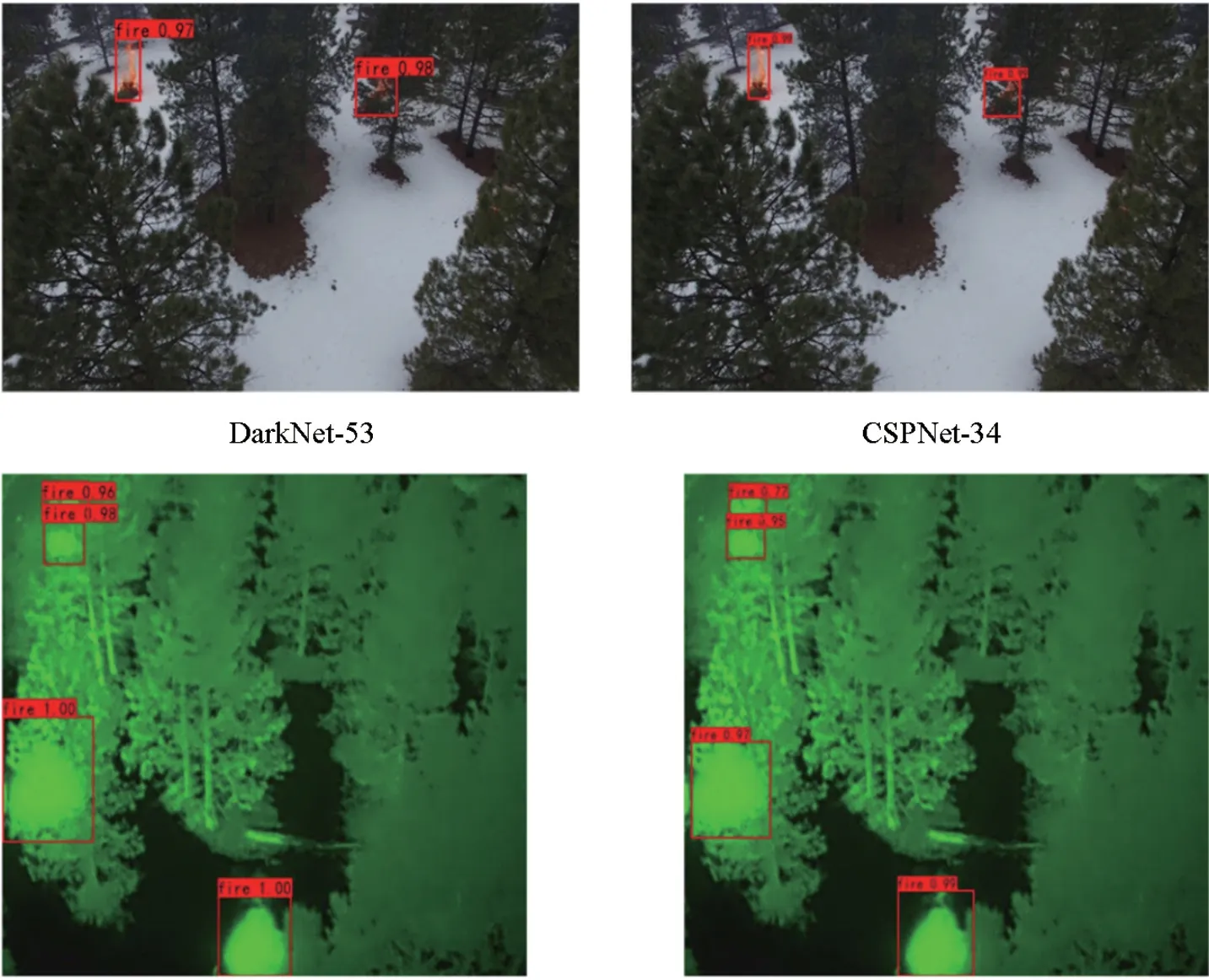

普通光学影像与红外影像的AP (Average Precision)曲线如图12所示,不同阈值下的准确度(Threshold-Precision)对比曲线如图13所示,不同阈值下的召回率曲线(Recall)对比如图14所示,不同阈值下的F1性能指标如图15所示。最终的测试效果如图16所示。

图12 模型的AP曲线Fig.12 Average precision of models

图13 不同评估阈值下的Precision曲线Fig.13 The precision of models in different threshold

图14 不同评估阈值下的Recall曲线Fig.14 The Recall of models in different thresholds

图15 不同评估阈值下的F1-Score曲线Fig.15 The F1-Score of models in different thresholds

图16 DarkNet-53与CSPNet-34在2种数据集下的表现Fig.16 Performance of DarkNet-53 and CSPNet-34 on two datasets

表1显示,基于CSPNet的森林火灾检测模型对目标具有更高的检测精度,模型对区域内目标的特征更敏感。由于CSPNet的特征堆叠具有双向叠加性,使得模型的特征更丰富,检测效果更好。对于森林火灾检测,红外数据能够反映的像素特征比光学图像更敏感,因此在热红外数据中,CSPNet的检测效果更加突出。

表2中,热红外数据视频具有更快的检测速度,这是由于热红外数据相比光学图像所包含的信息量更少,在对图像进行标准化的操作中,其进行预处理时,所需要的计算量与计算时间更少。在实际的检测任务中,无法抛去标准化操作,因为模型的输入标准具有固定不变的特征,且输入图像的形状大小对主干特征提取网络的影响较为严重。

表3显示,SPP的池化核大小对模型性能的影响相对较小,对于光学图像而言,13×13、8×8、4×4的SPP表现更优异,但在热红外图像数据中,另一类SPP模块更具有优势。这可能是由于无人机森林图像的深层特征所造成的影响,在光学图像中,图像数据的像素特征比热红外图像丰富,池化核越小,所堆叠的特征维度越长,越有利于对光学图像下目标的识别;但热红外图像的深层特征更少,因此特征堆叠的长度相对影响不明显。

由表4可知,图像的色域变换对光学图像目标检测模型具有较强的提升。但对热红外图像却提升不大,这可能是由于森林火灾的燃烧火焰在光学图像中与热红外图像中的火焰形态与色差有关。在光学图像中,火焰的色彩能量集中于R通道中,而环境中的色彩能量则大部分集中于G通道,只有少量与之交叉;而在热红外图像中,全图的色彩能量均集中于G通道内,因此火焰的确定只能依靠其他特征进行判别。此外,在光学图像中,森林火灾的火焰呈细条状,且焰苗在短时间内可能随当前风速出现大量的闪跃运动,而在热红外图像中,距离燃烧核心越远的部分,在图像中的特征存在越弱,因此光学图像的仿射变换,可以增加光学数据中心火焰的运动形态,而在热红外数据中,图像的仿射变换破坏了燃烧核心的稳定特征。

从图12~15中可以看出,CSPNet-34的IoU阈值可以扩展的范围更广,模型的稳定性更强。而DarkNet-53的IoU阈值选取范围更小,模型的稳定性更弱。图16中,CSPNet-34的检测框明显小于DarkNet-53,这是由于CIoU的回归算法对于普通的IoU更加严格,因此其目标的预测框也更为贴合。模型可以更加稳定地锁定快速移动的目标,更适用于无人机森林火灾检测任务。

3 结 论

本研究提出了一种基于无人机红外影像的森林火灾燃烧点检测方法,并在地面站配置的计算机设备上进行了仿真检测,结果表明基于无人机红外影像的模型在检测尺度、模型复杂度、检测速度、检测准确度与检测效率上比光学影像森林火灾检测模型更具优势。红外影像下的森林火灾检测任务受背景信息的干扰程度低,可以有效地抵抗无人机高速移动对拍摄造成的影响。在光学影像中被烟雾或树冠所遮挡的火焰燃点通过红外影像能有效地被检测到,减少了森林火灾检测任务中出现的检测丢失现象。此外,针对两类不同的无人机影像数据,匹配相应的数据增广方法,可以有效提升森林火灾检测模型的检测能力。