太阳射电频谱爆发识别的元学习方法

2022-08-17郭军成胡欣杰严发宝

郭军成, 万 刚, 胡欣杰, 严发宝, 王 帅,*

(1. 航天工程大学航天信息学院, 北京 101416;2. 山东大学空间科学研究院空间电磁探测技术实验室, 山东 威海 264200;3. 中国人民解放军66444部队, 北京 100042)

0 引 言

太阳射电爆发事件是射电天文最早研究的现象之一,射电爆发时的辐射频率最高可达到上百兆赫兹,同时其辐射强度也可达到平静太阳活动时的上万倍。由于太阳射电爆发时的辐射强度、辐射频率和谱形等均与辐射源区的磁场、等离子体和能量离子的性质有关,使得对太阳射电爆发的有关观测成为认识空间天气事件和太阳活动,特别是日冕物质抛射和耀斑等太阳射电爆发过程的一种独特和有效的诊断工具。太阳射电爆发时,射电辐射的急剧增强会对电离层状态,以及通讯和导航等活动产生显著影响。此外在军事方面,太阳射电爆发还可影响全球定位系统(global positioning system, GPS)的定位精度,减弱雷达监视系统的分辨和目标识别能力等。

太阳射电信号通常通过射电动态频谱仪和日像仪观测。射电频谱仪可以记录在一定频率范围内射电信号强度随频率和时间的变化,通常称之为动态频谱。中国太阳射电宽带动态频谱仪(solar broadband radio spectrometer, SBRS)在第23个太阳活动周期间投入工作,通过将分量分光计安装在北京、昆明和南京的不同天线上,SBRS可以全天候对太阳进行观测,也由此产生大量的射电频谱数据,而其中包含的太阳射电爆发数据却少之又少,这对天文工作者开展后续研究造成了一定困难。随着机器学习和人工智能技术在计算机视觉和天文学领域上的广泛应用,利用神经网络进行射电频谱图像的自动处理和分类识别已经逐渐成为主流,并取得了一系列成果。2015年,Gu等首先使用PCA对太阳射电频谱图进行降维,然后使用 SVM 对太阳射电进行分类,这是首个关于太阳射电频谱图自动分类的研究。2016年,Chen等人提出了用于太阳射电爆发分类的多模态深度学习方法,在学习的联合表示的基础上,对太阳射电爆发进行分类。实验结果表明,所提出的多模式学习网络能够有效地学习太阳射电谱的表示,提高分类精度。2018年,陈思思提出了一个基于卷积神经网络(convolutional neural network, CNN)的太阳射电频谱图分类算法,该网络采用了1×5和1×3卷积核代替了传统的卷积核,避免了通道之间的干扰,最终爆发频谱图像取得了84.6%的TPR值。2019年,崔泽潇采用将太阳射电爆发作为平静太阳射电活动噪声的思想,将射电爆发的识别问题转换为异常值检测的问题。2020年,张巧曼首先利用CNN对槎山观测站采集到的频谱图像进行了分类识别,然后对太阳射电爆发事件进行了定位检测和处理分析。

针对太阳射电频谱图像的少样本分类识别问题,本文分析了数据增强和迁移学习等少样本学习方法的局限性,提出了基于元学习和迁移学习的频谱图像分类算法。该方法利用MiniImageNet和Omniglot少样本数据集作为源域数据,将太阳射电频谱数据集作为目标域数据;首先通过让模型在源域数据集上进行多任务的元知识学习,然后将其学到的元知识迁移到目标域的分类任务中,最终实现少样本射电频谱图像的分类识别任务。实验结果证明,本文所提出的方法具有可行性。

1 元学习概述

依赖于大数据的支撑,近年来深度学习在人机交互、自动驾驶、智能推荐和模式识别等领域都取得了不俗的成绩。然而,由于深度神经网络包含的参数很多,需要海量的标签数据才能进行有效训练,而在许多场景下,获取大量的有标签数据是十分困难甚至是不现实的。与机器不同的是,人类并不需要大量的数据训练就可以实现快速地学习。比如,幼年时期的人类就可以实现,仅仅通过一两张某个动物的照片便可以分辨出该类动物。为了使得机器学习更加接近人类思维,真正迈向智能化,少样本学习的概念应运而生。自2003年Li等人首次提出少样本学习问题并利用贝叶斯框架对视觉对象进行学习以来,少样本学习技术日渐成熟,并发展形成了以基于数据增强的方法、基于迁移学习的方法和基于元学习的方法为代表的3类神经网络方法。

数据增强是解决深度学习模型训练过程中样本不足问题的最简单方法。基于无监督方式的数据增强是在已有的数据集基础上采用缩放、旋转、位移等仿射变换进行数据的扩增。这种基于几何变换和图像操作的方式可以在一定程度上解决数据量不足、模型过拟合的问题,但是其所增加的新样本并未改变目标特征,缺乏多样性。生成模型是有监督数据增强任务中最为关键的技术。生成模型不仅可以拟合高维数据分布,而且泛化能力更强,生成图像的质量更高,但其训练过程不稳定,容易出现梯度消失和弥散问题。总的来说,数据增强方法虽然简单直接的增加了新的训练样本,但是对于零样本学习来说,并没有从根本上解决少样本学习的问题。

迁移学习旨在利用源任务中模型参数的先验分布知识来学习目标任务的后验知识,从而实现将已经学会的知识迁移到一个新的领域中。迁移学习的主要策略是通过在目标域上继续训练来微调源域预训练网络的权重,但要求目标领域和源域之间必须具有一定的关联性,才能使得在源域数据中学到的知识和特征表示可以更好地帮助目标域实现模型的训练。此外,使用浅层的源域神经网络模型进行复杂信息的筛选和特征表示对于领域间的知识迁移具有局限性。

元学习又称学会学习,是利用以往的知识经验来指导新任务的学习,使网络具备学会学习的能力,也是解决少样本学习问题常用的方法之一。元学习的本质是增加学习器在多任务中的泛化能力。元学习对于任务和数据都需要采样,因此学习到的元知识可以在少样本的任务中迅速建立起映射。元学习中的“元”体现在网络对于每个任务的学习,通过不断的适应每个具体任务,使网络具备了一种抽象的学习能力。简而言之,元学习主要是通过对多个历史任务的学习,得到一个较好的模型超参数、架构、或者算法本身等元知识,使之能够快速适用于新的任务。

按照模型所学习到的元知识,元学习目前的研究大致可以分为3个较为主流的方向:基于度量的元学习、基于优化的元学习和基于模型的元学习。目前,基于度量的元学习分类算法有原型网络、匹配网络和关系网络等。这类方法的目标是获取一个可以度量相似性的特征空间,随后把这一特征空间用于新的任务,即在元学习的框架下构造一个可以端到端训练的分类器,实现对样本间距离分布的建模。但是当训练任务和测试任务相似性比较低的时候,模型效果受限。

基于模型的元学习方法是先学习任务的表示,再用任务的表示生成分类模型的部分参数。在训练时,对于每一个任务,神经网络按照顺序依次处理数据集,在每一个时间步中都会有一个输入改变模型的内部状态,使得模型的内部状态可以捕捉相关的特定于任务的信息,并将这些信息用于生成另一个分类模型的部分参数。基于这个思想,逐步发展形成了以MANNs(meta-learning with memory-augmented neural networks)、CNPs(conditional neural processes)和SNAIL(simple neural attentive meta-learner)为代表的少样本学习方法。

基于优化的元学习方法是通过对模型参数优化来快速的学习新任务。不同于经典的机器学习算法采用梯度下降来优化模型参数,基于优化的元学习器既可以通过学习来优化部分模型参数,也可以对整个模型的优化过程进行学习。元学习通过在多任务下执行参数优化,使得模型可以在更广泛的任务上学会快速学习新任务。但是,这种方法的计算量一般很大,需要更多计算资源,并且模型容易在训练任务上过拟合。这类方法包括MAML(model-agnostic meta-learning)、Meta-learner LSTM(long short-term memory)和LEO(Meta-learning with latent embedding optimization)等经典算法。

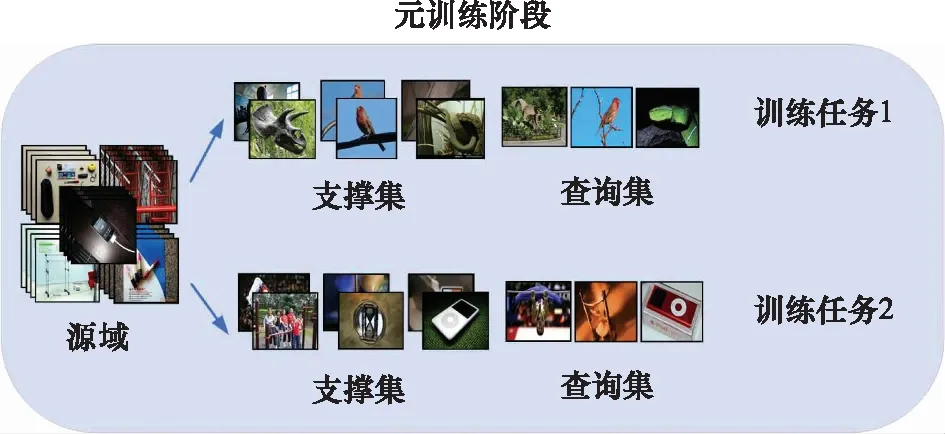

如图1所示,与一般的机器学习算法不同,元学习模型的基本训练单位为任务。为了区别概念,元学习中将训练过程定义为元训练阶段,测试过程定义为元测试阶段,相应过程中的任务称之为训练任务和测试任务。区别于一般神经网络端到端的训练方式,将每个任务中用于训练模型的数据集称为支撑集,用于测试的数据集称为查询集。 其中,元测试阶段所借助的数据称之为源域数据,元测试阶段所要学习的少样本数据称之为目标域数据。

需要注意的是,一般情况下源域和目标域是没有交集的。元学习所解决的是目标域中样本量少的问题,由于无法直接在目标域的小样本上进行训练,所以借助了源域的数据进行元知识的学习。在元测试阶段,为了对元学习模型进行泛化,每次训练都会从目标域中随机抽取个类别,每个类别个样本作为支撑集,称这种样本抽取方式为N-way K-shot。与此同时,为了保持元测试和元测试阶段的一致性,元测试阶段中源域每个任务的支撑集也保持相同的和。

2 基于优化的元学习方法

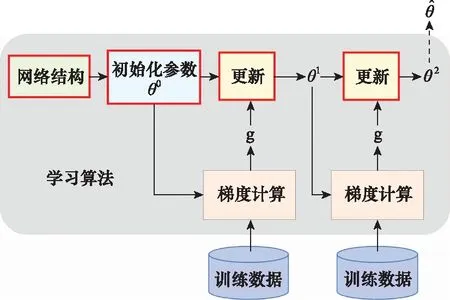

如图2所示,神经网络框架包括参数更新过程都可以视为学习算法,其中网络架构、初始化参数和更新规则都是可以人为设计的超参数,因此不同的超参数往往意味着不同的学习算法。基于优化的元学习方法可以通过让机器在源域数据上自主学习到部分超参数,再将学到的元知识迁移到目标域数据中,实现目标任务的元学习过程。

图2 神经网络的梯度下降过程Fig.2 Gradient descent of neural network

2.1 MAML

2.1.1 基本思想

Finn等人提出了MAML模型,使得可以在少量样本上,用少量的迭代步骤就可以获得较好的泛化性能。同时,模型容易微调也无需关心模型的形式,无需为元学习增加新的参数,可以直接用梯度下降算法来训练学习器。MAML本质上是学习任意标准模型的初始化参数,并让该模型能快速适配。采用一些更加适合迁移的具有泛化性的中间表达,使得MAML可以适应很多任务(分类、回归、增强学习),并通过微调来获得好的效果。

2.1.2 训练细节

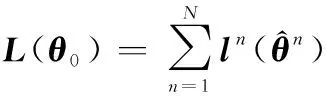

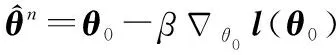

MAML通过多任务的学习,利用梯度下降算法让模型自主学习到一个最好初始化参数,并定义了一个损失函数()来评估所学到的初始化参数的好坏:

(1)

(2)

在不同的任务上进行训练时,按照梯度下降算法进行更新:

(3)

(4)

213 算法流程

用于少样本频谱图像分类任务的MAML算法的元测试过程如算法1所示。

214 与迁移学习的异同

2.2 Meta-learner LSTM

221 基本思想

在学习算法的梯度下降过程中,可以通过让机器自主的学习一些关键部分,使得学习算法可以在经过多个任务的训练之后,能够快速的适应few-shot的新任务。比如,通过学习初始化参数(initialization parameters),MAML和Retpile算法可以找到最适合测试任务的模型初始值,这个初始参数可以使得模型在新的任务上只需要少量数据便可以在支撑集上完成参数更新,并在查询集上取得最优的实验结果。而实际上,我们还可以对学习算法的梯度下降过程直接进行学习,使得模型在训练任务上完成训练之后,可以学到适应于测试任务的参数更新方式。这个更新模型可以仅通过在测试任务上的少量数据就能使算法完成对任务模型参数的快速准确更新,从而使模型在查询集上取得不俗表现。

Meta-learner LSTM学习基于梯度下降的参数更新算法,采用LSTM表示元学习器,用其状态表达目标分类器的参数更新。该优化算法最终学会如何在新的分类任务上,对分类器网络进行初始化和参数更新。同时,模型考虑到了一个任务的短时知识和跨多个任务的长时知识信息,并使用记忆机制保存这种信息。

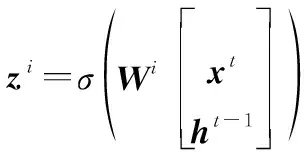

2.2.2 记忆单元和梯度下降

如图3所示,作为记忆模型的LSTM一般由多个cell所构成,每个cell部分都有3个输入、-1和-1。

图3 LSTM的内部运算结构Fig.3 Internal operation structure of LSTM

在时刻,LSTM中的每个cell中都发生以下的输入运算:

(5)

定义输入门:

(6)

遗忘门:

(7)

输出门:

(8)

其中,是各个门的输入权重,tanh和表示门控开关。每个cell同时也都输出3个值、和。其中,是LSTM的输出,是LSTM的各个cell之间的记忆存储部分,是一个中间变量。在时刻,每个cell的输出运算表达为

=⊙-1+⊙

(9)

=⊙tanh()

(10)

=()

(11)

式中:⊙表示点积运算。在梯度下降算法中,每个时刻的参数按照下面的规则进行更新:

(12)

式中:表示更新步长;表示模型的损失函数。

(13)

更进一步的,如果将遗忘门换成1,输入门换成,那式(13)就和式(12)完全一致了。因此,可以将梯度下降算法视为LSTM的简化版,并且在梯度下降算法中也存在输入门和遗忘门,只不过和与一般LSTM中的值不一样,是人为指定的1和学习率,是不需要通过训练去学习到的。

223 学习过程

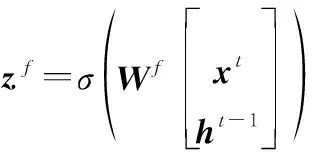

通过对LSTM和梯度下降算法的参数更新过程进行分析比较,元学习方法Meta-learner LSTM希望通过训练让机器自动地学习到动态的输入门和遗忘门,而不是固定不变的值(即学到一种新的优化方法或者说是更新规则),以实现模型参数在少样本学习任务上的快速优化更新来达到好的效果。如图4所示,具体来说,Meta-learner LSTM的训练过程要经过以下几个步骤:

(1) 首先,要给学习算法给定初始值,以及LSTM的输入门和遗忘门的初始值, 在学习过程中称LSTM为元学习者,称整个学习算法为学习者;

(2) 用源域的个训练任务对元学习者进行依次训练,对每个任务取出其支撑集和查询集;

图4 Meta-learner LSTM的训练过程示意图Fig.4 Training process of Meta-learner LSTM

2.2.4 训练细节

输入门在更新过程中,相当于梯度下降算法中的学习率,但是不同于梯度下降算法中恒定不变,在LSTM的学习过程中是动态的调整,使参数快速达到最优。遗忘门的作用相当于一个regularization,它会把前一个时刻算出来的参数进行缩放,而这个缩小的比例也是LSTM在学习过程中不断变化的,而不是在梯度下降算法中的固定值1。这样做是为了防止更新参数时陷于局部最优解中,从而无法做到有效优化。

图5 Meta-learner LSTM的梯度独立性假设Fig.5 Gradient independence hypothesis of Meta-learner LSTM

一般的LSTM中含有多个cell,但在实际的训练过程中,为了简化问题,此时的LSTM只有一个cell,而且所有的学习算法的参数都共用一个LSTM的参数来处理,这样做有以下几个好处:

(1) 合理的设置模型的尺寸和参数数量,使训练更加快速有效;

(2) 此时的LSTM和其他人为设计的参数更新算法(RMSProp、Adam)一样,都是对所有的参数采用相同的更新规则;

(3) 在MAML和Reptile方法中,要求训练模型和测试模型的结构保持一致。但在Meta-learner LSTM方法中,由于所有的参数都用同一个LSTM来更新, 所以训练和测试的模型结构可以不一样。

3 少样本频谱图像分类实验

3.1 数据集介绍

3.1.1 MiniImageNet数据集

ImageNet是一个非常有名的大型视觉数据集,它的建立旨在促进视觉识别研究。ImageNet为超过1 400万张图像进行了注释,而且给至少100万张图像提供了边框。ImageNet包含2万多个类别,比如:“气球”“轮胎”和“狗”等类别,并且每个类别均有不少于500张图像。由于训练ImageNet数据集需要消耗大量的计算资源。因此,在2016年,google DeepMind团队的Oriol等人在ImageNet的基础上提取出了MiniImageNet数据集,并将其用于少样本学习研究,自此MiniImageNet数据集成为了元学习领域应用最为广泛的数据集之一。MiniImageNet数据集包括100类60 000张彩色图片,其中每类有600个样本,每张图片的规格不定,并按照4∶1的比例划分训练集和测试集。

3.1.2 Omniglot数据集

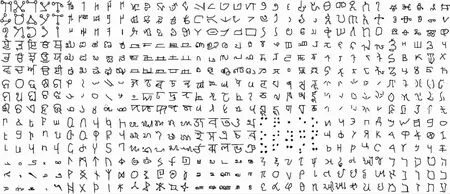

Omniglot数据集也是元学习领域的基准数据集之一,由50多种国际语言和虚构字符集组成的,每种语言都包括15到40多种字母,每个字母都是由20个不同的人通过亚马逊的 Mechanical Turk在线绘制的。总的来说,Omniglot数据集包括1 623种不同类型的字符,每种类型有20张大小为64×64的灰度图片,并按照3:2的比例划分训练集和测试集(见图6)。

图6 部分Omniglot数据集样本Fig.6 Some Omniglot dataset samples

3.1.3 太阳射电频谱数据集

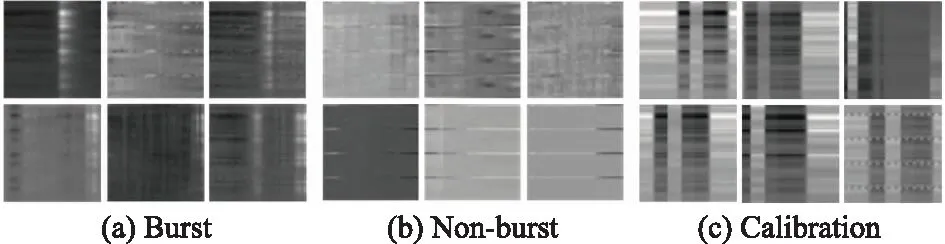

太阳射电频谱数据集中的频谱图像来源于SBRS,SBRS所采集的数据最终可以转换为以采样时间为横轴,以采样频率为纵轴的灰度图像,图像的像素值代表太阳射电的辐射强度。2015年,Chen等人建立了太阳射电频谱数据集,数据集中共有4 408张大小为240×2 520的射电频谱图像。这些图像按照爆发形态被分别3类,其中Non-burst代表图像中不存在太阳射电爆发现象,Burst代表图像中存在太阳射电爆发现象,Calibration类型代表图像受到观测设备等因素的影响需要进一步进行校准,图7展示了太阳射电频谱数据集中的3种类型图像。

图7 太阳射电频谱数据集中的3种类型图像Fig.7 Three types images in solar radio spectrum dataset

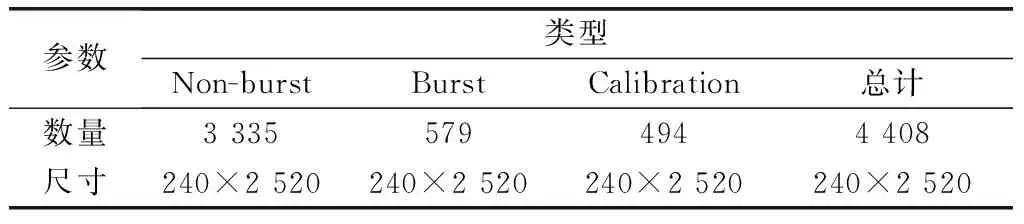

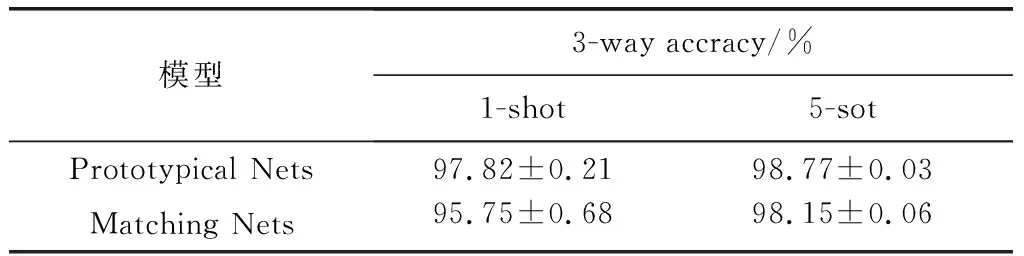

如表1所示,原始的太阳射电频谱数据集存在明显的样本数量不均衡问题,尤其是Calibration类型的图像只有494张,这对于传统深度学习网络来说,很容易造成模型过拟合。为了与元学习任务相匹配,本文对数据集进行了预处理,处理后的射电频谱数据分布如表2所示。

表1 原始频谱数据集样本分布

3.2 实验方案设计

本文将频谱图像的分类问题转换成少样本有监督学习任务,通过元学习方法来提高爆发频谱图像的检测精度。在实验中,采用MiniImageNet数据集和Omniglot数据集作为源域进行元知识的学习,然后将射电频谱数据集作为测试任务的目标域进行知识的迁移,最后通过对比分析验证元学习方法在射电频谱数据集上的有效性。

为了保持源域和目标域的样本形状一致以及为了加速网络训练速度,在输入神经网络之前,将所有样本的大小都缩放到了60×60。其中,MiniImageNet是三通道彩色图像,Omniglot是单通道灰度图像,为了使得各自学到的元知识更好的迁移到射电频谱数据集上,在进行实验时针对不同的源域数据对频谱图像的通道数进行了相应的调整。实验中所用的分类模型是采用4个3×3卷积层、池化层和全连接层构成的网络结构。在元测试阶段,每个任务的支撑集都从源域的数据集中随机选取3类样本,每类样本取1、5或20张图像组成;查询集是每类样本取5张图像进行模型精度检验和参数更新。在元测试阶段,支撑集会在射电频谱数据集中每次取3类样本,每类样本取和源域数据一致的图像数量进行领域迁移和参数更新;查询集是每类取5张图像进行最后实验结果评估,即实验中设置=3,分别取1、5或20,=5。各实验数据集的具体参数如表2所示。

表2 各实验数据集的样本参数

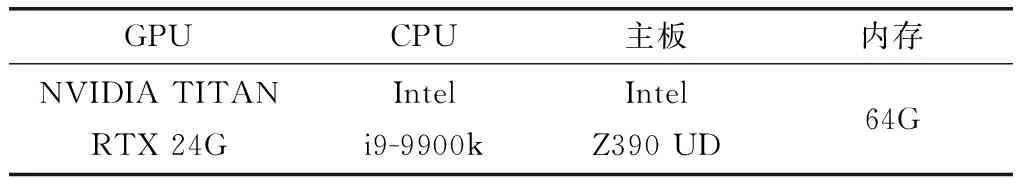

实验中,分别将MiniImageNet数据集和Omniglot数据集作为元学习的源域,将射电频谱数据集作为目标域,进行了多组对照试验。基于MiniImageNet数据集,开展了分别取1、5和20时,5个元学习模型的分类对比实验,并设置迭代次数epoch为1 000;基于Omniglot数据集,开展了分别取1和5时,两个元学习模型的分类对比实验,并设置迭代次数为500;所有实验的查询集数量都为5;实验的硬件环境如表3所示,每个对比实验的具体参数如表4所示。

表3 实验所用的硬件环境配置

表4 各对比实验的具体参数

3.3 实验结果分析

表5和表6分别是MiniImageNet数据集和Omniglot数据集作为源域时,少样本频谱图像的分类精度,从中可以发现:

(1) 在MiniImageNet数据集上,基于优化的元学习方法(MAML、Meta-learner LSTM)在新领域样本的适应度和学习能力要明显强于其他两个基于度量的学习方法(Prototypical Nets、Matching Nets);随着支撑集数量K的增加,每种模型的分类精度都在显著提升;当K 的数量达到20时,Meta-learner LSTM的分类精度反超MAML,达到了最优值91.60%;从表4的各模型参数中可以发现,此时的MAML由于硬件内存条件限制导致学习率和批大小参数未达到最优,从而使得=20时的精度较之=5时没有提升,反而有一些下降。

表5 基于MiniImageNet数据集的少样本频谱图像分类精度

表6 基于Omniglot数据集的少样本频谱图像分类精度

(2) 在Omniglot数据集上,原型网络的精度要普遍高于匹配网络,并且随着支撑集数量的增加,精度明显提高;受限于Omniglot数据集的各类样本数量,Prototypical Nets模型在=5时取得了最优的分类精度98.77%。

(3) 相较于MiniImageNet数据集,Omniglot数据集均为灰度图像且样本特征比较简单,也与射电频谱图像较为相像。这使得在源域学到的元知识可以更加合理的迁移到目标域中,从而可以取得更高的分类精度。

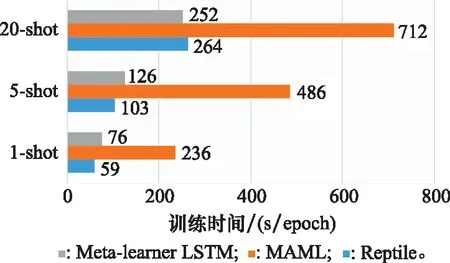

图8和图9分别描述了各个实验的训练过程和在MiniImageNet数据集上的训练时间对比,通过分析比较可以看出:

(1) 相比于度量的元学习方法,基于优化的方法训练过程更稳定,精度震荡更小,但同时Prototypical Nets和Matching Nets的收敛速度却更快。

(2) 因为Omniglot数据集更加简单,学习过程也更为讯速,只需要MniImageNet数据集一半的训练时间就可以达到收敛状态。

(3) MAML是通过对初始参数的学习来快速适应新任务的,因此其训练过程相较于其他基于优化元学习方法更为复杂,所耗费的时间代价也最大;同时,随着支撑集数量K的增加,时间开销呈现翻倍式的增长。

图8 各对比试验训练过程中的精度变化Fig.8 Accuracy changes during the training process of each comparative experiment

图9 各模型在MiniImageNet数据集上的训练时间Fig.9 Training time of each model on MiniImageNet dataset

4 结 论

本文针对少样本射电匹配图像的分类任务,提出了一种基于元学习和迁移学习相结合的分类方法。通过将MiniImageNet数据集和Omniglot数据集作为源域数据,射电频谱图像作为目标域数据,采用基于优化的元学习方法将学习到的源域知识迁移到目标域中,实现对少样本射电频谱图像的分类。通过设计多个对比实验,证明了本文所提出方法的有效性和先进性。