基于深度强化学习的光网络资源分配方法研究

2022-07-09尚晓凯翟慧鹏韩龙龙

尚晓凯 翟慧鹏 韩龙龙

(国家计算机网络与信息安全管理中心河南分中心 河南省郑州市 450000)

1 引言

随着互联网用户和流量的激增,数据中心和电信运营商骨干网网络承载面临着前所未有的压力,通过网络设备扩容来提升骨干网的运载能力,不仅需要大量的物理设备购置、升级等建设成本,还需要考虑庞大的骨干网体系的生存性。弹性光网络(EON)作为新一代全光技术成为重要研究方向,如何提高骨干网的资源使用效率、提升网络可靠性、又灵活的处理各类业务服务效率已成为重要研究方向。

骨干网络的互联技术经过了光电混合组网、波分复用(WDM)技术和EON 等发展阶段。在光电混合组网骨干网互联阶段,电交换由于其能耗、交换容量等因素限制,逐步转变为全光交换发展。WDM 技术原理是通过耦合器将多路波长耦合到一根光纤中进行传输,极大地提升了传输容量,能够满足数据中心之间的大容量业务传输需求,WDM技术凭借其大容量的优势,已被广泛应用于骨干网和城域网中,WDM 光网络在信道之间的最小间隔为50 GHz 或100GHz,当前单个WDM 信道可实现10Gbps、100Gbps、甚至400Gbps 的传输效率。然而,随着数据中心的大量部署和运营商海量数据传输,这时采用固定信道宽度的WDM技术显得力不从心,如图1 所示,固定的栅格和信道间距较大,导致其网络带宽利用率低、灵活性差。

图1: WDM 和EON 频谱分配示意图

EON 是将频谱资源进行更加细化的分割,与传统的WDM 技术相比,它采用正交频分复用技术,将传输的各项业务数据分配到几个低数据速率的子载波上,相邻子载波的频谱又是正交的,所以可以相互重叠,从而极大地提高网络的频谱效率。EON 不仅具有更小粒度的频谱隙,同时EON将多个低速率子载波灵活的分配给网络请求,具有高灵活性的业务传输能力。

EON 最大优势在于可根据业务实际需求分配相匹配的网络资源,尽可能地减少不必要的损耗,资源分配算法是EON 最核心的问题之一,合理有效的资源分配算法不仅可以大大提高频谱资源的利用率,而且提升光网络的传输效率。近年来,一些智能算法也被引入到EON 的资源分配问题上,常见的智能算法有:蚁群算法、遗传算法、机器学习、深度学习等一系列智能算法。智能算法在较大网络规模、较苛刻约束条件等问题上具有较强的适用性。

本文针对弹性光网络的频谱利用率和阻塞率等性能,提出了DQN 资源分配算法,通过构建数学模型,对算法模型进行多次训练,仿真实验表明,该算法具有较好地提高频谱资源利用率,同时降低网络中的业务阻塞率。

2 深度强化学习算法

强化学习是机器学习的重要分支之一,强化学习通过利用代理与环境进行交互,在提供动作的评价反馈的基础上,为不断优化其状态,以获得最大的累积奖励,即通过把实际问题转化为每次新状态与旧状态有关的迭代问题进行数学形式的求解。所以,也可描述为马尔可夫决策过程,其过程主要组成包括:状态空间、动作空间、回报函数以及状态转移概率等。深度强化学习(DQN)是在强化学习的基础上引入深度学习,如图2 所示为DQN 算法流程图。

图2: DQN 算法流程图

2.1 建立网络模型

首先,我们将弹性光网络的拓扑定义成G(V,E,F),V、E 分别是网络节点和链路的集合,F 是每条链路中的频隙,当频隙状态被占用时设置为1,空闲时为0。在状态空间中添加了业务优先级的标志位,因此状态向量可表示为:

其中,o、d、t 分别是业务请求的源、目的节点和业务持续时间,w表示业务请求频谱宽度,p为业务的优先级标志,取值为1 或0。

在动作空间中我们通过KSP 算法为业务找到K 条可用的候选链路,并对每条链路选取J 个可用的候选频谱块,若可用链路数是0 时,代表有业务阻塞,同理J 个频谱块也是如此,那么动作空间大小是K×J。

2.2 深度强化学习算法框架

依据马尔可夫决策过程的概念,强化学习的策略搜索转化为数学问题,其中状态价值函数V(s)在当前状态s时,通过策略π 的积累回报的期望值可表示为:

3 仿真结果与分析

3.1 性能指标

3.1.1 频谱资源利用率

在EON 的资源分配过程中,衡量一个分配方案的有异性指标就是频谱资源的损耗大小,即频谱资源利用率(SU)。SU 公式如下:

3.2 实验与分析

我们以国内典型的CERNET 网络作为实验拓扑进行仿真分析验证,其网络节点数有20 个,边数有22 条,假设每条链路上的频隙数设置为100 个。业务量的设置为业务到达率C 和业务持续时间t 的乘积,即A=C×t,A 代表业务量,单位为Erlang。

同时,假设业务请求达到设置满足泊松分布,每项业务成功建立请求后的持续时间设置服从负指数分布,请求带宽大小在1-5 范围内随机取整数值,源节点和目的节点在实验的网络拓扑的所有节点中随机生成。

在深度强化学习模型中将对未来奖励的衰减值γ 设为0.9,为了能够进行算法性能的比较,我们与传统的FF 算法[进行对比分析,FF 算法是基于最短路径在可用频隙索引号最小的位置建立业务请求,是一种经典的频谱分配算法。在实验中,业务量设为200Erlang,候选路径数K 和候选频谱块的数量J 设置为2,并以此判断业务分配之前需提前训练的次数。经实验,不同算法的分配训练次数与业务阻塞率的关系如图3 所示。

图3: DQN 算法业务分配训练次数

由图3 可以看出: FF 算法在10000 次业务分配后业务的阻塞率逐渐稳定在22.3%左右,DQN 算法在前5000 次业务分配时业务阻塞率呈指数型上升,后慢慢降低,最终在约50000 次业务分配后趋于平稳。据此,后续实验将对QDN算法模型进行50000 次的业务训练的基础上,再对业务分配的性能指标数据进行统计分析。

为了进一步对比分析两种算法的性能,我们对两种算法的频谱利用率和业务阻塞率方面进行评估。其中,基础参数选路径数K=3,每条路径上的候选频谱隙数为J=1。当业务量在50-600Erlang 之间变化时,两种算法进行业务分配时的频谱利用率和业务阻塞率分别如图4 和图5 所示。

图4: 频谱利用率

图5: 阻塞率

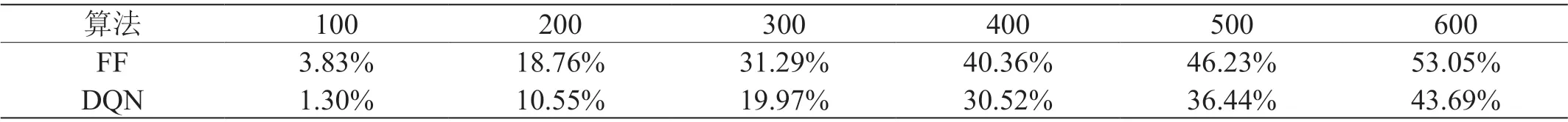

表1 和表2 统计了在业务量为100-600Erlang 时,两种算法模型下实验的频谱利用率和业务阻塞率详细数据。从上述图5 和表2 中可以明显看出,在业务量小于100Erlang时,两种算法的业务阻塞率相差较小,其主要是由于在业务分配初期,网络中频谱资源相对丰富,业务阻塞率也相对较低,但随着业务量的增加,两种不同的算法对频谱利用率和业务的阻塞率就有较大的差距。也就是当设置业务量从100Erlang 到600Erlang 时,DQN 算法的频谱利用率相比于FF 算法分别提升了1.16%、2.46%、2.67%、6.43%、6.06%、8.95%,平均提升了4.62%;在阻塞率方面分别降低了2.53%、8.21%、11.32%、9.84%、9.79%、9.36%,平均约降低了8.51%。因此,DQN 算法的表现优于FF 算法,能够较好地提高频谱资源利用率,降低业务阻塞率。

表1: 频谱利用率

表2: 业务阻塞率

总体来看,本文提出的DQN 算法的光网络资源分配方案始终表现出高频谱利用率和低阻塞率,对其方案的综合性能具有较大提升。这是因为我们提出的方案可以有效地预测业务请求,为未来任一时刻业务接入请求动态保留资源。

4 总结

本文提出了一种基于DQN 的EON 资源分配方案,利用DQN 中强化学习的决策能力和神经网络对特征的感知能力,将频谱分配过程构建成为不同的状态和动作集合,通过不断的训练迭代,将根据输入的环境状态得到最佳的频谱分配模型。在仿真实验中,通过与传统的FF算法进行对比分析,在CERNET 网络拓扑中,DQN 算法相比于FF 算法频谱利用率平均提升4.62%,业务阻塞率平均降低了8.51%。实验结果表明,本文提出的DQN 算法在频谱利用率和阻塞率方面均优于传统的FF 算法,能够更好地应用于弹性光网络的资源分配。