基于RGB-D 数据的笔记本面板表面缺陷检测研究

2022-06-04吴志远陈新度

吴志远,陈新度,2,吴 磊,2

(1. 广东工业大学 机电工程学院,广东 广州 510000;2. 广东省计算机集成制造重点实验室,广东 广州 510000)

0 引言

缺陷检测是工业生产过程中重要的一环,随着制造业的快速发展,自动化和智能化成为当前发展主要趋势之一[1]。利用机器视觉代替人工完成缺陷检测任务,不仅可以降低成本,还可以提高效率和检测准确率。机器视觉在工业缺陷检测的应用主要包括数据采集和缺陷检测两个过程,普遍的方法是通过工业相机和光源搭建采集平台采集2D 图像,利用机器学习或者深度学习方法进行缺陷检测。

但仅通过RGB 图像信息有时候无法对某些缺陷特征进行表达[2,3],如钢轨表面的污渍等假缺陷容易被识别为轧痕而被误判,边缘过渡光滑的鼓包缺陷无明显轮廓而识别不出来等。近些年来随着3D 数据采集设备的发展,深度相机的精度也得到显著提升。通过采集3D 数据进行缺陷检测可以弥补2D 缺陷检测的不足。如徐平等[4]通过结构光对物体表面孔特征进行提取和检测应用。

对笔记本面板表面进行缺陷检测,缺陷类型包括划痕、鼓包、麻点等,其中鼓包和麻点等缺陷通过2D相机难以采集到明显的缺陷特征,若通过深度相机进行数据采集,只能满足对深度空间的缺陷类型的检测,无法识别出划痕等颜色空间的缺陷。而市面上现有的RGB-D 相机,主要应用在行为识别,场景三维重建等领域[5],其中基于双目视觉方案的不适用于表面无明显特征的物体检测,基于飞行时间法和编码结构光原理的深度相机深度图像分辨率较低[6,7],需要后期对深度图进行超分辨率处理[8],都不适用于高精度的缺陷检测。

针对上述难点,通过线结构光三角测量法和错位取值的方法搭建了RGB-D 数据采集平台,在一台相机上同时获取高分辨率的RGB 图和深度图,制作成数据集;并通过基于Swin Transformer 优化的Mask RCNN 深度学习模型对数据集进行训练和检测,满足同时对深度空间和颜色空间缺陷类型的检测要求。

1 基本原理

1.1 激光三角测量法

激光三角测量法原理是通过激光投射到被测物体表面后反射到相机传感器的位置,利用三角形相似原理计算出被测点离相机的距离,从而获取被测物体表面的深度信息。

激光三角测量法分为直射式和斜射式两种[9],两者区别在于激光与被测物体表面的角度,图1 为直射式结构。直射式结构中,激光线垂直于物体表面,相机接收被测物体表面的散射光和漫反射光,直射式优点在于激光照射位置始终处于物体的同一行中,不随物体表面高度变化,适用于表面粗糙度高形状相对复杂的物体。

直射式激光三角法的三角几何关系如下:

由公式1 推出:

其中,L1为物距,L2为相机镜头的焦距。x为被测表面的相对高度,x′为激光在相机靶面的偏移绝对值,x和x′存在正相关关系,可通过x′求得被测物体表面深度信息。

1.2 基于Transformer 的Mask RCNN 网络模型

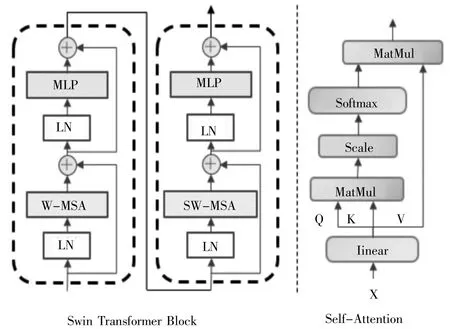

Mask RCNN[10]是二阶段的深度学习框架,第一阶段通过主干特征提取网络RoI 感兴趣区域;第二阶段是对RoI 区域进行分类、定位回归和分割。Mask RCNN 的主干特征提取网络ResNet 同大多数深度学习网络一样属于CNN 网络,存在单层网络无法捕获远距离特征的缺点,需要通过不断堆叠多个卷积层来实现局部信息到全局信息的学习。而Swin Transformer[11]网络基于Attention 注意力机制,从一开始就能实现对全局特征的学习,具有较强的特征学习能力。将Mask RCNN 的主干特征提取网络改为Swin Transformer 能有效提高模型的检测能力。

图2 基于Swin-T 的Mask RCNN 框架

Swin Transformer 网络由Swin Transformer block堆叠而成,主要模块是(S)W-MSA,如图3 所示,MSA通过自注意力Self-Attention[12]实现全局特征学习。

图3 Swin-T block 模型结构

2 RGB-D 数据获取

本方案使用一台彩色相机和线激光发射器,同时采集RGB 图像和深度图像,且要求深度图的分辨率和RGB 图像保持一致,以实现高精度的要求。

2.1 深度信息D 的获取

RGB-D 相机内部负责采集深度图像的一般为红外相机或者在相机镜头前会加装滤光片,滤除激光以外的光源,避免其他光源的干扰,激光中心线提取效果好。本方案设计用一台相机同时获取深度信息和RGB 信息,因为要采集RGB 图像,需要去除滤光片的同时加入光源,这将导致激光的成像质量受到其他光源影响。针对外部光源干扰问题,提出图像通道做差的方法,获取清晰的激光线图像。如图4 所示,(a)为相机采集原图,激光波长为405 nm,蓝色通道图像的激光线最为清晰,提取B 通道可得灰度图像(b)。(b)中沉头孔边缘位置受环境光影响,反射光强烈,像素值较高,直接影响激光中心线的提取效果,如(c)中所示,沉头孔边缘位置被错误的识别为激光线中心。通过对图像的分析,发现激光线位置的强度主要来自405 nm 波段的激光光源,B 通道强度明显高于其他通道;而沉头孔边缘处的高强度来自于其他光源的反射光,三个通道的强度值大致相同。将B 通道和G 通道相减,可消除边缘处反射光的影响,得到清晰的激光图,如(d)所示。最后对(d)进行激光中心线提取,得到准确的提取结果,如图(e)。获取每帧图像的激光中心线的位置后,通过激光三角测量法即可计算出深度信息。

图4 激光中心线提取过程

2.2 彩色信息RGB 的获取

从一帧图像中获取激光位置的深度信息的同时,还需获取该位置的RGB 信息,而激光线位置过度曝光,RGB 信息无法在同一帧中直接获取。本研究采用错位取值的方法,从第k帧图像中获取激光中心线处的深度信息,从(k+n)帧图像中恢复第k帧图像激光中心线处的RGB 信息,n为错位值,取激光线宽2倍。如图5 所示,在第(k+n)帧图像中,虚线位置的RGB 值即为第k帧图像的激光线位置RGB 值。

图5 错位取值法

3 实验分析

3.1 实验平台搭建和精度分析

实验平台采用的600W 像素的CMOS 面阵相机,分辨率为3072*2048,相机靶面尺寸7.18×5.32 mm(1/1.8”),像元尺寸2.4 μm*2.4 μm,镜头焦距12 mm。激光发射器采用线激光器,波长为405 nm,功率200 mW,线宽约0.5 mm。光源采用白色条形光源,直线运动系统采用伺服电机加丝杠方案,采集平台如图6 所示。

图6 RGB-D 数据采集平台

以相机3072 像素方向为X轴,电机直线运动方向为Y轴,激光方向为Z轴。将X轴方向单像素精度定为0.02 mm,则X方向视野应为0.02*3072 = 61 mm。Y轴精度应与X轴一致,所以Y轴的运动速度需要与相机的帧率相对应。当相机帧率为1000 fps,每一帧的采集时间为1 ms,则Y轴每1 ms 运动行程0.02 mm,直线运动速度为20 mm/s。

由公式2 可知,和并非正比关系,故Z轴精度不是常量,Z轴精度取决于图1 中的参数和物距L1。由X轴视野大小可确定物距L1= 104 mm,设定θ=45°,当x′=2.4 μm(1 个像元尺寸)时,x= 29 μm,在基准平面上方,Z轴单像素精度高于0.029 mm。

3.2 相机系统参数标定

由于数据采集平台搭建过程中存在安装误差,系统参数L1和无法保证绝对准确,故需要对系统进行标定。由公式2 有:

其中,L2是相机焦距,相机安装角度θ和物距L1是存在安装误差,令:

可得:

k1和k2为系统参数,标定时通过标准块测得两组值(x,x1′),(x,x2′),带入公式5 中可求得k1和k2,即可得到x和x′的数量关系。

3.3 数据集制作与缺陷检测

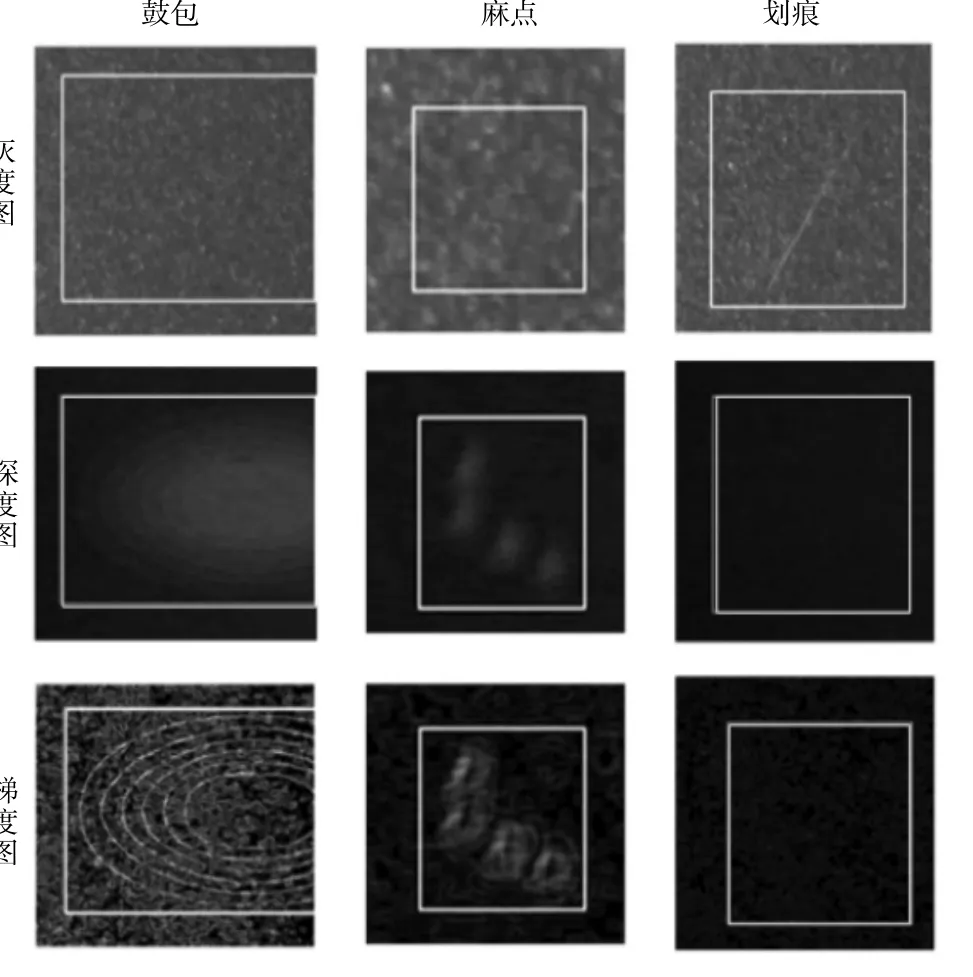

完成平台搭建和标定后,对笔记本面板进行数据采集,得到RGB 图像和深度图像。将RGB 图像转换成灰度图像,并求取深度图像的梯度图,如图7 所示,将灰度图、深度图和梯度图合并成三通道图像作为深度学习网络模型的输入数据。

图7 数据集图像对应的三个通道

从图7 中可看出,鼓包和麻点缺陷虽在灰度图像上特征不明显,但深度图和梯度图上能观察到明显特征;而划痕虽然也具有深度信息,但因为划痕宽度极小,深度信息难以采集,故仅在灰度图上有明显特征。

将采集的图像数据进行整理,减少训练时内存的消耗,将图像分割成512 × 512 大小,并标注缺陷标签,制作成数据集,最后对数据集进行训练和测试。

实验对比了传统Mask RCNN 和基于Swin Transformer 的Mask RCNN 算法,缺陷检测结果见表1。三种缺陷的平均检测精度达到86.5% mAP,说明采集平台采集的多种缺陷特征能够被有效的检测识别。基于Swin-T 的Mask RCNN 模型检测效果得到提升,mAP 提升了9.5%,检测效果更好。尤其是针对大目标,APL提升了13.3%,也说明了Transformer 全局学习能力的优势。

表1 Mask RCNN 模型缺陷检测结果

4 结语

搭建了的RGB-D 数据采集平台,在61 mm 视野时,X、Y轴方向单像素精度为0.02 mm,Z轴方向精度高于0.029 mm。使用此平台对笔记本面板进行RGB-D 数据采集,并制作成数据集进行缺陷检测。经实验,该数据采集平台能有效采集笔记本面板上深度空间的缺陷类型(鼓包、麻点)和颜色空间的缺陷类型(划痕)的缺陷特征。利用深度学习方法对笔记本面板表面进行缺陷检测,平均检测精度mAP 达到86.5%,满足对笔记本面板表面的缺陷检测要求。