基于卷积神经网络的机器人视觉地点识别分析

2022-05-30高振怀

高振怀

摘要:针对传统移动机器人视觉位置识别容易受环境影响、效率低等问题,文章提出了基于卷积神经网络(CNN)的机器人视觉地点识别技术。结合CNN的网络结构设计图像描述提取方法,旨在提升提取图像特征鲁棒性;通过构建公开数据集离线训练视觉词袋模型,提升图像匹配过程的搜索速度;通过对两幅图像相似度的分析,获得视觉地点识别的匹配结果。研究结果证明,基于CNN的机器人视觉地点识别在场景外观变化下地点识别鲁棒性、准确性均较传统方法好。

关键词:卷积神经网络;机器人视觉;地点识别;鲁棒性;图像描述符提取

中图分类号:TP18 文献标识码:A

文章编号:1009-3044(2022)29-0012-04

作为移动机器人核心技术,视觉地点识别主要指的是借助图像识别对图像中位置进行判断,并明确是否为机器人到过地点的过程,其在机器人领域有着广泛的应用,常见包括SLAM闭环检测、重定位等。近年来研究发现,机器人视觉地点识别的精准度会受到光照、季节等外界环境因素的影响,因此,如何保障在不断变换的场景外观下获得较好的鲁棒性成为相关领域的研究重点[1]。

传统机器人视觉地点识别多是通过SURF、SIFT等图像局部特征,与视觉词袋模型相结合,能够反映出图像的细节,在平移变换状态下仍具有较好的鲁棒性,但其对于光照、天气等因素较为敏感,限制了其在不同应用场景的推广,且提取特征多采用的是手工特征提取,容易出现图像信息缺失,对匹配结果造成影响[2]。基于此研究提出了卷积神经网络(CNN),其在大量数据中对特征表示进行学习,采用逐层提取的方式,具有一定的抽象性,語义信息丰富,较传统手工设计体现出鲜明的优势。以往有学者在研究中提出CNN下图像匹配算法,应用Alexnet网络,对网络中间层特征进行提取,经过相似性矩阵计算,结果显示该算法在光照条件下特征匹配改善明显,但对于季节、视角变化鲁棒性改善效果不佳[3]。针对其不足,本研究设计了CNN图像描述提取方法,应用于位置识别算法,体现了鲜明的优势。

1 实验模型

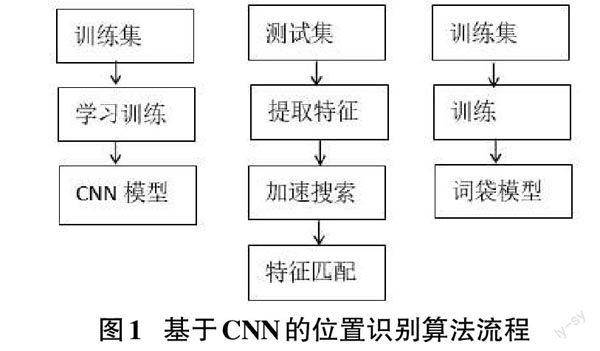

基于CNN机器人视觉地点识别算法流程见图1,其主要包括训练与测试两个方面,前者主要涉及到CNN、视觉词袋模型,后者包括图像特征提取、视觉词袋模型加速、图像匹配计算。

1.1 CNN结构

作为多层神经网络,CNN由卷积层、池化层、全连接层构成,其中卷积层主要功能为卷积运算,其能够强化原始图像特征,最大程度上降低噪声的影响;池化层可针对卷积层输出实施降维处理,使得计算量得到优化,提升计算效率,避免出现过拟合[4]。全连接层在CNN中承担的是分类器作用,在样本标记空间对“分布式特征表示”进行映射。

1.2 CNN模型的构建

此次研究在开源深度学习框架下对CNN图像特征进行提取,其将场景作为中心,囊括了200多个场景类别,图像数量多达250万幅,均来源于Places数据集。模型经过预先训练,将其作为全局图像描述发生器,对CNN全局图像描述符进行提取,经过重构获得CNN结构图(图2)。

该模型预训练后获得了网络模型VGG16-hy-brid365,属于VGG16网络模型,主要由13层卷积层、5层最大池化层与3层全连接层构成,与其他网络相比,VGG16能够将 大卷积进行核分,使其成为2~3个小卷积核,其能够在一定程度上使网络参数数量减少,当5×5卷积核被拆分为两个3×3卷积核后,可以发现其参数由原有的25个变为18个,不仅如此该算法还能够促进网络非线性程度的增加。

假设在图片上随机选择一个模型输入样本,如227×227的patch,第一个卷积层滤波器(11×11)数量为96个,卷积步长为4,函数激活状态下需要输出规格为55×55特征图共96个。CONV1、CONV2、CONV5分别与最大池化层连接,可以发现其Kernel均为2,池化步长参数为2。当提取到最大池化层图像特征后,需要对其进行降维处理,对其赋予对应特征转换,其构建抽象表达实际上是通过对低层局部信息的融合实现的,需要在近邻窗口局部实施。经过函数激活,卷积结果会被作为下一个卷积层完成输入[5]。最后的卷积层滤波器参数为13×13,数量共256个。需要注意的是每个滤波器均需要与其输入的MAP连接,然后为全连接层,每个全连接层之前的神经元均与当前层神经元相连。通过对CNN特征的提取,对其实施标准化处理,可表示为:

[X^=X-μxσx] (1)

其中X表示的是CNN不同层输出的原始特征向量,X的均值采用[μx],标准差采用[σx]。经过计算能够对位置图像进行查询,获得数据库中位置图像余弦距离,为位置识别提供参考。

2 基于CNN图像描述符的提取

通过卷积、池化等相关操作,能够获得包括多个层级在内的特征向量,其中低级特征位于最底层,多见于边缘与角点位置等。当网络层数增加后,所提取的特征抽象性会得到加强,输出内容呈现出语义特征,涵盖了图像的类别信息。在图像分类及物体检测等各个领域均可见语义特征的应用。本研究为获得相同位置场景,采用的是中间层特征,具有一定的抽象性,其能够对场景外观变化状态下的位置识别鲁棒性起到提升作用,且在资源节约方面具有一定的优势[6]。基于VGG16-hy-brid365网络模型,研究提出CNN下图像描述符,其提取方式如下:多个特征图共同构成了CNN的每一层输入,将其表示为:

[X=x(i,j)1≤i≤m,1≤j≤n] (2)

其中,量为m×n×c,各个特征图的尺寸采用m×n表示,特征图个数表示方法为c,基于此,x(i,j)指的是其在(i,j)的位置,假设矢量维度为c,那么其在CNN某一层能够获得m×n个相同的适量,其可以作为输入图像描述符。再如CONV4-3层能够输出特征图共512个,其尺寸为28×28,那么可以获得28×28个图像描述符,其维度均为512。

通过上述网络模型,可以发现图像描述符不急可作为输入图像局部描述,又可以作为感受野全局描述符,兼具局部与全局,体现整体属性的同时能够反映出局部细节,其特征提取流程如图3所示。

3 基于CNN视觉词袋模型的构建

研究在对CNN特征视觉词袋模型实施离线训练时引入了数据集Bovisa,词袋模型选择手工特征的DBOW2,先完成图像描述符进行提取,然后采用k-means法聚类描述训练图像,获得树形结构,可以发现叶子节点以外的节点均存在10个子节点。

视觉词袋模型在进行位置识别时能够对当前图像相似的候选图像进行搜索,防止出现大量的图像匹配,增加工作量,可提升识别与计算的速度[7]。经过离线训练的词袋模型结构特殊,每个叶子节点对应有离线权重,能够对其能力进行区别。随着离线权重的增加,节点区分图像的能力会得到进一步增强,其计算公式如下:

[idf(i)=logNni] (3)

其中离线权重采用idf(i)表示,所有图像数采用N表示,叶子节点i图像数用n[i]表示。

在测试环节,首先将一幅图像输入,根据研究设计的特征提取方法完成多个图像描述符的提取,到达词袋模型叶子节点后,对其在图像中的权重进行计算,计算方法为出现频率与离线权重的乘积[8~9],可以在叶子节点对图像ID、权重进行存储,作为反向索引,其权重公式如下:

[tf(i,It)=niItnIt] (4)

[vit=tf(i,It)×idf(i)] (5)

叶子节点用i表示,其在图像It中出现的频率采用tf(i,It)表示,出现的次数采用niIt表示,描述符总数采用nIt表示。

计算图像的所有描述符,能够获得其对应叶子节点图像的权重,其形成了图像的描述符向量,采用vt表示。在图像匹配环节,仅需要针对相同叶子节点的图像予以匹配,其相似度公式为

[s(v1,v2)=1-12v1v1-v2v2] (6)

可以发现,公式分数值越高表示图像的相似度越高。

4 实验结果分析

将基于CNN机器人视觉地点识别方法与基于传统手工特征的识别方法(SURF、BRIEF)进行对比。实验环境如下:工作站处理器Intel Xeon E5-2650 v3,实验在Ubuntu环境下进行,选择Caffe框架和C++编程语言实现程序。

4.1 性能分析

为完成性能对比试验,针对每组数据集均在两种不同条件下位置设置对应图像,两组分别作为搜索头像与数据库建立应用图像,两者对应的地点相等,表示其匹配結果真实。针对数据集中相邻帧相似度高的问题,研究提出容忍度概念,即在认可的容忍度范围内,可判断匹配结果为成功[10]。在实验环节,需要对每一幅搜索图像与数据库中图像的相似性进行计算,其能够为图像匹配提供可靠的参考。研究引入匹配比率作为实验结果判断标准,具体如下:

[F(r,k)=i=1nj=1kI(zij∈Si(r))/nk)] (7)

[Si(r)=xi-r,xi-r+1,...xi...xi+r-1,xi+r] (8)

n与k分别表示的是图像数(搜索图像/数据库图像)、匹配分数最高图像数量,容忍度用r表示,第i幅搜索图像与数据库对应的第j大的图像用zij表示,在容忍度r条件下,第i幅搜索图像对应的图像采用Si(r)表示,第i幅图像表示方法为xi。

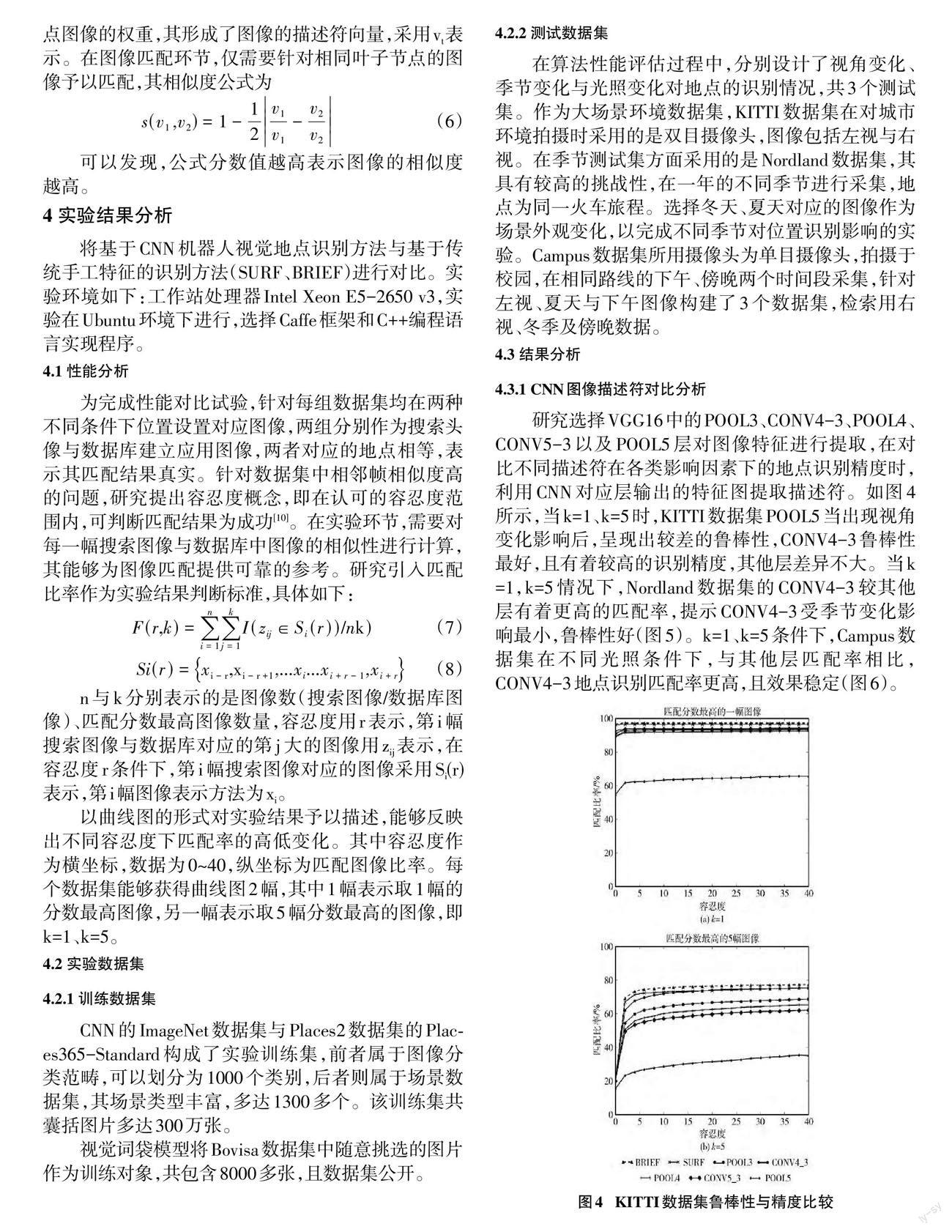

以曲线图的形式对实验结果予以描述,能够反映出不同容忍度下匹配率的高低变化。其中容忍度作为横坐标,数据为0~40,纵坐标为匹配图像比率。每个数据集能够获得曲线图2幅,其中1幅表示取1幅的分数最高图像,另一幅表示取5幅分数最高的图像,即k=1、k=5。

4.2 实验数据集

4.2.1 训练数据集

CNN的ImageNet数据集与Places2数据集的Places365-Standard构成了实验训练集,前者属于图像分类范畴,可以划分为1000个类别,后者则属于场景数据集,其场景类型丰富,多达1300多个。该训练集共囊括图片多达300万张。

视觉词袋模型将Bovisa数据集中随意挑选的图片作为训练对象,共包含8000多张,且数据集公开。

4.2.2 测试数据集

在算法性能评估过程中,分别设计了视角变化、季节变化与光照变化对地点的识别情况,共3个测试集。作为大场景环境数据集,KITTI数据集在对城市环境拍摄时采用的是双目摄像头,图像包括左视与右视。在季节测试集方面采用的是Nordland数据集,其具有较高的挑战性,在一年的不同季节进行采集,地点为同一火车旅程。选择冬天、夏天对应的图像作为场景外观变化,以完成不同季节对位置识别影响的实验。Campus数据集所用摄像头为单目摄像头,拍摄于校园,在相同路线的下午、傍晚两个时间段采集,针对左视、夏天与下午图像构建了3个数据集,检索用右视、冬季及傍晚数据。

4.3 结果分析

4.3.1 CNN图像描述符对比分析

研究选择VGG16中的POOL3、CONV4-3、POOL4、CONV5-3以及POOL5层对图像特征进行提取,在对比不同描述符在各类影响因素下的地点识别精度時,利用CNN对应层输出的特征图提取描述符。如图4所示,当k=1、k=5时,KITTI数据集POOL5当出现视角变化影响后,呈现出较差的鲁棒性,CONV4-3鲁棒性最好,且有着较高的识别精度,其他层差异不大。当k=1,k=5情况下,Nordland数据集的CONV4-3较其他层有着更高的匹配率,提示CONV4-3受季节变化影响最小,鲁棒性好(图5)。k=1、k=5条件下,Campus数据集在不同光照条件下,与其他层匹配率相比,CONV4-3地点识别匹配率更高,且效果稳定(图6)。

综合上述不同数据集的研究结果,可以发现,当发生视角变化、季节变化及光照变化,CONV4-3均表现出鲜明的优势,考虑CONV4-3层厚网络,在图像描述符提取方面进行了精简处理,减少了提取图像的数量,对地点识别效果产生了明显的影响。处于CONV4-3前的层图像描述符质量低,且仅含有少量的语义信息,以CONV4-3层提取效果最佳,因此可以将其作为地点识别算法的描述符。

4.3.2 CNN法与传统视觉地点识别方法对比分析

研究选择CNN下的CONV4-3层图像描述符,将其与手工设计特征SURF进行对比,可以发现两者在视角变化条件下能够达到相近的效果。当出现季节与光照变化因素时,场景外观发生改变,SURF算法表现得敏感,CNN描述符的地点识别算法具有较好的鲁棒性与精度。

5 结束语

综上所述,CNN下的图像描述符地点识别算法经过预训练,提取图像描述符,能够反映局部感受野区域图像的全局描述,且具有语义信息,其中CONV4-3层描述符在不同场景变化中均呈现出较好的鲁棒性与精度,效果稳定,具有一定的推广价值。

参考文献:

[1] 朱明秀.采摘机器人水果检测及定位研究——基于图像处理和卷积神经网络[J].农机化研究,2022,44(4):49-53.

[2] 熊勋,尹玲,陈新度,等.基于卷积神经网络的机器人象棋识别与视觉定位算法设计[J].东莞理工学院学报,2019,26(5):104-109.

[3] 辛菁,姚雨蒙,程晗,等.基于卷积神经网络的机器人对未知物体视觉定位控制策略[J].信息与控制,2018,47(3):355-362.

[4] 马倩倩,李晓娟,施智平.轻量级卷积神经网络的机器人抓取检测研究[J].计算机工程与应用,2020,56(10):141-148.

[5] 仉新,张禹,苏晓明.基于四元数卷积神经网络的移动机器人闭环检测[J].中国惯性技术学报,2019,27(3):357-365.

[6] 张顺,龚怡宏,王进军.深度卷积神经网络的发展及其在计算机视觉领域的应用[J].计算机学报,2019,42(3):453-482.

[7] 田应仲,刘伊芳,李龙.融合卷积神经网络的核相关滤波视觉目标跟随算法研究[J].计算机测量与控制,2020,28(12):176-180.

[8] 赵德安,吴任迪,刘晓洋,等.基于YOLO深度卷积神经网络的复杂背景下机器人采摘苹果定位[J].农业工程学报,2019,35(3):164-173.

[9] 朱斌,陈磊,邬金萍.基于改进卷积神经网络结构的机器视觉室内定位算法[J].国外电子测量技术,2021,40(1):58-64.

[10] 于乃功,魏雅乾,王林.基于卷积神经网络的仿鼠脑海马结构认知地图构建方法[J].模式识别与人工智能,2020,33(1):50-58.

【通联编辑:张薇】