基于眼动指标的飞行员注意状态识别可行性研究

2022-05-29张益凡王宇超张琴喻葛贤亮徐杰

张益凡 王宇超 张琴喻 葛贤亮 徐杰

摘要:在未來高度自动化的飞行器中,飞行员的作业将以监控任务为主,飞行员注意状态的实时检测和干预技术是保证飞行安全的重要基础性技术。本文采用心理学的缓发持续操作任务(GradCPT)试验范式和眼动追踪技术,探索采用眼动指标来识别飞行员注意状态的可行性。试验招募了30名被试验者,分别完成约30min的GradCPT任务,同时利用眼动仪收集眼动数据。根据被试验者作反应时的特征,被试验者在试验过程中的注意状态被划分为“专注”和“非专注”两种状态。眼动数据显示,瞳孔大小的平均值和变异性、扫视持续时间、扫视峰值速度以及注视持续时间均随注意状态的波动而发生显著的变化。该结果表明,通过眼动追踪技术来识别人的注意状态是可行的。未来的研究可以通过机器学习的方法,以眼动指标作为输入特征,构建针对飞行员的注意力实时监测系统。

关键词:人机工效;人机交互界面;航空人因学;持续注意;缓发持续操作任务

中图分类号:V223+.1文献标识码:ADOI:10.19452/j.issn1007-5453.2022.04.006

基金项目:航空科学基金(20185576005)

在航空领域,微电子技术和计算机系统的迅速发展使得飞机驾驶场景中飞机的自动化水平越来越高,这促使飞行员的工作内容从以手动操作任务为主,转变为以监视任务为主、适时干预为辅[1-2]。虽然这些技术将飞行员从繁杂的手动操作中解放出来,大大减少了体力支出,但对脑力需求却越来越高,飞行员需要对驾驶舱内的仪表进行持续的实时监控[3]。飞行员获取监控任务信息的主要途径是与人机界面进行交互,而对于无人机操作员来说,他们的岗位缺乏空间物理反馈,对仪表持续监控的需求更为突出。人因工程的研究表明,不良的人机界面设计会影响无人机驾驶员的驾驶状态[4],是飞行安全事故发生的诱因之一[5]。因此,深入研究无人机驾驶中人的因素,优化人机交互过程是提升航空系统安全的主要手段之一。美国国家航空航天局(NASA)的航空安全报告系统数据库显示,77%自动化驾驶事故的发生与飞行员的注意力下降有关[6]。早期研究也证明,注意力的下降会导致监控自动化系统的任务绩效降低[7]。最近的研究同样证明,在持续时间较长的无人机驾驶任务中,注意力相关任务的绩效不断下降[8]。现代人机交互设计强调人与机器的双向识别与干预[9]。因此,在人机系统中加入对飞行员注意状态的实时识别与干预的功能,有助于提升航空系统的安全性。

1研究背景

人的注意有信息的选择与过滤(选择性注意)和认知加工的维持(注意分配和持续注意)两大功能[10]。在注意对认知加工的维持方面,以往很多研究已经探讨了注意分配对飞行绩效的影响。注意分配主要与飞行任务的具体要求和目标有关,研究发现飞行员可以通过训练习得有效的注意分配策略[11]。除了执行任务,飞行员需要实时监视自动化界面并将注意在相对较长的一段时间内保持在某单一客体或活动上。因此,持续注意是维持飞行员监视的绩效的必要能力。然而,现有文献对飞行员持续注意的研究较少。相比于注意分配易受到任务和环境因素的影响,持续注意还会受到个体本身状态的影响,如走神或无聊[12]。如果智能系统可以通过行为或神经生理指标来实现对个体注意状态的实时监测,并提供相应的反馈与干预,就可以帮助个体及时调整注意状态,提高监控任务的绩效。

对于持续注意状态的实时监测系统的实现,人因工程的一种研究思路是在试验中诱导被试验者呈现出不同的注意状态,收集与注意状态相关的行为或神经生理指标,构建以这些指标作为输入的状态识别模型。

用于研究持续注意的心理学试验范式可以概括为两大类:(1)被试验者监控某界面并对界面中不频繁出现的刺激做出反应,如时钟测试;(2)被试验者监控某界面并对界面中频繁出现的刺激做出反应,抑制自己对不频繁出现的刺激做出反应,如持续操作任务(continuous performance test, CPT)。

在CPT任务范式基础上,研究人员开发出了缓发持续操作任务(gradual onset continuous performance task, GradCPT)[13]。“缓发”是指每一个刺激相继呈现过程中,通过规律性改变刺激的透明度来实现相邻两个刺激的过渡,以消除刺激突然出现时无意识注意带来的影响。该试验范式中,研究人员关注整个试验过程中被试验者反应时间的变异性,以较高的时间分辨率来追踪个体的持续注意状态。试验过程中被试验者会出现注意状态的波动,该范式可以基于反应时的时间进程变异性(variance time course, VTC)来模拟注意状态的波动,将注意状态被划分为:“专注”状态(in the zone),一种稳定的、高准确度的注意状态;“非专注”状态(out of the zone),一种不稳定且倾向于犯错的注意状态,个体的持续注意在这两种状态之间不断波动[14](“专注”与“非专注”状态是根据试验情境由操作定义得出的,区别于传统的专注与非专注)。以往研究表明,相比于“专注”状态,被试验者在“非专注”状态下表现出更高的虚惊率(信号检测论中的指标,表示人对不该做出反应的刺激错误地做出了反应的频率)、漏报率(信号检测论中的指标,表示人对应该做出反应的刺激错误地没有做出反应的频率)和更低的d′(信号检测论中的指标,表示人能成功分辨不同的刺激的程度,d′越大表示分辨能力越强),但是两种状态下的反应时或判断标准β(信号检测论中的指标,表示人在不确定情况下是否对刺激做出反应的主观阈值,β=1时表示判断标准不严格也不放松,β越大表示判断标准越严格)不存在差异[13,15]。总的来说,GradCPT是能够引导出不同的持续注意状态的实验范式,可以用于注意状态识别与预测建模所用的标签与输入特征数据的收集。

本研究的目的是利用GradCPT试验范式,诱导被试验者呈现“专注”和“非专注”两种注意状态,以探究采用眼动指标来识别飞行员注意状态的可行性。本研究分为以下两步。

(1)使用GradCPT试验范式,诱导被试验者出现不同的注意状态

根据以往研究结果[13, 15-16],如果GradCPT是有效的,结果将符合以下假设。假设1:“专注”和“非专注”状态下,平均反应时没有显著差异。假设2:“专注”和“非专注”状态下,判断标准β没有显著差异。假设3:“专注”状态下的d′显著大于“非专注”状态下的d′。假设4:“专注”状态下的虚惊率显著低于“非专注”状态下的虚惊率。假设5:“专注”状态下的漏报率显著低于“非专注”状态下的漏报率。

(2)探究眼动指标如何随注意状态的波动而变化

以往航空人因工程领域的眼动研究中,眼动指标多数与视点所在兴趣区(area of interest, AOI)相关[17-19];这些指标存在以下局限性:首先,对于人机界面AOI而言,AOI与界面设计密切相关,因此,在特定机型下划分的AOI不能在其他机型下直接使用,降低了相关眼动指标的通用性;其次,在飞行器中要实时识别飞行员所注视的AOI有较大的技术难度,如需要采用眼镜式眼动仪的前置摄像头,通过计算机视觉的方法对AOI进行识别,这可能提高注意状态识别系统的运行要求或降低其工作效率。因此,本研究将集中探索与AOI不相干的眼动指标与持续注意状态的相关关系。

2试验方法

2.1被试验者

本文招募了30名来自浙江大学的学生作为被试验者(共招募33人,其中3人被剔除,男生和女生各15人,年龄范围为20~29岁,平均值为24.3,标准差为2.4)。招募要求被试验者健康状况良好,矫正视力4.8及以上;无精神疾病或其他可能影响精神状态的疾病,无精神类药物服用史,试验当天未饮用含酒精或咖啡因饮品;试验前一天睡眠时间不小于6h;无烟瘾、酒瘾等物质依赖史。以上标准在试验前由试验主持检查确认。本研究方案获得了浙江大学心理科学研究中心伦理委员会的批准。

2.2任务和设备

缓发持续操作任务(GradCPT)。基于MATLAB开发的试验程序,试验材料包含两类圆形灰度图,分别是城市风光和山地景色(各10张),图1为“城市”和“山”的图例。在试验任务中“,城市”和“山”分别以90%和10%的概率随机呈现,相邻试次不会重复呈现同一张图片。前一张图片到下一张图片的切换通过透明度的渐变来实现,相邻图片的过渡期为800ms。例如,第一个800ms内,第一张图片的透明度从0(完全清晰)渐变为100%(完全透明),第二张图片的透明度从100%渐变为0;下一个周期内,第二张图片的透明度从0渐变为100%,第三张图片的透明度从100%变为0,依此类推。除每组正式试验中的第一张图片外,其余每张图片的透明度是从100%渐变到0再渐变到100%,跨越两个周期,共计1600ms。任务要求被试验者看到“城市”(90%)按空格键,看到“山”(10%)不做按键反应。

(1)眼动仪

试验中使用的是Eyelink 1000 Plus型眼动跟踪系统(SR Research, Ottawa, Ontario, Canada),该设备采样率为1000Hz。试验时要求被试验者坐在显示器前方,头部通过头托固定,使眼睛水平距离电脑屏幕60cm。

(2)问卷工具

使用NASA任务负荷指数(TLX)测量自我报告的工作负荷[20],采用邓迪压力状态问卷(dundee stress state questionnaire, DSSQ)测量压力,并且计算该问卷中任务投入、压力和担忧三个因素的得分[21]。

2.3试验过程

被试验者到达实验室后,需要先阅读并签署知情同意书。试验正式开始之前,被试验者需要坐在屏幕前,调整座椅高度与腮托(用于固定下巴,保持眼睛与屏幕中央达到要求距离),之后进行眼睛的校准。完成校准后,呈现试验指导语,要求被试验者大概了解试验流程并熟悉全部20张试验使用的图片(被标记为“城市”和“山”的图片),然后被试验者需要进行2min的练习以掌握任务要求,之后试验正式开始。试验共包含三组正式试验,每组时长为8min,两组试验的中间有2min休息时间。第三组试验结束后,被试验者需要填写NASA任务负荷指数量表和邓迪压力状态问卷,以评估试验期间的工作量和压力的大小,试验流程如图2所示。

2.4行为指标和眼动指标

研究中的行为指标包括反应时、时间进程变异性(variance time course, VTC)、虚惊率、漏报率、d′和判断标准β。反应时的详细计算方法遵照Esterman等[13]的研究。VTC是度量反应时可变性的指标,对于每一个被试验者来说,将其所有的反应时转化成对应的z分数(即标准分数),每个试次与其总体平均反应时的绝对偏差则为VTC值。虚惊率(commission)是指一段时间内,对“山”按键反应的次数与“山”出现总次数的比值。漏报率(omission)是指一段时间内,未对“城市”按键的次数与“城市”出现总次数的比值。d′和判断标准β的计算参照信号检测论[22]。图3展示的是根据试验情境对反应结果的估计,以下是本试验中部分变量对应的公式

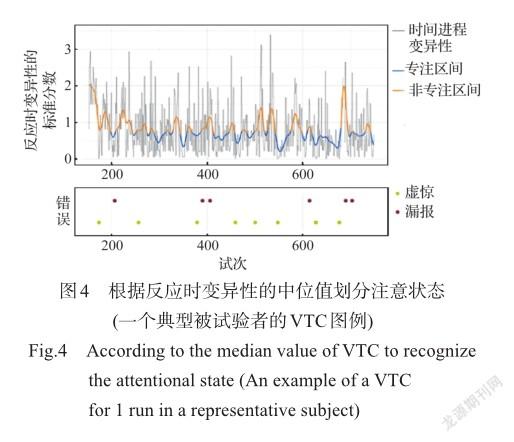

本文定义20个试次(或者说16s)为一个时间窗口,对每組试验内VTC时间序列进行高斯核平滑处理,基于此再来定义“专注”状态和“非专注”状态(in-the-zone, I; outthe-zone, O)。对于“专注”和“非专注”的状态划分I/O标准包括以下两种:(1)以平滑处理后VTC(每组内)的中位数值为划分标准,低于中位数的状态划分为“专注”,高于中位数的状态划分为“非专注”,两种状态的时间状态的比率(I/O)为1,图4展示的是该划分标准下的注意状态。(2)以平滑处理后VTC的75%的四分位数值为划分标准,两种状态的时间状态比率(I/O)为3,“专注”状态的时间状态是“非专注”状态的三倍。研究中的眼动指标包括瞳孔大小、瞳孔大小变异性(一段时间内瞳孔大小的标准偏差)、扫视频率(眼睛在一段时间内在点间快速移动的次数)、扫视幅度(一段时间内扫视点的平均距离)、扫视峰值速度(一段时间内扫视的平均峰值速度)、扫视时间(平均扫视时间)、注视频率、注视持续时间、眨眼频率、眨眼持续时间。除了瞳孔大小变异性、扫视/注视/眨眼频率外,对每个被试验者的其他眼动指标进行标准化处理。

2.5数据统计

三名被试数据被剔除,两人因设备问题数据采集失败,一人因瞳孔数据异常。30名被试验者的行为数据和眼动数据合理有效,反应时、正确率和瞳孔大小等指标均在±3个标准差之内。

为了探究可能存在的组间效应和被试验者间差异,使用线性混合效应(linear mixed effects, LME)模型对数据进行拟合。所有的数据分析都在R中进行(版本3.6.2)[23],采用lme4插件进行模型拟合,并通过afex插件使用KenwardRoger近似估计获取自由度,以进行显著性检验[24]。

3试验结果

3.1基于行为指标的注意状态分类

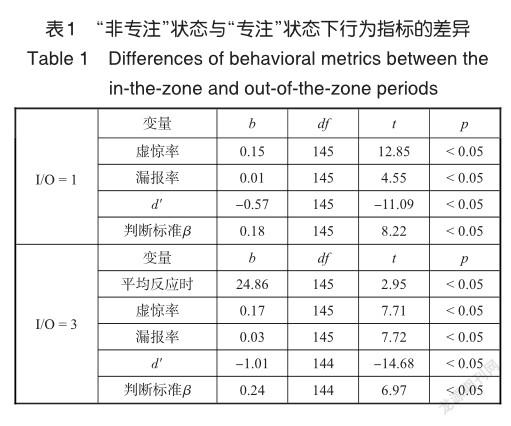

与前人研究保持一致,I/O = 1的划分标准用于假设检验,在单个试验组水平上进行统计分析。例如,在一组内分别计算“专注”状态和“非专注”状态的平均反应时。结果显示,相比于“专注”状态,“非专注”状态的虚惊率和漏报率更高,d′更低。两种注意状态下平均反应时的差异不显著,但是判断标准β的差异却显著。因此除假设2外,其他假设均得到支持。

当I/O = 3作为划分标准时,除了“非专注”状态的平均反应时显著慢于“专注”状态外,其他结果与I/O = 1时非常相似,“非专注”状态比“专注”状态具有更高的虚惊率和漏报率,更低的d′和更高的判断标准。

不同的试验组之间唯一发生显著变化的行为指标是平均反应时,具体来说,第一组的平均反应时最快(b=-29.22, t (145) = -3.27, p < 0.05),而第二组显著快于第三组(b =-24.67, t (145) = -2.39, p < 0.05)β,结果见表1。

NASA任务负荷指数得分与平均反应时之间呈显著正相关(b=1.90, t=3.12, p < 0.05),邓迪压力状态问卷得分与任何行为数据之间均不存在显著的相关关系。

3.2不同注意状态下的眼动模式

不同的试验组之间多个眼动指标发生显著变化:瞳孔平均大小逐渐减小,瞳孔大小变异性逐渐升高,扫视频率升高,扫视持续时间延长,扫视峰值速度加快,注视频率升高,注视时间缩短,眨眼频率升高,眨眼持续时间延长,结果见表2。

当I/O = 1作为划分标准时,瞳孔大小的平均值和变异性在两种状态下差异显著:相比于“专注”状态,“非专注”状态下瞳孔大小的平均值更小,而且瞳孔大小的变异性更高。同时,在整个试验进程中,瞳孔大小逐渐变小(F (2,174) = 21.66, p < 0.05),而瞳孔大小变异性逐渐增大(F (2,145) = 16.07, p < 0.05),结果见表3。

当I/O = 3作为划分标准时,瞳孔大小的平均值和变异性的情况与I/O比值为1时相似。“非专注”状态下瞳孔大小的平均值和变异性的情況与I/O比值为1时相似。“非专注”状态下瞳孔大小的平均值更小,且瞳孔大小的变异性更大。此外,“非专注”状态的扫视持续时间更长,扫视峰值速度更高,注视时间更长,见表3。图5、图6为两种状态下眼动指标的散点图和箱型图。

4讨论

4.1注意状态分类

本研究保持和前人一致的划分标准时(I/O = 1),成功地重现出两种注意状态,相比于“专注”状态,个体在“非专注”状态下表现出更小的d′(假设3),以及更高的虚惊率和漏报率(假设4和假设5),但是两种状态下的平均反应时之间不存在显著差异(假设1)。本研究结果未能支持假设2,这是与以往研究结果的显著不同之处,我们发现两种注意状态下的判断标准β之间存在显著差异。此外,当划分标准为I/ O = 3时,“非专注”状态的平均反应时显著慢于“专注”状态。

以往研究表明,反应时和判断标准β反映的是个体执行任务的策略,而d′反映的是个体维持注意的能力[25-26],后者才是更适用于识别注意状态的行为指标。在不同的划分标准下,“非专注”状态均表现出更小的d′,说明个体维持注意的能力在该状态下严重下降。已有研究表明,要求被试验者在一天中(24h)的不同时段完成GradCPT,结果发现错误发生率随持续注意状态的变化而变化[25]。本研究的结果与这一证据保持一致,在维持注意能力下降的情况下(“非专注”),个体也出现了更多的错误,更高的虚惊率被认为是短暂的注意力缺失,漏报率则可能表明更大程度的任务脱离,无论哪种错误均表明“非专注”下个体的持续注意状态不佳,从而影响了任务绩效。这表明,GradCPT非常有效地呈现出专注和非专注的注意状态,而且d′可以被视为有效的行为指标用于构建注意状态识别模型。当划分标准更严格时(I/O = 3),两种注意状态的平均反应时之间的差异由不显著变为显著,“非专注”状态的平均反应时显著慢于“专注”状态。我们推测,个体的注意力越不稳定时,越难以将注意保持在某单一任务上,因此个体倾向于使用更谨慎的策略[26],通过放慢反应速度或改变判断标准β来降低犯错率。同时,本研究还发现NASA任务负荷指数与反应时呈正相关。这可能表明,当个体主观察觉到更高的工作负荷时,可能会采用降低反应速度的策略来减少认知资源消耗。

4.2不同注意狀态下的眼动模式

个体在“非专注”状态下,瞳孔大小的平均值更小,更高的瞳孔大小的变异性更高。这些结果与之前的眼动研究结果相似,Unsworth和Robison发现较小的平均瞳孔大小和较大的瞳孔大小变异性与注意力不集中有关[27]。另一项使用GradCPT的眼动研究发现,瞳孔大小与注意表现之间呈倒U形关系:瞳孔直径相对较小和较大时任务绩效更差,反应时变异性更大[28]。我们推测,倒U形曲线的左边代表唤醒水平不足的状态,中间代表处于最佳唤起状态,右边代表疲劳状态且注意力无法集中。GradCPT是一项对持续注意要求很高的任务,所以较差的表现可能对应于倒U形曲线的中间到右边的转变,瞳孔大小的逐渐变小以及变异性的逐渐增大表明个体集中注意力越来越困难,进而导致表现不佳。

当I/O比值从1变为3时,我们发现扫视持续时间、眼跳峰值速度和注视持续时间在“专注”和“非专注”之间呈现显著的差异,而且“非专注”状态的反应时变异性也更高,即持续注意状态更差。这意味着,以上这些眼动指标与更不稳定的注意状态相关。尽管当改变划分标准时,其他眼动指标也出现了差异,但是瞳孔大小平均值以及变异性可以更加稳定地对注意状态做出鉴别。

4.3下一步研究内容

(1)后续研究需要构建新的注意状态分类方法。以往研究均使用I/O=1作为注意状态的划分标准,潜在假设是“专注”和“非专注”时段各占一半;然而在航空驾驶场景中,以恒定的I/O值来区分注意状态是不适用的。(2)构建了更有效的注意状态分类方法后,未来研究可以采用机器学习的方法,构建以注意状态为标签、眼动指标作为输入特征的注意状态识别模型,并对该模型的识别效率进行验证[29]。(3)本研究是识别飞行员注意状态的初步研究,使用的GradCPT是研究持续注意的典型实验室范式,未来的研究应提高任务的生态效度,采用更接近真实的飞行驾驶场景来进行注意状态识别模型的验证研究。

5结束语

本研究通过GradCPT试验范式成功地诱导出个体的“专注”和“非专注”注意状态,多个眼动指标在不同的注意状态呈现显著的差异,其中瞳孔大小的平均值和变异性是最为可行和稳定的识别指标。未来的研究可以通过机器学习的方法,以眼动指标作为输入特征,构建针对飞行员注意力的实时监测系统,并对不佳的注意状态实施干预,提升航空系统的安全性。

参考文献

[1]Sheridan T B. Telerobotics,automation and human supervisory control[M].MIT Press,1992.

[2]邓平煜,裘旭益,姚子羽.航空军事领域的人机混合智能技术[J].航空科学技术, 2020, 31 (10): 3-6. Deng Pingyu, Qiu Xuyi, Yao Ziyu. Human-machine hybrid intelligence technology in military aviation field[J]. Aeronautical Science & Technology, 2020, 31(10): 3-6. (in Chinese)

[3]吴佳驹,苏幸君,朱妍.驾驶员辅助系统的研究现状和发展展望[J].航空科学技术, 2021, 32(7): 12-20. Wu Jiaju, Su Xingjun, Zhu Yan. Research status and development prospect of pilot assistance system[J]. Aeronautical Science & Technology, 2021, 32(7): 12-20. (in Chinese)

[4]蒋浩,高鑫.人因工程在无人机中的应用及展望[J].航空科学技术, 2019, 30(5): 9-13. Jiang Hao, Gao Xin. Application and prospect of human factor engineering in unmanned aerial vehicle[J]. Aeronautical Science & Technology, 2019, 30(5): 9-13. (in Chinese)

[5]Baberg T W. Man-machine-interface in modern transport systems from an aviation safety perspective[J]. Aerospace Science & Technology,2001,5(8):495-504.

[6]Mosier K L,Skitka L J,Korte K J. Cognitive and social psychological issues in flight crew/automation interaction[M]. Human performance in automated systems:Current research and trends. Hillsdale,NJ:Erlbaum,1994:191-197.

[7]Molloy R,Parasuraman R. Monitoring an automated system for a single failure:Vigilance and task complexity effects[J]. Human Factors,1996,38(2):311-22.

[8]Wohleber R W,Matthews G,Lin J,et al. Vigilance and automation dependence in operation of multiple unmanned aerial systems(UAS):a simulation study[J]. Human Factors,2019,61(3):488-505.

[9]Stanney K M,Schmorrow D D,Johnston M,et al. Augmented cognition:an overview[J]. Reviews of Human Factors and Ergonomics,2009,5(1):195-224.

[10]Wickens C D,Mccarley J S. Applied attention theory[M]. 1st ed. Boca Raton:CRC Press,2008.

[11]Vidulich M A,Wickens C D,Tsang P S,et al. Information processing in aviation[M]. Human Factors inAviation,2010.

[12]Danckert J,Merrifield C. Boredom,sustained attention and the default mode network[J]. Expriment Brain Research,2018,236(9):2507-2518.

[13]Esterman M,Noonan S K,Rosenberg M,et al. In the zone or zoning out?Tracking behavioral and neural fluctuations during sustained attention[J]. Cerebral Cortex,2013,23(11):2712-2723.

[14]Esterman M,Rothlein D. Models of sustained attention[J]. Current Opinion in Psychology,2019,29:174-180.

[15]Fortenbaugh F C,Rothlein D,McGlinchey R,et al. Tracking behavioral and neural fluctuations during sustained attention:a robust replication and extension[J]. Neuroimage,2018,171:148-164.

[16]Esterman M,Rosenberg M D,Noonan S K. Intrinsic fluctuations in sustained attention and distractor processing[J]. Journal of Neuroscience,2014,34(5):1724-1730.

[17]Schnell T,Kwon Y,Merchant S,et al. Improved flight technical performance in flight decks equipped with synthetic vision information system displays[J]. The International Journal ofAviation Psychology,2004,14(1):79-102.

[18]Shao F,Lu T,Wang X,et al. The influence of pilot’s attention allocation on instrument reading during take-off:the mediating effect of attention span[J]. Applied Ergonomics,2021,90:103245.

[19]Brams S,Hooge I T C,Ziv G,et al. Does effective gaze behavior lead to enhanced performance in a complex errordetection cockpit task[J]. PLoS One,2018,13(11):e0207439.

[20]Hart S G,Staveland L E. Development of NASA-TLX(task load index):results of empirical and theoretical research[M]. Advances in Psychology,1988.

[21]Matthews G,Szalma J,Panganiban A R,et al. Profiling task stress with the dundee stress state questionnaire[M]. Psychology of Stress,2013.

[22]See J E,Warm J S D,Ember W N. Vigilance and signal detection theory:An empirical evaluation of five measures of response bias[J]. Human Factors,1997,39(1):14-29.

[23]Bates D,Maechler M,Bolker B M,et al. lme4:Linear mixed-effects models using ’Eigen’ and S4[J]. Journal of Statistical Software,2015,67:1-48.

[24]Singmann H. Analysis of factorial experiments[C]//Proceedings of the Asme International Mechanical Engineering Congress & Exposition,2014.

[25]Riley E,Esterman M,Fortenbaugh F C,et al. Time-of-day variation in sustained attentional control[J]. Chronobiology International,2017,34(7):993-1001.

[26]Fortenbaugh F C,DeGutis J,Germine L,et al. Sustained attention across the life span in a sample of 10000:dissociating ability and strategy[J]. Psychological Science,2015,26(9):1497-510.

[27]Unsworth N,Robison M K. Pupillary correlates of lapses of sustained attention[J]. Cognitive,Affective & Behavioral Neuroscience,2016,16(4):601-615.

[28]Van Den Brink R L,Murphy P R,Nieuwenhuis S. Pupil diameter tracks lapses of attention[J]. PLoS One,2016,11(10):e0165274.

[29]何曉骁,姚呈康.人工智能等新技术在航空训练中的应用研究[J].航空科学技术, 2020, 31 (10): 7-11. He Xiaoxiao, Yao Chengkang. Analysis of artificial intelligence and other new technologies in aviation training[J]. Aeronautical Science & Technology, 2020, 31(10): 7-11. (in Chinese)

Feasibility Research on Pilot Attention State Recognition Based on Eye Metrics

Zhang Yifan,Wang Yuchao,Zhang Qinyu,Ge Xianliang,Xu Jie

Zhejiang University,Hangzhou 310058,China

Abstract: The main tasks of the pilots in future highly automated aircraft will be tasks monitoring. One of the promising ways to promote performance and safety in such tasks is the development and utilization of real-time pilot attention recognition and intervention technologies in the cockpit. The purpose of the current study is to explore the feasibility of using eye metrics to identify the different states of sustained attention with the Gradual Onset Continuous Performance Task (GradCPT) paradigm. 30participants participated in the study and each completed three eightminute sessions of GradCPT tasks, while eye metrics are collected with an eye-tracker. "In the zone" and "out of the zone" periods during the task are identified according to the variance time course measure men. Eye-tracking data indicated that the mean and variation of pupil size, saccade duration, saccade peak velocity, and fixation duration measures are sensitive to the "in-the-zone" vs. "the out-of-the-zone" periods. The results suggest that it is feasible to recognize the attention state through eye metrics. Future research can use eye-tracking indicators as input features to build machine learning models of sustained attention for pilots.

Key Words: human factors and ergonomics; human-machine interface; human factors in aviation; sustained attention; GradCPT