功能性匿名方法对个人信息界分标准的重塑

2022-05-27宋云婷

宋云婷

(南京大学 法学院,江苏 南京 210093)

一、问题之提出:我国个人信息“可识别性”界分标准的困境

《中华人民共和国个人信息保护法》(以下简称《个人信息保护法》)第四条规定:个人信息是以电子或者其他方式记录的与已识别或者可识别的自然人有关的各种信息,不包括匿名化处理后的信息。第四条对“个人信息”进行了界定——以一定方式记录的与自然人相关的已识别或者可识别自然人本身的各种信息,并且将匿名化处理后的信息排除在个人信息保护的范围之外。同时,第七十三条第四款规定:匿名化,是指个人信息经过处理无法识别特定自然人且不能复原的过程。《个人信息保护法》开篇厘清了法律所保护的个人信息的概念及其范围,对个人信息保护立法具有先导作用。此法之立法目的在于平衡信息利用、信息保护二者的关系,而平衡的实质在于对国家利益、社会公共利益与个人利益三者之间的衡量。以个人利益平衡为例,若禁止个人信息流转,则极大阻碍企业信息利用及企业提供信息的积极性。个人信息得到绝对保护的同时,社会公共利益受损进而影响国家经济利益。

《个人信息保护法》第四条的规定采取并列包含及结果排除的方式界定了个人信息的概念及范围,即严格以“可识别性”作为界分标准,将能够直接识别与间接识别(1)直接个人信息是指能够直接识别信息主体的个人信息,包括姓名、身份证号、肖像、声音、基因等内容。间接个人信息是指需要结合其他个人信息方能识别信息主体的个人信息,如性别、年龄、身高、职业、学历、家庭住址、个人消费习惯、网络浏览记录、消费能力、地理位置、银行账号、支付宝账号等。[1]自然人的信息纳入个人信息保护法予以保护的范围,把匿名化技术处理过后的无法识别的信息排除于个人信息保护的范围之外。该规定虽然体现了兼顾个人信息保护与信息利用的价值取向,但根据现有司法实践观察,由于个人信息“可识别性”界分标准自身的不确定性及配套规定的缺乏,致使立法价值与司法的实际操作之间产生现实分歧。

大数据时代的来临使得数据日益成为创造价值的核心资产。传统被认为可以直接识别自然人的信息,如姓名、手机号码等,成为庞大数据中的一粒尘埃。现今有时并不能直接对自然人进行识别,需要与其他信息结合才能准确识别出个体。此时,被认为皆具有“可识别性”的直接识别信息与间接识别信息的界限开始模糊,“可识别性”标准的应用从内部逐渐瓦解。因此,在区分信息类型的过程中,不能将某类信息特定化为直接识别信息或间接识别信息。如在“苏州贝尔塔数据技术有限公司与伊日克斯庆一般人格权纠纷案”中,伊某的姓名具有特殊性,人民法院认定为可直接识别信息;而在“陈江霞、何启伟侵犯公民个人信息案”中,人民法院将公民的姓名与其他信息相结合进而识别公民本身,此时姓名则成为一种间接识别信息,见表1。

表1 个人信息分类与定性情况表

从表1列举的各案来看,我国民事与刑事司法裁判中对“个人信息”认定区分的标准与定性不同。当前,我国的民事司法裁判中逐渐将个人信息保护从隐私权保护路径中予以分离,而进一步明确个人信息获得保护的标准为该信息的“可识别性”。但是在刑事判决中,个人信息的保护仍然过度依赖于隐私保护的路径,个人信息的定性与隐私的认定相互杂糅,呈现出与民事司法实务中二者相区分之理念的背离,从而破坏了法秩序的统一性。例如,在“周琦等人侵犯公民个人信息案”及“肖江等人侵犯公民个人信息案”的判决书中,人民法院依据2013年4月23日公布的《最高人民法院、最高人民检察院、公安部关于依法惩处侵害公民个人信息犯罪活动的通知》将公民个人信息区分为公民个人身份信息和涉及公民个人隐私的信息两类。人民法院在认定犯罪嫌疑人侵犯公民个人信息时,首先判定该涉案信息是属于公民个人身份信息还是属于个人隐私信息。虽然个人信息与隐私具有一定的重合交叉关系,二者交叉部分为个人隐私信息,但是正确的逻辑是区分二者之后再讨论其重合部分。如果将个人信息先行割裂为隐私信息及个人身份信息,就会发生逆向的逻辑错误。同时,将公民个人信息分为公民个人身份信息和个人隐私信息的分类并不能涵盖所有公民个人信息的范围。

事实上,表1还反映了两个重要的问题。一是实务中对间接识别信息的认定存在矛盾与冲突。各级人民法院对间接识别信息的界定存在偏差,即与其他信息结合能够识别自然人本身的信息中所结合的“其他信息”是否应当是违法行为人所掌握、利用或流转的信息。如在“陈某某、刚某某侵犯公民个人信息案”中,人民法院认为虽然被告人陈某某提供的信息只有电话号码,但电话号码与其他信息结合后能识别特定自然人身份,因而将电话号码认定为间接识别信息,但与电话号码结合的其他信息陈某某并未掌握。而在“朱某诉北京百度网讯科技公司隐私权案”中,人民法院认为网络活动轨迹及上网偏好匿名化信息与网络用户身份相分离,用户身份为该公司未知,因而该公司就无法识别并确定自然人主体。该信息被认定为匿名化信息而不属于个人信息保护的范畴。在上述两案中,行为人皆仅掌握无法单独适用识别自然人身份的信息,但该信息在不同人民法院的实际认定中被双重定性。二是我国司法实践中对匿名化信息认定极少,法院通常倾向于将无法区分为间接识别信息还是匿名化信息的相关信息判定为间接识别性信息,从而纳入相关法律予以保护。匿名化信息的认定通常对技术认知水平的要求较高。我国法官大多缺乏信息处理专业技术知识,所以认定技术处理信息的程度与水平较低。同时,我国法院司法资源较为紧张,法官处理一个案件的调查成本有限,认定匿名化信息的案件极少,法院审判缺乏先例。为了避免对现有裁判秩序产生冲击性影响,法官认定信息性质时通常采取保守态度,倾向于将难以定性的个人信息全部纳入信息保护范围之中。

以上问题,究其本质而言是由于司法实务中个人信息保护的可识别性界分标准模糊、实操性较差。该标准不仅内部正在逐渐瓦解,且外部应用存在无法区分间接识别信息与匿名化信息的核心问题。为解决上述疑难,本文将功能性匿名的方法引入,并在此基础上尝试调试与应用个人信息界分之新标准,并对整体功能性匿名的流程进行评价。

二、功能性匿名方法的提出

本部分通过对欧盟及美国数据保护立法的研究,发现域外匿名化处理规则中的不适宜标准及简约化处理存在的问题,进而引入功能性匿名流程尝试探索解决问题的可能性。

(一)域外个人信息“可识别性”标准的困境

本文中个人信息保护与个人数据保护意义相同,研究中不做区分。域外数据保护[2]实践中,以“可识别性”标准界分数据保护范围的共识导致数据的简约化处理模型广泛应用。该模型包括欧盟使用的假名化处理,以及美国应用的移除直接标识符等,此种方法的实质是一种应用于数据匿名化处理而使数据达到不可识别性的算法[3]。而域外匿名化数据处理体系的崩塌源于简约化处理的失败。数据与信息的保护目的在于对信息的保护与利用进行平衡,而在过往的数据匿名化处理实践中,欧盟由于对匿名化数据采“穷尽一切合理可能之方法”的畸高标准,限制了数据的流转与利用,而美国移除数据中的直接识别符,片面考虑数据的去可识别性而未区分敏感信息的保护,可能导致隐私的泄露,产生数据保护的危机。

1.欧盟

欧盟对数据保护原则的排除适用施加了烦琐的限制。欧盟于2018年5月开始实施的《欧盟通用数据保护条例》(General Data Protection Regulation,简称GDPR)第4条将个人数据定义为“任何已识别或可识别的自然人有关的信息”,界定可识别的自然人是指“可以直接或间接识别的自然人,特别是通过相关的标识符识别,如姓名、位置数据;或通过一个或多个特定的因素识别,如生理、遗传、精神、经济、自然人的文化或社会身份”。此外,GDPR在序言第26条中还做了进一步限定:决定该数据是否能够识别特定自然人应穷极一切合理且可能使用之方法,允许直接或间接识别的方式,同时应考虑一切诸如成本、技术发展等客观因素。数据保护原则不适用于无法识别自然人的匿名数据及信息[4]。纵观欧盟建构的个人数据保护与匿名化数据标准的组成极为严苛,“直接或间接之识别性”成为适用数据保护原则的核心,而“穷尽一切合理且可能之方法”的判定似乎成为一道数据保护坚不可摧的防火墙。

欧盟对个人数据的匿名化处理主要采用假名化的方法。假名化处理是用一个抽象版本代替原有可识别性信息而达到匿名效果的算法。实践中两个问题导致假名化的失败:一是假名化处理的信息仍具有潜在可识别性。以假名化实践为例,研究人员通过个人对电影评级的辅助信息,从Netflix的50万个假名订阅用户的数据集中发掘出大量可识别用户个人的数据[5]。因此,对数据进行假名化处理时,无法排除试图识别信息者已经或将要拥有相关辅助信息的可能性,这种客观上无法周全的考虑可能为信息披露埋下伏笔。二是信息扩大化传播模式的形成进一步增加了信息披露的风险。现今人们的社交行为倾向于彼此之间信息的交流与生活的分享,辅助信息在扩大化传播模式中变得更加容易获得,信息披露风险上升也不可避免。

2.美国

在美国,“个人识别性信息”(PII)的范围界定较窄,指的是由联邦机构维护的可用于追踪个人身份或与个人相关的信息。可识别性标识符包括名称、地址及其他已知标识符(如社会安全号码)。2020年1月生效的美国加州颁布的《加州消费者隐私法案》(California Consumer Privacy Act,简称CCPA)中,“个人信息”是指能够直接或间接的识别、描述与特定的消费者或家庭相关或合理相关的信息,这些信息包括但不限于真实姓名、邮政地址、商业信息、地理位置数据、唯一的个人标识符等。CCPA对个人信息的定义更加广泛,其将消费者相关推断信息纳入个人信息定义之中,突破了GDPR对个人信息泛化的列举类型。

《健康保险可携性和责任法案》(HIPAA)隐私规则第14条列举出一系列构成PII的标识符,美国通过移除直接识别符进行数据保护。此种匿名化方法存在两点失败之处:一是通过法案对标识符进行列举存在滞后性。首先,官方列举不可能穷尽直接标识符类型,因而该官方列举不可能完整;其次,该官方列举完整性仅是相对完整,列举内容必然会随着时间扩充。二是移除直接标识符片面考虑数据的可识别性,不区分保护敏感信息。移除直接标识符之后仍然可能存在敏感信息的残留,进而使得隐私泄露。根据Farzanehfar Ali等学者的实验,在移除直接识别符的匿名数据中,个体经常能被重新识别。实验人员利用3个月的位置数据,实现了在一个六千万人的数据集中,唯一识别的人占93%。若仅使用四点辅助信息,最少识别的人数为其中的22 %,而当辅助信息增至五个点时,这个下限将增加到87%[6]。

(二)功能性匿名方法的引入

鉴于域外数据匿名化的失败,英国学者Mark Elliot等人提出了功能性匿名的命题:数据是否匿名(因此能否识别个人)是数据与其环境之间关系的函数[7]。他们强调匿名不应被理解为应用于原始数据集以产出具有可测量风险水平的派生数据集的算法,而是旨在将数据重新识别的风险降低到可接受水平的持续性过程(2)该风险并无准确的数字约束,此处采用Elliot等人使用的可忽略性概念来表示一个理性的人会忽略的风险,具体性质将根据具体情况而定。举例说明风险的可忽略性是指我离开家锁门时忽略被小偷撬门的风险,但我不忽略没有锁门时被小偷光顾的风险。参见文献[7]。。功能性匿名将一元的是否可识别的标准问题转化为风险控制问题,即将数据重新识别的风险降低到可接受之低水平,从而将技术支持的流程与数据匿名性度量相结合,在确保敏感数据安全保护的同时,提供满足复杂利用需求的机会[8]。

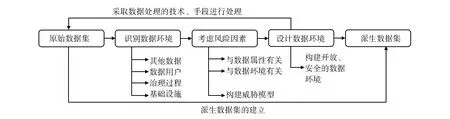

功能性匿名在原始数据集的基础上建立一个派生数据集,而使派生数据集达到功能性匿名要求的再识别风险可接受的低水平风险标准。功能性匿名呈现如下流程,见图1。

图1 功能性匿名流程图

功能性匿名中,数据环境包括原始数据集与派生数据集交互、控制该数据的交互或者为该数据提供可解释的背景。进一步确定数据环境的内部机理,数据环境通常由4个关键元素组成:其他数据、数据用户、治理过程及基础设施。其他数据是指放置派生数据集的环境中包含的以一系列复杂方式相互关联的数据,即上文提到的极易与原始数据产生链接的辅助性数据;数据用户及基础设施是数据操作的源头,对数据环境产生着重要的交互影响;而环境的治理流程将决定数据控制者如何管理用户与数据的关系。

全局数据环境由本地数据环境和二者之间的关系组成,数据环境由刚性或柔性的边界划分,如法律法规、业务模型、许可协议、防火墙等。这些边界被环境的基础元素构建,并由这些元素筛选。从利用的简单性及实用性出发,功能性匿名将复杂的、流动的总体数据环境屏蔽,而以数据控制者对基础元素的操作控制来建构本地数据环境。也就是说,基础元素的筛选与过滤在某种程度上最接近派生数据集环境。因此,在大多数情况下,数据控制者对基础元素的控制将显著影响从派生数据集重新识别数据主体的可能性及成本。

功能性匿名要求数据控制者不仅需要考虑与数据属性有关的风险因素,还需要考虑与数据环境有关的风险因素。有学者认为功能性匿名包括数据环境(Data Environment)和匿名化决策(Anonymization Decision-Making)两个要素[7]。实际上该种区分割裂了功能性匿名化的持续性过程,二者并非要素的并列关系,而是逻辑上的顺承关系,即数据控制者在进行匿名化决策时应当以数据环境为基准。

在整个功能性匿名流程中,数据控制者并非数据环境的被动承接者,他们在一定程度上享有通过设计数据环境确保数据安全的主动权。数据控制者被要求必须考虑风险因素,构建有用的威胁模型,并在此基础上对原始数据集采取数据处理技术与手段,如聚合、删除字段或变量、抑制独特的价值观等,从而建立派生的数据集。开放的数据环境非常宽松,不会留下任何残留的控制因素,派生数据集要求自身数据环境具有安全性、开放性。因此,数据控制者不仅需要考虑数据与环境中的风险因素,同时也应当以自己为主体,构建一个开放、安全的数据环境。

功能性匿名是一种基于数据环境依赖和风险评估的数据匿名“可识别性”标准的替代方法,旨在将法律与匿名的实际现实进行调和,并使数据保护设计嵌入到数据控制者与数据处理者的数据处理实践中,以促进数据的进一步利用[9]。这种方法具有主动性、预防性。在设计中嵌入数据保护,通过完整的闭合回路实现数据保护与数据利用的良性互动。且此方法以数据用户为中心,具有极强的可见性和透明性,从而实现正向收益。

三、功能性匿名的本土化调适

(一)我国个人信息保护的本土现实

2000年前后,我国开始着手个人信息保护专项立法。自2012年全国人大常委会通过的《关于加强网络信息保护的决定》(3)《全国人大常委会关于加强网络信息保护的决定》第一条:国家保护能够识别公民个人身份和涉及公民个人隐私的电子信息。到2017年实行的《网络安全法》(4)《中华人民共和国网络安全法》第四十二条:网络运营者不得泄露、篡改、毁损其收集的个人信息;未经被收集者同意,不得向他人提供个人信息。但是,经过处理无法识别特定个人且不能复原的除外。第七十六条第五款:个人信息,是指以电子或者其他方式记录的能够单独或者与其他信息结合识别自然人个人身份的各种信息,包括但不限于自然人的姓名、出生日期、身份证件号码、个人生物识别信息、住址、电话号码等。,再到2020年实施的以《信息安全技术 个人信息安全规范》(5)《信息安全技术 个人信息安全规范》3.1:个人信息,以电子或者其他方式记录的能够单独或者与其他信息结合识别特定自然人身份或者反映特定自然人活动情况的各种信息。为代表的一系列配套国家标准都将可识别性作为个人信息保护划定范围的标准。

《个人信息保护法》与该法第一版草案相比,删去了禁止匿名信息重新识别的规定(6)《个人信息保护法(草案)征求意见》第二十四条第二款:个人信息处理者向第三方提供匿名化信息的,第三方不得利用技术等手段重新识别个人身份。,这具有一定进步意义。再识别禁止规定在实践中无法落实。数据控制者已经获取原始数据集,数据处理者使用匿名化技术得到派生数据集,若能在数据处理的过程中利用原始数据集间接地从派生数据集中识别个体,任何一个客观理性人都会这样做以掌握更多信息。有的学者主张我国《个人信息保护法》应当规定“禁止反向识别”[10],但数据处理过程中的信息获取无法避免,因此禁止信息再识别在实然状态下无法实现。

《个人信息保护法》同样以“可识别性”作为个人信息保护范围的判断标准。正如有的学者所言,“可识别性”是一个不确定概念,由于数据的聚合操作或其他技术性手段,信息的识别区分度不断发生改变,间接识别变得更加容易,使得可识别性范围不断扩大[11]。此种“可识别性”的判断标准在实务应用中僵化、抽象:相互抵牾的审判较多、救济途径和衔接机制不畅、信息处理与分层保护规定存在空白、学界对个人信息标准问题也存在诸多误解。此时,信息保护的范围界定应寻求突破一元化可识别性标准的界点认定,而转向功能性过程化的综合评估。

(二)功能性匿名的递进式调适

1.整体架构之搭建

(1)匿名信息概念的再界定

传统视野下个人信息保护以可识别性分野,不具有识别性的信息,即匿名化信息被划出信息保护的范畴。上已述及,可识别性概念具有自身也无法克服之顽疾,而“概念是解决法律问题所必需的和必不可少的工具。没有限定严格的专门概念,我们便不能清楚地和理性地思考法律问题”[12]。

功能性匿名视角下,个人信息保护范围的分界点发生转移,该点并不在于信息是否具备可识别性,而在于识别风险是否已经降低到可接受的低水平。此时不受保护的匿名化信息不再以“可识别性”作为区分标准,而成为识别风险处于可接受之低水平的一类信息。这就解决了传统匿名化信息概念中的不确定问题,进一步从根源处解决信息保护界分模糊的痼疾。

(2)信息保护范围标准的再调整

对信息保护范围的综合性过程评估与一元化界点判断相比,摒弃了界点判断时“全有或全无”的桎梏,而采取了一个动态化相对性标准,即功能性匿名是通过对数据及其环境的控制来降低重新识别风险,从而使该风险处于可接受的较低水平标准。识别风险的可接受低水平标准中,似乎仍然存在不确定概念:风险究竟处于何种水平,该派生数据集才能被视为匿名数据集呢?

Mark Elliot等人提到了“可忽略性原则”(the principle of negligibility)[7],即作为一个理智的人会忽略的该种风险为可忽略的风险。例如,一个理智的人会在离开家时锁好门以防盗贼的侵入,但其并不会在上班途中防范被陨石砸死的风险,后种风险即为可忽略的风险。

对可忽略性原则中“一个理智的人”的界定不甚明晰,此处可采理性人标准。理性人标准解决了采取过程性动态化标准带来的不适配性,同时凭借自身的可调试性保留了各数据处理过程自身拥有的独特性“标准”。其适用一般经历三个阶段:理性人建构、场景重构、透过认知图式得出结论[13]。将该标准融入功能性匿名中标准的调整:首先,一个理性数据控制者的构建以其知识结构、能力水准的架构为核心;其次,重构该理性数据控制者所处的场景因素,包括对行为背景、场所、数据环境等信息进行筛选;最后,就能通过该理性数据控制者在相应的场景下的认知和行为,结合可忽略性原则,确定低水平之限度。

(3)数据环境的再描述

通常情况下,数据控制者为派生数据集创造的三种数据环境包括:①开放数据环境,如政府数据开放平台;②通过许可建立的用户社区环境,如社区服务平台;③受控安全设置环境,如受控制文件夹的访问环境。

根据相关法律及规范性文件要求,开放数据环境中数据皆被匿名化处理,该环境中的数据实际上处于被施加最小限制且各用户都能平等访问并处理的状态。此种环境中的数据发放皆应符合治理规范,因此治理约束几乎为零。假设存在数据用户U,U在开放数据集中能够接触到大量的辅助信息,如访问分区得到的分区数据(Ip)、本方或他方的个人数据(Ik)、易获取的数据(Ir)及其他数据(Io)。此时,理论上U在不受治理约束中的数据环境可表述为{Ip,Ik,Ir,Io},用Ei来代指该数据环境,其中i表示辅助信息,则Ei={Ip,Ik,Ir,Io}。而由于该数据用户U本身具备自身特性A,如特定的技能、资源及原始掌握数据,则该特征A本身会对数据环境造成一定的约束。若我们将被约束的数据环境用(FE)i(即functionally-constrained data environment)表示,则(FE)i=A(Ei)。此时,原始数据集D需要被纳入考虑观察被约束的数据环境(FE)i与原始数据集之间的交集,但该交集的存在具有一定概率性,就算二者的某些数据客观上能够重合,也不一定在实操中发生数据集的重叠。该概率性交集可表示为(FE)iD=A(Ei)∩D[7]。在功能性匿名的考虑中,要将识别风险控制在可接受的低水平中,那么(FE)iD应当约等于零,即(FE)iD≈0。

而通过许可建立的用户社区环境,由于数据的传递需要数据控制者的许可,如数据控制者对数据用户资格的限定,要求允许进入的用户做出禁止再识别的承诺等,实际上为数据的流通引入了一些摩擦。此时用户U的数量减少,分区约束增加,则包含辅助信息的数据环境Ei可能缩小,(FE)i似乎更加容易使其趋近于零。但是,设置许可的成本不可忽略。而在受控安全设置环境中,Ei则受到直接的限制,如用户U可能被要求在严格受限的物理环境中工作或从受控安全环境中删除数据受到严格控制,这严重限制了Ip、Io和Ir的范围。(FE)iD≈0容易实现,但该种环境在一定程度上也约束了数据流转,限制了数据的效用,并不适合广泛应用。

2.细节流程之填充

(1)识别数据环境

在新一代的数字科技引领之下,数据成为产业发展的关键要素并进一步进行价值的整合。在2020腾讯全球数字生态大会上,腾讯研究院联合腾讯云发布的《数字中国指数报告(2020)》(以下简称《报告》)中指出,数字中国指数持续高速增长,较去年同期上升73.2%。根据《报告》来看,中国产业数字化是增长的主要动能,产业链上下游通过数据赋能实现其全要素的数字化升级、转型和再造,具有极强的系统性与整体性。数字化程度虽有显著整体提升,中西部地区及四线城市数字化增速领先,但数字鸿沟仍然存在。在识别数据环境中,数据流转的系统性、整体性及各数字地域内数据差异化程度的把握都应纳入宏观角度综合考量。

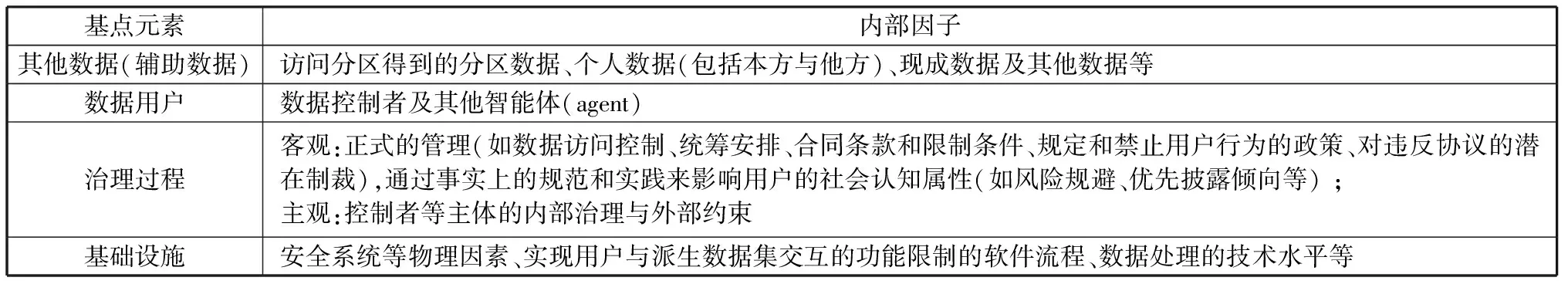

功能性匿名提出的数据环境识别四要素,即其他数据、数据用户、治理过程和基础设施,在本土化应用时应当作为识别数据环境的基点,其内部因子也要进一步做适合本国数字发展国情之细化。其中,功能性匿名对数据治理过程的要求包含施加一系列的行为限制措施,通常包括正式的管理及影响用户的社会认知属性,如风险规避、优先披露倾向等的相应举措。同时,我国正在探索建立激励相容的个人数据治理体系,以数据控制者的内部治理为核心,以外部执法有效威慑与执行的构筑为保障[14],该体系要求在识别数据环境中将数据控制者等主体的内部治理与外部约束纳入考虑因素。因此,在数据环境识别中,对治理过程的考量就演变为主观与客观的二元逻辑推演。而基础设施元素则包括安全系统等物理因素,以及实现用户与派生数据集交互的功能限制的软件流程。在数字鸿沟的存在之下,数据处理的技术水平也对数据环境的识别产生影响。综上,本文尝试给出一定的细化组件,见表2。

表2 数据环境识别因素的组件细化表

(2)考虑风险因素

在功能性匿名中,数据控制者具有一项重要职责:考虑风险因素,构筑威胁模型。前已明确,数据控制者在做出匿名化决策时不仅需要考虑与数据有关的风险,还应当对与数据环境有关的风险予以测评。结合功能性匿名理念与我国数据流转实践来看,风险大体包括:主体从数据中再识别的动机、再识别的后果、数据的管理、数据的来源、相关辅助数据及数据的质量[7]。现实中,数据控制者对数据进行再识别的动机多种多样,如通过成本较小的技术再识别获得个人信息以期实现自己的商业目的,而本身的数据处理过程中的数据再识别也无可避免。再识别的后果本身也是重要的考虑风险因素之一。再识别可能导致匿名化处理的数据与信息显形,从而造成信息泄露的后果,但若再识别本身处于一种可接受的风险低水平状态,则该派生数据集就达到了功能性匿名化的标准。数据来源与数据管理需考虑数据传递流程中的风险,即数据经谁之手流转何地、后续利用及利用条件,以及开放主体都在该条目射程之中。相关辅助数据包括时间序列数据、开放数据、同一领域的商业可用数据等,作为识别数据环境的基点因素,在风控阶段依然需要重点把握。需要注意的是,作为风险因素的数据质量自身存在悖论,从隐私的角度来看低质量的数据可能更安全,但是低质量的数据本身效用不足,降低数据质量有悖于数据匿名而加强对数据信息利用之目的。

除此之外,数据控制者需要全面了解数据泄露可能发生的方式、后果和环境,需要预防泄露发生的风险,并至少保证:当最坏的情况发生时,应当按照风险威胁模型执行。

(3)设计数据环境

数据控制者不是数据环境的被动占用者。他们可以发挥自身设计数据环境的主动性,以确保其对数据环境具有更大的控制力。其设计途径包括访问控制以及查询控制:控制限制数据分析者的访问仅使受信任的分析者通行,其在访问端口设置限制以使防御有效存在;控制限制数据库中查询问题的回答内容会限制它将显示的信息。数据经由硬件或软件在安全的数据环境中被访问,而此种安全的环境通常需要通过限制数据分析者的访问能力进行建构,如对数据分析者资格审批制度的设立。

数据环境的安全性是必然要求,除此以外数据控制者还应当设计一个开放的数据环境。开放的数据环境的内部是一种非常宽松且不会残留任何干扰或控制因素的状态,因此个人信息将会安全的以数据的形式存在于开放数据环境内部。保持数据环境的开放性是实现我国数据增值开发与利用的前提。数据环境的开放利用程度直接反应数据环境设计与治理的能力和水平。保证一个开放、安全的数据环境,能够更好地提高数据利用水平,缩小我国各区域的数据鸿沟及区域间数据利用的差距,实现数据提供者和数据利用者的价值共创和共享,才能使数据的开放利用能更好地服务于数据治理实践。

DPSIR概念模型最早是由OECD在1993年对PSR模型和DSR模型进行修订而提出的,现已逐渐成为解决各类社会问题的有效工具。对数据环境开放性评估可采用DPSIR框架[15]。该框架基于指标间的因果关系而建立,通过驱动力、压力、状态、影响、响应五个维度的基础因素分析数据及其利用水平的变化,有助于探求提高数据效用发挥的方法,进而全面把握数据环境中的数据开放利用程度[16]。本文尝试在DPSIR框架的基础上构建简单的数据环境开放性评价指标体系,见图2。

图2 数据环境开放性评价指标体系图

四、功能性匿名运行的反思与检视:评价与调整

(一)功能性匿名运行的总体评价

从制度运行的角度看,任何运行的制度与规则都需要具备相应的评价与防御机制,缺乏评价与防御机制的制度体系运行如空中楼阁,无法付诸实施。同时,数据的匿名化处理应当采取将功能性匿名的技术方法与其他非技术方法组合应用,形成一体化的整体方法论;而非把两种技术方法割裂开,将匿名化作为一项专门技术,将非技术性手段作为匿名化技术的弥补形式。因此,功能性匿名运行的评价机制是其自身属性的根本要求,也是运用整体方法论解决匿名化问题的关键所在。

宏观下的社会组织中各事态变化,以及各个环节的动态发展使得法律与规则的制订存在一定滞后性。同样,功能性匿名不是应用于数据集以达到可衡量安全水平的算法,而是一个持续的动态变化的过程,其目的是将识别风险降低到可接受的低水平状态。功能性匿名的流程运行中,其技术方法对各数据集的运用程度需要存在评价系统予以及时评价,再对流程的各个环节进行适时调整。功能性匿名的流程运行完成后,整体流程也需要评价系统予以检视,使之适应数据处理要求,达到识别风险可接受之低水平的目的。

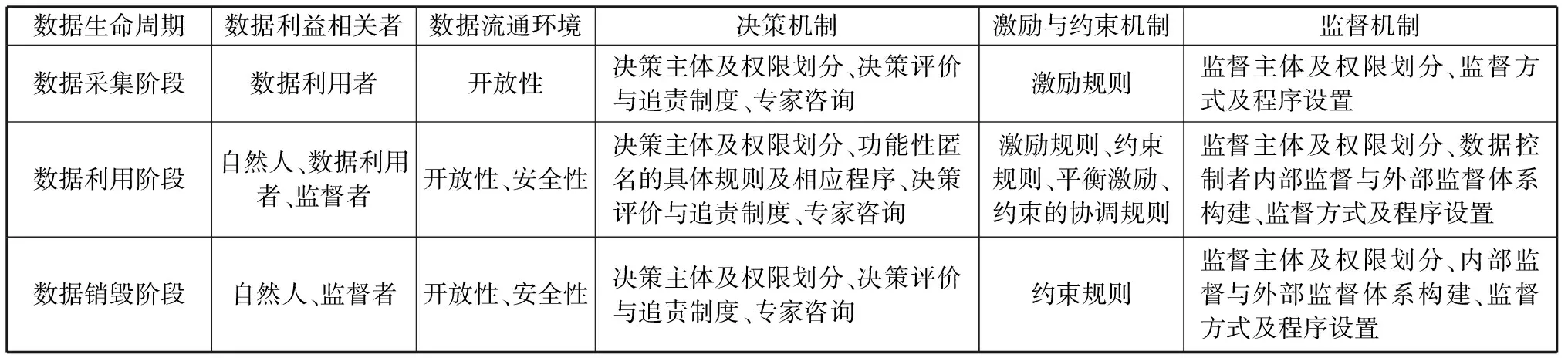

大数据治理的背景下,数据脱敏作为信息广泛利用、共享的前提,离不开采取功能性匿名手段处理个人信息的决策,而这正应和了决策作为治理要旨之一的重要地位[17]。同时,考虑数据利益相关者各方的利益平衡,激励相容的数据治理机制必不可少。此外,要对功能性匿名的运行进行整体评价,有效的监督机制下决策结果的呈现才是评价该技术手段的重要因素。因此,为了更直观地检视功能性匿名的整体性运行,及时反馈与评价其运行过程中出现的问题及产生的实效,本文在参考郑大庆[18]、程昔武[19]等学者的研究成果后,结合上述分析,总结抽取外部约束与内部治理两个维度,包括数据利益相关者、数据流通环境、决策机制、激励与约束机制、监督机制五个方面的指标,设计功能性匿名运行的评价体系,见表3。

表3 功能性匿名运行评价表

(二)基于数据生命周期的评价体系再调整

通过对以上文献的研究本文得出,数据的生命周期是指某个数据集中的数据从采集、处理、利用到归档和销毁的整个过程,体现数据从产生到消亡全过程状态的转变及其衍生物产出的整个循环周期,它是数据治理过程中数据呈现出的区别性状态特征。为了适应数据的动态周期性变化和功能性匿名的流程性特征,更加适时恰当地应用功能性匿名运行反馈评价系统,满足数据周期性变化的不同需求,本文基于数据生命周期各阶段呈现的不同状态,将数据生命周期大致分为数据采集、数据利用与数据销毁三阶段。功能性匿名运行的评价系统根据其所处数据生命周期阶段的不同,各指标衡量评价的侧重点也随之发生改变。

首先,在数据的采集阶段,个人数据汇集成为公共数据形成原始数据集,从原始数据集中采集出具有完整性、精确性等特征的高质量数据是保证匿名化后的数据具有较高效用的前提。此时,易出现的问题是所采集的基础信息质量无法满足应用需求[20],采集行为与获取的基础信息质量呈现事倍功半的效果。因此,评价体系的外部约束指标应当侧重数据利用者对高质量数据的抽取采集,监督者在此阶段监督力度不应过大,且需尽量为数据采集提供开放性强的数据环境,以保证高质量数据收集的可能性。在评价体系的内部治理指标中,决策机制指标应明确决策主体基础数据采集、汇总的权限,优化数据报送的规则与程序;激励与约束机制指标注重数据利用激励机制,激发各主体数据收集利用的积极性与主动性;同时,监督机制应侧重于对数据收集过程中存在的违规收集行为进行监督。

其次,数据的利用阶段包括数据的存储、处理、利用、共享等多环节内容。本阶段决定着数据匿名化目的实现的成功性,在数据的生命周期中具有主导性地位。数据利用与数据保护在此阶段发生激烈的价值碰撞。本阶段存在三重疑难,即如何扩大数据的利用效用,如何进行有效的信息保护,以及二者之间如何平衡,这对基于社会需求的价值衡量提出了较高的要求。因此,评价体系的外部约束指标中,主体方面应当广泛注重自然人、数据利用者,以及监督者个体及其相互关系,注重保护自然人隐私权、数据利用效能,监督者对数据利用者的行为也应当严格把关;而客观方面的数据流通环境要依据数据效用选择设置适当的数据环境,如在准入门槛较高的数据环境中,其内含的数据应当具有更高的价值,以使数据利用者进入环境的成本与获得的数据效用相匹配。在体系的内部治理指标中,决策机制指标应完善数据运用、功能性匿名方法处理,以及风险应对等决策的规则及程序,制订决策评价与追责制度,涉及技术手段及专业的问题要进行专家论证;激励与约束机制指标要侧重于激励规则与约束规则的协调运用,达到平衡激励、协调约束的效果;监督机制指标中应注意个人信息的匿名化处理是否成功并防范数据利用过程中信息的非法使用、扒窃、泄露等违法行为。

最后,数据销毁阶段主要运用删除、清除、物理销毁等数据销毁技术对数据进行清除[21],使数据生命归于消亡。数据清除不彻底就可能发生数据的泄露。基于此,在信息的价值发挥与个人利益保护中,应更加侧重对数据主体权利的保护。在评价体系的外部约束指标中,该阶段要求注重自然人权益保护,监督者对数据销毁也要进行监督;数据流通环境应具有安全性、开放性以使数据痕迹更容易清除。内部治理指标中,决策机制指标应广泛运用追责与评价机制及专家论证制度,隐私权、被遗忘权等权利应被给予程序保障;激励与约束机制指标中要侧重于约束规则的运用,达到防范信息泄露进而保护数据主体权益的效果;监督机制中应当建立完善的内部与外部监督体系,双向互动并及时对清除数据的环境进行过滤,检测是否存在遗留信息,见表4。

表4 基于数据生命周期的匿名化评价侧重表

五、结语

数字时代,数据利用不断寻求与数据保护共赢的平衡状态以谋得数字经济的发展。我国个人信息保护立法正在以兼具价值创造与信息保护的目的全面铺开,僵化的“可识别性”信息保护界分标准不应当成为限制数据利用与数据保护的阻碍。为了摆脱该标准的制约,功能性匿名技术应当被及时引入,以此建立动态的匿名化处理流程,确定新的识别风险处于可接受之低水平的匿名化信息区分标准。由此,在平衡信息利用、信息保护的基础上实现个人信息保护目的中个人、社会及国家三重利益的良性互动,真正实现挖掘数据价值的同时保证信息安全。