OFDM系统中基于SNR估计的改进DFT信道估计算法*

2022-04-26周维海邓炳光

周维海,程 方,邓炳光,吴 婷

(重庆邮电大学 通信与信息工程学院,重庆 400065)

0 引 言

在无线通信系统中,对无线传输信道特性的认识和估计是实现各种无线通信系统传输的重要前提[1]。由于正交频分复用(Orthogonal Frequency Division Multiplexing,OFDM)技术抗干扰和多径能力强且频谱利用率高,在4G和最新的5G技术中得到了广泛的应用[2]。在信号传输过程中,因为信道环境的随机性和时变性,通信传输质量会受到很大影响[3]。为了保证接收端能够无失真地接收到发送端的信号,通常需要采用信道估计技术[4]。

针对OFDM系统,目前已经提出了多种信道估计方法[5]。工程实现中最常用的是基于最小二乘(Least Square,LS)的信道估计算法,其复杂度低,易实现,无需获取信道中相关的先验信息,但是没有考虑噪声的影响,信噪比较小时均方误差较大。基于线性最小均方误差[6](Linear Minimum Mean Squared,LMMSE)的信道估计算法虽然很好地抑制了噪声的影响,是目前基于导频信道估计算法中最优准则,但不足的是需要获取信道的先验信息,这在突发通信系统中是很难获得的,并且由于涉及大量的矩阵求逆过程导致算法复杂度较高,硬件实现起来非常困难[7]。相比于LS算法和LMMSE算法,基于离散傅里叶变换(Discrete Fourier Transform,DFT)的信道估计算法在噪声处理上有了一定的改善,硬件实现也并不复杂,性能介于两者之间,但不足的是传统的DFT算法只是去除了循环前缀(Cyclic Prefix,CP)外的噪声而没有滤除循环前缀内的噪声,并且没有考虑非整数倍时延信道下存在的能量泄露问题,这会影响算法的性能[8]。为抑制循环前缀内噪声的影响,很多学者提出了多种基于阈值门限的降噪方法来弥补传统DFT算法的不足,大多数方法是在循环前缀内设置阈值和判决门限来滤除噪声样本点,阈值的选取一般是基于循环前缀内外样本点的能量值和幅度模,以平均值[9]、最大值[10]或者中位数[11]的方式来设定阈值门限。这些方法往往没有考虑系统非整数倍时延信道下存在能量泄露的问题,而且无法很好解决在遇到突发大脉冲噪声影响的情况下阈值过大滤除有效数据,阈值过小无法滤除噪声的问题。文献[12]提出了一种基于训练序列进行信噪比(Signal-to-Noise Ratio,SNR)估计的改进DFT算法,可以有效应对突发通信系统中大脉冲噪声的影响,但是计算量较大,而且也没有考虑能量泄露的影响。

对于传统DFT算法无法合理选取阈值门限滤除循环前缀内噪声和非整数倍时延信道下存在能量泄露的影响,本文提出了一种通过估计信噪比来设定阈值门限的改进DFT算法。利用循环前缀外噪声样本与循环前缀内信号样本来估计系统的信噪比,然后结合估计出来的信噪比设置阈值门限,信噪比的估计过程中加入窗函数来达到同时抑制非整数倍时延信道下能量泄露对信噪比估计和DFT估计算法的影响。仿真结果表明,本文改进的算法有效滤除了循环前缀内的噪声,在非整数倍时延信道下抑制了频谱泄露的影响,具有较好的性能和更低的误码率。

1 系统模型

本文以基于导频的OFDM基带系统为研究对象,以瑞利多径衰落信道为模型。系统模型如图1所示。

图1 OFDM系统中基于导频的信道估计系统流程图

从图1可以看出,在OFDM系统发射端输入的二进制数据流经过调制、串并转换、插入导频、快速傅里叶逆变换(Inverse Fast Fourier Transform,IFFT)将N个子载波频域数据X(k)转换成时域数据X(n),然后再加上循环前缀,其长度通常大于最大信道延迟。IFFT变换公式如下:

(1)

经过并串转换后发送到多径信道,其信道的冲激响应可以表示为

(2)

式中:l为信道多径信道的径数,ai是第i条路径的振幅,τi是第i条路径的延迟。信号通过多径衰落信道并去除循环前缀后,与信道响应进行卷积运算得到的时域信号可表示为

y(n)=x(n)⊗h(n)+w(n)。

(3)

式中:w(n)为加性高斯白噪声。对式(3)对进行离散傅里叶变换得到频域信号为

Y(k)=X(k)H(k)+W(k),0≤k≤N-1。

(4)

式中:X(k)是发射信号,Y(k)是接收信号,H(k)是多径信道的频率响应,W(k)为频域中的噪声响应。

2 信道估计算法

2.1 传统基于LS的信道估计算法

LS算法是一种基础的信道估计算法,结构简单且复杂度较低。该算法估计的信道响应值由接收信号和发送信号决定。假设在OFDM系统中,X是发送端发送信号,H是信道的频域响应,W表示信道传输过程中加入的噪声,则接收端接收信号可表示为

Y=XH+W。

(5)

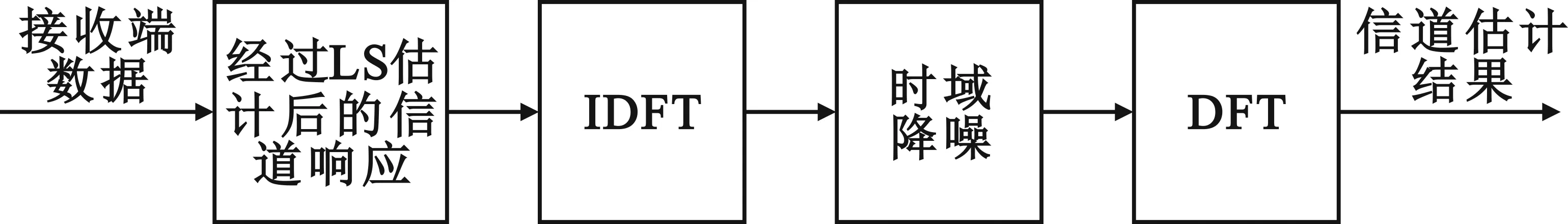

基于LS准则的信道估计值可以表示为

HLS=min[Y-XHLS]H[Y-XHLS]。

(6)

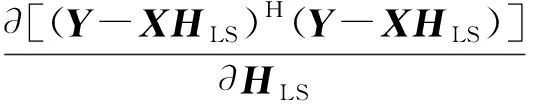

LS估计是在上述方程右侧找到最小的HLS,并求出上述公式的偏导数并使其为零,即

(7)

即可得到LS信道估计的解为

HLS=X-1Y=H+X-1W,

(8)

则信道估计的期望值为

E(HLS)=E(H+X-1W)=H。

(9)

可以看出LS信道估计是无偏的,算法结构简单,无需知道信道的先验信息。由于没有考虑噪声的影响,在噪声较大时性能较差,通常会在此算法的基础上进一步改进来降低噪声的影响。

2.2 传统基于DFT的信道估计算法

传统DFT信道估计算法将LS算法估计得到信道频域响应,先通过离散傅里叶反变换(Inverse Discrete Fourier Transform,IDFT)转换到时域进行降噪操作,把具有较高能量的样本点保留,循环前缀之外的点归零,然后再利用离散傅里叶变换将信道响应值变换到频域[13]。传统DFT信道估计算法流程如图2所示。

图2 传统DFT信道估计算法流程图

首先使用LS算法得到导频子载波的信道频率响应HLS,再利用逆离散傅里叶变换将导频频域信道响应转换到时域得到第n个样点的信道冲激响应(Channel Impulse Response,CIR),表示为

hLS(n)=IDFT[HLS(k)]=

(10)

式中:0≤n≤N-1,w(n)=IDFT(W(k)/X(k))。信道的有用CIR主要集中在循环前缀内前L个样本点上,并且在循环前缀之外仅包括噪声,可以得到

(11)

式中:L为信道冲激响应CIR长度且小于循环前缀的长度。由于现实系统中一般无法获知CIR长度,所以可以将循环前缀长度以外样本点的值设置为零来尽量消除噪声的影响。假设NCP为循环前缀的长度,可以得到

(12)

最后,通过离散傅里叶变换将信道响应变换到频域得到信道估计值如下:

(13)

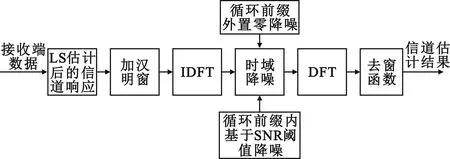

3 基于SNR估计的改进DFT算法

本文所提出的改进DFT算法核心是根据LS算法的导频序列估计系统的信噪比,再转化为阈值门限在时域进行二次降噪操作,其步骤流程如图2所示。

图2 本文改进的基于信噪比估计的DFT算法整体流程图

3.1 信噪比估计算法

系统的信噪比可由信号功率与噪声功率之间的比值得到。首先根据导频子载波通过最小二乘法估计获得导频的频域响应,估计结果HLS(k)可表示为

HLS(k)=Y(k)/X(k)=H(k)+W(k)/X(k)。

(14)

式中:k=0,1,…,N-1表示导频子载波序号。根据式(6)将HLS(k)通过离散傅里叶逆变换转换到时域得到hLS(n)。根据传统DFT算法原理可知,当n≥L时,hLS(n)=0,所以最后的N-L个采样点可以看作是噪声,但是可以用来估计噪声方差。由于CIR长度L通常小于循环前缀NCP的长度,因此可以使用NCP来代替L,则噪声功率表示如下:

(15)

理想状态下,这种方法在整数倍时延信道中可以得到更准确的估计值,然而在非整数倍时延信道中,IDFT变换过程中不仅会导致信号能量泄漏到hLS(n)的所有抽头也可能会造成噪声分量的能量泄漏,这给噪声估计带来了很大的干扰。当低信噪比较低时,对噪声估计的影响并不是很明显,但是随着信噪比的逐渐增加,噪声估计值会大大降低。为了得到准确的噪声方差估计结果,特别是在高信噪比条件下,本文提出了一种基于加窗的改进方法。

一般来说hLS(n)尾部会有一些残差信号分量,为了消除残差信号的影响设计噪声窗口范围为[NCP:N-NCP-1],此采样区间可看作全部都由噪声组成,则噪声功率可通过以下公式重新估计:

(16)

为了进一步消除由于信号多径传播造成信噪比增加时信号能量仍然会泄漏到噪声估计窗口导致精确度降低的影响,使用频域窗函数进一步降低能量泄露。相对于其他窗函数,汉宁窗与汉明窗简单实用且适用于未知信号,那么也适用于实际系统中受到噪声干扰的接收信号。另外,汉明窗的旁瓣和波动小,选择性较高,并且汉明窗由于加权系数与汉宁窗不同,旁瓣相对更小[14]。根据旁瓣越小泄露越少的原则可知汉明窗更能有效抑制能量泄露的影响,所以本文窗函数选择汉明窗,可表示为

(17)

将LS估计算法得到的导频频域响应与窗函数相乘可得

Hw(k)=HLS(k)·D(k)。

(18)

再进行IDFT变换得

hw(n)=IDFT(Hw(k))。

(19)

加窗函数后的噪声功率则可以表示为

(20)

由于CIR长度小于NCP长度,所以循环前缀内接收信号的功率可以表示为

(21)

计算平均信噪比可得

(22)

3.2 改进DFT算法

由SNR估计算法获得的信噪比可以用作信道估计的先验信息,因此可计算所接收的导频能量。根据Parseval定理,信号的能量可以通过时域集成和频域集成来获得。接收信号的总能量为

ER=ES+EN。

(23)

式中:ER代表接收的总能量,ES表示信号的能量,EN表示噪声的能量。根据Parseval定理可得

(24)

结合式(23)和式(24)可得

(25)

在这里用ER-cp表示为循环前缀内接收信号的总能量,ρav为上述SNR估计算法得到的平均信噪比。变换式(25)得

(26)

则循环前缀内采样点信号的平均能量为

(27)

(28)

多径信号的CIR幅度一般大于噪声的幅度,因此在去噪过程中只需选择CIR幅度较大的采样点,其余采样点应置零。由于循环前缀外得样本点基本都是噪声组成,全部置零;对于循环前缀内的噪声,采取ES-cp-av作为阈值门限来滤除CP内部的噪声,形式如公式(29)所示:

(29)

为防止突发系统中的大脉冲噪声分量无法滤除的情况,将再进行一次降噪操作。当ρav≤1 时,对于循环前缀内每个样本点来说,噪声分量的能量大于或者等于信号的能量,所以可以将ρav≤1的样本点置零,形式如下:

(30)

由于在SNR估计的过程中利用LS估计得到导频频域响应后,通过加汉明窗来抑制非整数倍时延信道下信号能量泄露对噪声估计的影响,当然频域加窗的效果同时可以抑制非整数倍时延信道下有用信号的能量泄露,从而进一步提高DFT改进算法的估计性能。在时域降噪后通过离散傅里叶变换并除以窗函数获取全部信道的频域响应:

HDFT(k)=HDFT-W2(k)/D(k)。

(31)

4 算法仿真分析

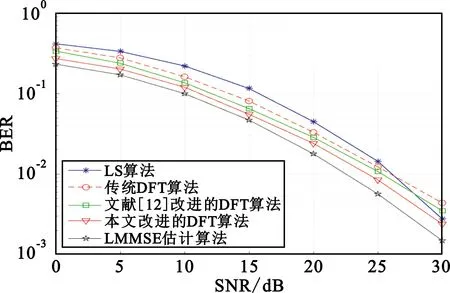

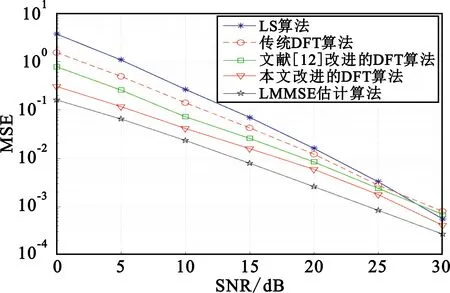

对本文所提的改进DFT信道估计算法在OFDM系统中进行仿真。根据要求,采用多径信道进行仿真,仿真参数如表1所示。分别比较了LS算法、传统DFT算法、文献[12]改进的DFT算法、LMMSE算法和本文基于SNR估计的改进DFT算法关于误码率(Bit Error Rate,BER)和均方误差(Mean Square Error,MSE)的仿真结果。

表1 系统仿真参数

当系统采样间隔为1 μs、多径时延分别为[0,2,4,8,12]μs时,即多径通道的时延为系统采样间隔的整数倍,不考虑能量泄漏的影响,五种算法在不同信噪比下的BER和MSE分别如图3和图4所示。由仿真分析可知,在相同的信噪比下,本文改进的DFT算法的BER和MSE均低于LS算法和传统DFT算法,同时可以看出循环前缀内降噪的效果也优于献[12]改进的DFT算法,进一步降低了BER和MSE。相比之下,本文提出的改进DFT算法最接近LMMSE信道估计算法的性能。

图3 整数倍时延信道下各种算法的误码率比较

图4 整数倍时延信道下各种算法的均方误差比较

当系统采样间隔为1 μs、多径时延分别为[0,1.4,2.2,4.1,7.4]μs时,即多径通道的时延为系统采样间隔的非整数倍时,考虑其造成的能量泄漏影响,五种算法在不同信噪比下的BER和MSE分别如图5和图6所示。由仿真分析可知,信噪比在25~30 dB之间的时候,传统的DFT算法和文献[12]改进的DFT算法的性能均低于LS算法性能,出现“误差平层”现象。这是由于信噪比低时噪声的影响大于频谱泄露的影响,此时降噪是提升系统性能的关键;但是当信噪比比较大,噪声的影响较小时,在时延为系统采样间隔非整数倍的情况下,频谱泄露成为影响系统性能的主要因素。从仿真结果可以看出,本文改进的DFT算法由于加窗函数的原因不仅提高了信噪比的估计精度,也有效抑制了频谱泄露对DFT算法的影响,性能好于传统DFT算法和文献[12]改进的DFT算法。

图5 非整数倍时延信道下各种算法的误码率比较

图6 非整数倍时延信道下各种算法的均方误差比较

5 结 论

本文针对传统DFT信道估计算法的不足提出了一种基于SNR估计的改进DFT估计算法。在基于LS算法的基础上,利用导频序列估计系统信噪比,将其转化为循环前缀内的降噪阈值门限,同时通过加窗函数的方法进一步提高系统在非整数倍时延信道下信噪比的估计精度和DFT算法的估计性能,并进行两次降噪操作进一步滤除突发大脉冲噪声系统下循环前缀内噪声分量较大的样本点。仿真结果表明,不管是在非整数倍时延信道下还是整数倍时延信道下,本文提出的基于SNR估计的改进DFT信道估计算法的性能都比文献[12]所提出来的改进DFT算法和传统的DFT算法有明显的提高。