对光源环境鲁棒的铣削表面粗糙度分类检测*

2022-04-26易怀安陈永伦陈秋嫦赵欣佳

易怀安,陈永伦,廖 晨,陈秋嫦,赵欣佳

(1.桂林理工大学a.机械与控制工程学院;b.信息科学与工程学院,桂林 541006;2.新疆大学信息科学与工程学院,乌鲁木齐 830046)

0 引言

表面粗糙度与机械零件的配合性、耐磨性、振动等密切相关,对机械产品的使用寿命和可靠性产生重要影响。传统针测法的金刚石触针易划伤被测表面,测量速度比较缓慢,不能满足对整个表面轮廓粗糙度的精确测量和在线测量,因此,基于机器视觉的粗糙度测量方法受到了学者们的重视。在机械加工过程中,不同的加工工艺会造成工件表面的纹理不一样。HARALICK等[1]研究了灰度色调的空间分布,认为纹理特征可分为规律和不规律等。对于不规律纹理的加工工件表面,YI等[2-3]提出基于RGB的色差算法和基于彩色图像奇异值熵的评价指标,构建出磨削表面粗糙度预测模型,并尝试从图像数理结构上寻找粗糙度的关联指标。LU等[4]设计纯色能量指标和两种光源混叠区域面积指标建立与粗糙度的对应关系模型。对于规律纹理的加工工件表面,TSAI等[5]研究铣削表面,提出5个表征粗糙度的特征量并输入神经网络中进行预测粗糙度。LEE等[6]在结合车削加工工艺参数的情况下,通过神经网络对车削加工表面进行粗糙度检测。DHANASEKAR等[7]将文献[6]的频谱特征指标以及加工工艺参数输入神经网络对较大粗糙度范围的铣削试样进行了预测。由此可见,基于机器视觉的表面粗糙度检测都要经过人为地设计图像的评价指标,且大多要结合加工工艺参数进行。

另外,虽然很多文章里没有直接说明,但拍摄光源环境对特征指标的提取有很大的影响,如YI等[8]提出的红绿色差指标和ZHANG等[9]提出的迁移学习粗糙度预测模型,都受到光亮的影响。而近年卷积神经网络(CNN网络)领域,KRIZHEVSKY等[10]提出的AlexNet模型和HE等[11-12]提出的ResNet和ResNet-v2模型都在图片分类大赛中有90%以上的分类准确率,究其原因是CNN网络有特征自提取的优点[13],但目前CNN网络结合微观表面粗糙度进行的研究并不多。

综上所述,由于目前所存在粗糙度检测方法的问题仍没有一个完美的解决方案,本文提出一种基于CNN网络的铣削表面粗糙度分类方法,它能够进行特征自提取,不需要人为设计指标,亦不需要结合工艺参数来进行模型构建。更重要的是,本文提出的方法对光源环境具有很好的鲁棒性,不需要进行固定的某个光照进行拍摄采集照片,在一定光强范围都可行,能够达到工业生产的要求。

1 基于卷积神经网络视觉粗糙度测量原理

1.1 卷积运算

卷积操作[13]在图像领域的运算原理和过程如图1所示。

(a) 5×5大小图片 (b) 3×3滤波器 (c) 卷积结果图1 卷积过程演示

1.2 Xception模型及网络主要参数

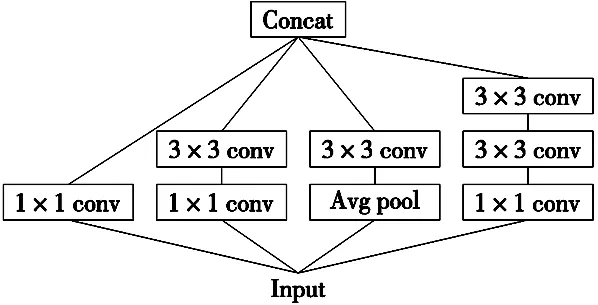

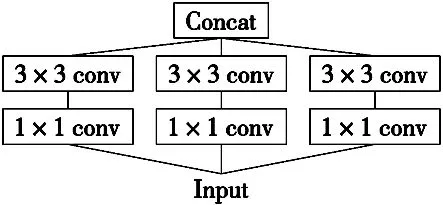

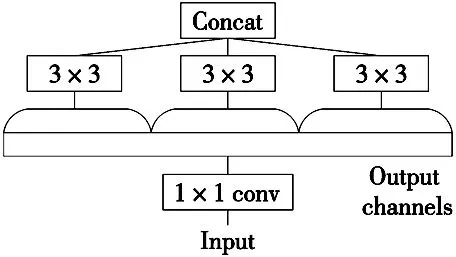

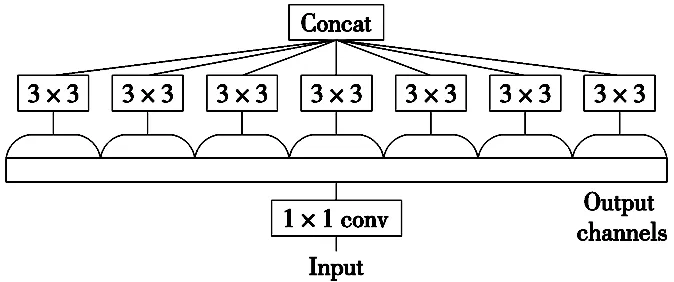

Xception,即深度可分离卷积。Xception模型包含36个卷积层,模型参照深度可分卷积[14]的特点,对输入数据的每个通道独立进行空间逐层卷积,再对其结果进行逐点卷积。由InceptionV3到Xception的结构改进过程[15]如图2所示。 其中,InceptionV3的结构图如图2a所示。对InceptionV3进行简化,去掉InceptionV3中的Avg Pool操作后,输入的下一步操作就是1×1卷积,如图2b所示。提取1×1卷积公共部分如图2c所示。而对于Xception,则是先进行普通卷积操作,再对1×1卷积后的每一个channel分别进行3×3的卷积操作,结果输出如图2d所示。

(a) 原始的Inception模块

(b) 简化形式

(c) 等价形式

(d) Xception基本模块图2 InceptionV3到Xception的结构改进过程

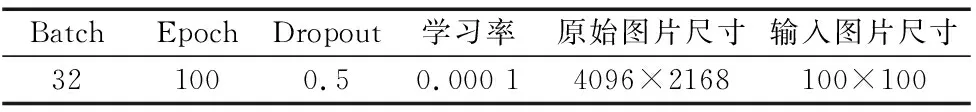

实验图片的尺寸为4096×2168像素,经预处理后尺寸变为100×100像素进行模型训练。网络中的图像特征不需要复杂精准的数学表达,通过大量的样本,网络能学习该数据潜在的映射关系,从而实现特征自提取。训练模型的过程中,可视化工具Tensorboard能实时更新epoch的准确率和损失函数的对应图像。主要参数如表1所示。

表1 网络主要参数

CNN网络训练时,损失函数采用categorical_crossentropy分类交叉熵函数,计算如式(1)所示。其中n是样本数,m是分类数,CNN训练过程保存精度最高的模型。

(1)

2 实验

实验包括铣削试样的制备、实验装置的设计、铣削样本图像拍摄、数据预处理和卷积神经网络程序的设计。

2.1 样品制备

60×40 mm2铣削样品由FANUC Series Oi Mate-MD型数控机床配合盘刀加工而成,用Talysurf pgi800型触针式粗糙度计在各试样表面上进行了6次均匀分布的测量。

2.2 实验装置设计

图3 机器视觉粗糙度测量装置

实验时,试样和光源的相对位置保持不变,相机的位置在离测量平台25 cm处。为了证明该方法对光源的鲁棒性较好,实验分别在晚上较暗的环境和白天明亮的环境进行。机器视觉粗糙度测量装置如图3所示。

2.3 数据预处理及样本集划分

实验图像通过数据增强,如图4所示。图4a为图像原图,图片大小为4096×2168像素,图4b~图4d的图片大小为100×100像素。

(a) 原图 (b) 缩放

(c) 旋转 (d) 调整饱和度

基于触针式粗糙度测量仪和铣削工件表面形貌的固有特点,在不同位置测量得到的粗糙度值具有随机波动性,故论文采用粗糙度分类的方法,类比工程制图0.8、1.6、3.2、6.3 μm的粗糙度等级划分,即把等级划分为0~0.8 μm,0.8~1.6 μm,1.6~3.2 μm,3.2~6.3 μm等。为证明本次实验和模型的稳定性,本文将粗糙度分类设计为6类和12类两种情况,即0.6~1.4 μm,1.4~2.2 μm,2.2~3.0 μm,3.0~3.8 μm,3.8~4.6 μm,4.6~5.0 μm(6类),0.6~1.0 μm,1.0~1.4 μm,…,4.2~4.6 μm,4.6~5.0 μm(12类),如表2和表3所示。按以上两种粗糙度的分类方法已经可以满足现有的工业生产要求,若还需更精密的测量和分类,在增加样本数据集的前提下,粗糙度的类别还能继续细分。

网络训练中,样本集可以划分为训练集和测试集。将铣削工件表面图像的训练集和测试集的比例为8:2,在本次实验中为了均衡采样训练和测试,在表2和表3中分别从各粗糙度分布中按该比例划分。

表2 数据增强后样本的分类和数量统计(6类)

表3 数据增强后样本的分类和数量统计(12类)

2.4 程序设计

依据主流模型结构的特点,深度学习网络参照相应数据集大小以及图像对应类别和特征来进行构建。实验采用Tensorflow框架,Xception模型,为了让模型训练的计算量小,且卷积计算的特殊性,一般采用较小尺寸的实验图片输入。

本文设计了训练和测试的卷积神经网络模型,整体结构如图5所示。由CCD工业相机对铣削样品的表面进行图像采集,实验图像通过2.3节所述方法进行数据增强,即数据预处理。随后将预处理好的数据集导入CNN网络Xception模型中训练,训练集和验证集的损失值都在设定的范围内,即损失函数收敛,程序结束。若损失函数不收敛,则程序会自动返回到全连接层继续训练,直到得到理想的结果。

图5 网络模型整体结构图

3 实验结果与分析

相对于灰度图片,利用 RGB 图像通常可以获得更准确和高级的综合特征,增加输入的多样性并且提高特征的复杂度,通过Xception模型进行训练,得到CNN网络训练损失曲线,包括训练集和验证集。其中样本分为6类和12类两种情况的实验结果分别如图6、图7和图8、图9所示。

3.1 样本分为6类时

图6 CNN网络训练损失曲线(6类) 图7 CNN网络训练准确率曲线(6类)

图6、图7中的浅色线是训练集的训练曲线,深色线是验证集的训练曲线,其中虚线表示Smoothing之前的训练曲线,实线表示Smoothing取值为0.498的训练曲线(下文的图同)。从图6可以看出,训练次数为3200次以后,CNN网络训练损失函数较小且基本平稳不增。但网络训练也要结合模型识别正确率,从图7可以发现,训练次数为3200次以后训练集和测试集的准确率较高,训练集的准确率可以达到100%,验证集准确率可以达到99.97%。由于模型训练时,训练集和验证集会有小幅度波动,所以验证集准确率达到100%也属正常。

在进行测试集测试时,用于模型训练的预处理后的照片有2840张照片,另外没有参与模型训练的照片284张用于测试,准确率达到97.89%,对比之下,达到理想效果。

3.2 样本分为12类时

图8 CNN网络训练损失曲线(12类) 图9 CNN网络训练准确率曲线(12类)

同样的,从图8可以看出,训练次数为3200次以后,CNN网络训练损失函数较小且基本平稳不增。但网络训练也要结合模型识别正确率,从图9可以发现,训练次数为3200次以后训练集和测试集的准确率较高,训练集的准确率可以达到100%,验证集准确率可以达到98.82%。

在进行测试集测试时,用于模型训练的预处理后的照片有2840张照片,另外没有参与模型训练的照片284张用于测试,准确率达到98.59%,对比之下,达到理想效果。

3.3 光源环境的鲁棒性评估

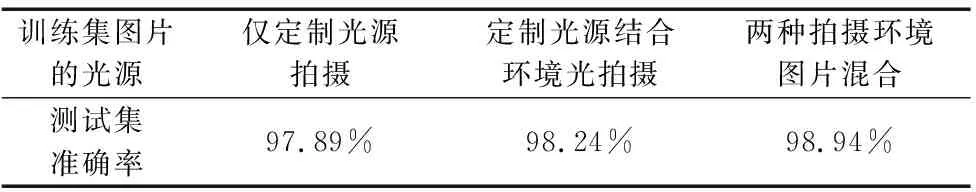

传统的机器视觉方法检测粗糙度方法,不仅在预测准确率上有较大偏差,对光源环境非常依赖。YI等[2-3,8]构建了粗糙度预测模型,ZHANG等[16]基于模拟数据和传递核学习的视觉粗糙度测量方法,所拍摄的图片都是源于黑暗环境并采用定制光源进行拍摄,目的是为了避免其他的光线对实验的影响,鲁棒性较差。而本文基于卷积神经网络的方法,不仅预测准确率有较为理想的效果,且对光源环境的鲁棒性很好。以下将用3组实验进行证明,实验样本图片包括仅用定制光源进行拍摄(黑夜),定制光源结合环境光进行拍摄(白天)。设计的3组实验用于训练得到模型,数据集光源环境如表4所示。

表4 拍摄的光源环境和用于分类验证的数据集

将3组实验得到的数据集(A、B数据集全部,C数据集的8/10)分别导入神经网络中得到了对应的模型。然后将数据集B导入实验1的模型进行分类,将数据集A导入实验2的模型进行分类,将数据集C剩下的2/10部分导入实验3的模型进行分类。3组实验CNN网络训练的曲线及相关数据如图10所示。

(a) 仅定制光源拍摄准确率曲线 (b) 定制光源结合环境光拍摄准确率曲线

(c) 两种拍摄环境图片混合训练准确率曲线

对以上3组实验的数据进行分析,3组的验证集准确率很相近,分别为99.97%、99.82%、99.79%;测试集的数据数量相同,准确率分别为97.89%、98.24%、98.94%。3组不同光源环境得到的数据集,采用本文方法进行训练及分类,得到3组分类准确率很接近的实验结果。足以证明,该方法对光源环境依赖较小,显示良好的光源鲁棒性。

4 讨论

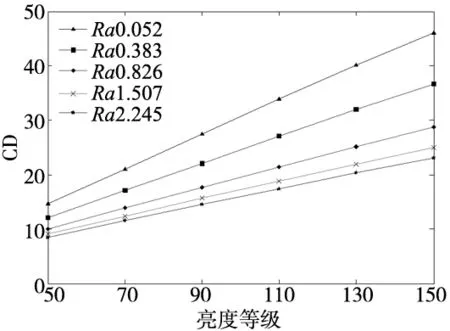

第3.1节展示了本文所使用的方法对拍摄的光源环境鲁棒性较好,而大多数的机器视觉方法光源环境对图像特征指标影响非常大,原因是检测机理不一样。例如YI等[2]提出的CD指标,其光照强度与CD指标的关系,如图11所示,从中可看到同一粗糙度在不同亮度下CD值的线性变化。粗糙度参数Ra和CD指标均属于统计参数,由于随机性问题,所以无法在图像特征指标和粗糙度参数之间构建严格的数学模型。而对于文献[3]的QE指标,该指标虽然尝试从数理意义上解决指标的数据结构问题,但是由于该指标是基于能量信息分布的,必定受光源环境的影响,限制了其对光源环境的适应性。

图11 光照强度与指标的关系

而本文提出的基于卷积神经网络的分类方法基于Tensorflow框架结合Xception模型,通过卷积层中的低层提取一些局部、抽象的特征,网络的高层将低层特征图进行组合进而提取一些全局、具体的特征。卷积层和池化层能够响应输入特征的平移不变性,即能够识别位于空间不同位置的相近特征。重要的是这些特征是试样固有的,与光照没有关系,因此在不同的光源环境下检测精度具有较大的鲁棒性。另外,在卷积层和隐含层中,通过层传递学习,保存推理并在后续层上创建新的推理。使得用该算法进行粗糙度检测时,无需进行特征提取,而是在训练过程中完成。3组实验的测试集准确率如表5所示。验证了本文方法的光源鲁棒性较好。

表5 鲁棒性评估实验及其准确率

5 结论

(1)基于卷积神经网格的铣削表面粗糙度视觉检测是一种精度较高的粗糙度分类方法,将同样的数据集图片输入Xception模型,输出结果为6类和12类粗糙度测试集,测试集正确率均超过98%。

(2)预测模型自动提取图像特征且无需结合加工工艺参数,以及测试集的正确率验证了该方法的优势和可行性。

(3)通过不同的光源环境对模型的分类准确率测试,证明模型对光源环境具有很好的鲁棒性,为工业生产不同光源环境下在线视觉检测提供了技术保障。