PS-DenseNet下的代数模型遥感图像场景分类研究

2022-04-23张明波

陈 垚,张明波

(1.广安职业技术学院,四川 广安 638000;2.江西财经大学统计学院,江西 南充 330000)

1 引 言

伴随遥感科技的飞速发展,遥感图像[1]逐步成为军事目标监测、土地规划和环境分析等诸多领域的重要依据。海量的遥感图像所包含的数据亟待被识别和解析,而遥感图像场景分类可直观地表达图像,其准确度直接影响后续场景解译质量以及相关目标物的获取。遥感图像场景不止涵盖了形态、颜色与纹理等数据,还囊括了众多语义层数据,使得自动分类的难度大大增加。

现有的很多遥感图像场景分类方法往往基于图像的底层特征[2],如:纹理、边缘、颜色等,根据工程应用场景的不同,针对性地采用人工特征获取的方式,因此,所获得的场景分类方法适应性与鲁棒性不佳。

伴随神经网络和机器学习方法的深度发展,神经网络逐步成为机器视觉领域强有力的技术之一,不少科研者尝试将其运用在遥感图像场景分类的领域中,获得了良好的效果。Rajendran[3]采用Alexnet完成遥感图像场景分类,该方法巧妙地训练了浅层神经网络,能够迅速完成分类,但准确度有待提升;Liu[4]提出将VGG-19网络设计在场景分类的线性变换部分,该方法的分类准确度得到提升,但不能满足遥感图像场景中的复杂空间与局部架构数据间的关联;Yan[5]选用集合子网络的Googlenet,该方法在完成场景分类任务时能分别处理低复杂度与高复杂度遥感图像,但主网络与辅助分支网络的结合度不佳,需要大量的训练图像集;Zhu[6]结合Resnet的思想并结合深浅层CNN实现多复杂度的遥感图像分类,但该方法的网络结构复杂,层数较深带来分类效率低的问题;吴晨[7]结合卷积特征与稀疏编码的方式,获得初始特征图,并在自动编码装置中完成分类,该方法能实现简单遥感场景的分类,复杂场景效果差。

实现遥感图像的场景分类在于获取充分的遥感图像特征,本文采用Lie group代数模型和PS-DenseNet分别提取遥感图像的底层特征和高层特征,并在交叉熵损失模型的基础上完成改进,可针对易和难分类的样本分别削弱和增强权值,从而加强难分类样本的重视度。

2 Lie group代数模型与Densenet网络分析

2.1 Lie group代数模型分析

大多数工程问题均可转换为数学模型的分析,因此可用代数方法辅助解决。为提升遥感图像的分类准确性,可引入Lie group代数模型[8]可获取底层特征并降低特征维度。Lie group代数模型可表述无穷小变换的代数架构,存在特殊的线性结构,可构建在Lie group胞元处的切集。将Lie代数元a转换为相应的Lie group胞元阵A可实现很多非线性[9]到线性[10]间的变化,并可表示为指数模型exp:k→K与对数模型:LOG。

(1)

将Lie group胞元A转换到相应的胞元空间M的映射为LOG:

(2)

由于矩阵[11]是图像的数据或特征表述的集合,而在机器视觉中常见的矩阵群(协方差矩阵、旋转阵和仿射阵等)均具有Lie group代数模型的相关性质。针对Lie group矩阵S(3),该矩阵包含单个集合与二元计算,此模型应具备四个特征:封闭特征、结合性、玄元特征与逆特征。令正交约束RRT=1,detR=1,R1,R2,R3∈S(3),表1给出Lie group矩阵的相关性质。

表1 Lie group矩阵的相关性质

2.2 Densenet网络分析

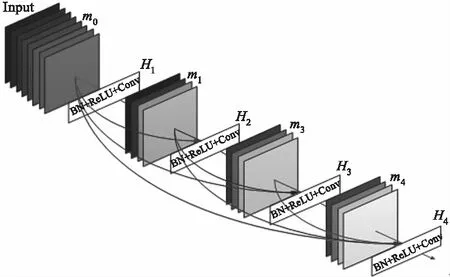

Densenet[12](密集连接深度网络)是基于Resnet[13](残差网络)的优化。Densenet应用跨层衔接模式获取参数训练过程中不同层的特征图,并将Alexnet、VGGnet、Resnet等传统网络中未充分应用的特征加载入新层中,从而实现了中底层优化信息的效应,实现获取样本特征的功能。此外,采用密集连接模式能增强层间的数据流动性,提升网络功能,削减网络参量。密集连接架构如图1所示。Densenet可将全部网络层所输出的特征用作当前网络层的输入,即m0,m1,…,mi-1,根据复合解析式Hi可获得输入mi,如公式(3)所示:

mi=Hi([m0,m1,…,mi-1])

(3)

复合解析式Hi可视为通过BN(批处理),ReLU激活函数与卷积处理连续操作的Dense Block架构。

图1 密集连接架构

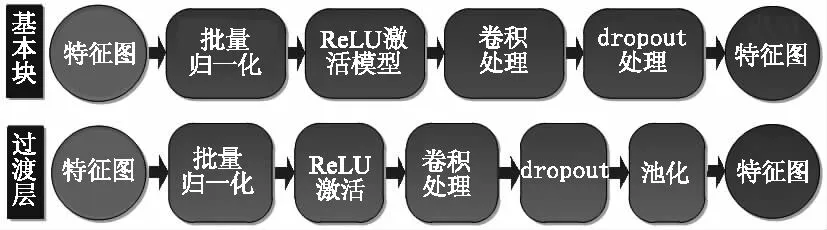

Densenet是由dense block架构和transition层组成,从图1中可知,在Densenet中任意层与后继层间的衔接均为密集连接,dense block作为基本块能够削弱梯度弥散作用的同时加强特征传送,而过度层则位于dense block间,可削弱密集块所输出的通道数,从而提升效率,如图2所示为dense block和transition层的结构。

图2 Dense block和transition层的结构

3 DenseNet下的代数模型遥感图像场景分类

3.1 遥感图像场景特征提取和融合

由于遥感图像中所包含的地物数据多样、空间布置复杂性高,因此,实现遥感图像的场景分类不仅在于获取充分的遥感图像特征,而且应完成遥感图像特征的准确表述。

3.1.1 Lie group代数模型提取底层特征

遥感图像底层特征涉及到纹理、形状、亮度、颜色和对比度等特征,而上述特征均可用代数模型表述相应的特征概念。将上述底层特征的Lie group代数模型相结合可构成矩阵模式,从而将遥感图像的各像素点结合为数据量丰富的向量模式,采用Lie group代数模型提取底层特征不仅维度较小而且能在图像分类中激发出较好的效能。Lie group作为微分流形,能实现遥感图像几何特征的有效表述,而矩阵模式与传统矢量空间存在差别,具有更多的特征数据。基于此,本文选用正定对称矩阵模式表述遥感图像。

将遥感图像Y表达为u×v,采用(p,q)代表像素点,式中的p=0,1,…,u-1,q=0,1,…,v-1,则各像素能采用Y(p,q)表达,可将遥感图像特征K表述为公式(4):

K(p,q)=λ(Y,p,q)

(4)

(5)

(6)

(7)

(8)

(9)

(10)

式中,Y(p,q)是像素点(p,q)的像素值;∂Y(p,q)/∂p是像素点(p,q)的p方向一阶梯度;∂2Y(p,q)/∂2p是像素点(p,q)的p方向二阶梯度;

3.1.2 PS-DenseNet下提取高层特征

通过深度网络模型可训练海量遥感图像样本特征,使模型具备较强的自学习功能,从而自动获取丰富的图像特征。Densenet网络模型具备优秀的学习效力,结合卷积层、池化层与全连接层可提取遥感图像的抽象特征,从而表达高层深度特征,不仅能直接将其完成分类,也可将其用于后续处理。Densenet模型由四个dense层构成,各个Dense层均有多个Dense block构成。为优化Densenet各卷积层的输入仅为前端卷积层的简单组合,并考量特征通道间的联系程度,本文在Densenet40的基础上添加PS“Press and Stimulate”模块,如图3给出。各卷积层的结果特征图通过“加压”处理(LPS(·)),由空间维度完成相应的特征压缩,可把各通道的二维特征图转换成实数,则第z层的第w个特征图Mz,w加压进程如公式(11)所示:

(11)

式(11)中的K与G分别代表特征图的宽度与高度;“激发”处理(LST(·))则包含两组全连接层,对各通道特征赋予权值,其激发进程如公式(12)所示:

=λ(β2η(β1))

(12)

(13)

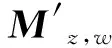

图3 PS-DenseNet下的高层特征提取

3.1.3 特征融合模块

如图4所示,特征融合[15]部分利用标准卷积完成底层特征的处理,得到输出特征图Ma;串行标准卷积和深度卷积处理高层特征,获得输出特征图Mb,进而将Ma与Mb相融合,获得融合特征图Mc。

图4 特征融合模块

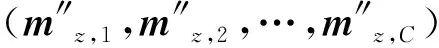

3.2 分类模块

分类模块采用softmax模型,如图5所示,将上层的节点与全连接层的神经元衔接,整合底层与高层特征图,从而将二维特征图变换成一维的特征参量,该特征参量能够表现成图像的全局数据,从而完成图像分类,其数学模型如公式(14)所示:

ml=f(ulml-1+bl)

(14)

其中,ul是全连接层的权值;bl是全连接层偏置参量;ml-1是前层的输出特征图。采用Sigmoid为全连接层的激活解析式,最后连接softmax解析式,从而预测各类的概率,其模型为公式(15):

(15)

其中,θ=(θ0,θ1,…,θN-1)为待优化参量;y(i)为第i个特征样本标签;m(i)为第i个样本;N为N个不同的标签类;d(m(i))为第i个样本的输出结果,采用归一化方法完成处理,可得概率和值为1。

图5 Softmax分类模型

3.3 参数训练

在深度学习的过程中,科学的代价函数选择能够在不断调整参数的过程中优化网络模型,从而使所设计的深度学习网络能够完成较为精准的遥感图像场景分类。本文采用焦点损失函数完成参数学习,该模型是在交叉熵损失模型(如公式(16))基础上的改进,如公式(17)所示:

LJC=-alna′-(1-a)ln(1-a′)

(16)

其中,a∈[0,1]为真实值;a′为预测值。

LJD(ητ)=α(1-ητ)puln(ητ)

(17)

式中,α(1-ητ)pu代表交叉熵损失模型相应的权值;ητ是特征值相应的τ类预判机率;pu是相应的惩罚项;α值介于0与1间,代表权重参量,可平衡易与难分类的重要度,根据经验可知;pu为2,α值为0.6。

本文所选用的焦点代价函数可对易和难分类的样本分别削弱和增强权值,从而完成加强难分类样本的重视度。

4 对比实验分析

4.1 实验数据集和设置

为校验本文方法的有效性,采用两类数据集完成验证,所选取的数据集包含UC Merced Land Use与SIRI WHU完成校验。

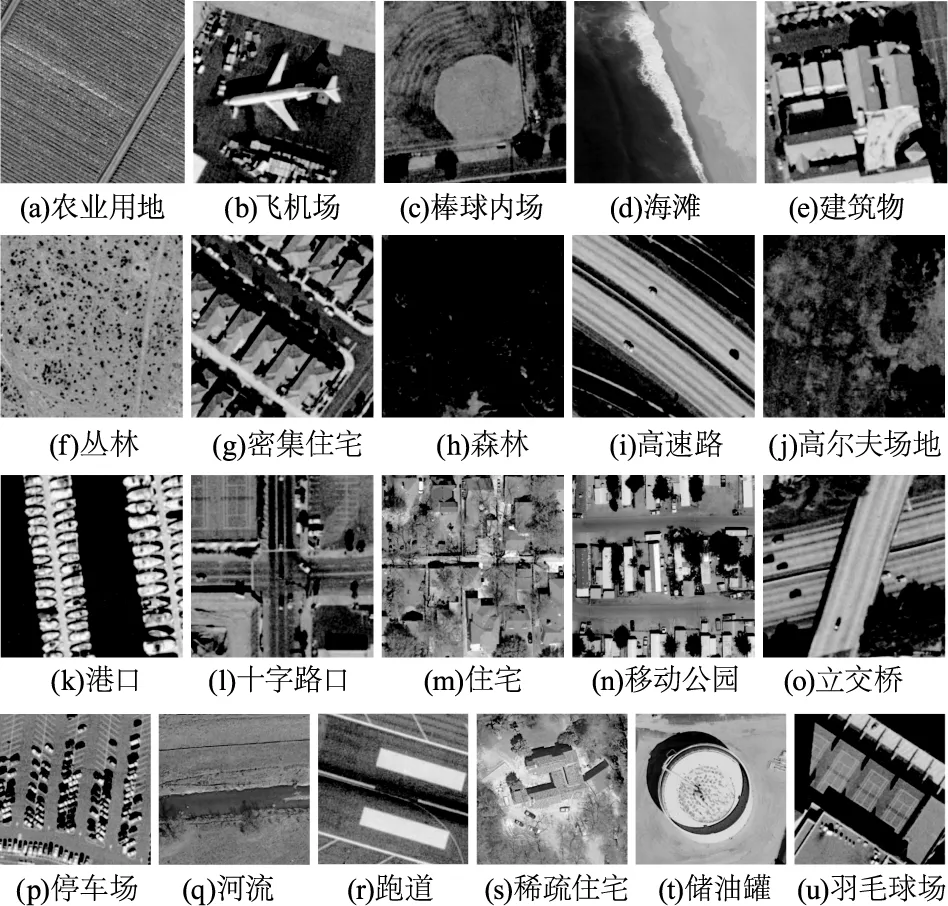

UC Merced Land Use(UCMLU)集生成于USGS的城市地图,共包含21类所获取的遥感正射图像场景,各类场景由100张256×256的图像构成,其空间分辨率均为0.3 m。此数据集包含若干个相似度和重叠度较高的场景、空间模式丰富,使得数据集更具完善性与挑战性。图6为每类场景的图像示例,本文随机选取各类图像中的70张用作训练样本,30张用作测试样本。

图6 UCMLU遥感图像集

SIRI WHU集生成于谷歌地球,共包含12类遥感图像场景,各类场景由200张200×200的图像构成,其空间分辨率均为2 m。此数据集存在更丰富的视角状态、光照情况与空间布局等因素,带来场景内图像差别大和场景间图像差别小的状况,对所提遥感图像场景分类方法带来了挑战。图7为每类场景的图像示例,本文随机选取各类图像中的150张用作训练样本,50张用作测试样本。

图7 SIRI WHU遥感图像集

本文的实验环境为Intel I7-10700KF 主频为3.7GHz的8核16线程CPU处理器,MX350显卡,采用Iris Plus核显,8GB运行内存,在windows 10系统中,加载Matlab 2020a完成本文方法的实验仿真和与现有的优秀分类方法[5-6]的准确度对比。

4.2 遥感图像分类指标

4.2.1 指标解析

为校验本文方法的遥感图像场景的分类准确度,给出本文方法的混淆阵列及三种方法在UCMLU与SIRI WHU数据集下的整体与平均分类的精准度(Overall Classification Accuracy,OCA)和Kappa参数,从数据出发,以客观指标的角度完成本文方法分类准确度的综合评判。

整体分类精准度代表某数据集中全部实现正确分类的遥感图像数目与所验证的全部图像数的比例,如公式(18)给出。公式中的RC和OP分别为某数据集某一类中被正确分类的样本数目和某一类中总体的样本数目,J为某数据集的样本类别数。

(18)

(19)

表2所示为Kappa参数与分类一致度的关联。

表2 Kappa参数与分类一致度的关联

4.2.2 实验结果

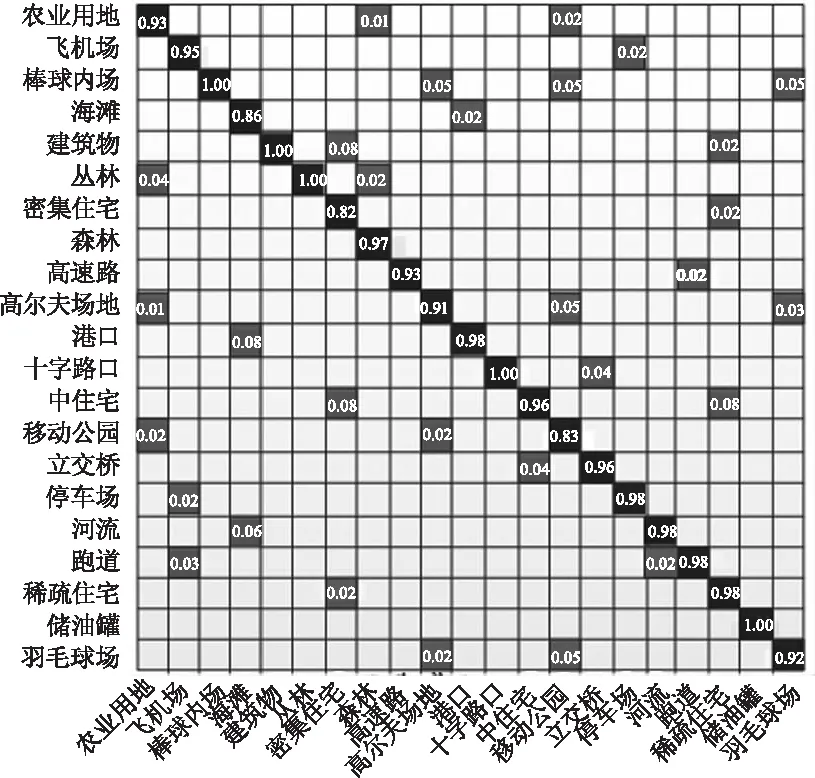

图8给出本文方法在UCMLU数据集下的混淆矩阵,在该阵列中,每行的信息代表相同场景的样本被预判成每个类别的比例,图中的空白部分标示成0,斜对角的信息则代表各类场景能够被正确预判的比率。从图中可知,采用本文方法能够得到较高的分类精准度,各类的分类精准度均高于0.8,并且棒球内场、建筑物、丛林、十字路口和储油罐的分类精准度均达到1,而且稀疏型、中等和密集型住宅区等场景存在相似度高、密集度低的特点,本文方法均取得了较好的分类效果。

图8 本文方法在UCMLU数据集下的混淆矩阵

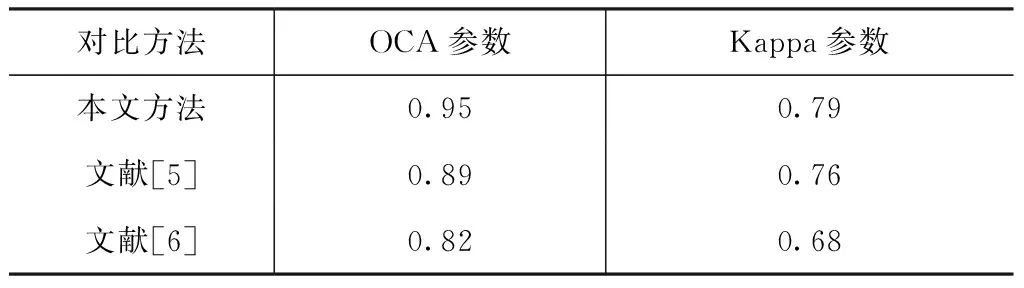

表3给出本文方法与方法[5]、[6]方法的指标对比,在UCMLU数据集中完成验证。实验结果表明,本文方法的OCA参数和Kappa参数均优于其他两种方法,这是由于文献[5]方法的主网络与辅助分支网络的结合度不佳,带来算法分类精准度欠佳的问题;文献[6]方法结合Resnet的思想并结合深浅层CNN实现多复杂度的遥感图像分类,但该方法的网络结构复杂,层数较深易带来分类效率低的问题。

表3 UCMLU数据集中的本文方法与文献[5]、[6]方法的指标对比

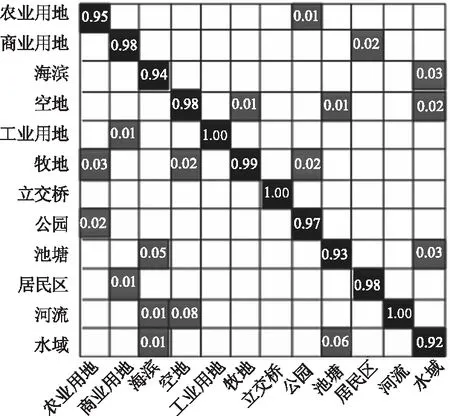

图9给出本文方法在SIRI WHU数据集下的混淆矩阵,在该阵列中,每行的信息代表相同场景的样本被预判成每个类别的比例,图中的空白部分标示成0,斜对角的信息则代表各类场景能够被正确预判的比率。从图中可知,采用本文方法能够得到较高的分类精准度,各类的分类精准度均高于0.9,并且工业用地、立交桥和河流的分类精准度均达到1,相对于UCMLU数据集由于场景类别数目偏少,使得整体精度得到提升。但一些遥感场景间存在相似性很难区分,例如水域边由于植物、石头等物体的覆盖易被识别为池塘。

图9 本文方法在SIRI WHU数据集下的混淆矩阵

表4给出本文方法与文献[5]、[6]方法的指标对比,在SIRI WHU数据集中完成验证。实验结果表明,本文方法的OCA参数和Kappa参数均优于其他两种方法,这是由于文献[5]方法难以实验遥感图像场景被遮掩后不易辨别的状况,该方法预测的适应性有限;文献[6]方法由于自身泛化能力有待增强,适应变化场景的能力有待提升。

表4 UCMLU数据集中的本文方法与文献[5]、[6]方法的指标对比

4.3 算法性能对比实验

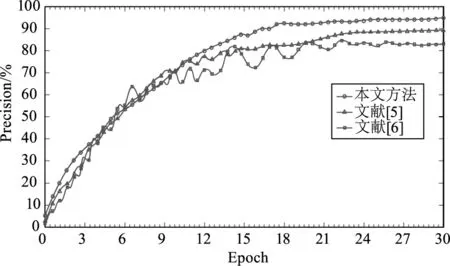

在UCMLU数据集中校验本文方法和文献[5]、[6]方法在三种网络模型上的效能对比,以Batch作为单位把数据集传送到模型张,Batch和epoch分别设成16和30,实现单个epoch应完成100次iteration,网络的初始学习率设定为0.001。图10和图11为训练进程中的准确度(Precision)和损失值(Loss)随epoch增加的变化状态。从图10中可以看出本文方法相对于其他两种方法能在较少的epoch中达到稳定状态,并且精准度较高,这是由于本文方法能够充分提取遥感图像中所包含的地物和空间数据。

图10 训练进程中的准确度随epoch增加的变化状态

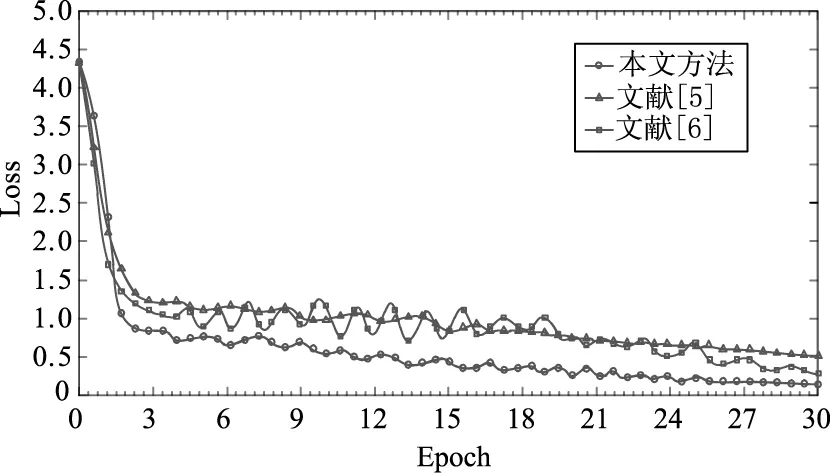

从图11中可知随着epoch的增加,本文方法的损失值逐步减少。这是由于本文方法所选择的代价函数选择能够在不断调整参数的过程中优化网络模型。

图11 训练进程中的损失值随epoch增加的变化状态

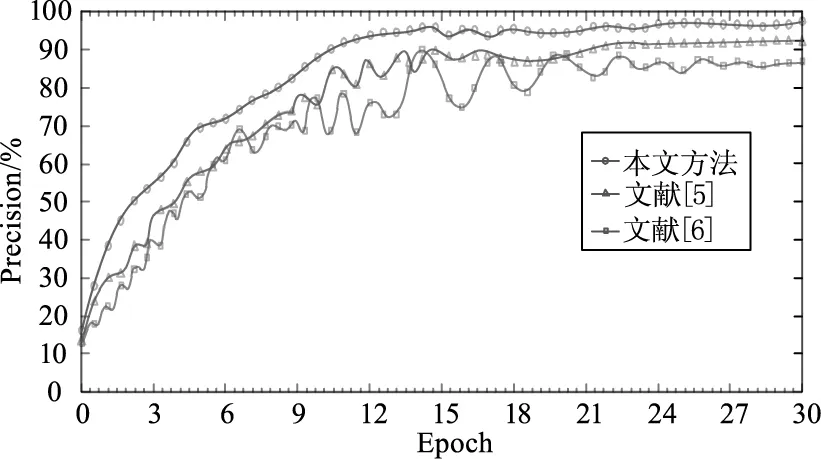

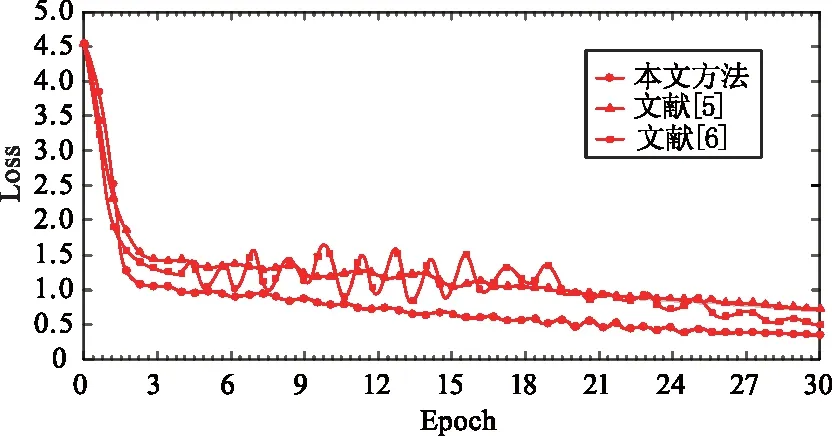

在SIRI WHU数据集中校验本文方法和文献[5]、[6]方法在三种网络模型上的效能对比,图12和图13为训练进程中的准确度(Precision)和损失值(Loss)随epoch增加的变化状态。从实验结果可以看出在不同的数据集中,本文方法和其他两种方法相比鲁棒性和稳定性好。

图12 训练进程中的准确度随epoch增加的变化状态

图13 训练进程中的损失值随epoch增加的变化状态

5 结 论

实现复杂遥感图像的场景分类对发掘有价值的遥感数据具有重要的价值。由于大多数工程问题均可转换为数学模型的分析,因此,本文引入代数方法辅助解决。为提升遥感图像的分类准确性,引入了Lie group代数模型可获取底层特征并降低特征维度,并在Densenet网络的基础上,设计PS-DenseNet网络提取高层特征。通过深度网络模型可训练海量遥感图像样本特征,使模型具备较强的自学习功能,从而自动获取丰富的图像特征。将上层的节点与全连接层的神经元衔接,整合底层与高层特征图,可将二维特征图变换成一维的特征参量,从而完成图像分类。

为校验本文方法的有效性,采用两类数据集,包含UC Merced Land Use与SIRI WHU完成校验。并给出本文方法的混淆阵列及三种方法在UCMLU与SIRI WHU数据集下的整体与平均分类的精准度(Overall Classification Accuracy,OCA)和Kappa参数,从数据出发,以客观指标的角度完成本文方法分类准确度的综合评判。实验结果表明,本文方法能够得到较高的分类精准度,较优的OCA参数和Kappa参数,并且随着epoch的增加,本文方法的损失值逐步减少。