基于视频图像的公路隧道火灾烟雾检测

2022-03-10邓实强陈建忠

邓实强,丁 浩,杨 孟,刘 帅,陈建忠

(1.重庆交通大学土木工程学院,重庆 400074;2.招商局重庆交通科研设计院有限公司,重庆 400067)

0 引言

随着我国公路建设的完善,公路工程已从大规模建设阶段转向运营养护阶段。目前,我国是世界上公路隧道发展最快、数量最多、形式最复杂的国家,截至2019年底,我国进入运营养护阶段的隧道已有19 067处、18 966.6 km,且每年以10%左右的速度增长[1]。由于公路隧道空间小、封闭性强,使得隧道发生火灾事故时,火灾趋势与规模发展迅速,将威胁隧道内行车人员生命财产安全,而且会对隧道设施设备以及结构造成破坏,严重影响隧道运营[2]。现阶段隧道火灾灾情获取主要依靠消防队员到达现场后抵近侦察,一方面会威胁侦查人员的安全;另一方面,灾情信息获取不及时,不利于现场指挥快速决策,导致救援队伍和装备调度滞后,可能引发二次灾害,造成更大的伤亡和损失。为保障公路隧道运营安全,有必要对隧道火灾烟雾发生进行识别、报警、监测。

传统感烟探测器检测原理是当周围空气中的烟雾体积分数达到预设的报警值时启动报警[3]。然而在隧道内,由于早期烟雾的扩散速度慢,加之空气流动对烟雾粒子体积分数的稀释,当烟雾经过一定时间到达探测器时,体积分数低于报警阈值导致漏报,而此时火势可能已经无法控制;且当隧道环境出现严重雾霾或者湿度较大情况时,空气中颗粒物体积分数超过阈值,则也可能造成误报。因此,传统感烟探测器易受多种因素影响,不利于隧道火灾烟雾的有效探测,且探测器仅有报警功能,无法得知烟雾后续扩散情况。视频图像型烟雾检测技术能够克服传统感烟探测器存在的问题并实现功能扩展,能更为准确、快速地检测烟雾即识别报警并获得实时烟雾扩散情况。

对于视频火灾烟雾识别检测,国内外相关学者已有诸多研究并应用于不同场景。刘恺等[4]在YUV色彩空间中分割出疑似烟雾区域,通过均匀局部二值模式和离散小波变换提取出烟雾图像纹理特征,输入至AdaBoost分类器进行烟雾图像识别分类,但当烟雾较少和体积分数较小时,系统无法快速识别。殷梦霞等[5]基于改进的三帧差分法分割疑似烟雾区域,然后提取烟雾图像的颜色、纹理、能量等特征,利用支持向量机训练识别模型实现烟雾检测,但如果存在缓慢移动汽车、飘动树叶等干扰可能造成漏报区域。Ding等[6]提出了一种在单帧视频序列图像中的烟雾检测方法,用于大空间和复杂场景下的森林火灾检测,根据光谱特征,通过支持向量机(SVM)对超像素块进行分类,但由于特征较少,使得烟雾检测的准确性较低,可作为监视森林火灾的辅助手段。王媛彬[7]在煤矿场景下进行烟雾识别检测研究,提出了基于模糊逻辑的图像增强方法,缓解矿井下照度低和光照不均对视频图像的干扰;再利用支持向量机对高斯混合模型提取出的烟雾区域周长面积比、面积随机性和漂移特性等特征进行识别分类,但由于矿井下光照以及存在太多疑似烟雾区域的干扰,始终导致误检率较高。Park等[8]利用烟雾生成器创建了一系列场景的数据集后,使用局部二进制模式描述符提取特征向量,输入到支持向量机分类器中进行模型训练,并将该烟雾检测方法应用至船舶机舱场景中;然而,如果背景和烟雾之间灰度值差低于运动检测的阈值,则系统无法检测到烟雾。

由于隧道的复杂性和环境因素的不确定性,已有研究中基于视频图像的隧道火灾烟雾检测仍然面临着巨大的挑战。雷丹[9]以自行拍摄的实际公路隧道内模拟火灾烟雾的视频为基础,提取烟雾高斯金字塔图像下的局部二值模式、圆形度、平均梯度和闪烁频率等特征作为优化后的支持向量机C-SVC的输入向量进行烟雾识别,同样在识别检测过程中,如果烟雾面积较小或者稀薄时,会导致图像特征区分不明显而出现漏报问题。朱国兴[10]用T-S模型模糊神经网络融合烟雾纹理特征的分类方法,对变化不同光照条件的隧道火灾视频进行检测,但只针对灰白、淡蓝和浅黄颜色的烟雾进行研究,需要进一步研究提高通用性。不同于传统的单一分类器检测,庞凤兰等[11]同时采用支持向量机和BP神经网络进行烟雾分类,然后利用D-S 证据理论对2个证据体进行融合,得到最终烟雾检测结果,但2个分类器仅分别输入一项特征进行识别,在隧道环境中准确性不高。杨孟拓[12]提出基于统计直方图法的改进方法提取背景,并采用基于块稳定性的背景更新算法,该背景提取更新方法不同于常用背景提取更新算法,能够解决光线变化问题,但由于样本有限,隧道火灾视频和模拟视频样本较少,算法的准确性需要进一步测试。

现阶段,火灾烟雾识别的相关研究主要基于网络共享数据集,这些烟雾图像背景单一,动态信息变化较少,而隧道内烟雾变化会影响灯具的照明效果,使得隧道内光环境发生变化;同时,隧道内火灾发生情况复杂,烟雾颜色多样,导致研究算法有局限性,无法应用于实际隧道环境。因此,本文建立了公路隧道模拟火灾烟雾以及真实隧道烟雾样本库,根据隧道火灾烟雾颜色信息、纹理信息、形态学信息对隧道烟雾进行识别,构建隧道烟雾识别模型,实现对隧道烟雾动态识别。

本文基于改进Vibe算法提取的运动区域在YUV颜色空间中通过滤色规则进行疑似烟雾区域分割,然后重点研究疑似烟雾区域烟雾的颜色、纹理特征,计算烟雾的颜色矩、提取烟雾的均匀局部二值模式(ULBP)、灰度共生矩阵(GLCM),利用多种机器学习分类器BP神经网络、支持向量机、随机森林进行模型训练,区分烟雾和非烟雾,完成烟雾识别。分析结果选取最优算法,并通过录制的模拟隧道火灾烟雾监控视频以及某隧道火灾视频进行试验测试,验证检测方法准确率。

1 隧道烟雾识别模型

本文隧道火灾烟雾识别检测流程如图1所示。

图1 视频烟雾检测流程

1.1 运动区域提取

针对隧道火灾烟雾向上运动沿拱顶前后扩散的特点与固定交通监控摄像机的关系,采用静态背景下的运动目标检测方法提取运动区域。Vibe算法速度快、计算量小,而且对噪声有一定的鲁棒性,检测区域更为完整,能够直接运用于交通行业监控视频的处理中,兼具准确性与时效性[13]。

但原始Vibe算法在进行运动区域提取时存在以下问题:

1)当烟雾扩散遮挡住灯具时,导致路面投射阴影区的颜色值与背景相差较大,路面投影阴影区被误检为运动目标;由于照明颜色与烟雾颜色相近,将前景误判为背景,产生空洞导致运动区域不完整。

2)由于隧道空间狭长,当场景光照有明显变化时,同样也会造成运动区域误检,将大面积的背景误判成前景,同时会出现较多噪声。

3)算法更新过快,有时起始烟雾运动缓慢,会将烟雾区域吸收为背景,导致检测不到烟雾;算法更新过慢,则会留下阴影。

针对原始Vibe算法存在的问题,对算法进行一定程度的改进,使其更好地应用于隧道环境烟雾运动区域提取,本文采用的改进方案如下。

1.1.1 扩大采样范围

使用5×5邻域建模,将采样范围从8邻域扩展到24邻域。扩大采样范围能避免一个像素被多次采样,提高初始模型的质量。

1.1.2 增加动态阈值

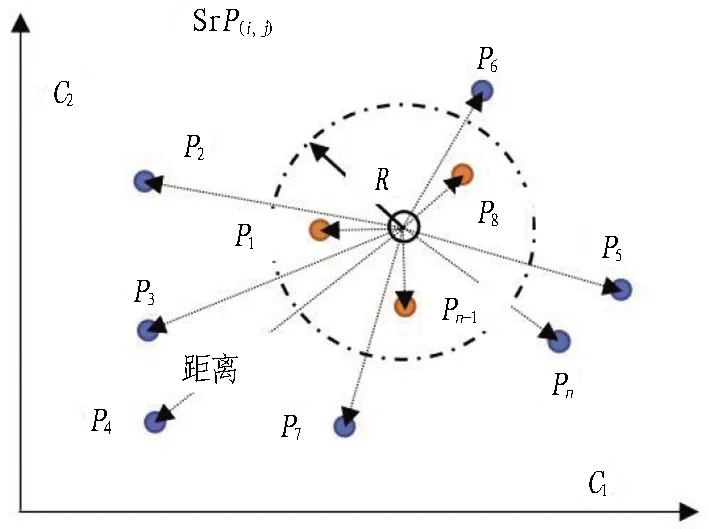

原始Vibe算法是通过计算当前像素与样本集中各个像素点之间的欧氏距离D进行前景和背景分割。欧氏空间中像素分类如图2所示。

图2 欧氏空间中像素分类

图2所示欧式空间中,Px为当前点P(i,j)的像素值;以Px为圆心,R为预先设定的半径参数以筛选近似样本数量;P1、P2、…、Pn为样本集Px中的像素值。统计D(x)={d1,d2,…,dn}中样本距离小于R的点个数count,count为当前像素点的近似样本数,然后用阈值T进行背景划分;如果count个数大于阈值T,则认为当前点P(i,j)为背景,否则为前景,用式(1)表示:

(1)

(2)

因此,可适当调整R和T的值来改变模型的灵敏度。原始Vibe算法试验中R=20,T=2,n=20。

原始算法选择固定半径参数R进行像素分类,会导致对背景或光照变化的检测效果不佳,前景会出现较多噪声。因此,将其调整为动态阈值,随着场景的变化而作自适应调整,增强算法鲁棒性。本文提出的调整动态阈值方法如下:

首先,取每个像素点到背景样本集的平均距离meanD(x,y),meanD(x,y)越大说明当前背景越复杂, 则R需取较大的值, 反之则需取较小值。给定一个参数β,根据背景变化调试为合适的值,取βmeanD(x,y)为阈值判断标准。动态阈值计算如下:

(3)

式中:r为初始半径参数;α1、α2、β为固定参数,通过参数调试得到合适阈值,使背景更新更加平滑,本文取α1=0.5,α2=0.2,β=4。

1.1.3 缩小时间采样因子

原始算法采用比较保守的背景模型更新机制,为了防止缓慢扩散的烟雾被误认为是背景,造成前景目标的空洞与不完整,调整时间采样因子φ,放慢背景模型的更新速率。本文取φ=5,算法其余参数不做修改。

模拟隧道火灾烟雾视频运动区域检测结果如图3所示。通过OpenCV 中使用概率前景估计算法的BackgroundSubtractorGMG,基于自适应混合高斯背景建模的背景减除法的BackgroundSubtractorMOG、BackgroundSubtractorMOG2以及原始Vibe算法和改进Vibe效果图对比得出,原始的Vibe算法本身检测效果优于其他3种算法模型;本文改进的Vibe算法使得提取的烟雾运动区域更加完整,噪声更少,获得了较好的检测结果。

(a)检测第36帧图像 (b)GMG算法二值效果图

虽然改进Vibe算法检测烟雾运动区域提取烟雾区域较为完整,但依然无法完全消除噪声以及空洞和残缺,可进一步利用膨胀、腐蚀、开运算与闭运算等形态学处理操作,去除未消除的小区域阴影像素点及噪声点,提取出完整的运动目标。掩膜效果如图4所示。

(a)形态学处理后图像 (b)掩膜后运动区域

通过运动检测方法提取出的运动区域不仅包括烟雾扩散区域,还可能包括运动的车辆、正在疏散的人员等。因此,需要对运动区域进一步分割,以得到更加准确的烟雾运动区域。

1.2 疑似烟雾区域分割

虽然运动区域提取确定了火灾烟雾区域,但从图4看出,这些区域中存在颜色与烟雾区别较大的非烟运动区域(如穿着荧光安全服人员),直接在此结果上进行特征提取、识别会耗费大量时间,影响检测的时效性。因此,对运动区域进一步进行颜色分割,滤除颜色上与烟雾区别较大的非烟雾干扰。在隧道环境内,灯光干扰较大,而视频图像从RGB色彩空间模型转换到YUV 色彩空间模型中,颜色信息不会受照明亮度变化影响,因此可利用YUV色彩空间进行颜色分割。YUV色彩空间如图5所示。

(a)RGB图像 (b)YUV图像 (c)Y分量 (d)U分量 (e)V分量

提出一种基于YUV色彩空间的疑似烟雾区域分割模型:

(4)

式中:Ut、Vt为在YUV色彩空间中像素点j在t时刻的U、V分量值;用Tmax、Tmin阈值分割出烟雾图像,取值在Tmin~Tmax即判断为烟雾图像,本文取Tmax=128、Tmin=30。

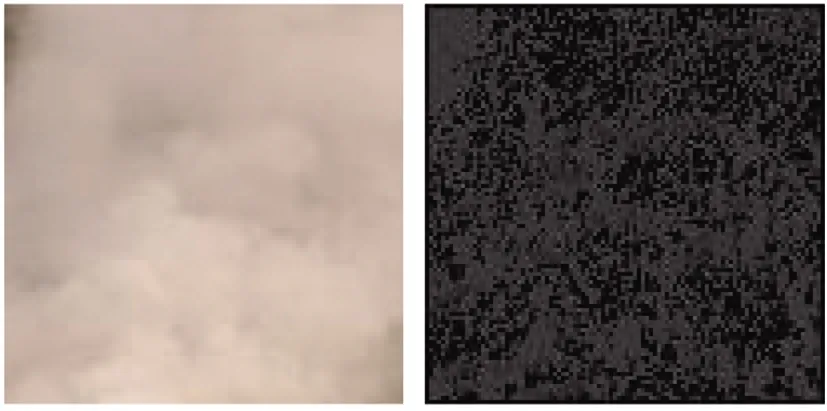

基于YUV色彩空间分割后的疑似烟雾区域如图6所示。在YUV色彩空间使用滤色分割疑似烟雾区域后,虽然可以消除大部分颜色与烟雾差异较大运动区域干扰,但仍然可能存在极少类似烟雾颜色的运动区域。应从烟雾图像更本质的特征出发进行深入分析,以确定其是真实烟雾还是类似烟雾。

(a)运动区域 (b)滤色后的图像

1.3 特征分析提取

烟雾具有色彩、纹理、运动、扩散等多种特征,本文选取颜色矩、均匀局部二值模式(ULBP)、灰度共生矩阵(GLCM)作为烟雾识别的特征判据。

1.3.1 颜色特征值提取

烟雾颜色作为最基本的图像特征信息,通常可作为复杂识别系统的一小部分[14]。颜色的一阶矩μi(均值)、二阶矩σi(方差)和三阶矩si(斜度)可以描述图像颜色分布,数学表达见式(5)[15]。颜色矩与颜色直方图相比简单高效,而且无需对特征进行向量化。

(5)

式中:pi,j为YUV图像中第j个像素点i通道分量值;N为疑似烟雾区域内像素总数。

在YUV颜色空间中分离出Y、U、V3通道,可提取9维颜色矩向量。

1.3.2 纹理特征值提取

纹理是物体表面共有的内在特征,与基于像素点的颜色特征不同,纹理特征统计计算图像区域内的多个像素点,被定义为一个区域内的属性[16]。图像的全局纹理可通过局部纹理体现。许多研究表明,通过纹理特征识别烟雾图像能够取得较好的效果,可见纹理特征是烟雾图像的重要特征之一[17]。因此,在隧道复杂环境中通过纹理特征识别烟雾具有明显优势。烟雾纹理特征提取中,局部二值模式(LBP)、灰度共生矩阵(GLCM)应用最为广泛。

1.3.2.1 均匀局部二值模式(ULBP)

局部二值模式(LBP)是由Ojala等[18]提出的一种通过比较像素与其领域像素灰度值得到该像素模式值,并用像素模式值统计直方图对图像纹理特征进行描述的灰度纹理算子。局部二值模式LBP算法计算公式如下:

(6)

式中:gc为像素点的灰度值;gP为邻域内像素点的灰度值;P为邻城像素点的数目。

在原始LBP算法中,3×3领域内通过灰度值比较,可提取出8位二进制数(再转换十进制数)得到28=256种模式,即得到该领域中心点的LBP值,并用这个值来反映该局部区域的纹理信息。

由式(6)可以看出,LBP的值仅与两相邻像素点灰度值的相对大小有关,因此,在隧道火灾发生,烟雾遮挡灯光造成各像素点灰度值发生变化时,中心点像素与其邻域像素灰度值的相对大小是不变的,所以LBP对光照变化具有较好的鲁棒性,可以很好地缓解亮度变化的影响。

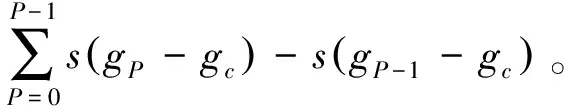

为了减少编码组合模式过多带来的统计计算难度,Ojala等[8]又提出采用“等价模式”对编码组合进行降维,提高后续图像识别分类效率。均匀局部二值模式ULBP直方图中U值计算如下:

ULBPj(P,R)=|s(gP-1,gc)-s(g0,gc)|+

(7)

ULBP的U值表示LBP模式中相邻的2个0/1或1/0传输的二进制值的个数,因此,U值可以反映局部结构的均匀性,U值越大,说明结构趋于不均匀,变化频率越高[19]。当P=8、R=1时,ULBP共有59种模式,包含58种均匀模式和1种非均匀模式,并将直方图中相同U值数量作为对应模式的特征值。图7示出烟雾图像和非烟雾图像的ULBP中模式的概率分布。

(a)烟雾等价局部二值模式值

1.3.2.2 灰度共生矩阵(GLCM)

灰度共生矩阵法(GLCM)定义为从灰度为i的像素点出发,距离为(dx,dy)的另一个像素点的灰度为j的概率,即灰度图像中某种形状的像素对在全图中出现的次数。计算公式如下:

p(i,j|d,θ)=#{(x,y)|f(x,y)=i,f(x+dx,y+dy)=j;

x,y=0,1,2,…,N-1}。

(8)

式中:d为用像素数量表示的相对距离;θ一般考虑4个方向,分别为0°、45°、90°、135°;#为集合;i,j= 0,1,2,…,L-1;(x,y)为图像中的像素坐标,L为图像灰度级的数目。

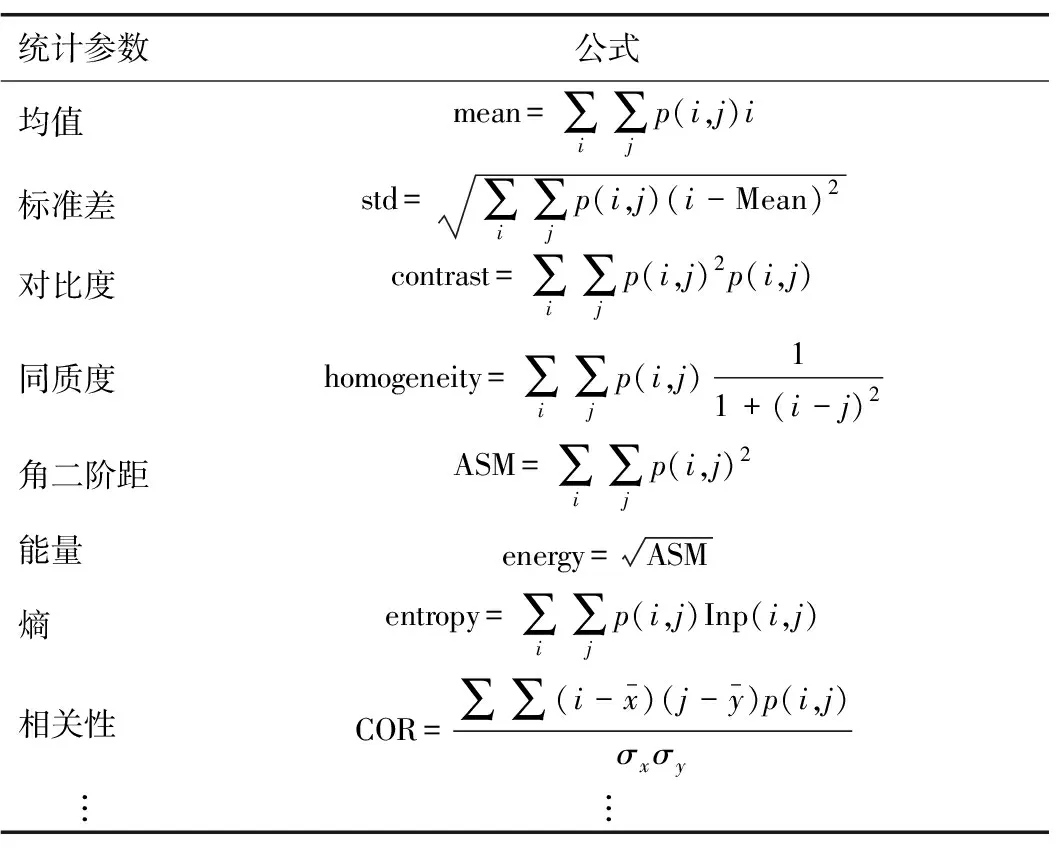

灰度共生矩阵能反映图像灰度关于方向、相邻间隔、变化幅度等综合信息,但并不能直接提供区别纹理的特征,因此,需要在灰度共生矩阵的基础上提取出用来能够定量描述纹理特征的统计参数。Haralick[20]于1973年提出14种纹理特征参数,部分统计参数见表1。烟雾图像和非烟雾图像(灰色路面)各灰度矩阵(GLCM)的统计参数分别如图8和图9所示。

表1 表征灰度矩阵(GLCM)的统计参数

(a)原始图像 (b)均值 (c)标准差 (d)对比度

(a)原始图像 (b)均值 (c)标准差 (d)对比度

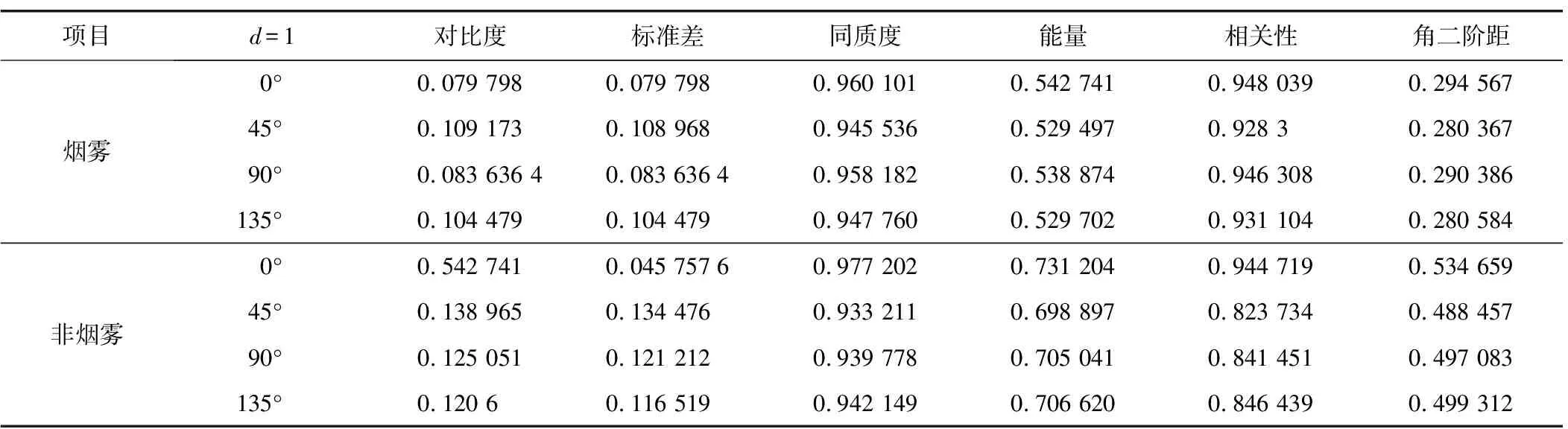

本文提取关于对比度、标准差、同质度、能量、相关性、角二阶距6个灰度共生矩阵统计参数4个方向共24个特征向量,见表2。

表2 烟雾与非烟雾灰度共生矩阵参数的比较

得到图像颜色矩、ULBP 和GLCM纹理特征后提取出特征向量,便可以利用机器学习算法进行分类识别。

1.4 烟雾识别

烟雾识别即烟雾与非烟雾分类(二分类),在机器学习中,最常见的问题就是分类问题,能够完成分类任务的算法通常被称为分类器(classifier)。支持向量机、BP神经网络和随机森林都是常用的监督机器学习分类器。由于隧道内环境的特殊性,采用以下3种分类器进行分析对比研究。

1)BP神经网络是用误差反向传播算法训练的多层前馈网络,学习过程包括信号正向传播和误差反向传播,学习过程循环往复,各层权值不断调整即网络训练过程[21]。这一过程持续进行,直到网络输出的误差减少到可接受的水平或到预定的学习次数。

2)支持向量机(SVM)[22]的核心思想是寻找一个最优超平面,将2类样本数据分割于平面两侧,同时尽可能使得距离该平面最近2类样本之间的距离最大化,分割就会具有较高的可信度,并且对输入的新样本数据具有良好的泛化能力即预测能力。

3)随机森林由多个决策树组成。要将一个输入样本进行分类,需要将输入样本输入到每棵树中进行分类。每棵决策树都是一个分类器,对于一个输入样本,N棵树有N个分类结果。随机森林将所有分类投票结果进行整合,将投票最多的类别作为最终输出[23]。

2 试验结果与分析

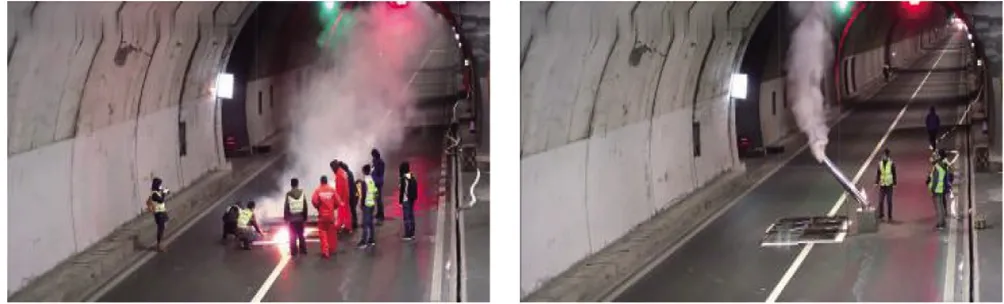

以G50S沪渝南线羊鹿山特长公路隧道模拟火灾烟雾试验监控视频为基础。试验场景1、2分别将火源点布置在7#车行横洞处和8#人行横洞处,如图10所示。在8#人行横洞处与8#车行横洞处中间为车辆区域,其中包含一辆大客车以遮挡监控视线。场景火源均选用酒精火、油盘火、木质作为燃烧材料。模拟烟雾发生器由发烟腔和导烟筒组成,侧壁为单开门,放置烟饼,烟饼可产生白色、低残留物的气体。

图10 试验场景布置情况

从ZK31+492开始,间隔150 m布置1组4台摄像机,共5组摄像机,如图11所示。试验场景1火源点位于ZK31+222处,距离A-1摄像机270 m,摄像机全部可用;试验场景2位于A-2和A-3摄像机下方,可用摄像机为其上方以及后方不同距离的摄像机。场景1可得较远距离完整起烟过程、烟雾漫延至车辆区域以及后方等长距离烟雾扩散的视频图像;场景2可得到包含近距离完整起烟过程、近距离车辆遮挡、近距离交通信号灯干扰、近距离烟雾全覆盖摄像机以及烟雾沿拱顶漫延过程等多类型视频图像。

(a) (b)

系统算法搭配环境为win10操作系统,pycharm操作平台python3.8.4和opencv3。从录制的隧道火灾烟雾试验视频中选取不同位置摄像机的监控视频图像。共有大小为100×100烟雾图元940张、非烟雾图元898张。每张样本图元将提取9个颜色矩特征、59 个均匀局部二值模式、24个灰度共生矩阵统计参数特征共计92个特征向量并输入分类器中训练获取分类模型。

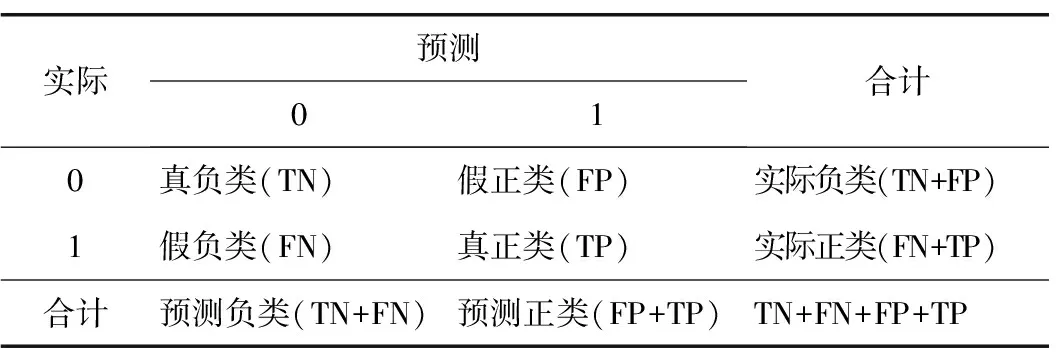

2.1 烟雾分类模型评价

在机器学习分类器完成烟雾识别分类后,需要对效果进行评价。本文引入混淆矩阵对支持向量机(SVM)、BP神经网络、随机森林3种分类器模型准确性进行分析研究。混淆矩阵能够直观反映分类器模型烟雾识别情况,体现分类模型的烟雾识别分类准确性,在混淆矩阵基础上得到准确率、精确率、召回率以及F1值对分类准确性进行描述。混淆矩阵如表3所示。

表3 混淆矩阵

1)准确率Acc。描述烟雾分类模型总体分类准确程度,其表达式为:

(9)

2)精确度Prec。描述烟雾分类模型分类结果中分类正确的百分比,其表达式为:

(10)

3)召回率Rec。描述烟雾分类模型分类为正的正样本数和总正样本数的百分比,其表达式为:

(11)

4)F值。被定义为精确度Prec与召回率Rec的调和平均数,体现了分类决策模型的稳定性,其表达式为:

(12)

2.2 试验结果分析

表4—6分别为SVM算法、BP神经网络和随机森林3种分类器混淆矩阵结果。

表4 SVM算法混淆矩阵结果

表5 BP神经网络混淆矩阵结果

表6 随机森林混淆矩阵结果

共对275张疑似烟雾图像进行测试,通过得到的混淆矩阵结果进一步计算分类器的准确率、精确率、召回率以及F1值,结果如表7和图12所示。表中数字代表含义参照表3。

表7 各分类器评价指标

根据图12机器学习分类算法的评价指标平均值对比可知,BP神经网络与随机森林的准确率、精确度、召回率、F1值均优于支持向量机(SVM);BP神经网络的准确率、精确度、F1值略高于随机森林,召回率指标略低于随机森林。

图12 分类算法评价指标平均值对比

分类器视频图像检测结果见表8。由表可知:情形1烟雾小而稀薄且与背景融合时,3种分类器均无法识别;情形2烟雾较小时,BP神经网络与随机森林能够识别,但支持向量机无法识别;情形3尽管烟雾较大,但由于交通指示灯影响,造成仅支持向量机无法识别。通过对支持向量机特点分析可知,支持向量机在小样本训练集上能够得到比其他算法好很多的结果,但如果样本图像特征数较多时(本文92个特征值)表现很差。从支持向量机核心思想上分析也可得知,特征数据过多,支持向量机很难寻找到一个最优超平面将两类样本数据分割于平面两侧,分割可信度不够,泛化能力不足。BP神经网络模型相对随机森林模型具有高度自学习和自适应和较好的泛化能力。

表8 分类器视频图像检测结果

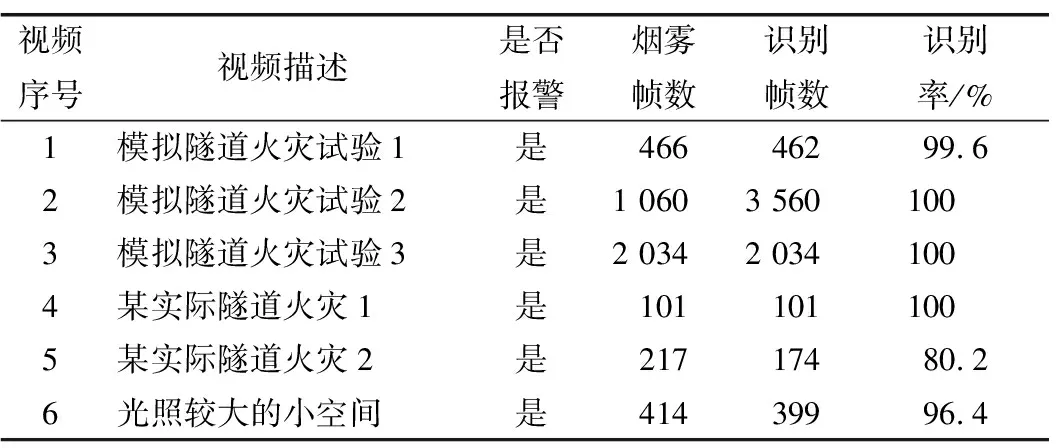

综上,本文采用BP神经网络分类算法构建隧道火灾烟雾识别分类模型。采用训练好的BP神经网络分类算法对模拟隧道火灾烟雾以及某实际隧道火灾烟雾视频进行测试试验。

视频1、2、3为试验模拟隧道火灾烟雾监控视频,都位于交通信号灯下,烟雾颜色可能改变;视频4、5为某真实隧道车辆火灾监控视频;视频6为某小空间光照直射船舱烟雾视频,来源于网络。视频样本示例及部分检测效果如图13所示,视频样本检测结果见表9。具体分析如下:

表9 烟雾视频检测结果

(a) (b)

视频1为初始烟雾检测,前几帧由于烟雾稀薄,颜色与背景墙面融合导致漏报,从视频第5帧开始成功检测,识别率为99.6%;视频2、3由于监控摄像机与烟雾位置关系,检测效果最佳,识别率为100%;视频4为某真实隧道火灾发生后部分截取视频,黑烟已经开始快速扩散,模型识别数据集中添加黑烟数据集,所以系统可有效检测黑烟,监测其扩散范围位置,识别率为100%;视频5由于隧道衬砌轮廓颜色与烟雾灰色烟雾极其相近,加之灯光影响使得烟雾特征在环境中不够显著,造成误检和漏报,识别率为80.2%;由于光照影响容易造成误检,单独验证本文算法对光照影响效果,视频6前5帧没有检测到烟雾,同时第2帧到第5帧造成误检,共有误检45帧,识别率96.4%,有烟雾存在同时造成误检。综上,在隧道环境中,当初始扩散的稀薄烟雾以及灯光影响下的烟雾检测会出现漏检问题,同时监控摄像机与火灾烟雾发生相对位置关系对烟雾识别检测有着一定影响。试验结果表明,本文方法能够满足隧道正常运营情况下烟雾识别,有效排除干扰源,满足时效性要求,同时能够监测烟雾扩散后范围。

3 结论与建议

本文提出了一种有效的基于监控视频图像的公路隧道烟雾检测方法。结合改进Vibe算法和YUV色彩空间滤色规矩分割出完整烟雾区域,以提高检测效率;使用颜色矩、局部均匀二值模式和灰度共生矩阵提取的特征向量能有效表达烟雾的本质特征;分析选出的BP神经网络分类器算法能较好地区分烟雾与非烟雾。测试试验结果表明:该方法在隧道发生火灾时具有较高的检测效率,相对于传统烟雾探测器,检测范围更广、报警更及时。

1)隧道火灾发生初期,由于温差和压差使得烟雾首先从着火点(产烟点)向上扩散,在向上扩散的过程中,其边缘不断变化,呈现出不规则的轮廓。同时,烟雾受到热气流和隧道通风影响,在扩散时烟雾体积分数时刻变化导致图像像素值不断变化,增加运动区域提取难度。针对隧道火灾初期烟雾扩散和图像像素值变化等特点,给出一种基于动态阈值的改进Vibe算法,用于运动区域提取。试验结果表明:同MOG2等算法比较,该算法一定程度上减少了隧道环境影响,能提取更加完整的烟雾运动区域,同时能够减少噪声干扰,获得了较好的检测结果。

2)颜色是烟雾基础和重要的图像特征。在隧道火灾初期,烟雾主要呈现为灰白色,在 YUV 颜色空间中,颜色信息不受照明亮度变化影响。因此,给出一种基于YUV色彩空间颜色信息的公路隧道火灾烟雾分割模型,能够有效滤出大量非烟区域。分割出的疑似烟雾区域较完整、边缘清晰,且对光照有较好鲁棒性。

由于公路隧道内照明灯具类型、显色指数不同,未来可针对具体照明灯具不同影响进行试验研究,不断完善烟雾检测系统,并考虑将烟雾检测与火焰检测方法相结合,进一步提高早期火灾检测正确率与时效性。本文制作的隧道火灾烟雾视频图像数据集,可作为研究实际隧道烟雾识别模型可靠的样本库。同时,未来可不断完善和丰富检测系统以获得隧道火灾发生后的烟气扩散情况,为应急救援决策提供精准信息,让烟雾识别检测在隧道火灾发生后疏散救援工作中发挥作用,使监控视频烟雾检测更具意义和应用价值。