基于卷积评价及对抗网络的花粉、孢子图像增广算法

2021-11-14王万亮江高飞严江伟薛卫

王万亮 江高飞 严江伟 薛卫

摘要: 针对花粉、孢子图像特征复杂,样本稀缺及种类繁多制约图像检测识别效果的问题,建立基于自适应阈值分割的pix2pix图像增广模型。首先基于卷积评价改进自适应阈值分割算法,择优选取语义分割图像;其次构建pix2pix图像增广模型,将语义分割图像和原始图像建立标签映射用于模型训练,根据语义分割图像生成仿真图像,扩充样本数据集。结果表明,以149种花粉、孢子图像为样本,通过图像增广模型生成的花粉、孢子图像整体相似度达到85.40%;图像增广前Faster RCNN、YOLOv3检测模型的检测精准率分别为86.18%、85.64%,使用增广后的样本训练模型,检测精准率分别达到92.16%、90.57%,提升5.98个百分点和4.93个百分点。

关键词: 花粉检测; 图像增广; 图像分割; pix2pix网络

中图分类号: S126 文献标识码: A 文章编号: 1000-4440(2021)05-1190-09

Augmented algorithm for pollen and spore images based on convolution evaluation and pix2pix network

WANG Wan-liang 1 , JIANG Gao-fei 2 , YAN Jiang-wei 3 , XUE Wei 1

(1.School of Artificial Intelligence, Nanjing Agricultural University, Nanjing 210095, China; 2.College of Resources and Environmental Sciences, Nanjing Agricultural University, Nanjing 210095, China; 3.School of Forensic Medicine, Shanxi Medical University, Taiyuan 030001, China)

Abstract: Aiming at the problems such as complex image features of pollens and spores, scarcity of image samples, restricted detection and recognition effects of various images of pollens and spores, a pix2pix image augmentation model based on adaptive threshold segmentation was built. Firstly, the adaptive threshold segmentation algorithm was improved based on convolution evaluation to select the optimal semantic segmentation images of pollens and spores. Secondly, the pix2pix image augmentation model was constructed, the semantic segmentation images and the original images were used to establish label mapping for model training, and emulational pollen and spore images were generated based on semantic segmentation images to extend sample dataset. The results showed that, the overall similarity of 149 pollen and spore images generated by the image augmentation model reached 85.40%. Before image enlargement, the detection accuracies of Faster RCNN and YOLOv3 detection models were 86.18% and 85.64%, respectively. After using the enlarged sample training model, the accuracies reached 92.16% and 90.57%, which increased by 5.98 and 4.93 percentages.

Key words: pollen detection; image augmentation; image segmentation; pix2pix network

花粉、孢子種类多,常见的花粉、孢子类别鉴别手段基于细胞学检测 [1] 。但即便是从事花粉学研究的植物学家、法医专家和一线科技工作者,也很难有效识别如此繁多的花粉类型。考虑到显微镜下人工观察统计玻片的工作量较大,通过计算机图像处理技术实现快速、高效花粉、孢子检测就具有重要的现实意义,将会给予该领域学者的研究工作提供较大帮助。

近年来,国内外针对花粉、孢子图像的计算机检测识别方法屡见不鲜。刘惠等 [2] 选取了3种纹理特征、3种颜色特征和5种形状特征,基于PCA与BP神经网络识别万寿菊黑斑病病菌孢子。谢永华等 [3] 利用离散二进小波变换获取图像突变点,并计算具有方向的邻域几何约束关系,最后通过直方图统计特征描述识别花粉图像。上述方法主要针对少量类别孢子识别检测,首先对花粉、孢子图像进行预处理,其次提取花粉、孢子图像的纹理、边缘、颜色等特征,最后应用经验知识及机器学习算法进行判别。此类方法依赖设计者人工选取合适的特征进行参照,面对多类别的花粉、孢子时效果不够理想,通用性不高。

深度学习 [4-9] 的发展给目标检测识别提供了新的思维和方法,研究最为广泛的就是卷积神经网络 [10-17] ,在花粉、孢子检测领域已经有所应用。Ramon等通过标记花粉、孢子图像,提出了利用卷积神经网络架构建立深度学习模型检测花粉、孢子,精准率达到89% [18] 。Voactor等在卷积神经网络的基础上,研究了基于迁移学习,基于特征提取,基于迁移学习和特征提取的孢子检测方法,并进行了论证比较 [19] 。上述方法通过卷积神经网络实现了10余种花粉、孢子的检测并取得了较高的准确率,涵盖的花粉、孢子类别有所扩展但不够丰富,用于构建深度学习模型的孢子图像数据集存在一些缺陷,表现为花粉、孢子种类少、数据不平衡及图像质量差。深度学习算法的优良性能依赖于全面的训练数据集,数据集缺陷使得孢子检测更加困难。

为了解决花粉、孢子数据集缺陷和多类别孢子检测问题,本研究基于深度学习的图像增广模型,利用pix2pix网络构建孢子的图像增广模型扩充孢子的样本数据集,通过深度学习的方法增强花粉孢子的样本,提升花粉检测的效果。

1 材料和方法

1.1 花粉、孢子图片数据集

本研究中花粉、孢子图片主要来自于PalDat(https://www.paldat.org)和Global Pollen Project(https://globalpollenproject.org) [20] ,总计 1 980 类别, 14 055 张花粉、孢子图像。使用labelImg工具标记花粉、孢子,生成PASCAL VOC格式文件,便于后续花粉、孢子图像的定位及增广和花粉、孢子识别模型的训练。剔除重复、不清晰及有效花粉、孢子数量小于5的样本数据,最终确定Protium、Serjania和Anadenanthera等 3个门类、13个科、149种不同类型的花粉、孢子图像作为数据源,总计 1 181 张图像,标记 2 246 个花粉、孢子,其中单类别花粉、孢子最少有5张图像。花粉、孢子族谱关系自上而下可以分为门(phylum)、纲(class)、目(order)、科(family)、属(genus)、种(Species)等。由于篇幅有限,将149种花粉、孢子类别按照所属纲目进行归类,统计数据见图1,其中Angiospermae纲目包含的花粉、孢子图像及孢子类别数最多,Equisetopsida纲目包含的花粉、孢子图像及花粉、孢子类别数最少。

1.2 算法流程

算法包括数据集制作、语义分割,图像增广与花粉、孢子检测4个方面,整体流程如图2所示。首先采集花粉、孢子图像,标注花粉、孢子制作数据集;其次通过语义分割,提取花粉、孢子的多尺度语义分割图像;每个花粉、孢子的部分语义分割图像与原始图像构成语义映射标签作为图像增广模型的训练数据集,另一部分语义分割图像用于生成花粉、孢子的仿真图像,达到扩充样本目的;最后使用扩充后的样本来训练和验证花粉、孢子检测模型。

1.3 基于卷积评价的自适应阈值分割方法

精准语义分割图像是花粉、孢子图像增广模型的基础。基于卷积评价的自适应图像分割算法分为2步:自适应阈值分割图与卷积评价。如图3所示,首先根据原始图像生成灰化图,使用不同的邻域分割灰化图自适应阈值,生成若干张二值化分割图;再利用卷积模板分别提取原始灰化图像和二值化分割图像的特征,并计算分割图与灰化图的矩阵距离,择优保留距离差较小的分割图像。

1.3.1 自适应阈值分割图 自适应阈值分割主要基于图像的局部特征,计算出最佳的分割阈值,不同邻域的局部特征迥异,分割阈值存在差异。本研究使用遍历法,设置邻域范围为1至输入图像尺寸的1/8,邻域步长为2,不断迭代生成若干张不同的二值化分割图像。

1.3.2 卷积评价 分别基于高斯卷积 [21] 模板和拉普拉斯卷积 [22] 模板提取灰化图像和各个分割图像的特征,使用曼哈顿距离公式计算卷积提取特征的距离差,选取距离差较小的分割图像作为最佳语义分割。

其中高斯卷积将接近中心的点赋予较大的权重,远离中心的点赋予较小的权重,能够降低图像噪点的敏感性,高斯卷积模板如下:

1 2 1 2 4 2 1 2 1 (1)

拉普拉斯卷積反映图像某个像素的邻域突变程度,增强图像的细节,能够突出图像的边缘和邻域特征,拉普拉斯卷积模板如下:

-1 -1 -1 -1 8 -1 -1 -1 -1 (2)

曼哈顿距离公式计算简单,处理速率较快。基于灰化图和分割图,分别计算高斯卷积模板及拉普拉斯卷积模板下的特征距离差。建立度量评价体系,最终保留总距离差较小的分割图像。特征距离计算公式为:

d(x,y)=|g(x)-g(y)|+|l(x)-l(y)| (3)

式中 g(x) 、 g(y) 分别为灰化图、分割图的高斯卷积特征矩阵, l(x) 、 l(y) 分别为灰化图、分割图的拉普拉斯卷积特征矩阵,两类特征间的距离差取绝对值相加之后即为总距离差。

1.3.3 图像分割结果 常见的图像分割方法主要基于区域、阈值和边缘检测对图像进行分割 [23] 。相较于上述分割方法,本研究的算法分割图像能够更加接近花粉、孢子图像的主体框架和轮廓,应对不同类型的花粉、孢子图像具有更强的鲁棒性,分割效果如图4f所示。图4b为Otsu阈值法 [24] 分割效果,利用图像的灰度特性,寻找图像的前景和背景的最大类间差,确定最佳的分割阈值。花粉、孢子图像前景特征丰富,难以确定有效的分割阈值。图4c为区域生长算法 [25] 分割效果,选取某个像素点作为种子点,将具有相似特性的像素连接起来形成区域。花粉、孢子图像纹理复杂,很多场景该算法只能分割出花粉、孢子图像的部分轮廓。图4d是Canny边缘检测 [26] 效果,利用边缘信息将变化的边界分割出来。花粉、孢子图像有比较复杂的连通区域,边缘分割产生大量小区域,破坏花粉、孢子的整体框架。图4e为自适应阈值法 [27] 分割效果,根据像素点邻域提取图像的部分区域,分析区域内图像特征,进行分割。受限于花粉、孢子图像的邻域及阈值不同,使用固定的邻域及阈值无法求得每种花粉、孢子图像分割的最优解,分割容易产生大量小噪点,轮廓缺失。针对每个花粉、孢子图像,保留评价最佳的6个语义分割图像,用于后续的图像增广。选取4组花粉、孢子(图5),语义分割图像与原始图像的基本轮廓一致,噪点及纹理细节存在微小区别。

1.4 基于pix2pix網络的图像增广算法

pix2pix网络 [28] 图像增广算法基于生成对抗思想,结合条件生成网络,通过成对匹配的语义映射关系,实现2个领域中匹配图像直接转换。输入为语义分割图和对应的原始图像,生成器根据分割图生成仿真图像。分割图像和仿真图像作为判别器的输入,生成器和判别器互相博弈,使生成的仿真图像不断接近真实图像。基于语义分割图,针对每个花粉、孢子图像,选取其中20%语义分割图像和原始图像建立标签映射关系。然后以标签映射作为图像合成的约束条件分别作为pix2pix网络图像增广模型的训练数据集和验证数据集。最后使用剩余80%语义分割图调用pix2pix网络图像增广模型生成仿真的花粉、孢子图像,扩充花粉、孢子图像的数据集。

1.4.1 生成器 生成器的输出为花粉、孢子的仿真图像,其网络模型基于U-net结构,该结构参照具有对称性的编码-解码模型设计。U-Net结构的不同之处是将第 i 层和第 n-i 层连接起来,其中 n 是总层数,这种连接方式称为跳过连接。U-Net结构通过卷积和池化下采样提取特征信息,使用转置卷积来上采样并裁剪之前的低层特征图进行融合用来生成仿真图像,U-Net图像细节提升明显。编码部分采用8个卷积核大小为4、步长为2的卷积层,不断对特征图进行下采样操作以进行编码,使用BN层归一化从而加速网络的收敛,再通过Relu函数对特征图进行激活操作。解码部分采用8个卷积核大小为4、步长为2的反卷积层,不断对特征进行空间扩充,使其恢复为原始的输入大小,再通过Tanh函数对特征图进行激活操作。

1.4.2 判别器 pix2pix判别器使用patchGAN结构,将图像等分成若干个固定大小的patch,分别判断每个patch的真假,再取平均值作为判别器的输出。该判别器使用步长为2的跨步卷积与普通卷积操作不断对图像进行下采样,最终得到一个大小为30×30的patch,该patch对应着原图30×30个图像块,patch中每个位置的取值代表判别器对其对应块的判别结果。

1.4.3 图像增广评价

1.4.3.1 结构相似性 用结构相似性模型(SSIM) [29] 将失真信息建模为图像亮度信息、对比度信息和结构信息的组合。亮度信息 l(x,y) 、对比度信息 c(x,y) 和结构信息 s(x,y) 分别用下列公式计算:

l(x,y)= 2μ xμ y+C 1 μ 2 x+μ 2 y+C 1 (4)

c(x,y)= 2σ xσ y+C 2 σ 2 x+σ 2 y+C 2 (5)

s(x,y)= σ xy +C 3 σ xσ y+C 3 (6)

式中 μ x 和 μ y 反映花粉、孢子图像的亮度均值信息, σ x 和 σ y 反映花粉、孢子图像的对比度方差, σ xy 是反映两幅图像的结构信息相关系数, C 1 、 C 2 和 C 3 为常量系数。综合上述3类信息计算2幅图的结构相似性( SSIM ):

SSIM(x,y,z)=[l(x,y)] α[c(x,y)] β[s(x,y)] γ (7)

1.4.3.2 增广结果 利用pix2pix网络对花粉孢子的原始图像(图6a)进行增广生成仿真图像。如图6b~6e所示,pix2pix模型生成的仿真图像与原始图像存在较高的相似性,前景、背景基本一致。花粉、孢子数据集由最初的 1 181 张图像、扩充至 5 905 张图像;单个类别最少的花粉、孢子图像由5张扩充至25张,数据样本得到显著增广。

使用结构相似性模型计算原始图像与仿真图像的相似度,整体平均相似度达到85.4%;纲目Pinopsida相似度平均值最高,达到91.48%;纲目Campanulids相似度平均值最低,达到81.1%;纲目Pinopsida相似度中位值最高,达到93.28%;纲目Basal core eudicots相似度中位值最低,达到79.44%。各个花粉、孢子纲目相似度分布如图7所示。

2 结 果

基于花粉、孢子图像增广数据集,选取Faster RCNN [30] 、YOLOv3 [31] 模型建立花粉、孢子检测算法,用来验证本文图像增广算法对于提升花粉、孢子检测效果的有效性。

Faster RCNN是两阶段目标检测算法,基于CNN [32] 的方法可以从花粉、孢子图像样本中学习特征,提取与图像更相符的特征,提高检测准确度。VGG16网络 [33] 的结构相对简单,性能比较高效。具体工作流程为:输入花粉、孢子图像并调整尺寸大小后送入卷积层,通过卷积层获得花粉、孢子图像的特征图,RPN从特征图中生成若干个候选框。再通过ROI pooling层提取候选框和卷积层输出的特征图。最后将其送入全连接层进行分类和回归。

另一种以YOLOv3为代表的单阶段目标检测算法,YOLOv3算法基于Darknet53网络结构,借鉴残差网络思想优化特征提取过程,输出多尺度特征; YOLOv3算法采用多尺度预测网络,将提取的特征进行回归,确定目标边框的位置、类别、置信度,最后使用非极大值抑制算法保留置信度高的预测框。

2.1 检测评价指标

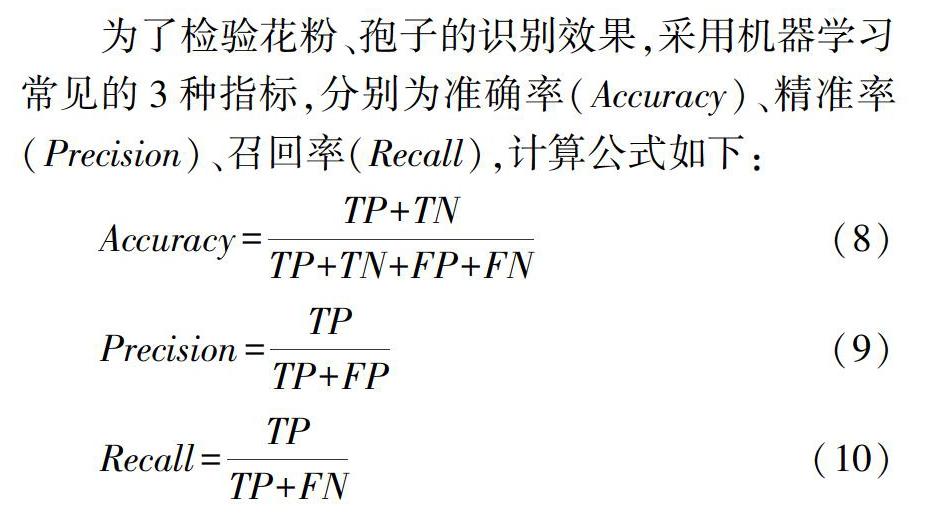

为了检验花粉、孢子的识别效果,采用机器学习常见的3种指标,分别为准确率( Accuracy )、精准率( Precision )、召回率 (Recall ),计算公式如下:

Accuracy = TP+TN TP+TN+FP+FN (8)

Precision= TP TP+FP (9)

Recall = TP TP+FN (10)

上述公式中 TP 为正确识别正样数量, FP 为错误识别正样本数量, TN 为正确识别负样本数量, FN 为错误识别负样本数量。

2.2 花粉、孢子检测结果

为了验证花粉、孢子图像增广对花粉、孢子识别的影响,基于149种花粉、孢子分别构建了增广前和增广后的数据集,分别按照 8∶ 2划分训练数据集和测试数据集。再使用检测模型对比图像增广前后花粉、孢子检测效果。由于篇幅有限,本研究仅列举部分花粉、孢子类别作为示意图。以Faster RCNN检测模型为例,主要列举ilex aquifolium、asplenium hemionitis、andryala pinnatifida、gevuina avellana等10种花粉、孢子的检测效果,其中图8a、图8c为图像增广前花粉、孢子检测效果,图8b、图8d为为增广后花粉、孢子检测效果。

以YOLOv3检测模型为例,主要列举soldanella alpina、salacia chlorantha、mitraria coccinea、atriplex portulacoides等10种花粉、孢子的检测效果,其中图9a、图9c为图像增广前花粉、孢子检测效果,图9b、图9d为增广后花粉、孢子检测效果。

从图8、图9中对比可以得出,经过图像增广后,原有无法识别或错误识别的部分花粉、孢子图像能够被准确检测,图像检测结果对比显示经过增广后花粉、孢子图像的识别效果显著提高。基于Faster RCNN检测模型,经过增广后图像识别的准确率、精准率、召回率分别提升3.81个百分点、5.98个百分点、2.06个百分点;基于YOLOv3检测模型,经过增广后图像识别的準确率、精准率、召回率则分别提升3.58个百分点、4.93个百分点、2.22个百分点(图10)。

3 讨 论

本研究建立卷积评价机制改进自适应阈值的花粉、孢子图像分割算法 [27] ,利用图像卷积计算后的距离差为度量标准择优选取语义分割图像,相对于常见的Otsu阈值分割法、区域生长阈值分割法、Canny边缘分割法和自适应阈值分割法有更高的分割精准度,有助于图像增广模型生成细节更逼真的孢子图像。

基于Pix2Pix网络 [28] 的花粉、孢子图像增广模型,生成器使用U-Net结构,能够多层次提取特征并综合;判别器借鉴PatchGAN结构,能够突出图像细节。而传统图像增广主要通过旋转、翻转、平移等方式扩充样本数据集,本质是同一张图像,获得的信息增益有限。相对于GAN、CAGN、ACGAN模型,结合语义分割图像的Pix2Pix增广模型,生成的花粉、孢子图像轮廓、纹理、主体结构更加逼真。

利用图像增广后的样本数据集训练Faster RCNN、YOLOv3花粉、孢子检测模型,能够有效提升花粉、孢子检测效果。此前基于神经网络的花粉、孢子检测 [18] 主要涉及10余种类别,精准率89%,拓展花粉、孢子类别后精准率有所下降。本研究算法在149种类别花粉、孢子的基础上,基于Faster RCNN及YOLOv3检测模型的检测精准率分别达到92.16%、90.57%,拓展花粉、孢子检测类别的背景下能够取得更高的精准率。

本研究算法解决了实际应用中花粉、孢子采样难、样本少、种类繁多的难题,为基于图像处理技术的花粉、孢子或其他显微镜下目标检测提供了科学依据,具有较高的研究应用价值。但是当前的算法涉及阶段多,工作流程长。后续研究中将把花粉、孢子图像增广模型和花粉、孢子图像检测模型融合,建立图像增广与花粉、孢子检测一体化模型。

参考文献:

[1] 吴瑞民,李朝献,李妤蓉. 5种快速方法检测真菌孢子的比较[J]. 国际检验医学杂志,2015,36(9):1257-1258.

[2] 刘 惠,冀荣华,祁力钧,等. 基于PCA和BP神经网络的万寿菊黑斑病孢子识别[J].中国农业大学学报,2015,20(6):263-268.

[3] 谢永华,赵贤国,王 琢. 基于突变点几何约束直方图的花粉图像识别[J]. 计算机仿真, 2018,35(12):411-416.

[4] GEETHA N K, BRIDJESH P. Overview of machine learning and its adaptability in mechanical engineering[J]. Materials Today: Proceedings,2020,9:611-617.

[5] RONG C. A summary of research on deep learning in time series learning methods[J]. International Core Journal of Engineering, 2020, 6(9):24-30.

[6] LECROSNIER L, KHEMMAR R, RAGOT N, et al. Deep learning-based object detection, localisation and tracking for smart wheelchair healthcare mobility[J]. International Journal of Environmental Research and Public Health,2020, 18(1):91-99.

[7] YANG J, LI S B, WANG Z, et al. Using deep learning to detect defects in manufacturing: A comprehensive survey and current challenges[J]. Materials (Basel, Switzerland),2020, 13(24):55-57.

[8] MING-FONG T, HUNG-JU T. Enhancing the identification accuracy of deep learning object detection using natural language processing[J]. The Journal of Supercomputing,2021,20(3):525-527.

[9] ITO S, ANDO K, KOBAYASHI K, et al. Automated detection of spinal schwannomas utilizing deep learning based on object detection from magnetic resonance imaging[J]. Spine, 2021, 46(2):195-200.

[10] ZENG Y N, DUAN Q W, CHEN X R, et al. UAVData: A dataset for unmanned aerial vehicle detection[J]. Soft Computing,2021, 25:5385-5393.

[11] HU J Y, RICHARD S C J, ZHANG J S. Saliency-based YOLO for single target detection[J]. Knowledge and Information Systems,2021,63 :717-732.

[12] KARIM S, ZHANG Y, YIN S L, et al. Auxiliary bounding box regression for object detection in optical remote sensing imagery[J]. Sensing and Imaging,2021, 22(1):305-315.

[13] SONG Z N, SUI H G, LI H. A hierarchical object detection method in large-scale optical remote sensing satellite imagery using saliency detection and CNN[J]. International Journal of Remote Sensing, 2021, 42(8):2827-2847.

[14] ZHOU S R, JIA Q. Enhanced SSD with interactive multi-scale attention features for object detection[J]. Multimedia Tools and Applications,2021,80(11):539-556.

[15] LI H, DONG Y, XU L W, et al. Object detection method based on global feature augmentation and adaptive regression in IoT[J]. Neural Computing and Applications,2021, 33(4):119-131.

[16] OMARA I, HAGAG A, MA G Z, et al. A novel approach for ear recognition: learning Mahalanobis distance features from deep CNNs[J]. Machine Vision and Applications,2021, 38(20):1155-1160.

[17] GAO J F, QUMMAR S, ZHANG J M, et al. Ensemble framework of deep CNNs for diabetic retinopathy detection[J]. Computational Intelligence and Neuroscience, 2020,8(6):698-709.

[18] RAMON G C,CARLOS J G O, ANTONIO G M, et al. Precise pollen grain detection in bright field microscopy using deep learning techniques [J].Sensors, 2019, 19(3): 583-595.

[19] VOACTOR S, JOSE A L, AZNARTE I D. Improving classification of pollen grain images of the POLEN23E dataset through three different applications of deep learning convolutional neural networks[J]. PLoS One,2018,13(9): 107-120.

[20] 潘浩晨,舒軍武. 第四纪主要孢粉数据库评述[J]. 微体古生物学报,2020,37(2):188-196.

[21] PANG Y T, ZHOU X Y, HE W, et al. Uniform design-based gaussian process regression for data-driven rapid fragility assessment of bridges[J]. Journal of Structural Engineering,2021, 147(4):387-399.

[22] WANG J H, GUO Y, WANG Z H, et al. Advancing graph convolution network with revised laplacian matrix[J]. Chinese Journal of Electronics,2020, 29(6):1134-1140.

[23] ZOU L, SONG L T, WEISE T, et al. A survey on regional level set image segmentation models based on the energy functional similarity measure[J]. Neurocomputing, 2020,45(2):606-622.

[24] HUANG C Y, LI X R, WEN Y L. An OTSU image segmentation based on fruitfly optimization algorithm[J]. Alexandria Engineering Journal,2021, 60(1):183-188.

[25] JIANG Y K, QIAN J H, LU S J, et al. LRVRG: a local region-based variational region growing algorithm for fast mandible segmentation from CBCT images[J]. Oral Radiology,2021, 9(1):201-210.

[26] HUANG C, JIN W, XU Q, et al. Sub-pixel edge detection algorithm based on canny-zernike moment method[J]. Journal of Circuits, Systems and Computers,2020, 29(15):273-285.

[27] WANG T, WANG X F, GEORGE S L, et al. Design and analysis of biomarker-integrated clinical trials with adaptive threshold detection and flexible patient enrichment[J]. Journal of Biopharmaceutical Statistics, 2020,30(6) :1060-1076.

[28] WEN P, CARLOS T V, MICHAEL J P. Stochastic pix2pix: A new machine learning method for geophysical and well conditioning of rule-based channel reservoir models[J]. Natural Resources Research, 2020, 30:1319-1345.

[29] 張偌雅,李珍珍.数字图像质量评价综述[J].现代计算机,2017(29):78-81.

[30] MA S L, HUANG Y, CHE X J, et al. Faster RCNN-based detection of cervical spinal cord injury and disc degeneration[J]. Journal of Applied Clinical Medical Physics,2020, 21(9):235-243.

[31] AHMED I, JEON G, CHEHRI A, et al. Adapting Gaussian YOLOv3 with transfer learning for overhead view human detection in smart cities and societies[J]. Sustainable Cities and Society, 2021, 10(70):290-298.

[32] HE F, CHUN R K M, QIU Z C, et al. Choroid segmentation of retinal OCT images based on CNN classifier and fitter[J]. Computational and Mathematical Methods in Medicine,2021,33(5):108-119.

[33] ZHANG Z P, HE J, ZHANG Z W, et al. Emotion recognition algorithm based on panorama-plane mapping dataset and VGG16 in prison monitoring system[J]. Journal of Physics: Conference Series,2020, 16(27):120-130.

(责任编辑:张震林)