深度学习中的对抗样本攻击技术

2021-10-28杨奎武张田

◆杨奎武 张田

深度学习中的对抗样本攻击技术

◆杨奎武 张田

(解放军战略支援部队信息工程大学 河南 450001)

作为人工智能核心的深度学习技术目前已被广泛应用于自然语言处理、机器视觉、决策推理等领域。相比于以往深度学习更加关注模型或算法的效率和性能,当前深度学习面临的安全问题也成为学术界研究的焦点,尤其是对抗样本攻击更是对深度学习的安全性和鲁棒性造成了影响。本文在对对抗样本的概念及其成因介绍的基础上,重点对对抗样本的分类方法、生成方法进行了分析和阐述,并给出了相关对比结果。最后论文从应用角度对对抗样本的作用进行了分析与总结,给出了未来对抗样本攻击的重点研究领域。

人工智能;深度学习;对抗攻击;对抗样本

1 引言

随着人工智能的快速发展,深度学习相关理论和技术目前已经广泛应用于自然语言处理、机器视觉、决策推理、关联分析等领域,但由于深度学习技术自身可解释性差、对训练数据依赖性强、相关模型或算法鲁棒性弱等原因,因此,深度学习技术在给我们生活带来方便的同时,也面临着非常严峻的安全问题,这其中对抗样本攻击就是深度学习模型和算法需要面对的一种典型攻击方式。

2 对抗样本及其成因

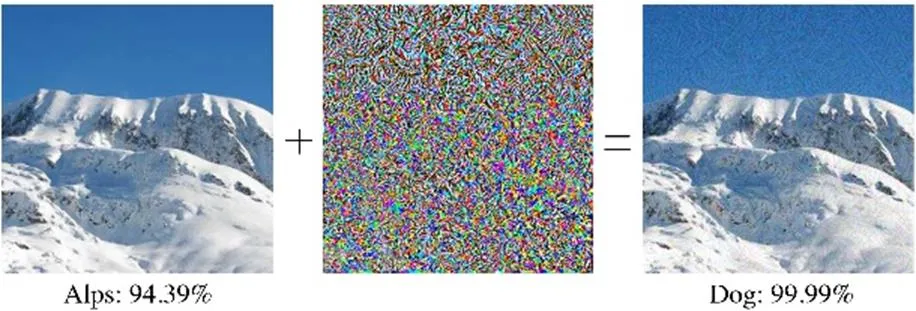

图1 Inception-v3中快速对抗样本生成

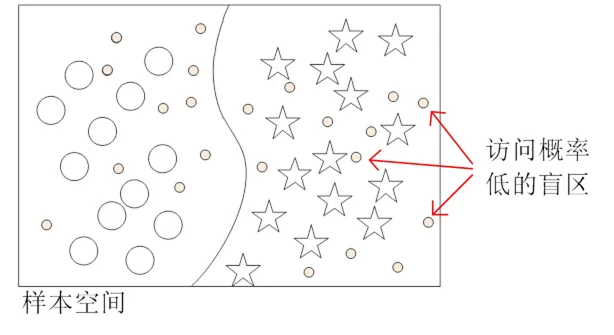

对抗样本的成因有多种解释,Szegedy等人[1]认为对抗样本是分布在低概率区域的数据,属于样本数据的盲区,由于深度模型的泛化性不够,使得盲区数据成为对抗样本,如图2所示。

图2 对抗样本“盲区”假说示意图

Goodfellow等人[3]认为神经网络的高维线性是对抗样本的主要成因,输入数据的微小变化,经过网络线性放大,就可能造成判决失误。Moosavi-Dezfooli 等人[4]则提出了决策面假说,认为存在一个低维子空间包含了决策边界的大多数法向量,而属于该子空间的对抗扰动便可以干扰大多数分类模型。由于深度学习模型的高度复杂性使其难以进行数学描述,因此不同的假说往往具有不同的侧重点,很难达成数理层面的统一认识。这也为对抗样本攻击提供了空间,使其难以防御。

3 对抗样本攻击分类

3.1 白盒攻击与黑盒攻击

在白盒攻击中,攻击者需要对目标模型有着准确的把握,比如掌握目标模型的网络结构、参数、应用场景等等。而在黑盒攻击中,通常假设攻击者对目标模型内部并不了解,只能通过不断向模型进行数据输入,然后观察模型的输出来实现和模型的互动。

3.2 有目标攻击与无目标攻击

有目标攻击也称为针对性攻击,是指攻击者可以设定攻击范围和攻击效果,从而使被攻击模型不但对样本进行错误分类,而且把样本分类为攻击者想要的类别。无目标攻击也称为可靠性攻击,攻击者的攻击目的只有一个,就是使被攻击模型出现决策错误,但并不指定分类的类别。

范数是一种强化了的距离概念,在对抗样本中用于测量扰动的大小,范数的定义为:

3.4 数字攻击与物理攻击

对抗样本在计算机、数字世界中的攻击行为被称为数字攻击;基于数字世界中的对抗样本,设计生成能够物理实现的对抗样本并对深度学习等模型进行攻击的方式称为物理攻击。比如利用对抗样本技术设计具有特殊图案的眼镜对深度学习人脸检测系统进行干扰使其识别错误。

4 对抗样本生成方法

对抗样本的生成更多以黑盒攻击和白盒攻击进行分类,早期基于白盒攻击的方法相对更多,但黑盒攻击往往更具有现实意义。当前比较典型的对抗样本生成方法有基于梯度的FGSM生成算法、深度欺骗攻击、JSMA攻击等。

4.1 快速梯度符号法(Fast Gradient Sign Method,FSGM)

图3 不同阈值攻击效果图

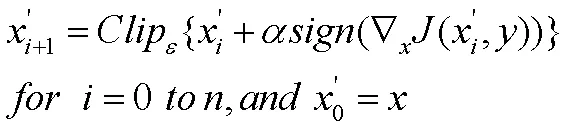

4.2 基础迭代法(Basic Iterative Method,BIM)

为了使得扰动尽量接近最优,基于白盒攻击FGSM又提出了很多方法,比较典型的就是BIM[5](又称Iterative-FGSM,I-FGSM),它是在FGSM的基础上加入了迭代过程,产生的扰动更加接近最优。该方法沿着损失函数梯度增加的方向通过每次迭代增加较小的扰动,采用多步小步的方式计算扰动值,迭代过程如下:

4.3 深度欺骗算法(DeepFool)

图4 多分类问题DeepFool方法示意

4.4 雅克比显著图攻击(Jacobian-based Saliency Map Attack, JSMA)

基于不同点的像素值对输出判决结果影响程度的不同,Papernot等人[7]提出了JSMA方法。FGSM和DeepFool一般生成的是非定向对抗样本,而JSMA以特征对输出结果的影响程度为依据,可以达到生成定向对抗样本的目的。JSMA通过计算前向导数生成对抗性显著图,显著图则体现了输入的不同特征对输出的影响程度,该方法也属于白盒攻击。

4.5 单像素攻击(One-Pixel Attack,OPA)

单像素攻击[8]是一种黑盒攻击方法,它使用遗传进化算法来发现扰动应该添加的位置。单像素攻击的目的是通过只在原始图像的一个像素点上添加扰动来影响目标模型的判决[9]。这种攻击方法是典型的黑盒攻击方法,无须对目标模型有深入的了解,实验表明该攻击在多种模型下都有较好的攻击效果。由于单个影响较大的像素点不容易发现,因此单像素攻击通常也会对多个像素点进行修改。

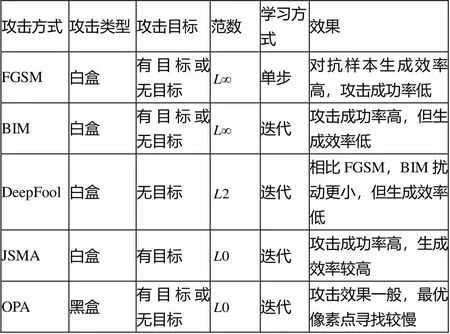

表1从攻击类型、攻击目标、学习方式、攻击强度及算法优劣五个方面对以上几种对抗样本生成方法进行了分析。

表1 对抗样本攻击方法及对比

5 结束语

以深度学习为典型代表的人工智能技术的快速发展,在给我们生活带来便利的同时,也面临着以对抗样本攻击为代表的安全威胁,严重损害了深度学习模型的完整性与可用性;但同时,对抗样本技术也可以用来对用户信息进行主动防护,防止敌对设备对用户信息的有效识别与获取,起到防止泄密的作用。

本文对对抗样本攻击基本情况进行了概述,并对其典型的生成方法进行了总结和分析。除图像领域外,对抗样本攻击在文本数据、语音数据、图数据等领域也广泛存在,这也将是人工智能安全以及对抗样本未来研究的热点。

[1]Szegedy C,Zaremba W,Sutskever I,et al. Intriguing Properties of Neural Networks[C/OL].Proc of ICLR.[2019-11-01]. https://arxiv.org/abs/1312.6199.

[2]Yinpeng D,Fangzhou L,Tianyu P,et al. Boosting Adversarial Attacks with Momentum[C],Proc of CVPR2018:9185-9193.

[3]Goodfellow I,Shlens J,Szegedy C,et al. Explaining and Harnessing Adversarial Examples[C/OL].Proc of Int Conf on Learning Representations.[2019-11-01]. https://arxiv.org/abs/1412.6572.

[4]Moosavidezfooli S,Fawzi A,Fawzi O,et al. Universal Adversarial Perturbations[C].The IEEE Conference on Computer Vision and Pattern Recognition. 2017:1765-1773.

[5]Kurakin A,Goodfellow I,Bengio S,et al. Adversarial Machine Learning at Scale[C],Proc of ICLR.2017.

[6]Moosavidezfooli S,Fawzi A,Frossard P,et al. DeepFool:A Simple and Accurate Method to Fool Deep Neural Networks[C]. Computer Vision and Pattern Recognition,2016:2574-2582.

[7]Papernot N,Mcdaniel P,Jha S,et al. The Limitations of Deep Learning in Adversarial Settings[C]. IEEE European Symposium on Security and Privacy,2016:372-387.

[8]Jiawei SU,Vasconcellos D V,Sakurai K. One pixel attack for fooling deep neural networks[J]. Proceedings of IEEE Transactions on Evolutionary Computation,2019, 23(5):828-841.

[9]姜妍,张立国,面向深度学习模型的对抗攻击与防御方法综述[J],计算机工程,2021,47(01):1-11.