基于深度相机的边缘融合直接位姿估计方法

2021-10-15王鹤群彭晓东周武根

王鹤群,彭晓东,周武根

(1.中国科学院国家空间科学中心,北京 100190;2.中国科学院大学 计算机科学与技术学院,北京 100049)

0 引 言

在计算机视觉领域中,无人驾驶、无人机自主导航及增强现实等应用的兴起使得即时定位与地图构建(simulta-neous localization and mapping,SLAM)技术[1]备受关注。视觉里程计(visual odometry,VO)对相机位姿进行估计,是视觉SLAM的重要组成部分。深度相机能够解决单目视觉的尺度不确定性问题,故基于深度相机的位姿估计逐渐成为研究热点。

相比于ORB-SLAM[2,3]等采用的特征点法,DVO[4],DVO-SLAM[5],LSD-SLAM[6]等采用的直接法通过最小化灰度残差从而解得最优位姿,避免特征点匹配数量不足而无法估计位姿等问题。但光照变化、相机曝光变化以及噪声降低了位姿估计的准确性。近几年出现了一些基于边缘的位姿估计方法,如D-EA[7],EdgeDirectVO,REVO[8]等。其中使用的Canny[9]等传统方法只能提取灰度梯度大的像素作为边缘像素而忽略了其他的图像信息。而REVO中使用基于深度学习的方法进行边缘检测,使得其对于光度变化、不同类型的场景更具稳定性,能在一定程度上提高位姿估计的准确性和鲁棒性。

为了解决现有基于边缘的方法对光度变化敏感、提取边缘不稳定的问题,本文提出了基于深度相机的边缘融合直接位姿估计方法并通过实验证明了方法的优越性和鲁棒性。

1 基于深度相机的边缘融合直接位姿估计方法

1.1 方法框架

本文提出的方法框架如图1所示,主要分为边缘提取与位姿估计两大模块:1)边缘提取过程中使用双阈值法融合Canny边缘检测方法与深度学习方法提取到的边缘结果;2)位姿估计中使用非参数统计方法拟合边缘像素残差形成误差函数,优化计算估计相机位姿。

图1 方法整体框架

其中,Canny边缘检测使用灰度图像,基于深度学习的边缘检测方法使用RGB图像,深度图则用于获得图像中边缘像素对应的三维空间中的深度。

1.2 边缘提取方法

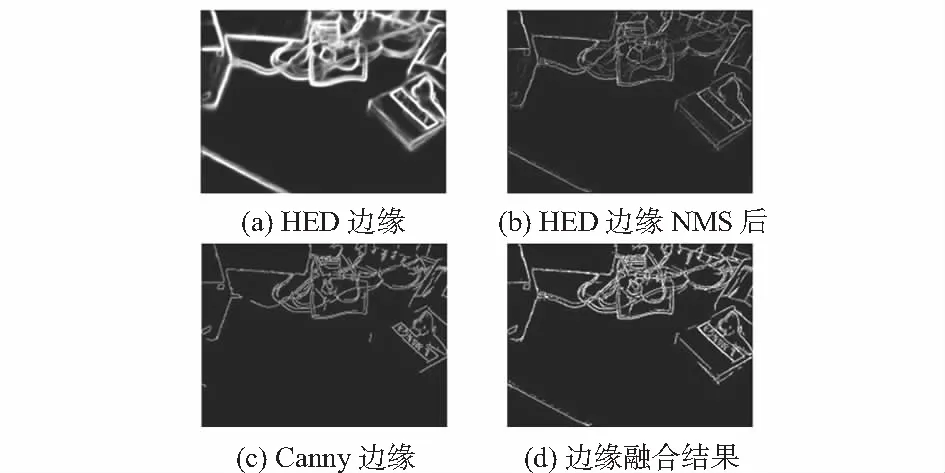

Canny边缘检测方法多关注于梯度较高的区域,容易产生较多的噪声;而基于深度学习的边缘检测方法则比较关注场景边缘的整体性,容易漏掉一些梯度较高的细小边缘。针对这两种边缘检测方法的局限性,本文采用基于深度学习的边缘检测方法HED[10]与Canny边缘检测方法相结合的方式,可实现鲁棒的边缘检测效果。图2(a)表示HED的边缘检测结果,做非极大值抑制(non-maximum suppression,NMS)处理得到本文所使用的边缘信息,如图2(b)所示;Canny效果如图2(c)所示。

图2 Canny与HED边缘检测效果对比

对于图像I的边缘像素集合ECanny(I)和EHED(I),采用双阈值法进行连接和融合。设高阈值为THhign,低阈值为THlow,则该方法可分为以下步骤:1)将ECanny(I)的像素作为强边缘,并将EHED(I)中灰度值大于THhign的像素加入强边缘集合;2)EHED(I)中灰度值小于THlow的像素认为不是边缘;3)对于EHED(I)中灰度值介于THlow和THhign之间的像素加入弱边缘集合;4)对于弱边缘集合中的像素,若周围的8个像素存在强边缘,则该弱边缘像素转换为强边缘;否则作为非边缘处理。

将最终强边缘集合中的像素作为本文方法的边缘,用E(I)表示,如图2(d)所示。可以看出相比于Canny方法和HED方法的边缘提取结果,本文提出的边缘检测方法有更好的信噪比和更多清晰的边缘像素。

1.3 相机位姿估计方法

1.3.1 相机模型

为了实现空间中3D点与图像上2D点的相互转换,本文采用针孔相机模型成像原理。根据模型,空间中的点P=(X,Y,Z,1)T映射到图像上的像素位置表示如下

(1)

式中fx,fy为相机的焦距,ox,oy为相机的光心位置,Z=Z(x)为像素点在空间中的测量深度,由深度相机直接获得,π为三维空间到图像的映射。同理,图像中某位置为x=(x,y)T的像素点,在空间中的位置用齐次坐标可表示为

(2)

式中π-1为三维空间到图像的映射关系。

1.3.2 相机运动模型及变换函数

相机运动在三维空间中遵循刚体运动规则,分为平移和旋转两部分,共6个自由度。其中,平移运动用三维向量t表示,旋转运动用3×3的正交矩阵R表示,则相机运动形成的位姿变换矩阵T如下式表示

(3)

空间中点坐标P在相机运动后至坐标P′的位置变换表示为

P′=TP

(4)

经过相机运动,图像中像素x对应的空间点在后一帧图像中的位置变换至x′,根据式(2)可整理得

x′=π(Tπ-1(x,Z(x)))

(5)

1.3.3 边缘残差非参数统计与目标函数

(6)

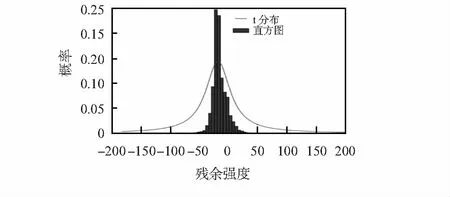

在TUM数据集[11]上对边缘像素的灰度残差进行统计。受文献[12]启发,本文采用基于t分布(t-distribution)的非参数统计模型来拟合像素残差分布,如图3所示。

图3 边缘像素残差统计与t分布

灰度残差的t分布非参数统计模型表示为

(7)

式中v为t分布的自由度,实验中,v取为9可以获得较好的位姿估计效果;μe为所有边缘的灰度残差均值,表示为

(8)

σe为边缘残差的估计标准差,使用绝对中位差(median absolute deviation,MAD)来估计

(9)

此时,对于所有N个边缘像素,可以根据非参数统计模型给出合理的权重,加权后的灰度残差对应误差函数为

(10)

为了便于优化,式中使用的ζ∈SE(3)为相机变换矩阵在李代数下的表示形式。迭代更新ζ使得误差最小,ζ*即为估计的相机位姿

(11)

为了使得式(11)的求解寻优过程不陷入局部极小值,相机位姿估计模型需要放在金字塔模型框架中优化求解。

2 实验与结果

2.1 实验设置

为了验证本文基于边缘融合的位姿估计方法的性能,实验在TUM RGB-D数据集[12]上选取了7个代表性的序列进行算法评估。该数据集中包含RGB图、深度图,以及真实的相机位置信息、相机内参,是用于视觉SLAM方法性能对比的标准数据集。

实验硬件平台为台式计算机,配有频率为4.00 GHz的8核Intel Core i7—6700K型号CPU、NVIDIA Quadro M4000显卡。操作系统为64位的Ubuntu 16.04。

2.2 实验结果与分析

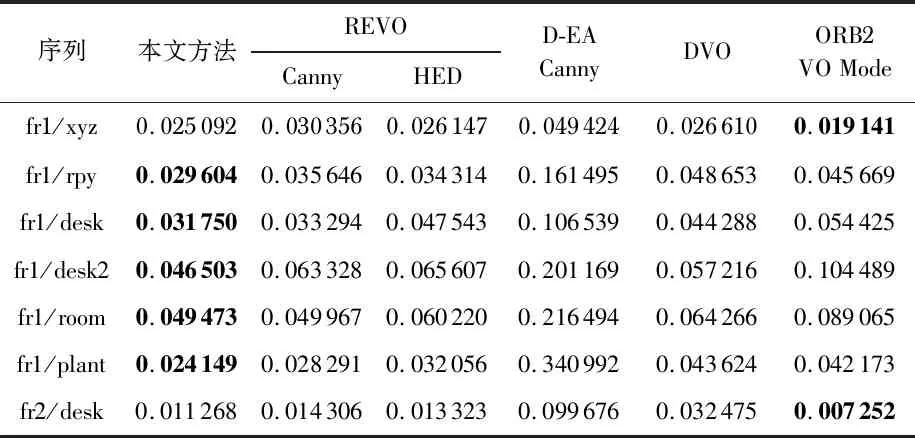

为了与其他VO和SLAM方法进行对比,实验采用相对位姿误差(relative pose error,RPE)的均方根误差(root mean squared error,RMSE)对本文方法及对照方法进行评价。RPE越小表示位姿估计效果越好,包括平移和旋转两方面。表1为本文方法与REVO[9],D-EA[7],DVO[4],VO模式的ORB-SLAM2[3]方法在7个序列上的平移RPE对比。

表1 多种方法的平移RPE对比 (m/s)

表1中的加粗数据表示同一个序列下的最优结果。从表1中可以看出,虽然ORB-SLAM2在其中2个序列上表现最佳,但本文方法在大多数序列上取得了更好的结果。而相比之下,表中其他位姿估计方法只在少部分序列上取得了与本文方法相近的效果。这些结果表明,本文提出的方法整体上要优于对比方法。

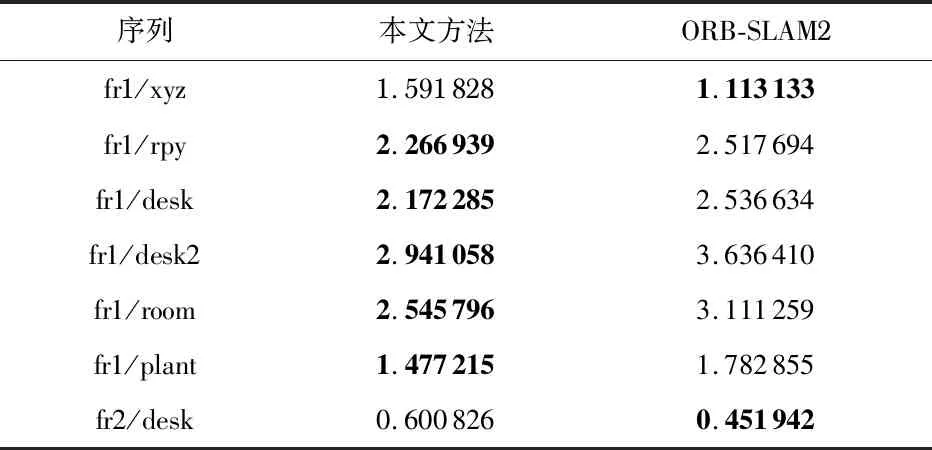

表2对比了本文方法与ORB-SLAM2的VO模式下的旋转RPE结果,本文方法在其中5个序列上的旋转误差均较小,表明本文方法的性能整体上要优于ORB-SLAM2。

表2 本文方法与ORB-SLAM2的旋转RPE对比 ((°)·s-1)

图4(a)和(c)对比了ORB-SLAM2的VO模式与本文方法在fr1/desk序列上随时间变化的平移误差,可以直观地看出,本方法相比于ORB-SLAM2,平移误差明显减小。该结论也可以反映在图4(b),(d)中的轨迹估计误差中,本方法相比于ORB-SLAM2方法而言,轨迹估计结果更接近于相机真实轨迹。因此,以上实验都说明,本文所提的相机位姿估计方法具有更高的精度和更好的鲁棒性。

图4 fr1/desk序列上ORB-SLAM2与本文方法的平移误差及轨迹对比

3 结 论

本文针对基于边缘的方法对光度变化敏感、提取边缘不稳定而影响位姿估计准确性的问题,提出了Canny边缘检测与基于深度学习的边缘检测进行融合的鲁棒边缘检测方法。引入了非参数统计模型来拟合边缘像素的残差分布,然后通过基于直接法的边缘位姿估计方法估计相机位姿。最后,通过实验证明了本文方法的优越性。