基于CLDNN的调制信号识别方法

2021-10-15符杰林林基明

张 军 符杰林* 林基明

1(桂林电子科技大学认知无线电与信息处理教育部重点实验室 广西 桂林 541004) 2(广西高校卫星导航与位置感知重点实验室 广西 桂林 541004)

0 引 言

在无线通信领域,通信调制信号的识别技术一直以来都是各国研究的热点,它在军事及民用领域有很高的使用价值。目前,调制识别技术有两大类方法:基于决策论的调制识别和基于特征工程的调制识别。前者具有完备的理论基础,但算法的理论推导复杂,且需要充分的先验知识,信号识别率不高;后者是对信号进行关键特征提取,如信号的高阶累积量[1]、循环谱特征[2]、谱特征等,然后针对不同调制信号的特征使用分类器进行分类识别。上述两类方法都需要人工参与提取特征,并且针对不同的信号通常只能提取表层的特征。因此,需要寻找一种方法,能从原始信号源中提取有利于信号识别的深层特征,而深度学习为此提供了一个强有力的框架。

文献[3-5]率先将深度学习应用至调制信号识别领域。为了使研究人员更好地研究与比较,文献[6]用GNU Radio生成具有同相和正交信息的不同调制信号的开源数据集。O’Shea等利用基带IQ信号训练不同的神经网络,合适的网络模型具有较高的识别率。文献[7]将原始IQ数据和计算所得的高阶累积量组合在一起表示调制信号,并用三层卷积层和一层长短期记忆层网络进行训练分类,但需要预先计算每个信号的高阶累积量。Li等[8]利用信号的循环谱和深度自编码器,完成了对FSK、PSK、ASK、MSK和QAM五类调制信号的识别,但需要预处理获得每个信号的循环谱信息。文献[9]利用眼图和卷积神经网络对4PAM等信号进行识别。文献[10]将信号的星座图转换为彩色图,并结合卷积神经网络对ASK、PSK和QAM等信号进行识别,但都需要对信号进行预处理成图片。文献[11]不需要预处理,利用LSTM网络,当信噪比为-2 dB时,针对八类数字调制信号和三类模拟调制信号的识别率能达到92%,但是信号在经过卷积层后会丢失部分时序信息,并且在低信噪比下识别率不高。文献[12]提出的CLDNN(Convolutional,Long Short-Term Memory,Fully Connected Deep Neural Networks)将CNN、LSTM和DNN 3种网络融合在一起,被广泛用于解决语音识别问题,实验证明该网络可以获得比单一的CNN、LSTM和DNN网络有更好的效果。

对此,本文利用CNN擅长减小频域变化,LSTM能够提供长时记忆,擅长对时域信息进行建模,DNN适合将特征映射到独立空间的特点[12],设计了一个适用于调制信号识别的CLDNN网络。该方法充分利用了深度学习端到端处理的优势,能够提取信号分类的关键信息,并对11种常见的调制方式进行分类,与已有的方法进行比较,识别精度有所提升。

1 适用于调制信号识别的CLDNN网络建模

CLDNN首先在语音识别领域中有广泛的应用,该网络通用结构是输入层与时域相关的特征,连接几层CNN来减小频域变化,将CNN的输出输入至几层LSTM来减小时域变化,LSTM最后一层的输出输入至DNN,目的是将特征空间映射到更容易分类的输出层。对此,为实现调制信号的识别,本文建立了适用于调制信号识别的CLDNN网络模型,如图1所示,由三部分组成:1) 三层卷积层;2) 一层长短期记忆网络;3) 两层全连接层和分类器。

图1 CLDNN网络模型

本文网络的输入层为IQ两路时域信号的原始数据,2×128代表了每个样本的数据矩阵,128为同相正交分量的采样点个数。首先将原始数据输入至CNN网络,第一层卷积层由50个大小为2×7的卷积核与输入进行卷积,输出为一维的特征数据,将该层的特征输出与后面两层卷积层短连接,加强了特征的传递和重用。卷积层均使用ReLU函数作为激活函数。将第一部分中每层卷积层的输出进行级联,输入至第二部分LSTM层,目的是为了充分提取信号的时序特征。

LSTM的记忆功能主要由三个控制单元组成,分别是遗忘门ft、输入门it、输出门ot,如图2所示。

图2中,Ct表示当前LSTM单元的细胞状态,保留了历史信息;xt和ht分别表示当前单元的输入信息和输出信息。具体计算过程如下:

ft=σ(Wf·[ht-1,xt]+bf)

(1)

式中:ft遗忘门用来计算t时刻之前的状态对当前状态的影响,若ft为1,则保留全部历史信息,若为0,则不参考之前的信息[13];σ为sigmoid函数;Wf为输入和遗忘门之间的权重矩阵;bf为连接的偏置。

it=σ(Wi·[ht-1,xt]+bi)

(2)

(3)

(4)

ot=δ(Wo·[ht-1,xt]+bo)

(5)

ht=ot×tanh(Ct)

(6)

式中:ot输出门与Ct用来更新t时刻当前单元的输出ht;Wo为输入和输出门间的权值矩阵,bo为偏置。

第三部分,将LSTM层输出至全连接层和softmax层,主要用来对输入进行降维分类,第一层全连接层节点大小设置为128,后一层节点大小设置为11,以11维的概率向量形式输出,以最大概率值的索引作为分类结果。同时输出层定义一个交叉熵损失函数,以降低损失函数为目标进行网络模型的训练。此外,为防止过拟合,训练时采用Dropout正则化技术,每隐藏层神经元均以0.5概率的数量保持原有的状态,即这些神经元不参与前向传播和反向传播计算。

2 仿真分析及性能对比

为验证模型的有效性,本文采用RML2016.04c及RML2016.10a[14]两个开放数据集进行研究,并且这两个数据集的数量及类型适合本文的工作。数据集中包含了11类不同调制信号的样本集,分别是8类数字调(BPSK,8PSK,CPFSK,GFSK,PAM4,QAM16,QAM64,QPSK)和3类模拟调制(AM-DSB,AM-SSB,WBFM),信号在信噪比-20~18 dB范围分布,间隔为2 dB。在不同SNR条件下,每个样本信号均由IQ两路组成,采样点数为128个。此外,两个数据集为模拟真实环境,在模拟信道中考虑了中心频移、多径、衰落和加性高斯白噪声等影响因素。

实验首先对CLDNN网络的性能及部分参数进行分析,采用RML2016.10a数据集共220 000个样本,将其中的70%作为训练集,30%作为测试集,从卷积层的数量、卷积核的数量及卷积核的大小考虑,确定一个网络性能最优的卷积状态,然后分析不同LSTM层的数量对网络性能的影响。最后在两个数据集上,将本文网络模型与文献[1]和文献[11]中的方法进行识别性能比对。本文所有网络模型均采用Tensorflow作为后端的Keras框架搭建,实验硬件采用PC,配有六核酷睿i7- 8750CPU,8 GB内存,搭载Nvidia GTX1050Ti 4G显存显卡。

2.1 卷积层数对识别性能的影响

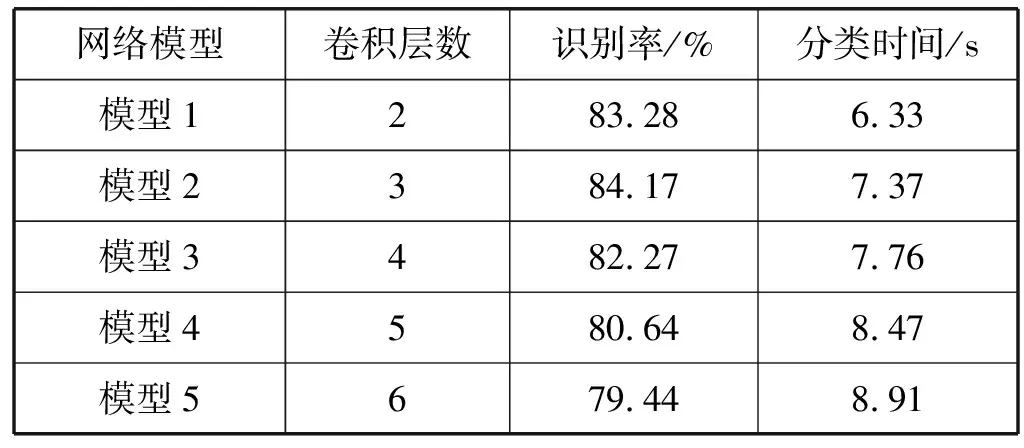

若卷积层数少将提取不出深层的特征信息;过多则提升了模型的复杂度,需要训练更多的实验参数,容易出现过拟合的情况。因此本实验需要讨论卷积层数对识别性能的影响。固定图1 CLDNN网络的卷积核数量为50,大小为×7,保持LSTM层和全连接层结构不变,从2层卷积层网络开始实验,并逐次增加卷积层数,增加的卷积核数量和大小均固定为50、1×7,在实验环境相同的条件下进行模型的训练及测试集的分类。记录训练好的不同网络模型对测试集的分类时间,并且当信噪比大于-2 dB,计算不同卷积层数下的正确识别率如表1所示。由表1可知,当采用3层卷积层数时网络具有最高的识别率和较短的分类时间;随着卷积层数的增加,网络的性能下降,说明当网络采用3层卷积时,卷积层提取的深层特征能够充分反映不同调制信号,继续增加卷积层数会提取一些冗余特征,同时提升模型的复杂度。故下文仿真中卷积层数选取3层。

表1 不同卷积层数对识别率、分类时长的影响

2.2 卷积核对识别性能的影响

为了分析卷积核数量对调制性能识别的影响,固定由2.1实验得出的最佳卷积层数3层,同时固定其他网络结构不变,在30~70间更改卷积核数量,寻找一个核数使识别性能最优,实验得到不同卷积核数对识别率的影响如图3所示。由图3可知,从低信噪比0 dB开始,识别率趋于平稳,不同核数量的识别率近似,最终平稳在82%~85%之间,且当核数为50时具有较高的识别性能。

此外,卷积核尺寸的不同能提取不同程度上的信号特征,尺寸过大会忽略一些空间信息,过小又不能提取关键的特征。因此,固定先前实验中的参数,将第一层卷积设定为2×,后面两层设定为1×,本实验考虑×3至×8间的不同卷积核尺寸对识别性能的影响如图4所示。由图4可以看出,从0 dB开始,不同卷积核尺寸的识别性能趋于稳定,并且当尺寸大小为×7时有相对较好的识别率,在高信噪比时,相对于×4的核尺寸高了近3%。

2.3 LSTM层数对识别性能的影响

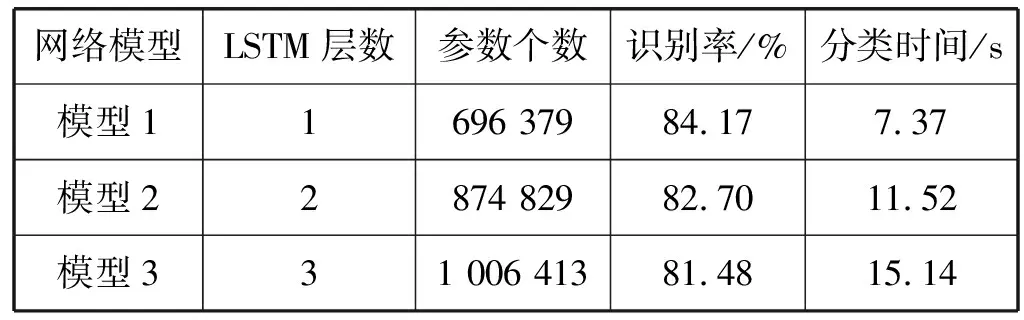

LSTM层能够提取信号的时序特征,LSTM层数过少可能导致时序特征提取不完全,过多则增加了网络的复杂度,可能导致识别性能的降低。本实验需要考虑不同LSTM层数对网络识别性能的影响。固定之前实验的网络结构,将第一层的LSTM输出大小为250,后续增加层数时LSTM输出大小设定为128。记录不同网络模型对测试集的分类时间,并且当信噪比大于-2 dB,计算不同LSTM层数下的正确识别率如表2所示。由表2可知,增加LSTM层数,使网络需要训练的参数个数大量增加,相应地通过网络对测试集的分类时间也持续递增,但对信号的正确识别率成递减趋势,表明一层LSTM的识别性能高于多层,可由一层LSTM充分提取信号的时序特征。

表2 不同LSTM层数对识别率、分类时长的影响

2.4 不同网络性能分析

实验分析比较本文CLDNN网络、文献[1]的CNN网络和文献[9]的CNN_LSTM网络。CNN网络主要由两层卷积层组成,第一层为64个大小为1×3的核,第二层为16个2×3的核;CNN_LSTM在CNN网络基础上添加了LSTM层,并对核数进行了修改。3个网络模型在两个数据上的识别率如图5和图6所示,可知本文CLDNN网络的识别性能最好,其次是CNN_LSTM,CNN网络性能相对较差些。从信噪比-6 dB开始,本文网络的识别性能始终高于CNN_LSTM和CNN网络。由图5所示,当SNR为-2 dB时,CLDNN、CNN_LSTM和CNN的识别率分别达到95.13%、92.21%、89.42%,但随着SNR的增大,识别精度出现抖动现象,这是由于RML2016.04c数据集中样本数量不足,且每类调制信号数量不等导致的。由图6可知,在RML2016.10a中,当数据量充足且每类调制信号数量相等时,网络总体趋势比较平稳,最终三类模型分别稳定在84.84%、82.88%和75.64%。

当信噪比大于-4 dB时,计算三类网络模型的平均识别率如表3所示;三类网络所需训练的参数个数及对1 000个信号的分类时间如表4所示。从表3可以看出,CLDNN在两个测试集的识别率最高,CNN的识别性能最差。在两个数据集中,CLDNN比CNN_LSTM识别率分别高了2.01%和2.6%,这是由于不同信号具有不同的幅度及相位信息,三层卷积层能充分提取信号的深层特征;并且为保留原始信号的时序特征,将每层卷积的输出级联后输入LSTM层,LSTM能提供长时间的记忆,减小时域变化;最后再输出至全连接层和softmax层,将特征空间映射到更能分类的输出层。由表4可知,CLDNN需要训练的参数个数高于后两者,针对1 000个信号的分类时间也相应的增加,这是由于网络的加深,需要计算的参数量加大导致的,CLDNN对每个信号的分类时间比CNN_LSTM多约38 μs。因此,本文设计的网络模型将复杂度的提高作为代价,换来了识别精度上的提升。

2.5 CLDNN网络识别性能分析

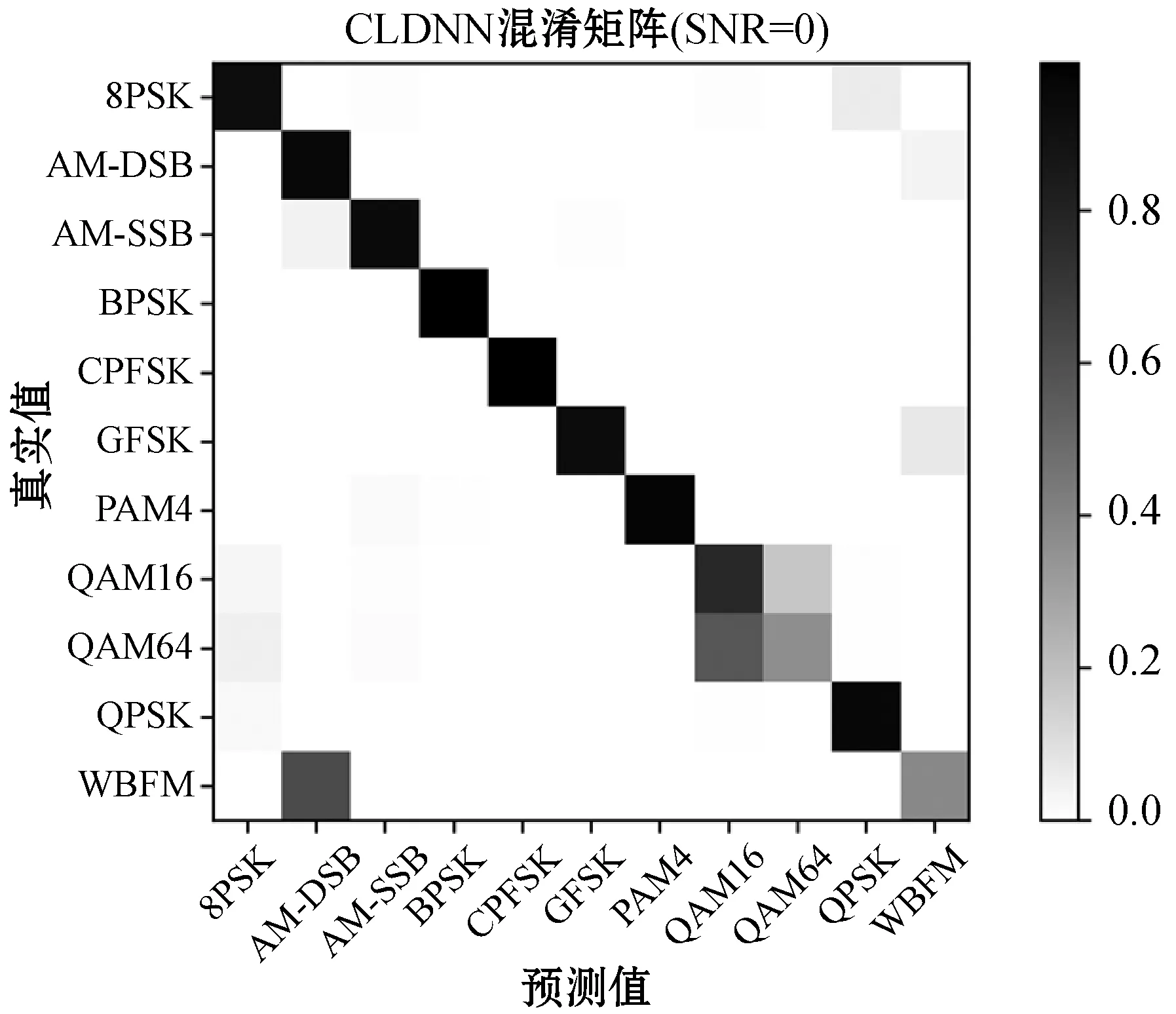

当SNR为-4 dB至12 dB时,CLDNN对各类调制信号识别结果如表5所示。为更直观地说明模型对每种调制信号的分类性能,图7是在信噪比为0 dB下的混淆矩阵图。当信噪比大于0 dB,该模型对各类信号的识别率趋向平稳,对AM-DSB、BPSK、CPFSK、PAM4和QPSK的识别率接近100%,对8PSK、GFSK和AM-SSB的识别率在95%左右。由图7可知,CLDNN网络将WBFM错误地识别成AM-DSB,将部分QAM64识别成QAM16,从而导致了对QAM64、WBFM和QAM16三种信号的识别率低。如何利用深度学习进一步提升识别率是后期需要改进的方向。

图7 SNR=0 dB上的混淆矩阵图

3 结 语

本文对多类数字、模拟调制信号的自动调制识别进行了研究。利用了CNN减小频域变化、LSTM提取时序特征的能力及DNN提取助于分类特征的能力,设计了适用于调制信号识别的CLDNN端到端网络模型。本文方法降低了人工参与度,训练好的网络能有效排除噪声的干扰,并且在低信噪比下提高了信号的识别率。实验结果验证了方法的可行性,具有实际的应用价值。