基于级联式深度网络模型的胃及胰腺自动分割研究

2021-08-31曹洋森朱晓斐韩妙飞卢明智高耀宗顾蕾于春山孙永健张火俊

曹洋森,朱晓斐,韩妙飞,卢明智,高耀宗,顾蕾,于春山,孙永健,张火俊

1.海军军医大学附属长海医院放疗科,上海200433;2.上海联影智能医疗科技有限公司,上海200232

前言

危及器官的结构勾画是肿瘤放射治疗过程中的重要环节之一。不同临床医师之间勾画的危及器官可能存在较大差异[1-3],这些勾画差异将影响后续计划设计阶段中危及器官优化参数的设置以及计划评估阶段危及器官DVH的真实剂量统计。危及器官的勾画耗费了临床医师大量的工作量,以射波刀治疗为例,临床医师在熟练掌握医生工作站的前提下,完成一例胰腺癌患者的结构勾画需要40~80 min,十二指肠、胰腺的结构边界在平扫CT 上常难以界定,如果是术后辅助放疗的患者更难区分改道后的胃、十二指肠,时间成本将更大。

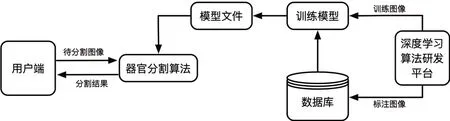

目前基于CT结构自动分割的解决方案主要有两种:一是基于图谱库(Atlas)的自动分割,二是基于深度学习的自动分割。基于图谱库的自动分割研究较为成熟且商业化,但其应用范围更多局限于较为刚性的人体结构部位(头颈部、盆腔等)。对于腹部受正常蠕动及充盈影响形变较大的结构(如胃、十二指肠等),基于Atlas的自动分割效果不理想。基于深度学习的自动分割可以在保证分割精度的同时提高分割速度,但目前开展的研究和应用相对较少。基于深度学习的图像分割流程图如图1所示。卷积神经网络(CNN)在深度学习的图像分割领域运用较为广泛,其中又以U-Net[4]和V-Net[5]应用最多。

图1 基于深度学习器官分割模型流程图Fig.1 Flowchart of organs segmentation model based on deep learning

笔者运用模型压缩思想,对V-Net 中的残差模块重新设计,引入Bottleneck的结构思想[6],将新的网络称为VB-Net。本研究旨在研究VB-Net 在胃及胰腺的自动分割效果。

1 方法

1.1 实验数据

回顾性采集上海长海医院2017年1月~2019年10月期间行射波刀治疗的150 例胰腺癌患者临床资料。所有患者均采用真空垫固定,仰卧位,双手自然放置身体两侧。使用荷兰飞利浦16排大孔径CT模拟定位机扫描定位。扫描条件为120 kVp、400 mAs、1.5 mm 层厚无间隔螺旋扫描。主图像为平扫,在患者吸气末屏气的情况下扫描,界限范围为肿瘤上下界各自增加15 cm。辅助图像为碘造影剂增强扫描,在患者呼气末屏气的情况下扫描,界限范围为肿瘤上下界各自增加5 cm。临床医师使用美国Accuray公司的MultiPlan®治疗计划系统(版本号4.0.2)进行靶区及危及器官勾画。

1.2 自动分割整体方案

本研究在常规V-Net 基础上进一步优化和处理,结合多尺度级联思想策略进一步减少显存消耗,降低网络计算量的同时,显著提升了运行精度和效率。分割模型的建立主要分为数据预处理、模型训练、模型整合、数据测试,技术流程如图2所示。图像预处理阶段是将原始数据重采样为指定分辨率的图像,随机从完整取出图像块,并对图像块进行归一化,加快模型的训练收敛。对图像进行分块操作也是为考虑显存限制,提高模型性能。

图2 基于多尺度级联策略的VB-Net算法流程图Fig.2 Flowchart of VB-Net algorithm based on multiscale cascade strategy

模型训练阶段,通过训练集的CT 及勾画数据训练产生用于器官分割的神经网络模型文件。该阶段需要训练两个模型文件,在粗分辨率(6 mm)和精细分辨率(1 mm)下训练,分别得到粗分割模型文件和细分割模型文件,粗分割模型文件用于后续算法中的器官定位,细分割模型文件用于对器官进行精细分割,经过多次迭代,待训练的失败值较低时,保存训练模型文件。

模型应用阶段,输入待分割图像后,首先对其进行预处理,采用和训练阶段同样的处理方式,将图像降采样为训练阶段粗分割指定的分辨率,归一化按照模型训练阶段采用的归一化方式进行。预处理后图像经过粗分割网络前向计算,得到器官分布概率图。概率图经过后处理可得到粗分辨率下器官的分割结果。截取粗分割结果的感兴趣区作为细分割的初始图像,之后采用同样的预处理模式,将预处理后的图像输入网络前向传播计算,得到器官的概率分布,进行后处理后得到该器官的精细分割结果。

1.3 自动分割实验

150例患者资料中,选取132例非增强CT数据进行胰腺及胃的分割模型训练,并进一步利用其中的116 例胰腺期增强CT 在胰腺模型上继续训练。模型建立时结合多尺度级联思想并开发神经网络算法前向传播框架,合理复用显存,大幅降低显存的使用量,进一步提升运行效率。剩余18 例患者的影像资料作为测试集对得到的分割模型文件进行测试。分别在非增强CT 及胰腺期增强CT 上对分割模型进行测试。

1.4 数据评估

采用戴斯相似性系数(Dice Similarity Coefficient, DSC)定量评估胰腺及胃的自动分割精度,并结合自动分割时间和医生手动勾画时间评估自动分割对器官勾画效率的提升。

DSC的计算公式为:

其中,A指人工勾画确认的金标准分割区域,B指自动分割区域。

2 结果

2.1 自动分割精度

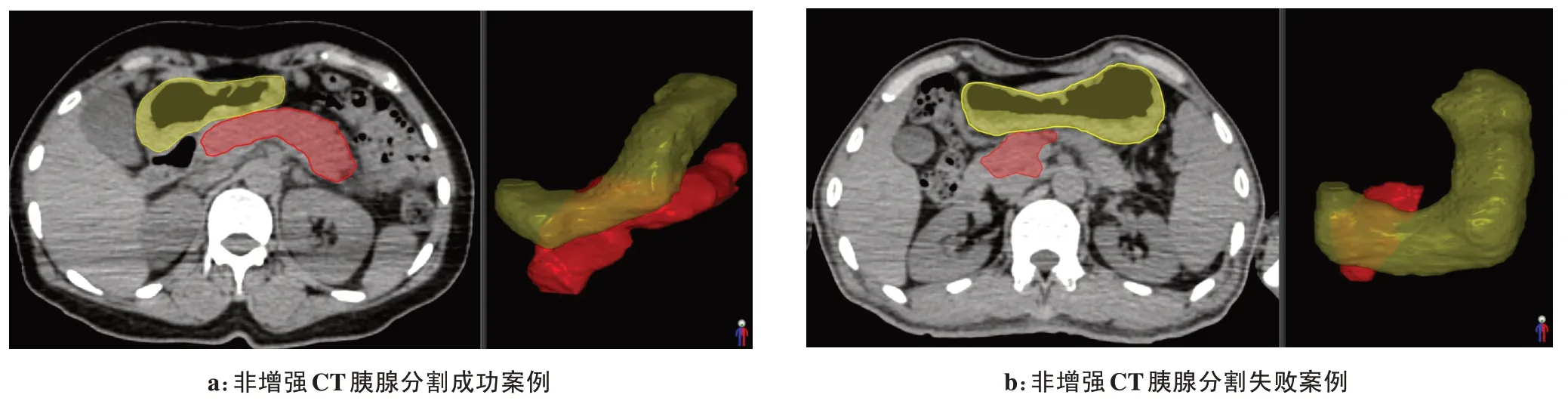

胃及胰腺的自动分割、人工勾画差异情况见图3,利用前期训练得到的分割模型,基于非增强CT 的胃、胰腺的自动分割平均DSC 值分别为87.93%、80.05%;基于胰腺期增强CT 的胃、胰腺的自动分割平均DSC值分别为89.71%、84.79%。

图3 胃及胰腺的自动分割和人工勾画Fig.3 Automatic segmentation and manual segmentation of the stomach and pancreas

2.2 自动分割效率

胃及胰腺的自动分割、人工勾画时间结果见表1。胃的自动分割平均时间为1.22 s,手动分割平均时间为158.7 s;胰腺的自动分割平均时间为0.84 s,手动分割平均时间为115.52 s。增强CT的自动分割时间低于非增强CT。使用自动分割极大提高了分割效率。

表1 胃及胰腺的自动分割、手动分割时间(s,± s)Tab.1 Time for the automatic segmentation and manual segmentation(s,Mean±SD)

表1 胃及胰腺的自动分割、手动分割时间(s,± s)Tab.1 Time for the automatic segmentation and manual segmentation(s,Mean±SD)

CT非增强增强危及器官胃胰腺胃胰腺自动分割1.31±0.19 0.92±0.15 1.13±0.17 0.75±0.12手动分割164.72±33.16 125.33±23.76 152.68±28.33 105.71±17.61

3 讨论

基于图谱库自动轮廓分割方法应用广泛,一般需要几十秒到几分钟即可完成一种器官的自动分割。但在具体临床应用中,由于图谱库数目有限,在分割过程中图谱库很难很好地适应差异性较大的个体,尤其在有病变、占位及手术后的CT 图像上其分割的精度往往达不到临床需求。该方法对不同解剖结构的自动分割能力相差悬殊,结构体积越小,CT值对比度越小,目标与周围组织界限不分明,分割结果越差[7]。分割结果的标准差较大证实了该算法稳定性较差[8-9],分割结果很大程度依赖于操作者的经验知识,一定程度上影响了其在临床上的推广应用。

腹部危及器官中,肝脏、肾脏、脾脏因为器官边界清晰,分割结果相对较好。Christ等[10]研究了基于CT和MR的级联全卷积神经网络CFCNs(U-Net)在肝脏及其肿瘤的自动分割,DSC 值超过94%,分割时间低于100 s。Hu等[11]研究了基于CNNs在肝脏、脾脏、肾脏的自动分割。结果显示3种危及器官的平均DSC值分别为96.0%、94.2%、95.4%,平均分割时间为125 s。胃肠道等危及器官的位置受患者体位、呼吸、蠕动、充盈等多种因素影响,且各软组织脏器之间的CT值灰度差异较小,边界不分明,基于图谱库的研究中未能取得满意的分割效果。Gibson等[12]研究比较了密集扩张卷积网络、多数投票、联合标签融合在肝脏、胰腺、胃和食管的自动分割。结果显示基于多数投票无法完成胰腺分割,肝脏、胃、食管的DSC值分别为85%、49%、25%;基于联合标签融合的胰腺、肝脏、胃、食管的DSC值分别为37%、93%、72%、54%;基于密集扩张卷积网络的胰腺、肝脏、胃、食管的DSC值分别为66%、92%、83%、73%,除肝脏外显著优于另外两种算法。针对胃、胰腺开展的自动分割研究较少,平均DSC值差异较大,胃为55%~87%[13-15],胰腺为45%~74%[13-16]。

本研究针对胃及胰腺,开展基于VB-Net 的器官分割模型训练及测试。目前实验分割结果优于检索文献报道的结果,非增强CT的分割结果劣于增强CT的分割结果,大部分非增强CT 的胰腺分割结果较为成功(图4a),但也有部分非增强CT 的胰腺分割结果失败,未能分割出完整的胰腺轮廓(图4b)。放射治疗的计划CT推荐使用非增强CT,所以在后续研究中考虑在训练集中将胰腺增强CT、增强MR 与非增强CT 数据配准后共同训练迁移学习,提高分割模型在非增强CT中的分割成功率和准确率。

图4 2例基于非增强CT的胃、胰腺自动分割结果示意图Fig.4 Automatic segmentation of the stomach and pancreas in 2 ceses based on non-enhanced CT