通过风格迁移的浓雾天气条件下无人机图像目标检测方法

2021-08-23殷旭平钟平薛伟肖子轩李广

殷旭平 钟平 薛伟 肖子轩 李广

摘 要: 雨雾恶劣天气条件下,无人机获取的图像细节丢失严重,直接对降质图像进行目标检测会导致目标的漏检和错检。先去雾后检测的方法对薄雾天气条件下无人机图像的目標检测性能提升显著,但无法解决目标检测模型过度依靠图像中目标物纹理和表面信息分类的问题, 浓雾天气条件下性能较差。针对这一问题提出通过风格迁移的无人机图像目标检测方法,在保持图像内容不变的基础上改变图像的风格,使目标检测模型从学习目标物纹理和表面信息转变为学习目标物轮廓这一更高难度的任务。实验在无人机数据集Visdrone2019上进行,首先利用不同浓度雾气图像在梯度特征、暗通道特征及小波特征上的差异,将无人机图像划分为无雾、薄雾、浓雾图像。其次针对薄雾和浓雾图像分别采取去雾和风格迁移的处理方式。实验结果表明,通过风格迁移的目标检测方法可以进一步减缓光照、噪声带来的影响,并显著提升无人机浓雾图像的目标检测性能,与先去雾后检测的方法结合,可以自适应地完成无人机浓雾天气条件下图像的目标检测任务。

关键词:无人机图像;雾图像;风格迁移;目标检测;图像分类

中图分类号: TP751; V279 文献标识码: A 文章编号:1673-5048(2021)03-0022-09

0 引 言

随着科学技术的快速发展,无人机技术不断取得新进展。无人机趋于微型化、自动化、智能化,因而被广泛应用在军事和民事领域[1],如自然灾害检测调查、空中侦察预警、航空监测等。目标检测作为无人机感知和理解环境的重要手段,是计算机视觉的一项基础而又高难度的任务[2],长久以来一直被国内外学者所研究。目标检测算法中的一个重要过程是图像特征提取,主要可以分为手工设计特征提取和深度学习特征提取。基于深度学习特征提取的方法在无人机图像目标检测领域有着优良的效果,尤其是对于无人机拍摄的清晰无降质的图像,可以进一步分为双阶段目标检测算法[3-6]以及单阶段目标检测算法[7-10]。两种检测算法各有特点,双阶段目标检测算法准确率和精度更高,适用于需要高精度识别的任务;单阶段目标检测算法速度更快,适合实时识别任务。然而常见的雨雾恶劣天气下,无人机获取的图像质量受到极大的影响,直接对降质图像进行目标检测性能不佳。

一种直接提升降质图像目标检测性能的方法,是在目标检测之前,对降质图像进行去雾,增强图像中的有效信息。然而基于先验的去雾方法,如暗通道先验(DCP)[11]和颜色衰减先验(CAP)[12],基于模型驱动的深度网络去雾方法, 如MSCNN[13]和AOD-Net[14],基于生成对抗网络的去雾方法,如EPDN[15],以及基于编码解码结构的全卷积神经网络去雾方法,如GMAN[16]和MSBDN[17]等,都是以人的视觉感知为基础设计评判标准的。以这种准则为基础设计的图像复原方法,虽然可以获得感知良好的图像,但目标检测模型仍过度关注图像中目标物纹理和表面信息,无法充分利用目标物形状信息,这通常会损失与目标检测相关的有效信息,导致浓雾天气条件下无人机图像的目标检测性能变差。事实上,

相比依靠人的视觉感知复原的清晰图像,风格迁移可能更有利于后续的目标检测、分类、识别、理解等中高层任务。

风格迁移通过图像生成网络对输入图像进行变换,在保持图像内容不变的基础上,将图像风格变换为预设风格。风格迁移可以平滑图像中目标物的局部细小纹理特征,丰富目标物的颜色信息,使CNN不能轻易学到目标物的纹理和表面特征,转而学习目标物轮廓这一更高难度的任务[18],而轮廓是人类和生物视觉中定义形状最可靠的信息。据此,本文提出通过风格迁移的无人机浓雾图像的目标检测方法,对无人机浓雾图像进行风格迁移,来弱化光照、噪声、天气变化等带来的影响,加强目标检测模型对图像中目标物边缘信息的利用。

本文在无人机数据集Visdrone2019[19]上进行实验。实验结果表明,将归一化的梯度特征、暗通道特征及小波特征作为组合特征,可以准确描述不同雾气浓度下无人机图像的特征差异。与先去雾后检测的方法相比,本文方法对真实无人机浓雾图像的检测效果更好,在合成的无人机浓雾数据集上进行检测,mAP50可提升2%~8%。

1 总体方法

本文方法可以自适应地完成不同雾气浓度的无人机图像的目标检测任务,整个过程分3个步骤进行。

(1) 数据集的构建。在无人机数据集Visdrone 2019[19]上根据风格迁移模型以及大气散射模型分别生成32种不同的风格数据集和18种不同浓度的雾天数据集。

(2) 无人机雾天图像的分类。结合图像的梯度特征、暗通道特征及小波特征,通过SVM进行有监督学习, 将无人机雾天图像分为无雾、薄雾、浓雾图像。

(3) 无人机雾天图像的目标检测。根据无人机雾天图像的分类结果,对无雾、薄雾、浓雾图像分别采用直接检测、先去雾后检测、通过风格迁移的检测方法进行图像检测。本文重点描述通过风格迁移的无人机浓雾图像的目标检测方法。

整个工作流程图如图1所示。

1.1 数据集的构建

将无人机数据集Visdrone2019[19]作为基础数据集来构建实验相关的风格数据集和雾天数据集。Visdrone2019由8 629张带标注图像和1 580张不带标注图像组成,包含12类常见目标,如行人、车辆等。该数据集中图像目标物尺度变化较大,从几像素到几千像素不等,且弱小目标十分密集,对其进行目标检测具有一定挑战。

1.1.1 风格数据集的构建

本文采用快速风格迁移模型[20]来生成风格数据集。快速风格迁移模型由图像生成网络和损失网络两部分组成,其结构图如图2所示。图像生成网络本质是一个全卷积神经网络,由5个残差模块和一对下采样和上采样模块组成。通过图像生成网络将输入图像映射成内容和风格与原图像及风格图像相似的输出图像。

损失网络本质是一个特征提取网络。通过预训练的VGG-16网络提取输出图像的感知特征,将其作为度量构建出内容损失函数和风格损失函数。此外,为了使输出图像更加自然,還引入总变分正则函数[21]进行约束。

内容损失函数:

l , jfeat(y^, x)=1CjHjWjj(y^)-j(x)2F(1)

风格损失函数:

Gj(y)c, c′=1CjHjWj∑Hjh=1∑Wjw=1j(y)h, w, cj(y)h, w, c′

(2)

l , jstyle(y^, y)=Gj(y^)-Gj(y)2F(3)

整体损失函数:

L=λcl , jfeat(y^, x)+∑Jλsl , Jstyle(y^, y)+λTVl TV(y^)

(4)

式中:j(·)表示第j层的损失网络;x表示输入的内容图像;y表示输入的风格图像;y^表示输出的图像;Cj,Hj,Wj表示特征变量的通道和高宽; λc, λs, λTV为标量。采用adam优化整体损失函数。

Geirhos等人[18]指出,CNN根据图像中局部纹理和表面信息进行分类,并不是设计出来的,而是由训练数据引起的。标准数据集训练的网络模型可能会通过关注图像中局部颜色和纹理信息来达到分类捷径。而风格数据集通过风格迁移来改变了图像中的局部信息,从而迫使网络模型更多地关注图像全局形状信息。

1.1.2 雾天数据集的构建

目前还没有专门针对目标检测的无人机雾天数据集,因此,本文采用人工合成的方法,借助大气散射模型在Visdrone2019数据集上生成不同浓度的雾天图像。在强散射介质下,引起探测系统成像结果降质有两种原因:一是目标反射光受大气中悬浮粒子的吸收和散射作用,造成目标反射光能量的衰减,导致探测系统成像结果亮度降低,对比度下降;二是太阳光等环境光受大气中散射介质的散射作用形成背景光,通常这部分背景光强度大于目标光,造成探测系统的成像结果模糊不清。

虽然遥感图像与自然图像的雨雾成像模型略有不同,但无人机在中低空飞行时所拍摄图像,其成像模型可以近似为自然图像的雨雾成像模型,表示为

I(x)=J(x)·t(x)+A(1-t(x))(5)

式中:I(x)和J(x)分别代表有雾图像和无雾图像在位置x上像素值;A代表大气光强,是一个常量;t(x)代表位置x上的透射率,表示为

t(x)=e-βd(x)(6)

式中:β代表大气散射系数;d(x)代表场景深度,随着位置的变化而变化。

根据上述方程,采用深度模型[22]估计场景深度d(x),并通过调整参数A和β生成18种不同浓度雾气图像,其中大气光强A∈(0.9, 0.8, 0.7),大气散射系数β∈(0.5, 1.0, 1.5, 2.0, 3.0, 4.0)。以β=3.0划分雾气浓度,β≥3.0时为浓雾图像,β<3.0时为薄雾图像。Visdrone2019数据集中的无雾图像以及生成的景深图像和雾天图像如图3所示。

1.2 无人机雾天图像的分类

针对不同浓度雾气图像自适应地选择合适的处理方法,将会显著提升目标检测模型的性能。综合考虑分类算法的时间复杂度、空间复杂度以及准确率,本文采用基于SVM和混合特征的雾天图像分类算法。经过大量实验分析,发现利用归一化的梯度特征、暗通道特征及小波特征,可以准确地表征不同雾天图像的浓度。因此,本文将上述三种特征作为混合特征完成对无人机雾天图像的分类。

1.2.1 归一化的梯度特征(NGrad)

不同浓度雾气图像最直观的区别是清晰度不同。相同场景下,雾气浓度越低,图像越清晰,图像中目标物边缘信息和梯度信息越丰富。相同雾气浓度下,图像清晰度和目标物景深呈负相关,在不考虑无人机图像倒置的情况下,利用图像上方区域目标物景深大的特点,可以更容易、准确地区分图像的雾气浓度。

本文使用无人机图像上1/3区域的梯度图,来表征图像的清晰度。无雾、薄雾、浓雾图像及对应的局部梯度图像如图4所示。可以发现,随着雾气浓度的加深,局部梯度图中的梯度信息明显减弱。对局部梯度图中灰度值低于200的像素进行直方图统计,将其简化为20维直方图并进行归一化,建立归一化的梯度特征,如图5所示。

1.2.2 归一化的暗通道特征(NDCP)

2009年He等人提出暗通道先验 [11],通过对大量室外无雾图像作统计分析,发现在无雾图像的局部区域存在一些像素,这些像素中至少有一个颜色通道亮度值非常低;相反地,有雾图像中通道亮度值普遍偏高。根据这一特性,本文采用归一化的暗通道特征来区分图像中雾气浓度。图4中无雾、薄雾、浓雾图像对应的暗通道图如图6所示。同样,采取和归一化梯度特征相同的方式,建立20维的归一化暗通道特征,如图7所示。

1.2.3 归一化的小波特征(NWTM)

小波变换在图像处理领域被称为图像显微镜,具有

多分辨能力,可以将图像信号分解为由原始小波位移和缩放后的一组小波,反映图像在不同方向上的高频信息和低频信息。对M×N的图像进行二尺度小波变化后的尺度系数和小波系数分别为

Wφ(j0, m, n)=1MN∑M-1x=0∑N-1y=0f(x, y)φj0, m, n(x, y)(7)

Wiψ(j, m, n)=1MN∑M-1x=0∑N-1y=0f(x, y)ψij, m, n(x, y) (8)

式中:j0为任意的开始尺度;φj0, m, n(x, y)和ψij, m, n(x, y)为尺度和平移基函数, i={H, V, D}; f(x, y)为待变换的图像。在极限情况下,即当j→∞时,可对f(x, y)实现精确表示。

本文采用三尺度小波变换,对图4中无雾、薄雾、浓雾图像进行变换,变换后的尺度系数和小波系数图如图8所示。考虑到尺度系数和小波系数量纲相差太大,将尺度系数缩放10倍,对缩放的尺度系数和小波系数求绝对值的均值并进行归一化,构成10维归一化的小波特征,如图9所示。

1.3 无人机雾天图像的目标检测

目前,针对无人机雾天图像的目标检测,主流方法是直接检测或先去雾后检测,然而这些方法对于无人机

浓雾图像的目标检测效果较差。因此, 本文提出通过风格迁移的无人机浓雾图像目标检测方法。方法的关键在于挑选使目标检测性能最优的迁移风格。文献[23]提出, 风格的选取会对风格迁移过程产生明显的影响,通过精心挑选迁移风格可以使风格迁移效果得到显著的提高。然而目前还没有详细的分析来可靠地确定哪些风格对风格迁移方法有促进作用。为此,本文采用两种评价准则:主观评价及定量评价rAP50来衡量迁移风格的好坏,并从中挑选出使目标检测性能最优的迁移风格。

(1) 主观评价

主观评价迁移风格的好坏,主要基于对原数据集和雾天数据集进行风格迁移后生成的风格数据集,背景是否连续,目标物是否突出,目标物是否发生形变,风格迁移过程中是否产生新的干扰。

(2) rAP50

目标检测问题中最常用评估指标是mAP50,然而当目标检测模型或数据集发生变化时,无法直接通过mAP50数值来衡量各种影响因素之间的相对关系。本文提出一种新的评估指标rAP50,表示为

rAP50=mAPsys50mAPori50 (9)

式中:mAPsys50和mAPori50分别代表目标检测模型在原数据集图像和生成图像上的平均精度。

对不同迁移风格生成的风格数据集进行目标检测,挑选出rAP50较高的迁移风格,作为候选最优迁移风格。

2 实验结果与分析

2.1 实验环境

CPU: Xeon E5-2620 v4 @2.10 GHz; RAM: 16 GB; Graphics Card: RTX 2080Ti @11 GB; Operating System: Ubuntu; Frame: pytorch. 1.2.0。

2.2 基于SVM的无人机雾天图像分类

本文构建的无人机雾天数据集包括18种不同浓度雾气图像,如图3所示。分别随机选取无雾、薄雾、浓雾共4 320张图像组成雾气分类数据集。提取这些图像的归一化梯度特征、暗通道特征及小波特征,合并成50维的混合特征集。

从4 320张图像中随机选出2 592张图像做训练集,1 728张图像做测试集,利用训练集的混合特征集对SVM进行监督学习。SVM分别采用高斯核exp(-γ‖xi-xj‖2), γ=0.9,多项式核(γxTixj+b)d, d=3, b=20,线性核xTixj,以及sigmoid核tanh(γxTixj+b), γ=0.000 1, b=-1。对无人机雾天图像的分类结果如表1所示。

由表1可见,采用高斯核函数时SVM的分类精度最高,可以达到93.4%,且对无雾图像和浓雾图像的分类正确率高于薄雾图像。这是因为本组实验中,采用的测试数据中部分无雾-薄雾图像、薄雾-浓雾图像分类边界模糊,容易被SVM判错,但这并不影响无人机雾天图像的目标检测。例如对于处在薄雾-浓雾边缘的图像,既可以采用先去雾后检测的方法, 也可以采用通过风格迁移的检测方法。

2.3 通过风格迁移的目标检测方法

2.3.1 训练设置

本文采用一阶段目标检测器RefineDet [7]來完成无人机雾天图像的目标检测。考虑到采用Visdrone2019[19]基础数据集训练的目标检测模型仍可有限地利用目标物形状信息,本文将基础数据集、最优迁移风格作用于基础数据集和浓雾数据集生成的风格数据集共同作为训练集,对RefineDet进行重新训练。初始学习率设置为0.001, 动量设置为0.9, 权重衰减设置为0.000 5, 训练迭代轮次设置为 400 000次, 批尺寸设置为16。当迭代次数为200 000和320 000时,将学习率降低至原来的1/10。按照训练验证集和测试集为8∶2 的比例进行数据集的随机分组。

2.3.2 挑选最优的迁移风格

通过风格迁移的目标检测方法的关键在于最适合目标检测的迁移风格的选取,为此需要尽可能包含不同的迁移风格。本文选取了32种包含不同的纹理、形状、颜色以及分布特点的迁移风格,如图10所示。借助快速风格迁移模型[20]在Visdrone2019数据集上生成32种不同的风格数据集,如图11所示。采用RefineDet[7]目标检测模型对这32种不同的风格数据集分别进行检测,相对于基础数据集的目标检测结果rAP50如表2所示。可以发现,选用迁移风格1,5,6,7,13,21,25,29,30时,rAP50较高,均在0.700以上。

对上述9种迁移风格作用于浓雾数据集生成的风格数据集(如图12所示)进行主观评价,可以发现采用迁移风格1,5,6生成的风格数据集的效果明显优于其他迁移风格,表现为背景连续,目标物突出且未发生形变,风格迁移过程中未产生新的干扰。进一步对迁移风格1,5,6作用于浓雾数据集生成的风格数据集进行目标检测,rAP50如表3所示。迁移风格1的rAP50最高,因此,最终选择风格1作为最优迁移风格。综合分析,好的迁移风格通常具备颜色分布均匀、结构简单且平滑、无明显线条感和块状感等特点。

2.3.3 与其他方法的对比

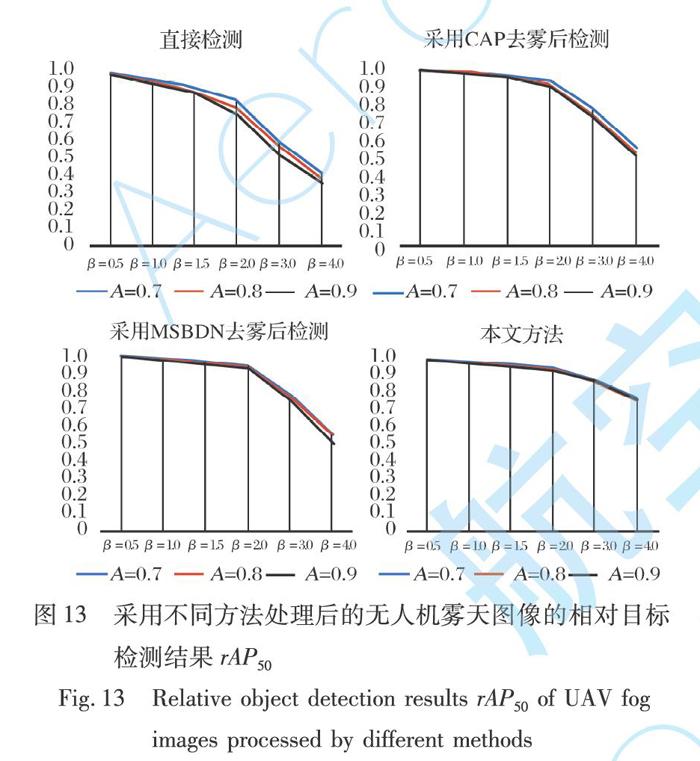

雾气的干扰会使无人机获取的图像细节信息丢失严重,直接对降质图像进行目标检测,性能不佳,如表4所示。采用CAP[12]和MSBDN[17]算法对降质图像去雾, 可以使无人机薄雾图像的目标检测性能得到显著提升,但对于无人机浓雾图像, 该方法性能仍较差,如表5所示。为此, 本文提出通过风格迁移的无人机浓雾图像目标检测方法。本文方法相对于其他方法的优势在于:进一步弱化了雾气干扰对目标检测模型的影响;解决了目标检测模型过度依靠图像中目标物纹理和表面信息分类的问题,使目标检测模型更充分地利用图像中目标物的形状和轮廓信息。

(1) 弱化雾气干扰对目标检测模型的影响

从图13可以看出,大气光强A及大气散射系数β均会对目标检测模型性能产生影响。随着A和β的增大,降质图像相对于原图的目标检测性能逐渐降低。相比于其他方法,本文的方法rAP50下降缓慢,且不同A下,rAP50 基本相等。这说明本文方法可以进一步缓解大气散射和光强变化引起的性能下降。

(2) 充分利用目标物的形状和轮廓信息

当待检测数据集颜色、纹理及表面信息发生较大变化时,目标检测模型性能下降严重,如对图11中采用迁移风格6生成的风格数据集进行检测,mAP50从0.373下降到0.260。而通过本文方法重新训练的目标检测模型可以将mAP50提升到0.299,说明本文方法可以使目标检测模型更充分地利用目标物的形状和轮廓信息。

然而本文方法也存在一定局限性。对合成的18种不同浓度的无人机雾天数据集中的目标物进行分类检测,检测结果如图14所示。可以发现本文方法对大目标,如car,van,truck,bus的检测性能较高,但是对于小目标的检测性能低于其他方法。这是因为学习目标物的形状和轮廓信息是一项更高难度的任务;小目标的轮廓信息较弱,快速风格迁移过程可能会把过小目标的轮廓平滑掉。

进一步,由表4~5可知,对于无人机清晰图像采用直接检测的方法,mAP50最高,为0.373,而对于无人机薄雾和浓雾图像分别采用MSBDN去雾后检测的方法以及通过风格迁移的目标检测方法性能最優。因此,针对不同浓度雾气图像自适应地选择合适的处理方法,将会显著提升目标检测模型的性能。

2.4 真实雾天图像检测

尽管本文方法是在合成的数据集上训练的,但同样适用于真实无人机浓雾图像的目标检测,如图15所示。可以发现,采用MSBDN[17]对浓雾图像去雾后检测,虽然会使降质图像得到一定恢复,但由于浓雾图像中雾气浓度太大,在图像复原过程中容易产生黑影,相较于直接检测的方法性能提升不明显;本文方法可以增大目标物与背景的对比度,将目标物从浓雾背景中凸显出来,并根据目标物的轮廓信息进行准确检测。但本文方法也可能会将风格迁移后轮廓相近的两类物体判别为同类,如图15(d)中将路灯判别为行人。

3 结 束 语

针对无人机雾天图像的目标检测任务,本文首先采用SVM借助归一化的梯度特征、暗通道特征、小波特征形成的混合特征对无人机图像进行雾气分类,并自适应匹配最优的检测算法,其次考虑到先去雾后检测方法无法解决目标检测模型过度依靠图像中目标物纹理和表面信息分类,浓雾天气条件下性能较差的问题,提出通过风格迁移的无人机浓雾图像目标检测方法。本文方法进一步弱化了雾气干扰对目标检测模型的影响,解决了目标检测模型过度依靠图像中目标物纹理和表面信息分类的问题,使目标检测模型更充分地利用图像中目标物的形状和轮廓信息。经测试,相比于其他方法,本文方法对合成和真实的无人机浓雾图像的目标检测性能均有明显的提升,在合成的无人机浓雾数据集上mAP50最高可提升8%。但本文方法对较小目标的检测能力相对较弱,对薄雾图像中目标物的检测性能低于先去雾后检测方法。下一步工作中,将在风格迁移过程中进一步利用图像的深度信息,研究以目标检测为驱动的风格迁移方法。

参考文献:

[1] 路静. 微型无人机的应用现状及未来发展[J]. 集成电路应用, 2018, 35(4): 88-91.

Lu Jing. Application Status and Future Development of Micro UAV[J]. Applications of IC, 2018, 35(4): 88-91.(in Chinese)

[2] 周启晨. 基于深度学习的无人机对地目标跟踪算法研究[D]. 北京: 北方工业大学, 2019.

Zhou Qichen. Research on Object Tracking Algorithm of UAV Based on Deep Learning[D].Beijing:North China University of Technology, 2019. (in Chinese)

[3] Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[4] Girshick R. Fast R-CNN [C]∥ Proceedings of the IEEE International Conference on Computer Vision (ICCV), 2015: 1440-1448.

[5] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[6] Lin T Y, Dollár P, Girshick R, et al. Feature Pyramid Networks for Object Detection[EB/OL].(2017-04-19) [2020-10-13]. https:∥arxiv.org/pdf/1612.03144.pdf.

[7] Zhang S F, Wen L Y, Bian X, et al. Single-Shot Refinement Neural Network for Object Detection[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 4203-4212.

[8] Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection[EB/OL].(2015-06-08) [2020-10-13].https:∥ai2-website.s3.amazonaws. com/publications/YOLO.pdf.

[9] Redmon J, Farhadi A. YOLOv3: An Incremental Improvement[EB/OL]. (2018-04-08) [2020-10-13]. https: ∥arxiv.org/pdf/1804.02767.

[10] Liu W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[EB/OL]. (2015-12-08) [2020-10-13]. https:∥arxiv.org/abs/1512.02325.

[11] He K M, Sun J, Tang X O. Single Image Haze Removal Using Dark Channel Prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353.

[12] Zhu Q S, Mai J M, Shao L. A Fast Single Image Haze Removal Algorithm Using Color Attenuation Prior[J]. IEEE Transactions on Image Processing: A Publication of the IEEE Signal Processing Society, 2015, 24(11): 3522-3533.

[13] Ren W Q, Pan J S, Zhang H, et al. Single Image Dehazing via Multi-Scale Convolutional Neural Networks with Holistic Edges[J]. International Journal of Computer Vision, 2020, 128(1): 240-259.

[14] Li B Y, Peng X L, Wang Z Y, et al. AOD-Net: All-in-One Dehazing Network[C]∥2017 IEEE International Conference on Computer Vision (ICCV), 2017: 4780-4788.

[15] Qu Y Y, Chen Y Z, Huang J Y, et al. Enhanced Pix2pix Dehazing Network[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019: 8160-8168.

[16] Liu Z, Xiao B T, Alrabeiah M, et al. Single Image Dehazing with a Generic Model-Agnostic Convolutional Neural Network[J]. IEEE Signal Processing Letters, 2019, 26(6): 833-837.

[17] Dong H, Pan J S, Xiang L, et al. Multi-Scale Boosted Dehazing Network with Dense Feature Fusion[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020: 2154-2164.

[18] Geirhos R, Rubisch P, Michaelis C, et al. ImageNet-Trained CNNs are Biased Towards Texture; Increasing Shape Bias Improves Accuracy and Robustness[EB/OL]. (2018-10-29)[2020-10-13].https: ∥arxiv.org/abs/1811.12231.

[19] Zhu P F, Wen L Y, Bian X, et al. Vision Meets Drones: A Challenge[EB/OL]. (2018-04-20) [2020-10-13]. https: ∥arxiv.org/abs/1804.07437.

[20] Johnson J, Alahi A, Li F F. Perceptual Losses for Real-Time Style Transfer and Super-Resolution[EB/OL]. (2016-03-27)[2020-10-13]. https:∥arxiv.org/abs/1603.08155.

[21] Aly H A, Dubois E. Image Up-Sampling Using Total-Variation Regularization with a New Observation Model[J]. IEEE Transactions Image Processing, 2005, 14(10): 1647-1659.

[22] Ranftl R, Lasinger K, Schindler K, et al. Towards Robust Monocu-lar Depth Estimation: Mixing Datasets for Zero-Shot Cross-Dataset Transfer[J/OL]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020. DOI: 10.1109/TPAMI.2020.3019967.

[23] Yeh M C, Tang S, Bhattad A, et al. Improving Style Transfer with Calibrated Metrics[C]∥ IEEE Winter Conference on Applications of Computer Vision (WACV), 2020: 3149-3157.

The Method of UAV Image Object Detection under

Foggy Weather by Style Transfer

Yin Xuping1, Zhong Ping1*, Xue Wei1, 2, Xiao Zixuan1, Li Guang1

(1. National Key Laboratory of Science and Technology on Automatic Target Recognition,

College of Electrical Science, National University of Defense Technology, Changsha 410073, China;

2. School of Computer Science and Technology, Anhui University of Technology, Maanshan 243032, China)

Abstract: Under the bad weather conditions such as foggy or rainy weather, the details of UAV images are seriously lost. Consequently, directly detecting without dehazing may lead to object missing and wrong inspection. Although the method of dehazing firstly and then detecting can significantly improve the detection performance of UAV images under misty weather conditions, it can not solve the problem that object detection model relies too much on the texture and surface information of the targets in the image which are used to classify, and thus leads to a poor detection performance on heavy fog images. In response to this problem, a method to detect after style transfer instead of haze removal is proposed to accomplish object detection of the UAV images under dense fog weather conditions. The method can change the style of the image while keep the content in image unchanged, making the object detection model transform from learning the object texture and surface information to learning the object contour, which is a more difficult task. The experiment is carried out on the UAV dataset Visdrone2019. Firstly, the UAV images are divided into fog-free, mist and dense fog images by using the differences in gradient features, dark channel features and wavelet features of fog images. Secondly, the processing methods of dehazing and style transfer are adopted respectively according to the concentration of fog. The experimental results show that the proposed method can further reduce the impact of light and noise, and can significantly improve the object detection performance of UAV dense fog images. Moreover, combining with the method of dehazing firstly and then detecting, the proposed method can adaptively complete the object detection task of UAV fog images.

Key words: UAV image; fog image; style transfer; target detection; image classification

收稿日期:2020-10-14

基金項目:国家自然科学基金项目(61671456; 61971428)

作者简介:殷旭平(1996-),男,山西朔州人,硕士,研究方向是计算机视觉中的目标检测、风格迁移、去雾。

通讯作者:钟平(1979-),男,河北赵县人,研究员,研究方向是卫星或航空光学图像的复原与增强、目标检测、目标识别、机器学习理论及其在航空领域的应用研究。