基于视觉技术的苹果采摘自动收集系统设计

2021-08-16年福东刘丹萍桑铭伟

白 琨,年福东,刘丹萍,桑铭伟

合肥学院先进制造工程学院,安徽合肥,230601

采摘作业所用的劳动力占整个生产过程所用的劳动力的33%至50%[1],是重要的生产环节,我国果园多采用人工采摘。为改善作业环境,帮助果农缓解采摘难题,多种形式的采摘器顺势而出。但是大多数采摘器并不具备对苹果自动识别、采摘、收集、装箱的功能。一般收集好的苹果需要重新整理完成装箱,费时费力。为进一步提高经济效益和降低劳动力投入,本文基于计算机视觉技术设计了一款采摘器,能自动对苹果进行识别采摘并完成装箱收集工作。

1 苹果采摘自动收集系统总体架构

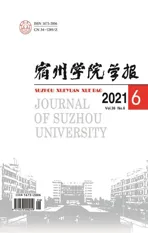

本文设计的苹果采摘自动收集系统主要由视觉识别模块和机械结构模块两部分组成。视觉识别包括苹果定位和成熟度判断,机械结构包括苹果采摘和自动收集。系统总体架构如图1所示。该架构中

图1 苹果采摘自动收集系统总体架构图

第一步是准确定位苹果,在摄像头所涉范围内将苹果与树叶等其他物质区分开来,捕捉到苹果;第二步判断苹果成熟与否,决定是否进行采摘,若不成熟则重新定位下一个苹果,否则进入第三步切割分离果柄;最后一步苹果切落后通过自动收集装置落入果盒。架构的前两步属于视觉识别设计,后两步属于机构结构设计。系统机械结构详细工作流程如图2所示。

图2 系统机械结构工作流程图

物体识别是计算机视觉领域中的一项基础研究,它的任务是识别出图像中有什么物体,并报告出这个物体在图像表示的场景中的位置和方向[2]。视觉识别的方法合理与否,直接决定着苹果采摘机的性能。在苹果识别方案的设计中,关键是能够快速、准确地识别出成熟苹果在果树枝头所处的位置,基于计算机视觉技术设计了苹果识别方案,先采集果树图片,进行苹果识别训练;再根据训练结果,使机器自动定位所有苹果(包括成熟的和未成熟的苹果)的位置,即在摄像头的采集范围内,准确地输出采集图片当中每一个苹果所在区域的最小矩形包围框;第三步,对第二步识别到的每一个苹果进行成熟度判断。识别出成熟苹果后,系统移动使苹果进入采摘筒,通过传感器判断苹果是否到位,到位后进行切割果柄分离,通过收集管道进入收集盒,通过计数传感器判断果盒是否需要移位或者是否装满。

2 视觉识别

2.1 苹果定位模块设计

本文采用的基于深度学习的苹果自动定位流程如图3所示,首先利用大量真实标签数据训练基于深度学习的物体检测算法获得苹果定位模型[3]。随后将待检测图片通过训练完成的模型获得每一个苹果的位置。主要包含三个步骤,即训练数据库的构建、自动定位苹果位置的深度模型训练和苹果定位模型的在线部署。

图3 基于深度学习的苹果自动定位流程图

2.1.1 训练数据库的构建

为了使机器能够在果树上准确捕捉到苹果,需要对其进行训练,使之学习苹果特征。这需要大量的、多样化的、质量高的训练数据,构建训练数据库。模拟果园真实环境,准备了150张带有苹果的图片,利用图像标注软件,在每一张图片上人工框选出图片的所有苹果,每一个苹果样本生成对应的坐标数据,建立数据库。工作流程如图4所示。

图4 苹果定位数据库构建示意图

2.1.2 自动定位苹果位置的深度模型训练

在训练数据准备完成之后,即可利用物体检测算法训练苹果定位模型。为了尽可能地平衡检测准确率与检测速度,采用YOLO物体检测算法[4]训练苹果检测定位模型。YOLO的原理如图5所示,其首先将图像等分为S×S的网格,然后利用卷积神经网络预测带检测物体落在每一个网格的概率,最后对所有可能的物体进行融合,选取概率最大的矩形框作为预测物体的实际位置。在实际训练时,采用官方训练框架darknet[5]。值得注意的是采用监督学习算法训练深度模型一般而言需要标注数以万计、甚至千万计的训练数据,否则可能会出现过拟合问题,导致所训练模型的泛化性能较差。为了避免这一问题,采用迁移训练的方式,即首先在公开大规模图片数据集上训练分类模型,随后再利用所标注的苹果数据进行模型的微调。

图5 苹果定位算法(YOLO)原理示意图

2.1.3 苹果定位模型的在线部署

由于模型的训练用到专用深度学习框架,不利于项目的实际部署。以OpenCV作为平台进行苹果检测模型的实际部署。具体做法如下:首先将darknet训练好的模型转换为OpenCV可读取的形式,随后利用OpenCV将模型二次封装,仅预留两个接口:一个是加载模型,另一个是输入一张图片返回当前图片内所有苹果的最小包围框的矩形坐标。

2.2 苹果成熟度判断模块设计

基于颜色模型判断苹果成熟度。成功定位出苹果的坐标后,依然达不到分类收集的一个目的,对苹果的识别不能只限于定位出苹果这个物体,还要对其是否成熟有一个判断,因此需要给出苹果成熟与否的分类依据。针对苹果在成熟后,其表面的颜色将从青色转变成红色的这一特点,通过颜色空间分析将捕捉到的图片中苹果红色区域超过70%是成熟苹果作为判断依据。

首先,将苹果图片进行颜色空间转换。通过摄像头采集到的图片所在色彩空间为RGB颜色空间。RGB颜色空间虽然利于电子屏幕进行显示和人眼进行肉眼观察,但由于其对光照即为敏感(例如,同样是红色,在不同的光照条件下,在RGB颜色空间下的数值将具有巨大差异),不利于对颜色的属性进行自动分析。在图像处理研究与应用领域中,RGB和HSV是两种极为常见的颜色空间,两者之间可以相互转化。RGB颜色模型简单来说就是以R(红色)、G(绿色)、B(蓝色)三种原色进行不断叠加产生多色的三基色模型[6],这种模型更加直观。HSV颜色模型则是把H(色相),S(饱和度),V(亮度)当作色值来定义颜色的空间,直观的表达色彩的明暗、色调以及鲜艳程度,方便进行颜色之间的对比,因此本文将利用HSV颜色空间对苹果的色彩进行分析。

经由RGB转化成HSV的公式计算[7],在将苹果图片由原始RGB转为HSV颜色空间之后,通过对H通道(即色相)的分析来判断红色区域的占比。经过大量图片实际测试,选取像素为红色的H取值范围是:(H>0&&H<16)‖(H>240&&H<360)。若红色像素占苹果区域的比例为大于一定阈值(设置为70%)则认为当前苹果为成熟,否则认为苹果未成熟。

3 机械结构设计

采摘收集装置[8]如图6所示。主要分为采摘和收集两部分。苹果采摘收集时主要考虑降低苹果的损伤度。Lu 等认为苹果损伤程度与下落高度成正比[9];Menesatti等通过对杏、梨、桃和苹果碰撞试验得到果实跌落冲击损伤的抵抗力和跌落损伤高度临界值,建立了桃的跌落损伤预测模型[9]。

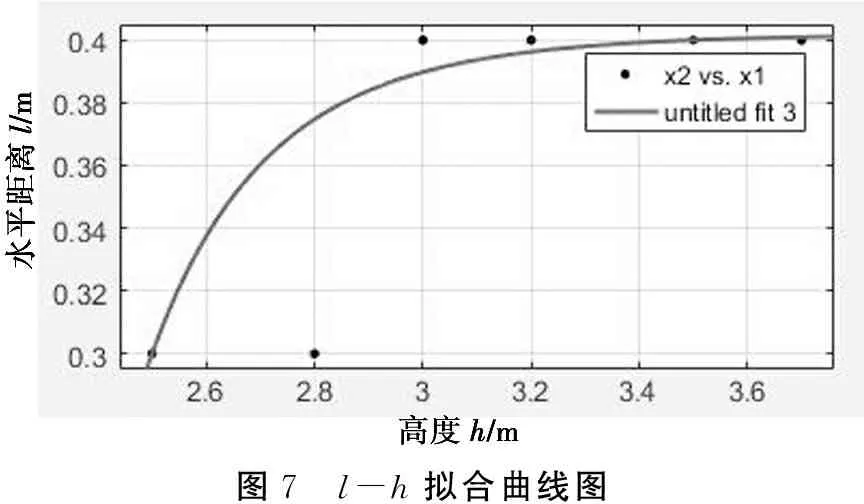

图6中采摘器升降高度h的范围为2.5~3.7 m,降落点相对于起落点的水平距离l的范围为0~0.5 m。可以预测,当起落点和降落点在竖直直线上时,降落点的加速度最大,苹果受到的冲击力最大、最容易受到损伤;当起落点和降落点的连线与竖直线间的夹角最大(即降落点相对于起落点的水平距离l最大)时,降落点的加速度最小、受到的损伤最小。考虑到结构的紧凑性,并不是l越大越好。在满足损伤可承受力的情况下,l值越小越好,既可以减小结构尺寸,又可以提高设备的运行效率。

苹果在降落点的切向加速度为:

(1)

图6 某苹果采摘器

设计l-h两因素六水平实验表1。可以看出当以加速度为9.7 m/s作为无损伤标准时,表中阴影部分显示l对应6个h水平的调节范围为0.3~0.4 m。经拟合计算,可得l和之间的优化模型式(2),其中a=-429 8,b=-11.62,c=0.402。图7为l-h拟合曲线图,可以更直观地看出拟合后的l和h位置关系,机械结构设计时可据此设计安装降落点调节装置,以达到合理的损伤控制。

(2)

图7 l-h拟合曲线图

表1 l-h因素水平表

4 结 语

本设计利用计算机视觉技术,基于深度学习的物体检测技术训练苹果检测模型,实现苹果位置的自动定位,建立了判断苹果成熟与否的依据,利用色彩分析算法对苹果的成熟度进行判断。分析了采摘器升降高度h和降落点相对于起落点的水平距离l对苹果损伤的影响,得出以下结论:h越大损伤越大,l越小损伤越大;可以减小设备收集装置的尺寸,使结构紧凑,且提高运行效率。