基于深度Q学习的室内无线网络资源分配算法

2021-08-06吕亚平贾向东敬乐天

吕亚平,贾向东,2,路 艺,敬乐天

(1.西北师范大学计算机科学与工程学院,甘肃 兰州 730070; 2.南京邮电大学江苏省无线通信重点实验室,江苏 南京 210003)

1 引言

第五代5G(5th Generation)移动通信网络还没有全面部署,第六代6G(6th Generation)移动通信网络已在路上。与5G移动通信网络不同的是,6G移动通信网络将会实现空、天、地、海一体化通信,但是这需要不同类型基站的密集部署甚至超密集部署。目前,我国已经部署约600多万个第四代4G(4th Generation)移动通信网络基站,而5G移动通信网络基站的数量预计将会达到4G移动通信网络基站数量的10倍,6G移动通信网络基站的数量可能会达到5G移动通信网络基站数量的10倍。虽然5G和6G提高了传输速率,提升了系统容量,但是基站的密集以及超密集部署将会消耗大量的能量,这不利于绿色通信的发展。因此,提高基站的能量效率对未来移动通信网络十分重要。

据调查显示,有超过50%的语音服务和70%的数据流量发生在室内[1]。对此类场景,家庭基站是较有潜力的节能技术之一,其可在密集部署的异构网络中,使用较低的发射功率来满足室内移动用户高传输速率的服务需求。

近年来,室内无线通信引起越来越多研究者的关注。众多学者对室内无线网络的吞吐量和容量进行了研究。例如,穆施瑶等[2]通过功率控制和信道分配相结合的方法来解决宏基站和家庭基站共存网络中的层间和层内干扰问题,以提升整个室内无线网络的容量;李俊伶等[3]通过基于路径损耗的功率控制算法来解决家庭基站密集部署网络中的干扰问题,以提高家庭基站用户的吞吐量;周雄等[4]通过基于博弈的频率复用方法来解决频谱冲突问题,以提高室内无线网络的信道容量;季萍萍[5]使用图论中的极大团和簇的方法对信道进行分配,以提高室内无线网络的容量;杨立立[6]基于图论的新型着色算法来解决家庭基站密集部署带来的严重同层干扰问题,以提高室内无线网络的容量;程艳丽[7]、刘桥[8]、许悦[9]、赵迅[10]和穆施瑶[11]分别通过基于价格机制的功率控制算法、基于分簇的子信道和功率联合分配方法、启发式动态分簇法和次梯度法、实时感知频谱情况的算法和功率控制算法以及凸优化和次梯度法来解决宏基站和家庭基站共存网络中跨层和同层干扰问题,在一定程度上提高了室内无线网络的容量和吞吐量;王振伟[12]使用自适应功率控制法解决家庭基站之间的同层干扰问题,以提高室内无线网络的吞吐量。虽然上述研究文献通过频谱分配、信道分配和功率控制方法在一定程度上提高了室内无线网络的容量和吞吐量,但没有考虑在满足室内移动用户服务质量需求的约束条件下去提高室内无线网络的能量效率。因此,在家庭基站密集部署场景中满足室内移动用户服务质量需求的情况下,本文旨在提高室内无线网络的能量效率。

目前,神经网络和强化学习算法被用于各个领域。例如,余永维等[13]使用深度学习方法识别数控机床的运动误差因素,而且正确率可达96%以上。也有一些研究者将其运用到无线通信领域中。比如,Wang 等[14 - 17]分别使用深度强化学习算法最大化无人机覆盖范围内的下行容量、室内无线网络的吞吐量、设备到设备D2D(Device-to-Device)通信系统的容量以及蜂窝网的传输速率。此外,Meng等[18]的工作表明,深度Q学习DQL(Deep Q-Learning)的功率分配算法优于随机功率、最大功率分配算法,但其并没有将DQL和Q学习(Q-Learning)进行对比分析。基于此,本文将对比分析DQL、QL和注水功率分配算法对系统能效的影响。

基于上述考虑,本文面向家庭基站密集部署场景,提出了一种DQL算法,旨在优化室内无线网络的能量效率。本文所提算法可动态调整家庭基站的发射功率,收敛速度快,在能量效率优化方面明显优于其他算法,能够有效解决家庭基站能耗过大问题。

2 系统模型与信道假设

如图1a 所示,本文考虑由一个宏基站和一栋建筑楼构成的系统模型。在建筑楼内有众多家庭基站(即家庭基站密集部署)和移动用户(配备单天线)。为了更清晰地展现家庭基站和移动用户的物理空间位置,假设家庭基站的空间物理位置遵循空间位置强度为λ(λ=3/4×30/1003π)的泊松点过程,移动用户随机分布在室内,如图1b所示。该系统模型采用正交频分复用技术,每个家庭基站完全复用K个正交子载波,每个用户在时刻t只能使用一个家庭基站上的某一子载波进行通信,每个家庭基站可以使用所有可用带宽。在网络初始化阶段,用户根据最大信号与干扰加噪声比SINR(Signal to Interference plus Noise Ratio)准则完成与家庭基站的级联,然后根据注水算法来分配子载波的初始功率。考虑到用户的公平性,将一个家庭基站的下行链路子载波平均分配给所有附属用户。图1a 中虚线箭头表示宏基站以及同层的其他家庭基站对移动用户的干扰。

Figure 1 System model图1 系统模型

3 能量效率分析

基于以上系统模型,本文考虑整个网络的业务层面,用能量消耗指数ECR(Energy Consumption Rating)来衡量家庭基站的能量效率。当移动用户j使用家庭基站i上的第f个子载波进行通信时,移动用户j受到的干扰为:

(1)

其中,Dif,j表示移动用户j是否使用家庭基站i上的第f个子载波进行通信,若移动用户j使用家庭基站i上的第f个子载波进行通信,则Dif,j=1;否则,Dif,j=0。Pif,j表示移动用户j使用家庭基站i上的第f个子载波进行通信时,家庭基站i上的第f个子载波的发射功率。Gif,j表示移动用户j使用家庭基站i上的第f个子载波进行通信时的信道增益,可以由式(2)得到:

(2)

其中,hif,j(仿真实验中hif,j=1)和Zif,j(仿真实验中Zif,j=8)分别是移动用户j使用家庭基站i上的第f个子载波进行通信时服从指数分布的多径衰落和服从对数正态分布的阴影衰落,φ(仿真实验中φ=4)是路径损耗因子,而di,j是家庭基站i和移动用户j之间的距离。

移动用户j的SINR为:

(3)

其中N0(仿真实验中N0=9 dB)表示移动用户j接收的噪声。

根据Shannon公式可得室内无线网络传输速率R的解析表达式:

(4)

则用来衡量系统能量效率的能量消耗指数的解析表达式如式(5)所示:

(5)

其中,Bi,f是家庭基站i上的第f个子载波的带宽,Pcif,j是移动用户j使用家庭基站i上的第f个子载波进行通信时的电路损耗功率。

根据最大化室内网络能量效率(即最小化能量消耗指数)这一优化目标以及在满足移动用户服务质量需求、家庭基站i上的子载波发射功率之和满足其最大发射功率约束的条件下,要解决的目标优化问题如式(5)和式(6)所示:

(6)

约束条件为:

SINRif,j≥τ0

(7)

其中τ0(仿真实验中τ0=6)是保证移动用户服务质量需求的最小SINR,Pmax是家庭基站的最大发射功率。

4 基于深度Q学习资源分配算法

本文主要通过具有感知能力和决策能力的DQL算法对家庭基站的发射功率进行分配,以优化室内无线网络的能量效率,使室内无线通信在满足用户服务质量需求的条件下朝着绿色通信的方向发展。

QL是强化学习算法中基于值的算法,用(s,a,t,r(s,a))来表示。其中,s表示状态,a表示动作,t表示时间,r(s,a)表示在当前状态(s),执行动作(a)后得到的奖励。它的主要思想就是将状态(s)与动作(a)构建成一个Q表来存储Q值,然后再根据Q表里能产生最大奖励值的Q值来选取动作。但是,如果每次决策都按照Q估计的最大奖励值来执行动作,那么就会很容易出现局部最优值,造成路径的规划可能收敛在一条上的情况,所以当Q表更新一定次数后,就不会产生更好的路径。

为了解决QL算法造成的局部最优值问题,本文在QL算法中引入了ε-greedy策略,即在决策系统进行决策时,有ε(仿真实验中ε=0.9)的概率进行随机决策,有1-ε的概率进行Q估计决策。

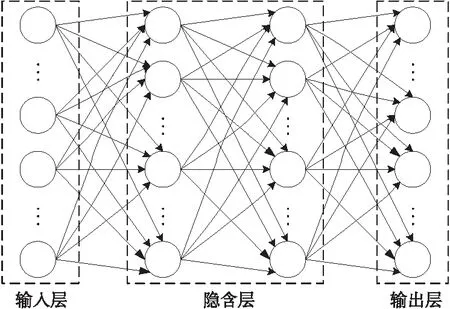

如图2所示,本文根据数据流的迭代更新构造了含有2层隐藏层的DQL网络模型。在该DQL网络模型中,家庭基站i(1≤i≤N)作为代理人,而且DQL网络由状态Si,f={Mi,Pi,f}、动作ai,f={i,f,ΔPi,f}和奖励函数组成。其中,Mi表示时刻t家庭基站i上的移动用户数量,Pi,f表示家庭基站i上第f个子载波的发射功率,ΔPi,f表示家庭基站i上第f个子载波的发射功率的调整值。

Figure 2 Structure of deep Q-learning network图2 深度Q学习网络结构

本文将能量消耗指数作为奖励,奖励函数的解析表达式如式(8)所示:

(8)

每个代理经过不断的迭代学习来更新行为状态值函数,更新方法如式(9)所示:

(9)

本文所提DQL算法流程图如3所示。

Figure 3 Algorithm flowchart图3 算法流程图

在图2所示的学习网络结构中,将基站与移动用户的通信连接关系和基站对移动用户的发射功率作为输入层的数据,即[D1,1,…,DN,M,P1,1,…,PN,M],输出层数据为基站i上第f个子载波发射功率调整之后的值。

激活函数为ReLU,即:

f(x)=max(0,x)

(10)

该函数可以避免梯度爆炸和梯度消失问题。

损失函数为:

(11)

本文所提DQL网络在训练模型后,算法的复杂度为O(M*(n1*n2+n2*n3+n3*n4)),其中n1,n2,n3,n4表示每层神经元的数量。

5 仿真与结果分析

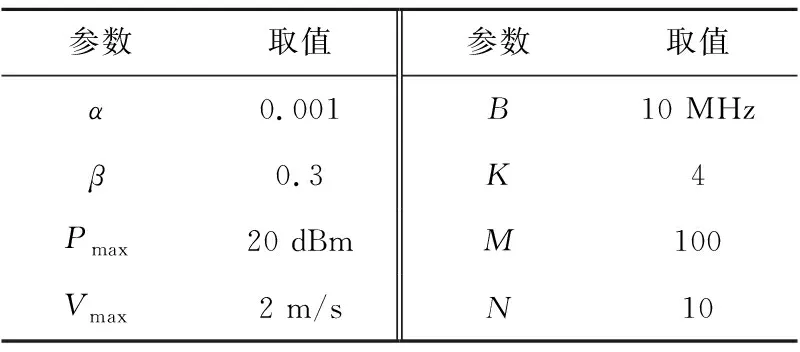

为验证本文所提算法的性能,本节对室内无线网络中基于DQL的功率分配算法进行仿真与结果分析。此外,文献[17]分析了折扣因子对系统传输速率和能耗的影响,借鉴文献[17]的结果,本文算法的折扣因子取值为0.3,仿真参数如表1所示。

Table 1 Simulation parameters

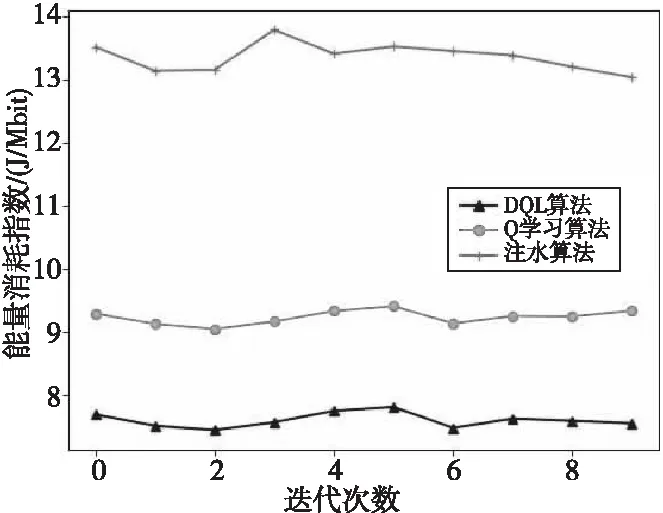

图4给出了不同功率分配算法对室内网络ECR的影响。从图4中可以明显看出,随着迭代次数的增加,由QL算法得到的室内网络ECR(大约为9)明显小于由注水算法得到的ECR(在13~14),故QL算法优于注水算法;而由本文所提算法得到的室内网络ECR(大约为7.5)小于由QL算法得到的ECR(大约为9),故本文所提算法在ECR优化方面明显优于其他2种算法。

Figure 4 Comparison of energy consumption rating obtained by the three algorithms图4 3种算法所得能量消耗指数对比图

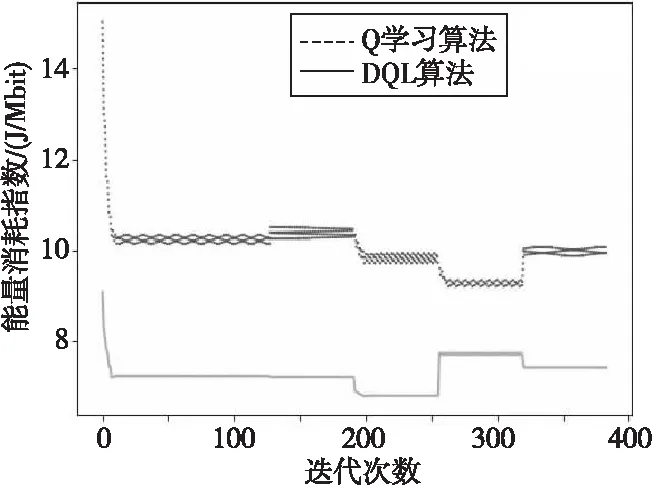

图5给出了由本文所提算法和QL算法所得到的室内网络ECR的收敛速度随迭代更新次数不断增加的波动情况。

Figure 5 Comparison of convergence speed between depth Q-Learning algorithm and Q-Learning algorithm图5 DQL算法和QL算法的收敛速度对比图

从图5中可以明显看出,在迭代更新次数约为8时,由本文所提算法得到的室内网络ECR开始收敛,而由QL算法得到的室内网络ECR在迭代更新次数不断增加的整个过程中始终处于波动状态。这是因为每当用户的移动性引起网络拓扑变化时,QL算法都需要重新计算室内无线网络的ECR,而由于DQL功率分配算法使用了深度神经网络,可以打破训练数据之间的联系以致最终的训练可以收敛,这在一定程度上提高了收敛速度。此外,虽然在动态情境中DQL功率分配算法也会出现波动,但与QL算法相比是相对稳定的。故本文所提算法在收敛速度方面是优于QL算法的。

6 结束语

为了在满足移动用户QoS需求的同时,尽可能降低室内无线网络的能耗,本文对室内无线网络的能耗过大问题进行了研究,并提出了一种能动态调整家庭基站发射功率的DQL算法。仿真从ECR和收敛速度2个方面评估了该算法的性能,结果表明该算法无论是在ECR方面,还是在收敛速度方面都明显优于其他2种算法。