基于BAU-Net的高分辨率遥感图像中建筑物的分割提取

2021-07-29李林祥温淑焕

李林祥,袁 毅,温淑焕,*

(1.燕山大学 智能控制系统与智能装备教育部工程研究中心,河北 秦皇岛 066004;2.燕山大学 工业计算机控制工程河北省重点实验室,河北 秦皇岛 066004)

0 引言

高分辨率遥感图像是我国重要的国土资源,遥感图像中建筑物的提取对经济预测、数字化城市建设以及国防安全等具有重要意义。

遥感图像中建筑物的分割提取实际上是将像素点分配语义标签的过程[1]。高精度GPS以及影像技术的发展给遥感图像带来了更多的微小细节以及结构信息,但在减少类内差异的同时,也增加了类内方差,尤其显著地表现在建筑物类别上,使建筑物包括更多精细的外形轮廓以及层次纹理图案等细节信息[2]。

在传统的遥感图像特征提取任务中,通常采取人工处理或者机器学习算法等获取图像的灰度值、像素梯度以及形状纹理等特征信息对目标进行分割提取。其中常用的方法可分为三类:基于阈值、基于边缘、基于区域的分割方法。ANDRES等[3]采用K-means算法确定图像的阈值信息,并在遥感图像分割过程中加入K-means算法作为监督指导,实现了对特定区域目标的分割提取。王宇等[4]建立的主动轮廓模型算法将遥感图像的局部区域灰度值作为分割特征,实现遥感图像目标提取。

受深度卷积神经网络的影响,由于全卷积神经网络具有强有力的捕获丰富的空间特征和多尺度信息的能力,基于全卷积神经网络的显著性目标检测方法在图像目标检测领域取得了丰厚成果。

2017年,Wang等[5]利用全卷积神经网络对高分三号高分辨率遥感图像进行解析,出色地实现了水体、林地以及建筑物的识别分割。2018年,王宇等[6]利用ResNet网络作为基础网络,后接条件随机场对粗分割结果进行细化修正,实现了遥感图像中建筑物的提取。目前较为经典的性能优越的目标检测模型算法主要有ResNet网络[7]、U-Net网络[8]等深度学习模型。

由于高分辨率遥感图像中建筑物类别多样、纹理复杂、空间分布不规则等特殊因素,导致在此领域的应用仍存在以下难题:

1) 建筑物漏分割和误分割;

2) 建筑物边缘分割模糊;

3) 复杂结构建筑物无法完整识别分割;

4) 密集建筑物无法实现单独分离分割;

5) 阴影和树木遮盖建筑物无法完整分割;

针对上述问题,本文基于U-Net网络[8]提出了一种双U型Encoder-Decoder架构[9]的边缘意识U型深度神经网络(Boundary-Aware U-Net,BAU-Net)。该模型能够自动提取高分辨率遥感图像中建筑物,在IAILD数据集(Inria Aerial Image Labeling Dataset)上的实验结果证明,本文所提出的BAU-Net算法能够有效地克服高分辨率遥感图像中道路、车辆、树木、阴影等强干扰因子,高精度分割提取出建筑物主体以及边缘轮廓,并且本文所采用的混合损失函数可以在一定程度上解决密集建筑物的分离问题。

1 BAU-Net网络模型

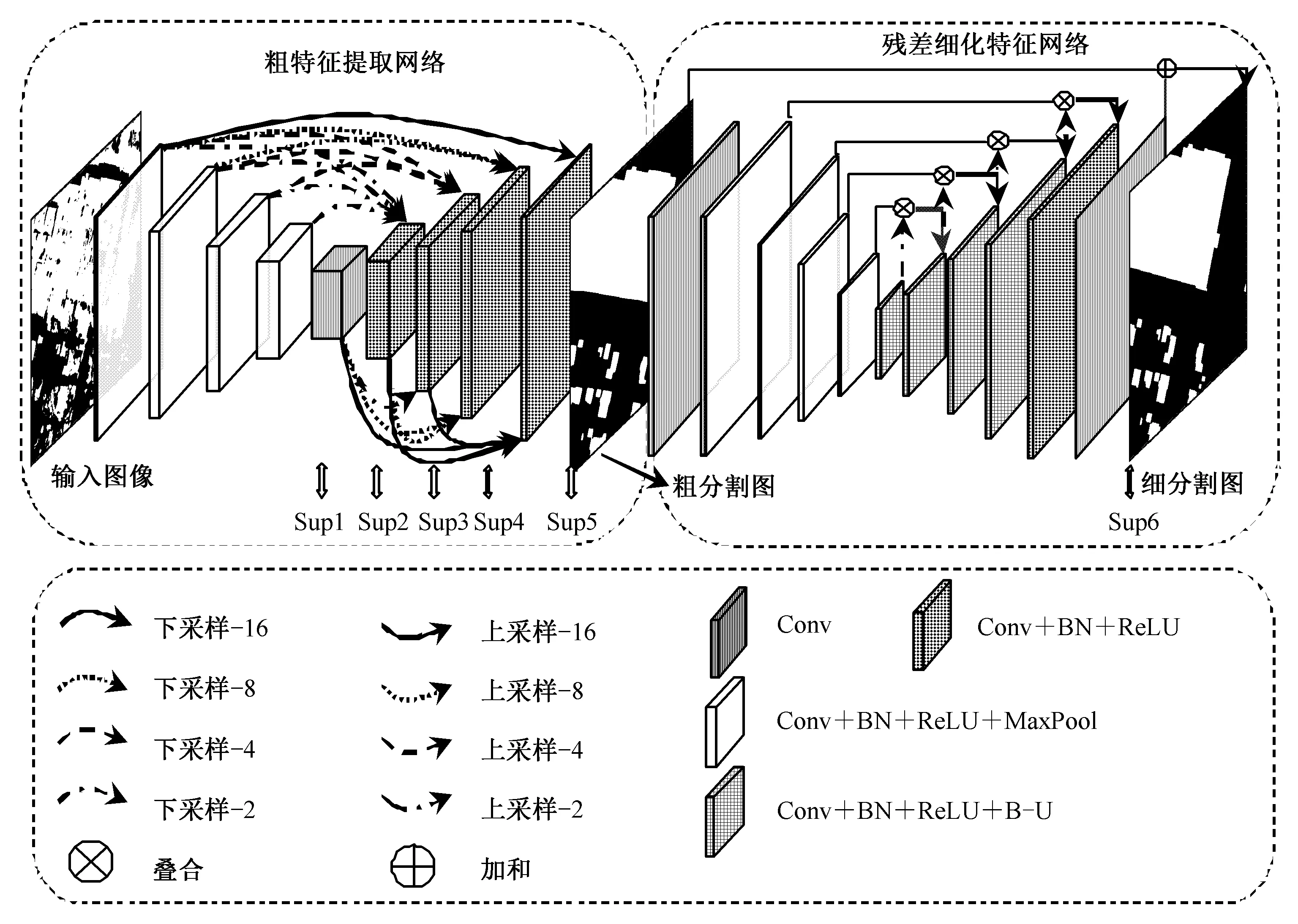

本文提出的基于BAU-Net的高分辨率遥感图像中建筑物分割的深度神经网络模型如图1所示[10-11]。网络模型整体架构分为两个部分:粗特征提取网络[10](Coarse Feature Extract Network,CFE-Net)和残差细化特征网络[11](Residual Refined Feature Network,RRF-Net),CFE-Net和RRF-Net均为基于U-Net的改进网络构成的Encoder-Decoder框架。遥感图像Image首先通过CFE-Net得到粗特征图Mcoarse,然后经过RRF-Net学习真实图像标签与Mcoarse的残差Mresidual得到细化特征图Mrefined。其中Conv、BN、ReLU、MaxPool、B-U分别表示卷积、标准化批处理、激活、最大池化和双线性上采样操作,Supi(i=1,2,…,6)表示监督子图。

图1 BAU-Net深度神经网络结构Fig.1 The structure of BAU-Net deep neural network

1.1 粗特征提取网络CFE-Net

由于U-Net的平面连接网络结构,导致其所融合的特征图较少,融合特征不足,难以有效地捕获全局各种尺度特征信息,增加特征损失,所以本

文采取全局密集跳跃连接的U-Net3+作为粗特征提取网络CFE-Net来增强特征融合。U-Net3+独特的全局密集连接融合所构成的Encoder-Decoder架构,使其在图像分割领域得到广泛的应用。

全局尺度融合主要表现为,CFE-Net的每一个解码器层都融合有来自较大或相等尺度编码器层的特征图以及较小尺度的解码器特征图[10],这种特征融合操作在全局尺度下捕获粗粒度语义和细粒度细节,其网络结构如图2所示[10]。

图2 CFE-Net网络结构图Fig.2 The architecture of CFE-Net

其中,x表示输入图像,M(x,s1)为最大池化函数,s1表示池化核大小,C(x,s2)表示卷积操作,s2表示卷积核的大小,Re(x,t)表示连续重复函数,t为重复次数,i表示层数,N表示解码器层的总个数,P(·)是聚集函数,其中包括卷积、池化和激活操作,D(·)表示下采样,U(·)表示上采样。

1.2 残差细化特征网络RRF-Net

残差细化特征网络主要是通过学习粗特征图与真实标签之间的残差Mcoarse来细化粗特征图得到更为准确的细特征图Mcoarse,其计算公式[11]为

Mrefined=Mcoarse+Mresidual。

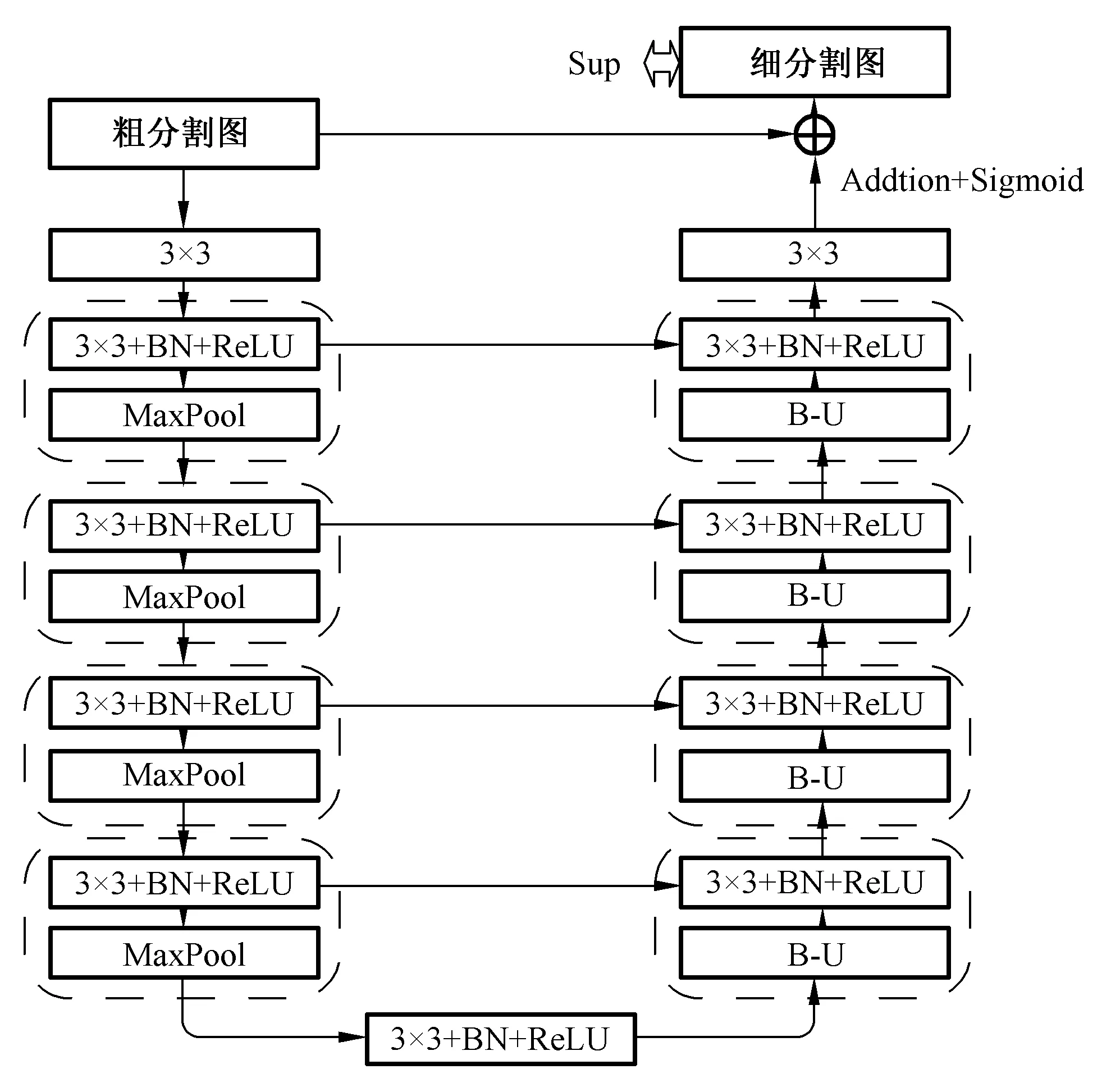

在下采样过程中,Mcoarse首先经过3×3卷积,然后连续经过4次特征聚集和最大池化。桥接部分为特征聚集。上采样过程对称与下采样,用双线性上采样代替最大池化,最后一层为单独的3×3卷积生成显著特征图。然后粗特征图Mcoarse与最后的显著特征图相加,进过Sigmoid函数输出为最终的细化特征图Mrefined。

本文所采用的RRF-Net网络为基于U-Net构成Encoder-Decoder的架构,如图3所示[11]。其中,B-U表示双线性上采样(Bilinear Upsampling),其他表示与上文表示相同。

图3 RRF-Net网络架构Fig.3 The architecture of RRF-Net

2 混合损失函数

本文网络训练中采用的损失函数定义[11]为

其中,i表示输出特征图的监督层数,N表示深度监督层的总个数,由图1可知,N=6,l(i)表示第i层的损失。

为了获得完整的主体以及分割清晰的边缘轮廓,本文定义以下混合损失函数[11]:

BEC损失函数常用于图像二分类问题,体现为像素级损失,其定义式[11]为

(1-G(i,j))log(1-S(i,j))],

其中,G(i,j)∈{0,1}、S(i,j)分别表示像素(i,j)的真实标签值和预测值。

SSIM损失函数主要用于图像结构信息的评估,体现为图像局部区域级损失,其定义式[11]为

其中,μx、μy以及σx、σy分别表示预测图与真实标签的均值和标准差,σxy为其协方差,C1=0.012,C2=0.032。

IOU损失函数主要用于表示两个集合的相似度,体现为图像全局级损失,其定义式为[11]

其参数含义与BEC损失相同。

BF1损失函数主要是通过特殊边缘像素扩张,获取更多语义信息,达到精细化边缘结构的分割目的,使边缘更加完整清晰,其定义式为[2]

其中,pool(·)表示最大池化,θ0、θ是滑动窗口的大小,θ0=3(图像中建筑物之间的最小缝隙的像素距离,本文随机抽取若干张图像,从中测得最小值为3)、θ=3(扩张像素数,取值越小有利于边缘分割;经反复测定,本实验最佳为3);ygt、ypd分别表示预测特征图和真实标签;(∘)表示两张图像像素点对应相乘;sum(·)表示特征图像素点总数。

混合损失函数中BEC、SSIM、IOU损失分别从像素级、区域级、全局级三个层面计算图像损失,使目标分割更加完整,边缘更加清晰[11]。而BF1损失函数特殊的像素扩张处理,使得精细轮廓更加准确。而密集建筑物分离的本质是边缘分割问题,故本文所采用的混合损失函数不仅可以使分割目标边缘更加清晰完整,而且可以在一定程度上解决密集建筑物的分离问题。

3 实验及结果分析

3.1 数据集及实验平台

为验证本文所采用BAU-Net网络结构和混合损失函数的有效性,在IAILD航空影像数据集上开展验证实验。该数据集覆盖810 km2空间分辨率为0.3 m的地表高清遥感影像,分为建筑和非建筑两个语义类别,涵盖不同的城市居民区,从人口稠密地区(如,旧金山的金融区)到高山城镇(如,奥地利蒂罗尔的林地山区)。

其中训练集包括180张覆盖范围405 km2,分辨率为5 000×5 000像素的芝加哥上空高清航空遥感图像,其经过准确的真值标注[12],可用来进行网络训练,而测试集则为旧金山上空的遥感图像(未公开其真值标注),可用其对网络的泛化性和鲁棒性进行评估。

为充分利用实验平台的计算性能,本实验将每张原始图像剪裁成100张500×500分辨率的样本图像,共计18 000张。并根据相关研究的数据集划分比例[4, 6],结合实际情况做出适当调整,取17 900张作为训练样本集,100张作为测试样本集。

实验平台采用容天DevTopAIX4770深度学习工作站,其详细配置如表1所示。

表1 实验平台配置Tab.1 The configuration of experimental platform

3.2 实验结果评价指标

召回率、准确率、F值以及平均绝对误差是图像分割领域常用的性能评价指标,本文采用其对实验结果性能进行评估,其计算公式[4,11]为

其中,Pr表示目标被正确分割的像素点数,Pu表示目标未被识别的像素点数,Pw表示背景误被分割为目标的像素点数,β2=0.3,H、W分别高和宽,S(i,j)、G(i,j)表示预测图和真实标签的像素点。

本文所采用的BAU-Net的分割性能在召回率、准确率以及F值等指标下,相比文献[6]得到了大幅度提高。且二者提高分割性能的侧重点不同,本文所采用的BAU-Net在网络结构上具有巨大的分割优势。更为重要的是文献[6]主要的分割优势取决于网络后端处理算法,体现为后端算法优势,利用消耗大量计算资源和训练时间换取一定限度的准确率回报,但与此同时会降低F值,影响其鲁棒性。

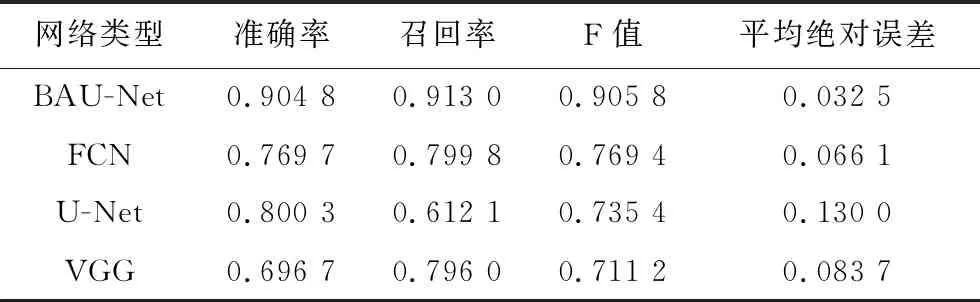

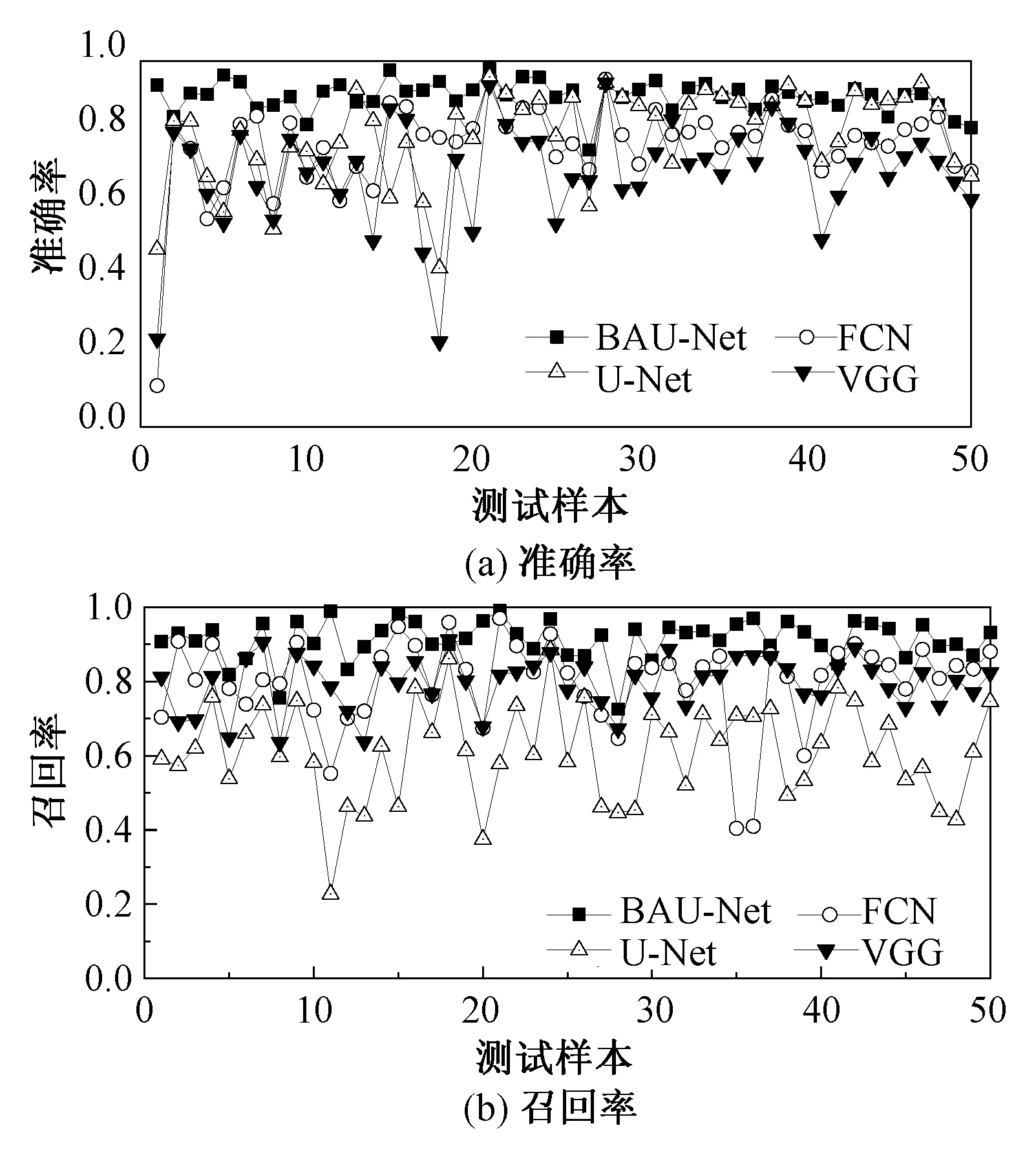

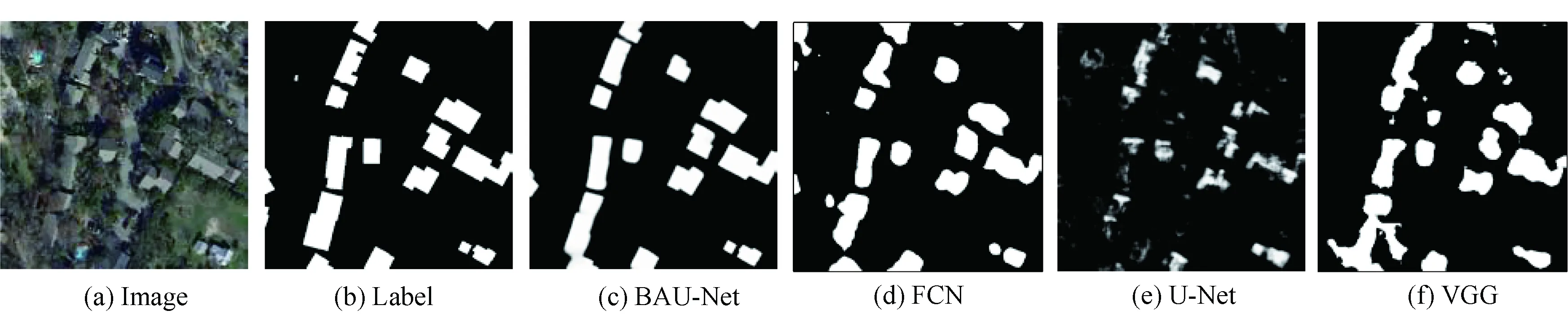

FCN[13]、U-Net、VGG[14]为近年来图像分割领域的经典算法,广泛应用于多个领域的图像分割任务中,并表现出良好的分割性能。为更好地体现BAU-Net的网络结构对高分辨率遥感图像中建筑物分割提取的优越性,本文增加与经典网络结构FCN、U-Net、VGG的对比实验。任取50张测试样本的性能指标和分割结果如表2和图4所示。

由表2所测得的实验数据可以看出,与FCN和VGG和U-Net经典的特征提取网络相比,本文所采用的BAU-Net在准确率、召回率、F值以及平均绝对误差项等分割性能指标上得到大幅度提高。其中准确率、召回率和F值均高于90%,平均绝对误差为0.032 5,与真值标注图的误差明显减小。

表2 性能指标对比Tab.2 Comparison of performance

由图4的性能指标对比曲线图可以看出,与经典分割网络相比,BAU-Net在准确率、召回率和F值等分割评估指标上,性能稳定,鲁棒性得到大幅度提升。

图4 与经典神经网络的分割性能指标对比Fig.4 The segmentation performance index compared with classic neural networks

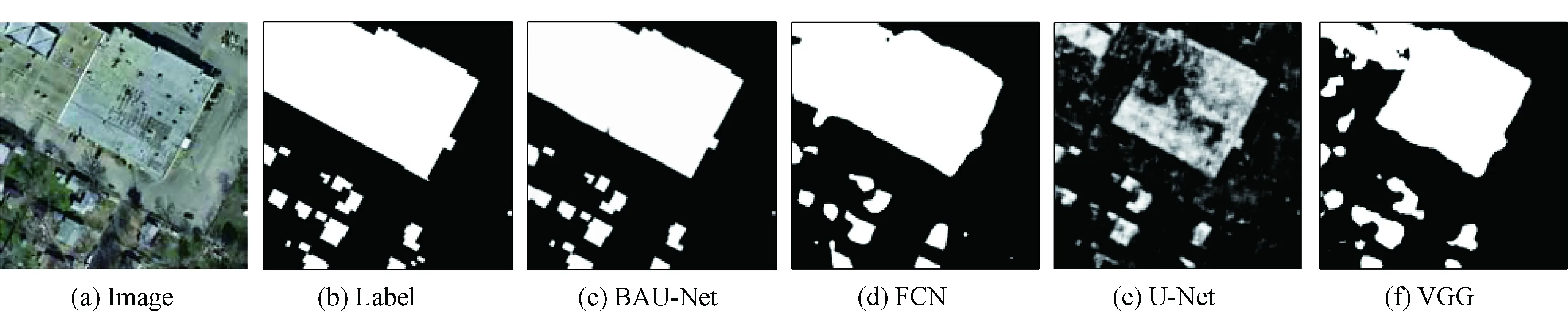

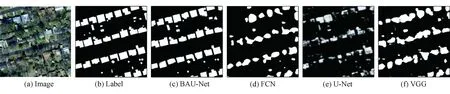

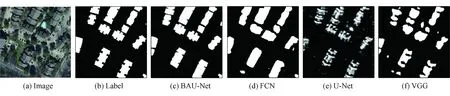

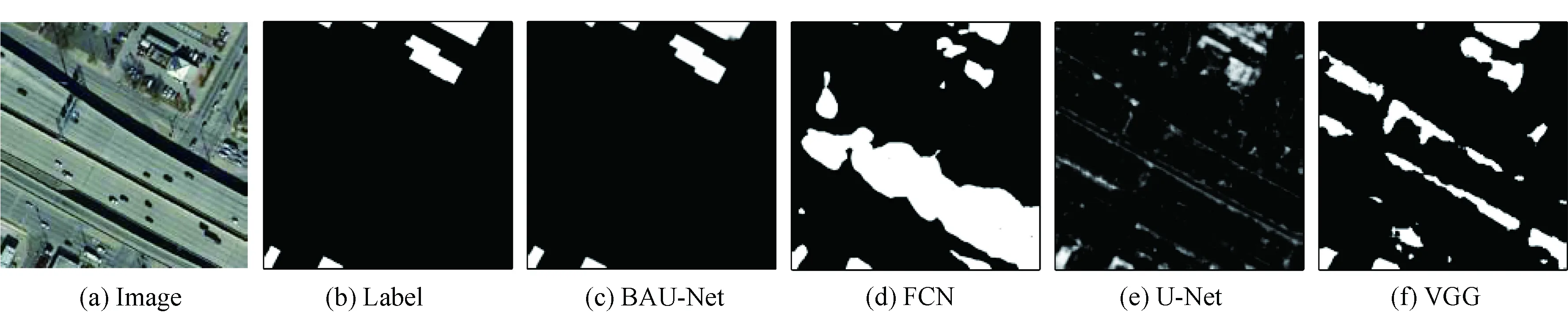

为了进一步证明BAU-Net在多种情形遥感图像中对建筑物分割提取的优越性能,本实验将遥感图像划分为6类:大型简单结构建筑物,如图5(a)所示;小型密集建筑物,如图6(a)所示;边缘特征复杂建筑物,如图7(a)所示;道路干扰,如图8(a)所示;树木干扰,如图9(a)所示;建筑物阴影干扰,如图10(a)所示。分别采用BAU-Net、FCN、U-Net和VGG作为分割网络进行训练测试,其分割结果如图5~10所示。

图5 大型简单建筑物Fig.5 Large and simple buildings

图6 小型密集建筑物Fig.6 Small and compact buildings

图7 边缘复杂建筑物Fig.7 Intricate edge buildings

图8 道路干扰Fig.8 Distraction of roads

图9 树木干扰Fig.9 Distraction of trees

图10 建筑物阴影干扰Fig.10 Distraction of building shadow

由图5~10的实验结果可以看出,BAU-Net分割效果优于FCN、VGG、U-Net,其可以更加完整地识别建筑物主体,清晰地分割边缘轮廓,并且可以有效地避免车辆、树木干扰,预测建筑物外形,达到精准分割的目的。由图6~7不难看出,密集建筑物群分离问题也得到了进一步改善。

4 结论

针对遥感图像中建筑物分割所存在的建筑物漏分割、误分割以及边缘模糊等问题,本文提出了一种基于BAU-Net的高分辨率遥感图像中建筑物分割提取的深度学习算法。特殊的双U型结构、多尺度特征融合以及混合损失函数的引入使得分割结果边缘轮廓更加清晰,提高分割精度。

本文所提出的BAU-Net在IAILD航空影像公开数据集上的准确率为90.48%,召回率为91.30%,F值为90.58%,平均绝对误差为0.032 5,均优于经典分割算法。结果预测图表明,BAU-Net能够有效地克服道路、车辆、树木、建筑物阴影等影响,准确有效地分割颜色形态各异的建筑物及边缘轮廓。