基于聚类的离群点检测方法研究综述

2021-06-23朱文豪

周 玉,朱文豪,房 倩,白 磊

华北水利水电大学 电力学院,郑州450011

聚类在数据处理中占有重要地位,它利用相似性对数据进行分组,同组数据的相似性尽可能大,不同组数据的相似性要尽可能小。聚类分析技术已广泛应用于各种领域,如计算机科学、生命和医学科学、社会科学及经济学等[1]。

离群点是聚类的副产品,因此对常见的聚类算法,如K-means、DBSCAN[2]、CHAMELEON[3]、CLIQUE[4]等加以修改都可将其用于离群点检测,这些方法大多通过考虑数据对象与簇之间的关系检测离群点。离群点检测是数据预处理中的一项重要任务,它的目的是发现数据集中与大多数数据偏离较远的对象[5]。离群点不一定是错误的数据,它们往往包含着重要信息,能够表征数据集的某些特点,具有重要研究意义。离群点检测技术在欺诈检测[6-7]、入侵检测[8-9]、环境监测[10]、定位[11-12]和目标跟踪[13-14]等方面已经有了广泛应用。Gan等提出的KMOR(K-measn with outlier removol)[15]算 法 以 及Ahemd等提出的ODC(Outlier Detection and Clustering)[16]算法都在执行聚类的同时就能进行检测离群点的任务,这是基于聚类的离群点检测的最大优点。目前,没有任何一种聚类方法都适用于所有数据集,不同数据集需要采用不同的聚类方法,这是聚类方法的最大缺点,同时,也是基于聚类的离群点检测的最大缺点。

文献[17]从有监督和无监督的角度入手概述了基于深度学习的离群点检测方法,文献[18-19]综述了传统的和前沿主流的检测方法,其中都对基于聚类的检测方法有所提及。但是之前的综述研究均没有对基于聚类的检测方法做出系统总结与分析。为了及时掌握当前基于聚类技术的离群点检测方法的研究现状,本文通过归纳与整理,将具有代表性的基于聚类的离群点检测方法进行了介绍和归类,将其主要分为静态数据集中的检测方法、数据流中的检测方法、大规模数据中的检测方法和其他方法等四大类。对每类方法所解决的问题、算法思想、应用场景以及各自的优缺点进行了详细地归纳和分析,并分析目前存在的问题以及提出未来发展方向。

1 基于聚类的离群点检测方法分类

1.1 静态数据集中的检测方法

静态数据是指在运行过程中主要作为控制或参考用的数据,它们在很长的一段时间内不会变化,一般不随运行而改变。聚类技术在静态数据集中离群点检测方法可以分为定量分析法和定性分析法。定量分析法主要包括采用离群因子、熵等来检测离群点的方法,它们对数据点具有明确的离群程度度量,即离群因子或者熵越大,离群程度就越大。而采用距离与概率等的方法中,只能判别数据点是否是离群点,这些方法是定性分析的,定性分析法对离群程度没有明确的度量。

1.1.1 定量分析方法

在数据处理中,离群点往往包含重要的信息,一个数据点具有多大的离群程度需要根据不同的应用环境获得,有些离群点可以被“容忍”。

Zhang等人[20]引入了一种称为基于局部距离的离群因子LDOF(Local Distance-based Outlier Factor)来度量散乱数据集中的离群点。

文献[21]使用K-means算法对聚类中心周围的一些点进行剪枝,并使用LDOF从剩余的数据点中识别离群点。文献[22]提出了一种基于聚类的离群点检测(Clurstering Based Outlier Dectection,CBOD)的两阶段算法来检测数据集中的离群点。在第一阶段,采用one-pass聚类算法将数据集划分为半径几乎相同的超球体。在第二阶段,计算第一阶段得到的所有数据的离群因子,并根据其离群因子对数据点进行排序,具有高离群因子的数据点被视为离群点。

Li等人[23]基于FCM里面隶属度和信息论里面熵的概念提出了一种基于信息熵的离群点检测方法,他们把聚类之后得到的隶属度看作数据点属于对应类别的概率,通过熵来度量数据点的离群程度,计算得到每一个数据点的熵值,将其按从大到小的顺序排列,找到数据集中的离群点。

Breunig等人同样提出了局部离群因子的概念[24-25],这是一种基于密度的方法,这种方法不再将离群点看做一个二值属性,而是量化地描述数据对象的离群程度,其能在数据分布不均的情况下准确发现离群点,但由于离群点在数据集中所占的比重较小,直接计算数据对象的离群度会增大计算量。Chen等人[26]提出了基于粗糙集理论的混合数据离群点检测算法,首先指定数据对象每个属性的粗糙邻域,再利用属性值的差异性计算对象的离群程度,但该算法的检测结果对人工指定的属性粗糙邻域范围参数十分敏感,针对上述缺点,文献[27]提出了改进的DBSCAN聚类和LAOF两阶段混合数据的离群点检测算法,在第一阶段,通过输入K近邻的个数代替Minpts并通过K近邻确定聚类半径,从而减少参数输入进而提高聚类质量,通过改进的DBSCAN对混合数据进行初步筛选,然后利用新构造的LAOF计算筛选后数据的离群程度,在混合数据进行距离度量的过程中采用除一化信息熵差值确定属性权重,并在第二阶段进行二次权重确定。最后利用真实数据对提出的算法进行了验证,结果显示该算法能够提高离群点检测的精度,降低计算复杂度,但该算法中参数K值的选取直接影响聚类结果。

文献[28]从定义出发,提出基于聚类的局部离群点的概念。他们解释了局部的定义,即小聚类在宏观上可以看作离它最近的大聚类的局部,给出倍数β来作为大小聚类的判别。通过新的局部概念,提出了CBLOF(Cluster-Based Local Outlier Factor)的计算公式,计算得到每一个数据点的局部离群因子来表征离群程度。

Jiang等人[29]利用离群点检测技术初始化K-modes聚类,避免离群点被选作聚类中心,影响聚类结果。他们根据数据集中的简单距离提出了属性加权距离,即不同的属性对数据的影响不同。在这个定义下,提出两种表征离群程度的方法。第一种是传统的基于距离的方法,用DOF衡量离群度。第二种是基于属性熵的检测方法,根据提出的属性加权距离得到每一个数据的属性熵,计算得到其基于熵的离群因子PEOF来表征离群程度。

文献[30-34]提出了类似的用信息熵或离群因子来表征离群程度的方法。这些方法的优点十分明显,它们能够表征离群点的离群程度,给研究者很重要的参考来判断哪些离群点可以被“容忍”。

各种离群因子计算公式如下:

u ij表示数据x的隶属度,c是聚类个数[23]:

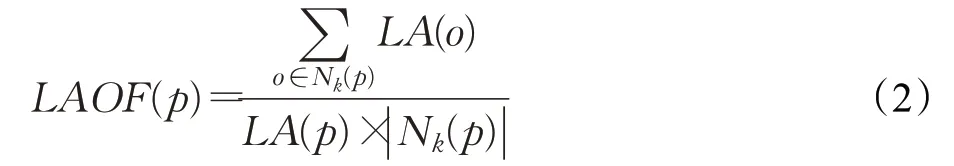

对象p的局部离群因子表示为LA(p)与它的k个邻居局部密度均值比值的倒数[27]:

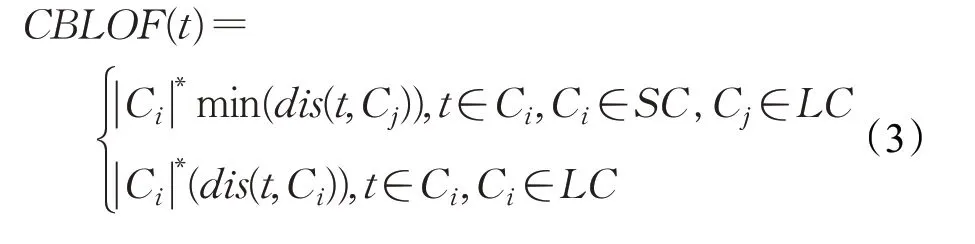

|Ci|*表示数据集C i的大小,SC、LC分别表示小、大数据集,C j为离C i最近的大数据集[28]:

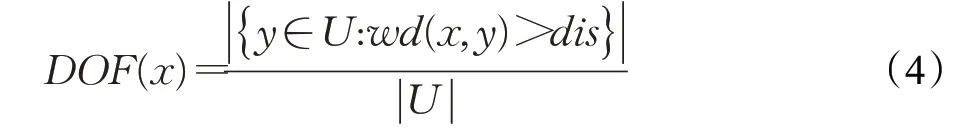

数据点x的离群因子表示为加权距离w d(x,y)大于参数dis的点的个数与数据集大小的比值[29]:

然而,这些方法的缺点也显而易见,从计算公式(1)~(4)中可以看出,无论是信息熵还是离群因子的计算,都要首先得到数据点与其他所有点的距离或者数据点周围其他点的密度,这对于大型高维数据集,计算复杂度会大大增加。

1.1.2 定性分析方法

定性分析方法与定量分析方法的区别是有相应的阈值来判别离群点。

文献[35]提出了基于K均值和层次聚类的离群点检测与去除方法,先执行任意一种聚类方法,直接将小簇当作离群簇去除,然后计算每一对数据点之间的距离,提出一个阈值,该阈值是最大距离与最小距离和的一半,如果数据点与聚类中心的距离大于这个阈值,则该点视为离群点,把离群点去除后,聚类效果得到提升。这个阈值是噪声距离的原型。Rehm等人[36]提出了更为复杂精确的方法,他们引入了单独的离群簇,将所有的离群点归类到这一簇中,基于特征空间中超体积的概念给出了新的噪声距离的计算公式,通过实验证明,这个阈值更加精确。

Saha等[37]采用了一种综合的方法检测离群点,他们的亮点在于提出了硬聚类中隶属度的概念,先使用Kmeans、K-mean++和FCM对数据集分别进行聚类,得到相应的隶属度,把隶属度当作数据点属于相应类别的概率,然后根据加权概率公式,算出总概率。最终给出阈值的计算过程,如果加权概率中最大的概率小于此阈值,该点就被视为离群点。如公式(6)中,K为聚类个数,θ为所设置的阈值,需通过多次实验获得,当阈值减小时,被检测到的离群点个数随之减少,反之增加。

Dan等[38]发现通过传统的FCM算法能巧妙地检测离群点。他们根据FCM的目标函数发现离群点的存在会使其值显著变大,也就是说,把离群点去除后,目标函数值会显著减小,他们通过实验证明了把每一个数据依次剔除,观察目标函数值的变化量能很好地判别离群点。对于“显著”的判断,他们同样提出了阈值——目标函数值平均变化量的T倍,T是研究者自己确定的。如公式(7)中,T通常情况下取1.5得到的检测效果最佳,若T减小,则检测到的离群点个数增加,反之减少。

相关的判别公式:

u cj表示第j个点对应于第c类的隶属度,μ、σ为噪声聚类隶属度的均值和标准差,β为提出的阈值[36]:

P[i][j]为三种聚类执行后得到的综合概率,k为聚类个数,θ为提出的阈值[37]:

DOFi为去除第i个点得到的目标函数值变化量,AvgDOF为平均变化量,T为提出的阈值[38]:

文献[39-41]同样提出了类似的定性分析方法,都是通过一个界限即阈值来判别离群点,如公式(5)~(7),表述起来十分清晰方便,这是区别于定量分析的最大优点,然而,阈值(β,θ,T等)的确定是一项复杂的工作,需要大量实验的支撑,并且涉及到大量参数,上述方法几乎都是在阈值的确定方面做出了创新。

定量分析方法和定性分析方法都有同样的缺点,即计算复杂度过高,对于大型高维数据集的处理十分困难。在基于K近邻的离群检测方法中,文献[42]提出了在Hadoop平台上采用分布式计算的方法来解决计算太过复杂的问题。但是,在基于聚类的领域,大型高维数据仍然是一个棘手的问题。

1.2 数据流中的检测方法

在前一节中提出的检测方法大多只适用静态数据集,然而,数据流在许多应用中越来越常见。由于数据流的输入是动态变化的,这使得有监督的方法基本无从下手,所以无监督的聚类方法更适合数据流的离群检测。

文献[43]中基于距离的数据流离群点挖掘算法DSOBD主要是通过计算各个数据块中每个数据点与其他所有数据点的距离计算离群度的方式判断是否为离群点。在阈值合适时,此算法检测的精确度比大多数算法高,但对于大数据集,由于该算法对每个数据都需要计算离群度导致运行效率低。文献[44]把检测过程分为两个阶段,首先将滑动窗口固定大小,第一阶段对滑动窗口中的数据进行聚类,第二阶段负责把小规模的远离其他簇的小簇挑选出来作为离群点集。这个算法实现了无监督的检测,但它单一地认为离群点就是小簇,这是不合理的。针对以上缺点,文献[45]提出了动态离群点检测算法(Dynamic Outlier detection based onKMeans,DOKM),同样先使用K-means算法对初始滑动窗口聚类找出小簇并视为离群点集,然后计算剩下的数据点的相对距离,如果此距离大于一定阈值,则该点被视为离群点,同时在滑动窗口中删除此点。该方法完善了前一个方法检测到的离群点的类型,改善了检测结果,并减少了运行时间。

文献[46]采用频繁项集的方法处理流数据,Zeng等人[47]提出通过对流数据进行划分先进行K-means聚类,然后进行聚合聚类的流数据噪声检测算法。文献[48-49]提出一种基于K均值的数据流聚类方法,算法将数据流中数据进行分区,顺序的s个数据点构成一个区域,输入s个数据点,按照K-Means聚类算法从中找出K个均指点,每个点的权重为隶属于该均指点的数据点数目,重复这一步骤,直到内存中生成s个均值点,对应层次聚类算法的第1层聚类效果;对生成的s个均值点按照K-Means聚类算法从中找出2K个中心点,同时更新这些均值点的权重;继续读入s个数据点,进入下一层聚类。借鉴这一方法,倪巍伟等人[50]提出基于K均值分区的流数据离群点发现算法(Data Stream Outliers detection alogorithm based onK-means Partioning,DSOKP)算法,该算法通过对流数据进行分区,在每个分区内基于K-means聚类获得均值点集,然后识别出异常数据,此算法可以有效解决数据流离群点检测问题,但参数K的选取依然对算法效能存在较大影响。

文献[51]提出了一种无监督的快速准确多维序列异常检测方法(unsupervised Fast and Accurate Anomaly Detection,FAAD)来检测数据流中的离群点,首先,采用信息计算和最小生成树聚类的方法减少冗余维数;其次,为了适应数据流的动态特性,加快模型的构建,提出了基于RSIPST(Random Sampling and subsequence partitioning based on the Index Probabilistic Suffix Tree)的随机采样和子序列划分方法;最后,用ABMDA(Anomaly buffer Based on the Model Dynamic Adjustment)降低概念漂移的影响。同样,为了能够及时发现异常现象,Yogita等[52]利用加权属性矩阵来检测离群点,通过计算当前和以前的方差矩阵来更新权重和聚类中心。文献[53]提出了基于离群点检测的不确定数据流聚类算法,先把数据集划分成若干个微聚类;然后,根据过滤机制获取全局离群点,在离群点微聚类中使用基于距离的方法挖掘出局部离群点;最后,采用不确定数据流子空间聚类算法完成全局离群点以及局部离群点两种不确定数据流聚类。这种方法在数据维度和数据规模增加时,不会对算法结果产生太大影响,因此稳当性较好。

文献[54-56]也提出了类似的数据流中的检测方法,但是数据流中的离群检测与静态数据相比面临更大的挑战,首先,数据流中的冗余维数和较大的状态空间会导致对数据的建模能力差;其次,数据流是连续的,速度很快,这就需要离群检测方法具有实时性;最后,与静态数据相比会出现概念漂移的现象,新的数据可能与历史数据的特征完全不一致,从而影响检测性能。

1.3 大规模数据集中的检测方法

随着数据规模的不断增长,传统的集中式算法计算复杂,处理效率受限,无法满足用户日益增长的需求。基于聚类的检测方法对于大规模数据处理起来十分困难,也是亟待研究的领域,但也有少量的学者在这个方面做出了研究,大多以分布式计算作为解决问题的手段。

文献[57]提出了一种多步异常检测方法,他们基于互信息和广义熵的特征选择技术来选择相关的非冗余特征子集,基于生成树的聚类技术生成一组参考点和一个离群值函数来对传入的网络流量进行排序以识别异常,设计了一个快速的分布式特征提取和数据准备框架,从原始网络流量中提取特征。张天佑[58]提出基于网格划分的高维大数据集离群点检测算法,先对高维空间进行网格划分,之后对剩余离群点集进行检测,但在网格划分时,时效将成指数增长。

王习特等人在大规模数据检测方面具有代表性。文献[31]提出了一种基于网格的划分算法(Gird-Based Partition algorithm,GBP)作为数据预处理的方法,该方法把数据集分成几个网格,然后将这些网格分配给分布式环境中的数据节点,其次,提出了一种分布式LOF计算方法(Distributed LOF Computing,DLC),它只需要少量的网络通信就可以并行检测基于密度的离群值。文献[59]提出了一种新型的分布式离群点检测算法,在预处理阶段,设计了新的BDSP(Balance Driven Spatial Partitioning)数据划分算法,实现了良好的过滤效果,降低了网络开销。在这种划分算法的基础上,提出了BOD(BDSP-based Outlier Detection)检测算法,第一步,利用R树索引进行批量过滤,快速地计算离群点并得到本地候选集,第二步,利用BDSP中提供的块编码确定需要相互通信的节点,使用少量的网络开销得到最终的结果。文献[60]提出了更为高效的DACB(Distributed Algorithm for the Cluster-Based outlier detection)算法检测离群点,主节点根据每个从节点上权重较大的点计算阈值,在每个从节点上设计了一种剪枝方法加快KNN的搜索速度,并利用阈值过滤掉大量冗余节点,最后通过一系列的仿真实验证明这个方法能有效地减少分布式异常点检测的运行时间和网络传输量。

Google提出的MapReduce是一种用于大规模数据集的并行运算编程模型,能够处理T级别以上巨量数据的业务[61],Apache基金会开发的Hadoop分布式系统能够很好地处理巨量数据,刘亚梅等[62]发现王习特等人提出的BOD算法对全局离群点具有良好的检测率,但不适用于局部离群点。于是,将传统的检测方法LOF和Hadoop分布式平台下的MapReduce框架结合,实现了并行化策略,并通过密度聚类算法DBSCAN对其进行了改进,但在进行并行化操作时聚类效果会受到影响,并且这种方法对参数(ε,MinPts)和K距离参数比较敏感。

文献[63]在LDOF算法的基础上,提出了一种基于多重聚类的离群点检测算法PMLDOF,该算法针对局部离群度量计算量大的缺点,采用聚类剪枝技术作为减少计算量的方法,同时,为了避免将位于簇边缘的离群点错剪,算法利用多重聚类的差异性对簇的边缘点进行筛选。在对数据集进行剪枝后,计算剩余数据的局部离群度LDOF,并找出符合条件的离群数据点,此算法在时间复杂度和检测精度上具有良好的优越性。

文献[64-66]同样给出了在大规模数据集上的处理方法,由于聚类算法在大规模数据集处理上的局限性,其检测方法同样不多。目前对大规模数据集的处理主要集中在两个方面:首先,在数据预处理方面,对数据集进行剪枝[67]、降维[68],或如文献[59]中提出新的数据划分方法,平均化每个节点上的工作负载,提高并行性,降低网络开销。其次,采用Hadoop平台上的MapReduce模型框架,解决数据规模过大的问题。

1.4 其他检测方法

除了以上三类主要检测方法外,依然有一些其他检测方法。文献[69]提出了三阶段K-means算法,对数值型数据进行聚类和离群点检测。文献[70]提出了一种用于离群点检测的两阶段聚类算法。在第一阶段,对K-means算法进行了改进,当数据点远离所有聚类时,将这个数据点指定为一个新的聚类中心。在第二阶段,根据第一阶段得到的聚类中心构造最小生成树,在小子树中的簇被视为离群点。文献[71]提出了一种同时从数据集中聚类和识别离群点的ORC(Outlier Removal Clustering)算法。ORC算法由两个连续的阶段组成:第一阶段是纯K-means算法;第二阶段迭代地删除远离聚类中心的数据点。文献[72]提出了一种基于马氏距离的离群点检测方法。文献[73]提出了K-means-L算法,它需要两个参数:K和L,分别指定所需的聚类数和期望的最大离群点数量。

针对传统的基于最小生成树的聚类算法时空复杂度过高且容易漏检较大簇中局部离群点的问题,文献[74]将基于K近邻与基于聚类方法的优势相结合,提出了一种快速K-NN的最小生成树聚类离群检测方法,减小了时空复杂度。该方法首先在数据集上构建平分树,计算数据点的K近邻,然后减枝确定全局离群点,通过计算局部离群因子来检测局部离群点,该方法能够自适应的识别聚类数目并且能够检测出多种类型的离群点。

基于密度的聚类通常需要输入大量的参数,这时参数的选择在很大程度上会影响聚类以及检测的效果。邱华等[75]以用电数据上传过程中的掉线问题为对象,研究一种基于极限学习机的密度聚类离群点检测方法,他们发现传统的LOF算法对于智能电表的报文数据掉线分析效果不理想,于是在此基础上,提出了基于权值的局部离群因子(WLOF)算法,把预处理后的历史报文数据放入ELM进行训练,预测得到判别离群点的WLOF阈值,再用密度聚类算法对实时数据进行离群点检测。这种算法不用知道离群检测的阈值,拓宽了算法的应用范围。

同样,为了解决参数输入过多的问题,文献[76]将自然邻居搜索算法和密度聚类算法相结合,提出了基于聚类离群因子和相互密度的离群点检测方法,他们使用相互密度和γ密度构造决策图,将γ密度异常大的样本点作为聚类中心进行聚类,最后根据聚类的离群因子找出离群聚类边界检测离群点。OPTICS也是常用的基于密度的聚类方法,文献[77]提出了OD-OPTICS算法,为了过滤无效半径,选择合适的半径,在覆盖空间(coverspace)中提出了半径过滤策略(RFS),重新定义了核距离(core-distance),更加突出了离群点与正常点之间的不同。

离群点检测的方法很多,应用场景也多种多样,例如在文献[78]中,利用离群检测提出了OEDP-K-means方法来保护数据挖掘过程中暴露的个人隐私,文献[79]采用两步无监督的聚类方法应用于医疗欺诈的检测。不管是哪种方法,他们都以聚类为背景检测离群点,在不同领域做出了贡献。

2 方法总结及存在的主要问题和进一步研究方向

静态数据集与数据流是相互对立的,因此在检测离群点时所应用的方法和所要解决的问题截然不同,然而大规模数据集中的检测方法与上述两种稍有重合,只不过它的重点在于如何解决计算复杂度过高这个难题,比如对其进行剪枝、降维等。基于聚类的离群点检测方法方便高效,在进行聚类的同时,就能完成检测离群点的任务,由于无监督学习的特点决定了数据无需类标签,因此适用于大多数数据,这是其他方法不可比拟的。

同时,它的不足与劣势也十分明显:

(1)基于聚类的离群点检测方法检测结果的好坏受到聚类方法本身的制约,对于不同的数据集没有普遍适用的聚类方法,因此,对于不同的应用场景和数据特征,需要对算法进行调整,这就增加了应用的难度。

(2)在静态数据集中,定量与定性分析从两种截然不同的角度判别离群点,定量分析中离群因子与熵值大小能够明确衡量离群程度,它们的得出往往需要计算每个数据点与其他所有数据点之间的距离或者与周围点的密度,当数据维数比较高,数据集比较庞大的时候,这种方法运行起来就十分困难,计算就比较复杂,在文献[27]中,由于传统的LOF算法计算可达距离和可达密度的时间复杂度较高为o(Nk2),所以对该算法的相关定义进行了改进,采用数据对象的K距离作为可达距离并用区域半径求得区域面积代替距离和,这样就降低了时间复杂度变为了o(Nk),定性分析中根据阈值来判别离群点简洁明了,但阈值的确定是个十分复杂的问题,文献[36]提出了基于特征空间超体积概念的噪声距离确定方法,对于其中参数α的确定需要大量实验,在文献[38]中,通过大量实验提出了将目标函数值的平均变化量的T倍作为阈值,其中T的确定同样需要重复实验多次。

(3)在数据流中,无监督的方法更加适用动态变化的数据,但冗余维数和较大的状态空间导致数据建模能力差,不断变化的数据需要算法具有很强的及时性。文献[45]提出的DOKM算法在检测离群点的同时也优化了聚类,但是此算法只能检测数值型数据,并且质心的初始值随机性比较大。文献[50]提出的基于K均值分区的检测算法需要对数据流先进行聚类生成均值参考点,而K-均值聚类效果受K的影响较大,因此参数K的选取对该算法效能具有很大影响。

(4)在大规模数据中,基于聚类的检测方法面临巨大挑战,离群因子、熵、阈值等的计算复杂度过高是急需解决的问题。文献[59]研究了分布式环境下的离群点检测方法,在数据预处理阶段,他们提出了新型的数据划分方法BDSP来均衡每个计算节点的工作负载并具有良好的过滤效果,基于BDSP算法提出了BOD分布式离群点检测方法,提高了计算效率并大幅降低了网络开销。刘亚梅等[62]采用Hadoop平台上的MapReduce模型框架,以Hbase作为数据库,解决了数据规模过大的问题,但是由于对数据进行并行化操作时导致数据集聚类效果受到影响,并且此算法同样对参数(ε,MinPts)和K距离参数比较敏感。

在基于聚类的离群检测领域,未来应该针对上述问题提出相应解决方法:

(1)研究一种或几种具有普适性的且运行稳定的针对离群点检测的聚类算法,在该算法的指导下使离群检测能够适用大部分数据集以及更多的应用场景。

(2)针对静态数据集中的离群点检测,需要对阈值的计算方法进行创新,因此需要研究新的离群因子模型,给出更为精确的阈值计算公式是当下研究的关键。

(3)针对数据流中的离群点检测,需要解决对流数据的及时适应的问题,如何减少数据的冗余维数以及提高时效性是未来需要研究的方向。

(4)针对大规模数据集中的离群点检测,需要研究数据预处理方法,进而减小数据量,同时,与并行计算相结合是未来研究的趋势。

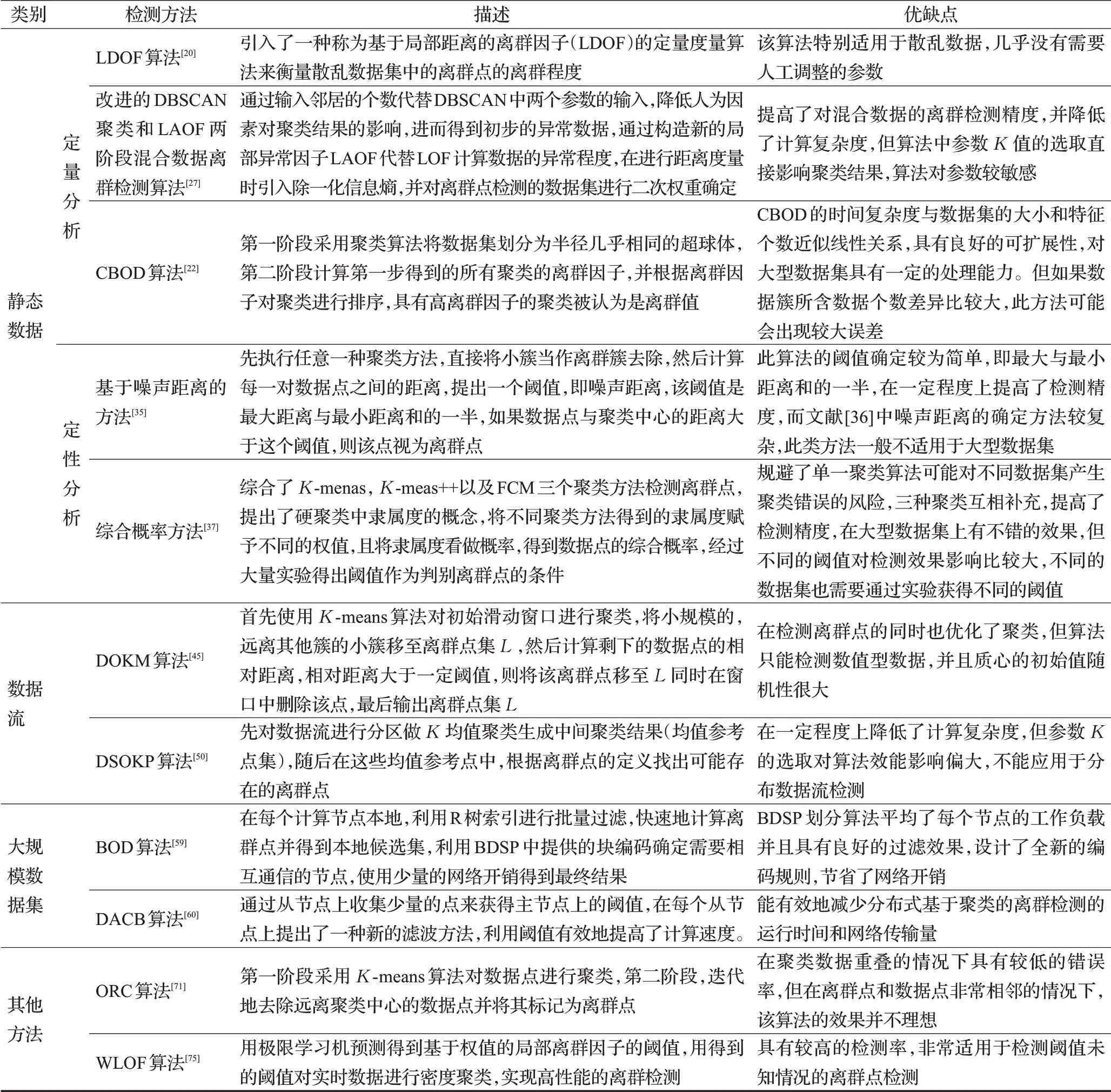

最后,把本文涉及到的文献与对应的检测方法类别进行了整理,如表1所示。

表1 典型检测方法描述与优缺点

3 结语

基于聚类的离群检测方法在众多方法中具有明显优势,本文主要从数据类型的角度对其进行了分类,在静态数据集中又从定性定量的角度进行了划分。在离群检测领域,大量的方法已被研究者提出,无论是基于统计的,基于密度的,基于距离的还是基于聚类的方法,它们在大规模高维数据集方面都存在一定的局限性,随着大数据和分布式计算时代的到来,相信这些检测方法会迎来新的突破。