基于毫米波雷达和机器视觉融合的车辆检测*

2021-05-12张炳力詹叶辉潘大巍宋伟杰刘文涛

张炳力,詹叶辉,潘大巍,程 进,宋伟杰,刘文涛

(1. 合肥工业大学汽车与交通工程学院,合肥 230041;2. 安徽省智能汽车工程实验室,合肥 230009;3. 合肥长安汽车有限公司,合肥 230031)

前言

环境感知作为关键技术之一,主要是通过雷达、摄像头等传感器获取车辆周围的环境信息,是实现智能驾驶的前提和基础。在环境感知系统中,前向车辆识别是关键,准确可靠的前向车辆识别结果对智能汽车的安全行驶意义重大[1]。

目前广泛使用的道路环境感知设备主要有摄像头、毫米波雷达和激光雷达等。但由于单一传感器不能全面、精确地对车辆周围所有环境信息进行采集,因此往往采用两种以上感知设备进行信息融合。多传感器信息融合技术可以实现各传感器优势互补,最大程度采集环境信息,提升环境感知系统的可靠性、实时性和抗干扰能力。综合各传感器的优劣,本文中选择摄像头和毫米波雷达进行数据融合,完成前向车辆识别。

Zhang 等[2]使用毫米波雷达检测障碍物的位置和速度,图像处理模块通过深度学习,使用边框回归算法精确定位和识别障碍物。Kim 等[3]提出了一种基于目标运动状态及形状特征的车辆识别方法,通过毫米波雷达和摄像头分别采集目标的运动状态和形状特征,从而识别前向车辆,并应用于自动紧急制动系统。Chang 等[4]提出了一种利用毫米波雷达和视觉传感器进行障碍物检测的空间注意融合(SAF)方法,考虑了雷达点的稀疏性,并可以嵌入特征提取阶段,有效地利用了毫米波雷达和视觉传感器的特性。孙青[5]针对目标跟踪中系统噪声的统计特性未知或时变的问题,结合传统的Sage⁃Husa自适应滤波算法和平方根滤波思想,提出改进的线性自适应平方根卡尔曼滤波算法实现目标状态预估。王战古等[6]使用深度置信网络对车辆进行初步识别,并根据车型宽度和高度统计数据验证识别结果,在多种恶劣道路环境下取得了良好的识别效果。

综上所述,目前大多数方法只是根据毫米波雷达检测结果在图像中生成假设目标区域,再利用视觉方法对假设目标区域进行检测,这类方法在一定程度上降低了雷达的误检率和视觉检测的运算量,但并未考虑雷达漏检等情况,在输出检测结果时,也没有对两种传感器进行更深一步的信息互补,融合的效果一般。

鉴于此,本文中提出了一种基于毫米波雷达和机器视觉融合的车辆识别方法。该方法首先利用毫米波雷达和摄像头分别获取初步识别结果,然后搭建数据融合模型实现两传感器检测目标匹配,利用扩展的卡尔曼滤波算法进行多目标跟踪,提高识别稳定性。最后通过试验验证车辆识别算法的有效性,并对其稳定性和环境适应性进行验证。

1 融合算法架构设计

目前主要有3 类传感器融合方法:数据级、目标级和决策级融合。其中,目标级融合的主要思路是:首先单传感器获得各自的检测目标,然后融合算法综合分析检测目标,最终得到符合融合策略的目标。目标级融合能够充分利用单传感器的优势,提升系统鲁棒性,因此,本文中采取目标级传感信息融合方法。

融合算法架构如图1 所示,主要由雷达处理模块、视觉处理模块和融合模块3部分组成。雷达处理模块从毫米波雷达获得的原始数据中筛选出潜在的车辆目标,视觉处理模块从摄像头拍摄的图像中获取视觉检测信息,融合模块根据检测框交并比和全局最近邻数据关联(GNN)算法[7]等综合雷达、视觉方法的检测结果,完成目标级的传感器信息融合。

图1 融合算法整体架构

2 传感器数据处理

2.1 毫米波雷达目标筛选

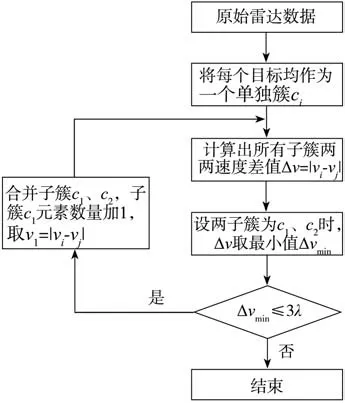

毫米波雷达原始数据中包含大量静止目标,这些目标通常不会对自车行驶造成危险,而所需识别的车辆目标一般为动态,据此可以设置处理策略,完成车辆目标的筛选。雷达处理模块中采用分层聚类算法[8]来过滤无效目标,算法的具体流程如图2 所示,其中λ为雷达自身测速误差。

图2 分层聚类算法

通过该算法可以把原始数据分成n个子簇。其中静止目标由于速度都为0,皆被归为同一个子簇,把它删除,即可获得n- 1个动态目标。由于采用的是相对速度进行判断,在自车速度未知的条件下,该算法仍可有效完成静态目标的过滤,提取出所需的动态目标,具有较好的稳定性。图3(a)为原始雷达数据,图3(b)为经过算法处理后的雷达数据。可以看出,分层聚类算法有效去除了静止目标,提升了雷达模块输出结果的可信度。

图3 原始雷达数据和处理后的数据

2.2 基于改进YOLO v2的车辆检测

视觉处理模块基于YOLO v2[9]算法改进而来,YOLO[10]系列算法是Redmon 等人在2016 年提出的一种端到端(end to end)的视觉卷积神经网络方法,其在视觉检测方面具备较好的实时性和准确性。

后续版本的YOLO算法是在最开始的v1版本上改进而来,因此这里以最初的YOLO v1 为例介绍YOLO算法的工作原理。

YOLO v1将待检测的图像分成大小相同的S×S的单元格(grid cell),每一个单元格将负责检测中心落在其区域内的目标。假设网络需要对C类目标进行检测,每个单元预测出B个目标包围框(bounding box)及其置信度(x,y,w,h,c),网络的输出为S×S×(5×B+C)大小的向量。其中,(x,y)表示目标包围框的中心点位置;(w,h)表示目标包围框的宽和高;c代表预测的目标包围框中包含物体的置信度(confidence)。

每个单元格预测目标类别的条件概率为Pr(Classi|Object),i= 1,2,…,C,位于同一个单元格中的B个目标包围框共享该条件概率。在测试时,将网格预测的条件概率分别和该网格中目标包围框预测的置信度相乘,即可获得每个目标包围框中存在物体的类别置信度。设置阈值过滤掉置信度较低的目标包围框,对剩余的目标包围框进行非极大值抑制(non⁃maximum suppressio,NMS)处理,即可得到最终的检测结果。

YOLO v2 在v1 版本的基础上进行了部分改进,提升了算法的识别速度和精度,但直接用于车辆检测仍有以下不足:YOLO v2 采用13×13 的特征图进行预测,在车辆目标较小时,无法稳定识别目标;YOLO v2 的高实时性需要配置较高的硬件设备,目前车载设备性能有限,直接采用YOLO v2网络,无法达到车辆识别的高实时性。

针对上述问题,对YOLO v2做了如下改进。

(1)删减卷积层:YOLO v2 使用Darknet-19 卷积网络进行目标特征提取,该网络对于单一类别的目标识别略显复杂,本文主要检测前方车辆,因此在保证识别精度的前提下,对Darknet-19进行修改,删减部分卷积层,降低网络复杂度,提高车辆的识别速度。

(2)使用多尺度检测:在卷积神经网络中,网络较低的层次其感受野尺寸较小,所表征的特征语义信息较少,特征图分辨率高,几何细节表征能力强,适用于检测小目标。网络较高的层次则有较大的感受野,特征语义信息丰富,但是特征图分辨率较低,对几何细节的表征能力较差,适用于大目标提取,并在有阴影或目标遮挡时,也能识别目标,具有较强的鲁棒性。因此,使用多尺度目标检测,可以同时获取几何细节和大目标语义信息,实现对不同距离、不同状态的前方车辆识别。

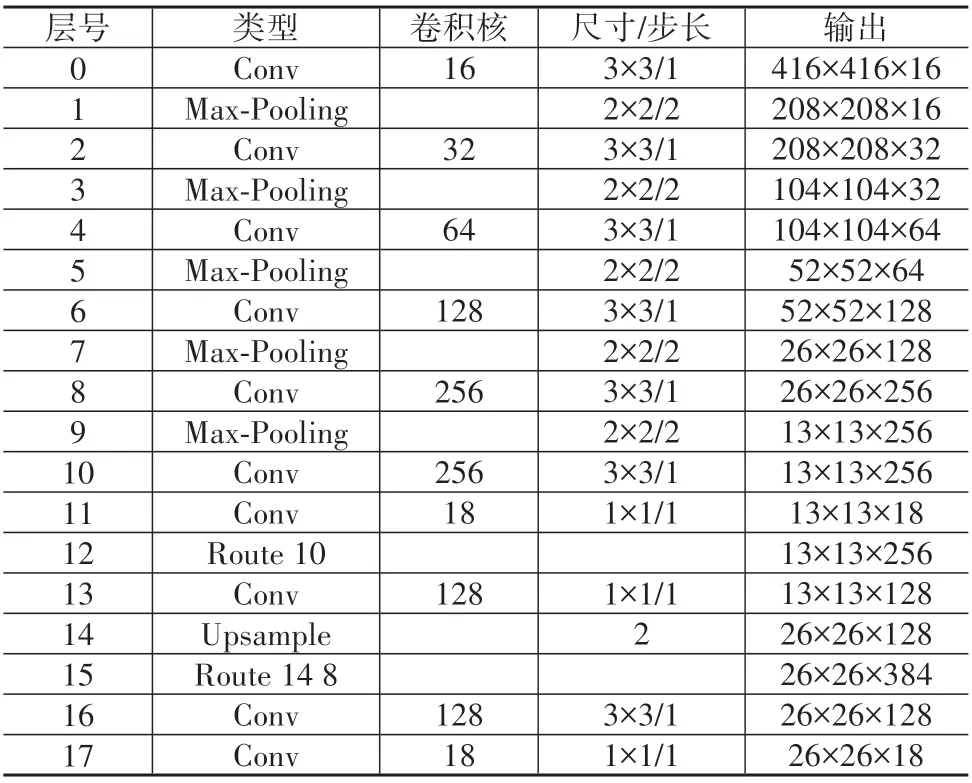

基于上述策略对YOLO v2进行优化后获得了改进的YOLO v2 网络,网络输入为416×416×3 的图片,具体结构如表1所示。

改进的YOLO v2网络将用于特征提取的卷积层缩减为8 层,使整个网络的复杂度和运算量显著减少;并在11 层和17 层中分别使用13×13 和26×26 两种尺度的特征图进行目标检测,增加了对远处小目标车辆的检测能力。

表1 改进YOLO v2网络结构

3 多传感器信息融合策略

3.1 空间同步

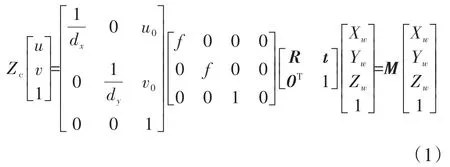

在对多传感器进行融合时,首先需要进行传感器空间同步,即将不同传感器坐标系的测量值转换到同一个坐标系中。毫米波雷达与摄像头的空间坐标系转换公式为

式中:Zc表示点在摄像头坐标系下的纵坐标;(u,v)表示在像素坐标系下投影点的坐标;dx、dy表示像素点在图像坐标系下x轴和y轴上的单位长度;(u0,v0)表示摄像头主点偏移量;f为焦距;R、t分别表示旋转矩阵和平移向量;M为投影矩阵。

利用上述公式可以将雷达检测目标投影到图像上,从而获得雷达检测的目标包围框。同时,经过标定获得传感器内外参数后,可以将图像投影到雷达扫描平面,从而计算出像素在该平面的坐标,最终获得摄像头检测目标的位置信息。由于摄像头的检测结果为矩形框,而雷达坐标系下的检测结果为点,为准确表示出视觉有效目标在雷达坐标系中的坐标,从而获得摄像头检测到的目标位置,本文选取视觉检测框的底边中点作为目标的位置点。

3.2 基于目标检测交并比的融合

获得雷达目标和视觉目标之后,首先为每个雷达目标以检测点为中心,建立宽2.6 m、高2 m 的矩形包围框,将所有包围框基于距离和相似原理投影到图像上。设雷达和摄像头对某一目标的矩形检测框分别为Rradar、Rcamera,Rradar与Rcamera所包围的总面积为Sunion,重合区域的面积为Sintersection,则交并比IOURC为Sintersection与Sunion的比值,IOURC的计算公式为

参考相关文献[11],并经测试与分析,当IOURC∈[0.6,1]时,雷达和摄像头都可识别同一目标车辆,且识别结果基本匹配,具有较好可靠性。由于在此种状态下,摄像头获取的目标位置信息较为精准,故将摄像获取的目标横向位置与雷达检测的目标其他状态参数综合并输出。

3.3 基于全局最近邻数据关联算法的融合

当IOURC的值不在上述范围时,无法判断识别的准确性,由于通过“帧差法”可以获得摄像头对目标速度的检测结果,在忽略目标的加速度等信息,仅考虑目标位置和速度的前提下,利用数据关联的方法对剩下无法匹配的雷达和摄像头检测数据进行处理,将两者的检测数据视为雷达在连续两个采样周期下获得的两帧数据,即看作单一传感器的数据关联问题。

本文中采用全局最近邻(GNN)数据关联算法,该算法在综合考虑整体的关联代价后,选取总代价最低的关联方案,较为符合实际工况,且计算量较小。

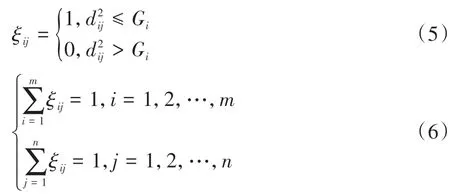

设雷达和摄像头剩余有效目标个数分别为m和n,目标到坐标原点的距离为dkr、dkc,将其按距离大小排序并存入对应的有效目标矩阵R、C,将雷达检测值作为航迹,摄像头检测值作为量测。设vij(k)为k时刻航迹i与量测j的残差,其计算公式为

式中H表示状态转移矩阵。

航迹i与量测j的归一化距离d2ij表示为

式中:S-1ij(k)表示vij(k)的协方差矩阵。设Gi表示航迹i的门限值,当满足d2ij≤Gi时,认为量测j落入航迹i的门限内,可以进行匹配,同时航迹和量测的匹配需满足以下约束条件:

即每个航迹最多匹配一个量测,每个量测对应一个航迹。

GNN算法中的代价函数定义为

式中cij表示代价,计算公式为

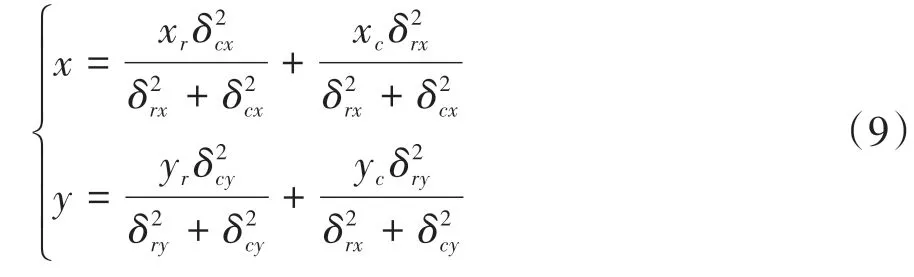

通过上述公式可得出GNN 算法的代价函数,即可完成剩余雷达和摄像头目标的匹配,从而实现雷达和摄像头的信息融合。目标匹配成功后,对雷达和摄像头检测到的目标位置进行加权处理,将加权后的目标位置和雷达检测的其他信息综合后输出,加权策略为

式中δcx、δcy、δrx、δry分别表示摄像头和雷达检测的目标位置在x、y方向的平均误差。

3.4 目标决策

传感器信息融合完成后,需要对融合目标进行存在性判断,采用扩展卡尔曼滤波(EKF)算法跟踪融合目标,根据跟踪结果得到最终的输出目标。

融合目标的状态向量为

式中x、y、vx、vy分别表示目标的纵向坐标、横向坐标、纵向速度和横向速度。

EKF的状态方程和观测方程为

式中:X(k)、X(k- 1)分别表示目标在k、k- 1 时刻的状态向量;Z(k)表示目标在k时刻的观测向量;f、h表示状态转移矩阵;V(k)、W(k)表示高斯白噪声。

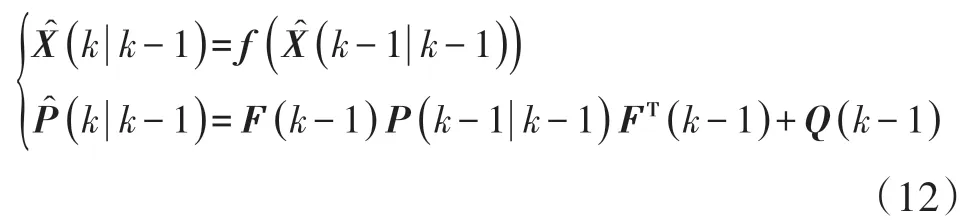

基于k- 1时刻的目标状态,可以预测出目标在k时刻的状态为

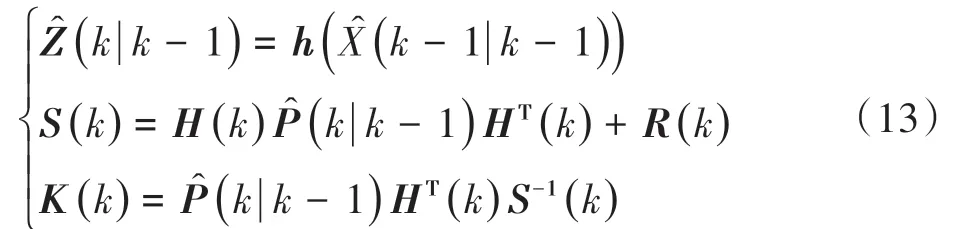

最终更新得到目标的状态信息为

图4 目标决策方法

4 试验与分析

4.1 改进YOLO v2验证

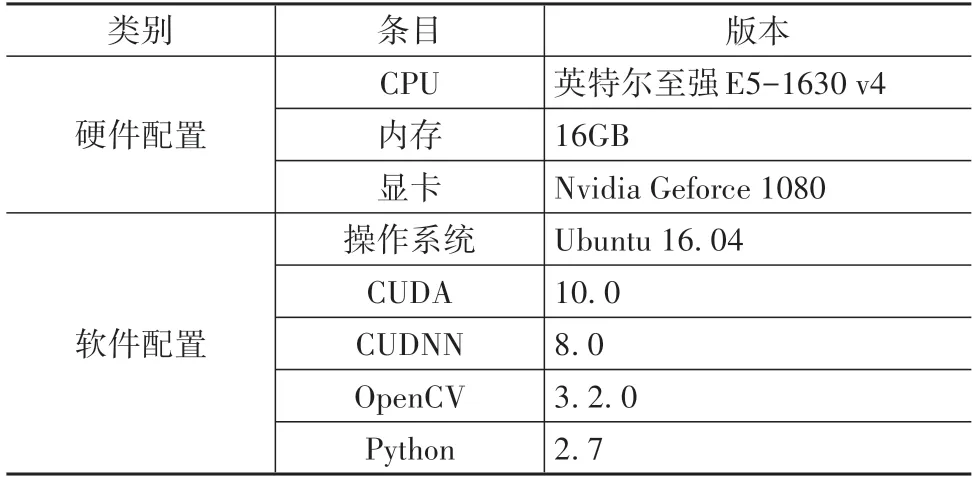

本文中使用的车辆数据集为自主采集并标注获得,数据集共有5 861 张图片,并按照8∶1∶1 的比例划分为训练集、验证集和测试集,网络的训练和测试在如表2所示配置的工作站上进行。

表2 工作站配置

为验证改进YOLO v2的性能,利用自制测试集,分别使用YOLO v2和改进的YOLO v2两种网络进行检测试验,并统计网络检测的准确率、漏检率和检测速度,试验结果如表3所示。

表3 网络检测结果对比

从表3 可以看出,在相同配置下,本文设计的改进YOLO v2在车辆检测准确率上与YOLO v2大致相同,但漏检率降低,在检测速度上也得到显著提升。

4.2 实车检验测试

本文中采用的传感器为德国大陆公司生产的ARS 408⁃21 毫米波雷达和大恒MER⁃230⁃168U3M/C CMOS工业相机,试验车辆与传感器如图5所示。

图5 试验车与传感器

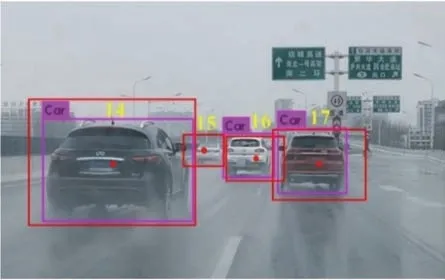

为综合分析融合算法的性能,在晴天、阴天、傍晚和雨天等多种道路条件下进行了实车试验,部分检测结果如图6 所示。图中红色框为雷达检测框,紫色框为视觉检测框。

图6 部分检测结果

如图7(a)所示,12 号目标的雷达和视觉检测框出现较大偏移,基于检测框交并比无法完成融合,将视觉检测的该目标投影至雷达平面,如图7(b)所示,图中红色点和紫色点分别表示雷达、视觉检测到的该目标在雷达坐标系中的位置,基于GNN 算法成功完成了雷达和视觉检测结果的融合。

图7 基于GNN算法的融合

图8 雨天环境融合效果

图8 展示了雨天环境下的融合结果。摄像头在雨滴的干扰下未检测出15 号目标,雷达由于自身较强的环境适应性,未受到下雨的影响,成功检测出视野内的所有车辆,在最终的融合结果中,并没有因视觉漏检而遗漏车辆目标。

为对比融合算法与单传感器之间检测效果的差距,选取了500 组经过时间同步后的图像和雷达数据,分别采用雷达算法、视觉算法和融合策略进行处理。表4为3种方法的处理结果。

表4 传感器检测结果对比

从表4 可以看出,相比于单一传感器检测方法,融合策略综合了毫米波雷达和视觉的各自优势,在提升准确率的同时降低了漏检率,实现了更好的检测效果。

5 结论

提出一种基于毫米波雷达和机器视觉融合的车辆检测方法,利用分层聚类算法完成车辆目标的初筛,通过改进YOLO v2算法降低了漏检率,并实现了更高的检测速度,在确保传感器空间同步下,基于目标检测交并比和GNN 数据关联建立融合策略,最后利用扩展卡尔曼滤波算法实现融合目标跟踪。

试验结果表明:该方法有效地实现了雷达和视觉检测结果的信息融合,可在多种天气条件下完成对车辆目标的检测,且检测效果优于单传感器算法,但在隧道和车辆密集的路口等复杂场景下仍会出现一定程度的误检和漏检情况。在后续研究中需要针对相应场景,进一步开展实车试验,分析误检和漏检发生原因,优化传感器融合策略,提升融合策略的场景适应性。