基于雾天高速车路协同模拟驾驶的驾驶人视觉信息加工模式

2021-04-10李雪玮赵晓华李振龙杨家夏荣建

李雪玮 赵晓华 李振龙 杨家夏 荣建

(北京工业大学 交通工程北京市重点实验室,北京 100124)

随着互联网和通信技术的发展,车路协同系统通过车-车、车-路通信技术,以提高道路安全为目标,为交通信息感知、出行服务及交通管控提供了新的思路,也为整体交通系统的优化提升带来了新的机遇[1]。尤其是在不良天气(如雨、雪、雾等)驾驶人视线受阻的环境下,车路协同系统能够为驾驶人带来更加安全、高效的出行体验。

车路协同系统车载单元通过语音、图像等形式将多元信息传递给驾驶人,在提高驾驶安全性的同时,也会成为驾驶过程中的次任务来源,从而影响驾驶绩效。研究表明:雾预警系统的应用可有效控制行车速度[2],减少雾天交通事故[3];自适应巡航系统等车路协同系统的使用能够提高驾驶人的态势感知能力并减少焦虑[4],降低驾驶人的紧张程度[5]。然而,驾驶任务是一项复杂的多任务过程,驾驶主任务依赖于主要视觉注意带(即前方道路主要关注区域,PVAL)的信息加工。Wickens[6]的多资源理论将驾驶人的加工资源分为知觉通道、编码和阶段3个维度,当驾驶任务在同一维度或更多维度上有共同需求时,会导致时间共享性变差,从而影响驾驶绩效。可见,其他车内视觉或非视觉次任务(如接听电话、查看导航、收发微信等)都会造成驾驶人的视觉注意分散[7]。也就是说,车路协同系统的应用无疑会成为驾驶过程中视觉次任务的来源,在给予更多信息辅助的同时,必将在一定程度上削弱驾驶主任务,从而影响驾驶人的视觉信息加工。

事实上,驾驶过程中80%的信息由视觉获取并加工,一项驾驶人视觉测试研究证实,人因(Human Factors)占事故致因的比例高达92.6%,而在人因中起主导作用的因素也多与视觉有关,包括驾驶人观察不当、注意力不集中、动态视敏度较差等。可见,视觉特性研究在交通安全中占据极为重要的地位。以往的研究探究了视觉信息、听觉信息及信息复杂度对视觉表现的影响。学者们通过对注视点的研究发现,影响视觉信息的内在因素是视觉次任务信息与驾驶主任务视觉信息争夺驾驶人有限的视觉注意资源[8]。视觉信息的出现会导致扫视时长与扫视频率的显著变化[9],使得注视时长变短,注视点分布不稳定[10],并减少驾驶人对道路中心区域的关注[11];同时,听觉次任务信息的视觉影响表现为平均注视时长增加,影响注视点的位置波动变化[12],扫视行为减少,视觉关注点相对集中在视野中心区域[13],继而引发驾驶人探测能力的下降。另外,部分研究也指出,预警系统中的辅助视觉信息纵向预警明显提高了驾驶人对道路情况的探测能力,加快了突发情况的反应时间[14],信息复杂时会损害驾驶人的视觉注意行为,信息简单时可提高行车及方向盘控制的稳定性[15]。综上,车路协同系统多元信息介入对于驾驶人的视觉影响是必然存在的,但其影响的具体表现暂不明确,而视觉表现与驾驶安全息息相关,针对车路协同系统开展相关研究十分必要。

车路协同系统以驾驶安全为目标,但多元信息的介入对驾驶人视觉注意的影响尚未明确,而在雾天等视线受阻的环境下,驾驶人对于辅助信息的依赖程度明显增加,这也就更加需要关注车路协同条件下驾驶人视觉信息的加工模式。因此,明确雾天车路协同系统作用下驾驶人的视觉行为特性,解析车路协同系统作用下驾驶人的视觉注意及信息加工过程,从而评价车路协同系统给予驾驶人辅助信息的同时,是否对驾驶安全造成了负面影响,就显得十分重要。而驾驶模拟技术作为评估与车内系统的使用相关的驾驶行为的常用工具,创造了一种安全可控和经济有效的实验环境,其在现实世界的有效性也已在前人研究中得到证实[16]。在系统设计和开发过程的早期进行相关研究,可在一定程度上减轻在现实环境中开发和实现的相关成本。

鉴于此,文中围绕以上核心问题,从视觉层面探讨雾天高速公路车路协同系统对驾驶人视觉信息加工处理模式的影响,依托模拟驾驶实验测试平台,借助其安全性高、设计性强、便于控制外部因素等特点,搭建雾天高速公路车路协同驾驶场景,获取驾驶人注视、扫视等显性视觉行为特性,刻画驾驶人视觉信息加工模式,探究车路协同系统信息对驾驶人视觉信息加工模式的影响机理。

1 实验

1.1 实验设备

1.1.1 车路协同系统实验平台

基于模拟驾驶技术搭建车路协同实验环境,分别由驾驶模拟系统、协同数据管理中心及车路协同系统人机交互终端(Human Machine Interface,HMI)组成,通过无线通信技术实现各组成部分的互联互通。其中,驾驶模拟系统模块具备场景设计开发、车载数据采集、数据传输等功能,并实现车载单元的模拟信息采集功能,包含交通系统中本车及邻近车辆的速度、位置、刹车、油门等信息,并通过UDP协议传输给协同数据管理中心;路侧单元信息包含外部天气条件、道路条件、交叉口信息、交通流信息等,可通过驾驶模拟系统的API函数提取;协同数据管理中心接收车载单元及路侧单元传输的环境信息,进行数据融合处理及判定策略的计算,并通过Wi-Fi与HMI互联,完成辅助提示信息的触发及发布。实验平台的架构如图1所示。

图1 实验平台系统

1.1.2 HMI设计

HMI以Android6.0系统平板电脑M3为原型进行开发,其安装位置如图2所示。参考车载驾驶辅助系统产品现状,设计界面遵循重要性、使用频率、功能分组和使用次序原则[17]。信息发布内容包含车辆状态信息、安全预警信息、路径信息、道路环境信息等。其中,限速提醒、超速监测、车距监测及盲区预警为持续性信息。预警信息通过语音、文字、图案3种方式进行视听联合信息发布。在各场景提示点中,HMI显示信息提示并同步语音播报。实验过程中,HMI放置在方向盘左前方区域便于驾驶人观察。

图2 HMI的安装位置

1.1.3 眼动仪

实验采用SMI ETG 2w 眼镜跟踪器(眼动仪)以60 Hz的频率采集驾驶人的动态视觉信息,在驾驶人视线移动过程中实现对现实世界三维信息的视觉追踪。眼动仪采集分辨率为0.1°;凝视定位精度为0.5°,采集范围为水平80°、垂直60°,采集距离在40 cm以上[18]。眼动仪可追踪拍摄对象双目,捕捉被试者的自然凝视行为,获取高分辨率的场景视频,进行动态兴趣区的深度分析。

1.2 场景设计

选择兴延高速46 km路段作为实验场景设计原型,场景设置为双向四车道,道路横断面为26 m,车道宽3.75 m,绿化带宽2 m,肩宽4.5 m,自由流状态,限速80~120 km/h。依据T/CSAE 53—2017《合作式智能运输系统 车用通信系统应用层及应用数据交互标准》[19]中“车用通信系统基础应用”章节的内容,选取适用于高速公路的7个车路协同预警系统,并设计部分生态车道,形成8个车路协同预警系统共13个事件的场景库,分别如下:长下坡预警A、生态车道B、浓雾预警C、前向碰撞预警D、异常车辆预警E、失控车辆预警F、紧急车辆预警G、拥堵预警H、施工区预警I、长隧道预警J、弯道预警K、隧道预警L及排队预警M。

为避免疲劳驾驶,将整段道路用服务区分割成22 km和24 km两段。图3所示为场景第1段(即22 km路段),其中C1-C3段为雾区试验路段,全长840 m,限速60 km/h。车路协同信息包含进入雾区前500 m预警(前方500 m浓雾,限速60 km/h)、进入雾区预警(进入雾区,请小心驾驶)、车速监测、盲区预警及超速预警。实验针对2个路段(路段1和2)及车路协同条件(有、无车路协同系统)共设计4种场景。

图3 实验场景路径概览(单位:m)

1.3 被试者选择

招募37名视力及听力状态良好的驾驶人,其中男性22人,女性15人,年龄分布在24~55周岁(平均年龄36.1,标准偏差11.7)。被试者均具有高速公路驾驶经验,平均驾龄12.5年。结合以往关于驾驶人视觉特性研究的实验[15,20],本次实验样本量满足要求。

1.4 实验步骤

被试者需进行2次实验,完成包含所有预警系统及事件在内的4个子实验场景的驾驶任务,每次完成2个子场景。实验主要过程如下。

①实验前 首先,被试者填写驾驶前问卷记录基础信息;其次,实验员对被试者进行实验前培训及测试,保证被试者正确理解HMI信息,并通过模拟器试驾使被试者熟悉模拟器操作;然后,向被试者宣读实验指导语,告知被试者在正式实验中需严格按照路侧限速标志行驶,确保自然驾驶状态。

②实验中 被试者正确佩戴眼动仪,在单次实验中完成2个子场景的实验,每个子场景的驾驶任务持续约20 min,每次驾驶任务至少间隔5 min。每次实验开始前均进行仪器标定及矫正。

③实验后 被试者填写驾驶后主观问卷以获取其主观认知感受和对场景的真实度评价。

1.5 数据预处理

首先,运用眼动仪自带数据分析软件SMI工具输出驾驶人场景视频以及对应的文本数据;其次,对照视频记录驾驶人行驶至雾区前500 m及驶出雾区的时间节点,并根据时间区间截取文本数据,输出原始数据及事件数据,包含驾驶员的注视、扫视、眨眼行为的坐标值、时间间隔等指标;然后,观测驾驶人的注视点分布范围及规律,按经验划分前方道路视觉区域;最后,提取驾驶人在全局范围及前方道路区域的注视时间、注视频率等指标。

2 驾驶人视觉特性的变化规律

2.1 驾驶人的视觉特性及指标提取

驾驶人的视觉特性表现为注视、扫视和眨眼。注视行为是指将眼睛对准对象的活动,注视持续时间指视轴中心位置保持不变的持续时间,通常在100~20 000 ms之间[21]。扫视行为产生于两次注视之间,通常指人眼对于交通环境中目标搜索的过程,或注视点的转移过程。结合以往研究可认为,驾驶人的注视与扫视行为是与信息加工处理有关的指标,眨眼特性是与视觉需求或工作负荷有关的指标,因此,文中主要考虑驾驶人的注视及扫视行为特性。

另外,驾驶人在行车过程中应尽量保证主要注意力集中于前方道路,因此根据经验将前方道路区域定义为兴趣区域(AOI)[22],定义包含前方路面、车内、车外环境等在内的整体行车环境为全局水平,分别提取驾驶人在兴趣区域及全局水平下的平均注视时间、平均注视频率、平均扫视时间及平均扫视速度。视觉特性指标的定义如表1所示。

表1 视觉特性指标汇总及描述

2.2 视觉特性指标分布及差异性分析

提取驾驶人的视觉特性指标值,将数据采集丢失严重的无效数据进行剔除,最后保留29位被试者的眼动特性指标。经过Shapiro-Wilk检验,指标数据服从正态分布。在指标差异性比较过程中,将超过箱身1.5倍长度的个例数据予以剔除,绘制HMI组与基准组两种实验条件下驾驶人视觉特性指标的对比图,见图4。

图4 视觉特性指标对比

如图4(a)所示,HMI组全局平均注视时间为319.43 ms,小于基准组的平均注视时间(355.45 ms),且后者的变异程度(标准差为93.14 ms)高于前者(标准差为70.42 ms)。AOI平均注视时间的变化与全局规律保持一致,均表现为基准组的平均注视时间更长,且变异水平更高。另外,无论是HMI组还是基准组,AOI平均注视时间均高于全局平均注视时间。

平均注视频率方面,就全局水平而言,基准组的平均注视频率(138.26次/min)低于HMI组(149.16次/min),且基准组的变异水平更高。在兴趣区域内的表现则相反,HMI组的平均注视频率(109.09次/min)低于基准组,基准组的变异水平同样表现得更高。综合上述结果可知,无论是否使用HMI,AOI平均注视频率均小于全局注视频率。与基准组相比,HMI组的全局平均注视频率增加,但AOI平均注视频率降低。

平均扫视时间方面,无论是全局还是兴趣区域,HMI组驾驶人的平均扫视持续时间(全局为66.42 ms,兴趣区域为64.41 ms)均大于基准组(全局为61.78 ms,兴趣区域为61.59 ms)。与全局平均扫视时间相比,兴趣区域内的平均扫视时间(HMI组为64.41ms,基准组为61.59 ms)小于全局水平(HMI组为66.42 ms,基准组为61.78 ms)。另外,基准组的平均扫视时间的变异水平高于HMI组。综合上述结果可知,驾驶人对前方道路的平均扫视时间小于全局的平均扫视时间,HMI组的驾驶人需要花费更长的扫视时间来完成信息的搜索。

平均扫视速度方面,全局水平下HMI组的平均扫视速度(97.34°/s)大于基准组(94.12°/s),在兴趣区域内也表现出同样的趋势。与前述视觉特性指标不同的是,HMI组驾驶人的平均扫视速度的变异水平更高。

从兴趣区域及全局水平综合考虑驾驶人的注视及扫视行为特性,驾驶人在常态下对于前方路面的平均注视时间高于全局平均注视时间,平均注视频率、平均扫视时间及平均扫视速度小于全局水平,表明驾驶人主要通过长时间地注视前方道路获取所需信息,对于其他车内外环境等的扫视行为更多;同时,HMI组驾驶人在兴趣区域及全局水平下均表现出均值更低、变异性更小的平均注视时间,而驾驶人的全局注视频率增加,但对前方路面的注视频率降低,这一定程度上影响了驾驶人对于前方道路的关注,同时信息提取相较于不使用车路协同系统的情况也更为容易;另外,无论是兴趣区域还是全局水平,HMI组驾驶人均表现出更长的扫视时间及更快的扫视速度,但平均扫视速度的变异程度更高。

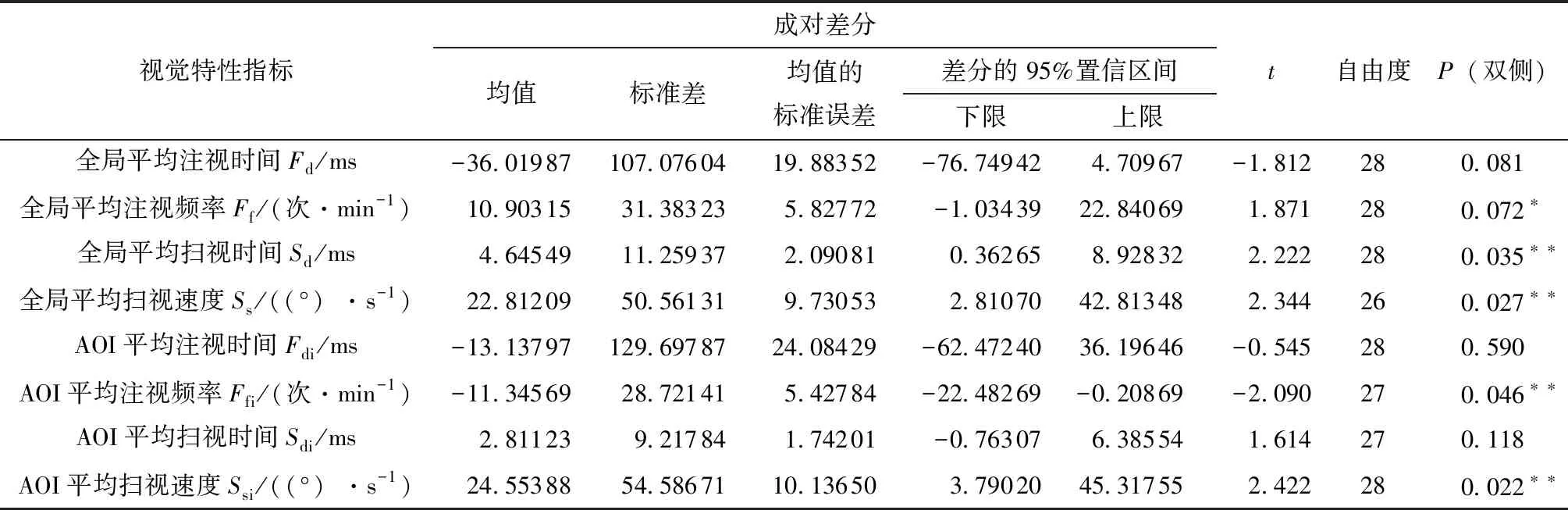

明确有无车路协同系统情况下驾驶人在兴趣区域及全局水平下的注视、扫视特性指标分布后,通过配对t检验比较HMI组和基准组显性眼动指标的差异,结果如表2所示。

表2 成对样本的t检验结果1)

从表2可以看出,全局平均扫视时间、全局平均扫视速度、AOI平均注视频率、AOI平均扫视速度存在显著差异。使用HMI的被试者的全局平均扫视时间为(66.42±8.21)ms,比基准组的(61.78±9.73)ms增加了4.66 ms,差异具有统计学意义,t(28)=2.222,P<0.05。HMI组被试者的全局平均扫视速度为(97.33±37.23)°/s,大于基准组的(74.53±37.90)°/s;AOI注视频率为(109.09±20.67)次/min,小于基准组的(120.43±25.32)次/min;AOI平均扫视速度为(94.12±43.22)°/s,大于基准组的(69.57±34.17)°/s;另外,当显著性水平降低时,全局平均注视频率的差异呈现边缘性显著差异。以上结果表明,在当前实验条件下,即雾天使用车路协同系统时,终端HMI会显著影响在前方路面及整个行车环境中的扫视行为,全局平均扫视时间增加,搜索行为更加快速,从而显著降低了驾驶人对于前方道路的注意分配。注意分配的结果与以往研究[11]得出的视觉信息的出现减少了驾驶员对道路中心区域的视觉关注的结论相一致。另外,研究表明车路协同系统的驾驶辅助信息介入使驾驶人在不同区域的扫视速度、扫视时长均发生了明显变化,其对于扫视行为的影响大于注视行为。

3 基于因子分析的驾驶人视觉信息加工模式

文中将驾驶人的视觉搜索表现(即视觉信息的获取、处理与加工过程)定义为视觉信息加工模式。本节将基于因子分析模型对注视时间、注视频率、扫视速度等显性指标进行关联融合处理,以刻画驾驶人的视觉信息加工模式,并探讨车路协同系统的信息给予对驾驶人视觉信息加工模式的影响。

运用Z-score对数据进行标准化转换。首先进行KMO(Kaiser-Meyer-Olkin)检验和Bartelett球型检验,一般认为KMO检验值大于0.5即可[23],实际KMO=0.656,说明上述数据适合作因子分析。根据悬崖碎玉图和总方差解释表,以特征值大于1为标准提取因子。因子经过方差最大法正交旋转可提取3个公因子,累积方差贡献率达88.982%。计算旋转成分矩阵如表3所示。

表3 旋转成分矩阵

由表3可知,公因子F1中全局平均注视时间(Fd)和AOI平均注视时间(Fdi)的荷载分别达到了0.935和0.963,而驾驶人的注视时间与信息提取密切相关,因此将公因子F1定义为信息提取因子。同时,平均注视时间越长,因子得分越高,表明驾驶人的信息提取效率越低。同理可得出,公因子F2中扫视时间(Sd、Sdi)为荷载较大的指标,扫视时间越长,表明驾驶人获取不同信息的时间间隔越大,说明驾驶人感知的信息密度降低,因此,将公因子F2定义为感知密度因子,驾驶人的信息搜索时间越长,因子得分越高,信息感知密度越低。公因子F3中全局水平及兴趣区域扫视速度(Ss、Ssi)为荷载较大的指标,因此将公因子F3定义为信息搜索因子,因子得分越高,表明信息搜索速度越快,信息搜索的效率越高。综上,将驾驶人的注视、扫视行为及不同指标提炼为信息提取因子F1、感知密度因子F2及信息搜索因子F3,以刻画驾驶人的视觉信息加工模式。

由Thompson回归法得到旋转成分矩阵如表3所示。表3中的负数是相对于平均水平而言,由数据处理的传递效应产生,不影响计算结果。计算得到3个公因子的得分函数分别如下:

F1=0.270Fd-0.298Ff+0.031Sd+…-0.044Ssi,

F2=-0.061Fd-0.044Ff+0.495Sd+…-0.131Ssi,

F3=-0.023Fd+0.093Ff-0.088Sd+…+0.578Ssi。

根据以上得分函数计算基准组及HMI组的信息加工因子得分,得到图5所示结果。图5表明:在雾天使用车路协同系统终端HMI的情况下,驾驶人的信息提取因子F1得分降低,由0.452±0.248降低至0.417±0.200,说明驾驶人使用车路协同系统花费的信息提取时间减少,信息提取效率增加;信息密度因子F2得分升高,由0.297±0.160提升至0.367±0.159,表明车路协同环境下驾驶人的信息感知密度降低;同时,信息搜索因子F3得分升高,由0.280±0.157提升至0.418±0.242,表明驾驶人使用车路协同系统表现出更快的信息搜索速度,信息搜索的效率提高。

图5 因子得分对比图

4 结语

为揭示车路协同系统信息介入对驾驶人视觉信息加工模式的影响,文中依托驾驶模拟实验测试平台搭建车路协同环境开展实验,获取雾天高速公路车路协同视听联合信息下驾驶人的视觉特性指标,分析驾驶人在全局水平及兴趣区域内的注视、扫视特征及差异性,并采用因子分析模型从信息提取因子、感知密度因子及信息搜索因子三方面刻画驾驶人的视觉信息加工模式,解析了雾天高速公路车路协同系统的应用对驾驶人视觉行为特性及信息加工模式的影响,主要结论如下:

1)驾驶人在常态下主要通过长时间地注视前方道路获取所需信息,对于其他车内环境等的扫视行为更多;而车路协同系统信息的介入,一定程度上影响了驾驶人对于前方道路的关注程度,对驾驶人的扫视行为影响更大;

2)车路协同系统的使用,给驾驶人的全局平均扫视时间、全局平均扫视速度、AOI平均注视频率、AOI平均扫视速度等指标带来了显著差异,表明车路协同辅助信息的介入显著影响了驾驶人对前方道路的注意分配,同时,驾驶人表现出时间更长、速度更快的搜索以适应信息分布的改变;

3)雾天高速公路车路协同信息系统的加入改变了原有信息的分布,驾驶人的信息提取更加容易,信息感知密度降低,信息搜索效率更高。

车路协同系统在提升安全性和效率的同时,也造成了驾驶人视觉认知资源的占用,这种正负影响的共存性在系统设计、测试及应用中需要被同时考虑,这对于最大程度地发挥车路协同技术的安全保障作用至关重要[24]。文中以驾驶任务相关的车路协同信息交互为控制变量,聚焦于驾驶人视觉认知加工过程的刻画及影响规律探索,区别于以往研究中对驾驶次任务(如微信、电话、车内娱乐系统等)的分心或负荷评估。另外,本研究主要采用注视、扫视等原始基本视觉行为指标,便于精细化地揭示驾驶人的视觉行为变化规律,并基于视觉指标的本质特性抽取驾驶人的视觉加工模式。当前研究证实了车路协同系统对于驾驶人信息感知加工模式及前方道路关注的影响是确实存在的,而这种改变的内在致因以及其是否会进一步影响驾驶安全,则需要结合驾驶人的操作及车辆运行状态进一步探讨。

文章仅以雾天高速自由流状态为实验条件,考虑视觉特性的场景敏感性,未来研究应继续探究车路协同系统在模拟驾驶及自然驾驶条件下不同天气、交通状态及交通事件时的应用前评估及对比分析,例如一般路况、拥堵及事故路况条件、交叉口环境等。同时,应综合考虑不同行车元素(如仪表盘、车载终端、后视镜等)的视觉资源需求与占用,探索影响驾驶人视觉信息加工改变的内在致因。另外,从视觉认知以及人机交互认知心理学的角度开展研究,探讨车路协同辅助信息的呈现方式及视觉、听觉信息的合理匹配,通过信息的合理选取、人机界面的简化设计、驾驶人培训等方案手段尽可能降低视觉干扰,使得车路协同系统在提高驾驶安全的同时,降低视觉资源及认知资源的占用,确保其综合安全性能和服务品质的提升。