一种用于答案选择的知识增强混合神经网络

2021-02-28李超凡陈羽中

李超凡,陈羽中

(福州大学 数学与计算机科学学院,福州 350116) (福建省网络计算与智能信息处理重点实验室,福州 350116)

1 引 言

答案选择是问答系统开发中的一项基本任务,它的目的是从几个候选答案中选择出正确的答案[1].在大多数情况下,答案选择任务被视为排序问题[2,3]或分类问题[4,5].目前针对答案选择问题已经进行了大量的研究工作,所提出的答案选择模型主要基于统计学习方法[2-11]和深度神经网络[12-36].

在深度学习兴起之前,传统的答案选择模型依赖于人工定义的规则来提取特征,比如从问答对中提取词汇特征、句法结构特征、n-gram特征等,获取特征后,使用统计学习算法或排序算法识别问题的匹配答案[6-11].该类模型在答案选择任务上取得了一定的进展,但其主要缺点在于依赖人工进行特征工程,耗时耗力.

近年来,深度神经网络模型在答案选择任务中受到了极大的关注,深度神经网络能够自动地从文本中提取上下文信息和语义信息,并将潜在信息编码为连续低维向量的表示形式,并且进行相关性排序,从而将人们从繁琐的特征工程中解脱出来.因此,深度神经网络已逐渐成为答案选择任务中的主流方法.卷积神经网络能够有效获取句子中的语义信息,因此,一些模型使用卷积神经网络[12-19]来对问题和候选答案之间的语义关联进行建模.但是,卷积神经网络无法充分地对句子中的上下文依赖关系进行建模,且卷积核窗口大小难以确定,可能造成语义信息的丢失.与卷积神经网络相比,循环神经网络(RNN,Recurrent Neural Network)在序列的上下文依赖关系建模方面具有优势[20-27],因此许多模型采用RNN,如长短期记忆网络[20]、门循环单元(GRU,Gate Recurrent Unit)[21]等对问题与答案的上下文相关性进行建模.然而,循环神经网络是有偏的,词序列中的后部词语往往会获得更高的关注,影响问题与答案间相似度特征的准确提取.因此,单一的卷积神经网络或循环神经网络,均难以全面准地提取问题与答案在语义信息、字符序列上下文关系方面的相似特征.

近年来,知识库作为外部资源在各类自然语言处理任务中获得了关注[34-36].知识库可以被用于识别问题和候选答案句子中出现的实体,来自知识库中的信息则可以作为文本表征的补充帮助生成问题和答案的细粒度语义表征.但是现有的知识增强神经网络模型通常采用简单的方式从问答对和知识库中共同学习语义表示,因此,现有的知识增强神经网络模型不能准确地利用问答对与知识实体之间的语义交互.并且没有充分考虑问题与答案的知识表征之间的相互影响,而这对于获取更精确的知识表征是至关重要的.

针对上述问题,本文提出一种基于知识增强的混合神经网络模型KE-HNN,主要贡献如下:

1)提出了一种结合多头注意机制的混合神经网络.该混合神经网络融合CNN和Bi-LSTM对问答句子中的语义信息和上下文信息进行建模.同时在特征提取过程中引入了多头注意力机制,使模型关注于问题和答案语句中的关键部分.

2)来自知识库中的信息是对于文本语义信息的重要补充.KE-HNN融合外部知识库,提出了一种文本指导注意力机制,获取与问答相关的知识表征信息;

3)提出了一种交互注意力机制,获取基于知识的问答表征交互信息,并通过对问答对的文本表征和知识表征进行联合建模,增强问答对的细粒度语义特征表征.

4)针对KE-HNN模型与基准模型,在Trec-QA数据集上进行了充分的实验与分析,实验结果表明KE-HNN取得了领先的性能.

2 相关工作

答案选择任务的目标是根据给定问题在多个候选答案中自动选择出最相关的答案,这在问答领域中发挥着重要的作用.

在深度学习网络流行之前,答案选择模型将答案选择视为分类或排序问题,并应用统计学习方法识别问题的匹配答案.Yao 等[6]引入了基于树编辑距离的新特征并且建立了线性链条件随机场来提取答案.Yin 等[7]结合来自各种语义模型的语义信息用于问题和答案的匹配.Filice等[8]采用排序特征、启发式特征等多种特征,进一步挖掘了问题和答案之间的语义相关性.上述模型在答案选择问题上取得了一定的进展,但高度依赖于人工进行特征工程,耗时耗力且缺乏适用性.

近年来,深度神经网络在包括答案选择在内的许多自然语言处理任务上取得了显著的成绩.在答案选择任务中,核心问题是利用深度神经网络从问答对中获取具有区别性的语义特征,从而为给定的问题选择最适合的答案.Yu 等[12]提出了一种基于CNN的答案选择模型,该模型利用CNN从问题和答案中提取语义信息,分别映射为低维分布式表征向量,并学习了一个语义匹配函数,进行问答对的语义匹配.Severyn 等[13]也提出了一种基于CNN的答案选择模型,该模型同时学习问答对的中间表征和最终表征,生成更精细的问答对语义表征,用于语义相似度匹配.Kalchbrenner 等[14]提出了用于答案选择的动态卷积神经网络(DCNN,Dynamic Convolutional Neural Network),为了精确呈现问题和答案句子中的语义信息,DCNN采用多层的宽卷积并且结合动态k-max池化操作来获取能够呈现句子中的短期和长期关系的特征表示,这不但保留了句子中的词序信息和词语之间的相对位置,而且能够动态地处理不同长度的问题答案句子.

与传统统计学习模型相比,基于卷积神经网络的答案选择模型有了显著的改进,但单一的卷积神经网络不能有效提取问答对中的上下文语义相关性信息,而这对于从答案序列中选择出最适合的答案是至关重要的.为了解决上述问题,一些模型将循环神经网络用于答案选择任务.吴少洪等[22]通过循环神经网络获取文本中不同粒度的语义表示,然后从问题和答案文本不同粒度的语义交互信息中提取它们的语义匹配信息,从而计算问题和答案的语义匹配度.Wang等[23]使用堆叠的双向长短期记忆网络从问答句中捕获前向和后向上下文信息.Tay等[24]利用全息组件扩展长短期记忆网络,建立了问答对特征表示之间语义关联的模型.陈柯锦等[25]利用双向长短期记忆网络提取问题和答案在各个尺度下的特征,并且使用3种不同的相似度矩阵学习模型从局部特征相似度得到问答整体相似度.

CNN和RNN虽然可以从问答序列中学习语义信息和上下文信息,但无法评估句子中不同词语对语义信息的重要性,限制了问答对的语义匹配精度的进一步提升.因此,一些模型引入了注意力机制[28-33].Tan等[28]考虑到问题与答案之间的交互作用,提出了一种单向的注意力机制,在给定的问题语境下生成嵌入答案.Wang等[29]提出了3种基于注意力的GRU神经网络模型,通过在模型中加入了注意力信息来影响GRU隐藏表示的计算.熊雪等[30]基于双向长短期记忆网络与词匹配方法对问题句与候选答案句进行特征提取,提出了一种基于层叠注意力机制的答案选择方法.

目前,大规模知识库已被广泛应用于包括答案选择任务在内的自然语言处理任务中.DasRajarshi等[34]对通用模式进行了扩展,将结构化知识库事实与句子对齐,并利用记忆网络学习文本和知识库组合中大量事实的最终表示.Shen等[35]设计了一种文本指导的注意力卷积神经网络来帮助获取知识库中实体的精确表示,并且将知识嵌入到句子表示中用于增强问答对的特征表示.

3 模 型

3.1 模型架构

KE-HNN模型的总体架构如图1所示.模型由输入嵌入层、特征学习层、融合层、输出层组成.其中特征学习层包括两个模块:文本表征学习模块和知识表征学习模块.首先,输入嵌入层将输入的问题、答案以及从知识库中抽取的实体信息转换为低维表征向量.特征学习层中的文本表征学习模块使用带有多头注意力机制的混合神经网络获取问题和答案中的语义信息;知识表征学习模块则从知识库中学习问题和答案的背景知识,得到知识表征以增强问题和答案的文本表征,从而得到问题和答案的细粒度语义特征表示.融合层则融合特征学习层的输出与外部语义特征,得到用于答案选择的最终特征表示.最后,输出层利用softmax函数预测给定问题的答案标签概率分布.

图1 KE-HNN模型架构

3.2 输入嵌入层

问题和答案的关键词之间的相关性有利于进行问题-答案匹配.因此我们通过计算问题和答案之间的相关性得分并通过连接的方式来增强它们的初始词表示.相关性得分是通过对问题和答案句子的初始词表示上进行乘法操作,然后在该结果的列方向上执行最大池化操作得到的,如以下公式所示:

(1)

(2)

(3)

(4)

(5)

(6)

3.3 文本表征学习模块

3.3.1 卷积神经网络

为了获取问题答案中语义匹配的部分,在问题句子和答案句子的初始词表示上使用两个独立的CNN网络来获取多个特征映射.每一个特征映射都是一个具有固定窗口大小的卷积过滤器的输出,通过使用不同窗口大小的多个卷积过滤器来生成多个特征映射.然后将多个特征映射相连接分别形成问题和答案的表示,如下所示:

(7)

(8)

3.3.2 双向长短期记忆

LSTM能够学习序列的长期依赖关系,一个典型的LSTM细胞包含3个神经门:输入门it,遗忘门ft和一个输出门ot.输入门决定有多少输入向量的信息将被存储在记忆细胞中,输出门决定在下一个时间步骤中允许使用多少记忆信息.遗忘门控制着前一个时间状态ht-1中应该遗忘多少信息.给定一个输入句子s=(w1,w2,…,wl),位置t的隐藏向量计算如下:

(9)

(10)

(11)

(12)

ct=ft⊙ct-1+it⊙gt

(13)

ht=ot⊙tanh(ct)

(14)

(15)

(16)

3.3.3 多头注意力

通过给句子中的每个词分配不同的权重,注意机制可以有效地捕捉上下文词的重要性.多头注意力是一种可以并行执行多个注意力函数的注意力机制[33].每一个注意力函数可以将查询向量Q和输入序列K=[k1,k2,…,kN]映射到输出向量.对于每一个注意力函数,其输出向量的计算公式计算如下:

(17)

(18)

其中f是一个可以获取输入序列K中每个部分ki对Q重要性的对齐函数,如下所示:

f(ki,Q)=Wmftanh([ki;Q])+bmf

(19)

其中Wmf和bmf分别是可学习的权值矩阵和偏移值,tanh是非线性激活函数,[;]表示向量连接操作.将所有注意力函数的输出进行加权连接得到多头注意力机制的输出向量,表示如下:

c=MHA(k,Q)=[c1;…;ch;…;cn_head]Wh

(20)

ch=Attentionh(k,Q)

(21)

其中Wh是可训练的参数,n_head是并行的注意力函数的数量,c是多头注意力机制的输出,ch是第h个注意力函数的输出,h∈[1,n_head].

句子的语义信息主要由句子的关键词来表示,因此问题和答案的关键词在它们之间的语义匹配中起着重要的作用.为了进一步挖掘句子中词语之间的依赖关系,分别在Bi-LSTM输出的问题表征和答案表征上应用多头注意力机制,得到如下问题表征和答案表征:

(22)

(23)

3.4 知识表征学习模块

3.4.1 文本指导注意力卷积神经网络

知识库中的信息可以作为增强问题和答案表示的重要背景知识.然而,问题和答案中的候选实体在不同的语境语义可能不同,可能导致歧义.例如,spring这个词可以指泉水也可以是一个季节.因此,为了更好地增强问答的表征,需要在文本信息的引导下获得候选实体的准确表示.KE-HNN采用文本指导注意力机制[35]来准确挖掘句子表示和知识表征之间的关联,从而生成更精确的问答知识表征.问题q的文本指导知识表征可以计算如下:

(24)

(25)

其中Wm∈Rda,We∈Rde×da,Wh∈Rdh×da是注意力训练参数,da是注意力参数大小,α是一个包含有文本指导注意力权值的向量并且qkb是问题q原来的知识表征经过加权后的表示.同样可以得到答案a的经过文本指导的知识表征,如下所示:

(26)

(27)

由于CNN具有收集n-gram结构信息的优势.最后qkb和akb被分别输入到CNN中来学习抽象化的问答知识表征.

(28)

(29)

3.4.2 交互注意力

(30)

(31)

(32)

其中Ms∈Rdc×dc是能够获取问题与答案句子表示中相似性信息的相关性矩阵,并且Uq,Ua∈Rdc×dc是学习到的注意力权值矩阵,dc是卷积神经网络的卷积核大小.

3.4.3 知识增强表示

在得到文本表征和知识表征后,通过连接的方式将知识表征和文本表征进行聚合得到知识增强的问题表示和回答表示:

(33)

(34)

3.5 融合层

除使用知识增强的问题和答案表示来进行问题-答案匹配之外,我们还增加了几个特征来充分利用问题和答案之间的语义匹配部分,我们利用诸如可用于衡量问题和答案之间相似性的二元相似性得分[15,16]和统计问题和答案句子(包含和不包含停用词)中共现词数量的词重叠特征[24]作为补充的附加特性,通过将它们与知识增强的问题和答案表示进行连接得到最终的问题-答案匹配向量.

of=concat(qr,ar,add_feature)

(35)

3.6 输出层

本文中答案选择任务被当作是一个二元分类问题.聚合层的输出通过一个全连接的层,并使用softmax函数来生成一个类标签上的概率分布:

p(yi)=softmax(relu(Wjof+bj))

(36)

其中Wj和bj是可训练的参数,p是预测为类别i的概率分布.

3.7 模型训练

模型训练的目标是最小化损失函数,损失函数采用具有L2正则化项的交叉熵损失函数,计算公式如下:

(37)

4 实 验

4.1 数据集和评估指标

本文选择使用Trec-QA数据集[8]的两个版本(TRAIN-ALL,TRAIN)对KE-HNN模型进行评估,Trec-QA数据集包含一系列事实性问题并且将答案限制在一个句子内.TRAIN-ALL中每个答案的正确性都是通过正则表达式自动判断的,而TRAIN中的答案是人工判断和标注的.Trec-QA数据集的统计信息如表1所示.我们采用MRR(Mean Reciprocal Rank)和MAP(Mean Average Precision)作为实验结果的评估指标,定义如下:

表1 Trec-QA数据集信息

(38)

(39)

这里N是问题的数目,ranki是第i个问题第1个正确答案在答案列表中的排列位置,这里值得注意的是当第1个正确答案没有出现在第i个问题的答案列表中时,ranki将会被设置为0.mi是对于第i个问题正确答案的数目,ranki,j是对于第i个问题的第j个正确答案的排列位置.

4.2 实验设置

在数据预处理方面,数据集中文本的所有字符均为小写,不删除停用词、符号和数字.选择数据集中文本的最大长度作为输入长度,当文本长度小于输入长度时用0填充,词向量使用预训练的300维Glove词向量,对于未在词向量表中的词通过在正态分布N(0,0.05)中采样进行词向量初始化.Bi-LSTM网络的隐藏单元维度设置为300,对于文本表征和知识表征的CNN网络卷积核大小分别为350和300,窗口大小均为[3,5],多头注意力机制中并行注意力函数的数量n_head设为8,L2正则化项系数设为0.01.

实验包含以下部分:

1)在Trec-QA数据集上对模型KE-HNN和其他最新的基于深度神经网络的模型在答案选择任务上的性能进行比较,以验证KE-HNN的性能.

2)对模型KE-HNN进行消融实验,研究模型的不同组件对模型性能的影响.

3)分析基于文本表征学习模块中每个卷积滤波器所采用的特征映射的数量对KE-HNN模型性能的影响.

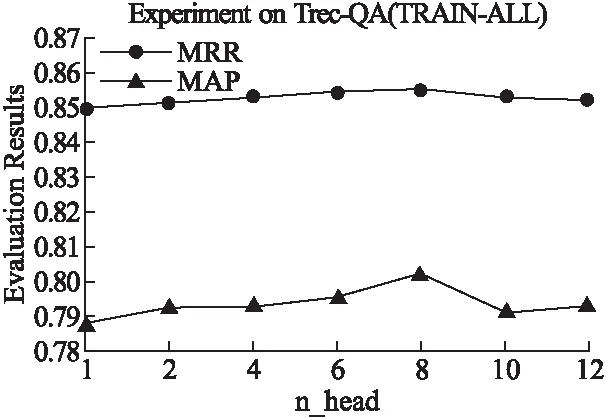

4)分析多头注意力机制中并行注意力函数的数量n_head对KE-HNN模型性能的影响.

4.3 基准模型

实验中所选择的基准模型如下:

1)CNN1[12]:该模型利用二元图上的一维卷积神经网络学习问题和答案的特征向量,利用语义匹配函数并且集成了两个附加的单词匹配特征评估问题-答案对的语义相关性.

2)CNN2[13]:该模型使用两个CNN分别学习问题和答案的中间表示,然后模型将它们与相似度评分以及丰富的外部特征连接起来,生成最终的问题-答案匹配表示.

3)QA-LSTM[26]:采用双向长短期记忆(Bi-LSTM)模型和注意机制来学习问题-答案对的特征表征,然后利用相似度函数来对它们的语义相关性进行评估.

4)HD-LSTM[24]:该模型扩展了全息合成的长短期记忆网络,建立了问答对特征表示之间的语义关联模型.

5)IAGRU[29]:该模型在计算RNN隐藏表示之前添加了注意力信息以获得更好的问答对特征表示.

6)CTRN[27]:该模型利用时间门来同步、联合地学习问答对之间的交互,以学习它们的细粒度表示.

7)HCAN[17]:该模型使用了一个混合编码器,其中包括基于CNN和基于LSTM的编码器,以及每个编码器层的协调注意力机制,以学习基于上下文的多粒度问题和答案表示.

8)KABLSTM[35]:该模型设计了一个文本指导的注意力卷积神经网络,通过将知识嵌入到句子表示中来丰富问题-答案对的特征表示.

4.4 实验结果分析

为了分析KE-HNN与其他基准模型相比是否具有优越性,表2列出了KE-HNN模型和其他基准模型在两个Trec-QA数据集上的实验结果.从表2可以发现,在Trec-QA(TRAIN-ALL)上KE-HNN模型MRR和MAP分别达到85.5%和80.2%.在TRAIN上,MRR和MAR的值分别为84.9%和79.2%,均取得了最佳的性能,表明KE-HNN模型的性能优于其他基准模型.

表2 KE-HNN与基准模型的性能对比

首先讨论各模型在Trec-QA(TRAIN-ALL)数据集上的表现,在所有基准模型中,CNN1的性能表现最差,起MRR和MAP分别为78.4%和71.1%.KABLSTM的性能表现最佳,其 MRR和MAP分别为84.4%和79.2%.KE-HNN模型的MRR和MAP则分别为85.5%和80.2%,分别比比KABLSTM提高1.1%和1%.与CNN1相比,CNN2同样使用一维卷积神经网络来学习问题和答案的语义表示,但CNN2引入了一些额外的语义特征,如词重叠特征、相似度评分等,这些特征有助于建立问题与答案之间的语义相关性,因此CNN2的性能表现略优于CNN1.

在基准模型中,发现基于LSTM的模型的性能总体上优于基于CNN的模型的性能,表明LSTM能够比CNN更有效地对问题和回答中潜在上下文语义信息进行建模.从实验结果还可以发现,与仅使用RNN或CNN的基准模型如CNN1、CNN2以及HD-LSTM相比,HCAN获得了更好的性能表现,这是由于HCAN结合了基于CNN和基于LSTM的编码器在对句子语义信息和句子的语义信息以及上下文相关性信息建模的优势,而句子语义信息和句子的上下文相关性信息对于构建用于问答匹配的细粒度特征表示是至关重要的.此外,KABLSTM的性能显著优于其他基准模型.我们认为这是由于KABLSTM将知识库作为外部信息源,将知识表征集成到句子表示中,进一步增强了问答匹配的特征表示,KABLSTM的性能表现也证明知识库是弥补问题和答案之间语义鸿沟的重要补充.

接下来讨论各模型在Trec-QA(TRAIN)上的性能表现.在各基准模型中,IAGRU和CTRN分别取得了最佳的MRR和MAP,分别为83.2%和75.9%.作为比较,本文提出的KE-HNN模型MRR和MAP的值分别为84.9%和79.2%,分别提高了1.7%和3.8%.值得注意的是,与CNN1、CNN2以及HD-LSTM相比,IAGRU模型由于将注意力机制和深度神经网络相结合,将问题的上下文表示以注意力的方式引入到答案表征的学习过程中,能够专注于问题与答案中富含相关语义信息的部分,这对于揭示问题和答案之间的语义相关性是至关重要的.CTRN模型在学习问答对的表示过程中引入了时间门的思想,以成对的方式对问题和答案对进行联合学习.该方法通过在问题和答案之间交叉应用时间门,使得问题和答案能够在相互交互地学习句子的语义信息,有助于获取回答对之间的语义匹配关系.

从以上实验结果可以看出,本文提出的KE-HNN模型获得了优于所有基准模型的性能表现.将其归因于KE-HNN引入了混合神经网络、知识表征和上下文感知混合注意机制,从而能够有效地学习问题和答案的细粒度语义相关性特征.首先KE-HNN模型采用由CNN和Bi-LSTM组成的混合神经网络来获得句子的初始语义表示,与单个CNN或RNN相比,混合神经网络能够更好地学习句子的语义和上下文信息.KE-HNN模型还引入知识库作为问题和答案的背景知识,同时学习问答的知识表征和句子表征,并且进一步利用相关性得分来增强问题和答案的初始语义表示.此外,KE-HNN模型还通过多头注意力机制聚焦于学习问答对中包含丰富相关语义信息部分.因此,KE-HNN模型可以利用基于上下文和背景知识的语义相关性,构建更丰富、更具区分性以及更细粒度的用于问答匹配的特征表示,从而能够更准确地定位问题的正确答案.

4.5 KE-HNN模型分析

本节通过Trec-QA数据集上的实验,比较KE-HNN与其消融模型的性能表现,分析KE-HNN中的各个模块对其整体性能的影响.KE-HNN的消融模型包括KE-HNN w/o MHA,KE-HNN w/o KB,KE-HNN w/o Relevance-score和KE-HNN w/o KB-Attention.KE-HNN w/o MHA 从KE-HNN中移除多头注意力机制,将经过混合神经网络的问题和答案表征作为最终的特征表示.KE-HNN w/o KB从KE-HNN中移除知识表征模块,仅依靠学习来自问题和答案自身语句的文本表征来确定两者之间的语义相关性.KE-HNN w/o Relevance score则未使用相关性得分来增强问题和答案的文本表征.KE-HNN w/o KB-Attention则移除知识表征学习模块中的文本指导注意力机制和交互注意力机制,只使用从输入嵌入层获得的问题和答案的初始知识表征,而不考虑两者的知识表征之间的交互以及问题和答案的文本表征对知识表征的影响.

实验结果如表3所示,可以看出各模块对KE-HNN模型的总体性均有积极的影响.从表3可以发现,与KE-HNN相比,KE-HNN w/o Relevance-score在Trec-QA(TRAIN-ALL)数据集上的MRR和MAP分别下降了3.8%和4.2%,在Trec-QA(TRAIN)数据集上则分别下降了3.0%和2.8%.上述结果表明相关性得分是反映问题与答案之间的语义相关性的一个重要特征,同时也表明输入嵌入层输出的初始表征的质量对最终输出的问答对语义匹配特征有着显著的影响.与KE-HNN相比,KE-HNN w/o MHA在Trec-QA(TRAIN-ALL)数据集上的 MRR和MAP的值分别下降了3.4%和4.1%,在Trec-QA(TRAIN)数据集上则分别下降了1.6%和2.9%.性能的显著下降表明利用多头注意力机制获取问题和答案的语句中的关键词语义信息对于获取问答对语义匹配特征同样有着至关重要的影响.与KE-HNN相比,KE-HNN w/o KB在Trec-QA(TRAIN-ALL)数据集上的MRR和MAP分别下降了1.8%和2.1%,在Trec-QA(TRAIN)数据集上则分别下降了1.3%和0.9%.上述结果证明了引入知识表征能够很大程度上弥合问题和答案之间存在的语义鸿沟.与KE-HNN相比,KE-HNN w/o KB-Attention在Trec-QA(TRAIN-ALL)数据集上的MRR和MAP分别下降了1.3%和1.2%,在Trec-QA(TRAIN)数据集上则分别下降了0.9%和1.3%.上述性能下降表明未考虑问答句知识表征之间的交互以及文本指导信息的缺乏,将使得模型无法精确获取知识库中与问题和答案的语义信息密切相关的重要信息.

表3 KE-HNN及其消融模型的性能对比

4.6 参数分析

KE-HNN模型的文本表征学习模块利用融合CNN和Bi-LSTM的混合神经网络来获得问题和答案的语义表示,其中CNN的每个卷积核的特征映射的数量是影响KE-HNN性能的重要参数.图2、图3分别给出了文本表征模块中的CNN采用不同特征映射数量时KE-HNN在Trec-QA(TRAIN-ALL)和Trec-QA(TRAIN)数据集上的性能变化情况.特征映射数量取值范围为[100,500],间隔为50.从图2可以发现,随着特征映射数量的增加,KE-HNN的MAP和MRR逐步提高,当特征映射数量为350时,KE-HNN获得最优的MAP和MRR.但是,KE-HNN的性能并不随着特征映射数量的增加而单调递增,当特征映射的数量从350增加到500时,KE-HNN的性能会逐步下降.上述实验结果表明,当特征映射数量过小时,文本表征向量无法充分反映问题和答案中蕴含的语义信息,因此需要增加特征映射的数量来避免语义信息的丢失.但是,特征映射数量过大将显著增加模型的复杂性,容易导致模型的过度拟合,引起性能下降.此外,从图2与图3可以发现,特征映射数量变化所导致的KE-HNN的性能波动范围较小,表明KE-HNN模型对特征映射数量的变化较不敏感,具有较好的健壮性.

图2 特征映射数量对KE-HNN在Trec-QA(TRAIN-ALL)数据集上性能的影响

图3 特征映射数量对KE-HNN在Trec-QA(TRAIN)数据集上性能的影响

KE-HNN模型的文本表征学习模块利用多头注意力来融合句子的不同部分的语义信息,多头注意力机制的输出通过对n_head个注意力函数的输出进行加权拼接得到.因此,注意力函数的数量n_head是影响KE-HNN性能的重要参数之一.图4、图5分别给出了文本表征模块中的多头注意力机制采用不同数量的注意力函数时KE-HNN在Trec-QA(TRAIN-ALL)和Trec-QA(TRAIN)数据集上的性能变化情况.n_head的取值范围[1,12].从图4与图5可以发现,n_head为1时,KE-HNN的性能表现最差.这是由于当n_head为1时,多头注意力机制退化为单注意力机制,而单注意力机制无法为上下文中高度相关的词语准确地分配注意力权重,导致语义匹配信息的丢失.随着n_head的增加,KE-HNN的MAP和MRR逐步提高.当n_head为8时,KE-HNN获得最优的MRR和MAP.上述性能提升表明多头注意力机制在提取上下文中高度相关的词语方面具有优势,这对构造问题和回答的细粒度语义表征是十分重要的.但是,KE-HNN性能并不随n_head增加而单调递增,当n_head超过8后,KE-HNN的性能会逐步下降.原因在于引入过多的注意力函数将引入大量的训练参数,增加模型的复杂度,使训练变得困难,导致模型过拟合.

图4 n_head对KE-HNN在Trec-QA(TRAIN-ALL)数据集上性能的影响

图5 n_head对KE-HNN在Trec-QA(TRAIN)数据集上性能的影响

5 结 论

本文提出了一种结合多头注意机制的混合神经网络模型KE-HNN.为了充分利用问答句子中的语义信息和上下文信息,KE-HNN采用由CNN和Bi-LSTM融合成的混合神经网络对输入句子进行建模,此外使用多头注意力机制在特征提取过程中关注问答句子中富含信息、具有高度相关性的关键部分,并减少噪声词的干扰.此外,KE-HNN融合来自外部知识库中的信息,提出了一种文本指导注意力机制,获取与问答相关的知识表征信息.针对KE-HNN模型与对比模型,在Trec-QA数据集上进行了充分的实验与分析,实验结果表明KE-HNN取得了领先的性能.

在未来的工作中,由于图神经网络可以利用句子的语法结构来更好地获取文本中潜在的语义特征,我们将尝试在答案选择任务中引入图神经网络,此外我们还将尝试多任务的学习模式通过将回答选择任务和其他问答任务相结合共同学习来进一步提高KE-HNN的性能.