数据中心气流组织研究综述

2021-02-21张学伟盖东兴

叶 萌,张学伟,盖东兴

(1.武汉工程大学 光电信息与能源工程学院,湖北 武汉 430205;2.广东申菱环境系统股份有限公司,广东 佛山 528000)

1 引言

随着国家新基建的提出,数据中心作为其中唯一的基础设施建设得到了迅速的发展,数据中心是一个企业向数据化、智能化发展的基础。另外,随着5G技术的发展,数据中心的数量和规模也大大增加。由于数据中心是储存,处理和传递各种数据信息的中枢,对数据中心的可靠性和安全性提出很高要求,通常需要全年365 d的不间断运行。

典型数据中心能耗构成如图1所示,精密空调系统是除IT设备所必须耗能外数据中心最大的能源消耗系统,它们占数据中心总能耗的32%,具有很大的节能潜力,而空调系统则由制冷量过大和气流损失等原因消耗大量能源[1]。数据中心制冷设备的运行状态取决于IT设备的运行环境要求,包括房间的温度和湿度,随着新时代数据机房的变化,相应的机房空调也会有更加合理的设计[2]。机房空调气流组织的好坏决定着服务器运行的效率,因此合理的气流组织是精密空调设计的重要组成分,低温空气在机房流动的过程中,需要时刻保持一个合适热湿环境[3]。

图1 典型数据中心能耗构成

2 数据中心风冷技术研究介绍

2.1 风冷的主要工作原理

目前市面上大部分都是使用风冷模式对数据中心降温,精密空调出风口保持恒温恒湿的冷却气流。数据中心中主要产生热量的部位是机柜服务器中的CPU,内存条和硬盘等,冷却气流从服务器的入口进入,经过对流换热后的气流温度随服务器硬件设备温度升高而升高,高温气体从服务器的出口流出,最后又回流到精密空调中进行降温,开始下一轮循环。

2.2 数据机房气流组织的配置方式

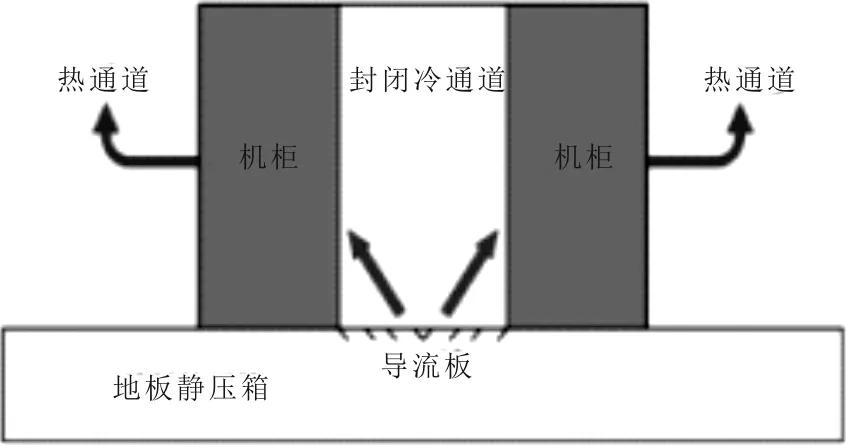

下送风(地板孔送风)(图2):主要由静压箱,精密空调和地板格栅构成,其主要原理是将机房放置在静压地板之上,每个机柜的入口对应着下面的地板格栅,机柜使用面对面,背对背方式布置,同时封闭冷通道。精密空调的出风口放置在静压地板下,回风口在地板上部分,精密空调出风口的冷却气流通过静压箱从地板格栅吹出来从服务器的入口进入,对发热单元进行散热,温度升高后的气流从机柜背面出来,在机房中回流再次进入到精密空调中。

图2 下送风方式

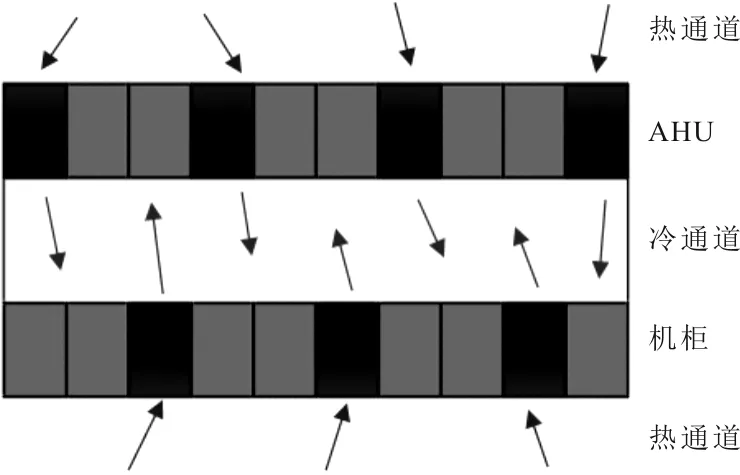

侧间送风(图3):精密空调与机柜处在同一个机房之中,机柜和机柜面对面排列,背面朝向背面,热通道关闭,精密空调出风口的冷气流对机房全局进行降温,低温气流从服务器入口进入,带走发热单元产生的热量,低温空气变为高温空气从背面出来,热气流再热通道内由于密度变小会向上流动,同时热通道上面设置回风口将高温气流带走送回到精密空调中去降温,进行下一次循环。

图3 侧间送风

列间送风(图4):将列间空调与机柜并排放在一起,空调使用和侧间送风同种方式排列,将对列的排机柜中穿插若干个精密空调,可以采用斜对排布,也可以采用正对排布,低温气流流出后以最短的距离对服务器发热单元进行降温,降低了气流在传递的过程中热量变化程度,高温气流从服务器背部出来通过列间空调上面的回风管道再次回到精密空调中降温,进行下一次循环。

图4 列间送风

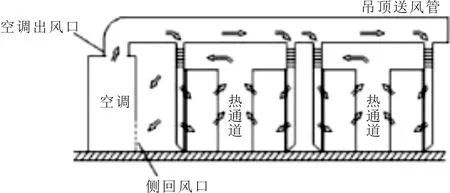

风管送风(上送风)(图5):低温气流从精密空调上方出来,经过送风管道到达机柜服务器给发热单元降温,升温后的高温空气从地板下面进入到空调同样安装在下部分的回风口,进行再降温处理。

图5 上送风方式

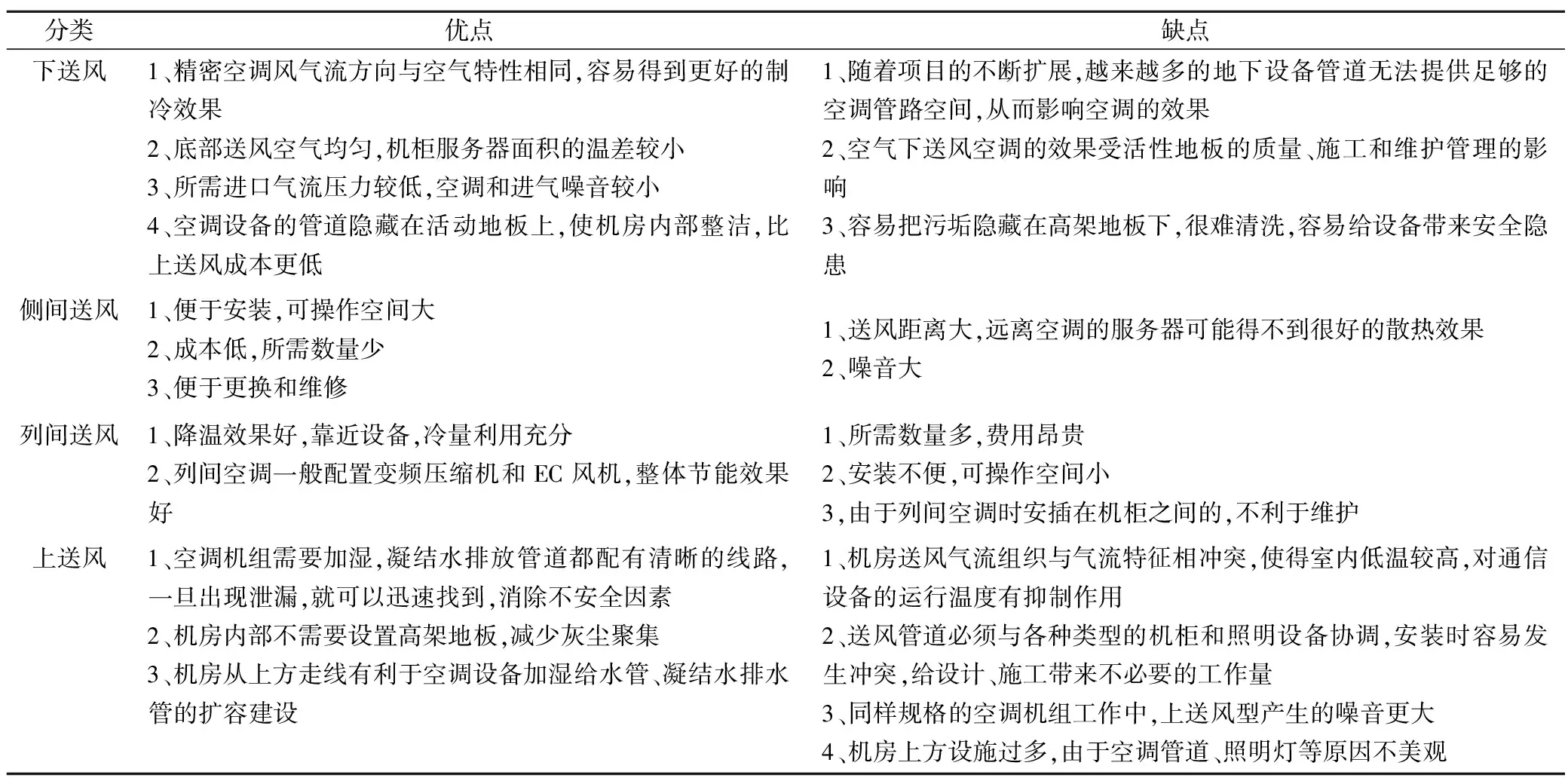

以上4种数据中心送风方式优缺点详见表1。

表1 各种送风方式对比

3 气流组织的优化方案

在国内外,目前精密空调的设计、制造和运行都有一套完整的规格标准,可以对机房的温度、湿度和洁净度有一个非常精确的控制,精密送风温度下不同的气流组织也得到了广泛的研究。

陈文辉[4]使用了一种特别定制的冷墙侧面送风,这种侧面送风气流分布需要封闭热通道,使用DeST软件对其进行分析,以计算空调的月能耗,使用这种盖板气流组织方式所产生的精密空调的年电耗为224.9万kW·h。此种配置方式与风管送风方式248.6万kW·h的空调耗电量相比,全年节约9.6%的空调电耗。黄渤[5]使用高架地板下方的正压送风系统,静压层高度为600 mm,穿孔楼板速度为20%。使用挡板隔离地板下方正压送风系统的静压层,创建两个独立的空气分配室,设置2号挡板在一列机柜的1/4处,5号挡板在一列机柜的1/2处,并都设置有无开孔、20%、80%开孔率。对模型进行了仿真研究和分析,通过数值模拟最后得到了结果:这种新型的带有局部挡板的地板下送风结构被证明对改善数据中心的气流组织和热性能是有效的。封闭挡板结构位于2号挡板处,能彻底消除热点;当带有穿孔率 20% 穿孔挡板结构位于2号挡板处时,气流最均匀。耿云[6]改变地板下挡板角度大小产生的气流组织对机房热环境的影响,为保证服务器有一个良好的冷却状况,在机房静压层内安装有利障碍物,使用airpak建立相关模型进行模拟仿真,通过气流组织结构的温度场和速度场的分析表明,在高架地板下方搭建15°的挡板,静压层高度为700 mm,地板穿孔率为20%时出现最佳的冷却效果,此时服务器内热环境的品质最佳。马欣宇[7]提出了一种梯形静压箱对气流组织的优化,目的主要是消除压力分布不均匀对气流组织产生的不利影响,考虑将地板静压箱的流通面积沿冷通道方向逐渐减小,截面变为梯形,利用CFD模拟探究梯形静压箱对气流组织的优化效果,得到了最佳的静压箱结构参数,综合分析原尺寸14 m×0.7 m的矩形静压箱,修改其界面为梯形,使其下底长度为0.7 m,上底长度变为0.2 m,这样静压箱的内部压力分布情况有了较大改善。局部涡旋基本消失,对气流组织优化效果最佳。

申佳惠[8]研究了不同服务器的配置方案对气流组织的优化和对发热单元的影响,提出了放置在机架底部服务器产生的热量最终都会汇集到机架顶部服务器之中,高温空气的聚集会严重影响服务器余热的排出。于是建立4种不同的服务器功率密度模型,模型分析发现,当服务器在机架中的放置密度发生变化时,热性能逐渐变化,其中从下到上密度逐渐减少的排列方式热性能最好。服务器进出口温度达到了安全运行的标准,优化方法具有深刻意义。秦冰月[9]采用模拟了封闭冷通道前后机房的气流组织变化,通过数种热环境评价指标分析了模拟结果,获得了冷却气流集中、冷热气体掺混现象改善,局部热点消除等研究进展。黄翔[10]利用6sigmaRoom对机房气流组织和热湿环境进行模拟,使用残差控制求解方程收敛的精度,同时确保求解残差趋于稳定且收敛为1[11~13]。分析了机房内不同高度典型截面的温度分布,结果表明当架空地板高度在600 mm时,空调的无效送风量大大减小。根据业内统计,高热密度数据机房单个机柜能耗水平已经达到了5 kW[14],Shrivastava[15]等人2005年在“下送上回式”气流系统中进行的研究结果使得气流分布更为高效,而在“上送下回式”气流分布最差。Cho Kim[16]等人研究了当采用安装简单挡板(simple partition wall)的方式改善冷热气流的混合情况下的效果。对于一个主要由极高密度的数据通信设备,这意味着冷却系统应该对其寿命和负荷进行全面的考量,以便在10年内使负载增长两倍,或每3-5年增长约50%[26]。逢书帆[17]进行优化的机房空调为150 kW的CRAC,共有机柜240个,总功耗为896 kW,将机房原来高架地板高度0.6 m改为0.8 m,格栅开孔率由50%改为40%,优化后机柜的整体温降1.9 ℃。张振国[18]进行优化的数据中心位于北京市,带有24台机柜,单台最大电功率4 kW,两台单台额定制冷量为80kw恒温恒湿专用空调,风速<3 m/s,封闭冷通道后,空调风量为额定状态的50%,测量后发现回风温度由30 ℃提高到了33 ℃,进一步降低了PUE。文献[19~23]简化了机房空调模型,出风口的流量设置为定压定量,回风口为自由溢流口,大多数没有设置单个对象,而是直接在墙的边界上开有送风口和排气口,此模型适用于单个机房的模拟,如果多台空调机组同时开启,各回风口外的风压不等,如果采用自由溢流的排风口,则各台空调机的回风量势必会不等;但实际上专用于单个机房的空调的进口风量和回风量总是相同的。李俊[25]等研究发现大型数据机房冷冻水供回水温度采取12 ℃/18 ℃时,可以使用的自然冷却时间大大增加,有利于机房的节能效果。王小元[27]等使用CO2作为余热回收用热泵的工作介质,提高系统紧凑性与环境友好性,与常规房间级风冷空调机组相比,CO2热泵系统可降低全年冷负荷108 MW·h,节约电耗制冷电耗167 MW·h,为建筑供热290 MW·h,获得年收益4.23万元。朱立伟[28]进行模拟的机房规模为9台机柜,每台18个服务器,空调额定风量为45000 m3/h,进口风速为2.31 m/s,18 台服务器表面热流量为10 kW,通过数值计算得到2个冷通道地板风速为1.93 m/s,冷通道温度均值为24.5 ℃,与设备换热后的热通道温度均值为37.2 ℃,两者绝热隔离,均值达到12.7 K的温差,是绝佳的散热模式。冷通道或机柜进风区域的温度推荐值为18~27 ℃,冷通道或机柜入口温度允许值为15~32 ℃;湿度变为露点温度,同时相对湿度不大于60%采用露点温度可以使测量更加准确[29,30]。S.A.Nada[31,32]通过数值模拟实验,研究地板格栅开孔率大小、不同单机柜功率对数据机房的影响,结果表明,地板格栅开孔率为20%~50%范围内时,增加格栅开孔率可减少热空气回流,而封闭冷气流通道使得中间机架比两边冷却能效高约20%。

4 其他几种数据机房冷却方式及优劣

目前,根据不同的数据机房需要的散热能力可以使用不同的气流组织形式,降低将数据中心能耗,对于有一些特殊的数据机房,需要非常低PUE值,单一方式很难将数据中心能耗继续降低,需要采取多种散热方式的组合。针对这个问题,提出另外两种可以降低数据中心能耗的冷却方式,其一是自然冷却与风冷冷却相结合,主要原理是将自然冷风直接或者间接引入到数据中心,带走服务器中产生的热量,当环境温度较低时,使用自然冷却对数据中心进行降温,当环境温度较高时,同时使用自然冷却和风冷冷却进行降温,缓解单方面使用风冷冷却时产生的巨大电耗。缺点是自然冷却对环境空气温度、湿度和洁净度要求较高,不能有难以清理的灰尘进入到电子设备中,否则会造成严重后果。目前使用自然冷却方式的数据中心所选地址大部分在贵州等地;其二是液冷,主要原理是用无相变且绝缘的液体对服务器中的CPU、内存条、硬盘等降温,可以直接接触也可以间接接触,因为溶液的导热性能比空气导热性要好得多,所以在相同工况下液冷的降温效果要优于风冷的降温效果。节能效果更好。缺点是数据机房内管道设计必须有严格的防漏措施,在防漏方面具有较大的挑战性。

5 结论

在对数据中心进行强制风冷冷却的几种方式当中,四种送风方式各有优劣,但还是以地板下送风、上回风为主,送风过程中要尽量考虑温度、速度、湿度和压力等各方面因素对数据中心热性能的影响,尤其是在压力方面需要进一步研究,在下送风中随着送风距离的增加冷空气速度降低,静压增大,在一定范围内冷量逐渐增大,所以在靠近出风口的机柜的温度比中部的机柜温度要高。目前为止,数据中心还是以风冷为主要冷却方式,但是未来随着5G基站建设的增加,对于如何降低数据中心的PUE将是一个巨大的难题,国家需要加快除风冷冷却以外其他冷却方式的发展步伐。目前不仅是要在对数据中心进行节能的同时要充分保证维护、运行、安全等问题,还要尽量发挥数据中心降低能耗方面最大的应用价值。