上海地区实现超低能耗数据中心的技术路线研究与探讨

2020-12-24郑竺凌上海建科建筑节能技术股份有限公司上海200032

郑竺凌(上海建科建筑节能技术股份有限公司,上海 200032)

上海市在《上海市推进新一代信息基础设施建设 助力提升城市能级和核心竞争力三年行动计划(2018—2020 年)》中明确提出,建设网络强国、数字中国、智慧社会,加快构建技术多样、主体多元、模式创新的新一代信息基础设施供给格局,打造“连接、枢纽、计算、感知”四大支柱体系,支撑经济发展并服务社会民生。随着上海国际经济、金融、贸易、航运、科技创新“五个中心”建设的逐步推进,预计未来 10 年内,上海将建设累计超过 10 万个机架的大型数据中心。

数据中心内部安装了大量计算机以及配套的环境控制系统和输配电系统,用能强度很高。经对上海地区 2 个典型互联网数据中心的能耗统计,其用电强度平均达到 2 000 kWh/(m2·a),是普通公共建筑的约 20 倍,接近居住建筑的 70 倍。预计 10 万个机架的大型数据中心的能耗增量在 200 万 tce 左右。

本文从技术角度对上海地区实现超低能耗数据中心的技术路线进行了分析。

1 上海地区数据中心能耗现状

1.1 样本的选取

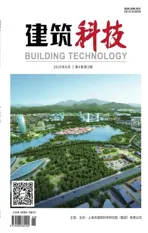

首先在上海地区选取 20 个数据中心进行了调研、现场踏勘、测试及数据分析。根据调研的信息,筛选去掉了机架数不多的及资料不全的 8 个数据中心,留下 12 个设计机架数超过 1 000 个的数据中心。这 12 个数据中心的设计机架数为 1 179~3 280 个,如图 1 所示,与当前主流数据中心的规模或主流数据中心的单个模块的规模吻合。

图1 各数据中心的设计机架数

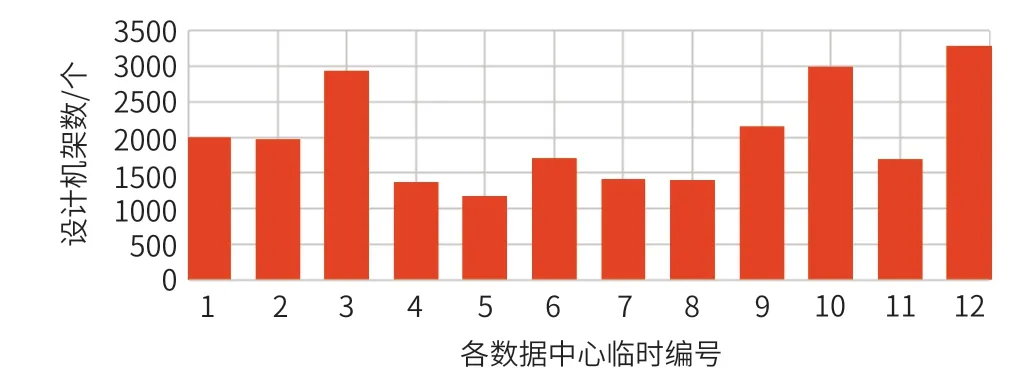

根据各数据中心所提供的数据,通过现场测试、数据校核等方式,对样本数据中心的实际电源使用效率(Power Usage Eあectiveness,PUE)进行了计算、校核。计算的参考依据为 GB/T 32910.3—2016《数据中心资源利用第 3 部分:电能能效要求和测量方法》。计算校核得到各数据中心的年 PUE 值为 1.40~2.93,如图 2 所示。其中,大部分处于 1.50~2.20 的范围内。有 1 个数据中心 PUE<1.50,1 个数据中心 PUE 在 2.20~2.50 之间,1 个数据中心 PUE 在 2.50~3.00 之间。

图2 各数据中心的年 PUE 值

图 2 中有 2 个点偏离较大。对 PUE 在 2.50~3.00 之间的数据中心进行现场踏勘和分析发现其 PUE 高的原因在于 3 个方面:① 数据中心的使用率过低,其使用率低于20%;② 其数据中心空调冷站兼顾办公园区的冷量供应;③其数据中心设计了 3 套冷却系统,较为庞大和复杂。对 PUE 在 2.00~2.50 之间的数据中心进行现场踏勘和分析发现其 PUE 高的原因在于 2 个方面:① 内部大量机房中有数量较多的运营商传输类特殊机房;② 数据中心空调冷站兼顾大楼内较多办公场所的冷量供应。

踏勘结果表明,这两个数据中心的情况较为特殊,不汇总研究。在去掉这两个较为特殊的数据中心后,余下 10 个数据中心设定编号为 1~10 号,作为本课题研究的样本。

1.2 能耗现状数据分析

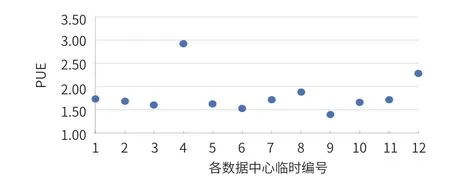

以各样本的使用机架数除以设计机架数得到图 3 的各样本机架使用率,除 9 号数据中心未提供相关数据外,其他 9 个数据中心的机架使用率大多数在 80% 以上,有 1个为 69%,1 个为 79%。

图3 各样本的机架使用率

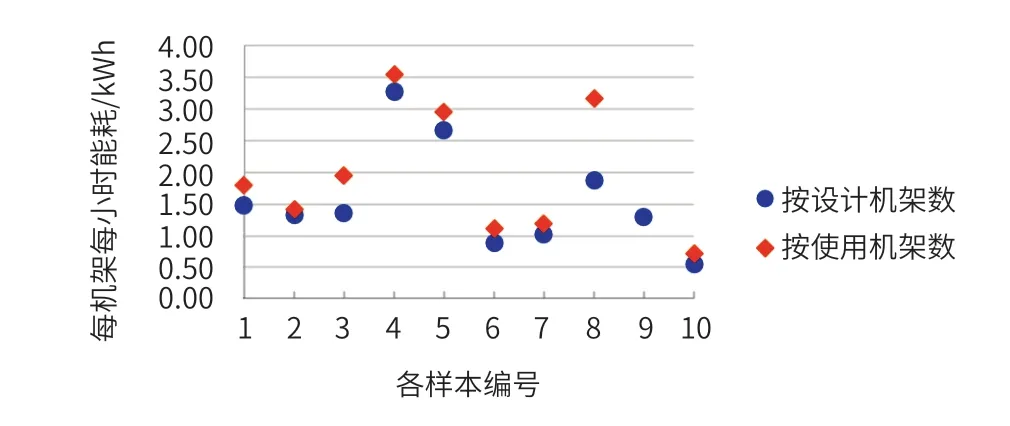

根据测试、校核后的数据,对样本数据中心的每个机架的运行功率进行分析。由于无法获取大量实时的每个机架的运行功率,考虑到数据中心运行相对稳定,以单个样本的年总 IT 设备能耗除以机架数并计算到每个小时能耗的方式来替代每个机架的运行功率进行分析。

图 4 为各样本的平均每机架每小时能耗。按分母的不同分为按设计机架数计算的数值和按使用机架数计算的数值两组数据。其中,9 号样本未提供使用机架数数据。从图 4 可见,各数据中心的单机架运行功率分布较散。从按使用机架数这组数据来看,1 kWh 以下有 1 个数据中心,在 1 ~2 kWh 区间有 5 个数据中心,在 3 kWh 以上也有 3 个数据中心。

图4 各样本的平均每机架每小时能耗值

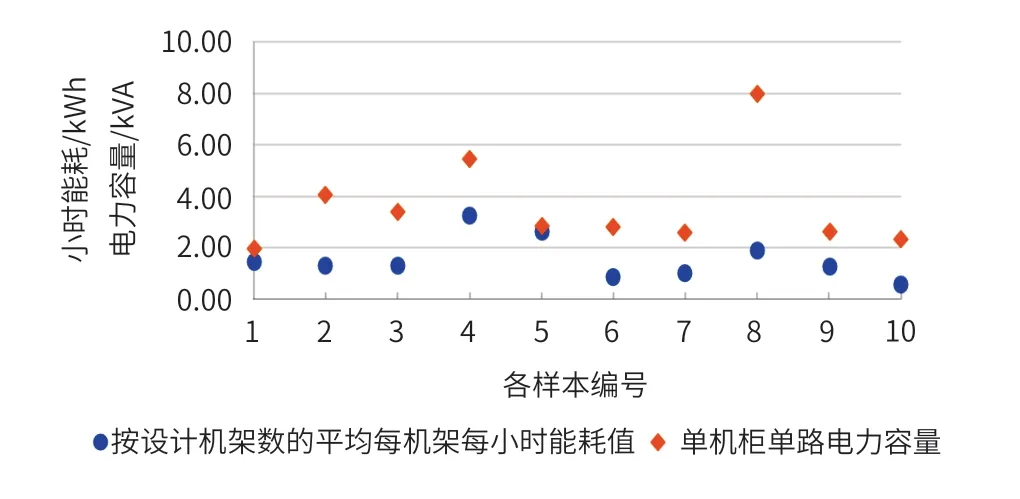

进一步分析数据中心设计与运行的能耗差异。将设计时的单路电力容量值除以设计机架数,可得到设计时平均每个机架的电力容量值,即单机柜单电路电力容量。将此数据与平均每机架每小时能耗值进行简单比较,如图 5 所示。

图5 各样本的单柜小时能耗与电力容量的比较

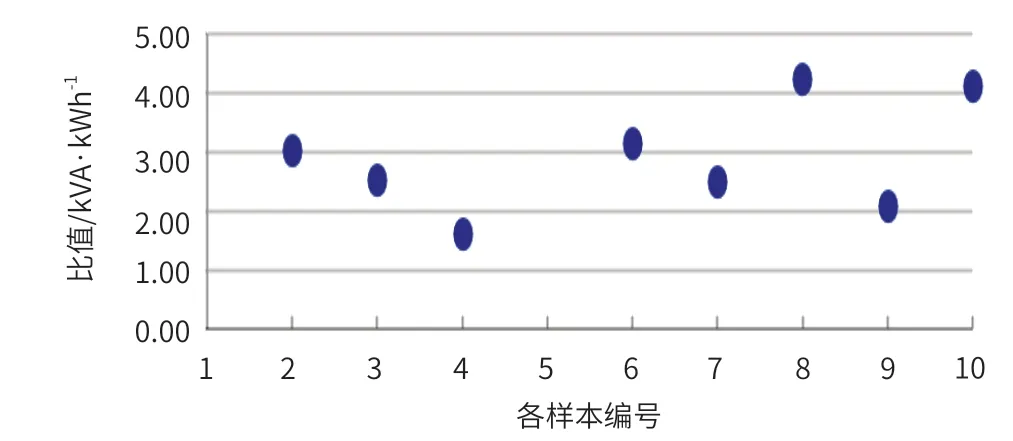

从图 5 中可见,5 号样本所提供的两个数据过于接近,不予采信。1 号样本的两个数据差值也较小,虽有一定可能性,也不纳入后续分析。将图 5 的电力容量除以每小时能耗值后得到的结果如图 6。从图 6 可见,这个系数的值基本都在 2 以上。但有 2 个样本在 4 以上。若此数值为 4,则各变压器的余量较大,实际运行中的负载率可能仅为 17% 左右。

图6 单机柜的设计电力容量值除以按设计机架数每小时能耗的比值

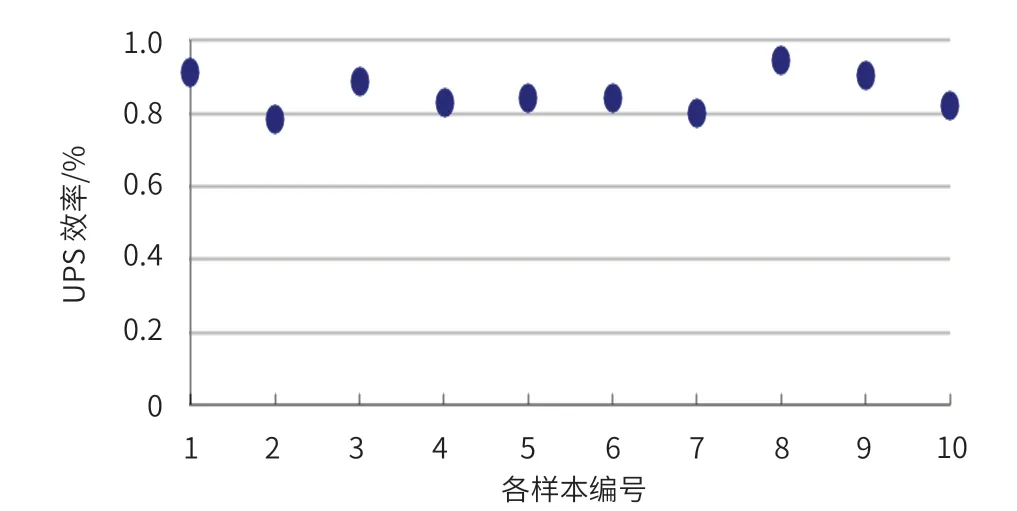

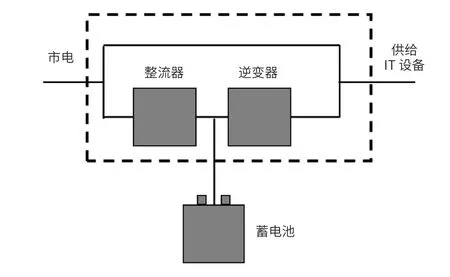

通过现场测试和数据校核,得到各样本的不间断电源系统(Uninterruptible Power Supply System,UPS)的效率如图 7 所示。由图 7 可见,有较多样本的 UPS 效率为 80.0%~90.0%。相对于当前 96.0% 以上的 UPS 系统而言,样本 UPS 效率过低,电能损耗较大。外供的交流电通过不间断电源系统的整流器转换为直流电,再通过逆变器转换为交流电供给给 IT 设备,而 IT 设备的电源再将交流电通过整流器等转变为自用的直流电供给给内部部件。整流、逆变、整流 3 个过程的损耗较大。

图7 各样本的 UPS 效率

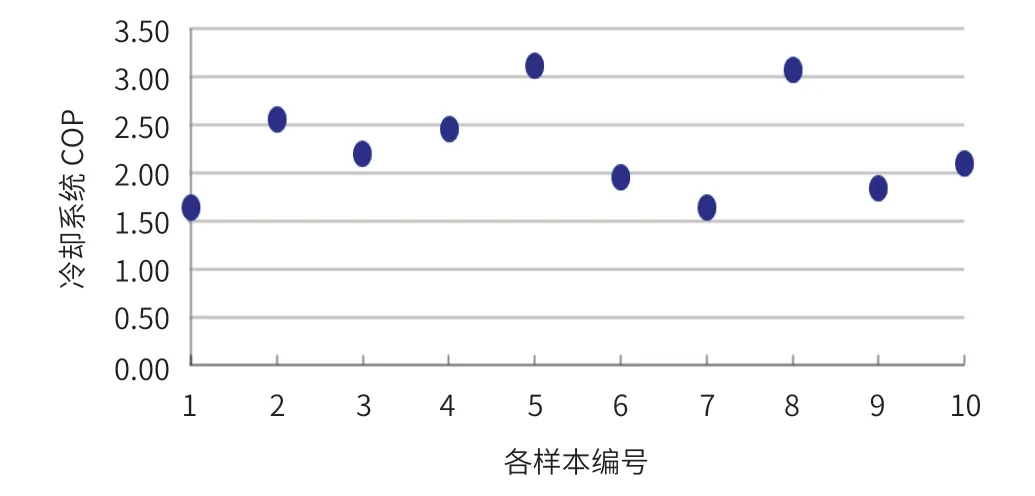

以 IT 设备全年能耗除以冷却系统全年能耗作为冷却系统全年效率值 COP,得到结果如图 8 所示。各样本的 COP 值较为集中在 1.50~2.50 范围,但相对于常规空调系统 3.50 左右的 COP 值,其数值偏低。分析常规空调系统和数据中心冷却系统差异可知:数据中心由于冬季也需要供冷,在此时室外温度较低,制冷效率较高;由于数据中心的单位建筑面积发热量大,供冷量密度远大于常规空调系统,因此输配系统损耗较高。

图8 各样本的冷却系统全年效率值(COP)

2 上海地区数据中心实现超低能耗的路径分析

根据上节的分析,上海地区要实现超低能耗数据中心,要通过以下几个方面进行实现。

(1) 如何提高供配电系统的负载率,从而提升其能效。

(2) 如何降低不间断电源系统中的交直流转换。

(3) 如何提高室外冷源的利用。

(4) 如何降低输配电能耗。

通过研究,提出了以下 4 条解决路径。

2.1 高负载的供配电系统

供配电系统中,电能损耗分两个部分:固定损耗和可变损耗。其中固定损耗是指在输出电能变化时其变化不大的损耗,例如变压器的铁损、UPS 的蓄电池浮充损耗等。可变损耗是指随着输出电能的增大而增大的损耗,例如变压器的铜损。

固定损耗可通过提升技术、用高质量电缆、用高效变压器等方式解决,而且大多数数据中心选用的设备性能均较好。根据样本数据,较多样本的电能负载率较低。在此条件下,可变损耗的总量并没增加,甚至略微下降。但可变损耗在总电耗中的占比大幅度增加。

通过数据中心模块化设计可实现数据中心内部部分区域的高负载运行,提高该区域的供配电能效。通过采用模块化不间断电源系统,也可利用设备内部运行调整,实现投入运行的不间断电源系统的高负载率,从而提高效率。

2.2 少变换的不间断电源系统

不间断电源系统由于需要保障 IT 设备的供电,往往采用在线式运行,因此,需要“整流-逆变-整流”的 3 个过程。从对这 3 个过程的分析即可知,若能去掉一个“整流”及一个“逆变”过程,可满足供电需求且减少耗能过程实现节能。

若去掉前面两个过程,则可采用市电旁通的不间断电源系统。外供电直接跳过整流器和逆变器供给 IT 设备,可大幅度提高供电效率,如图 9 所示。但此技术存在一个风险点,即当外市电断电时,如何在最短时间恢复蓄电池向 IT 设备供电。华为公司在一次课题组交流时给出了一个可大幅度缩短恢复供电时间的锁相技术,使得此技术路线可行。

图9 市电旁通的不间断电源系统示意图

若去掉后面两个过程,则可采用高压直流的不间断电源系统。外供电通过整流器转为高压直流电,直接供给 IT 设备。这时,若市电停电,由于蓄电池一直在线,可不间断地向 IT 设备供给高压直流电。此项技术的应用,则需要 IT 设备内部电源采用高压直流电源,但受数据中心客户的影响较多。

2.3 小“火积”损的换热过程

江亿院士在论坛报告中指出:数据中心的 IT 设备冷却过程,是一个从芯片向室外传热的过程。在这个过程中,IT 设备的芯片温度为 50~60℃,而上海地区室外温度为 -4~37℃,是一个热量向外传递的冷却过程。而根据清华大学李震教授在论坛报告中提出的观点:热量自然向外传递的能量是其自身的“火积”,热量的传递会产生“火积”损耗。若能降低换热过程中的“火积”损耗,则可减少冷却系统输入的能量。

为减少“火积”损耗,需要降低传热时的温差。在传统冷却系统的设计方案下,芯片温度达到 60℃ 时,IT 设备出风温度往往在 40℃ 以下,而专用空调回风温度仅为 23~25 ℃,冷冻水回水温度为 12~18℃。此时,冷冻水回水温度往往低于室外干球温度、湿球温度,因此需要利用压缩机提升至 40℃,再通过 34℃ 左右的冷却水至冷却塔散热。与此同时,冷机制取 7~13℃ 的冷冻水,供给至专用空调后,以12~21℃ 的冷风送入机房,再混合形成 22~25℃ 的冷风进入 IT 设备。在此过程中,“火积”损耗较为严重。

若要减少“火积”损耗,可采用芯片冷却的方式减少芯片至冷冻水的温差,或采用背板冷却、列间冷却等方式减少IT 设备出风口至冷冻水的温差。最终目标是完全利用芯片与室外的 20~50 K 的温差,以热量的自然传热大幅度减少外供能源。

2.4 大温差的运行模式

减少传热的“火积”损耗,从冷却系统设计而言,就是要尽可能实现进出 IT 设备的风温差、进出专用空调的风温差、进出专用空调的冷冻水温差、进出冷机或板换的冷却水温差尽可能一致,或仅有不大的差值。

增大了温差,在同等冷量条件下,降低了送风量、循环水量,可减少风机能耗和水泵能耗。增大了温差,使得冷冻水回水温度较高,在大部分时间段内超过上海地区室外湿球温度,可直接利用低温冷却水散热从而减少甚至避免需要冷机传递热量,降低冷机能耗。

3 结 语

数据中心是上海地区大力发展的一类特殊的建筑,其能耗强度大、总量高。通过对上海地区机架数超过 1 000 个的 10 个现有数据中心的调研、测试和分析可知,当前数据中心机架使用率尚可,大部分在 80% 以上;运行 PUE 为 1.50~2.00;平均的每机架每小时能耗分布较散,数值在0.50~3.50 kWh 之间;各数据中心的电力冗余依然较大;UPS 效率为 80.0%~90.0% 居多;大部分冷却系统 COP 为 1.50~3.00 。通过对现有情况的分析,提出了采用高负载的供配电系统、少变换的不间断电源系统、小“火积”损的换热过程、大温差的运行模式这 4 个设计及运行建议。采用这 4 个技术路线,是实现上海地区超低能耗数据中心的重要途径。