基于改进全卷积神经网络的红外与可见光图像融合方法

2020-08-19冯玉芳卢厚清

冯玉芳,殷 宏,卢厚清,程 恺,曹 林,刘 满

(1.陆军工程大学 研究生院,南京 210007; 2.中国人民解放军71375部队,哈尔滨 150038)

0 概述

图像融合是指对同一目标的两幅或多幅图像中互补信息进行分析与提取,生成一幅能准确描述场景信息的合成图像。图像融合对于图像识别及理解具有重要意义,被广泛应用于遥感、医学、计算机视觉、目标检测与识别等领域[1]。红外图像是根据辐射差区分目标与背景的辐射图像,但是其不能反映真实场景信息。可见光图像是包含多个高频分量的反射图像,其能在一定光照条件下展现场景细节,然而在夜间低光照度、浓雾、浓烟等光线较差的环境下,可见光图像很难捕捉到场景中全部有用信息。将红外与可见光图像进行融合,可有效提取红外图像中目标区域信息与可见光图像中细节信息,得到目标与背景清晰的新图像[2],从而有利于准确检测目标。

在过去几十年中,红外与可见光图像融合方法成为研究者们关注的热点[3]。目前,在红外与可见光图像融合领域应用最广泛的是金字塔[4]、小波[5]、非下采样轮廓波[6]和边缘保持滤波器[7]等基于多尺度变换的图像融合方法。这些方法将源图像分解为一系列多方向、多尺度的子图像,利用特定融合规则对相应的子图像进行融合,从而得到重构的目标图像。但是多尺度变换方法受方向数限制,不能有效检测图像的方向特征。为了解决这一问题,研究者们将非下采样剪切波变换(Non-Subsampled Shearlet Transform,NSST)用于图像融合[8]。由于剪切波具有强大的数学结构,能够获取不同方向和尺度特征[9-10],在非下采样过程中,其可以保持良好的方向性和平移不变性,因此基于非下采样剪切波变换的图像融合方法能更多地保留图像细节信息,得到更好融合效果[11]。

融合图像权重映射图获取是图像融合的关键。在传统基于多尺度分解的融合方法中,该问题可通过活动水平测量和权重分配来解决。然而噪声等因素的存在使得活动水平测量和权重分配鲁棒性较差。针对该问题,研究者们提出更复杂的分解方法和更精细的权重分配策略,并取得良好融合效果,但是这种方法和策略不易设计,而且会增加计算复杂度。为了获得更有效的融合方法,压缩感知[12]、稀疏表示[13]、神经网络[14]、模糊理论[15]等技术被应用于图像融合,提高了图像融合质量。

近年来,随着深度学习的兴起,基于深度学习的图像融合技术研究逐渐增多。文献[16]提出一种基于卷积稀疏表示(Convolutional Sparse Representation,CSR)的红外与可见光图像融合方法,利用CSR提取细节层的多层特征,然后将其融合得到新图像,该方法较基于稀疏表示的融合方法鲁棒性更强。文献[17]提出一种基于卷积神经网络(Convolutional Neural Network,CNN)的红外与可见光图像融合方法,使用CNN学习图像的多层特征,将图像融合中活动水平测量和权重分配两个关键问题作为整体来完成,克服了传统融合方法中融合框架设计复杂的问题。文献[18]提出一种基于深度学习的红外与可见光图像融合方法,采用视觉几何群(Visual Geometry Group,VGG)网络提取细节层的多层特征,然后将其进行融合得到新图像。然而上述方法只将网络最后一层的计算结果进行融合,丢失了网络浅层许多特征信息,不能很好地保留图像细节信息。

针对目前图像融合技术难以获得高质量图像的问题,利用非下采样剪切波变换将源图像分解为低频子带和高频子带,使用区域能量和融合策略对低频子带进行融合,通过改进的全卷积神经网络模型提取多尺度特征,同时采用最大加权平均算法对高频子带进行融合。在此基础上,对融合后的高频子带和低频子带进行NSST逆变换得到融合图像。

1 NSST图像分解

剪切波是小波的一种特殊形式,具有较好的方向灵敏度[19]。当维数n=2时,剪切波变换定义为:

MAS(Ψ)={Ψj,l,k(x)=|detA|j/2Ψ(SlAjx-k);

(1)

其中,Ψj,l,k为剪切波原子,Ψ∈L2(R2),j、l和k分别为尺度、方向和移位参数,A和S均为2×2的逆矩阵,且det|S|=1。

(2)

矩阵A和S在红外与可见光图像分解过程中起到重要作用。矩阵A控制剪切尺度,矩阵S控制剪切方向。

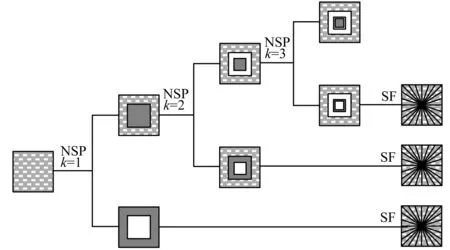

NSST图像分解包括多尺度分解和多方向分解。在采用非下采样金字塔变换(NSP)实现图像多尺度分解过程中,图像经过k级尺度分解后,得到k+1个与源图像大小相等的子图像,其中有m个高频子带图像和1个低频子带图像。在多方向分解过程中,采用剪切滤波器(SF)实现图像多方向分解。NSST图像分解过程如图1所示。

图1 NSST图像分解过程Fig.1 Image decomposition process of NSST

2 本文图像融合方法

2.1 设计思路

本文提出的图像融合框架如图2所示,图像融合的具体步骤为:

图2 图像融合框架Fig.2 Image fusion framework

1)利用NSST对红外与可见光源图像进行多尺度和多方向分解,得到低频子带系数和高频子带系数。其中,多尺度分解是为了使不同尺度空间上重叠特征充分分离。

2)对于低频子带系数,采用区域能量和融合策略进行融合。

3)对于高频子带系数,利用FCN提取细节层的多层特征,得到特征映射图,然后选择最大加权平均融合策略对其进行融合。

4)进行NSST逆变换得到融合图像。

2.2 FCN模型构建与训练

2.2.1 模型构建

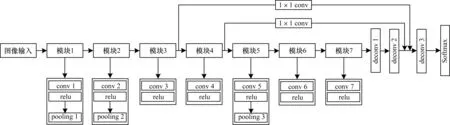

网络结构对卷积神经网络的功能发挥起着重要作用,本文在文献[20-21]研究的基础上,提出一种新的FCN模型,该模型包括卷积(conv)层、relu层、池化(pooling)层和反卷积(deconv)层,其结构如图3所示。FCN模型的特征提取部分共有7个模块,在每个卷积层中,交替使用非线性映射提取特征,采用relu作为激活函数加速模型训练过程,在模块1、模块2和模块5中,池化层位于relu层之后。在FCN浅层网络中提取图像的颜色、边缘和纹理等基础特征对融合图像质量至关重要,然而随着网络层的加深,这些特征很容易丢失。针对该问题,将2个1×1卷积的跳转连接添加到FCN模型中,在保留浅层网络图像特征的同时,避免增加计算复杂度。在模块7后增加3个反卷积层对所学到的所有特征进行上采样,以对所有多尺度特征进行融合,然后使用Softmax函数计算输出块的概率分布。

图3 FCN模型结构Fig.3 FCN model structure

由图3可以看出,FCN模型特征提取部分包括7个卷积层和3个池化层,为了增强输入图像特征的平移不变性,设置所有卷积层大小为3×3,步长(stride)为1,池化层大小为2×2,步长为2。由于本文将图像融合看作是分类问题,因此设置反卷积层的核数为2。根据输入图像大小和反卷积层的上采样功能,设置前2个反卷积层大小为4×4,步长为2,第3个反卷积层大小为16×16,步长为8。卷积层和反卷积层具体参数设置如表1和表2所示。其中,横杠表示该参数值不存在。

表1 卷积层和池化层的参数设置Table 1 Parameter settings of convolution layers and pooling layers

表2 反卷积层的参数设置Table 2 Parameter settings of deconvolution layers

2.2.2 模型训练

在训练阶段,本文FCN模型在深度学习框架tensorflow上,利用随机梯度下降法对整个网络进行训练。将所有偏置值初始化为0,学习率初始化为0.001,批量大小设置为128,动量和权重衰减分别为0.9和0.000 5[20]。权重更新规则表示为:

(3)

与其他用于图像融合的卷积神经网络相比,本文FCN模型能保留图像的颜色、纹理等浅层特征,并将这些浅层特征与深层特征进行融合,充分利用不同细节层的多尺度特征,以提高图像融合质量。由于在网络结构中增加2个1×1卷积的跳转连接,因此大幅降低计算复杂度,提高了融合算法速度。

2.3 图像融合

设A和B分别表示同一场景下大小为m×n的红外与可见光源图像。源图像A和B均被NSST分解为低频子带和高频子带,并分别进行融合。高频子带融合是对FCN提取到的特征权重图进行融合,采用最大加权平均融合规则。低频子带融合采用区域能量和融合规则。对融合后的高频子带融合图像和低频子带融合图像进行NSST逆变换,得到最终的融合图像。

2.3.1 低频图像融合

低频子带包含源图像大部分能量,保留了源图像大部分特征,虽然通过绝对值取大法和加权平均法能实现低频子带融合,但是上述方法本身局限性影响到融合图像的效果。绝对值取大法是通过比较红外与可见光图像在相同像素点上变换系数绝对值的大小,选取绝对值较大的变换系数作为图像在该像素点上系数值。由于该方法只考虑了像素点变换系数绝对值大小,未考虑其他影响因素,因此会导致重要信息丢失和融合图像边缘不平滑。加权平均法是将可见光和红外图像的变换系数通过相应权重比例整合到融合图像中。该方法虽然能有效提高融合图像边缘平滑度,但是会导致图像局部区域特征丢失,造成融合图像对比度较差。

区域能量和算法能结合相邻区域信息,对区域中心元素能量大小进行评估,最终选择能量较大的元素。由于利用区域能量和算法对低频子带进行融合,可使其包含源图像绝大部分能量,并在融合图像中保留源图像的基本信息,因此基于低频子带包含图像绝大部分能量的特性,本文采用区域能量和融合策略对低频子带进行融合。区域能量值计算公式如下:

(4)

其中,I=A或B,α、β分别为邻域窗口的长和宽,α×β为(i,j)的邻域系数。

利用区域能量大小判断融合系数活动水平,能量越大表示保留信息越多。融合系数计算公式如下:

(5)

2.3.2 高频图像融合

高频子图像主要包含图像边缘特征和纹理细节信息,这些信息直接影响融合图像分辨率和清晰度,因此,高频子带融合规则的选择对融合图像质量影响较大。本文将红外与可见光图像高频子带输入训练好的FCN模型中提取图像深度特征,并生成高频子带特征映射图,通过最大加权平均融合策略得到高频子带权重图,计算公式为:

Fsub(i,j)=max(α1subA+α2subB)

(6)

其中,subA、subB分别表示输入的红外与可见光图像的高频子图像,α1、α2分别表示subA、subB的权重值。

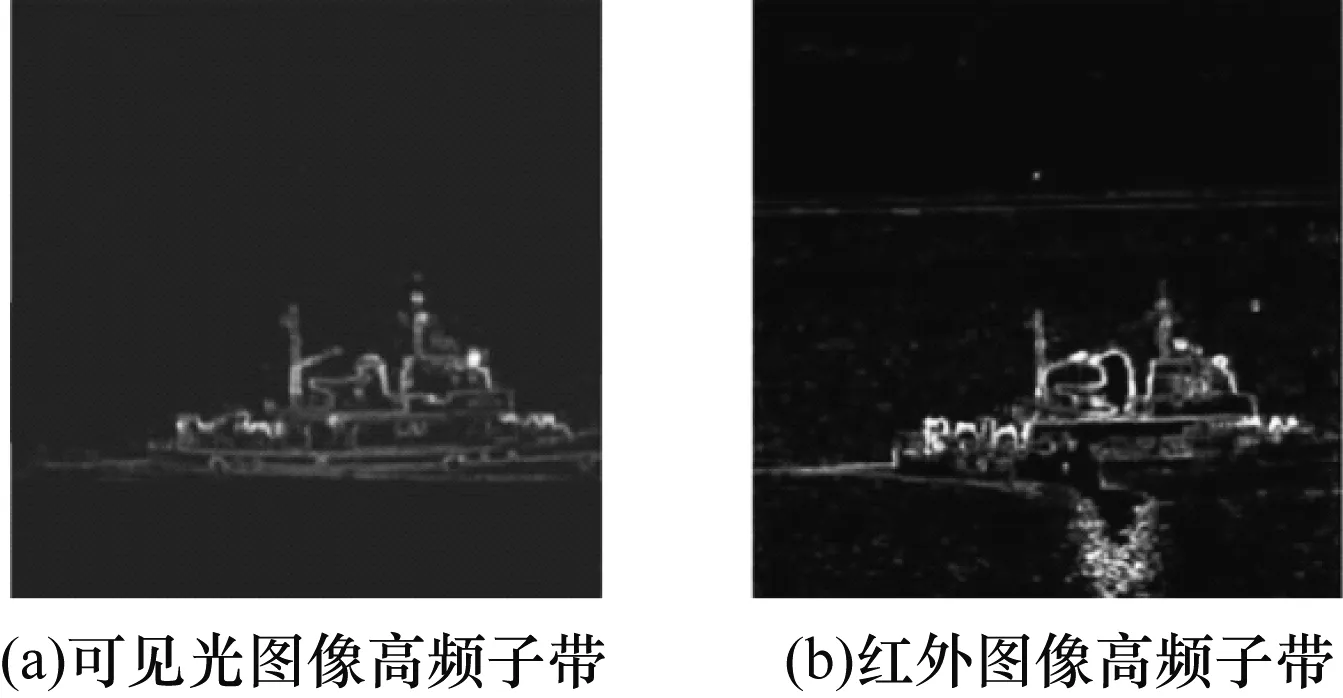

图4为采用FCN模型提取的红外与可见光图像高频子带特征映射图。可以看出,图像边缘特征和纹理特征被保留,保证了高频图像信息完整性。通过最大加权平均算法将图像边缘特征和纹理特征进行有效融合,得到分辨率和清晰度较好的高质量融合图像。

图4 采用FCN模型提取的红外与可见光图像高频子带特征映射图Fig.4 Feature mapping graphs of high frequency sub-band of infrared and visible light image extracted by FCN model

2.4 图像重构

根据低频和高频融合规则分别计算得到融合图像的基础图像Fb(x,y)和细节图像Fd(x,y),将两者进行重构,最终得到融合图像F(x,y)如式(7)所示:

F(x,y)=Fb(x,y)+Fd(x,y)

(7)

3 实验与结果分析

3.1 实验设置

本文选择红外与可见光图像融合领域常用的6组图像为研究对象,通过实验对本文所提方法进行主观和客观评价,并与现有的GFF[22]、WLS[23]、IFE[24]、GTF[25]和CSR[16]5种方法进行对比。图像由网站[26]下载得到,实验采用的硬件平台为CPU Intel Core i7,主频为2.5 GHz,内存为4 GB,软件平台为 Matlab 2015b。

图5为实验选择的6组红外与可见光源图像,每组左侧为红外源图像,右侧为可见光源图像。先从主观上通过人眼观察不同图像融合结果的视觉效果,再采用信息熵(EN)[27]、局部互信息(LMI)[28]、结构相似度(SSIM)[29]、边缘信息保留度(QAB/F)[30]和视觉信息保真度(VIFF)[31]5种融合质量客观评价指标对融合图像进行客观评价。上述指标数值越大,表示图像融合效果越好。

图5 6组红外与可见光源图像Fig.5 Six groups of infrared and visible light source images

3.2 主观评价

6组红外与可见光图像的实验结果如图6所示,在每组图像中,从左到右依次为采用GFF、WLS、IFE、GTF、CSR和本文方法得到的融合图像(以下分别称为GFF、WLS、IFE、GTF、CSR和本文方法图像)。

由图6(a)可以看出:GFF图像背景灰度值分布不均匀,导致图像背景模糊;WLS图像整体偏亮,目标边缘模糊,对比度较差;IFE图像中可见光图像信息丢失严重,导致海面和背景模糊,且海岸线有白色噪音;GTF图像与红外图像相近,图像整体偏暗,对比度较差;CSR图像融合效果总体较好,但是视觉效果不自然,海面、沙滩纹理融合效果不如本文方法;本文方法图像整体更自然,船只与背景的亮度和对比度适中,且沙滩纹理清晰,海面水波的纹理过渡较自然。

由图6(b)可以看出:GFF图像和GTF图像可见光图像细节信息丢失严重,目标边缘不清晰,场景信息模糊;WLS图像和IFE图像整体偏亮,对比度较差,部分纹理细节丢失;CSR图像总体融合效果与本文方法图像接近,但是灌木丛等场景较模糊;本文方法图像能完整保留源图像细节信息,目标边缘突出,整体视觉效果更好。

由图6(c)可以看出:GFF图像与红外图像接近,但没有体现车头灯可见光信息;WLS图像背景模糊,未能很好地融合可见光图像信息;IFE图像整体偏亮,图像整体视觉效果不自然;GTF图像丢失大量细节信息,导致图像模糊;CSR图像对比度较低,背景细节融合效果不如本文方法图像;本文方法图像能较好地反映源图像中所有信息,视觉效果更好。

图6(d)~图6(f)为其他3组图像的融合结果。可以看出,与其他5种方法相比,本文方法得到的融合图像目标提取完整,图像纹理清晰、亮度适中、对比度较高,整体融合效果较好,更适合人类视觉感知。

3.3 客观评价

表3为采用不同融合方法所得图像的客观评价结果。表中数据为每种方法在6组源图像上的平均得分。可以看出:IFE方法在所有指标上都优于GFF、WLS和GTF方法;GFF方法在QAB/F上表现良好,但在VIFF上表现较差;CSR方法在所有指标上都表现良好,且在VIFF上表现最好;本文方法除在VIFF指标上排在第2位之外,在其他5项指标上均居首位。综上所述,本文方法较其他方法具有更好的客观评价结果。

表3 不同方法所得融合图像的客观评价指标Table 3 Objective evaluation indexes of fusion images obtained by different methods

4 结束语

本文提出一种基于改进全卷积神经网络的红外与可见光图像融合方法。利用非下采样剪切波变换将源图像分解为低频子带和高频子带图像,按照区域能量和融合规则融合低频子带,采用FCN模型提取高频子带图像的多尺度特征,生成特征映射图,使用最大加权平均融合策略融合高频子带,对融合后的高频子带和低频子带进行NSST逆变换得到融合图像。实验结果表明,该方法得到的融合图像较GFF、WLS和IFE等方法客观评价结果更好。后续将对图像融合耗时和模型结构进行改进,以达到更好的图像融合效果。