基于眼动预测与多层邻域感知的显著目标检测算法*

2020-07-19李媛丽孟祥豪张坤峰段永胜

李媛丽,黄 刚,王 军,孟祥豪,张坤峰,段永胜

(国防科技大学 电子对抗学院,安徽 合肥 230037)

0 引言

视觉显著性检测旨在模拟人类视觉注意机制,利用计算机对图像、视频进行处理,提取图像、视频序列中的显著性信息,忽略无用信息。作为计算机视觉领域的一项重要预处理过程,它在图像和视频质量评估、目标识别以及图像检索等领域发挥着重要作用[1-4]。目前,对显著性检测的研究已取得很大进展,但是随着时代的发展,视觉显著性检测应用的场景愈发复杂。在以往的研究中,人们往往只基于图像自身的显著性线索如对比度、边界背景先验等,通过设计低层次手工特征(颜色、纹理等)或者高层次语义特征(深度特征)来提取显著性目标区域,没有很好地考虑人眼的视觉注意特征。例如,Li 等人[5]提出将图像边界区域作为背景模板,提取颜色和位置特征,构造稀疏和密集重构误差模型来计算显著性。Cheng 等人[6]提出通过提取区域对比度的特征,以预测图像的显著性。Lee 等人[7]通过将手工设计的低层特征与从神经网络中提取的高级语义特征相结合来预测其显著值。这些算法虽然能够在简单场景下检测出显著目标,但当面临较为复杂的场景时如边界目标、低对比度等往往会检测失效。近年来,基于深度学习显著性检测模型虽然在一定程度上解决了上述问题,但往往需要复杂的训练过程,且计算模型较为复杂。

针对上述问题,本文提出基于眼动预测和多层次邻域感知的显著性目标检测算法。首先,基于GBVS 原理提取人眼感兴趣区域(Human Attention Fixation Map,HAFM),再对图像进行多尺度的超像素分割,基于HAFM 提取可靠目标种子;其次,结合超像素颜色、纹理、空间距离、视觉注意等多维度特征,计算超像素间的相似度权重;再次,在多个分割尺度下,基于元胞自动机原理构造多层次邻域感知模型进行显著性目标种子的传播;最后,经过多尺度融合生成整个目标的完整显著图。相较于之前的研究,本文所提算法有以下3 个特点:

(1)将人眼视觉注意特征融入显著性目标检测,并以此生成可靠性目标种子,提高了检测结果的精度;

(2)提取颜色、纹理、视觉注意图等多维度特征进行显著性计算,使得算法面临不同的场景均能达到良好的结果,提高了算法的鲁棒性;

(3)构造多层次邻域感知模型进行显著目标种子的传播,使得目标种子能够在不同的分割尺度下进行扩散,并生成准确的显著目标图。多层次邻域感知模型能够处理不同尺度规模的目标检测问题,提高了算法的适用性。

1 眼动预测与目标种子获取

1.1 视觉注意机制与眼动预测

眼睛是心灵的窗户,人类观察世界、获取外界信息的重要方式之一便是人类视觉系统(Human Visual System,HVS)。当大量外界的视觉信息被眼睛接收时,大脑不能对所有的视觉信息同时进行处理,而是采取忽略大部分无用的信息,关注少部分感兴趣的重要信息的方式,帮助人们更容易地理解场景。人们会在无意识中“关注”眼前场景中最“显眼”的部分,这样的行为被定义为视觉注意(Visual Attention)机制[8-9]。这些场景中更容易被重点关注的区域吸引人们注意力的程度,被描述为视觉显著度(Visual Saliency)[10-11]。利用计算机算法模拟人类的这种视觉关注性行为,被称为眼动点预测(Human Eye Fixation Prediction,HEFP)。

在之前的研究中,学者多结合心理学、神经学、生物学进行眼动点预测的研究。比较著名的模型是Harel[12]等人提出的基于图论的眼动点预测方法(Graph-Based Visual Saliency,GBVS)。该模型利用马尔科夫链的原理,计算特征差异后进行归一化处理,最终生成基于图论的显著图。本文首先基于GBVS 预测图像中人眼感兴趣的区域图(Human Attention Fixation Map,HAFM):

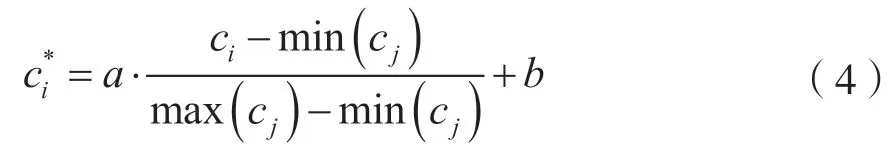

其中P为输入图像,H为图像P所对应的HAFM 图。如图1 所示,利用眼动点预测得到的特征能够帮助快速锁定显著目标区域,从而为完成显著目标检测提供有用的指导信息。

图1 基于视觉注意的目标种子获取方法示例

1.2 超像素分割

为了更好地提取受测图像的结构信息和目标边界信息,使检测更加高效、精确,目前很多算法将图像进行分割处理。在计算机视觉领域,将数字图像细分为多个图像子区域的过程就是图像分割。图像子区域即是图像中像素的集合,也被称作超像素。Achanta[13]等人提出的简单线性迭代聚类(Simple Linear Iterative Clustering,SLIC)具有执行快、简单高效、分割质量高等优点,已被广泛应用于计算机视觉中的预处理环节。SLIC 将彩色图像转化为CIELAB 颜色空间和xy 坐标下的5 维特征向量,并构造其距离度量标准,再对图像像素进行局部迭代,从而生成较为紧凑和均匀的超像素。

SLIC 超像素分割算法具体流程如下:

输入:图像P

输出:超像素集合R

流程:

1.以步长S初始化聚类中心,个数为预设的超像素个数;

2.在n×n邻域内重新选取聚类中心;

3.在每个聚类中心的2S×2S邻域内为每个像素计算距离,并分配类标签;

4.反复迭代直到整体收敛;

5.增强连通性。

1.3 目标种子获取

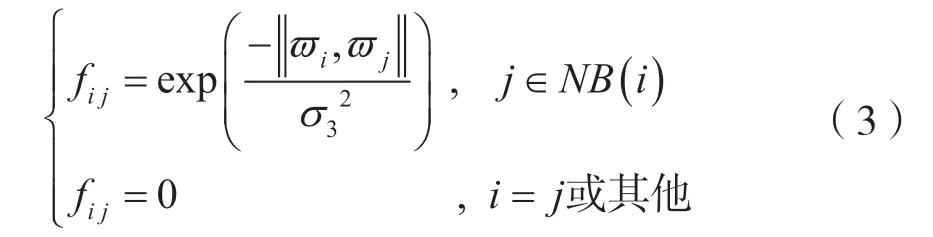

在提取图像的人眼视觉注意特征并对图像进行超像素分割后,为有效利用人眼视觉注意特征来进行显著性目标检测,本文将HAFM 图与超像素分割图结合提取目标种子。定义oi是超像素ri中的像素集合,H(o)是单个像素在HAFM 图中所对应的视觉注意特征值。本文计算超像素ri中包含的所有像素点的视觉注意特征值的平均值hi作为该超像素的人眼视觉注意特征,并基于此构建目标种子。hi的计算方法为:

其中Oi为超像素ri中的像素点数量。

将图像的HAFM 图与SLIC 分割图相结合,获取基于视觉注意特征的可靠目标种子。本文将大于0.5 的超像素定义为目标种子,示例如图1 所示。

2 多维度特征提取

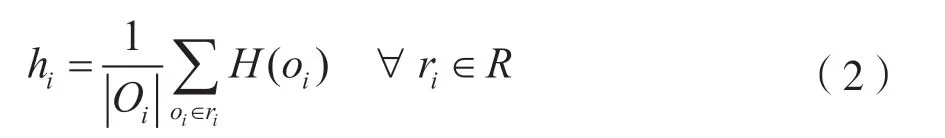

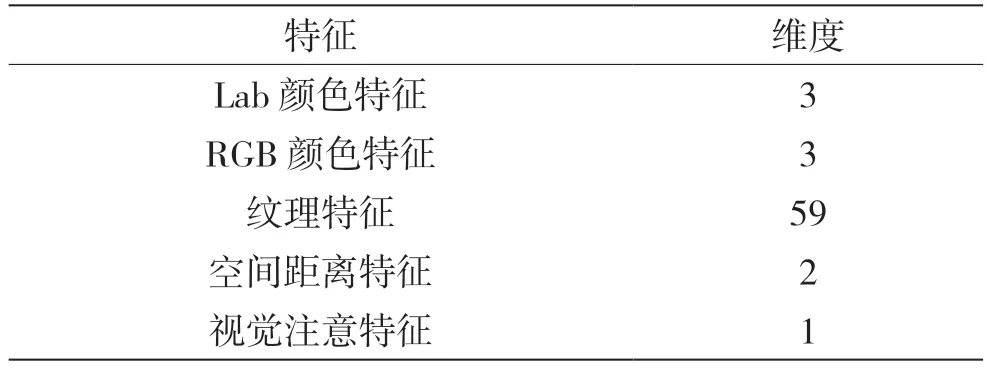

通常而言,图像的颜色特征对于显著性检测来说最重要。因此,目前主流算法主要提取颜色特征向量计算相似度权重进行显著性传播。对于颜色特征较好的图像来说,传播结果已经能够达到比较满意的程度。但是,当图像颜色特征较差而纹理、距离、视觉注意等特征较为优秀时,仅使用颜色特征向量计算相似度权重,往往出现目标缺失、噪声过大等问题,导致算法性能下降。为提高算法的鲁棒性,本文提取颜色、纹理、空间距离以及视觉注意等多维度特征,构造联合特征向量来描述每个超像素ri。联合特征向量的具体特征构成如表1 所示。

表1 联合特征向量构成

为说明多特征联合的有效性,图2 给出了几个例子。可以看出,相较于采用单一颜色特征向量,采用联合特征向量计算相似度权重后,算法在检测复杂场景时,检测目标更加全面、准确,且抑制了背景噪声,提高了算法的鲁棒性。

图2 单一特征与联合特征计算结果对比

3 多层次邻域感知

本文多层次邻域感知模型包含3 大步骤:单一尺度下基于元胞自动机的显著值传播,多尺度融合和Sigmoid 优化。

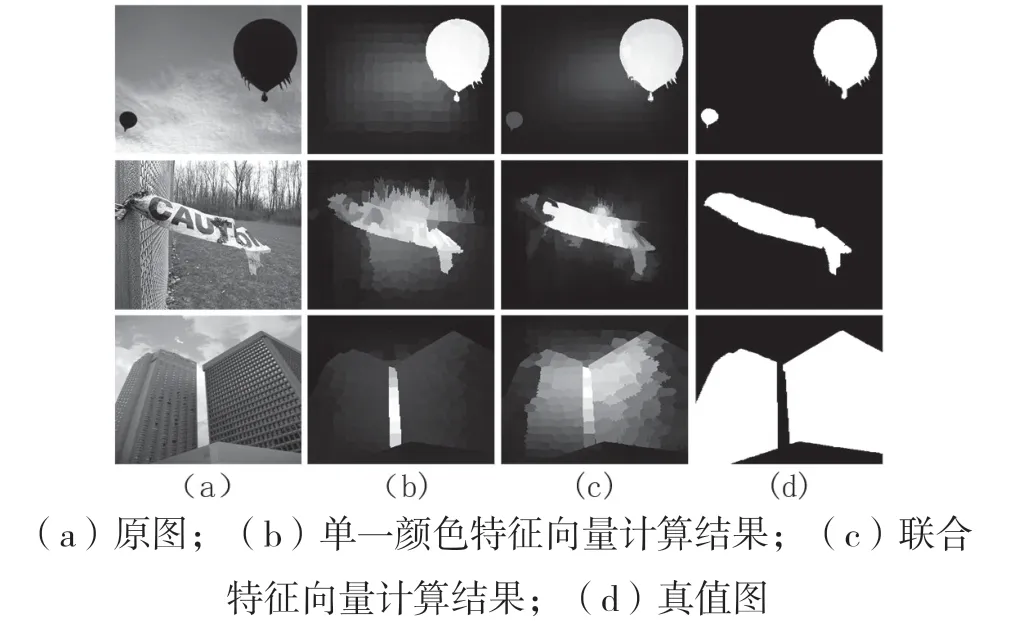

3.1 基于单层元胞自动机的显著性优化

本文利用单层元胞自动机[14]在单一尺度下进行显著性优化。元胞自动机原理如图3 所示,核心是由于一个超像素点受其周围超像素及其自身的影响,在经过若干次传播后,整体的状态达到收敛。在获取目标种子、构造联合特征向量后,需建立超像素ri对超像素rj的影响因子矩阵:

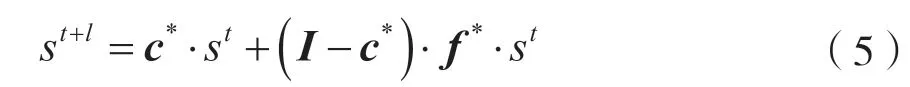

fij为超像素ri和rj之间的相似度权重,ϖi为超像素ri的联合特征值,NB(i)为超像素ri邻域的集合,σ3是用于控制相似度的参数。将矩阵因子归一化后,再建立置信度矩阵:

其中ci是超像素ri当前时刻对自己的置信度,a和b为常数。最后,根据影响因子矩阵和置信度矩阵,同步更新原则:

其中I是单位矩阵,f*是由fij构成的影响因子矩阵,c*是置信度矩阵,st和st+1是当前状态显著图和更新后的显著图。经过N1次对所有元胞的遍历更新,得到显著图s。元胞模型显著性传播示意如图3 所示。

图3 邻域感知模型

3.2 多尺度融合

由于不同图像的显著性目标尺度规模往往不尽相同,本文将原始图像进行M个尺度的超像素分割。对于每个尺度都单独进行显著值传播优化,生成M个子显著图。将M个子显著图进行线性加权融合,得到融合显著图:

其中αi为加权融合系数。

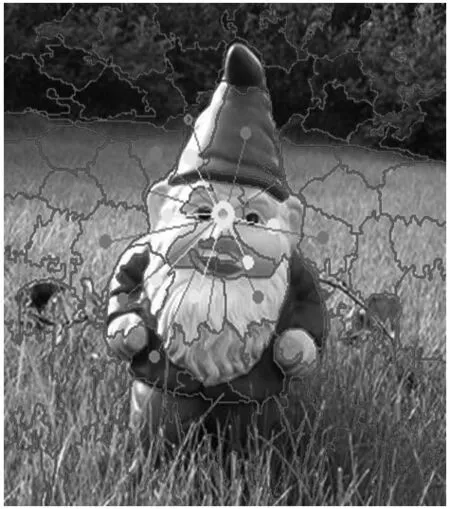

如图4 所示,单一尺度下显著图的目标不够平滑连续,经过多尺度融合后,不仅目标区域的显著性得到强化,且使得显著图更加平滑。

图4 单一尺度与多尺度融合显著图

3.3 显著图强化

最后,使用Sigmoid 函数来抑制融合显著图的背景噪声,并对整体显著值进行平滑和优化:

其中S为输入显著图,S´为优化后显著图,a、b为控制优化效果的参数。为使强化效果达到最佳,本文通过训练的方法确定参数a和b。为综合考虑MAE 与F-measure 值评价图像的差异性,本文定义FRM值作为作为图像的评价指标:

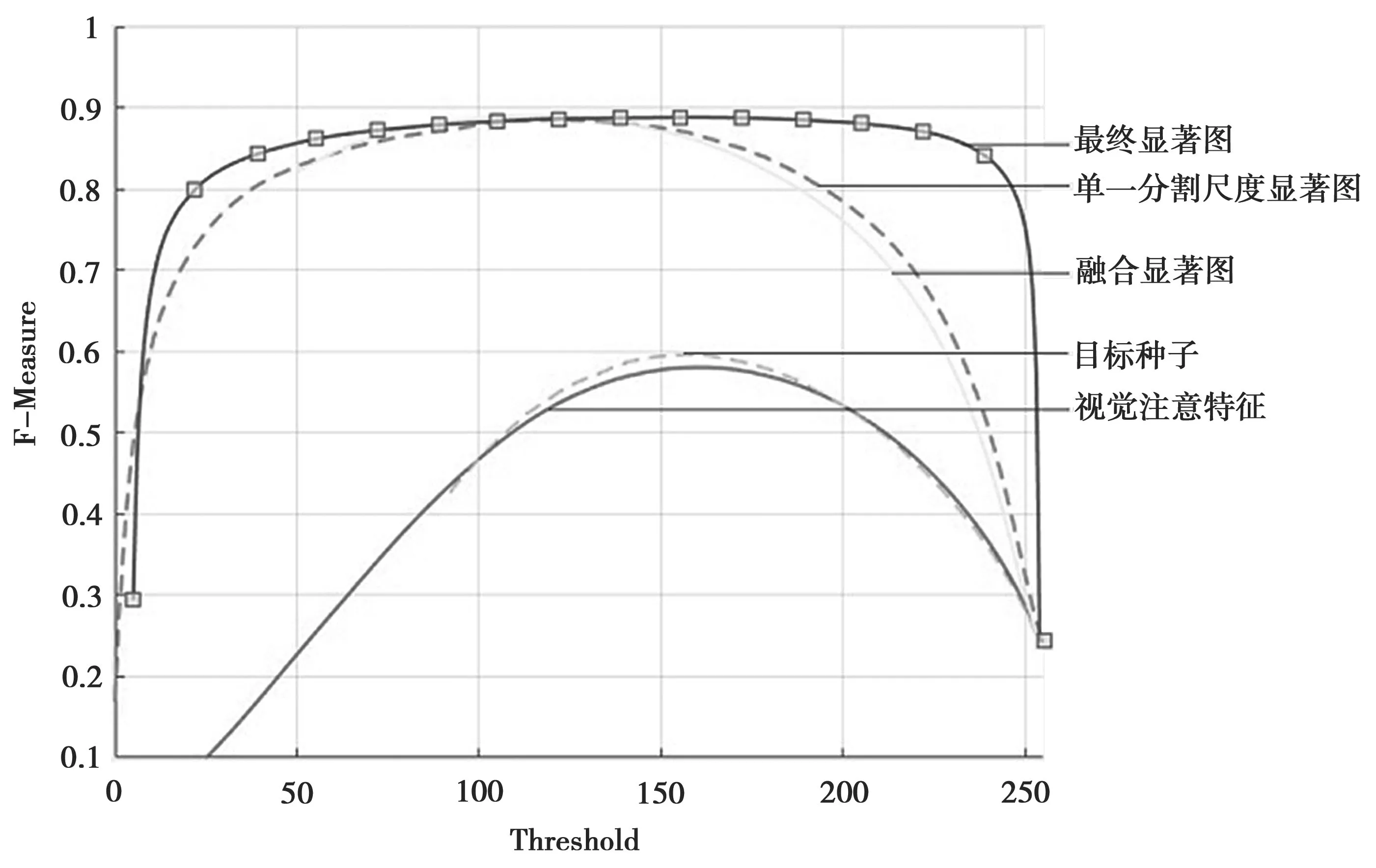

训练前,设置a的变化范围为[1,10],步长为1。b的变化范围为[0.1,1],步长为0.1。对所有参数的优化结果进行评价计算FRM值,找出最优结果。训练结果如图5 所示,当a=10、b=0.6 时,FRM达到最大。最终,通过最优参数对融合显著图S进行强化,得到最终显著图S´。

本文算法流程如下:

输入:图像P

输出:显著图S´

流程:

1.利用GBVS 获取人眼视觉注意特征区域;

2.对图像进行多尺度超像素分割;

3.结合视觉注意特征、超像素分割图计算目标种子;

4.联合颜色、纹理、空间距离、视觉注意多维度特征计算节点相似度权重;

5.利用元胞模型对每个单一尺度进行显著性优化;

6.多尺度显著图融合;

7.将融合显著图进行Sigmoid 强化,得到最终显著图S´。

图5 FRM 值训练结果

4 实验与分析

4.1 实验设置

本文在MSRA[15]数据集上测试各类算法。MSRA中包含各类物品、人物、植物等目标,能够有效检测显著性模型的适用性。数据集中的每一张图片都有像素级别的真值标注。本文主要结合以下典型算法GB[12]、DSR[5]、LR[16]、BFS[17]、BSCA[14]、PCA[18],对结果进行分析与比较。

显著性检测的评价指标主要包括ROC 曲线、P-R曲线、AUC值、MAE值和F-measure 值[14]。本文主要通过MAE、F-measure 值、FRM值3 个评价指标对结果进行评价。其中,MAE 为平均绝对误差,其在像素层次计算显著图与真值之间的误差,并在整幅图像上求平均:

F-measure值为精确率和召回率的加权和平均,用于测量两幅图像相匹配的程度:

其中P为精确率,R为召回率,β2一般取0.3。FRM 值在3.3 节已作相关介绍。

4.2 本文算法阶段性能分析

本文首先基于GBVS 提取图像人眼视觉注意区域,生成HAFM 图后对图像进行多尺度超像素分割,然后超像素分割图结合HAFM 图获得目标种子。其次,联合图像颜色、纹理、空间距离以及视觉注意等多维度特征构造联合特征向量,计算相似度权重。再次,对每个单一尺度进行显著性优化,并进行多尺度融合获得融合显著图。最后,将融合显著图利用训练得出的优化参数进行Sigmoid 强化,得到最终显著图。为进一步分析算法各步骤对生成显著图质量的贡献程度,图6 给出了本算法中的人眼注意特征线索、基于视觉注意机制的目标种子、单一尺度显著图、多尺度融合显著图以及图强化后的最终显著图性能曲线对比。从图6 中算法各阶段的性能曲线可以看出,经过综合处理后的算法性能有了显著提高。

图6 本算法各阶段F-measure 曲线对比

4.3 本文算法与其他算法的对比

表2 给出了本文算法与其他算法在MSRA 数据集上的MAE、F-measure 值以及FRM 值数据对比。从表2 可以看出,本文所提算法在保证较大F-measure 值的同时,有效减小了显著图的MAE,保持了较高的FRM 值,提高了显著图的质量。

图7 给出10 张图像检测效果示例(均来自MSRA 数据集)。从检测结果可以看出,PCA[18]算法基于主成分分析和对比度先验进行显著性检测,其检测结果目标边界较明显,但目标区域内部显著性不足,背景噪声较大。BSCA[14]算法对图像颜色特征依赖较强,当图像其他特征占优时,出现背景噪声过大等问题。DSR[5]算法基于边界先验选取目标种子,当目标靠近图像边界时,出现显著目标检测不全的问题。而本算法在面对复杂场景、目标处于非理想位置的图像时均取得了较好的检测效果,直观说明了本文所提算法的优异性。

表2 本文算法与其他算法的对比

图7 本文算法与其他算法对比示例

5 结语

针对传统算法中往往只关注图像本身显著信息,而忽略了人类自身视觉注意信息的问题,提出了基于眼动预测与多层邻域感知的显著目标检测算法。首先,利用GBVS 原理获取人眼感兴趣的区域生成HAFM 图,再对图像进行多尺度超像素分割,并基于HAFM 获取目标种子,提取图像颜色、纹理、视觉注意等多维度特征构造联合特征向量,计算相似度权重。其次,对每个单一尺度进行显著性优化,再进行多尺度融合获得融合显著图。最后,利用训练得到的最优参数对融合显著图进行Sigmoid强化,获得最终显著图。本文所提算法能够利用人眼视觉注意特征获取可靠的目标种子,并提取了多维度特征计算节点相似度权重,提高了算法的鲁棒性;构造的多层次邻域感知模型保证了显著性检测精度,提升了算法在面对复杂场景时的适用性。实验表明,本文所提算法性能优于目前主流的图像显著性检测算法,具有较强的鲁棒性和适用性。