基于视差图指导的无参考立体图像质量评价

2020-06-04李素梅丁义修常永莉

李素梅,丁义修,常永莉,韩 旭

基于视差图指导的无参考立体图像质量评价

李素梅,丁义修,常永莉,韩 旭

(天津大学电气自动化与信息工程学院,天津 300072)

考虑到视差图在立体成像中的重要性,设计了一种双通道的卷积神经网络来实现无参考立体图像质量评价.首先,建立一个以密集连接网络为主体的卷积神经网络结构,用于提取特征. 其次,基于人类视觉系统的双目融合和双目竞争的特性,将左右视图进行R、G、B三通道融合得到彩色融合图像,并将此融合图像作为卷积神经网络的一个通道的输入;另一通道的输入为视差图,视差图起到了特征补偿的作用. 然后,通过改进挤压和激励模块来实现视差图对融合图像的加权指导. 这种加权策略加强了融合图像的重要信息的比重,减轻了非重要信息的比重. 最后,在卷积神经网络的末端,将视差图的特征和加权校正过的融合图像的特征进行融合得到总体特征,将总体特征与主观评价方法得分进行回归分析,得到待测立体图像的质量分数. 在两个公开的LIVE立体数据库上进行实验验证. 结果表明:所提出的无参考立体图像质量评价方法能够有效地应对对称和非对称失真类型的立体图像,并与主观评测方法保持高度一致.

立体图像质量评价;融合图像;卷积神经网络;视差图;挤压和激励模块

随着3D技术的飞速发展,3D内容受到了越来越多的关注.为了保证人们在观看3D内容时能够获得良好的视觉舒适性,应设计一种可靠、有效的立体图像质量评价方法来检测其质量.目前,立体图像质量评价方法分为主观评价和客观评价,主观评价符合人类视觉特性,但实现过程繁琐、耗时耗力;客观评价方法的实现则更为简单、快捷,具有良好的可操作性,因此,越来越多的学者投身于立体图像质量的客观评价领域中.此外,依据评价过程中是否使用原始参考图像,客观质量评价又分为3类:全参考、无参考和半参考立体图像质量评价.全参考立体图像质量评价,充分利用原始图像的信息作为参考对失真图像进行评价;半参考立体图像质量评价,利用原始图像的部分信息来进行质量评价;无参考立体图像质量评价,仅利用失真图像的信息就可以完成质量评价.在实际应用中,原始图像的获取比较困难[1],因此,无参考立体图像质量评价具有很好的应用价值.本文主要研究的是无参考立体图像质量评价方法.

依据使用方法的不同,立体图像质量评价方法被分为两类:传统方法[2-5]和深度学习方法[6-13].文献[2]计算视差图的梯度,从而为融合图像进行加权,然后提取左、右视图和加权融合图像的自然场景统计特征,最后通过支持向量回归(support vector regres-sion,SVR)得到质量分数.文献[3]首先提取梯度幅值图、梯度相位图和视差图,其次分别对这些特征图进行稀疏表示,将这些稀疏特征通过主成分分析(principal component analysis,PCA)得到最终的特征,最后将最终特征通过SVR获得质量分数.文献[4]对空间域和局部二值模式提取特征,并且用这些特征进一步进行稀疏表示,从而获得立体图像的质量.文献[5]首先对左右视图提取自然场景统计特征,其次考虑到双目视觉特性,将左右视图融合形成融合图像,并对其提取统计特征,然后计算左右视图的相似性和视差图的统计特征,最终将所有提取的特征融合送入SVR与主观得分训练出一个回归模型.对于这些传统方法而言,使用手工提取特征的方法不能充分体现对人类视觉系统和自然场景统计的解释.

然而,深度学习模拟了大脑对图像进行分层处理的过程,并通过网络本身提取图像的特征,克服了手工提取特征的缺点.一些学者开始将深度学习的方法应用在立体图像质量评价领域.文献[6]通过深度置信网络分别得到左、右视图和深度图的质量分数,然后,将这些分数融合得到立体图像的质量分数.文献[7]使用基于深度图像渲染的技术,从右视图中合成了左视图,并通过全参考的方法计算出左视图和合成的左视图自相似性,另外,依据参考图像和失真图像计算出双目整体标签,用来训练深度置信网络,最终将自相似性和深度信念网络的输出结合,得到了立体图像的质量分数.文献[8]使用深度置信网络分别得到左、右视图和融合图像的质量分数,然后,考虑到双目融合特性将这些质量分数融合,最终获得立体图像的质量分数.文献[9]首先对左右图像分别进行Gabor滤波,获取不同尺度和方向的统计特征作为单目特性;然后根据人眼视觉系统的双目竞争特性,将左右图像融合得到融合图像,提取其方向梯度直方图作为双目特征;最后将这些特征送入深度信念网络得到立体图像质量分数.文献[10]通过一个三通道的卷积神经网络(convolutional neural networks,CNN)对左、右视图和视差图进行特征提取,并且将这些特征融合在一起,得到立体图像的质量.文献[11]通过CNN提取左、右视图和视差图的特征,并将这些特征送入SVR得到最终的质量分数.文献[12]首先通过PCA得到融合图像,然后将融合图像送入卷积神经网络,得到立体图像的质量分数.文献[13]为每个图像块计算出相应的标签,利用CNN对融合图像进行特征提取,得到最终的质量分数.

从上面的分析可以看出,有两种方式来处理左视图和右视图.一些学者使用2D的方法分别对左、右视图提取特征,并将左、右视图的特征进行融合得到总体特征,进而得到立体图像的质量分数.还有一些学者关注于使用融合图像的方法,在观察者观察一对立体图像时,观察者脑中形成的一种单目图像,这种单目图像被称为融合图像.文献[14]中将左视图和经过视差补偿的右视图进行线性相加得到一种融合图像,这种线性模型不能充分体现复杂的双目竞争机制.文献[15]根据双目竞争机制,为左、右视图分别分配非线性权重,将加权后的左、右视图进行相加得到融合图像.文献[16]通过将左、右视图的相位图和幅值图分别进行非线性结合得到融合相位图和融合幅值图.这些非线性模型充分考虑到非对称失真类型的图像的特点,但是在一定程度上忽略了人眼应对对称失真类型时的线性模型.所以,本文提出了一种融合图像的模型,这种模型既能应对对称失真图像又能应对非对称失真类型图像.

另外,一些学者仅仅使用融合图像的特征,来进行立体图像质量评价[12-13].一些学者将左、右视图特征和视差图特征进行融合得到总体特征[10-11],视差图往往起到了特征补偿的作用.于此同时,在文献[2]中,视差图起到了对融合图像指导的作用.对于传统方法而言,将视差图用来特征补偿和对融合图像进行指导,是十分便利的.对于CNN来说,本文建立了一种特殊的通道,在神经网络的末端将融合图像和视差图的特征进行融合,实现了视差图的特征补偿作用.在人脑中,对视差信息的感知在视觉通路中是一个长期的过程.所以,本文使用SE模块来对融合图像的特征进行加权指导.SE模块[17]通过特征的自我校正能够加强有用信息和抑制无用信息.但是,原始的SE模块仅仅有一个输入,不能满足使用视差图特征对融合图像特征进行校正,所以本文对原始的SE模块进行了改进,实现了视差图对融合图像的长期指导作用.

1 算法模型

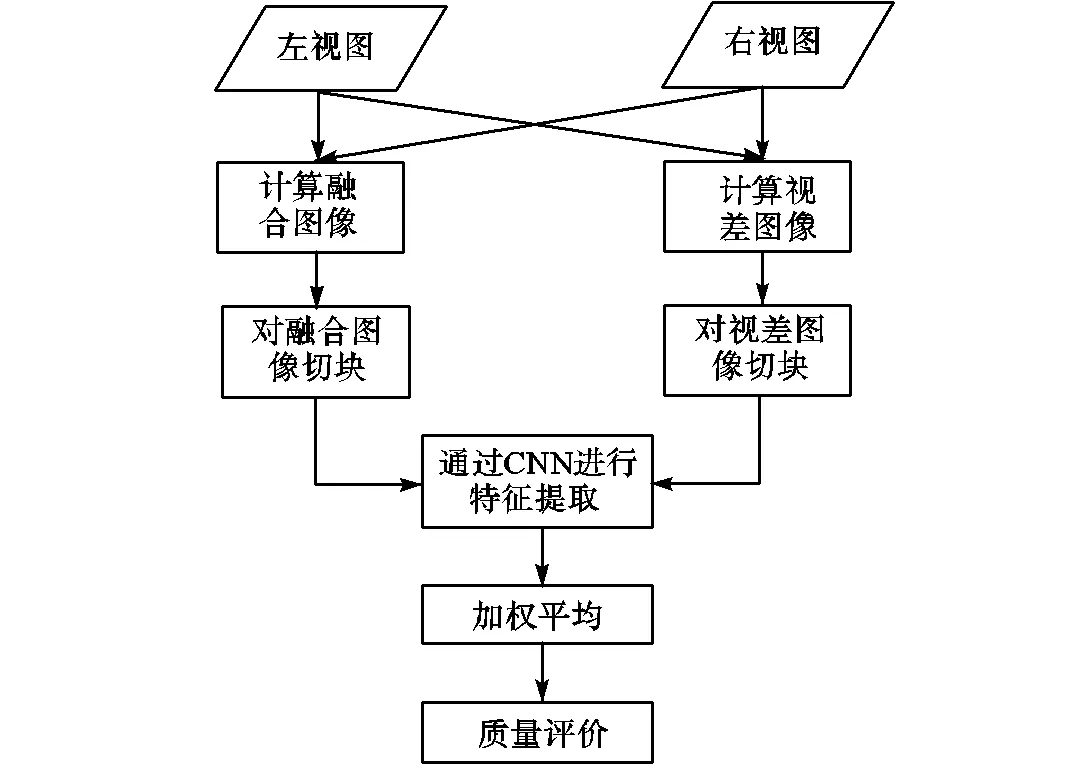

本文所提出的卷积神经网络的结构如图1所示,被命名为双通道密集和改进的SE模块的卷积神经网络(two channel dense and modified SE-block CNN,TCDMSE-CNN),其中一列的输入为融合图像的图像块,另一列的输入为视差图的图像块.除了改进的SE模块,两列网络具有相同的结构和参数.

图1 双列卷积神经网络的算法结构

每一列的网络包括2个卷积模块和2个3层的密集模块.每个卷积模块中含有一个批处理规范化(batch normalization,BN)层,一个修正线性单元(rectified linear unit,Relu)的激活层和一个池化层.在每一个3层的密集模块之后,使用改进的SE模块,通过视差图特征为融合图像特征进行校正,并且,在第2个3层的密集模块之后,将两列的输出结合在一起,形成总体特征.最后,通过全连接模块得到小块的分数.

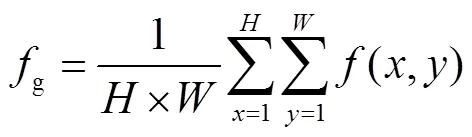

本文提出无参考立体图像质量评价算法流程如图2所示,以左、右视图为输入得到融合图像和视差图像,将这两种图像进行不重叠切块,将图像块送入TCDMSE-CNN.然后,将所得图像块的分数进行加权平均处理,进一步得到未切割之前的图像分数,最后计算出相应指标.融合图像、视差图像以及神经网络中的重要模块详述如下.

1.1 输入图像

本文将融合图像和视差图分别作为TCDMSE-CNN中两列网络的输入,同时输入的融合图像和视差图,由同一对左、右视图生成.这种融合图像符合双目竞争双目融合和视觉的多通道性,视差图由立体匹配算法计算所得[15].

图2 本文质量评价算法流程

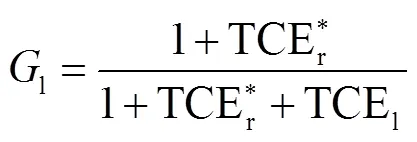

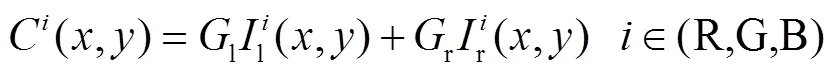

1.2 融合图像

根据增益控制理论、视觉多通道性、Gabor滤波器和对比敏感函数,本文提出了一种能够应对对称失真和非对称失真的融合图像.

图3 彩色融合图像获取过程

1.3 3层密集模块

在文献[19]中,为了加强特征传播和特征复用,设计了一种紧密连接的卷积神经网络模块.基于这些优点,同时考虑到模块更少的层数能够满足本文的需求,将文献[19]中的5层密集模块修改为3层密集模块来完成无参考立体图像质量评价.图4展示了3层密集模块的结构,模块中的任意一层对它的所有后续层都有一个直接的跨层连接.

图4 3层密集模块的结构

1.4 改进的SE模块

图5 原始的SE模块和改进的SE模块结构

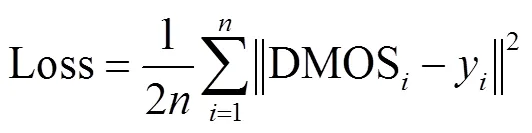

当进行网络训练时,网络的参数通过最小化平均主观得分差(differential mean opinion score,DMOS)和网络输出的欧式距离来实现更新,损失函数见 式(5).

2 实验结果及性能分析

本文在两个公开的立体图像数据库(LIVE Phase Ⅰ和LIVE Phase Ⅱ)上进行了所提算法的性能验证.其中LIVE Phase Ⅰ数据库中包含365幅对称失真立体图像对和20幅原始立体图像对;LIVE Phase Ⅱ包含对称和非对称失真立体图像对共360幅和8幅原始立体图像对.将特征向量与DMOS值拟合,得出PLCC、SROCC、RMSE 3种评分来衡量结果好坏.RMSE值越低、PLCC和SROCC值越高说明本文所提算法性能越好,得出的客观质量分数与主观质量分数具有较高的一致性.为了解决在训练过程中图像不充足的问题,本文将每张图像切成不重叠的40像素×40像素尺寸的小块,每张图可分割为144个小块,实现了对数据集的扩充.随机将图像块分为两个不重叠的子集,80%用于训练,20%用于测试.测试过程中,同样将每张图片切块,对每张图的144个小块分别送入网络得出各自的分数,再通过加权平均得到整幅图像的分数.实验重复20次以减少偏差,将20次的平均值作为最终结果.

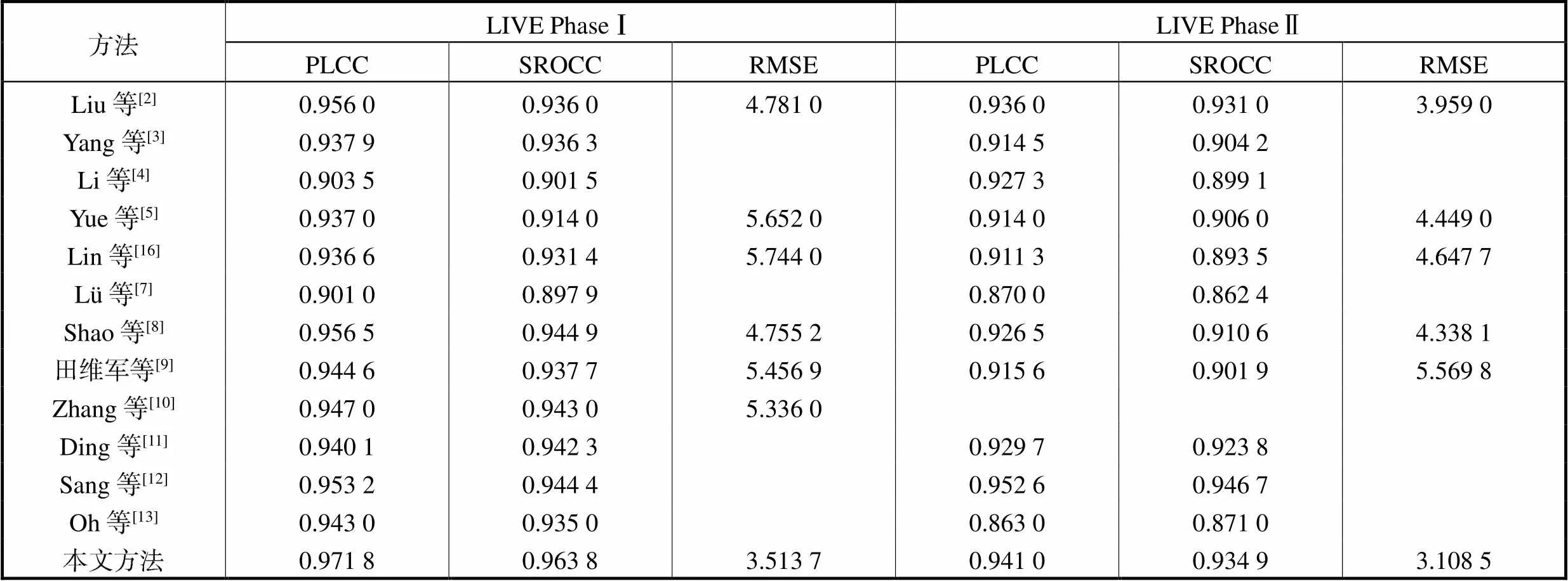

在表1中,将本文方法和其他10种立体图像质量方法进行比较.本文方法在LIVE PhaseⅠ上,PLCC为0.9718,SROCC为0.9638.在LIVE Phase Ⅱ上,PLCC为0.9410,SROCC为0.9349.与使用传统方法[2-4]的相比,本文的方法优于这些方法,这表现了所提方法使用CNN模型优于使用手工提取特征的方法.与使用深度学习的方法[9-13]相比,本文方法的性能仅仅在LIVE Phase Ⅱ上低于文献[12],这表明本文方法的性能优于大部分使用深度学习的方法.与使用传统方法实现视差图对融合图像进行指导的方法[2]相比,本文使用改进的SE模块实现视差图指导融合图像的方法取得了更好的性能.与使用融合图像的方法[2,10-13]相比,本文方法有明显的优势.本文方法在LIVE PhaseⅠ和LIVE PhaseⅡ上,取得良好效果,能够很好应对对称失真和非对称图像.

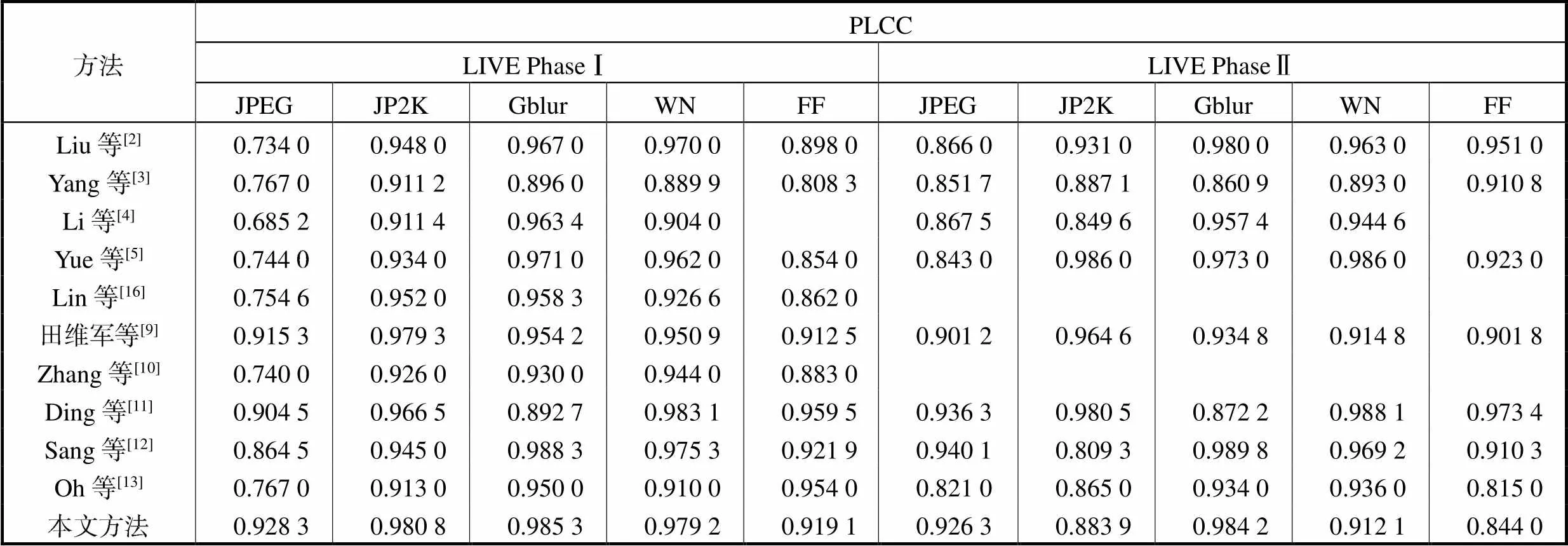

在表2中,列出了不同失真类型在LIVE PhaseⅠ和LIVE PhaseⅡ上PLCC的性能对比.本文方法在LIVE PhaseⅠ上,取得了良好的效果,在LIVE PhaseⅡ的GBlur失真取得了良好的效果,在其他失真类型上表现仍需提高,但在表1中的LIVE PhaseⅡ上获得了良好的整体性能.

表1 各种方法总体性能比较

Tab.1 Comparison of the overall performance of various methods

表2 不同失真类型的性能比较

Tab.2 Performance comparison of different distortion types

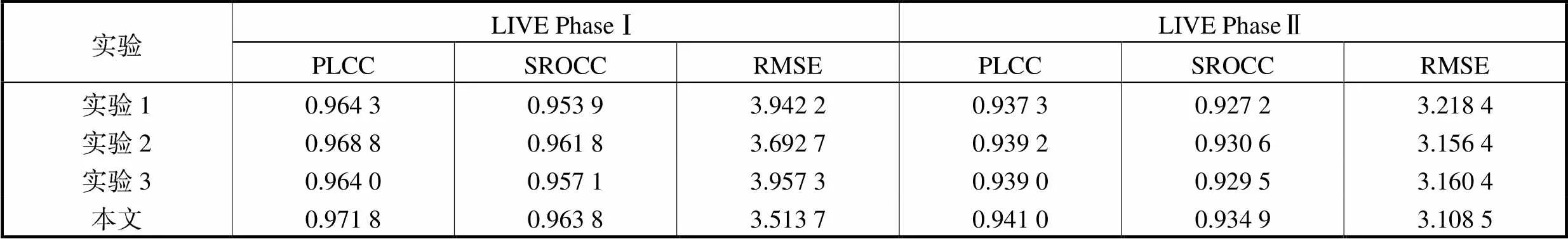

为了进一步证明本文方法的优势,进行了一系列关于改进SE模块和视差图特征的对比实验.在表3中,实验1表示仅仅使用融合图像的单通道网络和原始的SE模块,实现融合图像的特征提取和特征的自我校正.实验2在实验1的基础上,加入视差图的另一个通道网络,在这个实验中,视差图是用来进行特征提取和最终的特征补偿,不对融合图进行加权指导.实验3表示视差图通过使用改进的SE模块对融合图像进行加权指导,但没有将视差图的特征融入最终特征,质量分数仅仅由加权的融合图像的特征向量得到.与实验1相比,实验2取得了更好的性能,与实验3相比,本文方法取得了更好的性能,这两种现象,充分体现了将视差图的特征最为补偿特征,提升了整体性能.另外,实验1中,使用原始的SE模块实现了融合图像的自我校正;实验3中,使用改进的融合图像实现了视差图指导融合图像,与实验1相比取得了更好的性能.与实验2相比,本文将改进的SE模块替换原始的SE模块,取得了更好的性能.这两种情况说明了改进的SE模块的优越性.通过上述的对比实验,说明了本文算法的通过视差图进行特征补偿和改进的SE模块的优点取得了优异的性能.

表3 对比实验的性能比较

Tab.3 Performance comparison of comparative experiments

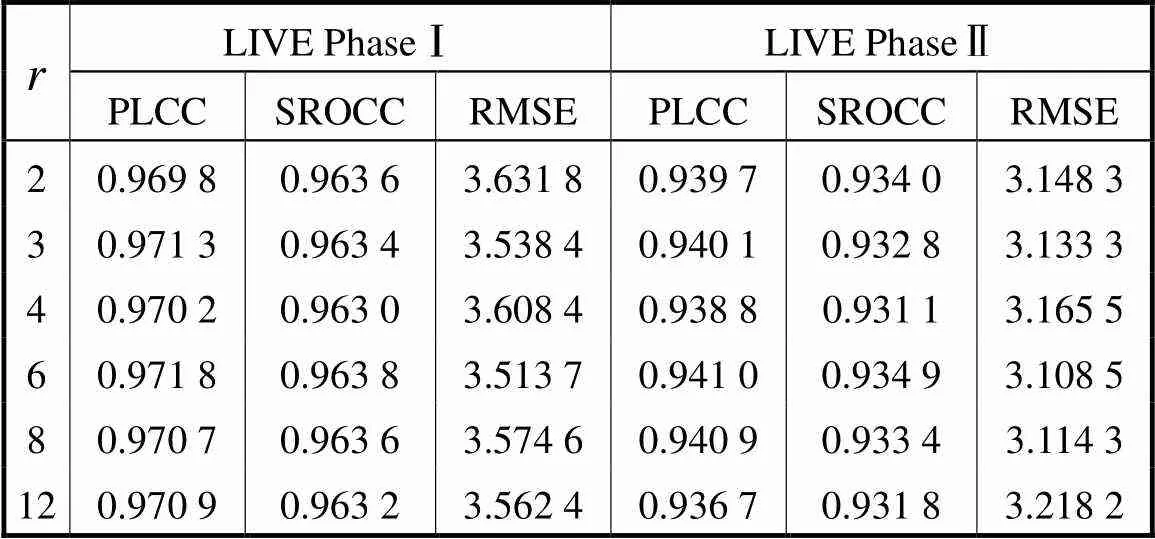

表4 不同衰减因子下的性能比较

Tab.4 Performance of different reduction ratios r on the LIVE 3D image database

3 结 语

本文依靠卷积神经网络提出了一种无参考立体图像质量评价方法,基于人眼的双目融合、双目竞争、双目抑制等特性,模拟人脑进行双目融合的过程,将左、右图像在R、G、B 3个通道进行视觉融合形成彩色融合图像.通过建立一个双通道CNN模型实现了视差图的特征补偿作用,并通过改进的SE模块,实现了视差图对融合图的自适应加权指导.实验结果表明,该方法能够较好地处理对称失真和非对称失真类型的立体图像,与人眼主观评价保持较高的一致性.

[1] Chen Mingjun,Cormack L K,Bovik A C. No-reference quality assessment of natural stereopairs[J]. IEEE Transactions on Image Processing,2013,22(9):3379-3391.

[2] Liu Lixiong,Liu Bao,Su Chechun,et al. Binocular spatial activity and reverse saliency driven no-reference stereopair quality assessment[J]. Signal Processing:Image Communication,2017,58:287-299.

[3] Yang Jialu,An Ping,Ma Jian,et al. No-reference color stereo image quality assessment by learning gradient dictionary-based color visual characteristics[C]// International Symposium on Circuits and Systems(IS-CAS). Florence,USA,2018:1-5.

[4] Li Fucui,Shao Feng,Jiang Qiuping,et al. Local and global sparse representation for no-reference quality assessment of stereoscopic images[J]. Information Sciences,2018,422:110-121.

[5] Yue Guanghui,Hou Chunping,Jiang Qiuping,et al. Blind stereoscopic 3D image quality assessment via analysis of naturalness,structure,and binocular asymmetry[J]. Signal Processing,2018,150:204-214.

[6] Yang Jianchen,Zhao Yang,Zhu Yingbao,et al. Blind assessment for stereo images considering binocular characteristics and deep perception map based on deep belief network[J]. Information Sciences,2019,474:1-17.

[7] Lü Yaqi,Yu Mei,Jiang Gangyi,et al. No-reference stereoscopic image quality assessment using binocular self-similarity and deep neural network[J]. Signal Processing:Image Communication,2016,47:346-357.

[8] Shao Feng,Tian Weijun,Lin Werisi,et al. Towards a blind deep quality evaluator for stereoscopic images based on monocular and binocular interactions[J]. IEEE Transactions on Image Processing,2016,25(5):2059-2074.

[9] 田维军,邵 枫,蒋刚毅,等. 基于深度学习的无参考立体图像质量评价[J]. 计算机辅助设计与图形学学报,2016,28(6):968-975.

Tian Weijun,Shao Feng,Jiang Gangyi,et al. No-reference stereoscopic image quality assessment based on deep learning[J]. Journal of Computer-Aided Design and Computer Graphics,2016,28(6):968-975(in Chinese).

[10] Zhang Wei,Qu Chenfei,Ma Lin,et al. Learning structure of stereoscopic image for no-reference quality assessment with convolutional neural network[J]. Pattern Recognition,2016,59:176-187.

[11] Ding Yong,Deng Ruizhe,Xie Xin,et al. No-reference stereoscopic image quality assessment using convolutional neural network for adaptive feature extraction[J]. IEEE Access,2018,6:37595-37603.

[12] Sang Qingbin,Gu Tingting,Li Chaofeng,et al. Stereoscopic image quality assessment via convolutional neural networks[C]// 2017 International Smart Cities Conference. Wuxi,China,2017:1-2.

[13] OhH,AhnS,Kim J,et al. Blind deep 3D image quality evaluation via local to global feature aggregation[J]. IEEE Transactions on Image Processing,2017,26(10):4923-4936.

[14] Fezza S A,Mohamed-Chaker L. Stereoscopic 3D image quality assessment based on cyclopean view and depth map[C]// IEEE 14th International Conference on Consumer Electronics. Berlin,Germany,2015:335-339.

[15] Chen Mingjun,Su Chechun,DoKyoung K,et al. Full-reference quality assessment of stereoscopic images by modeling binocular rivalry[C]// 2012 Conference Record of the 46th Asilomar Conference on Signals,Systems and Computers(ASILOMAR). Pacific Grove,USA,2012:721-725.

[16] Lin Yancong,Yang Jiachen,Wen Lu,et al. Quality index for stereoscopic images by jointly evaluating cyclopean amplitude and cyclopean phase[J]. IEEE Journal of Selected Topics in Signal Processing,2016,11(1):89-101.

[17] Hu Jie,Shen Li,Albanie S,et al. Squeeze-and-excitation networks[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City,USA,2018:7132-7141.

[18] Ding Jian,Klein S A,Levi D M. Binocular combination of phase and contrast explained by a gain-control and gain-enhancement model[J]. Journal of Vision,2013,13(2):1-31.

[19] Huang Gao,Liu Zhuang,van der Maaten L,et al. Densely connected convolutional networks[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Honolulu,USA,2017:2261-2269.

No-Reference Stereoscopic Image Quality Assessment Guided by a Disparity Map

Li Sumei,Ding Yixiu,Chang Yongli,Han Xu

(School of Electrical and Information Engineering,Tianjin University,Tianjin 300072,China)

Given the importance of the disparity map in stereoscopic imaging,a two-channel convolution neural network(CNN)was designed to evaluate the quality of stereoscopic imaging without reference.Firstly,a CNN structure with a dense connection network as the main body was established for feature extraction.Secondly,a column of CNN input came from the cyclopean image,which was based on the characteristics of binocular combination and rivalry of the human visual system.Left and right views were fused into three channels to get the color cyclopean image.This image was used as the input of one channel of the CNN.The input of other channel was the disparity map,which provided some compensatory information for the cyclopean image.More importantly,we employed the features of the disparity map to guide and weigh the feature maps obtained from the cyclopean image,which were implemented by modifying the structure of the squeeze and excitation(SE)block.This weighting strategy strengthened the transmission of important information,and reduced the transmission of non-significant information from the cyclopean image.Finally,we combined the outputs from the two columns and processed them to get the final quality score of the stereoscopic image at the end of the CNN.The experiment was carried out on two open LIVE stereoscopic databases.Experimental results demonstrated that the proposed method could achieve highly consistent alignment with the subjective assessment.

stereoscopic image quality assessment;cyclopean image;convolution neural network;disparity map;squeeze and excitation block

the National Natural Science Foundation of China(No. 61571325,No. 61971306).

TN911.73

A

0493-2137(2020)08-0854-07

10.11784/tdxbz201907015

2019-07-05;

2019-11-29.

李素梅(1975— ),女,博士,副教授,lisumei@tju.edu.cn.Email:m_bigm@tju.edu.cn

丁义修,370259620@qq.com.

国家自然科学基金资助项目(61571325,61971306).

(责任编辑:王晓燕)