高光谱遥感影像与高程数据融合方法综述

2020-04-30杜星乾侯艳杰

杜星乾,侯艳杰,唐 轶

(1.中国科学院 西安光学精密机械研究所光谱成像技术重点实验室,陕西 西安 710119; 2.中国科学院大学,北京 100049; 3.太原卫星发射中心,山西 太原 030027;4.云南民族大学 数学与计算机科学学院,云南 昆明 650500)

高光谱影像(hyperspectral image, HSI)是用途最为广泛的遥感技术之一,高光谱遥感技术是一种被动遥感技术,通过获取地物反射的电磁波得到连续而丰富的光谱信息,这决定了借助高光谱遥感影像可以很好地区分出的不同材质构成的地物.但由于高光谱图像空间分辨率较低,因此对于相似材质的不同类型地物(如乔木和灌木,水泥地面和水泥屋顶)的分辨能力有限.

高程数据同样是遥感中常用的数据类型,它能够表征地面的高度信息.通过研究地物的高程分布特点可以实现对地物的分析与理解,在地理信息分析中起到重要的作用.激光雷达(light detection and ranging, LiDAR)技术是获取精确高程信息的常见手段,它属于主动遥感技术,具有精度高、灵活性好、受天气因素影响小等优势.激光雷达技术通过主动发射激光束,接收从地面反射回探测器的光波,计算出探测器与目标之间的距离.使用脉冲激光对地面场景进行不断扫描即可得到地面场景的高程信息,还可以通过这种手段建立地面数字高程模型(digital elevation model, DEM).在使用通过激光雷达获取到的高程数据进行遥感场景的分类、识别等任务时,能够很好地辨别出地物高程的差异,尤其是在分辨建筑物与地面、树木与草地等任务中起到很好的效果.但由于缺乏光谱信息,对地物的光谱特性,包括材料、质地、成分难以进行有效的区分.

基于高光谱遥感影像和高程数据(激光雷达数据)的上述特点,在遥感数据智能分析中,将这两种数据进行融合能够最大限度地发挥各自的特点,实现更高精度的分类与识别.基于对比实验可以证明相比于使用单一类型的数据,两种数据的融合能够显著提升对地物分类的精度[1].近年来,涌现了非常多的基于高光谱影像和激光雷达数据融合的工作,并成功地应用于复杂场景地物分类[2]、植被覆盖分析[3-7]、树种分类[8-10]、生物量估算[11]、冰川地貌分析[12]、小气候建模[13]等任务,取得了较好的效果[14].

本文侧重于复杂场景地物分类的应用,整理了近年来该领域的工作.在高光谱和激光雷达数据融合的地物场景分类的任务中,一般分成数据预处理、特征提取、特征融合以及特征分类几个步骤.在对数据融合方法进行分类时,常见的分类方法是按照融合的层级进行分类,分为像素级融合、特征级融合以及决策级融合[15].像素级融合常用于具有不同光谱特性的影像数据,如多光谱和全色图像的融合.由于激光雷达数据和高光谱图像的像素点表征的信息类型差异较大,一般不进行像素级融合.在该领域中,决策级融合的方法同样较少,而特征级融合方法较为常见,因此按照融合层级进行分类意义不大.在传统的特征级融合中,使用的特征以形态学特征为主.近年来,深度学习技术发展迅速,在图像处理等领域展现出了非常强大的潜力,具有较强的特征提取能力,在高光谱和激光雷达数据融合分类的领域也涌现了不少优秀的相关工作.基于此,本文按照特征的类型进行分类,分为基于形态学特征的融合方法和深度学习方法两大类,分别对这两类方法进行介绍与总结.文中首先介绍了基于形态学特征的融合方法,根据具体的特征融合方式又分为特征拼接的融合方法、基于低秩模型的融合方法、基于复合核(composite kernel)的融合方法以及基于图结构的融合方法.基于深度学习的方法又分为深度特征拼接的方法和深度特征核空间融合的方法.本文的最后还对该领域未来发展趋势进行了总结和展望.

1 基于形态学特征的融合方法

1.1 形态学特征拼接的融合方法

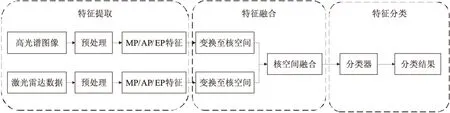

形态学特征(morphological profile, MP)从自然图像推广到高光谱图像[16],再到高光谱图像与激光雷达数据的融合,已经在各个领域广泛地使用.形态学特征提取是通过一系列的开运算和闭运算以及结构元素的扩张来区分图像中不同的区域,构造出形态的轮廓,从而有效地提取纹理信息和空间特征,同时保留其他区域的几何特性.基于形态学特征MP[17],引申出了属性特征(attribute profile, AP)[18]和消光特征(extinction profile, EP)[19-20].通过一系列的形态学腐蚀和膨胀运算,可以得到图像的属性特征AP[1],而通过连续的形态学消光滤波可以得到图像的消光特征EP[21].AP在特征提取的过程中融合了图像多层级的信息,而相比于AP和MP,EP能够更好地提取出图像中的局部极值点,从而使算法具有更好的识别能力[22].使用MP、AP、EP等基于形态学特征的这一方法特点是时间复杂度低,运算速度较快.该类方法的一般框架如图 1所示,首先分别对两种数据进行预处理,如利用主成分分析(principle component analysis, PCA)降维,然后进行特征提取,得到MP/AP/EP特征后,再通过向量拼接的方式进行特征融合[23],最后使用分类器对特征进行分类,得到最终的分类结果.

图1 形态学特征拼接融合方法的一般框架

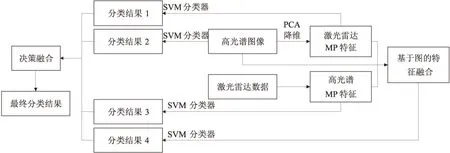

Ghamisi等[19]的工作是这种方法的典型代表(图 2).对激光雷达数据直接提取AP特征,对高光谱图像首先进行PCA降维,对提取到的前n个主成分分别提取AP特征.同时考虑到将所有特征向量进行拼接,就得到了融合后的特征.最后,采用支持向量机(support vector machine, SVM)和随机森林(random forest, RF)两种模型作为分类器,得到分类结果.

Pedergnana等[21]在完成AP特征的提取后,引入了遗传算法(genetic algorithm, GA)来进行特征选择,对特征进行优化和精炼.类似地,Ghamisi等[20],还提取了高光谱图像和激光雷达数据地EP特征,拼接后使用RF分类器进行分类.

基于形态学特征拼接的融合方法存在的主要缺点是拼接后的特征维度过高,同时给后续分类步骤带来较高的运算复杂度.由于这类方法将提取出的特征进行直接拼接,融合后的特征维度随着数据的种类线性增加,而训练的样本数量保持不变,因此给后续分类的数据处理带来一定的压力,且容易出现Hughes现象.为了解决上述问题,出现了低秩模型和复合核的方法,更加高效地融合高光谱和激光雷达数据.

图2 Ghamisi等的形态学特征拼接方法

1.2 基于低秩模型的融合方法

与特征拼接的融合方法相比,为了提高运算效率,避免特征维度过高带来的问题,同时考虑到高光谱图像中光谱信息存在一定程度的冗余,许多学者研究了采用低秩模型的融合方法[1,22],其主要思想是使用稀疏表示的方法将高光谱影像和激光雷达数据的特征从高维度映射到较低维度的空间中.该类方法的一般框架如图 3所示.特征提取部分和特征分类部分与特征拼接的方法类似,但在特征融合过程中,建立稀疏的低秩模型来表示特征,通过求解稀疏模型的系数,就实现了特征的降维.

图3 基于低秩模型融合方法的一般框架

Rasti等[1]提出了公式(1)所示的低秩模型来融合高光谱图像的光谱信息、高光谱图像的EP特征和激光雷达EP特征.

F=AVT+N,

(1)

其中F=F[f(i)]是融合后的n×p特征矩阵,V是未知的p×r低秩子空间基,A=A[a(i)]是被融合的特征,N=N[n(i)]是模型误差和噪声.高光谱的光谱特征和EP特征以及激光雷达EP特征在矩阵通过F=[FHSI,H,FLiDAR]的形式进行融合.

在公式(1)中,矩阵A和V都是未知的,需要进行估计.Rasti等[1]使用了正交全变分分析(orthogonal total variation component analysis, OTVCA)[24]对这2个矩阵进行估计,如公式(2)所示.

(2)

其中第二项,TV惩罚项用于融合空间特征,它保留了特征的空间结构,同时促进融合的特征分段平滑.

在基于低秩模型的另一个典型方法中[22],作者采用了稀疏低秩成分分析(sparse and low-rank component analysis, SLRCA)的方式进行特征融合.首先对两种数据提取EP特征,然后使用稀疏低秩模型[25]进行特征融合,如公式(3)所示.

F=DWVT+N,

(3)

其中F=[FHSI,H,FLiDAR],FHSI和FLiDAR分别是从高光谱和激光雷达数据中提取到的EP特征,H是高光谱影像的光谱维度上的信息.D是包含2D小波基的n×n矩阵,W=[w(i)]是包含第i个融合分量的二维小波系数的n×r矩阵.之后再使用稀疏和低秩成分分析方法[25-26]估计W和V,如公式(4)所示.

(4)

基于低秩模型的融合方法通过稀疏表示的手段,在特征融合的同时能够对数据进行有效地降维,大大降低了后续分类任务的运算复杂度.但常用的稀疏表示手段难以拟合光谱信息和地物特征之间的非线性关系,并且在降维的同时往往伴随着信息的损失.

1.3 基于复合核的融合方法

基于复合核(composite kernel)的融合方法核心思想同样是对特征进行降维,在低维空间进行融合.不同于低秩模型的方法,该方法采用另一种思路,通过将不同的特征空间的特征(包括激光雷达特征、高光谱图像中的光谱特征,和空间特征等)全部映射到核空间,如希尔伯特空间(Hilbert space),然后在核空间内进行融合[27].由于融合的信息包括光谱、空间邻域、纹理、高程等复合信息,因此称为复合核,其一般框架如图4所示.

图4 基于复合核融合方法的一般框架

Zhang等[28]提取了高光谱图像和激光雷达数据的消光特征EP后先进行局部区域滤波(local-region filter, LRF)减少类内光谱差异和固有噪声,再使用复合核的方法进行特征融合,其复合核的表示如公式(5)所示

K(xi,xj)=μKs(xsi,xsj)+(1-μ)Kw(xwi,xwj),

(5)

其中xsi,xsj代表提取出的空间EP特征,xwi,xwj代表光谱EP特征,Ks(·)和Kw(·)分别是将2种特征映射到核空间的核函数,μ是用于调整融合中两部分比重的参数.

Khodadadzadeh等[29]采用了更为灵活的融合方法,基于AP特征提取和空间多项逻辑回归(subspace multinomial logistic regression, MLRsub)分类器,将待学习的特征的权重迁移到分类器的权重,无需正则化参数,从而减轻多特征学习任务中的工作量.

Zhang等[30]提出了一种用于多源数据融合的联合稀疏表示分类技术(adaptive locality weighted multisource joint sparse representation classification, ALWMJ-SRC),该方法的核心思想是基于稀疏表示进行分类.其中多种数据源采用多源稀疏表示的方法,使用字典的方法一同映射到低维子空间,得到数据的稀疏特征,再稀疏表示的过程中引入自适应权重用于更好地表示数据的局部特征.然后利用核希尔波特变换(kernel Hilbert transform)将特征变换至核空间,使用子区域的每个样本与其稀疏表示之间的最小二范数距离用于分配该类别的标签,从而完成分类.

Ge等[31]对高光谱图像和激光雷达数据分别提取EP特征和局部二值模式(loacal binary pattern, LBP)特征,将计算出的特征用KCRT-NF(kernel collaborative representation with tikhonov regularization - neighborhood filtering)计算残差.将光谱信息、HSI的特征、LiDAR的特征3部分计算出的残差进行特征-决策级融合,通过融合后的残差得到分类结果.

基于复合核的方法针对特征拼接的方法维度过高的问题,采用核空间变换的方式进行降维,其融合方式也是行之有效的.但这类方法存在的一个问题是模型精度受参数影响非常大,如Zhang等[28]的方法中参数μ的小幅改变可能对结果产生较大的影响.

1.4 基于图结构的融合方法

基于图结构的方法也是对特征进行融合与降维的有效方式之一[32].由于图结构能够很好地表征节点之间的连接关系,因此更利于同一类别间的相似像素进行聚合,在特征融合的过程中缩小类内方差.一般的方法是将特征拼接后作为图的节点特征矩阵,根据高光谱和激光雷达数据中像素间的相似性使用K近邻(k nearest neighbor, KNN)方法建立邻接矩阵,从而完成图的建立.得到图以后,运用图拉普拉斯特征方法,计算出拉普拉斯矩阵,就完成了特征的降维.

Debes 等[2]的方法在这类工作中具有一定的代表性.他们首先提取高光谱图像和激光雷达数据的MP特征,以及高光谱图像本身的光谱特征,将这三者使用基于图的特征融合方法进行融合.分别在3个特征空间建立图,以光谱特征为例,建立的图为Gspe=(Xspe,Aspe),其中Xspe代表空间维度提取出的特征,Aspe代表根据每个像素光谱特征之间的相似度建立的邻接矩阵,如果像素xi和xj之间的光谱信息处于k近邻范围内,那么Aspeij=1,否则Aspeij=0.按照相似的方式,建立空间特征图Gspa=(Xspa,Aspa)和高程特征图Gele=(Xele,Aele).那么融合后的图可以表示为GD=(Xsta,Afused),Afused定义为:

AFus=ASpe⊙ASpa⊙AEle,

(6)

其中⊙代表逐元素相乘,Xsta=[Xspe;Xspa;Xele]代表光谱特征、空间MP特征和高程MP特征的拼接.基于融合后的图Gfused可以计算出其拉普拉斯矩阵:

Lfused=Dfused-Afused,

(7)

进一步地,Liao等[33]提出了高光谱和激光雷达数据的决策融合方法,其方法框架如图 5所示,共提取了4种特征:高光谱图像的光谱信息、高光谱图像的MP特征、激光雷达数据的MP特征以及对前三者基于图的方法融合后的特征,其中融合方法与Debes 等[2]的融合方法类似.得到4种特征后,将每一种特征分别输入SVM分类器进行分类,对4个分类结果采用加权和投票机制的方式进行融合,得到最终的分类结果.

图5 Liao等提出的决策融合方法框架

Liao等[34]还提出了另一种基于图的特征融合方法,半监督图融合方法,使用数据集中有标签的像素和无标签的像素分别约束样本的类内相似度和空间相似度.Xia等[35]在特征融合的过程中也加入了半监督图的方法.提取高光谱影像和激光雷达数据的MP特征后,再加上每个像素点的光谱信息,将这3个特征一同投影到低维子空间得到融合后的特征.在投影的过程中建立半监督的图,根据相同类别的节点间建立边,进而指导特征融合的过程.

基于图理论,Iyer等[36]将高光谱图像和激光雷达数据的每个像素点作为一个节点,建立了边的权重大小和相似度正相关的图.在此基础上,计算图的拉普拉斯矩阵的特征向量作为节点的特征,在这些特征上使用数据分割算法(如谱聚类等)得到最终的分类结果.Gu和Wang[37]提出了判别图融合(discriminative graph-based fusion, DGF)方法,结合了降维和异构特征融合,在激光雷达数据和高光谱影像空域和频域分别建立图,通过相似性度量将图融合,最小化类内相似度,最大化类间相似度将不同类别的样本分开.

由于建立图的过程考虑到了所有节点的连接关系,因此图结构的优势在于能够对整个数据集中所有相似的节点进行聚合,从而更好地考虑全局信息.伴随而来的是运算复杂度的增加——建立图的过程需要对所有节点两两之间计算相似度,该过程中运算量较大,耗时较多.

2 基于深度学习的方法

2.1 深度特征拼接的融合方法

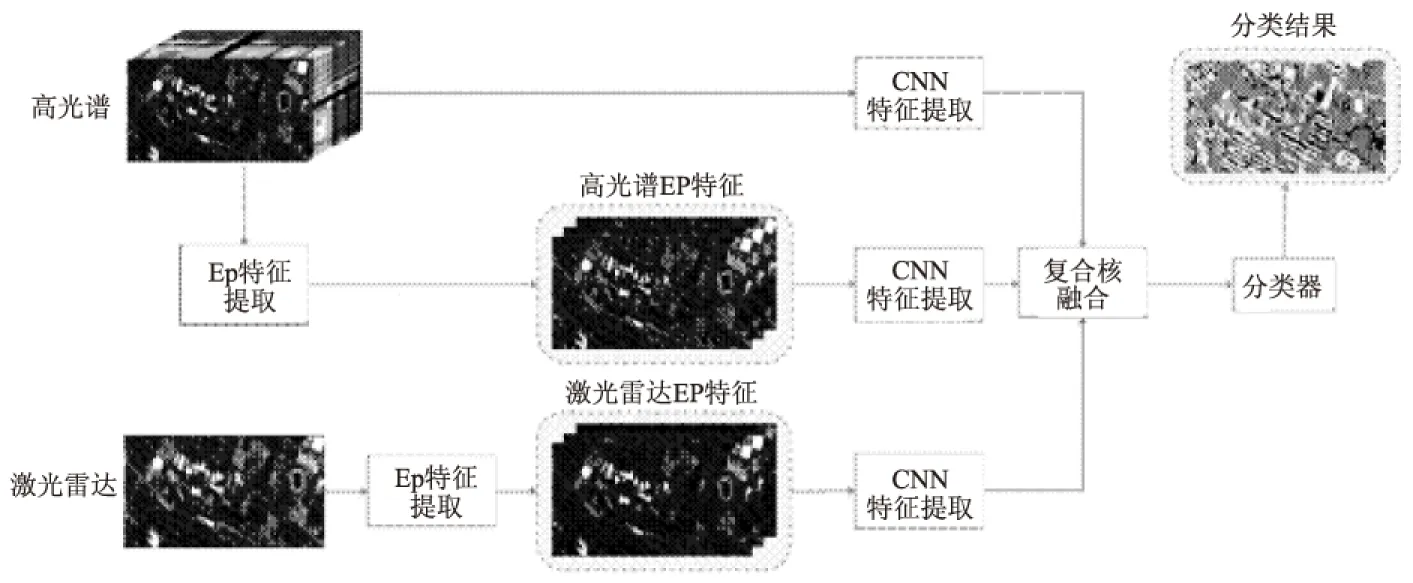

深度学习是遥感领域中一个快速发展的方向,在激光雷达和高光谱数据融合的领域也出现了大量的应用.深度神经网络的特征提取思路不同于边缘、纹理、形态学特征等传统特征提取,是通过大量的神经元学习一系列的模型参数,在整个网络上完成特征提取与分类.在使用单一数据源进行分类时,一般的方法是使用卷积神经网络(convolutional neural network, CNN)提取图像的深度特征,然后再用多层感知机(multilayer percseptron),即全连接网络和softmax函数作为分类器,对提取出的深度特征进行分类.将这种方法迁移到高光谱数据和激光雷达数据的融合上,最直接的思路就是类似Chen等[38]的方法(如图 6所示),使用两路CNN网络分别提取2种数据的深度特征,将提取出的2种特征进行拼接,再使用逻辑回归(logistic regression)或全连接网络作为分类器对特征进行分类,得到最终的分类结果.

图6 Chen等提出的深度融合框架

进一步地,基于类似的框架,Xu等[39]提出了另一种基于CNN的融合方法,双分支CNN网络(图 7至图 9).与文献[38]类似,2种数据分别使用CNN提取特征,但不同的是Xu等[39]引入了新的网络结构,在高光谱分支增加了空间通道和光谱通道的融合,激光雷达分支增加了级联模块以提升对邻域特征的提取能力.结构对称的CNN网络提取2种数据的特征,对两者的特征进行拼接后使用全连接网络作为分类器实现场景的分类任务.

图8展示的是高光谱分支的网络结构,该部分又分为2个小分支:空间分支和光谱分支.其中空间分支采用的是二维卷积、池化的操作,提取高光谱图像中1个方形区域内的空间特征,光谱分支提取空间分支中心点像素对应的光谱信息,对该信息做一维卷积,这2个小分支提取到的空间特征和光谱特征进行拼接,就得到了高光谱图像的整体特征.在激光雷达分支中(图 9),加入了级联模块(cascade block)用于提取激光雷达数据的多尺度特征.

图7 双分支CNN网络整体结构

图8 高光谱分支的网络结构

图9 激光雷达分支的网络结构

2.2 深度特征核空间融合的方法

与1.3节中介绍的形态学特征基于复合核的方法类似,深度特征同样可以变换到核空间进行降维.典型的例子是Ghamisi等[40]使用了如图 10所示的三分支卷积神经网络融合框架.

所谓三分支指的是光谱特征,空间特征和高程特征3种特征的3条提取路线.该方法首先对高光谱图像和激光雷达数据提取形态学的EP特征,在EP特征的基础上再使用CNN网络进一步对特征进行精炼.同时,高光谱图像各个像素的光谱信息也使用CNN网络进行特征提取.各分支的CNN网络结构如图 11所示.

经过3条CNN网络输出的光谱、空间和高程特征分别为xspei,xspai,xelei,用Φ1(·),Φ2(·),Φ3(·) 表示对3个特征进行的希尔伯特变换,将其分别变换到希尔伯特空间H1,H2,H3,有如下变换:

Φ(xi)={Φ1(x(spe)i),Φ2(xspai),Φ3(xelei)} .

(8)

在希尔伯特空间中,特征以点积的形式进行融合,如公式(9)所示.

K(xi,xj)=[Φ(xi),Φ(xj)]=Kw(xwi,xwj)+KS(xSi,xSj)+Ke(xei,xej).

(9)

最后作者采用了支持向量机SVM和极限学习机(extreme learning machine, ELM)两种分类器分别进行分类,取得了较好的效果.

图10 三分支卷积神经网络

图11 3条分支的网络结构

3 总结与展望

将现有的高光谱图像和激光雷达数据融合方法归纳总结成表格,如表1所示.

从表 1中可以看到,传统的基于形态学特征的方法中,最简单而直接的方法是特征拼接的方法,直接将特征以向量的形式拼接再进行后续分类任务.针对其特征维度过高的缺点,出现了低秩模型、复合核以及图结构的特征融合方法,均能够在融合的过程中起到降维的作用.其中低秩模型采用稀疏表示的方法,降维效果好,但可能存在较多信息损失,难以拟合非线性关系;复合核的核空间变换方法运算复杂度较低,但分类精度受模型参数影响较大,易受参数影响;图结构的融合方法采用另一种思路,借用图结构特征提取范围大的特点,能够获取更多的全局信息,但计算邻接矩阵的过程可能引入较大的计算量.基于深度学习的方法能够应对复杂的地物信息,通过深层网络提取高维度、抽象的语义特征,对复杂的数据集能够起到更好的效果,达到更高的分类精度.同时,深度学习方法往往需要大量的标记数据进行训练,在实际应用情况下可能会受到限制.

表1 高光谱图像和激光雷达数据融合方法优缺点对比

在高光谱和激光雷达数据的融合工作中,现有的方法在常见的公开数据集上已经取得了很好的效果,达到了较高的精度.未来的研究趋势可能在以下方向开展.

1) 深度学习方法成为主流.深度学习相比于传统特征提取方法具有强大的深层语义特征挖掘能力,这类方法将会是未来发展的主要方向,尤其是结合迁移学习(transfer learning)、元学习(meta learning)等方法,开展多时相、跨场景识别等任务,探索更加合理的融合方式,充分发掘高光谱和激光雷达数据包含的信息.

2) 基于图模型的方法是一个备受关注的领域.在遥感图像处理领域,传统的深度学习方法大多采用卷积神经网络,而近年来基于图模型进行卷积运算,做特征提取的方法已经在自然图像处理领域取得了一些显著的成果.图模型的特点是对全局信息的提取能力较好,相比于卷积神经网络不需要堆叠许多卷积层来获得更大的感受野,从而能够以更少的参数来达到相同甚至更高的分类精度.在高光谱和激光雷达图像的处理中,全局信息对分类精度起着重要的作用,能够弥补局部特征的不足,因此将图模型和深度学习方法结合,构建基于图模型的深度网络会在该领域得到很好的应用.

3) 研究新的特征融合方法.无论是基于形态学特征或是深度学习,其完成的核心任务是特征的融合,融合的方法也具有一定的相似性.从表1中可以看到,基于深度学习的特征融合方法相比于传统的形态学特征融合方法还较为单一,以特征拼接与核空间融合为主.CNN网络本身具有降维的作用,因此深度特征融合的关键不在于降维,而是如何尽可能有效地将信息提取出来,针对高光谱和激光雷达数据的特点优势互补,提高分类精度.

4) 激光雷达数据中包含的信息还有待进一步发掘和利用.现有的研究工作中,高光谱中丰富的光谱信息对地物分类起到主导作用.实验表明,仅使用高光谱数据进行分类达到的精度要远高于仅使用激光雷达数据的分类精度[1].激光雷达包含的深度信息结合图像二维坐标能够提供丰富的空间和形状信息,充分利用这些信息能够对分类任务起到重要的作用.高精度的激光雷达还可以重建出场景的三维模型,基于这些三维形状信息本身就可以实现高精度的分类、分割、检测等任务.例如PointNet[41]、PointGrid[42]等深度网络框架可以在仅使用三维信息的情况下完成场景的分类和语义分割.但现有工作中,鲜有人针对激光雷达的数据特点设计数据处理方法,整体方法框架依然以高光谱图像为主.因此激光雷达数据包含的信息还有待进一步发掘,以减少对光谱信息的依赖.

5) 小样本学习、迁移学习等对数据标注要求较低的方法发展迅速.深度学习往往需要大量的标注数据进行训练,而在遥感领域,数据标注的工作需要大量的人工成本,费时费力.因此弱监督、无监督学习的优势逐渐体现出来.基于此,未来的发展方向可能会向小样本学习、零样本学习的方向发展,以减少对数据标注的依赖.在这方面,迁移学习也具有一定的优势,在现有的标注好的数据集上进行训练,在新的数据上进行微调与测试,同样可以减轻数据标注工作的负担.