融合深度学习与外极线约束的三维人体位姿测量方法

2020-04-12宋丽梅吕昆昆杨燕罡

宋丽梅,吕昆昆,杨燕罡

(1.天津工业大学 电气工程与自动化学院 天津市电工电能新技术重点实验室,天津 300387;2.天津职业技术师范大学 机械工程学院,天津 300222)

引言

为设计更符合我国驾驶员人体工学的汽车座椅,需采集大量汽车座椅上人体的三维数据。目前人体关节点采集方式主要是基于二维图像和三维点云[1-3]。

赖军等人[4]提出的基于点云的人体尺寸测量方法能够精确获取人体关键尺寸,但需粘贴标记点。朱欣娟等人[5]提出的基于改进ASM(active shape model)的人体特征点定位和建模方法具有定位精度高、测量速度快的优势,但需要被测者保持特定的姿态。鲍陈等人[6]提出的基于散乱点云三维姿态测量方法精度高,但需被测者保持直立姿态。Deng J 等人[7]提出的堆叠沙漏网络(stacked hourglass)能够适应不同的测量场景。Shen C 等人[8]在堆叠沙漏网络基础上提出的生成对抗网络(generative adversarial network,GAN)在识别精度上提高了0.2%。Kaiming H 等人[9]提出的Mask R-CNN网络耗时长且精度受待测场景复杂度影响大。SIMON T 等人[10]提出利用自底向上进行关节点识别的模型OpenPose,该模型能准确获取人体二维关节点坐标并利用PAF 方法[11]提取人体骨架。基于深度学习的二维关节点检测方法耗时短、精度高,但缺乏深度信息,无法满足设计的需求。

针对上述问题,本文设计了融合深度学习和外极线约束的三维关节点获取方法。在保留了深度学习二维关节点检测方法精度高、耗时短优势的同时也能获取关节点的三维信息。

1 二维关节点提取网络

现有二维关节点提取网络主要分为基于回归和基于检测2类,基于回归的网络检测精度较高,但其受待测场景影响较大且耗时较长。基于检测的网络通过输出关节点热图来获取关键点位置,检测速度快,但无法排除误检点的影响[12]。实际应用中,通常将关节点热图和回归网络相结合,提高网络检测效率。

1.1 网络结构

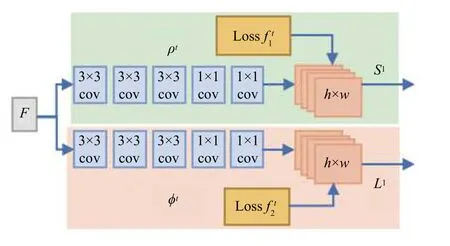

网络的初始化阶段分为关节点位置初始化ρ1和肢体初始化 ϕ1,如图1所示。

该阶段采用VGGNet-19 网络前10 层的输出作为输入,经过卷积处理最终得到与输入图像大小相同的掩模图像,2个初始化阶段的处理过程分别如公式(1)和公式(2)所示。

图1 初始化网络结构示意图Fig.1 Structure of initialization network

网络核心阶段主要用来获取关节点和肢体的准确位置,如图2所示。

图2 核心网络结构示意图Fig.2 Structure of core network

该阶段采用VGGNet-19 网络前10 层的输出及前一层关节点和肢体检测网络的输出作为输入,通过卷积运算得到修正后的掩模图像。处理过程如公式(3)和公式(4)所示。

1.2 损失函数

由于采用双通道网络,因而采取双损失函数进行网络训练,损失函数分别如公式(5)和公式(6)所示。

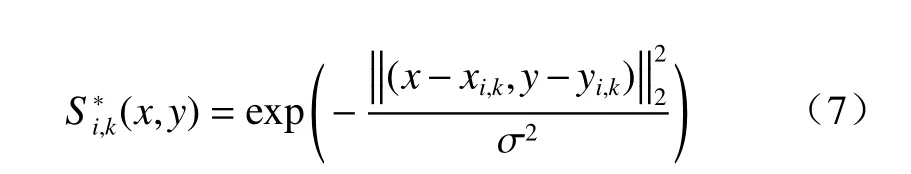

式中:I、J分别表示St、Lt特征图中特征关节点和肢体的数量;(x,y)为特征点的位置;W(x,y)表示二值化函数;Sti(x,y)和Lt j(x,y)分别代表第t次迭代时St、Lt掩模图上各点像素值;Si*(x,y)、L*j(x,y)分别代表关节点和肢体的真值置信图,其中S*i(x,y)可由公式(7)获取。

L*j(x,y)表示图像中肢体的位置,其计算过程由公式(8)和公式(9)共同决定。

式中:nc(x,y)表示非零向量L*j,k(x,y)个数。

2 人体三维位姿测量方法

2.1 基于外极线约束的双目三维数据获取方法

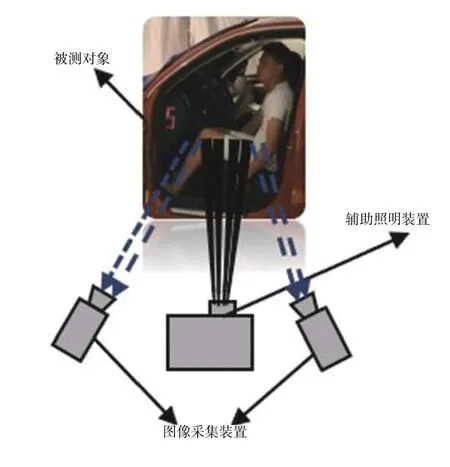

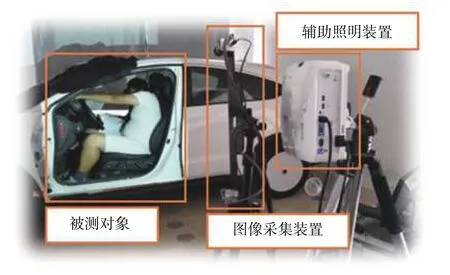

文中采用如图3所示的双目系统进行数据采集,系统包含2个工业相机和1个辅助照明投影仪。

图3 双目采集装置结构示意图Fig.3 Structure of binocular acquisition device

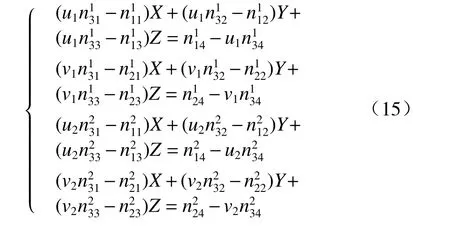

假设某一关节点的三维坐标为[X,Y,Z,1]T,其在左右相机成像平面的坐标分别为[u1,v1,1]T和[u2,v2,1]T。经双目相机标定后可分别获取左右相机的内参矩阵Ml、Mr及其旋转矩阵Rl、Rr和平移矩阵Tl、Tr。根据世界坐标系和相机成像坐标系的转换关系,上述参数满足公式(10)和公式(11)。

为了简化后续描述,做如公式(12)的假设。

将公式(12)分别代入公式(10)和公式(11),得到公式(13)和公式(14)。

联立公式(13)和公式(14)可得公式(15)。

从二维关节点获取三维关节点的过程可归结为公式(15)所示的方程求解问题。文中采用外极线约束补足漏检二维关节点,原理如图4所示[13]。

图4 外极限匹配示意图Fig.4 Schematic diagram of epipolar line matching

空间中某一点P(x,y,z)分别投影到左右相机成像平面Pl、Pr处,分别位于极平面POlOr与左右图像平面交线Plel和Prer上。

搜索过程中采用Brief特征作为待匹配特征,Brief特征描述算子是一种简单有效的特征提取方法,通过统计特征点 (x,y)周围S×S区域内N对像素点的像素变化,得到该点的特征表示[14]。提取Brief特征时,首先在特征点的邻域内按照公式(16)选取一对点 (xi,yi),i=1,2。

式中:N(µ,σ2)表示服从均值为µ ;方差为σ2的正态分布。

假设随机选取2点的像素值分别为a、b,则2点处的Brief特征可做如公式(17)的表示。

由于人体关节点位置接近,选取S=35 作为Brief特征算子的作用范围。考虑到关节点位置的像素较为相似,选取N=256 作为Brief特征算子的位数。文中采用汉明距离作为特征相似度衡量的指标,选取Brief特征相同位数最多的2个点作为匹配点对。

2.2 人体三维关节点数据获取流程

文中采用二维关节点提取网络获取左右相机图像中关节点位置,利用外极线约束和Brief特征获取左右相机图像中关节点的匹配关系,整个三维关节点获取流程如图5所示。

图5 人体三维关节点获取流程示意图Fig.5 Flow chart of 3-D joint point acquisition of human body

本文关节点提取方法,不仅保留了基于深度学习的二维关节点提取网络速度快、精度高的特点,并且采用双目采集装置与外极线约束相结合的方式提高了三维关节点检测效率。

3 实验结果与分析

综合考虑设备成本和采集效果,选取海康威视公司的RS_A1300_GM60_M10 相机和Computar系列的M0814-MP 镜头搭建文中的双目采集系统,选取BenQ 公司的E540系列投影仪作为辅助照明装置。系统构成如图6所示。

图6 人体姿态三维测量系统Fig.6 Human position 3D measurement system

双目标定采用的靶标及标定数据如图7所示。靶标圆心的水平距离为55 mm,竖直距离为51 mm。

图7 标定靶标及采集标定数据Fig.7 Calibrate target and collect calibration data

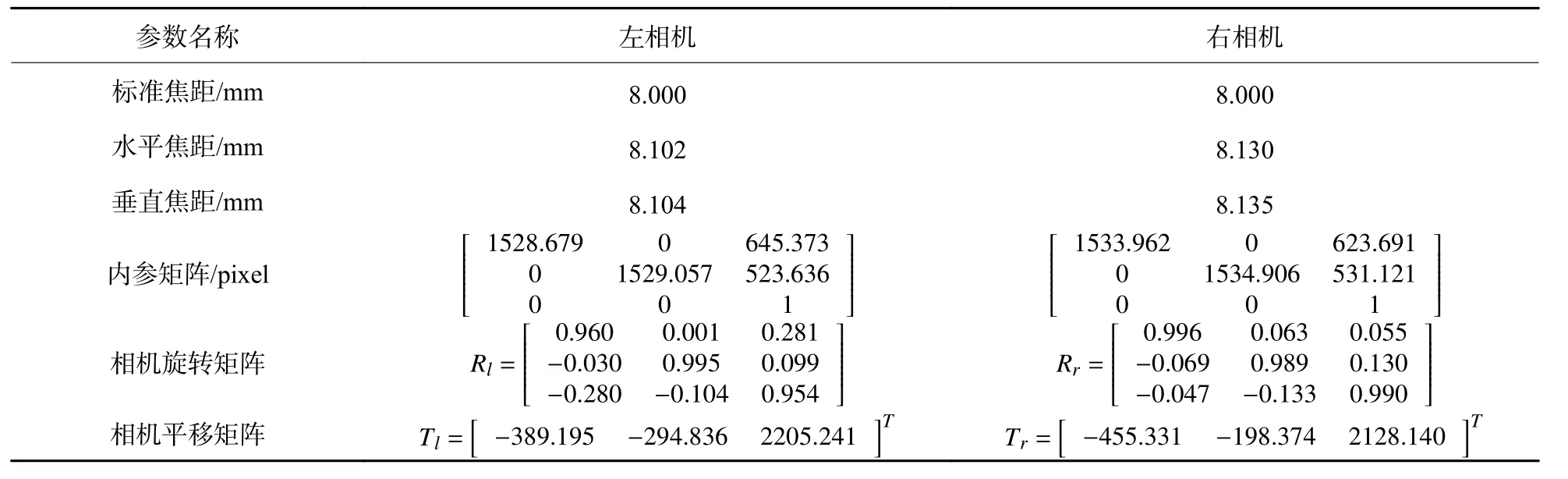

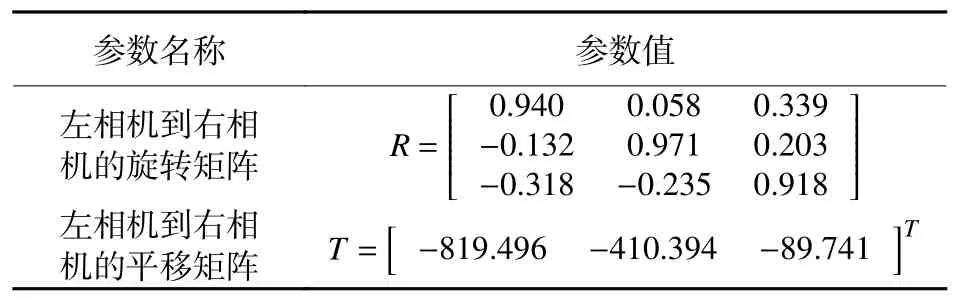

将5个不同位置的标定数据输入基于OpenCV 2.4.10 设计的标定程序[15],得到左右相机的内参,具体如表1所示。利用表1所得相机内参可得表2所示的双目相机外参。

通过统计水平和竖直方向上测量数据与真值数据的差异,得到系统的标定误差。计算过程如公式(18)所示。

表1 左右相机的内部参数Table1 Internal parameters of left and right cameras

表2 双目相机外部参数Table2 External parameters of binocular cameras

式中:yi为圆心距离的测量值;为圆心距离的标称值;N为测量数据样本数,文中水平方向误差评定时有N=10×9=90,竖直方向评定时有N=8×11=88,测量结果如图8所示。

文中所测量人体关节点如图9所示。

由于文中采集的待检测数据有限,选取COCO2017数据集作为本文的训练及验证数据。文中采用的训练测试数据构成如表3所示。

图8 双目三维测量系统立体标定误差Fig.8 Stereo calibration error of 3-D measurement system

图9 本文采集人体关节点位置示意图Fig.9 Position diagram of human joints collected in this paper

表3 二维人体关节点提取网络训练测试数据集构成Table3 Construction of dataset of human 2-D joint extraction network

训练过程中每隔10 张进行一次验证以获取训练过程中各项数据,通过选取不同核心网络循环次数t,得到如图10所示的训练结果。

由图10可知,当t=6时,网络具有较快的收敛速度和检测精度,实际使用中也选取t=6。为测试其在本文待测场景中的检测准确率,采集左右相机各50 张图像构成测试集,测试结果如图11所示(红色圈部位代表漏检关节点)。

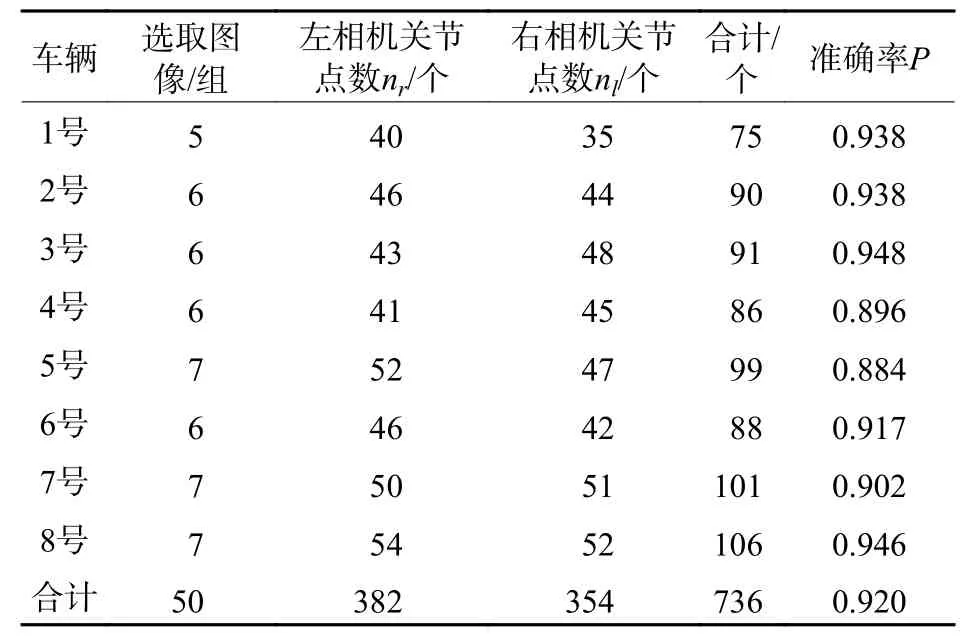

通过统计每辆车左相机和右相机检测情况,利用公式(19)得到二维关节点提取网络在整个测试集上的检测精度。

图10 COCO2017 数据集中的人体图像Fig.10 Human body image in COCO2017 dataset

图11 网络训练过程中精度值变化趋势Fig.11 Trend of precision during network training

式中:P为测试精度;n代表待测样本关节点总数;nr和nl分别表示左相机和右相机采集关节点总数,具体统计数据如表4所示。

由表4可知,二维关节点提取网络平均提取精度为92%,并且漏检往往发生在左右相机某一幅图中,因而可通过本文提出的基于外极线匹配的方法来获取漏检点的位置,进行缺失点补足后的二维关节点检测,结果如表5所示。

采用外极线约束和Brief特征后二维关节点检测精度从原来的92%增加到了98%。文中采用图12中 θ1、θ2、θ3对算法进行稳定性评价。

表4 左右相机关节点检测结果统计Table4 Joint point detection results of left and right cameras

表5 改进二维关节点检测结果统计Table5 Statistics of improved 2-D joint detection results

图12 左右相机不同的检测结果Fig.12 Different test results of left and right cameras

假设B(x1,y1,z1)、C(x2,y2,z2)、D(x3,y3,z3),根据余弦定理可知:

分别利用传统测量方法和本文方法获取40组三维关节点 坐标信息,计算待测关键角度 θ1、θ2、θ3,求取其均值和方差作为观测量,如表6所示。

表6 不同方法关键角度统计结果Table6 Statistical results of key angles of different methods

由表6可知,本文方法和传统方法所得θ1、θ3均值基本相同,但θ2测量结果存在较大偏差。驾驶情况下 θ2角度通常大于90°,因而传统方法测量结果存在较大偏差。本文方法稳定性较高,适用于汽车座椅上三维人体位姿数据的测量。

4 结论

对比传统关节点测量方法,本文提出了一种融合深度学习和外极线约束的人体三维关节点检测方法。该方法采用多阶段循环网络提取关节点二维坐标,利用外极线约束和Brief特征进行缺失关节点补足和匹配,最终获取人体关节点的三维信息。实验结果表明,本文三维关节点检测方法检测精度达到98%,并且相比传统三维关节点获取方法,该方法稳定性较高。目前该方法仍存在以下问题:1)二维关节点提取网络存在漏检,需搜集自采数据进行网络性能调节。2)采集系统对环境光线要求较高,后续需增加多组补光装置,保证采集环境光线波动较小。