基于迁移学习及特征融合的现勘图像检索算法

2019-11-25高梓铭彭亚楠李大湘刘红燕

高梓铭, 彭亚楠, 刘 颖, 李大湘,刘红燕, 程 美, 朱 丽

(1.西安邮电大学 图像与信息处理研究所, 陕西 西安 710121;2.电子信息现场勘验应用技术公安部重点实验室, 陕西 西安 710121)

刑侦现场勘验(现勘)图像是刑侦部门在案发现场获取与案件相关的图像,是现场勘验信息的重要组成部分。现勘图像分类检索可为刑侦破案提供重要线索,并在串并案中起到重要作用[1]。因此,迫切需要一种自动、有效的现勘图像分类检索系统,以快速地从大量现勘图像中找到相关图像,以提高刑侦部门的工作效率、节省人力物力资源。

现勘图像涉及实际案件,数据来源特殊,国内外关于现勘图像检索的研究方面报道相对较少。目前的现勘图像检索技术可分为两大类:基于低层特征的现勘图像检索和基于高层语义的现勘图像检索[1]。基于低层特征的现勘图像检索技术了采用基于内容的图像检索(content-based image retrieval, CBIR)框架,通过提取图像低层特征,如颜色直方图、灰度共生矩阵、Gabor特征、小波纹理特征等,或者不同低层特征的融合特征进行图像检索,实验结果证实了CBIR技术在刑侦现勘图像检索中的可行性[2]。针对现勘图像提出采用图像主导颜色描述符来作为颜色特征,灰度共生矩阵来作为纹理特征并结合梯度向量流获得的现勘图像边缘来构成现勘图像的低层特征向量进行检索[3],也得到了较好的检索效果。其缺点是计算比较复杂, 提取图像特征耗时较多。也有针对现勘图像提出基于区域语义模板的图像检索方法[4],该方法依据用户提交查询图像及感兴趣区域,构建区域语义模板并进行预分类,最终进行图像排序,实验证明此算法在提高刑侦现勘图像的查准率方面是有效的。还有一种两层体系现勘图像检索框架,该框架首先计算现勘图像数据库对应的特征数据库,预先训练一个可实现多语义分类的支持向量机分类器模型[5]。在提交检索图像后,支持向量机(support vector machine, SVM)根据图像特征自动判定其语义类别,然后在仅包含该语义的图像库上进行匹配检索。实验结果表明,该方法在多个检索指标上优于按例查询(query by example, QBE)的方法,其检索时间约为QBE方法的一半。将相关反馈引入到现勘图像检索中也是一种有效的手段,如文献[6]在比较输入鞋印图像的特征与图像特征库中特征时引入了人工反馈,利用人工判断参与比较的鞋印图像是否有残缺, 对于残缺部分通过积分直方图计算出残缺图像在完整图像中的最相似区域位置, 再提取该区域的特征,最后进行相似度计算。虽然上述方法取得了一定效果,但是这类传统图像检索方法中的“语义鸿沟”问题仍严重影响图像检索的准确率。

随着2006年Hinton等人提出深度学习技术[7]后,深度学习得到迅速的发展,至今深度学习的框架已有数种,如卷积神经网络(convolutional neural network, CNN)、深度信念网络等,已经广泛应用于数字识别、图像分类和人脸识别等领域上,并且获得了前所未有的成功。深度学习在图像分类与检索领域有着广泛的应用。如在ImageNet比赛中,2010年采用传统分类器的准确率(top 5精度)是71.8%,2011年是74.3%。而在2012年,Hinton等人将深度学习技术的准确率提高到84.7%,而在2017年的比赛中最终准确率更是高达97.7%[7]。Babenko[8]和Donahue[9]分别提取CNN的全连接层的特征作为高层语义特征进行检索,也可以从卷积层提取图像特征进行检索[10],均获得了良好的检索效果。Carvajal等人[11]通过对3种预训练模型进行微调并提取输出层的前一层特征进行了蝴蝶种类的检索,也获得了很好的结果。

CNN在图像分类检索方面的优异表现依赖于大量的训练数据,然而,现勘图像数据源特殊,相关文献显示目前学术界并没有标准的大型现勘图像数据库。西安邮电大学图像与信息处理研究所多年来与公安部门合作,整理出了目前学术可用的最大的现勘图像图像库,包含19363幅多种类别的图像[12]。为了将CNN在一般图像检索上的优势应用到现勘图像检索中,本文将利用迁移学习提取的CNN特征与低层特征融合,以期可充分利用CNN在深度语义特征提取方面的优势,同时考虑适用于该数据库的低层特征,从而能有效提高现勘图像检索效率。

1 基于CNN与低层特征融合的现勘图像检索算法

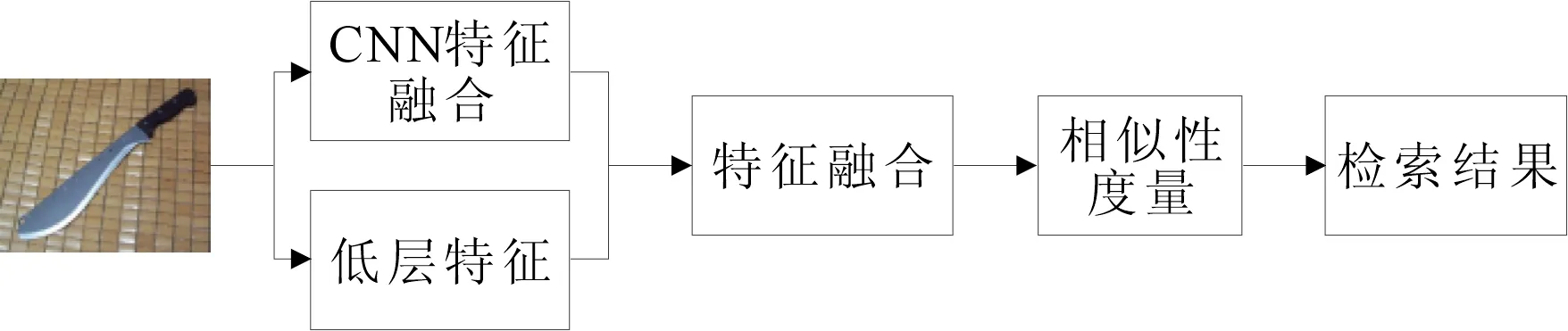

为了克服低层特征在检索时候的语义鸿沟问题,本文采用将CNN特征与低层特征融合方法,同时,为了弥补单个CNN模型的不足,将从两个CNN模型提取的特征进行融合之后,再与适合该图像数据库的低层特征融合,以此来更全面的描述图像,其算法流程如图1所示。

图1 基于CNN与低层特征融合的 现勘图像检索算法流程

1.1 CNN特征提取

CNN特征提取按照预训练CNN模型的迁移、微调CNN模型和CNN特征提取与融合等3个步骤进行,下面将描述各步骤的具体过程。

1.1.1 预训练CNN模型的迁移

CNN特征在图像分类和检索中取得了很大的成功,其重要原因在于其依赖大量的训练数据,可以训练出有效的CNN。但是,现勘图像检索方面,由于数据的缺乏使得卷积神经网络的训练容易过拟合而无法达到理想效果。为此,可以将在ImageNet数据集上学习到的一些CNN模型迁移到刑侦图像的学习任务中。

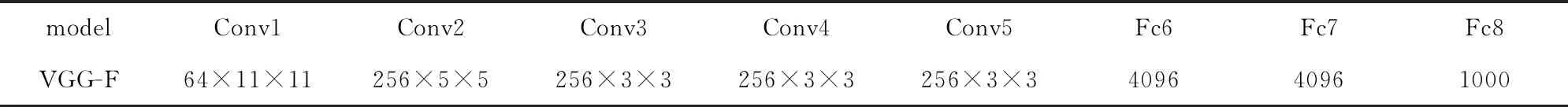

目前,有很多著名的预训练模型,如AlexNet、视觉几何组[13](visual geometry group,VGG)和VGG-VD[14](VGG very deep convolutional network )被成功地运用在场景分类[15-16]和图像检索[8,15-17]等各个方面。VGG网络包括的CNN模型有VGG-F、VGG-M 和VGG-S等预训练模型, 它们具有相似的结构,只有卷积层中滤波器的数量和大小稍有差别。本文选择VGG-F作为预训练模型,其共有8层,包括5个卷积层,3个全连接层,具体结构如表1所示。

表1 VGG-F模型结构

VGG-VD是一个深度CNN网络,包括VD16(共16层,其中13个卷积层和3个全连接层)和VD19(共19层,其中16个卷积层和3个全连接层)。本文选择VGG-VD16作为预训练模型,其具体结构如图2所示。

图2 VGG-VD 16结构

1.1.2 微调CNN模型

通常情况下,目标任务的图像集与预训练图像集无论是类别数量还是图像样式都存在很大差别。在目标图像集的检索任务中,直接用预训练的CNN模型提取图像特征往往难以达到最优的性能[18]。因此,为了使预训练的CNN模型参数更好地适用于目标图像集的特征提取,采用目标图像集的图像对预训练的CNN模型参数进行微调。下面将说明具体微调过程。

步骤1图像库中的每张图像均被调整到像素为224×224,作为CNN的输入。

步骤2对于第1到第7层,即conv1—fc7,利用预训练模型的参数对其进行初始化,然后将预训练CNN模型的最后一层全连接层的输出类别数目设置为本文图像类别数,并重新进行训练。最终形成适合自己学习任务的CNN模型。

1.1.3 CNN特征提取与融合

考虑到模型总共有3个全连接层,前两个全连接层被用作特征提取器,最后一个全连接层连接分类器用来进行分类。因此,如果从两个CNN模型中提取第二个全连接,则fc7层的输出作为图像的特征分别为4096维。若直接进行融合,融合特征将具有相当高的维数,高维特征将导致计算复杂度高,耗时多,内存占用率高,这对于检索实时性是很大的阻碍。但是,考虑到这些特征之间往往存在着一定的相关性和信息冗余,因此,在融合前,利用主成分分析法[19](principal components analysis, PCA)对两个模型所提取的特征降维至128维,然后再进行融合。融合特征F表示为

F-CNN=[w1fCNN1,w2fCNN2],

(1)

式中fCNN1表示从VGG-VD 16模型中提取的fc7层特征,fCNN2表示从VGG-F模型中提取的fc7层特征,w1,w2分别为对应特征的权重,其取值实验结果给出。将两个降维后的特征进行级联,这样不仅保证了特征的有效性,还极大地减少了计算量,节省了内存,又可以在保证正确率的情况下做到实时检索。

1.2 低层特征提取

图像底层特征与深度特征在描述图像内容时具有互补性,为此针对现勘图像低层特征的测试结果[12],本文选取以下4种图像低层特征。

1.2.1 HSV颜色直方图

颜色直方图是描述图像颜色信息的基本特征,它反映的是不同色彩在整幅图像中所占的比例,即各个颜色出现的频率,其计算公式为

(2)

式中,n(k)是图像中具有特征值为k的像素的个数,N是图像像素的总数,k表示图像的特征取值,k=0,1,…,L-1,L是特征可取值的个数。

考虑到HSV颜色空间更符合人眼感知,因此,本文实验将图像转换到HSV颜色空间,并对H、S、V三通道分别进行20、10、5的非等级量化,最终形成1000维的颜色直方图[20]fHSV。

1.2.2 Gabor特征

Gabor小波与人类视觉系统中简单细胞的视觉刺激响应非常相似,在提取目标的局部空间和频率域信息方面具有良好的特性,本文使用Gabor滤波来抽取图像的纹理信息[21]。Gabor特征提取步骤如下。

(1)建立Gabor滤波器组。选择4个尺度,6个方向,组成24个Gabor滤波器。

(2)Gabor滤波器组与每幅图像在空域卷积,每个图像可以得到24个滤波器输出,这些输出是图像块大小的图像。

(3)提取每一个滤波器输出的均值和方差作为图像的纹理特征fGabor,共48维。

1.2.3 DCT波

离散余弦变换(discrete cosine transform,DCT)是经典的图像频域信息分析工具,常用于图像纹理特征提取。小波(wavelet)是通过时间频率分析,将数据或信号分解成不同频率分量的数学函数。通过小波变换可以分析不连续和尖锐的信号。将Kekre变换矩阵生成的Kekre’s Wavelet(Kekre波)作用在DCT系数矩阵上,能够得到DCT Wavelet(DCT波)。Kekre变换矩阵[22]可表示

(3)

Kekre变换矩阵是任意N×N矩阵,本文采用16×16的Kekre变换矩阵来构造162×162的Kekre波矩阵。在得到Kekre波矩阵之后,将Kekre波矩阵与正交变换的DCT变换系数相运算,得到的DCT波为

F=kwd(kw)T,

(4)

其中,kw为Kekre波矩阵,d为DCT变换系数,F为最终得到的DCT波。

本文将现勘图像分为4块,对每一小块的R、G、B三通道进行DCT变换;将得到的DCT变换矩阵与Kekre波矩阵进行运算得到DCT波系数;计算DCT波系数的均值、方差,构成每一小块的特征向量;最后将所有小块的特征向量串联形成整幅现勘图像的纹理特征,共24维fDCT[12]。

1.2.4 GIST空间包络特征

GIST模型最早由Olive提出,GIST特征是一种生物启发特征, 该特征模拟人的视觉提取图像中粗略但简明扼要的上下文信息。GIST描述子用一系列统计属性来来量化图像场景,如自然度、开放度、粗糙度、膨胀度、险峻度。GIST特征的提取步骤如下。

(1)将一幅大小为h×w的图像划分为n×n个网格区域,每个网格区域的大小为h′×w′,其中,h=h/m,w′=w/n。

(2)每个区域与拥有m尺度n方向的Gabor滤波器进行卷积得到nc=mn个通道的Gabor响应结果,再将每个通道的结果级连起来得到Gabor特征,计算过程为

(5)

其中i=1,2,…,na×nb,gmn(x,y)表示具有m个尺度n个方向的Gabor滤波器,cat 表示将每个通道的响应结果级联。

(3)计算每个区域的Gabor特征的均值并级联得到GIST特征fGIST。

1.3 特征融合

为了获得更具区分性的特征以及更全面的描述图像,将上述深度特征和低层特征进行融合,可得到融合特征F′为

F′={w1fCNN1,w2fCNN2,w3fGIST,w4fHSV,w5fGabor,w6fDCT},

(6)

其中,fCNN1表示从模型VGG-F中提取的CNN特征,fCNN2表示从模型VGG-VD 16中提取的CNN特征,fGIST表示GIST特征,fHSV表示HSV颜色直方图,fGabor表示Gabor特征,fDCT表示DCT波特征。wf=[w1,w2,w3,w4,w5,w6]表示特征权值向量,具体的值将在实验结果部分给出说明。

2 实验结果与分析

2.1 实验数据库

实验采用两个数据库来测试所提出的算法并采用MatConvNet[23]来实现本文算法。MatConvNet是一个MATLAB工具箱,提供了计算机视觉的卷积神经网络。 它简单、高效。许多预训练的CNN网络可以用于图像分类,分割,面部识别和文本检测等。

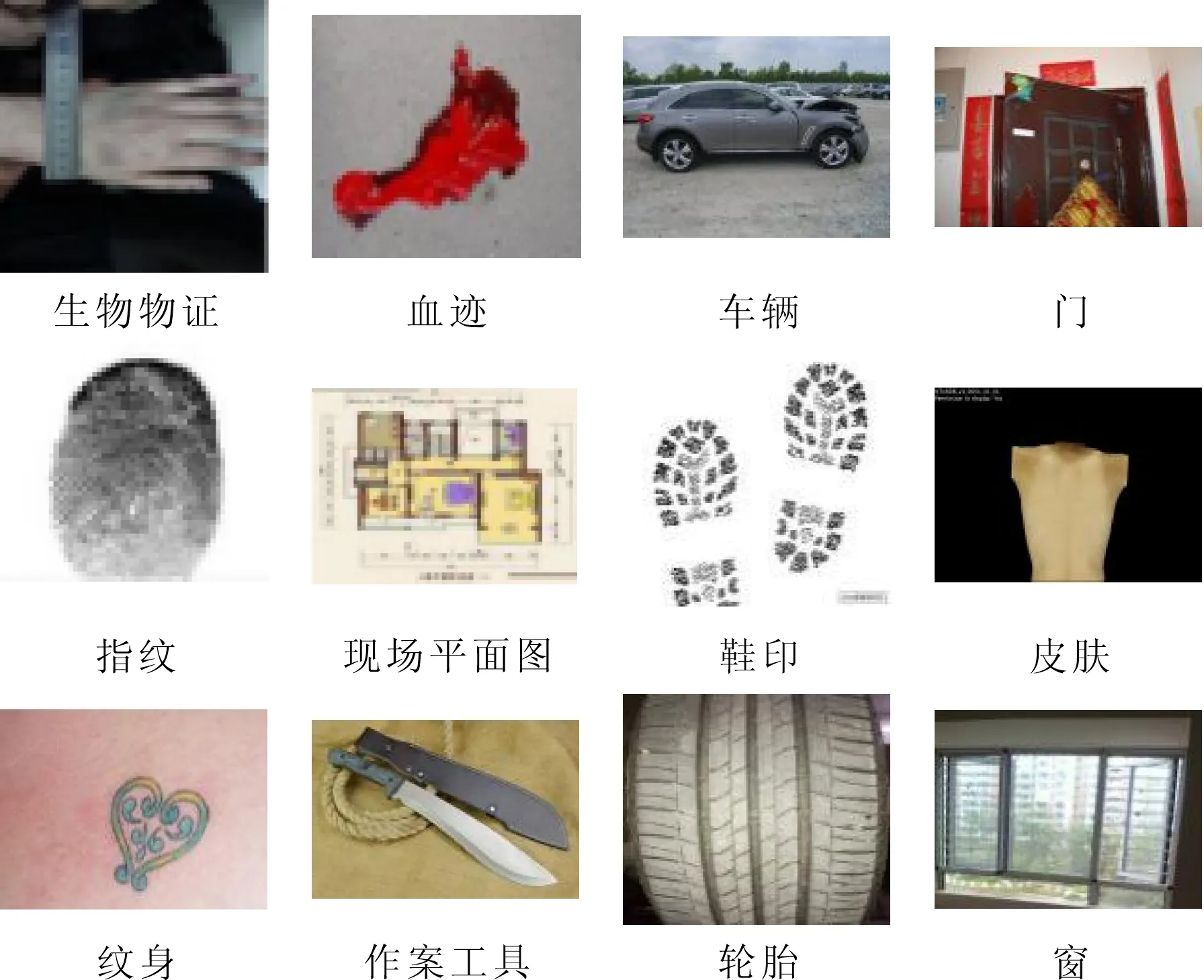

第一个数据库是西安邮电大学图像与信息处理研究所(center for image and information processing, CIIP)依托与公安部共建的研究平台,从公安系统获取了大量实际现勘图像作为实验测试数据[12](CIIP Crime Scene Investigation Image database, CIIP-CSID)。实验从中选取了12个语义类别的图像,分别为生物物证、血迹、车、门、指纹、现场平面图、鞋印、皮肤、纹身、作案工具、轮胎、窗等,共计10500张图像,其示例如图3所示。

图3 CSID示例

第二个数据库GHIM-10K数据库[24],其中共包含20类图像,如烟花、建筑、汽车、花朵、蝴蝶等,每类包含500张图片,共有10000张图片,部分示例如图4所示。

图4 GHIM-10K数据库示例

2.2 评价标准

实验利用查准率(Precision)来衡量检索性能。该值越大,表明返回的相关图像个数越多,检索效果越好。查准率定义为

(7)

其中S为一次查询中返回的结果中包含的正确相关图像的数目,K为一次查询中算法返回的图像总数。

2.3 实验结果

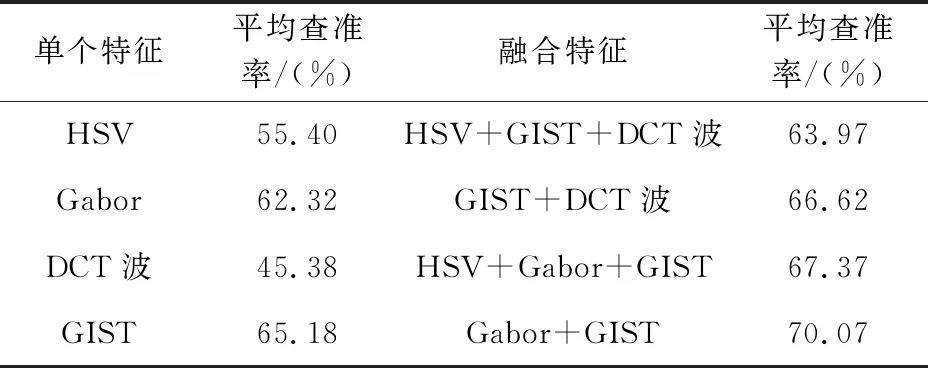

2.3.1 低层特征的选择

在CSID和GHIM-10K数据库上分别测试了上述几种低层特征及其融合特征的查准率,测试结果分别如表2和表3所示。

可以看出,由于现勘图像数据的特殊性,图像内容一般没有明显的颜色特征区别,颜色特征的加入反而会影响查准率。GIST描述了一些场景特征更适合于现勘图像。因此,最终选择Gabor和GIST作为低层特征。颜色适用于描述自然图像,因此加入颜色特征对于自然图像的检索更有效。Gabor特征和GIST特征分别描述图像的纹理信息和场景信息,融合这三种特征可以对自然图像进行更加充分地描述。

表2 CSID中不同低层特征及其组合后的平均查准率

表3 GHIM-10K数据库上各种不同低层特征 及其组合后的平均查准率

2.3.2 CNN特征和融合特征的平均查准率

为了弥补单个CNN网络的不足,将两个CNN网络的fc7层特征进行级联,再与适合描述该图像库图像的低层特征进行融合,以此来更全面的描述图像信息。分别在现勘数据库和GHIM10K数据库上进行测试。测试是每次检索返回10幅图像,实验结果可得,对于现勘图像数据库当采用CNN1、CNN2、GIST、Gabor 特征权重比例为0.2∶0.6∶0.1∶0.1时的组合,其检索效果最优。对于GHIM-10K数据库,当采用CNN1、CNN2、HSV、Gabor、GIST特征权重为0.1∶0.7∶0.1∶0.05∶0.05的比例组合时,检索效果最优。对应的实验结果分别如表4~5所示。

从实验结果可以看出,将两个CNN特征级联后再与低层特征融合,能够有效提高图像检索的准确率。

表4 CSID中CNN特征和融合特征的平均查准率

表5 GHIM-10K中CNN特征和融合特征的平均查准率

2.3.3 各个类别图像的平均查准率

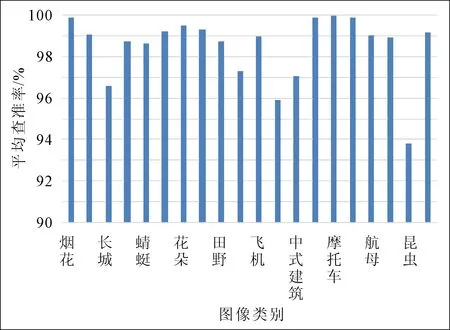

上述结果是各数据库总体的平均查准率,为了了解各个类别图像的平均查准率,分别计算出两个数据库中各类图像的平均查准率,结果分别如图5-6所示。

图5 CSID中各个类别图像的平均查准率

图6 GHIM-10K中各个类别图像的平均查准率

从图中的结果可以看出,在同一数据库中各个类别图像的查准率各不相同。例如在CSID中生物物证的查准率比其他类别的平均查准率都低,在GHIM-10K数据库中,昆虫的平均查准率较低。其原因在于目标物不明显且受背景影响较大,这可能与算法特征融合权重比例或者其他因素有关,需要进一步讨论研究。

3 结语

为了克服现勘图像数据数量有限造成训练卷积神经网络时易过拟合的现象,提出了利用迁移学习即特征融合的先看图像检索算法,其思想把大型数据库ImageNet上训练的CNN模型迁移并利用目标数据库进行微调。先利用目标数据集对预训练模型VGG-F和VGG-VD 16进行微调并分别提取fc7层特征,再将两个模型的降维后的CNN特征进行融合,之后与适合描述该图像库的低层特征进行融合并进行检索。实验结果表明,本文算法可以有效描述现勘图像的内容并且保持较高的平均查准率。此外,本文算法对于其他类型的数据库具有一定的普适性。本文算法针对个别查准率低的类别,特别是刑侦图像,更有效地提高算法对该类别的平均查准率的方案有待于进一步研究。