CNN-BiGRU网络中引入注意力机制的中文文本情感分析

2019-11-15王丽亚刘昌辉蔡敦波卢涛

王丽亚 刘昌辉 蔡敦波 卢涛

.

摘 要:传统卷积神经网络(CNN)中同层神经元之间信息不能互传,无法充分利用同一层次上的特征信息,缺乏句子体系特征的表示,从而限制了模型的特征学习能力,影响文本分类效果。针对这个问题,提出基于CNN-BiGRU联合网络引入注意力机制的模型,采用CNN-BiGRU联合网络进行特征学习。首先利用CNN提取深层次短语特征,然后利用双向门限循环神经网络(BiGRU)进行序列化信息学习以得到句子体系的特征和加强CNN池化层特征的联系,最后通过增加注意力机制对隐藏状态加权计算以完成有效特征筛选。在数据集上进行的多组对比实验结果表明,该方法取得了91.93%的F1值,有效地提高了文本分类的准确率,时间代价小,

具有很好的应用能力。

关键词:卷积神经网络;双向门限循环神经网络;注意力机制;中文文本情感分析

中图分类号:TP391.1

文献标志码:A

Abstract: In the traditional Convolutional Neural Network (CNN), the information cannot be transmitted to each other between the neurons of the same layer, the feature information at the same layer cannot be fully utilized, making the lack of the representation of the characteristics of the sentence system. As the result, the feature learning ability of model is limited and the text classification effect is influenced. Aiming at the problem, a model based on joint network CNN-BiGRU and attention mechanism was proposed. In the model, the CNN-BiGRU joint network was used for feature learning. Firstly, deep-level phrase features were extracted by CNN. Then, the Bidirectional Gated Recurrent Unit (BiGRU) was used for the serialized information learning to obtain the characteristics of the sentence system and strengthen the association of CNN pooling layer features. Finally, the effective feature filtering was completed by adding attention mechanism to the hidden state weighted calculation. Comparative experiments show that the method achieves 91.93% F1 value and effectively improves the accuracy of text classification with small time cost and good application ability.

Key words: Convolutional Neural Network (CNN); Bidirectional Gated Recurrent Unit (BiGRU); attention mechanism; Chinese text sentiment analysis

0 引言

随着互联网的飞速发展,神经网络迎来梦寐以求的大数据时代,其中,文本情感分析[1]是一个重要的研究方向,能有效地分析文本所包含的情感信息,同时具有很高的商业价值。

文本情感分析是自然语言处理(Natural Language Processing, NLP)领域的一个重要研究方向,主要目的是从原始文本中提取出评论人的主观情感,即对某个对象是积极还是消极的态度。主要分析方法可分为三类:基于有监督的学习、基于语言学和基于深度学习的方法[2-3]。Pang等[4]针对电影评论,通过词袋模型分别加上贝叶斯、最大熵、支持向量机等各种分类器取得较好的分类效果。Bengio等[5]最早使用神经网络构建语言模型。Mikolov等[6-7]2013年在Log-Bilinear模型[8]的基础上提出了word2vec技术。Kalchbrenner等[9]提出动态卷积神经网络(Dynamic Convolutional Neural Network, DCNN)的模型处理长度不同的文本,将卷积神经网络(Convolutional Neural Network, CNN)应用于NLP。Kim[10]对比了不同词向量构造方法,利用提前训练的词向量作为输入,通过CNN实现句子级的文本分类。但传统CNN无法深度学习池化后的特征,本文采用CNN-BiGRU聯合网络进行特征学习。

Lee等[11]利用基于循环神经网络(Recurrent Neural Network, RNN)和CNN训练文本的向量,通过普通人工神经网络(Artificial Neural Network, ANN)实现文本分类,说明了添加文本序列信息可以提高分类的准确率。普通RNN可以有效地利用近距离的语义特征[12-13],但存在梯度消失的不足,

为解决这一问题,RNN出现了多个变种循环神经网络模型。长短时记忆网络(Long Short-Term Memory,LSTM)[14],在文本上可以提取长距离的语义特征。

Zhou等[15]提出C-LSTM进行文本分类,但忽略了文本上下文的特征联系。双向长短时记忆网络(Bidirectional LSTM, BiLSTM)[16]则由前向传播和后向传播的两个LSTM组合而成,提取全局特征弥补了LSTM的不足;但网络结构复杂,所需参数多,时间代价大。Cho等[12]提出了门限循环单元(Gated Recurrent Unit,GRU),GRU网络结构相对LSTM更加简单,能有效缩短模型训练时间。双向门限循环神经网络(Bidirectional Gated Recurrent Unit, BiGRU)则是由正向GRU、反向GRU、正反向GRU的输出状态连接层组成的神经网络。

综上,BiGRU相对于BiLSTM的网络结构较为简单,时间代价小。因此,本文采用BiGRU学习CNN池化后的特征得到句子体系的特征表示。

Bahdanau等[17]最早提出了注意力机制理论,并将其应用到机器翻译领域。Mnih等[18]在RNN模型上使用了注意力机制来进行图像分类,使得注意力机制真正意义上流行了起来。Xu等[19]展示了如何使用学习得到的注意力机制为模型生成过程提供更多可解释性;Luong等[20]提出了全局、局部两种注意力机制,促进了基于注意力机制的模型在NLP的应用。胡荣磊等[21]将LSTM和前馈注意力模型相结合,提出了一种文本情感分析方案。王伟等[22]提出BiGRU-Attention模型進行情感分类。陈洁等[23]提出了基于并行混合神经网络模型的短文本情感分析方法,

以上结合注意力机制进行情感分析的模型,皆说明了通过引入注意力机制能有效地提高了情感分类的准确度。

由于利用传统CNN或BiGRU网络进行特征学习时,CNN在局部特征提取上较BiGRU具有优势,但缺乏句子体系的特征表示,而一个模型对特征的学习能力会直接影响文本分类效果,所用本文提出联合网络引入注意力机制的模型进行情感分析。

本文的主要工作如下:

1)针对中文文本,提出了CNN-BiGRU联合网络模型学习文本特征,充分利用CNN局部特征的强学习能力,使用BiGRU网络获取此层次前后向特征,提取句子体系的特征表示,从而提高文本情感分析的准确率,并在时间代价上验证了此网络的有效性。

2)在联合网络模型上引入注意力模型,获取文本中的重点特征,降低噪声特征的干扰,从而进一步提高文本情感分析的准确率。

1 词向量

本文实验采用谷歌开源工具word2vec来构建文本词向量。word2vec技术包括两种模型:连续词袋模型(CBOW)和Skip-gram模型。CBOW模型根据上下文预测一个词,而Skip-gram模型正好相反,是利用当前词来预测周围的词。本文使用Skip-gram模型。

Skip-gram模型分为输入层、投影层和输出层,模型结构如图1所示。

如果上下文窗口大小设置为4,且设当前词W(t)所对应的向量形式为V(W(t)),其周围4个词所对应的向量形式为V(W(t+2))、V(W(t+1))、V(W(t-1))、V(W(t-2)),则Skip-gram模型通过中间词预测周围词,是利用中间词向量V(W(t))的条件概率值来求解,如式(1)所示:

2 联合网络引入注意力机制模型本文提出了CNN-BiGRU联合网络引入注意力机制(C-BG-A)的文本情感分析方法。

结构主要可分为CNN-BiGRU联合网络特征学习和CNN-BiGRU-Attention特征筛选。

2.1 CNN-BiGRU联合网络特征学习本文利用CNN提取局部短语特征。CNN是一种前馈神经网络,模型结构主要包括输入层、卷积层、池化层、全连接层和输出层五部分,CNN的网络结构如图2所示。

1)输入层。将嵌入层的输出作为输入,句子中每个词的词向量为xi∈Rn×d,其中n是词数,d是向量维度,本文定为100维。

2)卷积层。通过设置好大小的滤波器来完成对输入文本句子特征的提取,如式(2)所示:

其中:ω是卷积核;h是卷积核的尺寸;

xi:i+h-1是i到i+h-1个词组成的句子向量;b是偏置项;通过卷积层后,得到特征矩阵c=[c1,c2,…,cn-h+1]。

3)池化层。通过对卷积层之后得到的句子局部特征矩阵c进行下采样,求得局部值的最优解Mi。这里采用MaxPooling技术,如式(3)所示:

由于BiGRU输入必须是序列化结构,池化将中断序列结构c,所以需要添加全连接层,将池化层后的向量Mi连接成特征矩阵U,如式(4)所示:

将新的连续高阶窗口U作为BiGRU的输入。BiGRU由正向GRU、反向GRU、正反向GRU的输出状态连接层组成,网络结构如图3所示。

若记t时刻正向GRU输出的隐藏状态为t,反向GRU输出的隐藏状态为t,则BiGRU输出的隐藏状态ht,其具体的计算过程如式(5)~(7)所示:

GRU是对LSTM的一种改进,它也存在一个贯穿始终的记忆状态单元(Memory Unit),该记忆单元用更新门代替原来LSTM中的遗忘门和输入门,即在网络结构上要比LSTM更为简单,且所需参数减少,从而能够提高模型训练速度。GRU的原理如图4所示。其具体的计算过程如式(8)~(11)所示:

其中:wz、wr、w为权值矩阵;zt为更新门;rt为重置门;t为备选激活函数;ht为激活函数;Ut为t时刻GRU的输入;

σ为sigmoid激活函数。

2.2 CNN-BiGRU-Attention特征筛选

注意力机制通过对文本向量的语义编码分配不同的注意力权重,以区分文本中信息的重要性大小,提高分类的准确率。本文使用前馈注意力模型,注意力模型结构如图5所示。

1)生成目标注意力权重vt,如式(12)所示:

其中:σ是一种注意力学习函数tanh;ht是CNN-BiGRU网络输出的特征向量。

2)注意力权重概率化,通过softmax函数生成概率向量pt,如式(13)所示:

3)注意力权重配置,将生成的注意力权重配置给对应的隐层状态语义编码ht,使模型生成的注意力权重发挥作用,αt是ht的加权平均值,权值是pt,如式(14)所示:

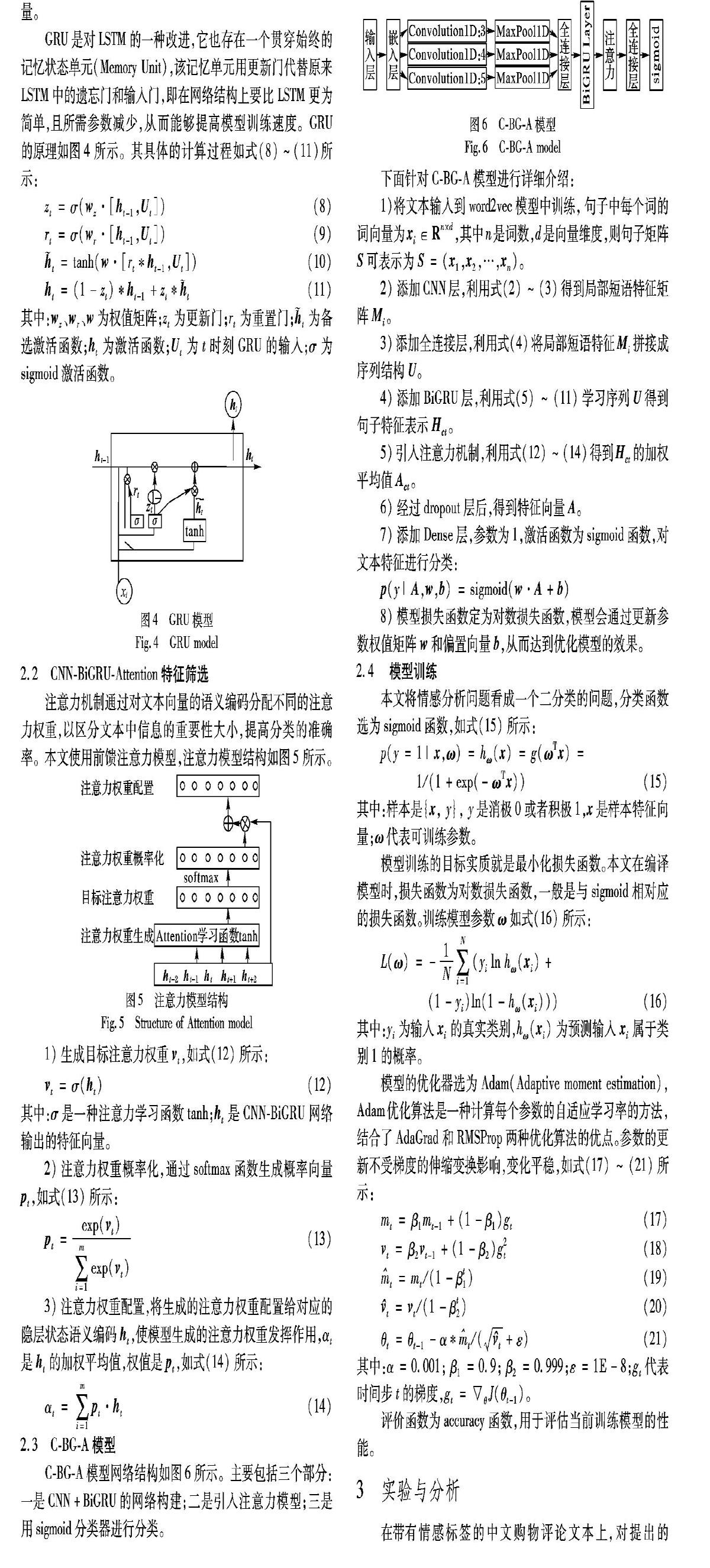

2.3 C-BG-A模型

C-BG-A模型网络结构如图6所示。主要包括三个部分:一是CNN+BiGRU的网络构建;二是引入注意力模型;三是用sigmoid分类器进行分类。

下面针对C-BG-A模型进行详细介绍:

1)将文本输入到word2vec模型中训练,句子中每个词的词向量为xi∈Rn×d,其中n是词数,d是向量维度,则句子矩阵S可表示为

2)添加CNN层,利用式(2)~(3)得到局部短语特征矩阵Mi。

3)添加全连接层,利用式(4)将局部短语特征Mi拼接成序列结构U。

4)添加BiGRU层,利用式(5)~(11)学习序列U得到句子特征表示Hct。

5)引入注意力机制,利用式(12)~(14)得到Hct的加权平均值Act。

6)经过dropout层后,得到特征向量A。

7)添加Dense层,参数为1,激活函数为sigmoid函数,对文本特征进行分类:

p(y|A,w,b)=sigmoid(w·A+b)

8)模型损失函数定为对数损失函数,模型会通过更新参数权值矩阵w和偏置向量b,从而达到优化模型的效果。

2.4 模型训练本文将情感分析问题看成一个二分类的问题,分类函数选为sigmoid函数,如式(15)所示:

其中:样本是{x, y}, y是消极0或者积极1,x是样本特征向量;ω代表可训练参数。

模型训练的目标实质就是最小化损失函数。本文在编译模型时,损失函数为对数损失函数,一般是与sigmoid相对应的损失函数。

训练模型参数ω如式(16)所示:

其中:yi为输入xi的真实类别,hω(xi)为预测输入xi属于类别1的概率。

模型的优化器选为Adam(Adaptive moment estimation),Adam优化算法是一种计算每个参数的自适应学习率的方法,结合了AdaGrad和RMSProp两种优化算法的优点。参数的更新不受梯度的伸缩变换影响,变化平稳,如式(17)~(21)所示:

评价函数为accuracy函数,用于评估当前训练模型的性能。

3 实验与分析在带有情感标签的中文购物评论文本上,对提出的C-BG-A模型情感分析方法进行验证与分析。实验环境配置数据如表1所示。

3.1 实验环境与数据

实验数据来自网络购物的评论,数据内容对象类型有酒店、牛奶、书籍、手机等。评论情感标签分为两类[0,1],消极的情感为0,积极的情感为1。例如:“地理位置优越,交通方便,饭店环境好,服务优良,洗衣迅捷”,情感为积极,“手机系统差,容易坏.部分按键不灵活,半年后就会出现在大问题.”,情感为消极。数据集设置为:总数21105条,训练集16884条,验证集2000条,测试集2221条。

3.2 参数设置参数设置会直接影响后续模型的分类效果,具体的参数设置如表2所示。

3.3 评价指标

准确度(Accuracy)、精确度(Precision)、召回率(Recall)、F值(Fθ)这4个模型评测指标是NLP模型评估的常用标准。设总的测试集个数为TP+TN+FP+FN,其具體含义如表3所示。

3.4 对比实验设置实验设置以下多组对比实验,包括传统机器学习算法支持向量机(Support Vector Machine,SVM)与深度学习网络的比较,单一网络与联合网络的比较,及与引入注意力模型的网络对比。网络输入均是利用word2vec训练的词向量。

1)SVM[24]:采用传统机器学习算法SVM进行情感分析。

2)BiLSTM[16]:单一的BiLSTM网络。

3)BiGRU:单一的BiGRU网络。

4)CNN[25]:单一的CNN网络。

5)CNN+BiLSTM:先添加一个CNN网络,再添加一个BiLSTM网络。

6)CNN+BiGRU:先添加一个CNN网络,再添加一个BiGRU网络。

7)CNN+BiLSTM+Attention(CNN+BiLSTM+Att):先添加一个CNN网络,再添加一个BiLSTM网络,最后引入Attention机制。

8)CNN+BiGRU+Attention(C-BG-A):先添加一个CNN网络,再添加一个BiGRU网络,最后引入Attention机制。

3.5 实验结果分析

实验在测试集上计算出Accuracy值、Precision值、Recall值、F1值,对比结果如表4所示。

从表4显示的8组模型对比结果可看出:从两个综合评测指标Accuracy、F1上来看,C-BG-A准确率达到92.03%,F1值达到91.93%,均优于对比模型。SVM虽然取得较好的分类效果,但基于深度学习的7组模型明显优于SVM。第5、6与之前3组模型的对比,体现出本文提出的CNN-BiGRU联合网络提取特征的优势,因为CNN对文本特征的强学习能力有助于联合模型对深层次特征的学习,而双向循环神经网络对序列化特征前后的学习能力,在联合模型对CNN提取的特征进行再加工时,起到正影响的作用。第7、8与5、6组的对比,可知在联合模型的基础上添加注意力机制能有效地提高模型分类的准确度,因为注意力机制分配给特征不同的权重,让模型学习到了特征之间的轻重不同之分,有助于模型快速掌握重要的特征。第8与7组的比较,说明利用BiGRU学习CNN池化后的特征较BiLSTM效果更佳。

为了更直观地反映基于深度学习的7组模型的优劣,本文选择绘画验证集的准确率(val_acc)和损失率(val_loss)变化图。准确率的变化如图7所示,损失率的变化如图8所示。

从图7可看出:总体上7组模型准确度都不断上升,第二次迭代后均达86%以上,其中C-BG-A模型的准确度均达90%以上,且趋势平稳,不如其余6组模型波动性大。可见C-BG-A模型在提取文本特征上更为优秀和稳定,在短时间内准确度可达较高水平且趋势稳定,即在迭代次数较少的情况下也可以达到较高的准确度,在第5次迭代时达到最高值92.93%。

从图7中也可发现,有BiGRU参与的模型准确度都能快速达到较高水平且波幅较平稳,相对与BiLSTM表现更好。模型损失率是越小越好。从图8中可看出:CNN模型的波动最大,其余6组都较为集中;细看可发现,C-BG-A模型的损失率第1次迭代结果就达到0.2552,第2次迭代结果为最低值0.2051,且趋势平稳。综合图7~8的分析结果,C-BG-A模型具有收敛性快、准确度高、稳定性强的特点,相比较其他6组模型在文本分类上更具有优势。

为了量化模型的优劣,本文在测试集上进行预测,样本总数为2221。实验统计了预测结果的TP值、FP值、TN值、FN值、Right值、Wrong值,Right为模型预测正确的样本数,Wrong为模型预测错误的样本数。输出结果为预测样本是1概率,为方便统计,将值大于0.5的定为1,其余为0。预测值统计的结果如表5所示。

表5中,C-BG-A模型预测正确最多,错误最少,可见C-BG-A模型最优。

针对模型的时间代价分析,本文给出5组对比模型完成每次迭代所需时间的对比图,如图9所示。

实验尽可能统一其运行条件,在减少因各方面因素不同对其影响的情况下进行统计。从图9模型的时间代价来看,单模型迭代所用时间均为最少,其中,BiGRU所用时间最短,因为其网络结构最为简单。C-BG-A多数保持在117s/epoch。在时间代价上,C-BG-A比CNN+BiLSTM+Attention更有优势,说明选择BiGRU模型能有效地缩短模型的训练时间,具有高效性。

利用模型对真实单句进行预测,展示了模型真实的运用功能。选句子时要避免与原数据中的句子相同,否则会影响评估模型性能。为方便了解输出结果含义,将值大于0.5的定为positive,其余定为negative。单句测试结果如表6所示。

预测结果句子情绪从表6单句测试结果上来看,C-BG-A模型对随机所选的单句的预测结果都是正确的,从而更加直观地说明了C-BG-A能在中文文本分类问题上的成功应用。

综上,针对本文所用数据集,利用CNN-BiGRU联合模型提取特征优于单模型CNN或BiGRU,再引入注意力機制能进一步地提高文本分类的准确率,且模型具有高效性和很好的应用能力。

4 结语

本文提出了一种C-BG-A模型的中文文本情感分析方法。利用CNN局部特征的强学习能力,提取短语体系的特征。再利用BiGRU深度学习CNN中池化后连接组成的特征,加强短语特征之间的联系,从而使模型学习到更深层次的句子体系特征表示。最后引入注意力机制进行特征筛选,降低噪声干扰。

在中文网络购物评论文本上进行训练和测试,实验结果表明本文模型有效地提高了文本情感分类准确率,且时间代价小。但由于本文模型使用的CNN网络深度不够,如何使用更深的CNN网络作为联合对象进一步提高分类准确率,是下一步工作的目标。

参考文献(References)

[1] 魏韡, 向阳, 陈千. 中文文本情感分析综述[J]. 计算机应用, 2011, 31(12): 3321-3323. (WEI W, XIANG Y, CHEN Q. Survey on Chinese text sentiment analysis[J]. Journal of Computer Applications, 2011, 31(12): 3321-3323.)

[2] TURNEY P D. Thumbs up or thumbs down?: semantic orientation applied to unsupervised classification of reviews[C]// Proceedings of the 40th Annual Meeting on Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2002: 417-424.

[3] NI X, XUE G, LING X, et al. Exploring in the weblog space by detecting informative and affective articles[C]// Proceedings of the 16th International Conference on World Wide Web. New York: ACM, 2007: 281-290.

[4] PANG B, LEE L, VAITHYANATHAN S. Thumbs up?: sentiment classification using machine learning techniques[C]// Proceedings of the ACL-02 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2002: 79-86.

[5] BENGIO Y, DUCHARME R, VINCENT P, et al. A neural probabilistic language model[J]. Journal of Machine Learning Research, 2003, 3: 1137-1155.

[6] MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[EB/OL]. [2017-08-04]. http://www.surdeanu.info/mihai/teaching/ista555-spring15/readings/mikolov2013.pdf.

[7] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality [EB/OL]. [2019-01-10]. http://papers.nips.cc/paper/5021-distributed-representations-of-words-and-phrases-and-their-compositionality.pdf.

[8] MNIH A, HINTON G E. A scalable hierarchical distributed language model[C]// Proceedings of the 21st International Conference on Neural Information Processing. New York: Curran Associates Inc., 2008: 1081-1088.

[9] KALCHBRENNER N, GREFENSTETTE E, BLUNSOM P. A convolutional neural network for modelling sentences[C]// Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2014: 655-665.

[10] KIM Y. Convolutional neural networks for sentence classification[C]// Proceedings of the 2014 Conference on Empirical Methods in Natural Language Proceeding. Stroudsburg, PA: Association for Computational Linguistics, 2014: 1746-1751.

[11] LEE J Y, DERNONCOURT F. Sequential short-text classification with recurrent and convolutional neural networks[C]// Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2016, 515-520.

[12] CHO K, van MERRIENBOER B, GULCEHRE C, et al. Learning phrase representions using RNN encoder-decoder for statistical machine translation [C]// Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing.Stroudsburg, PA: Association for Computational Linguistics, 2014: 1724-1734.

[13] EBRAHIMI J, DOU D. Chain based RNN for relation classification[C]// Proceedings of the 2015 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2015: 1244-1249.

[14] HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[15] ZHOU C, SUN C, LIU Z, et al. A C-LSTM neural network for text classification[EB/OL].[2019-01-09].https://arxiv.org/abs/1511.08630.

[16] XIAO Z, LIANG P. Chinese sentiment analysis using bidirectional LSTM with word embedding[C]// Proceedings of the 2016 International Conference on Cloud Computing and Security, LNSC 10040. Berlin: Springer, 2016: 601-610.

[17] BAHDANAU D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[EB/OL]. [2018-03-20]. https://arxiv.org/pdf/1409.0473v7.pdf.

[18] MNIH V, HEESS N, GRAVES A, et al. Recurrent models of visual attention[C]// Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014: 2204-2212.

[19] XU K, BA J, KIROS R, et al. Show, attend and tell: neural image caption generation with visual attention[EB/OL]. [2018-03-20]. https://arxiv.org/pdf/1502.03044.pdf.

[20] LUONG M PHAM H, MANNING C D. Effective approaches to attention-based neural machine translation[C]// Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2015: 1412-1421.

[21] 胡荣磊, 芮璐, 齐筱, 等. 基于循环神经网络和注意力模型的文本情感分析[J/OL]. 计算机应用研究, 2019, 36(11). [2018-12-10]. http://www.arocmag.com/article/02-2019-11-025.html. (HU R L, RUI L, QI X, et al. Text sentiment analysis based on recurrent neural network and attention model[J/OL]. Application Research of Computers, 2019, 36(11). [2018-12-10]. http://www.arocmag.com/article/02-2019-11-025.html.)

[22] 王伟, 孙玉霞, 齐庆杰, 等. 基于BiGRU-Attention神经网络的文本情感分类模型[J/OL]. 计算机应用研究, 2018, 36(12) [2018-12-10]. http://www.arocmag.com/article/02-2019-12-045.html (WANG W, SUN Y X, QI Q J, et al. Text sentiment classification model based on BiGRU-Attention neural network[J/OL]. Application Research of Computers, 2018, 36(12)[2018-12-10]. http://www.arocmag.com/article/02-2019-12-045.html.)

[23] 陳洁, 邵志清, 张欢欢, 等. 基于并行混合神经网络模型的短文本情感分析[J/OL]. 计算机应用, 2019. [2018-12-10]. http://kns.cnki.net/kcms/detail/51.1307.TP.20190329.1643.008.html. (CHEN J, SHAO Z Q, ZHANG H H, et al. Short text sentiment analysis based on parallel hybrid neural network model[J/OL]. Journal of Computer Applications, 2019. [2018-12-10]. http://kns.cnki.net/kcms/detail/51.1307.TP.20190329.1643.008.html.)

[24] 常丹, 王玉珍. 基于SVM的用户评论情感分析方法研究[J]. 枣庄学院学报, 2019, 36(2): 73-78. (CHANG D, WANG Y Z. Research on the method of user comment sentiment analysis based on SVM[J]. Journal of Zaozhuang University, 2019, 36(2): 73-78.)

[25] 王煜涵, 张春云, 赵宝林, 等. 卷积神经网络下的Twitter文本情感分析[J]. 数据采集与处理, 2018, 33(5): 921-927. (WANG Y H, ZHANG C Y, ZHAO B L, et al. Sentiment analysis of twitter data based on CNN[J]. Journal of Data Acquisition and Processing, 2018, 33(5): 921-927.)