物尽其用:基于计算机思维的新闻文本挖掘研究*

——以“中国突发事件数据库”的建设实践为例

2019-10-10张振宇喻发胜

■ 张振宇 喻发胜

一、问题的提出

早在2000年,学者麦奎尔(Denis McQuail)就指出:“原则上,其它我们已经叙述过的媒介好像已经没有什么存在的必要了,因为所有的媒介都能够纳入以计算机传播为核心的架构之下。”①随后十多年间,计算机科学给传媒行业带来的冲击有目共睹,而数据库(Database)②作为计算机科学的重要分支,③虽然早在20世纪80年代即被引入到国内传媒行业,但30多年过去了,大多数媒体对数据库的理解和应用还停留在资料库、案例库的初级阶段,远远没有发挥出数据库蕴含的巨大威力。近年来,基于数据库技术的大数据(Big Data)理念与方法的出现,更为拥有海量内容资源的新闻行业带来了新的发展契机,传统媒体应该如何通过数据库建设来实现新闻文本的“物尽其用”,进而探索其战略转型的可能性路径,是一个值得尝试的研究方向。

在这一背景下,笔者团队自2013年起在两项国家社科基金课题的支持下,开始探索如何基于传媒本体来建设“中国突发事件数据库”,并于2018年初步完成了该数据库的基本架构。在历时五年的研发过程中,我们发现数据库建设虽然是一个面向实践的应用课题,但却蕴含着更抽象层面的理论命题,那就是计算机科学的思维方式(即“运用计算机科学的基础概念去求解问题、设计系统和理解人类的行为”④)对重新发掘新闻价值的启示意义。⑤具体而言,该命题可以展开为:(1)在传统媒体的市场逻辑中,被称为“易碎品”的新闻在媒体平台发布之后,往往就因其时效性的消逝而失去了使用价值,但在计算机思维的加持下,是否能从已经过时的新闻中挖掘出新的价值?(2)计算机思维中的数据库理念和方法对新闻报道文本的深度加工有何借鉴意义?这不同于过去简单地将新闻内容数字化之后入库,而是如何根据不同的需求将新闻报道加工成数据库能够挖掘和可视化呈现的结构化数据?(3)如果将前面两个问题的答案相结合,是否能为传统媒体的转型提供一种路径选择的可能性(从内容提供商到数据服务商)?为了回答这一问题链,有必要追本溯源,首先考察国内媒体数据库的建设史及对其的研究史。

二、国内媒体数据库的建设史、研究史及其缺憾

就目前能够查询到的史料而言,国内媒体的数据库建设史可以上溯到20世纪80年代,当时新华社、文汇报等新闻单位率先引入了对媒体进行数字化存储的机制,这可被视为媒体数据库的雏形。但在随后十多年时间里,新闻媒体的数据库主要是直接将报纸进行数字化扫描后以电子文档的形式存储起来,只提供基本的新闻查询和检索功能,因此更接近档案库(或曰资料库、案例库)的概念。⑥

进入21世纪以来,随着数据库技术的不断迭代升级,新闻媒体也比过去更加重视数据库的建设,主要体现为以下三点:一是在建设主体上,除了国家通讯社和几大中央纸媒外,越来越多的地方媒体和广电媒体也开始自建数据库;⑦二是在内容架构上,除了档案型新闻报道数据库之外,还出现了读者(订户)数据库、影视剧数据库、广告客户数据库、影视政策研究数据库、无人机新闻采集数据库等;⑧三是在功能设计上,媒体数据库除了对内提供新闻检索等功能外,也开始尝试对外提供一定的增值服务。虽然这些服务基本上还停留在信息查询的层面,但这对于媒体转型的探索意义远超过其实际价值。⑨

通过历史梳理我们发现,国内新闻媒体数据库的建设体现出以下几个特点:一是起步晚,基础相对薄弱,直至目前也没有出现具有盈利能力的新闻内容数据库;二是各自为营,不同数据库的适用范围受限于所属媒体的辐射范围,极少能提供跨地域、跨行业的数据服务;三是功能单一,基本上只能提供最基础的新闻内容的存储、检索服务,没有对新闻内容进行深度挖掘和可视化呈现。

与国内媒体数据库的建设进程相呼应,国内新闻传播学界对传媒数据库的相关研究也体现出一定的阶段性特征:目前能查到的最早的相关文献是1985年的《美日报纸的信息服务》,⑩当时国内媒体尚未开始建设数据库,因此该文主要是引介发达国家报业在20世纪六七十年代建设数据库的经验。在随后十多年的时间里,国内媒体在数据库的建设上乏善可陈,相关研究也停滞了近十年,直到1994年,才有第二篇文献开始研究国内新闻媒体的数据库建设。严格意义上说,在2000年以前,国内相关文献都很难称得上是学术论文,而主要是各类资讯和经验总结,没有太多理论含量。直到2001年后,随着越来越多的媒体开始自建各类数据库,这一时期相关研究才在广度和深度上有所拓展:在广度上,这一时期的研究超越了过去主要研究报刊数据库的界限,而将不同类型和功能的媒体数据库纳入研究范畴;在深度上,这一时期的研究不再停留于对数据库基本知识的介绍和经验总结上,而是开始探讨数据库的设计理念、建设规划、内容架构、应用领域等内容,乃至对传媒数据库可能带来问题的反思上。尽管取得了不少成果,但国内相关研究还存在以下问题:(1)研究视角相对集中,大多数文献都站在应用角度,聚焦于数据库如何服务新闻报道和产品营销;(2)研究思路较为单一,大都遵循了“现状-问题-原因-对策”的常规模式,并未体现出传媒行业数据库建设的特殊性与不同类型媒体数据库的丰富性;(3)研究结论流于空泛,所提出的对策多为宏观的描绘,缺乏相对具体的方法与路径,也未见从实践到理论的学术建构。

从上述梳理中不难发现,国内传媒数据库实际建设进度与理论研究成果呈现出很强的相关性,且都存在着继续深入的空间。其中,这两者共同存在的问题是它们基本上都在传统的史料保存或档案管理范畴中进行,相对缺乏计算机思维的引入。对此,本文拟通过引入计算机思维来重新审视和发掘新闻文本的价值,将其从仅供查阅的“史料”转变为可供挖掘的“语料”,在此基础上搭建数据库的平台架构并进行数据挖掘,以实现新闻内容资源的充分燃烧,进而探索为传媒转型提供一种可能路径。下面将分而述之。

三、从新闻文本到结构化数据:传媒数据库建设的资源配置

从传统新闻学的视角看,失去了时效性的新闻也就失去了最核心的使用价值,只剩下档案或者史料价值。但从计算机思维的视角看,已经“过时”的新闻报道却因其事实层面的准确性、报道领域的全面性和文字表达的规范性而天然地具备了成为优质数据库语料资源的巨大潜质。这正是建设传媒数据库所具有的独特优势——因为建设任何类型的数据库首先都需要考虑数据的来源问题,而传媒可以直接取材于自身丰富和优质的内容资源。

正是在这一学科交叉的视野下,我们在思考中国突发事件数据库的数据来源问题时,就发现不同类型的突发事件分属不同的职能部门(如社会安全事件主要归口公安部,公共卫生事件则归口卫计委),而各部门对突发事件进行信息管理时所使用的数据结构存在较大差异(如公安部的数据表格就不同于卫计委),数据整合的难度很大。相比较而言,从媒体报道中对突发事件相关新闻进行数据清洗反而效率更高,因此,在经过反复尝试和比对后,我们选择了新华网、人民网和中国裁判文书网作为突发事件数据采集的主要来源。这一研究选题也正好给我们提供了一次以“突发事件”为对象、尝试借助计算机科学的数据库思维来对媒体内容资源进行重新整合的探索发现之旅。

为了服务于后期的数据挖掘和知识发现,我们从一开始就摒弃了直接对媒体内容进行数字化转换的传统模式,采用了对媒体内容进行结构化处理这一新的资源配置模式。因为从计算机思维的视角看,数据库与资料库的根本区别正在于后者所存储的是只能检索浏览的非结构化数据,而前者存储的则是可供计算挖掘的结构化数据,即“可以用二维表表示的数据,其中每个字段的取值范围和存储所需的数据量都有清晰的界定”。数据的结构化问题实际上源于新闻思维和计算机思维的根本性差异——因为人在阅读新闻时能够直接通过文字理解其文本的意义,但计算机所看见的文本却是一行行的字符串,因此只有当字符串以特定格式出现在指定区域时,才能被计算机读取和理解,这就是结构化的意义。

而对新闻报道进行结构化处理的前提是制定基础数据处理标准,在计算机思维看来,这其实是一个信息表示标准化的问题——“除非信息系统(数据库)对其所处理和交换的信息的表示有一致性的认识,否则信息系统的优越性就不能发挥,而对于各种信息表示一致性的认识,只有通过开展信息表示标准化才能达到。”在本项目中,这就意味着对于所有以文本形式存在的突发事件新闻报道,都应该有一个统一的标准和规范来描述与突发事件本体相关的各个维度信息。

为此,我们专门研究制定了“中国突发事件基础数据处理标准(下文简称EBDPS)”。由于突发事件的种类繁多、特征各异,再加上对其进行新闻报道时不同媒体所采用的语汇也不尽相同,因此制定标准必须兼顾事件的本体特征和新闻报道的文体特征。为此,该标准将突发事件的基础数据分为三个模块:本体、影响与应对。其中,“本体”指的是对突发事件本身各项特征的描述,例如发生的时间、地点、类别、级别等;“影响”指的是对突发事件所造成后果的描述,例如死亡人数、受伤人数、经济损失(货币化和非货币化)等;“应对”指的是政府部门、社会组织和公众所开展的各项救援措施。每个模块均包含了相应维度的字段,每个字段则有相应的数据类型、数值单位和填写规则,制定该标准的过程,其实也就是在各类突发事件新闻报道所涉及到的信息之间寻求“并集”的过程,最终的目标是尽可能保障对任意一起突发事件的新闻报道都可以被加工成一条能够被数据库识别和存储的突发事件数据。

标准的制定只是结构化处理的第一步,因为在录入的过程中我们发现,以求全为原则的基础数据处理标准不可避免地产生了大量的冗余字段,从而极大地影响了前期录入和后期检索的速度,为此,我们又引入了“最小数据集”的方法来对基础数据处理标准进行二次加工。所谓最小数据集(Minimum Data Set,简称MDS),是指通过收集最少的数据,最好地掌握一个研究对象所具有的特点或一件事情、一份工作所处的状态,其核心是针对被观察的对象建立一套精简实用的数据指标。如果说基础数据处理标准的制定需要“求其全”的话,那么最小数据集的制定则需要“取其精”,以使其能够被数据库便捷地检索和运算。由此,我们将突发事件的MDS确定为“类别、时间、地点、死亡人数、经济损失”五个可量化的维度,从而用最小的数据量勾勒出一起突发事件最核心的信息要素,以便提高后期对突发事件新闻语料进行批量结构化处理的速度和准确率。

综上,在确定主要数据来源、制定好EBDPS和提炼出MDS之后,就基本上制定好针对任意一条新闻文本的数据处理方法,亦即完成了突发事件数据库所需要的资源配置工作。从学理层面看,这一过程的理论意义部分在于,它揭示了计算机科学中结构化数据的思想对于新闻报道文本再加工的重要借鉴意义——那些已经过时的“新闻”文本通过符合数据库标准的结构化处理之后,就能转化为可供继续挖掘的数据资源。但面对海量的新闻报道文本,如何利用计算机思维及相关方法来设计批量化处理的加工流程,则是接下来需要研究解决的问题。

四、人机协同:新闻批量化处理的加工流程

过去新闻媒体自建的资料库、档案库之所以未能实现对内容资源的深度加工,最重要的原因就是在数据采集环节上无法实现对海量文本的高效批量化处理,特别是无法基于特定的主题需求对相关文本进行流水线式的加工作业,所以只能简单地将原有的纸质文本数字化后存储起来。为了解决这一问题,在建设突发事件数据库时,我们采用了计算机科学中的“人机协同”理念来设计整个结构化信息加工流程。

所谓“人机协同”,指的是“在知识管理、尤其在基于语义Web的知识处理过程中,强调人与计算机的分工与合作,通过人对知识处理的前端控制,降低计算机知识处理的难度,在人与计算机之间寻找最佳的协同状态……人与计算机共同感知、共同决策、相互学习、相互监督,共同完成知识管理任务。”之所以需要人机协同,是因为人的思维和计算机思维在文本处理领域中各有所长——人脑的长处是基于长期知识积累后对语义信息的准确理解和判断,而计算机的长处则在于通过特定算法对规定重复任务的高效完成。这一理念在本次研究中体现为:首先在知识处理的前端由人工研发作为检索依据的正则表达式(“人”),接下来用专门开发的爬虫软件对指定域名的目标文本进行抓取(“机”),再借助特定算法对抓取的海量文本进行初步的数据清洗(“机”),最后由人工完成对计算机已处理文本的甄别、录入与检查(“人”)。

在人机协同的过程中,新闻传播学者最能发挥其专业优势的地方是通过对突发事件新闻报道的内容分析来编写爬虫软件所依据的正则表达式(regular expression)。作为一种匹配文本中字符序列的查找模式,正则表达式最基本的功能就是让计算机用户和开发人员找到想要的文本块。对于本项目而言,正则表达式的意义在于为爬虫软件提供描述突发事件的关键词,以寻找和抓取在语义上最相关的新闻报道。当然,任何爬虫软件都无法做到对目标文本的完全匹配,只能尽可能避免遗漏与冗余。因此,如何从已有的典型语料中提炼关键词来组成正则表达式是一个非常重要的问题。

最开始,我们考虑到抓取文本描述的主体对象是突发事件,因此选择了政府部门制定的“突发事件分级分类标准”作为提取关键词的依据,但测试后发现,抓取效果并不理想——得到的文本多为政府文件,跟目标文本的匹配度不高。经过仔细甄别,发现症结在于误将政府文件作为正则表达式的编写依据,而想抓取的目标文本源自媒体上的新闻报道,两种文体的差异导致了正则表达式的匹配失灵。对此,我们改为直接从典型的新闻报道中提取关键词,并考虑到爬虫软件搜索语料的逻辑是字符串匹配而非语义匹配,为了避免遗漏,我们设计了包含and和or这两级逻辑结构的正则表达式,以尽可能全面地涵盖各种关键词:第一级是用and连接“主体”和“动词”,如“洪水and发生”;第二级是用or连接主体或动词的不同表达方式,如“(洪水or洪灾or山洪)and(发生or出现or遭遇or袭击)”,并对三级分类的每一个突发事件类别中都设置了三个正则表达式,分别对应其本体、影响和救援这三类新闻,以提高检索的准确度。

经过多次试错修订好正则表达式之后,接下来的网络爬虫、数据清洗等环节就基本上纳入了计算机的正常工作流程,在此不再赘述。当然,期间也有人工的随时介入(如对采集过程的监测、爬虫方式的改进、防火墙障碍的清除等),直至最后将清洗完毕的新闻素材按照之前研发的MDS格式录入数据库,原本也想编写程序来批量录入,但经过尝试发现准确率太低,所以还是选择了“人工录入+检查”的方式。最后,项目组从约一亿三千万个原始网页中几经淘炼,共录入了15354起突发事件(工作时间截至2018年12月1日),并将每一起突发事件的原始新闻报道都以完整网页的形式作为科研素材另存为数据库中备察。

从学术研究的层面看,这一实践环节的学理意义主要在于计算机思维中“人机协同”理念的深刻启示,正如计算机专家周以真所指出的,计算机思维能够帮助我们明晰哪些事情计算机比人做得好?哪些事情人比计算机做得好?对于本研究命题而言,计算机在大规模语料的批量处理、对结构化数据的统计运算、工作流程的无缝衔接和稳步递进等方面具有人脑所无法比拟的优势;而人在研究问题的发现、研究目标的锚定、文本意义的识别理解等方面比计算机要更胜一筹。因此,要想计算机科学为我所用,首先必须清楚本专业的需求与优劣势,同时也要理解计算机的高能与局限,并学会以计算机的思维方式来思考问题,这样才能超越过去“仅得其表”的媒体资料库阶段,进入到“深得其里”的媒体数据库阶段。基础数据录入工作的结束,也标志着突发事件数据库的初步建成,接下来需要面对的就是“so what?”的问题,即,当我们已经获取了由新闻文本加工而来的海量突发事件数据之后,又能怎样?对此,下文将借助计算机思维中的数据挖掘理念及方法来回答这一问题。

五、数据挖掘:新闻文本的潜在价值呈现

作为一种重要的计算机思维方式,数据挖掘是指“通过特定的算法对大量的数据进行自动分析,从而揭示数据当中隐藏的规律和趋势,即在大量的数据当中发现新知识,为决策者提供参考”,大数据的兴起使其重要价值被更多专业人士所认识,图灵奖得主吉姆·格雷(Jim Gray)甚至将数据科学上升到范式革命的高度,将其从第三范式的计算机科学中独立出来成为第四范式(The Fourth Paradigm),理由是其不同于基于数学建模的传统研究范式,而能够跨域对物理界(physical universe)的观测而直接通过对数据界(data universe)的研究获取新知识;数据挖掘的思想传播到国内后,李国杰院士也敏锐地发现数据挖掘对于计算机科学与社会科学交叉协同的重大意义,指出社会科学能够借助大数据的推力,脱下“准科学”的外衣,真正迈进科学殿堂。

这一论断对于作为社会科学的新闻传播学也有启示意义:已经结构化的新闻文本为我们提供了优质的语料基础,通过对其进行数据挖掘,可以“发现未知的关系,和以数据拥有者可以理解并用对其有价值的新颖方式来总结数据。”具体到本题所建设的突发事件数据库中,目前的数据挖掘主要沿着两条路径展开:一是对中国境内四大类突发事件的时空分布特征进行统计呈现,以显示其整体性的变化趋势;二是就某一类突发事件与特定领域的关联度展开具体分析,以揭示其风险演化的相关性。需要说明的是,由于本课题属于探索性研究,目前只进行了一些最基础的挖掘工作,因此所列举的数据挖掘成果主要是为了证明对新闻文本进行价值挖掘的可行性,并不能代表相关研究的最高水平。下面将分而述之:

(一)利用权威媒体的全样本数据对四大类突发事件时空分布特征的整体呈现

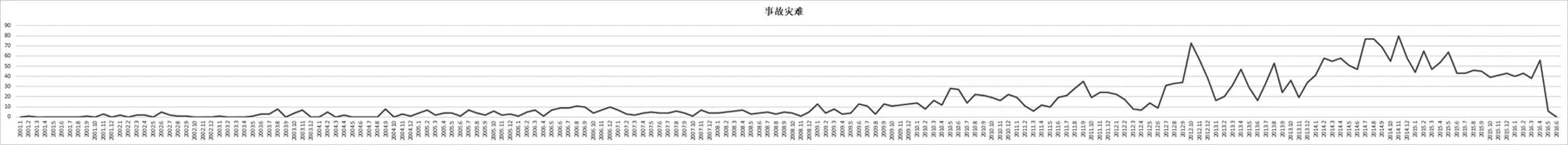

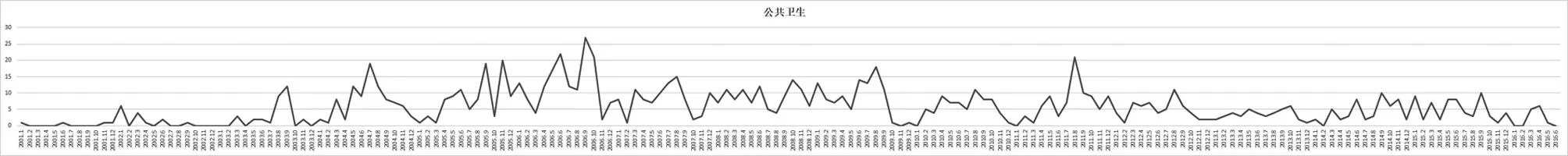

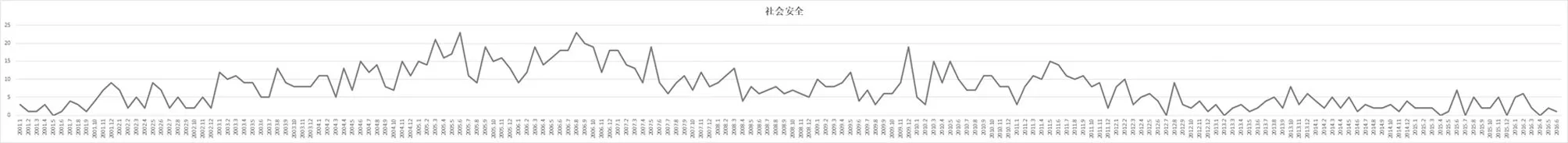

由于突发事件的发生时间和地点是描述其本体特征的重要信息,因此我们在制定EBDPS和MDS时都设置了相应的字段,当基于全网爬取的所有突发事件MDS都录入进数据库之后,即可采用最基础的数据挖掘算法对描述其发生时间和地理位置的结构化数据进行统计分析,以时间和空间两个维度来计算每一类突发事件的发生频次,从而观测其发生的概率是否具有一定的特征?应该说,这也能体现突发事件数据库的最基本功能——即从宏观上了解四大类突发事件在时空中的分布状况。经过初步统计和可视化处理之后,得到了以下三组图表,第一组是从2001年以来四大类突发事件发生频次的年度分布图(以月为最小单位),见图1-图4:

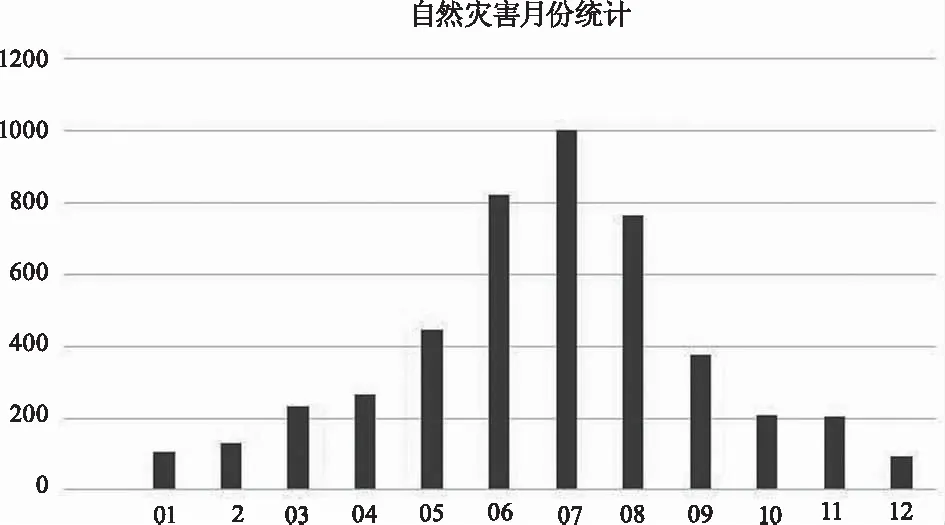

第二组是从2001年以来四大类突发事件发生频次的月份分布图,见图5-图8:

图1 2001-2016中国自然灾害的时间分布

图2 2001-2016中国事故灾难的时间分布

图3 2001-2016中国公共卫生事件的时间分布

图4 2001-2016中国社会安全事件的时间分布

图5 2001-2016自然灾害的月份分布

图6 2001-2016事故灾难的月份分布

图7 2001.1-2016公共卫生事件的月份分布

图8 2001.1-2016社会安全事件的月份分布

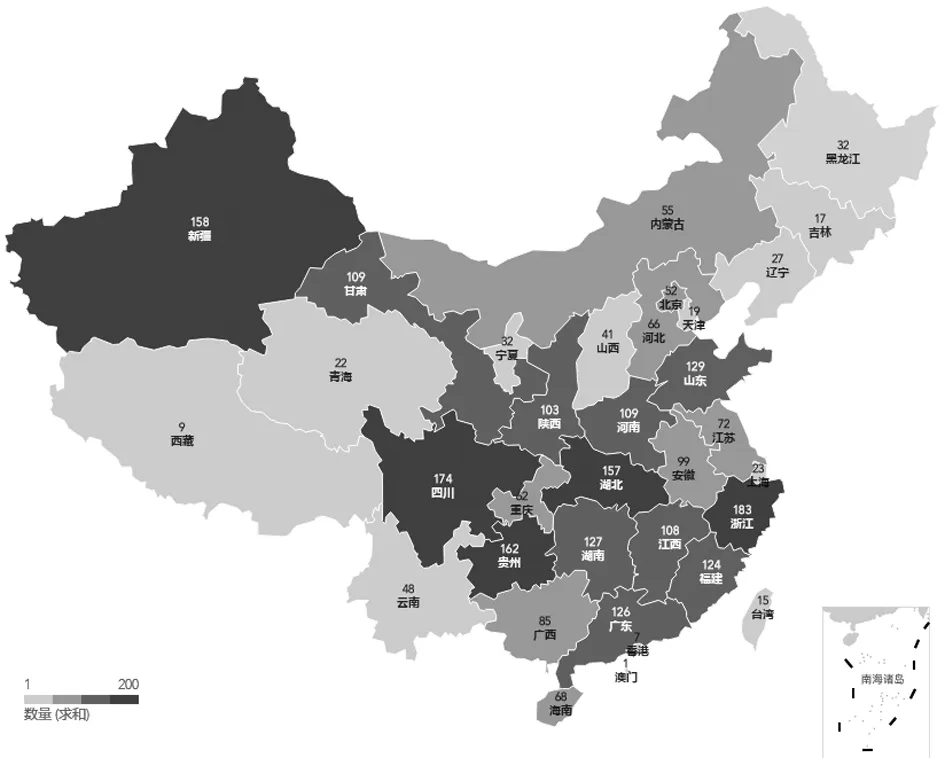

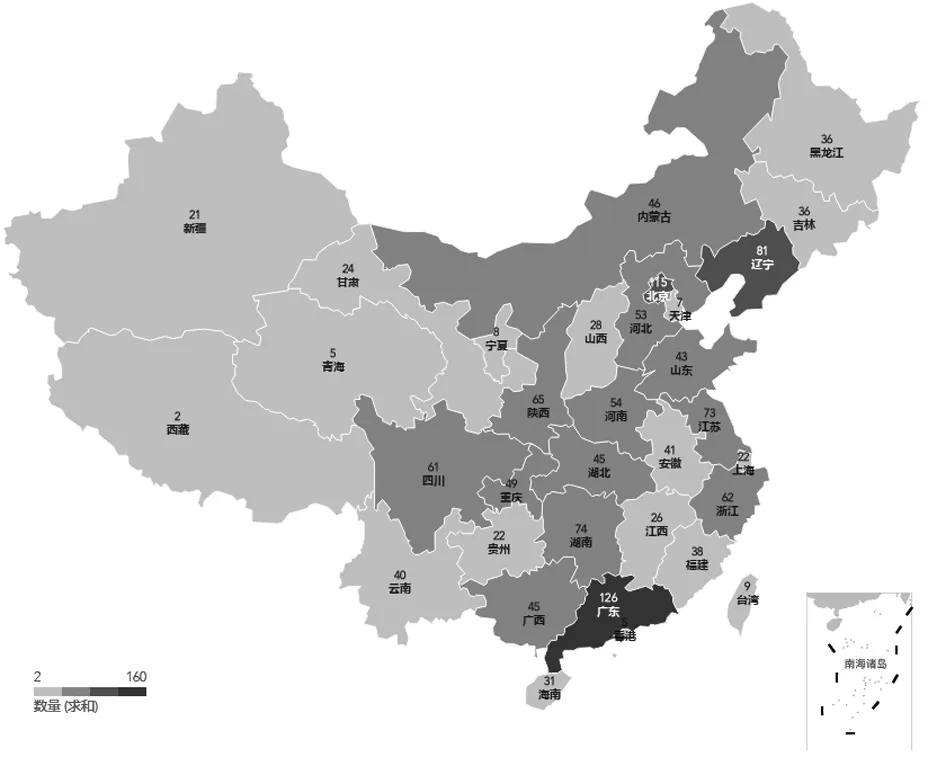

第三组是从2001年以来四大类突发事件的空间分布图(以省份为最小单位),见图9-图12:

图9 2001-2016中国自然灾害的空间分布

图10 2001-2016中国事故灾难的空间分布

图11 2001-2016公共卫生事件的空间分布

图12 2001-2016社会安全事件的空间分布

如果能够掌握全样本的突发事件时空分布特征,对于理解突发事件的发生规律和研究相应的风险防控措施无疑具有重大意义。但就笔者所检索的范围来看,不论是政府部门的权威发布,还是科研院所的研究成果,均未发现有对2001年以来四大类突发事件整体性的时空分布特征进行展示的数据和文献(只有就某一特定类型突发事件的时空分布研究文献),其原因可能是受条块分割的管理体制和领域细分的科研需求所限。而本文基于新闻报道所挖掘出的四大类突发事件时空分布特征的可视化呈现自然不敢称全面,也难以做到精准,但大数据研究本身就意味着对误差的容忍,这一挖掘结果至少给我们提供了从某个侧面(主流媒体新闻报道)“一窥全豹”的契机,也间接证明了新闻文本所蕴含的价值所在。

如果有朝一日政府部门公开了突发事件的相关统计数据,再将其与本文的数据挖掘结果进行比对,抑或还有另一种研究价值:即分析怎样的突发事件才能见诸于媒体?换言之,新闻媒体对于突发事件的报道是依据怎样的标准进行选择的?这样的报道标准凸显了什么内容,又遮蔽了什么内容?那可能会为突发事件相关研究开拓一个新的面向,本文不再展开。

(二)利用相关性运算来揭示某类突发事件在某个特定领域的风险演化

如果说对突发事件时空分布特征的可视化呈现是从整体上让我们获知其发生频次的概貌的话,那么对某一特定类型突发事件的数据挖掘则有助于我们深入分析其对于人类社会的风险影响,而实现这一目标的路径就是对某一具体事件类型的不同维度数据进行相关关系(correlation)运算。

对“相关性”的重视也是大数据的支撑性理念之一,舍恩伯格就曾旗帜鲜明地指出,大数据“要相关性而不是因果性”,安德森(Chris Anderson)甚至有更极端的观点认为:“相关关系的价值已经可以让我们忽略因果关系”。对于本题而言,我们主要分析了特定类型的突发事件与其随后发生的其它事件之间的相关性,以此来推测其风险演化的某些可能性。为了尽可能试验不同的价值适用场景,我们设计了一个以两年为研究周期,以写作硕士研究生学位论文为实现途径,涵盖四大类突发事件的研究计划,并取得了一些之前未曾预料的研究发现。限于篇幅,此处不展开分析过程,仅对其结果做概括性的描述。

在自然灾害领域,骆璟选取了数据库中2011-2015年经过中国境内的全部台风灾害及其衍生灾害的相关信息进行数据挖掘,发现台风除了能造成显而易见的气象灾害以外,还容易引发地质灾害——约占96%的台风发生后均有地质灾害发生,其发生概率从高到低依次是滑坡(23%)、泥石流(19%)、崩塌(8%)和决堤(3%)等,从而以实证数据提出了需要重视对台风衍生灾害的预警建议。

在事故灾难领域,于清在数据库平台上对新华网2005-2015年4983条道路交通事故相关报道进行结构化处理和数据挖掘,发现道路交通事故,提出了高速交通事故的四因素致灾模型,即高速交通事故一般都是由环境(天气、时间等)、道路(路况、地理等)、车辆(机械故障等)、人为(驾驶员、行人等)因素所导致的,并计算出它们在交通事故发生因素中所占的比重,以期能为高速交通事故的传媒预警提供一些借鉴。

在公共卫生事件领域,徐睿含关注的是突发性猪流感对生猪产业链的影响,她通过比对2004-2015年间突发事件数据库中的猪流感疫情数据与农业部发布的《中国农产品价格调查年鉴》中生猪产业链(如猪仔、猪肉、猪饲料等)相关价格数据进行相关性分析,发现猪流感疫情对仔猪价格存在显著负相关关系(时滞6-12个月,相关系数为0.6827),对出栏量也是显著负相关关系(时滞5个月,相关系数为0.6870),但与猪饲料价格、兽医站经营收入则没有太大影响。

在社会安全事件领域,王湘云通过对2006-2016年间1176起抢劫类突发事件的数据挖掘,发现抢劫案件与节气存在一定的相关关系:在相对寒冷的第一和第四季度,抢劫事件的案发率为52.4%,但值得注意的是,二月份多处于中国的农历春节,该月份的案发率全年最低,仅占全年案发总数的6.4%。此外,尽管该研究中的统计数字人口流动的大省往往也是抢劫案件高发的省份,然而并不能说明流动人口是抢劫案件的“主力军”。例如,在广东、浙江等经济发达地区,外籍人员作案比例分别为17%和9%,而在辽宁、新疆等经济欠发达地区,该统计数字分别攀升至27%和32%。作者通过相关性分析发现外来流动人口作案率与该地区的经济发达程度呈显著负相关(相关系数为-0.486)。

当然,从新闻传播学的学术标准来衡量,上述研究发现可能对传统新闻传播学的学术谱系没有太大的理论贡献,但其意义主要在于探索了对新闻报道进行数据挖掘以实现其潜在价值的可行性。正如计算机专家David Hand曾指出的:“(数据挖掘)和所有科研事业一样,许多努力将是没有回报的(做一项保证会成功的研究既是罕见的也是乏味的),但是一旦有了令人兴奋的发现,这些努力就得到了加倍的补偿。”对于本部分研究而言,虽然目前所取得的成果很有限,但其令人兴奋之处在于:发现了作为一种计算机思维的数据库方法对于新闻文本价值挖掘乃至传媒行业转型的启示意义。

六、结语:计算机思维对于媒体转型的战略意义及其反思

数据科学家周涛曾提出:要从能源的高度来重估数据的价值,即计算和数据是现代社会重要的能源和材料,是第三次工业革命的主要推动力。这一典型的计算机思维方式似乎可以提醒我们换一个角度思考传媒行业的转型发展问题:目前,传统传媒业大多遭遇了经营上的困境,“二次售卖”理论对此的解释是:当第一次售卖失败时(传统媒体渠道提供的内容不再被受众选择),第二次售卖也就很难实现了(传统媒体无法将受众售卖给广告商)。学界为了从理论上纾解这一困境,提出过不同版本的“三次售卖”理论,如卖品牌、卖衍生品、卖短信互动、卖价值链等等,但总的看来,上述观点都跳不出传统传媒经营的范畴,究其原因,可能是因为相关研究大多集中在新闻传播学领域,学科的藩篱在一定程度上限制了关于“哪些可以售卖”的想象力。

但计算机思维(特别是数据库理念)的引入却能够让我们拓宽“三次售卖”的思路:因为媒体经年积累的内容资源中其实蕴含着海量的数据,而“通过对海量数据进行分析,能够获得具有巨大价值的产品和服务,或深刻的洞见”,在数据库技术的加持下,诸如新闻报道等媒体内容就可以通过结构化处理流程提炼出数据,进而具备了可供挖掘和售卖的价值,正如舍恩伯格所指出的:“当文字变成数据,它就开始大显神通了——人可以用之阅读,计算机可以用之分析”。因此,本题研究的意义也可以解读为另一种“三次售卖”理论,以此来为传统媒体转型提供一条可供借鉴的路径:传统媒体在“二次售卖”的基础上,还能够通过建设基于自身内容积累的传媒数据库,根据用户的特定需求来进行数据挖掘和分析,即售卖以数据库为载体的“传媒行业所积累的海量数据和基于大数据的增值服务”。

当然,就本课题组目前研究的程度而言,利用计算机思维来建设传媒数据库进而实现新闻价值的完全燃烧,还面临着不少现实障碍。例如:在建设主体层面,现在很多新闻媒体相对缺乏大数据理念,尚未意识到基于自身资源建设传媒数据库的可行性和潜在价值;在数据采集层面,存在着描述性的新闻报道范式与结构化的数据采集标准之间的矛盾,导致很多模糊表达的报道文本很难进行结构化处理;在数据来源层面,大数据思维要求数据源多多益善,因为不同来源的数据叠加在一起时往往能够产生“1+1>2”的效应,但目前条块分割的传媒管理制度和开放程度非常有限的公共数据导致了现在媒体数据库的建设只能以自身积淀的数据为主,如果能够在未来能够引入更多元的数据仓库与传媒数据库进行叠加的话,无疑能从新闻文本中挖掘出更有价值的信息,等等。虽然这些听起来都属于应用层面的问题,但正如罗杰斯(Everett M.Rogers)所指出的:“在传播学史上,面向实际应用的研究选题经常会为抽象理论领域的突破打下基础。”因此,本文不成熟的研究仅仅只是一个粗浅的开始,这些问题都有待于未来更进一步的探索。

(感谢华中师范大学新闻传播学院王然老师对本文所作贡献)

注释:

① [美]丹尼斯·麦奎尔:《麦奎尔大众传播理论》(第4版),崔保国、李琨译,清华大学出版社2006年版,第14页。

② 从技术层面讲,数据库就是关联记录项(或曰关联表,related tables)的自描述(self-describing)集合。见David M.Kroenke、David J.Auer:《数据库原理(第3版)》,清华大学出版社2008年版,第15页;在计算机科学的话语体系中,数据库是持久存储在计算机内有组织、可共享的数据集合。即按照一定的数据模型组织、描述和存储,具有较小的冗余度、较高的数据独立性和易扩展性,并可为用户所共享。见《数据库百科全书》编委会:《数据库百科全书》,上海交通大学出版社2009年版,第11页。

③ 关于计算机科学的分类有不同的说法,如1991年ACM(国际计算机学会)和IEEE(国际电气和电子工程师协会)联合发布的“Core areas of computer science(计算机科学的核心领域)”,将其分为九大种属;维基百科(Wikipedia)则将计算机科学分为十三个门类,但无论哪种划分,都将Database单列为其中一种。

④ 在这里采用的曾任美国卡内基·梅隆大学计算机科学系主任、著名计算机科学家周以真(Jeannette M.Wing)在美国计算机权威期刊《Communications of the ACM》杂志上给出的定义,见Jeannette M.Wing:《Computational Thinking》,《COMMUNICATIONS OF THE ACM》,March 2006/Vol.49,No.3。

⑤ 从某种意义上看,本文可视为该数据库建设的副产品:一则在研发过程中所遭遇的很多难题其实折射出传媒数据库建设的共性困境,这些具体的问题及其解决为本文写作提供了灵感和素材;二则与数据库编程专家贯穿始终的深入讨论甚至争辩,也促使笔者学习如何以计算机科学的思维方式来思考本学科的问题,并尝试将这些思考以本学科畛域的话语方式表达出来。

⑦ 据不完全统计,国内自建数据库的新闻媒体除了前文列举的之外,还有:国家广电总局、解放军报社、北京日报社、广州日报社、浙江日报社、深圳特区报、天津日报社、贵阳日报社、浙江工人日报社、银川晚报社等新闻媒体。

⑧ 上述数据库具体内容依次参见下列文献:葛红霞:《转企改制与构建媒体用户数据库》,《记者摇篮》,2012年第2期;陈秀敏:《广播影视政策研究数据库建设与发展思考》,《广播与电视技术》,2014年第6期;胡新桥,刘志月:《广告专业化数据库生存策略》,《新闻前哨》,2010年第6期;《合润SSI影视剧数据库正式上线》,《声屏世界·广告人》,2013年第7期;刘胜男:《搜狐建立飞手数据库 加速改变新闻生产方式》,《中国传媒科技》,2015年第9期。

⑨ 如贵阳日报数据库就向当地党政机关、企业、高等院校等提供信息服务,见郭英剑,梅敏:《无忧检索、增值管理、服务社会——贵阳日报数据库激活信息数字化》,《中国传媒科技》,2003年第2期。