一种改进的FasterR?CNN对小尺度车辆检测研究

2019-06-19张御宇杨彪邓林红

张御宇 杨彪 邓林红

摘 要: 针对传统Faster R?CNN算法对小尺度车辆检测效果不佳的问题,提出一种改进型网络进行车辆检测的方法。首先,通过改进经典全卷积网络和区域建议网络的结构,增强低层特征与高层特征之间的信息传递;其次,增加更小尺度的锚,从而改善Faster R?CNN对小目标的检测能力;最后,增加锚选择策略,通过平衡锚数量的差异,缓解区域建议网络生成的正负锚数量不平衡问题。文中实验分别在VOC2007、Kitti、真实数据集上对所提方法和传统Faster R?CNN算法进行比较,检测准确率分别提高了9%,8.1%,8.9%。

关键词: Faster R?CNN; 小尺度车辆检测; 全卷积网络; 区域建议网络; 锚选择; 平衡锚数量

中图分类号: TN98?34 文献标识码: A 文章編号: 1004?373X(2019)11?0098?06

Abstract: A vehicle detection method based on improved Faster region convolutional neural network (Faster R?CNN) is proposed to improve the small?scale vehicle′s detection effect by using traditional Faster R?CNN algorithms. The structures of classic fully convolutional network and region proposal network are improved to enhance the information transfer between low?level and high?level features. The anchors with smaller scale are added in Faster R?CNN to improve the detection ability of small?size objects. An anchors selection strategy is used to balance the number of positive and negative anchors generated in the region proposal network. The effectiveness of the proposed method is compared with traditional Faster R?CNN algorithms with VOC2007, Kitti and real datasets, and its accuracy is increased by 9%, 8.1% and 8.9% respectively.

Keywords: Faster R?CNN; small?scale vehicle detection; fully convolutional network; region proposal network; anchor selection; number balance of anchor

0 引 言

随着汽车数量的高速增长,交通事故发生率逐渐增高,其中,后车追尾占事故总数的30%以上[1]。提前检测车辆并预警可以有效避免此类事故的发生。车辆检测技术有很多种,如基于车载传感器和射频识别技术[2]、红外和视觉传感器等。相比于其他方法,视觉车辆检测有许多优势,如容易实施、成本低、性能高。但其依然面临诸多挑战,如部分遮挡、外形差异、尺度变化等。因此,视觉车辆检测已成为当前研究的热点,引起了越来越多的关注。

传统基于视觉的车辆检测以手动提取特征为主,包括Haar,LBP,HOG等。这些方法通常在生成的目标候选区域进行特征提取,然后使用SVM,Random Forest,AdaBoost等分类器判断该区域是否属于真实车辆。这类方法的优势在于速度快,即使在嵌入式平台也可以满足实时性要求,但其检测准确率通常达不到理想状态。

近年来,深度神经网络在目标检测与定位[3]、行人重识别、人脸识别[4]、车辆识别[5]等领域得到了广泛的应用。深度神经网络相比于传统的特征提取方法,效果更佳。诸如R?CNN[6],Fast R?CNN [7],Faster R?CNN(Faster Region Convolutional Neural Network)[8],YOLO[9],SSD[10]等通用目标检测算法都取得了较好的结果。其中,Faster R?CNN算法相比其他方法具有更高的检测精度和检测速率。而在检测小尺度目标时,该算法检测精度会降低,主要是由于网络高层特征对应的感受野较大,在该感受野内小尺度目标区域相对于背景区域非常小,因此在训练阶段存在正负样本数量差异较大的问题(正样本采自目标区域,负样本采自背景区域)。

针对这一不足,本文在通用检测器Faster R?CNN的基础上进行改进,具体改进措施如下:

1) 调整传统神经网络的结构,对全卷积网络进行密集连接,从而增强低层特征与高层特征之间的信息传递;

2) 增加更小尺度的锚,使改进后的算法能够覆盖小尺度车辆目标;

3) 增加锚选择层,缓解区域建议网络生成的正负锚数量不平衡问题。

1 相关工作

车辆检测算法种类颇多,对于静止背景,可以采用背景差法和帧差法,对于变化背景,主要采用光流或特定检测器检测车辆。本文主要关注变化背景下的车辆检测问题,考虑到光流法计算开销极大,主要关注如何设计检测器进行车辆检测。下面对生成候选区域、特征提取、车辆检测三个方面进行分析。

1.1 生成候选区域

滑动窗法经常被用来生成候选区域,但该方法搜索区域大,计算复杂耗时,不利于实时目标检测。因此,大量学者对滑动窗法进行改进,文献[11]提出基于相机位置、距离及目标先验信息的自适应滑动窗方法,加快滑动窗检测速度。文献[12]在滑动窗口上增加几何约束,提高车辆检测的鲁棒性。文献[13?14]通过约束条件加快滑动窗速度,利用粗略语义分割限制滑动窗区域。文献[15?16]对滑动窗使用粗到细的策略,即先使用大尺度窗口粗略寻找目标区域,再使用小尺度窗口对其精细寻找。

1.2 特征提取

得到候选区域后,需要从候选区域中提取车辆特征。Gabor滤波器具有方向和尺度相关特征机制,常被用于描述车辆特征[17]。HOG也属于常用的车辆特征[18]。近年来,Harr特征[19]由于其对垂直、水平、对称结构的敏感性以及计算的高效性,被广泛应用于车辆实时检测,文献[20]将Harr和Gabor结合在一起,加强了检测鲁棒性。

1.3 车辆检测

当从候选区域提取得到车辆特征后,需要用分类器判断该区域是否属于真实车辆。常见的分类算法包括AdaBoost,SVM以及极限学习机等。如:将AdaBoost与Harr特征结合进行快速车辆检测,将SVM与LBP特征结合进行鲁棒的车辆检测。

传统的车辆检测方法在简单环境下表现较好,在复杂交通环境下受到天气、遮挡以及不同车辆之间外形差异大等影响,效果欠佳。近年来,基于深度学习方法的目标检测已经取得很大的成功。许多最新的通用目标检测框架如R?CNN,Fast R?CNN,Faster R?CNN,YOLO以及SSD被用来检测不同种类目标,有研究者尝试将生成候选区域、特征提取和分类器结合,利用通用的端到端的检测框架检测指定道路的车辆。如文献[21]使用基于序列蒙特卡罗滤波器将通用Faster R?CNN检测器使用到特定车辆场景下;文献[22]深入研究Faster R?CNN的尺度问题,改善了候选区域的选择方法,并且在这些区域上选择更优的尺度,以提高在小尺度车辆上的检测性能;文献[23]通过语义分割检测车辆,为自动驾驶设计了一个快速场景理解系统。

2 本文方法

2.1 Faster R?CNN

文献[8]提出一种通用目标检测框架Faster R?CNN,在VOC2007数据集上对20类目标进行检测,平均精度达到73.2%。不同于R?CNN与Fast R?CNN,Faster R?CNN使用区域建议网络(RPN)生成候选区域,提高检测速度和准确率。

RPN网络通过输入任意大小的图片,得到若干矩形区域候选框,其中每个候选框对应目标存在的概率和位置信息。在特征图上使用3×3的卷积核与特征图进行卷积,得到一个三维矩阵数据结构。在3×3的区域上,每一个特征图上得到一个1维向量,256个特征图即256维向量。在最后一个卷积层的特征图上,每个像素点称为一个锚。每个Anchor对应于输入图像预测3种尺度(如1282,2562,5122,单位为像素)、3种宽高比(1[∶]1,1[∶]2,2[∶]1)的9个区域。将其输入到两个全连接层,即分类层和回归层,分别用于分类和包围框(Bounding Box)回归。根据提议区域得分高低,选取前300个候选区域输入Fast R?CNN进行目标检测。

2.2 改进的Faster R?CNN

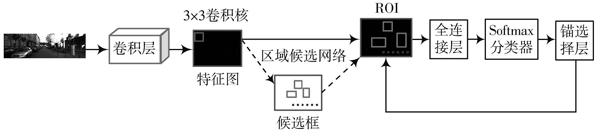

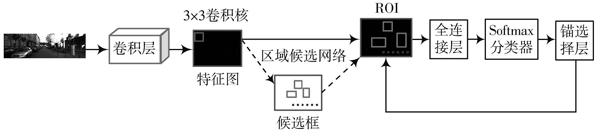

正常尺度车辆样本图片在Faster R?CNN下检测效果较好,但对小尺度车辆检测效果不佳,因此本文对Faster R?CNN进行改进,使其对于小尺度车辆有更好的检测效果。图1为本文改进的训练网络的总体框架图,主要有三处改进,下文将详细介绍。

图1 改进的Faster R?CNN模型框图

1) 本文在传统Faster R?CNN的基础上添加了两个更小的锚(322,642,单位为像素)。对于每个尺度的锚,仍旧使用1[∶]1,1[∶]2,2[∶]1作为宽高比,其余的参数均保持与經典Faster R?CNN算法相同,特征图上每个像素位置可产生15个锚。

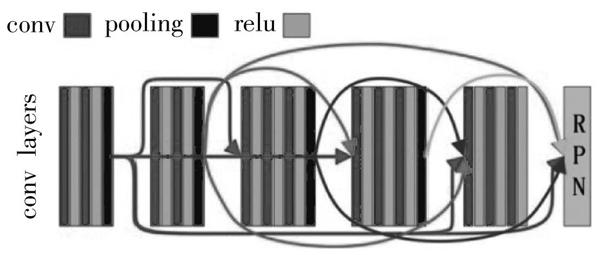

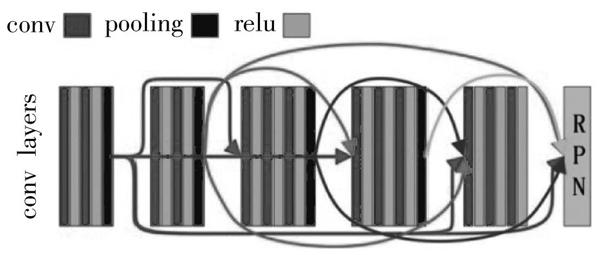

2) 文献[22]认为通过Faster R?CNN中的全卷积网络会得到较大的感受野,从而检测到更多的图像信息。小尺度的目标容易受到更多背景信息的干扰,往往会被平滑从而造成漏检。因此,使用底层卷积信息获取较小的感受野,但忽视了层次之间信息传递的效率,所以精度方面没有明显提高。图2借鉴文献[24]提出的DenseNet,增加了层与层之间的联系,将前面所有层的输出作为本层的输入,加强特征传播和特征信息共享。

图2 卷积层密集连接

3) 图片背景面积较大,车辆所占区域较小,这使得训练过程中正负锚的数量差异较大。在训练和测试的过程中,选取具有较高训练损失的负样本,较随机抽样所有的负样本效果更好[25]。因此,本文在训练过程中增加锚选择层,在测试阶段,需要移除锚选择层,同时选取训练损失较高的正负锚,具体锚选择算法如下:

式中:[Ncls]为每次迭代的最小批量;[Lcls]为交叉熵损失;[pi]和[p*i]分别是第[i]个锚点的预测概率以及对应的标签,如果是正样本则标签为1,反之则为0。

3 实验分析

3.1 实施细节和评价指标

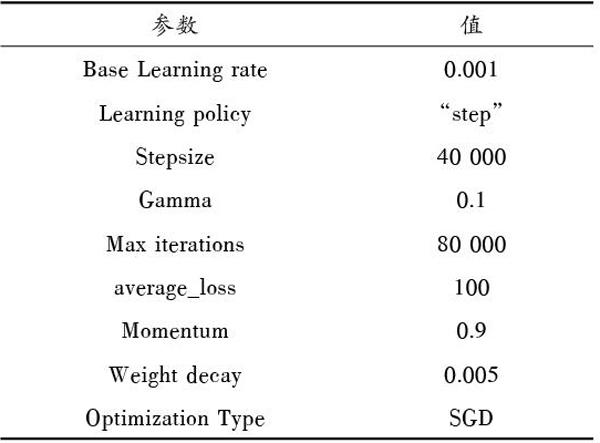

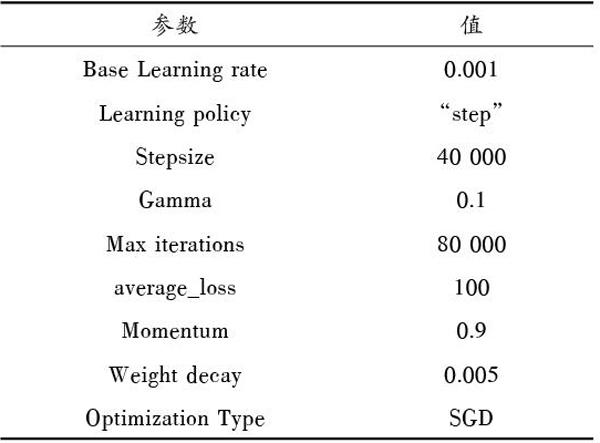

本文使用的改进Faster R?CNN框架与通用Faster R?CNN一样,都是以VGG16作为模型初始化。本文在每个像素位置使用滑动窗,生成15个边界框(5个尺度[322,642,1282,2562,5122]和3类长宽比[1[∶]1,2[∶]1,1[∶]2])。从不同的数据库选取车辆图片,对Faster R?CNN进行端到端微调,交叠率(IOU)阈值设置为0.7。其他的网络参数参照Faster R?CNN(见表1),采用交替训练的方法[4]在NVIDA Gefore Titan X GPU (12 GB)下训练Faster R?CNN。

表1 训练阶段使用的主要参数

式中:[TP]表示车辆被正确预测的数目;[FP]表示非车辆被预测为车辆的数目;[FN]表示车辆被预测为非车辆的数目。精度和召回率直接反映出分类效果的优良,[F1]?分数是两者的折中表示。

3.2 VOC2007数据集检测结果

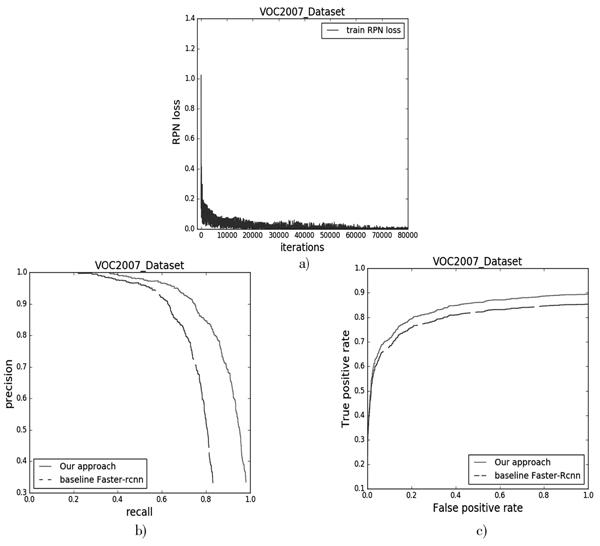

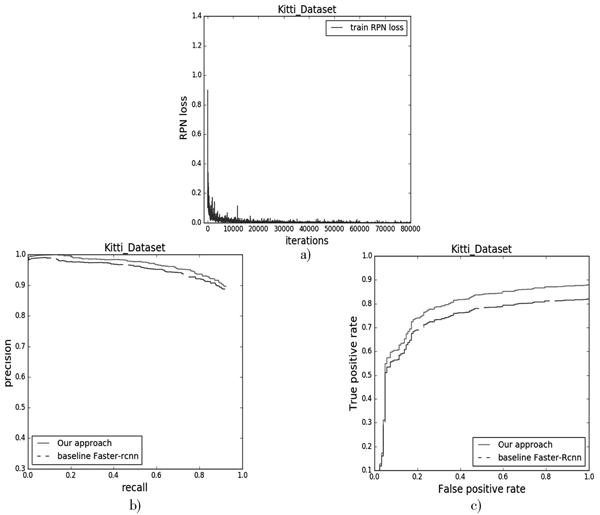

VOC2007数据集包含2 501张训练图片(6 301个目标)和2 510张测试图片(6 307个目标),总共21类,有自行车、鸟、汽车、飞机等。本文从中选取1 430张包含车量的图片,并使用5折交叉验证进行检验,并得到三个评价指标上的最终结果。在VOC2007上使用本文方法的RPN loss如图3a)所示,结果表明,损失随着迭代的增加逐渐收敛。

图3 VOC2007数据集训练曲线

VOC2007数据集上的Precision?Recall曲线和ROC曲线如图3b)和图3c)所示,从图中可以看出本文方法对Faster R?CNN进行的改进有显著效果。

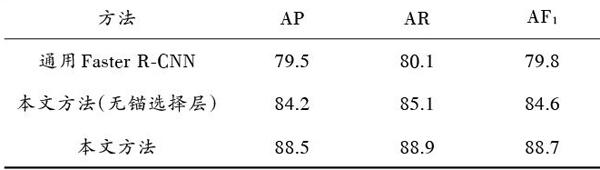

表2中列出了不同方法在VOC2007数据集上的平均精确率(Average Precision,AP),平均召回率(Average Recall,AR)和平均[F1]?分数(Average [F1]?score,[AF1])。在使用锚选择之前,本文的整体效果比Faster R?CNN提升4%~5%,而在增加锚选择层之后,平衡训练时的正负样本数据,各个指标在此基础上又提高了3%~4%。

表2 VOC2007数据集上的定量比较分析

本文方法与通用Faster R?CNN在检测结果上的定性比较如图4所示。在正常尺寸下,两种方法的检测效果相当,但是对于如图4第4列所示的小尺度目标来说,通用检测器效果不佳,但本文方法效果较好。

3.3 Kitti数据集检测结果

Kitti数据集总共包含7 841张图片,本文选取6 600张包含车辆的图片,并使用6折交叉验证进行检验,最终得到3个指标上的结果。实验结果在训练阶段会随着迭代次数的增加越来越收敛,如图5a)所示。

图4 VOC2007数据集上的定性比较分析

图5 Kitti数据集训练曲线

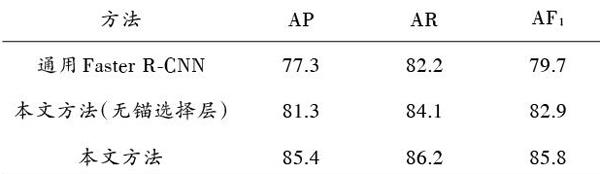

在Kitti數据集上Precision?Recall曲线图和ROC曲线图分别如图5b)和图5c)所示。从图中曲线结果可以明显看出,本文方法优于通用Faster R?CNN。表3描述了各类方法AP,AR,[AF1]的定性比较,从表中结果可以看出每一项指标不使用锚选择层的情况下,有2%~4%的增长,增加锚选择后,相对于通用Faster R?CNN算法有8%~9%的增长。

表3 Kitti数据集上的定量比较分析

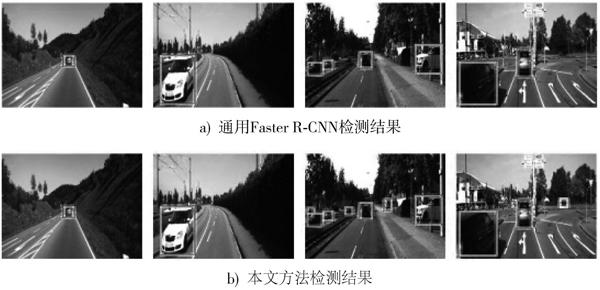

图6给出了在Kitti上本文方法和通用Faster R?CNN的定性检测效果,如图中第3、4列所示,本文的方法在小尺度目标上的检测效果优于通用Faster R?CNN,但是两种方法都不能有效地解决目标遮挡问题。

图6 Kitti数据集上的定性比较分析

3.4 实际数据的检测结果

本文的实际数据集是从实际车载摄像机拍摄的视频中进行截取的,本文总共选取了3 000张车辆图片。使用5折交叉验证进行检验,并最终得到3个指标的结果,从图7a)中可以看出,随着迭代次数的增加,损失逐渐收敛。

图7 实际数据集训练曲线

如图7b)、图7c)所示为实际数据集上的Precision?Recall曲线和ROC曲线,可以看出本文所提方法明显优于通用Faster R?CNN。表4列出了3个指标的对比(AP,AR,AF1),由于实际采集的图片比通用数据集包含更复杂的道路情况(如行人穿插、自行车等),检测效果弱于在通用数据集上的检测效果,但本文方法在车辆检测上明显优于Faster R?CNN。

图8是在实际场景车辆数据集上两种方法的定性比较,可以看出本文方法可以有效地检测小尺度车辆(如第3、4列所示),通用Faster R?CNN只可以检测正常大小车辆,但是两种方法都不能较好地检测出遮挡车辆(如图8第1列所示)。

表4 实际数据集上的定量比较分析

图8 实际数据集上的定性比较分析

4 结 论

本文对通用的Faster R?CNN检测框架进行改进,将其运用到小尺度车辆的检测中。本文首先选取车辆图片对Faster R?CNN进行微调,并且重新设计了全卷积网络和区域建议网络。将全卷积网络密集连接增强了不同层之间的信息交互,在区域建议网络中增加两个更小尺度的锚以检测小尺度车辆。同时在训练阶段增加了锚选择层以缓解正负样本不平衡的问题。通过在VOC2007、Kitti以及实际数据集中与传统的Faster R?CNN进行对比,本文方法在平均精度指标上分别得到了9%,8.1%,8.9%的提高。但是,本文方法仍然无法解决严重的车辆遮挡问题,未来将尝试通过特征加工解决车辆严重遮挡导致的漏检问题。

参考文献

[1] National Transportion Safety Board. Special investigation report?highway vehicle and infrastructure?based technology for the prevention of rear?end collisions [R]. [S.l.]: National Transportion Safety Board, 2001.

[2] SONG X, LI X, TANG W, et al. A fusion strategy for reliable vehicle positioning utilizing RFID and in?vehicle sensors [J]. Information fusion, 2016, 31(C): 76?86.

[3] JONGPIL K, PAVLOVIC V. A shape?based approach for salient object detection using deep learning [C]// 2016 European Conference on Computer Vision. Switzerland: Springer, 2016: 455?470.

[4] 吴尧,邱卫根.基于改进的深度卷积神经网络的人脸识别[J].计算机工程与设计,2017,38(8):2246?2250.

WU Yao, QIU Weigen. Face recognition algorithm based on improved deep convolutional neural network [J]. Computer engineering and design, 2017, 38(8): 2246?2250.

[5] 蔡英凤,王海,陈龙,等.采用视觉显著性和深度卷积网络的鲁棒视觉车辆识别算法[J].江苏大学学报(自然科学版),2015,36(3):331?336.

CAI Yingfeng, WANG Hai, CHEN Long, et al. Robust vehicle recognition algorithm using visual saliency and deep convolutional neural networks [J]. Journal of Jiangsu University (Na?tural Science Edition), 2015, 36(3): 331?336.

[6] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation [C]// Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2014: 580?587.

[7] GIRSHICK R. Fast R?CNN [C]// 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015: 1440?1448.

[8] REN S, HE K, GIRSHICK R, et al. Faster R?CNN: towards real?time object detection with region proposal networks [J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 39(6): 91?99.

[9] REDMON J, FARHADI A. YOLO9000: better, faster, stronger [C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 6517?6525.

[10] LIU W, ANGUELOV D, ERHAN D, et al. Ssd: single shot multibox detector [C]// 2016 European Conference on Computer Vision. Swizerland: Springer, 2016: 21?37.

[11] HASELHOFF A, KUMMERT A. A vehicle detection system based on Haar and triangle features [C]// 2009 IEEE Intelligent Vehicles Symposium. Xian: IEEE, 2009: 261?266.

[12] SUDOWE P, LEIBE B. Efficient use of geometric constraints for sliding?window object detection in video [C]// 2011 International Conference on Computer Vision Systems. [S.l.]: Sprin?ger, 2011: 11?20.

[13] CARREIRA J, SMINCHISESCU C. CPMC: automatic object segmentation using constrained parametric min?cuts [J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(7): 1312?1328.

[14] ENDRES I, HOIEM D. Category independent object propo?sals [C]// 2010 European Conference on Computer Vision. [S.l.]: Springer, 2010: 575?588.

[15] GEISMANN P, SCHNEIDER G. A two?staged approach to vision?based pedestrian recognition using Haar and HOG features [C]// 2008 IEEE Intelligent Vehicles Symposium. Eindhoven: IEEE, 2008: 554?559.

[16] PEDERSOLI M, GONZ?LEZ J, BAGDANOV A D, et al. Efficient discriminative multiresolution cascade for real?time human detection applications [J]. Pattern recognition letters, 2011, 32(13): 1581?1587.

[17] SUN Z, BEBIS G, MILLER R. On?road vehicle detection using Gabor filters and support vector machines [C]// 2002 IEEE the 14th International Conference on Digital Signal Proces?sing. Santorini: IEEE, 2002: 1019?1022.

[18] YUAN Q, THANGALI A, ABLAVSKY V, et al. Learning a family of detectors via multiplicative kernels [J]. IEEE transactions on pattern analysis and machine intelligence, 2011, 33(3): 514?530.

[19] CHANG W C, CHO C W. Online boosting for vehicle detection [J]. IEEE transactions on systems, man, and cyberne?tics, 2010, 40(3): 892?902.

[20] SUN Z, BEBIS G, MILLER R. Improving the performance of on?road vehicle detection by combining Gabor and wavelet features [C]// 2002 IEEE the 5th Conference on Intelligent Transportation Systems. Singapore: IEEE, 2002: 130?135.

[21] MHALLA A, CHATEAU T, MA?MATOU H, et al. SMC Faster R?CNN: toward a scene?specialized multi?object detector [J]. Computer vision and image understanding, 2017, 164: 3?15.

[22] GAO Y, GUO S, HUANG K, et al. Scale optimization for full?image?CNN vehicle detection [C]// 2017 IEEE Intelligent Vehicles Symposium. [S.l.]: IEEE, 2017: 785?791.

[23] NEVEN D, DE BRABANDERE B, GEORGOULIS S, et al. Fast scene understanding for autonomous driving [C]// 2017 IEEE Symposium on Intelligent Vehicles. [S.l.]: IEEE, 2017: 1?5.

[24] HUANG G, LIU Z, WEINBERGER K Q, et al. Densely connected convolutional networks [EB/OL]. [2018?01?28]. https://arxiv.org/pdf/1608.06993.pdf.

[25] SHRIVASTAVA A, GUPTA A, GIRSHICK R. Training region?based object detectors with online hard example mining [C]// 2016 IEEE Conference on Computer Vision and Pattern Re?cognition. Las Vegas: IEEE, 2016: 761?766.