面向蜂窝结构件的机器人视觉定位方法

2019-05-09张嘉礼谭朝元刘海波李兰柱王永青

张嘉礼 李 特 谭朝元 刘海波 刘 阔 李兰柱 王永青

面向蜂窝结构件的机器人视觉定位方法

张嘉礼1李 特1谭朝元2刘海波1刘 阔1李兰柱2王永青1

(1. 大连理工大学机械工程学院精密与特种加工教育部重点实验室,大连 116024; 2. 航天材料及工艺研究所,北京 100076)

针对航空航天等领域蜂窝夹层结构件机器人化制造中的蜂窝型特征精确定位问题,提出了一种利用双目视觉引导工业机器人进行蜂窝夹层结构件单孔灌注的定位方法。目标区域分割原始双目图像,并通过双目匹配计算生成三维深度图;边缘检测、膨胀、腐蚀、骨骼提取、多边形拟合处理左图像蜂窝棱边,获得蜂窝角点特征的二维坐标,再利用深度图获得蜂窝特征角点空间坐标。利用6个角点坐标计算得到蜂窝芯孔的空间定位位姿信息。最后,在工业机器人和双目相机构成的定位系统上定位试验蜂窝结构件。结果表明:该定位方法能够精确定位存在一定变形的蜂窝芯孔(非标准六边形),其定位精度约为2mm,能够满足灌注作业精度要求。

工业机器人;机器视觉;机器人定位;蜂窝特征

1 引言

为保证飞机等飞行器内部重要仪器设备的安全性,需要在某些结构部件中安装蜂窝夹层[1,2]。密集排列的蜂窝状芯孔较多采用隔热件夹层结构。制造蜂窝夹层结构件时,需要在芯孔中填充隔热材料[3,4]。为解决人工灌注出现的质量差、效率低、劳动强度高等难题,制造过程机器人化已成为迫切需求。机器人灌注装置在蜂窝结构件上的精准定位是技术难题之一。

针对机器人定位问题,国内外学者提出了很多行之有效的方法。孟浩[5]等提出了一种结合SIFT特征点的双目立体视觉定位方法,能够对双目视觉中的左右图像分别检测特征点实现精确双目定位。李靖[6]等为降低双目视觉中稠密对应点匹配的复杂度,引入编码结构光条纹约束空间从而实现三维重建。宋忠超[7]基于三维光学扫描,将处理后的点云数据与三坐标测量仪数据相融合,有效解决了蜂窝轮廓的计算。李刚[8]针对密集规则排列物体,提出了一种特征拟合方法实现蜂窝孔中心的识别定位。仲训杲[9]等研究了多模特征深度学习与融合方法,并应用于高精度定位引导。然而,由于密集排列的隔热夹层件存在局部变形、毛刺、大量重复特征等不利于识别因素,导致机器人末端执行装置定位难度较大。

因此,以蜂窝夹层件芯孔的精确定位为目标,提出了一种基于双目立体视觉的机器人末端执行装置定位方法。通过分析蜂窝排列方式,分割出目标区域降低处理难度;采用基于闭运算的蜂窝角点特征提取方法计算蜂窝角点坐标;根据角点坐标计算出蜂窝轮廓的空间位姿;最后,验证了所提定位方法对蜂窝特征结构件的有效性。

2 基于双目立体视觉的定位原理

图1 隔热夹层件实物

夹层结构件一般由密集排布的正六边形蜂窝芯孔构成,如图1所示。视觉定位目的在于辅助机器人及末端执行装置精准定位在芯孔的中心位置。由于制造工艺限制,蜂窝芯孔往往存在一定程度的不规则形变和边缘毛刺。因此,蜂窝芯孔的视觉定位存在以下特点:

a. 特征重复:蜂窝芯孔的高重复性会使几何特征难以区分,引起视觉测量过程中目标点误匹配,从而导致识别误差;

b. 几何变形:蜂窝受挤压等因素影响,实际形状与正六边形有一定偏差,导致难以用先验模型特征匹配识别;

c. 毛刺干扰:蜂窝棱边凸起的毛刺会影响边界特征分布,导致边缘提取困难。

综合考虑蜂窝芯孔视觉定位特点及空间位姿识别需求,提出了一种基于双目立体视觉信息的机器人精准定位方法。

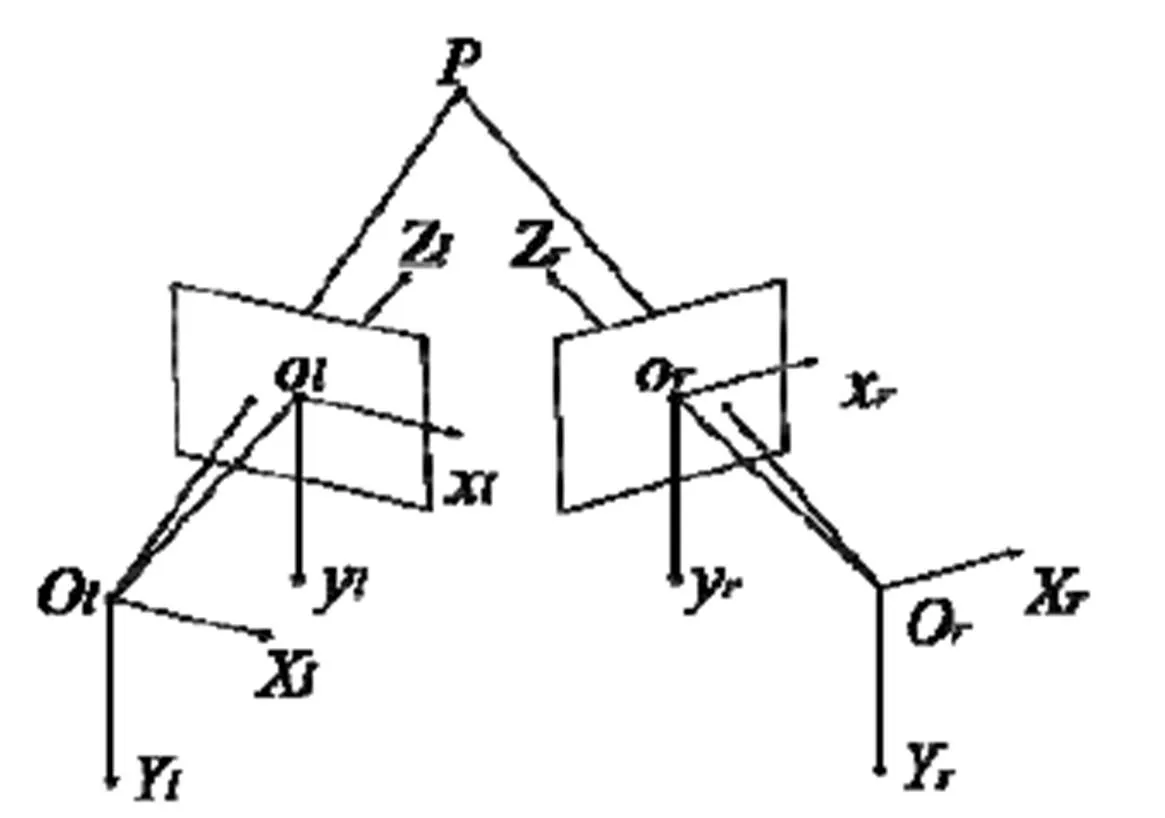

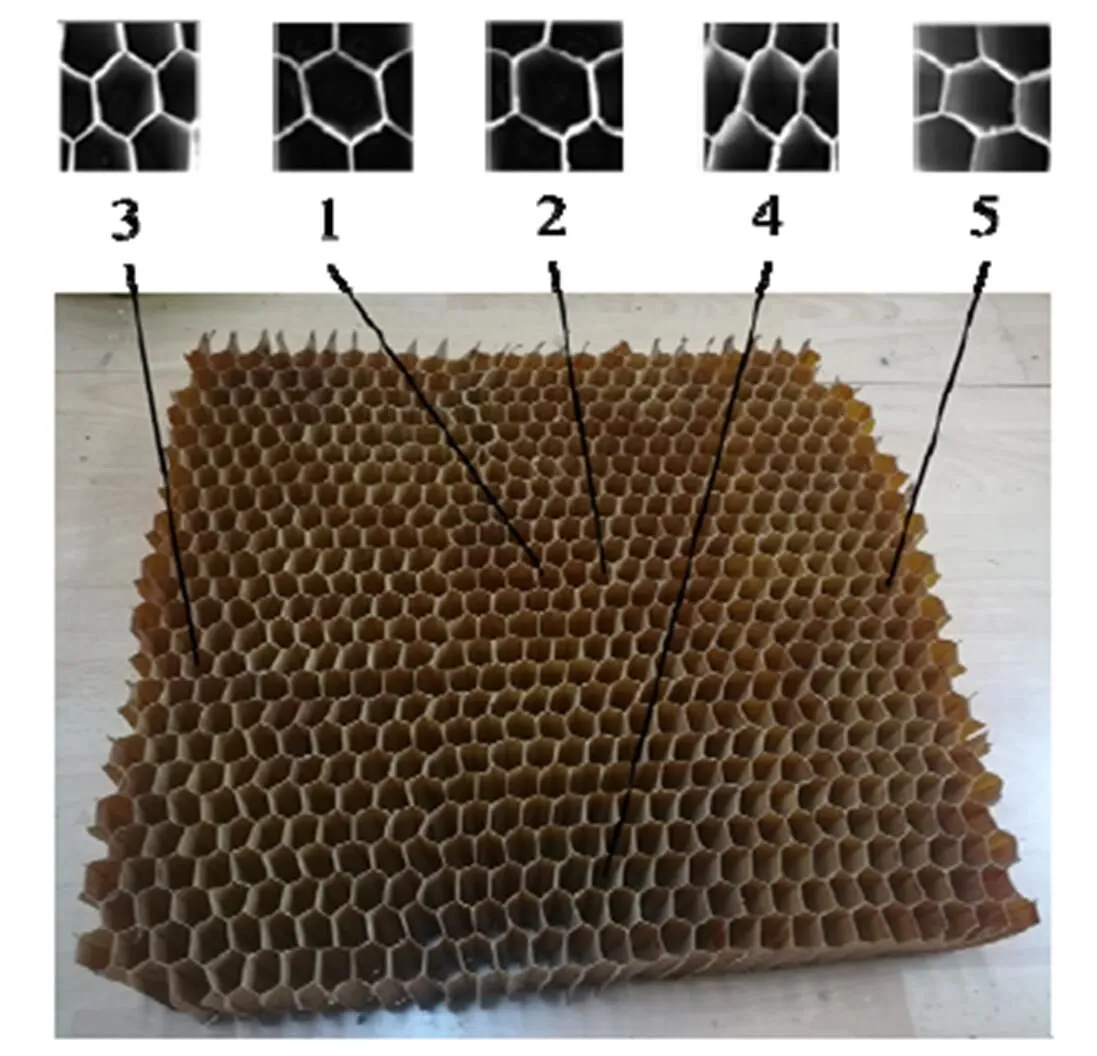

图2 双目测量原理

双目立体视觉定位是基于视差原理由左右两个相机图像中匹配点的二维像素坐标重建空间点三维坐标。如图2所示,设左相机坐标系为O-XYZ,原点位于光心上,其图像坐标系为o-xyz,有效焦距为f;右相机坐标系为O-XYZ,原点位于光心上,其图像坐标系为o-xyz,有效焦距为f;为物体空间点,在左右两相机平面内的坐标分别为(x,y)和(x,y);世界坐标系与左相机坐标系重合,且右相机坐标系与左相机坐标系之间的位置关系可由一个空间转换矩阵表示:

空间点三维坐标可以表示为:

图3 双目视觉定位流程图

基于双目视觉的蜂窝特征定位方法流程如图3所示,具体为:

a. 将双目相机安装于工业机器人末端法兰盘上,组成手眼检测系统;

b. 根据蜂窝分布特征分割定位芯孔的目标区域图像,以降低计算复杂度;

c. 双目图像立体匹配、视差计算及深度图构建;

d. 左右相机图像预处理,获取蜂窝角点在图像中的二维坐标信息;

e. 根据深度图,解算角点特征的三维坐标信息;

f. 根据目标蜂窝角点特征的空间坐标计算蜂窝芯孔位姿,完成空间定位。

3 蜂窝芯孔特征图像处理方法

3.1 目标区域图像分割

蜂窝型结构中含有大量重复性特征,在双目匹配过程中会导致特征点的误匹配从而对测量精度产生影响。因此,提出分割双目图像的方法,以保留目标区域局部特征,同时缩小搜索空间,提高计算速度。

图像的分割效果如图4所示。结合蜂窝材料的成型方法,找到与粘胶垂直的方向,即图4中的水平方向,该方向上的蜂窝呈直线均布。根据视场范围、相机机距和采集高度计算出同一特征在左右两幅图像中的视差值。分别只选取固定视差的区域为有效区域计算,例如图4中的实线框区域。完成一个蜂窝孔的定位后,相机沿水平方向平移一个蜂窝的位置,则虚线框中的蜂窝会进入有效区域。通过调整第一次拍照的位置就可以对同一行的蜂窝连续定位计算。

图4 图像分割效果

3.2 基于闭运算的蜂窝角点特征提取

蜂窝的不规则变形与随机分布的毛刺会导致特征边界像素点灰度值分布不均匀,从而严重干扰对蜂窝边界特征的识别与提取。提出基于闭运算原理的蜂窝角点特征提取方法,获得角点三维坐标。

首先,立体匹配分割处理后的双目图像。综合考虑计算速度与精度要求,采用块匹配算法[10]。块匹配算法使用绝对误差累计的小窗口来检测两幅图像之间的匹配点。最优匹配点是由匹配代价决定的。匹配代价值越小表示匹配度越高。双目匹配分割后有效区域得到视差图,结合相机内外参数计算出深度信息,即图像每个特征点的三维坐标。

匹配代价公式如下:

其中,、和分别表示匹配窗口中点的灰度值、窗口大小和窗口位移量。

图5 左图像二维角点特征提取

选取左图像,基于闭运算提取二维角点特征坐标,如图5所示。提取过程包括边缘检测、膨胀、腐蚀和骨骼提取4个步骤。

步骤1:基于Canny边缘检测方法检测分割后的局部蜂窝图像边缘。Canny边缘检测是基于图像梯度理论的边缘检测算法,其原理是将原始图像矩阵(,)进行高斯滤波,并得到矩阵(,)×G(,)(为尺度因子)。再对矩阵()×G()进行梯度计算,其梯度矢量的模M和方向A分别为:

图像边缘特征点即为在A方向上使M取得局部极大值的点。如图5a所示,左蜂窝图像经边缘检测后只剩下六边形蜂窝边缘轮廓信息。边缘提取实现了亮度变化明显特征点的标识及噪点剔除。

步骤2:采用膨胀算法将由蜂窝变形和光线引起的边缘不完整特征进行修补,如图5b所示,实现两条不完整的蜂窝棱边的封闭连接。

步骤3:基于腐蚀算法细化膨胀后图像如图5c所示,消除小且无意义的点。由膨胀和腐蚀组成的闭运算方法具有填充蜂窝棱边图像的不规则细小空洞、连接邻近特征及平滑边界的作用。

步骤4:基于Zhang并行快速细化算法的骨骼提取运算。骨骼提取运算是将图像核心骨架特征保留与赘余点删除的方法。Zhang并行快速细化算法具有速度快、曲线连通和无毛刺等特点[11],适合于蜂窝型结构的骨骼提取。如图5d所示,经骨骼提取后,可将腐蚀后的蜂窝棱边厚度进一步消除,得到由棱边中心特征点组成的单像素厚度轮廓。

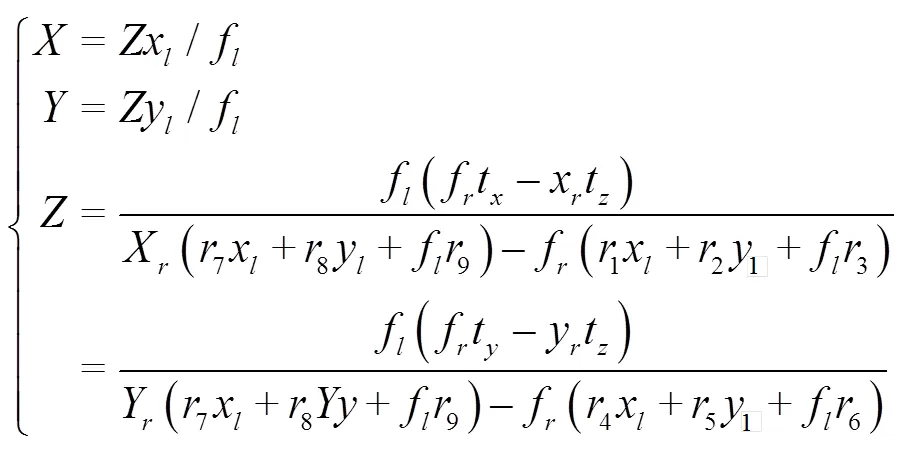

基于道格拉斯-普克算法进行蜂窝棱边轮廓点集的多边形拟合,获得蜂窝角点在图像当中的二维坐标值。道格拉斯-普克算法是将曲线近似表示为一系列点组成的折线,以减少点数量的一种拟合算法。拟合效果如图6a所示,将拟合结果投影到原图上的效果如图6b所示。可以看出,本文所提出的基于闭运算的蜂窝角点特征提取方法能够准确有效地得到蜂窝角点在单幅图像中的二维坐标值。将拟合得到的二维蜂窝角点坐标代入深度图中,计算得到目标蜂窝的6个角点三维坐标值。

图6 图像预处理流程

3.3 蜂窝芯孔空间定位模型

在获得蜂窝特征角点在世界坐标系(即左相机坐标系)O-XYZ下的空间坐标1~6后,如图7所示,需要建立蜂窝芯孔定位模型,即机器人末端为实现灌注操作需要到达的空间位姿点。

图7 蜂窝芯孔位姿计算方法

蜂窝芯孔中心点的坐标可以认为是6个蜂窝角点坐标值的平均值:

使用最小二乘法可以将6个蜂窝角点拟合出一个蜂窝表面所在的平面,该平面的法向量即为蜂窝芯孔的空间姿态。

4 机器人视觉定位实验

4.1 系统搭建

基于双目视觉的工业机器人蜂窝灌注定位系统主要由KUKA工业机器人、双目工业相机和控制系统三部分组成,如图8所示。

图8 基于视觉的工业机器人蜂窝灌注定位系统

采用KUKA KR120R 2500PRO型工业机器人,其有效负载120kg、工作半径2500mm,能够实现2m×1.5m蜂窝件的全区域定位。采用Basler acA2440-20gm型工业相机,其分辨率为2440px×2040px、搭配镜头焦距为8mm。当相机采集距离为200mm时,有效视野为 215mm×180mm、分辨率为0.088mm,能够满足视觉定位精度需求。

工业相机固定在机器人末端的执行装置上,与机器人构成一个“眼在手”的视觉定位系统。工业相机通过网线将采集到的蜂窝图像发送给控制系统。控制系统以visual studio2017为开发工具,实现机器人定位功能。控制系统通过TCP/IP协议将蜂窝芯孔定位的位姿数据传递给机器人。机器人根据接收到位姿数据规划轨迹并移动到目标位置,完成定位。

4.2 定位实验结果

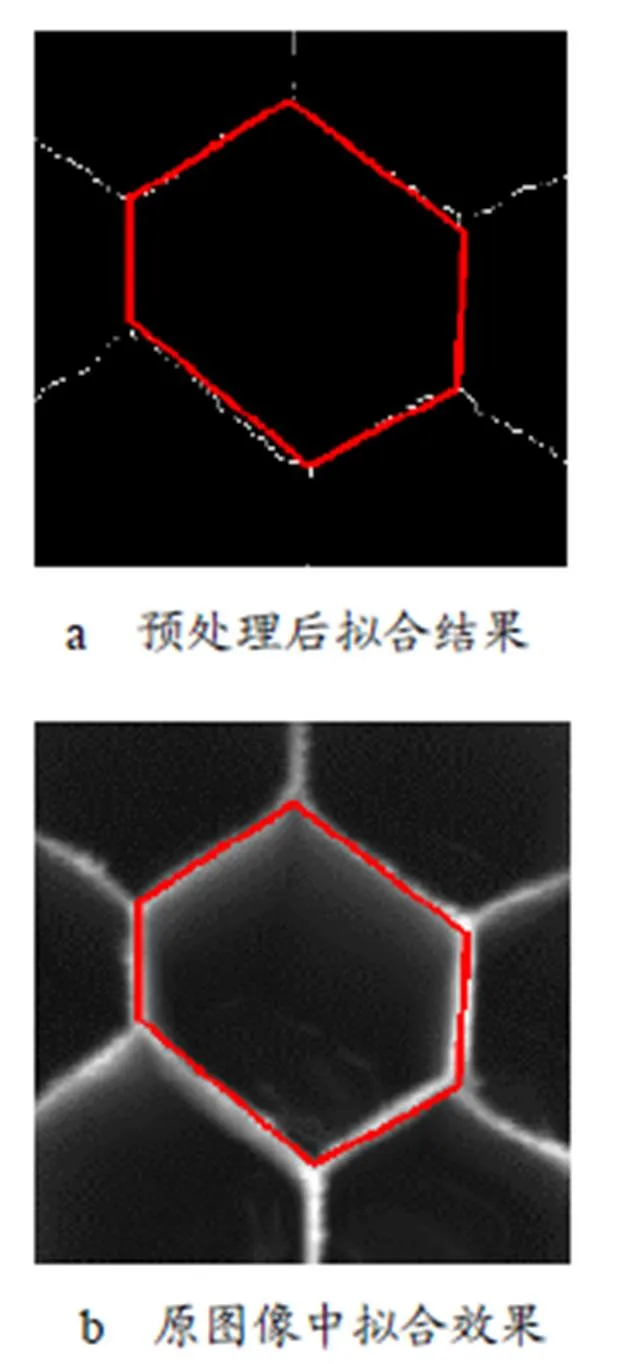

在基于双目视觉的机器人定位精度验证试验中,采用边长15mm、棱边厚1.5mm、孔深50mm的蜂窝结构件,并选取5个具有不同变形特征的蜂窝芯孔,如图9所示。

图9 试验用蜂窝件

表1 机器人X、Y、Z轴定位结果 mm

表2 机器人B、C轴定位结果 (°)

在机器人达到实际定位位置后,记录下实际定位位置的机器人末端执行器六自由度坐标。再通过示教器调整机器人位置,使其运动到后续能够灌注的理论位置并记录下此时机器人末端执行器六自由度坐标,将两者进行比较。、、轴误定位结果如表1所示,、轴定位结果如表2所示(轴上误差为0)。在水平位移方向上实际定位位置和理论位置的定位误差最大值为1.37mm,平均值为0.72mm。考虑到灌注头直径为16mm、蜂窝内切圆直径约为26mm,在此误差范围内灌注头能够保证完全在蜂窝芯孔内而不会对蜂窝造成破坏。在竖直方向上实际定位位置和理论位置的定位误差最大值为1.88mm,平均值为1.23mm,在后 续灌注工艺允许的高度误差内。旋转方向上误差最大值为2.89°,平均值为1.92°,蜂窝孔平均深度为50mm 时伸入底端的最大偏差为2.52mm,平均偏差为2.34mm,能够满足对于后续工艺定位的需求。

5 结束语

针对蜂窝材料灌注定位困难的问题,提出了一种基于双目视觉信息定位蜂窝芯孔特征的方法,并以工业机器人为载体,实现了机器人末端执行器的准确定位。实验结果表明:本方法能够有效定位有轻度变形的蜂窝芯孔,其定位精度可以满足灌注工艺需求。

1 梁馨,谭朝元,罗丽娟,等. 低密度防热材料烧蚀性能研究[J]. 载人航天,2016,22(3):298~301

2 陈华建. 大型球冠蜂窝结构防热层自动灌注机器人系统研究[D]. 北京:北京交通大学,2016

3 马秀萍,郭亚林,张祎. 轻质烧蚀防热材料研究进展[J]. 航天制造技术,2018(1):2~6

4 武海生,郑建虎,徐伟丽,等. 航天器蜂窝夹层结构胶膜热破工艺研究[J].航天制造技术,2015(4):10~13

5 孟浩,程康. 基于SIFT特征点的双目视觉定位[J]. 哈尔滨工程大学学报,2009,30(6):649~652,675

6 李靖,王炜,张茂军. 双目立体视觉和编码结构光相结合的三维重建方法[J]. 计算机应用,2012,32(S2):154~158,161

7 宋忠超. 蜂窝芯类复合材料零件数字化测量方法研究[D]. 成都:西南交通大学,2017

8 李刚. 基于机器视觉的密集复杂物体识别与定位[D]. 哈尔滨:哈尔滨工业大学,2013

9 仲训杲,徐敏,仲训昱,等. 基于多模特征深度学习的机器人抓取判别方法[J]. 自动化学报,2016,42(7):1022~1029

10 林森,殷新勇,唐延东. 双目视觉立体匹配技术研究现状和展望[J]. 科学技术与工程,2017,17(30):135~147

11 Zhang T Y, Suen C Y. A fast parallel algorithm for thinning digital patterns[J]. Communications of the ACM, 1984, 27(3): 236~239

Robot Vision Location Method for Honeycomb Structures

Zhang Jiali1Li Te1Tan Chaoyuan2Liu Haibo1Liu Kuo1Li Lanzhu2Wang Yongqing1

(1. Key Laboratory for Precision and Non-Traditional Machining Technology of Ministry of Education, Dalian University of Technology, Dalian 116024;2. Aerospace Research Institute of Materials & Processing Technology, Beijing 100076)

Aiming at the problem of accurate localization of honeycomb feature in robotic manufacturing of honeycomb sandwich structure in aerospace field, a localization method using binocular vision to guide industrial robots in single hole filling of honeycomb sandwich structure is proposed. Firstly, the binocular image is segmented into target regions, and the three-dimensional depth map is generated by binocular matching calculation. Then, edge detection, dilation, erosion, skeleton extraction and polygon fitting are carried out on the left camera image to obtain the two-dimensional coordinates of the honeycomb corner feature, and then the actual three-dimensional coordinates are calculated according to the two-dimensional positioning results in depth maps. The position and rotation information of honeycomb holes are obtained by thethree-dimensional coordinates. Finally, the positioning experiment of honeycomb structure parts is carried out on the positioning system composed of industrial robot and binocular camera. The experimental results show that the proposed location method can accurately locate honeycomb holes (non-standard hexagon) with certain deformation. The positioning accuracy is less than 2mm, and the positioning accuracy can meet the accuracy requirements of subsequent perfusion operations.

industrial robot;machine vision;robot localization;honeycomb structure

国家自然科学基金(51805071);中央高校基本科研业务费DUT17JC16、DUT18RC(3)073。

张嘉礼(1994),硕士,机械设计制造及其自动化专业;研究方向:机器人控制。

2019-02-25