基于深度网络分级特征图的图像超分辨率重建

2019-03-27张一帆朱松岩周大可

张一帆,杨 欣,朱松岩,周大可

(1.南京航空航天大学 自动化学院,江苏 南京 210016;2. 江苏工程技术学院 纺织服装学院,江苏 南通 226000)

单幅图像的超分辨率重建(SISR)是从单幅的低分辨率图像重建(LR)得到单幅的高分辨率图像(HR).SISR用于各种计算机视觉任务,例如安全和监视成像[1],医学成像[2]和图像生成[3].从LR图像映射到HR图像可以有多种解,因此超分辨率重建(SR)是一个病态的问题.传统方法如基于插值的[4]、基于重建的[5]和基于学习的[6-7]被应用于解决SR问题.近年来,随着深度学习的发展和图像集的丰富,基于深度学习的图像超分辨率重建也显现出了极好的重建效果.尤其的,更深的网络模型有着更大的感受野,可以利用更大空间范围内的低频信息来恢复HR图像中的高频信息,使HR图像中的边缘更加锐利,对于SR任务而言通常使用卷积层加深网络来获取大的感受野.

Dong等[8]提出了基于卷积神经网络(CNN)的超分辨率重建的卷积神经网络(SRCNN)方法,直接学习低分辨率图像块和高分辨率图像块之间的映射.只采用了一个卷积层得到从LR图片到特征图的映射,因此特征提取的能力有限,同时整个网络只有3个卷积层因此非线性映射能力有限.Kim在SRCNN的基础上提出了超分辨率重建深度网络(VDSR)[9]和循环超分辨率神经网络(DRCN)[10].由于VDSR和DRCN的网络过深难以训练,VDSR使用了梯度剪切和跳跃连接,DRCN在映射部分使用循环的技巧避免引入过多的卷积核,同时引入中间损失函数.这些方法,使得训练极深的网络有着一定的可行性.

快速超分辨率重建的卷积神经网络(FSRCNN)[11]、子像素卷积超分辨率网络(ESPCN)[12]通过直接对LR图像进行卷积运算和将上采样过程所用算子分别替换为反卷积层和子像素卷积来提高SRCNN的运算速度.邰[13]提出CNN的特征图感受野大小不同,深度的网络中特征图是不同层次的.Zhang[14]在此基础上提出残差密集连接超分辨率网络(RDN),引入密集连接,充分的应用不同层次的特征图.

深度跳跃连接网络DCSCN[15]整个网络模型分为特征提取网络和重建网络2个部分.特征提取网络的全部CNN都使用跳跃连接至特征提取网络的输出处,将全部特征图按通道联结.重建网络提出了类似于Network in Network结构的并行上采样网络,在计算复杂度和重建效果两方面都取得了一定的效果.本文在DCSCN的网络结构基础上,做出了以下2点创新:①对联结后的多层次特征图进行特征提取,得到融合的特征图,应用于SR任务.②使用子像素卷积神经网络作为上采样算子,进行LR图像到HR图像的重建.

1 本文算法

1.1 模型

本文模型分为2个部分:特征提取网络和重建网络.特征提取网络可以分为层次特征提取部分和融合特征提取部分,层次特征提取部分采用的CNN 数目为可设置参数n,每个CNN的卷积核数目为参数G,融合特征提取部分由一个1×1CNN和一个3×3CNN构成.重建网络由一个上采样算子和3×3CNN构成.如图1所示.

特征提取网络的第1个CNN的数学形式表示为:F1(X)=σ(0,W1*X+B1).层次特征提取部分中第1个卷积层之后的卷积层的输出数学形式为:Fi=σ(Wi*Fi-1+Bi).Fi为第i个卷积层的输出,Wi为第i个卷积层的卷积核,Bi为偏置项,*为卷积运算.σ代表PReLU操作,数学形式为:F(y)=max(0,y)+α(min(0,y)).Fi-1为第i个卷积层的输入,是特征提取网络中第i-1卷积层输出的特征图.特征提取网络在输出特征图之前将网络中全部卷积层输出特征图的联结,表示为:[F1,F2,…,Fn].

1×1CNN跨通道的融合了联结特征图不同通道中的信息,再使用3×3卷积从FDF更进一步提取特征,整个特征提取网络的输出表示为Fout.在LR空间大小特征提取网络提取特征图后,使用ESPCN中的子像素卷积作为上采样算子,表示为Iup=FL(Fout)=PS(Wup*Fout+bup).最后使用3×3的CNN得到最后的HR图像:ISR=σ(W*Iup+b).

1.2 特征提取网络

对于SR任务而言,特征提取是至关重要的,如何提取低层次局部的特征和保留对重建有用的纹理信息一直是研究的重点.

本文算法在特征提取网络中采取跳跃连接的思想,将特征提取网络中CNN的特征图连接至层次特征提取部分的末端并联结,自适应的学习权重来调整不同层次特征图信息的留存.

本文算法中特征提取网络以1个3×3CNN为末端,从降维的特征图提取特征.

1.3 重建网络

本文中我们选用子像素卷积来对LR图像重建达到HR大小.与DCSCN的特征提取网络不同的是,本文算法的特征提取网络输出的特征图已是经过1×1CNN降维的,并经3×3CNN提取特征,因此在本文的重建网络中并行结构是不必要的.我们选择使用1个子像素卷积层重建至Iup.ESPCN中直接将子像素卷积的输出作为重建结果,本文添加1个3×3的卷积层,由于Iup的通道数为HR图像的通道数C,几乎不增加计算复杂度,却使重建网络有更好的非线性映射能力,得到更好的重建结果ISR.

1.4 训练

2 实验结果

为验证模型的有效性,本文以set5数据集为测试图像,在PSNR和视觉效果2个方面与双3次插值、SRCNN、DRCN、VDSR和DCSCN算法进行对比.使用yang91作为训练图片,由于SR任务对训练图片的方向不敏感,本文中对训练集进行水平、垂直方向反转和90度旋转来增强数据集.因此,文章中的全部训练集经预处理后包含1 164张的图片.

2.1 实验参数设置

本文模型中除1×1卷积层之外全部卷积层的卷积核大小设置为3×3.层次特征提取部分卷积层的个数n本文实验中设置为7,卷积核的个数G设置为64.模型中的3×3卷积层使用填0来保持特征图的空间大小不变.

CNN卷积核的初始化全部采用HE[16],偏置项和PReLU的值置零.使用ADAM对网络进行训练,初始学习率设置为0.002.训练过程中当连续5个epochs损失函数没有降低,就将学习率除以2,当学习率低于0.000 02时停止整个训练过程.

2.2 实验结果

峰值信噪比(PSNR)是图像超分辨率重建效果的1个重要性能指标,本文使用PSNR作为重建准确率的性能指标.对于人眼观察到的视觉效果而言,亮度分量更为重要,因此在实验中先对RGB图片进行转换到Ycbcr空间处理.

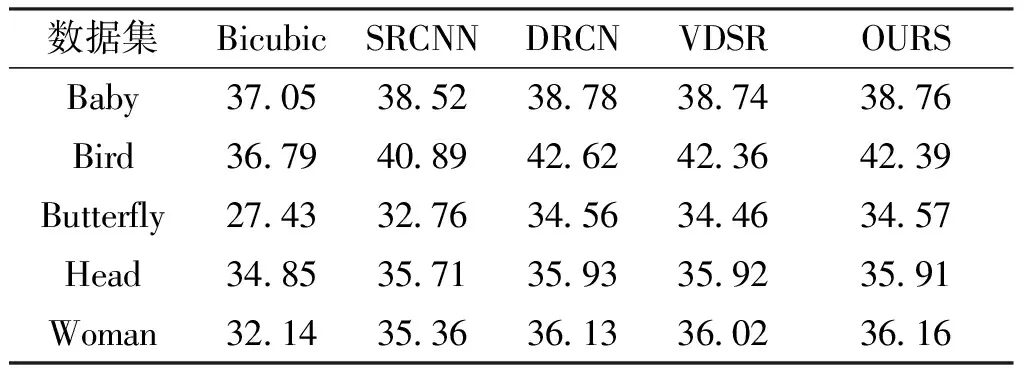

表1表示了尺度为2时算法在set5图片集上的重建结果PSNR,从PSNR来看本文算法对比其他算法有着一定程度的提高.本文算法相比双3次插值算法有较大的提升.从视觉效果与SRCNN、DRCN、VDSR对比纹理细节更为清楚锐利,本文算法得到的高分辨率图在改善上采样后模糊的情况下更好的恢复了局部的细节信息.

表1 本文算法与其他算法set5实验

图2与图3为set5中的Head和Woman图片,由左至右分别为原图、双3次插值、SRCNN、DRCN、VDSR和本文算法,第1行为HR大小的图片,第2行为图片的局部放大.通过对图像局部的放大,可以观察到更多的纹理细节,双3次插值在细节的重建上效果较差.

通过对图2与图3的观察,在如Head中毛发此类的细节纹理复杂的区域本文算法没有因细节信息缺失而影响重建视觉效果,验证了在本文算法中特征提取网络跳跃连接将低层次特征图连接至特征提取部分末端并添加3×3CNN提取特征以保存细节信息的想法有效.

3 结语

提出了一种改进的基于深度学习的超分辨率重建算法,在特征提取方面引入跳跃连接与不同层次特征融合充分利用不同层次的特征图,在重建方法方面改为使用子像素卷积在减少计算量的情况下取得了更好的重建效果.实验结果表明,无论是从客观性能指标PSNR还是主观视觉感受上,本文算法都取得了更好的结果.