基于无人机遥感影像的玉米苗期株数信息提取

2018-11-23刘帅兵杨贵军周成全景海涛冯海宽

刘帅兵,杨贵军,周成全,4,景海涛,冯海宽,4,徐 波,杨 浩

基于无人机遥感影像的玉米苗期株数信息提取

刘帅兵1,2,杨贵军2,3※,周成全2,3,4,景海涛1,冯海宽2,3,4,徐 波2,3,杨 浩3,4

(1.河南理工大学测绘与国土信息工程学院,焦作 454000; 2. 农业部农业遥感机理与定量遥感重点实验室, 北京农业信息技术研究中心,北京 100097; 3. 国家农业信息化工程技术研究中心,北京 100097; 4. 北京市农业物联网工程技术研究中心,北京 100097)

准确、快速地获取玉米苗期株数对于育种早期决策起着至关重要的作用。该文利用2017年6月于北京市小汤山镇采集的无人机影像,首先对比分析RGB、HSV、YCbCr及L*A*B 4种色彩空间,变换优选HSV颜色模型对无人机影像前景(作物)与后景(土壤背景)进行分割,得到分类二值图。然后利用骨架提取算法及多次去毛刺处理等数学形态学流程提取玉米苗形态,得到高精度作物形态骨架,结合影像尺度变换剔除噪声影像,将影像分为多叶、少叶2类,经Harris、Moravec和Fast角点检测识别结果对比,Harris角点检测算法可以较好地提取玉米苗期影像的株数信息。结果表明,少叶类型识别率达到96.3%,多叶类型识别率达到99%,总体识别率为97.8%,将目前传统影像识别精度提高了约3%。同时在多个植株叶片交叉重叠覆盖的情况下,该文的研究方法有良好的适用性。通过无人机影像提取玉米苗期作物准确数目是可行的。该文采用了数学形态学的原理,通过HSV色彩空间变换得到的二值图,从无人机影像中识别提取玉米苗期形态信息,利用影像尺度缩放变换去除噪点,优化骨架识别算法使得识别精度大大提高,最后采用角点检测从无人机影像中直接读取玉米材料小区内的具体数目,该方法节省了人力物力,为田间大面积测定出苗率及最终估产提供了参考。

无人机;作物;遥感;玉米;株数;色彩空间;骨架提取;角点检测

0 引 言

玉米的产量不仅受遗传因素的影响,还受到栽培方式与生长环境等因素综合影响。研究玉米苗期出苗株数对育种早期决策,研究不同品种出苗率,以及在空缺土地及时补种作物,提高产量起着重要作用[1-2]。随着无人机(unmanned aerial vehicles,UAV)技术的迅速发展及其在农业科学中的应用,使得获取田间信息的手段变得多样化,灵活化[3-4]。无人机影像相较于传统卫星影像,可以有效排除云朵的遮挡的影响,在阴天同样可以采集遥感影像数据[5],按照实际需求方便地制定测量方案,改变飞行高度,得到高分辨率的影像数据[6]。此外,无人机遥感作物表型平台可以在短时间内得到高通量遥感影像,节省了时间、人力和经济成本[7-8],为农业科学田间作物信息快速采集分析,提供了有力的支持,前景广阔[9]。

表型组学是研究生物体表现型特征的学科,利用目标群体详细的表型信息,结合生物的基因型为功能基因组学提供坚实的基础,现已经用于复杂的生命系统研究中[10]。今年来,农业科学发展已经对植物密度、作物产量和相关土壤特性等空间数据获取分析研究提出更多需求。虽然现代的农业机械化水平不断地提高,但是传统的生物量、叶面积指数(leaf area index,LAI)和产量等表型参数大多还停留在人工操作阶段,耗时耗力,效率低且精度较低[11-14],因此需要采集高分辨率的影像,对作物表型进行研究[15-16]。高通量作物表型平台作为快速获取表型信息的有效工具,从平台上划分可以分为温室型和田间型。温室型高通量平台配置可见光(visible light,VIS)成像,红外(infrared,IR)成像,近红外(near infrared,NIR)成像和激光3D扫描仪等传感器,获取大量单株表型信息,但是其机动性差、成本高等限制,难以用于植物种植密度大、生长环境多变的大田生产条件。针对温室型高通量平台观测局限性及现代农业对大田观测条件的要求,田间高通量平台发展迅速。其主要分为农用机械平台(农业机械、农用车等)、人工移动平台(手推车)和无人机平台等。同时在识别方法上主要采用模式识别,机器学习等算法,对目标地物进行识别分类,目前大多数研究对作物识别精度停留在95%左右。Burgos-Artizzu等[17]利用拖拉机平台,采用数字视频流的方式,在不同光照、土壤湿度和杂草生长的条件下检测植物,在录制的视频中,其探测系统对杂草的识别率为95%,对作物的识别度为80%。Shi等[18]利用人工移动平台搭载激光雷达,从多个角度扫描秸秆根部,利用改进的算法误差将前期研究24%误差的降低到14%。Shrestha等[19-20]利用数字视频流对玉米植物进行计数,通过椭圆决策表面模型与空间分析的方法确定作物个数,验证表明人工计数与系统株数有良好的相关性,其²达到0.9,对作物的识别误差为5.4%。Gnädinger等[21]利用无人机RGB影像采用阈值分割模式识别方式识别玉米苗,其人工计数与计算机计数相关系数²=0.89,误差约为5%;Jin等[22]首次利用无人机影像,采用支持向量机对包含的图像进行估计,并用粒子群优化算法进行训练优化,识别计算作物密度状况。对比其他高通量表型平台,基于搭载多传感器无人机表型平台进行田间作物表型信息快速解析的技术,效率高、成本低,适合复杂农田环境[23-31]。现今大多数研究还停留在温室[24],或在可控条件下进行试验,难以用于种植密度大、环境因素不可控的大田生产条件。因此,本文针对大田环境数据采集处理困难等缺点,采用田间无人机遥感平台进行数据采集,监测田间田间作物表型信息,有一定的实用价值。

本研究针对玉米苗期分叶较少、重叠度低等特点,借助无人机遥感高通量作物表型平台,利用计算机视觉原理,建立一套基于数学形态学自动化处理流程提取株数信息研究,以期为田间估产、农场管理以及田间育种试验等提供参考。

1 材料与方法

1.1 试验材料与数据源获取设计

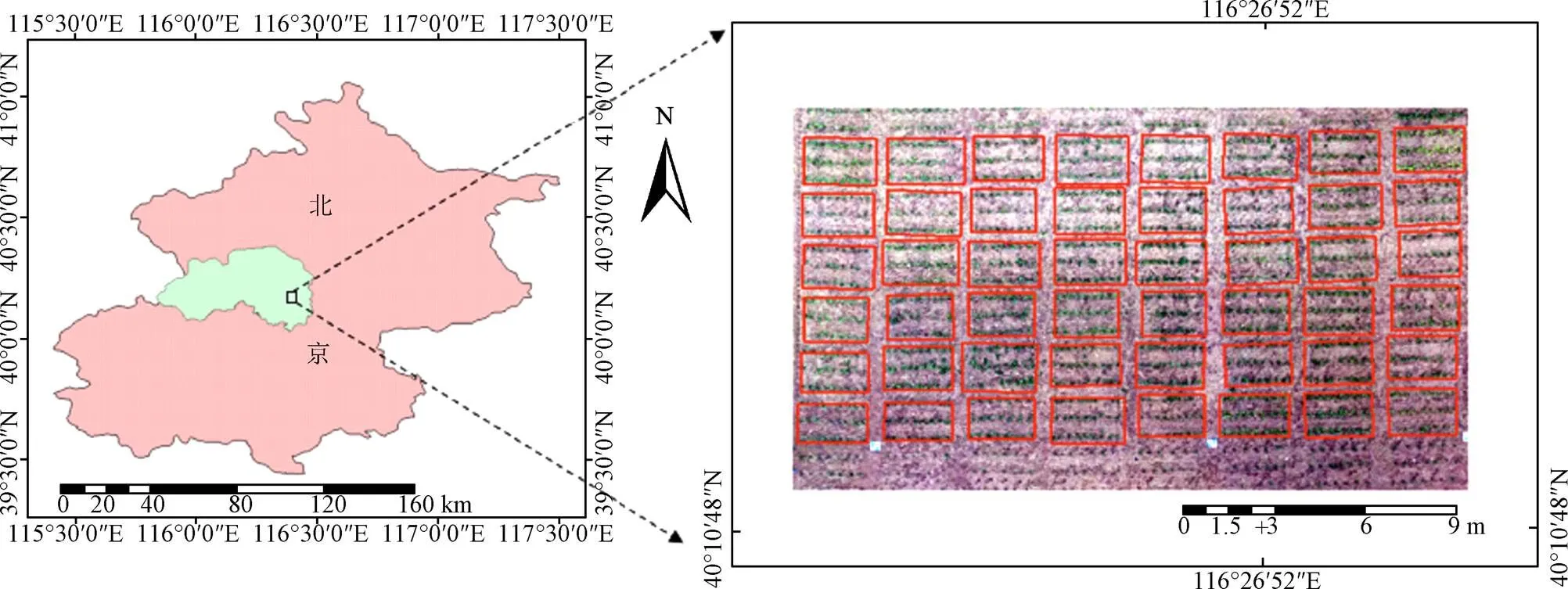

试验田位于北京市昌平区小汤山国家精准农业示范基地。小汤山40°10′31″~40°11′18″N,116°26′10″~116°27′05″E,海拔高度约为50 m,有丰富的地热资源。整个试验区总体约800个玉米材料小区,为了进行育种分析,每个玉米材料的品种都不尽相同。每个材料小区设定为2.5 m×2.4 m,种植3行,每行栽种9到10株,设置25 cm株间距,每行间距0.6 m,排距为0.8 m。部分育种材料小区分布如图1所示。

注:图中红色方框为不同育种材料的小区分布框图。

无人机影像试验数据于2017年6月8日(10:00-14:00)在北京市小汤山国家精准农业示范基地进行采集。在无人机影像获取时,为了避免因云朵遮挡使得部分影像纹理特征信息丢失,选取太阳光辐射强度稳定,天空晴朗无云的天气情况进行采集。飞行高度约为40 m。采用DJ-S1 000八旋翼电动无人机,总质量为4.4 kg,飞行载质量为6 000~11 000 g,电池为LiPo(6S、10 000~20 000 mAh、最小15C),尺寸为460 mm×511 mm× 305 mm,悬停时间为15 min左右。无人机搭载高清数码相机航测影像仪器采用Sony Cyber-shot DSC-QX100镜头,质量为179 g,尺寸62.5 mm×62.5 mm×55.5 mm像素,2 090万像素CMOS传感器,拍摄影像最大分辨率为5 472×3 648,焦距10 mm(定焦拍摄),光学变焦倍数为3.6倍,采集到的数据源为*.TIF格式影像数据。在无人机拍摄影像前,在飞行区域内布置地面黑白布,用于数码影像DN值的标定,降低相机的系统误差。

本研究借助Agisoft PhotoScan软件进行无人机高清数码影像的拼接处理。不同航带之间设置30 cm×30 cm几何参考板,在玉米整个生长周期内保持固定。几何参考板中心点为测量的GPS控制点,为不同航带影像拼接时提供依据,提高影像拼接精度。本研究借助Agisoft PhotoScan软件自带的几何校正功能,基于几何参考板GPS控制点进行影像几何校正,去除无人机姿态变化,大气折射等影像。由于800个玉米育种小区的品种都不相同,采用Adobe Photoshop CC 2017将所有的地块按照育种材料小区规划进行切割,整理出可行的研究区域。

1.2 研究方法

1.2.1 作物识别分割研究

本研究为了检测田间植株数量及空间分布,将获取的RGB图像转换到HSV进行颜色分析,玉米苗期影像识别及形态拾取采用Matlab 2017b软件进行处理。具体处理流程如图2所示。

图2 影像处理流程

为了减少影像噪声及多余骨架分支对研究精度的影响,本研究引入影像尺度变换的原理,将影像进行缩放,突出骨架主轴部分,去除大部分的噪点和骨架分叉。由于玉米品种的不同,同时期各材料小区内玉米苗的长势也不尽相同。因此,根据玉米苗分叶情况,将材料小区分为2类,一类为窄叶-叶小,二类为宽叶-叶大。2种材料小区采用不同的影像缩放系数,分类处理。通过选取40个小区,作为影像尺度研究样本,反复分析样本区域,最终确定影像尺度缩放系数为0.04与0.05。同时另选40个小区作为验证。

构建彩色直方图有助于判断、校正和优化图像的亮度和对比度,评价图像质量,从影像中得到颜色通道信息,以供进一步处理。对于RGB图像,利用各颜色通道的直方图来解释图像的亮度,利用红色、蓝色和绿色通道直方图,采用0~255的取值范围,其中0为黑色,255为白色,直方图的高度演示了图像中以像素表示的颜色值频率。

本研究选取4种色彩空间模型,分别为RGB、HSV、YCbCr及L*A*B模型,通过对比分析,优选HSV色彩空间作为遥感影像处理模型。RGB色彩空间模型通道可以表示为Red、Green、Blue,3个通道相互作用形成了各种颜色,各个分量的数值越小,亮度越低,数值越大,亮度越高。HSV(hue, saturation, value)是根据颜色的直观特性由Smith创建的颜色空间,是颜色模型是RGB模式的一种非线性变换,因为接近人类的色彩感知,因此常用到人脸识别[32]、园艺检测[33]及去除阴影[34]等研究中。其中H表示色相,由物体反射或透射出来的颜色,在色相环上用0~360°来表示,从红色开始逆时针方向计算,红色为0,绿色为120°,蓝色为240°;S表示饱和度(saturation,又称纯度),是指颜色的强度,用色相中彩色成分所占的比例来表示,0为灰色,100%达到完全饱和,取值范围为0~1.0,值越大颜色越饱和;V表示明度(value),表示颜色的明亮程度,反映颜色的相对明暗程度,取值范围为0~255,取值为0时为黑色,255时达到最大亮度为白色。YCbCr色彩模型中,Y代表亮度分量,Cb指蓝色色度分量,Cr指红色色度分量。L*A*B*色彩模型中,L*指亮度,底端为黑色,顶端为白色。+a*代表品红色,-a*代表绿色,+b*代表黄色,-b*代表蓝色。通过不断重复对比分析,确定影像处理阈值设定,将原始影像分为前景(作物)与后景(土壤背景),去除后景,只留下前景影像作为研究区域,将前景影像二值化得到玉米苗期形态二值图。

1.2.2 骨架提取

通过色彩变换将影像变换到HSV色彩模型,根据作物色彩特性,通过阈值分割进行边缘信息提取[35]提取,最终得到作物土壤分离后的二值图。本文采用基于势能平衡的图像骨架提取方法[36],在作物分割二值图的基础上进行骨架提取研究,识别作物形态结构。骨架化的结构是目标图像的重要拓扑描述,在影像处理中,形态信息是非常重要的,可以从视觉上保有物体原有形状即细化结构,便于描述目标形态和抽取特征。本研究利用作物识别二值图进行骨架提取,同时加入多次去除毛刺分叉的方法,得到准确度较高的玉米苗形态图。

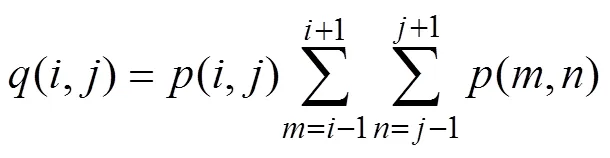

设原始影像中的像素点(,)如图3所示(、为格网坐标数值,、为像素点临近格网坐标数值),当(,)=0时,响应点为黑点;当值为1时,为白色背景点。其中(,)为

若(,)<9,且不为0,则说明该背景像素点周围至少临近了一个黑点,此时该点被标注为边界点(,),所有的边界点(,)的集合为。在求取像素点势能时,只计算以像素点为中心半径为的范围内各边界点对该点的影响。以窗口中间像素为中心,考察其对邻近点的势能矢量对,若两者角为钝角,则可以认为当前点在该对称方向的势能为0。若所有4对对称邻近点在当前点上形成的势能矢量都为0,则该像素点为基本骨架。

1.2.3 角点检测方法

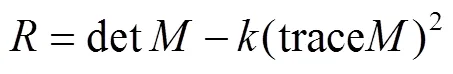

本研究通过角点计数的方式,从材料小区中提取作物数目信息。为了验证本文方法的适用性,采用Harris、Moravec以及Fast 3种经典的角点检测算法,对影像株数信息进行分析提取。从影像分析的角度来定义角点有2种:1)角点可以是2个边缘的角点;2)角点是邻域内具有两个主方向的特征点。基于边缘进行角点提取,由于形态的不规则性导致角点拾取偏差较大,因此采用从作物二值图提取识别的形态骨架进行第二种角点检测。Moravec等[37-38]提出了基于灰度强度的角点检测算法,主要通过检查图像局部边缘、角点及同质区域的灰度值的变化来检测角点。Harris角点检测算法是由Harris和Stephens在Moravec算法的基础上提出的一种特征点提取算法[39]。Fast角点检测算法是由Smith等[40]提出的基于邻域中与中心像素有相同亮度色素点小于阈值表明中心像素点是角点。经过分析论证,发现利用Harris角点检测提取影像缩放后的株数信息精度最高。因此本文利用经典Harris角点检测算法[41]进行检测,将检测出的角点数目作为材料小区内的计算机视觉准确计数数目进行统计,实现了短时间内,低成本测定材料小区作物的准确株数。其基本原理是通过一个识别窗口,当遇到窗口内区域灰度发生较大变化是,就认为遇到了角点。如果这个特定的窗口在图像各个方向上移动时,窗口内图像的灰度没有发生变化,那么窗口内的图像可能就是一条直线的线段。构建数学模型,计算移动窗口的灰度差值对于影像(,),当在点(,)处平移(Δ,Δ),产生灰度变化(,)

式中(,)为窗口函数,(+,+)为平移后的图像灰度,(,)为图像灰度。为了减小计算量,利用泰勒级数进行简化公式最终得到

式中矩阵为梯度协方差矩阵,在实际应用中为了能够应用更好的编程,定义焦点响应函数,通过判定大小来判断像素是否为角点

其中det=12,trace=1+2,1和2为矩阵的特征值,为特征系数。

2 结果与分析

2.1 4种色彩空间对比

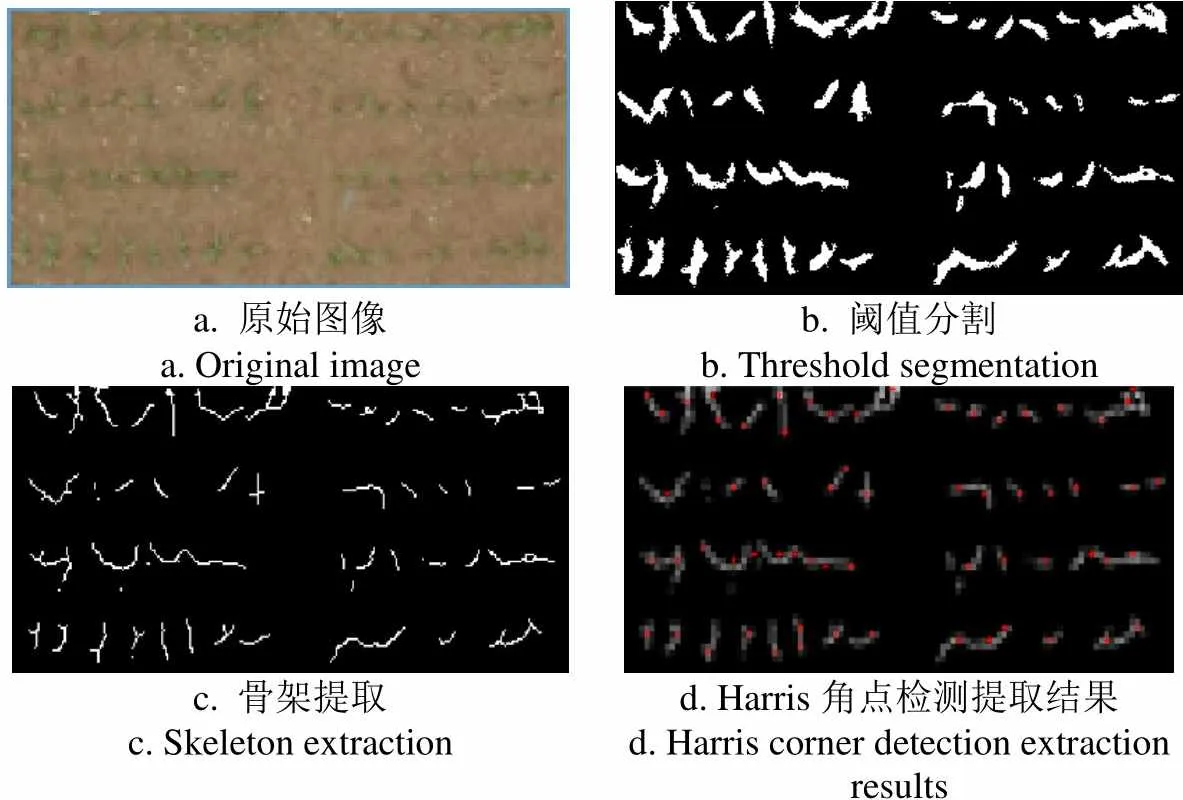

本研究采用了4种色彩空间变换模型对影像进行研究分析,通过设定各个颜色通道特征阈值范围,将影像前景与后景分离,得到材料小区内植株作物阈值分割图。4种色彩空间变换模型对比图如图3所示。

a. 原始图像a. Original imageb. 阈值分割b. Threshold segmentation c. 骨架提取c. Skeleton extractiond. Harris角点检测提取结果d. Harris corner detection extraction results

根据数学形态学原理,经过一步步处理,最终得到Harris角点检测结果如图3d所示。本研究尝试过腐蚀膨胀的算法对阈值影像进行处理,但仍未得到平滑的边缘,因此采用原始阈值分割图像进行后续研究处理。参照刘涛等[42],麦穗识别方式,最终将二值图骨架的Harris角点个数作为田间玉米株数。4种色彩模型阈值设置范围及处理过后影像特征结果如表1所示。

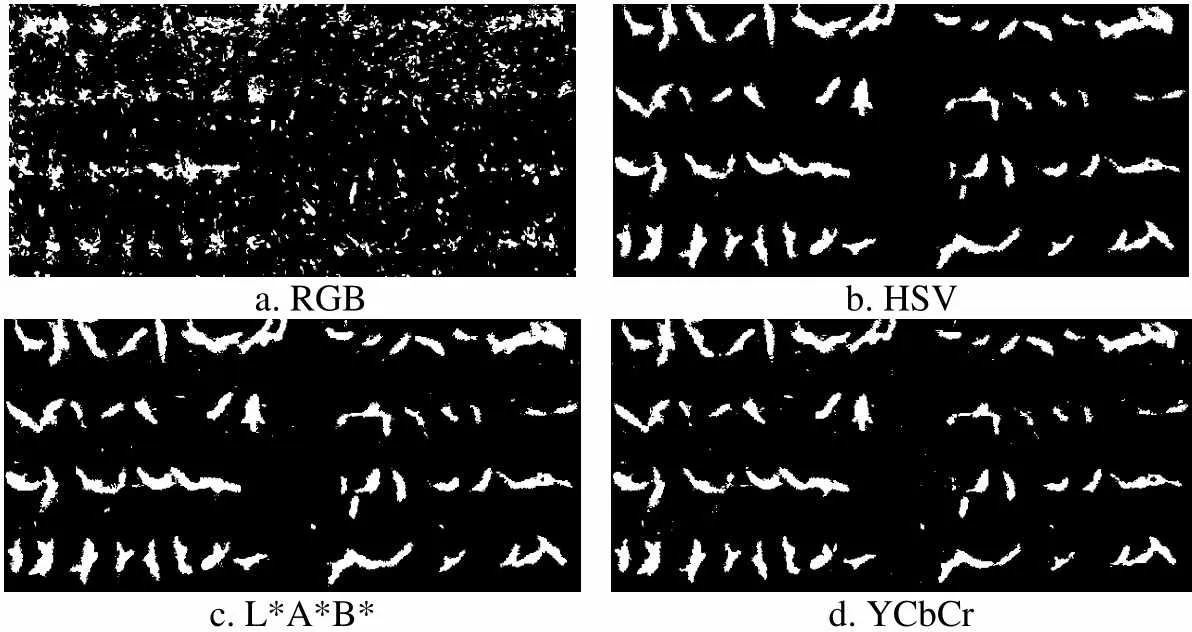

经表1所表述的阈值,可以将玉米植株与土壤背景完全分离,并且同时进行二值化,得到4种玉米苗形态二值图。但是,由于各彩色通道的特性不同,因此影像处理出的结果有明显差异。横向对比4种色彩模型分析结果,其中采用HSV色彩变换模型得到的玉米形态像元数最高为156 591个,同时产生的噪点(独立点块)数最少,为133个。因此说明,在4种色彩空间变换模型中,HSV处理的效果最好,噪点最少,精度最高。材料小区处理过后4种色彩空间处理过后的影像如图4所示。

表1 色彩空间阈值范围与信息统计

Table 1 Threshold range and information statistics of color space

统计信息statistical informationRGB模型RGB modelHSV模型HSV modelL*A*B模型L*A*B modelYCbCr模型YCbCr model 通道1 Channel 1最大值Max1660.12166.905157 最小值Min1220.05237.64098 通道2 Channel 2最大值Max1340.6089.930127 最小值Min1070.0450.471108 通道3 Channel 3最大值Max1120.94827.589146 最小值Min630.33715.409137 玉米形态像元数Maize morphological pixels148 171156 591179 057149 252 独立点块Independent point block1113133206183

a. RGBb. HSV c. L*A*B*d. YCbCr

图4 4种色彩空间变换模型阈值分割结果

Fig.4 Threshold segmentation results of 4 color space transformation models

从图4中可以明显看到,HSV相较于其他3种色彩空间处理结果,在保持较好形态的情况下,噪声点块最少,尤其是小石头等田间杂物产生的大块图斑,在HSV阈值分割结果中可以准确的过滤掉,同时植株边缘提取结果更圆滑,凸起及毛刺较少。因此,本研究采用HSV色彩空间模型进行图像处理。

2.2 样本小区统计结果

由于本研究采用样本按照品种进行划分分析,因此为了验证方法可行性,将作物小区按照1/2小区、2/3小区、1个小区、2个小区和4个小区进行分别计数,以验证方法的可行性及精度。当材料小区分割面积不同时,各样本区域真实植株数目与计算机自动识别技术对比,各小区具有较高的识别精度。计算机识别株数与人工目视株数十分的接近。将2组数据进行线性回归分析,经检验其相关指数2约为0.99,证明2组数据拟合效果较高,具有较强的相关性,证明了本文的方法可靠。

将试验田按照玉米苗叶子形态大小进行分类,利用Harris角点检测识别提取40个样本小区株数信息如图5所示。图中红色框中区域代表一类材料小区(叶窄、叶少),蓝色框中区域代表二类材料小区(叶宽、叶多),将影像尺度缩放系数分别设定在0.05和0.04,得到材料小区数目分类计数结果。

图5 材料小区精度统计

由图5可知,绝大部分小区(32个)的误差在3个以内,各个材料小区内的平均株数约为24株,平均误差为2.25株,精度可靠。其中有7个小区计算机识别计数值与材料小区内实际植株数目完全相同,达到100%。剩下的由于材料小区植株基数较小,因此很小的误差所带来的精度影响也是比较大的。但是绝大多数小区准确率达到80%以上(小区总样本量较少,因此浮动较大),实现了从材料小区中通过计算机计数高精度识别作物准确株数的目标。

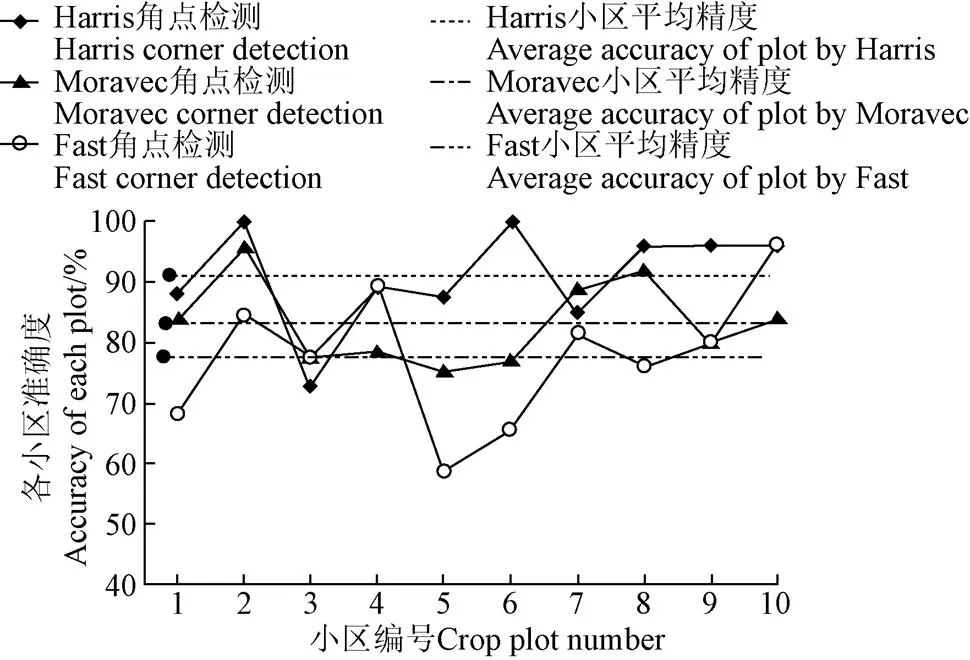

本文采用3种不同的角点检测方法对作物小区作物株数进行识别研究,在图6中可以得到,Harris角点检测的精度优于其他2种角点检测方法。从作为验证的10个样本小区中可以看出,Harris角点检测材料小区识别精度曲线要明显高于其他2种方法识别精度,且小区平均精度也明显更准确。经Harris角点检测得到的材料小区株数信息平均精度为91.07%,Moravec检测平均精度为83.28%,Fast角点检测得到的结果为77.64%。从结果上看Harris对整体材料小区识别精度最高,其对折线转点识别要更为准确。

图6 样本小区作物株数信息识别精度

2.3 精度分析

本研究从试验区中摘选常见的物种玉米苗期形态进行分类分析,表2为流程处理结果。

表2 流程处理结果

由表2可知,玉米苗期田间作物常见形态有5种,分别是双叶单株、四叶单株、五叶单株、双株重叠覆盖、3株重叠覆盖。根据本文的处理流程,表2介绍了从原始RGB影像到去土壤背景,二值化,骨架提取,角点检测,一步步流程处理中,单株形态变化。

从影像准确度上来说,绝大部分可以从单株上进行检测,在出现有几株作物重叠覆盖的时候,本方法依然有良好的识别适应性。计算材料小区真实作物数目时候,利用正射影像的特性,从玉米苗开叶之后,茎中心出现的黑色纹理进行识别,得到真实值。从图中可以看出,在单株时,虽然可以检测出角点,但是由于影像尺度变换使得纹理改变,导致检测出的角点所代表的中心点未能与目视中心重合。

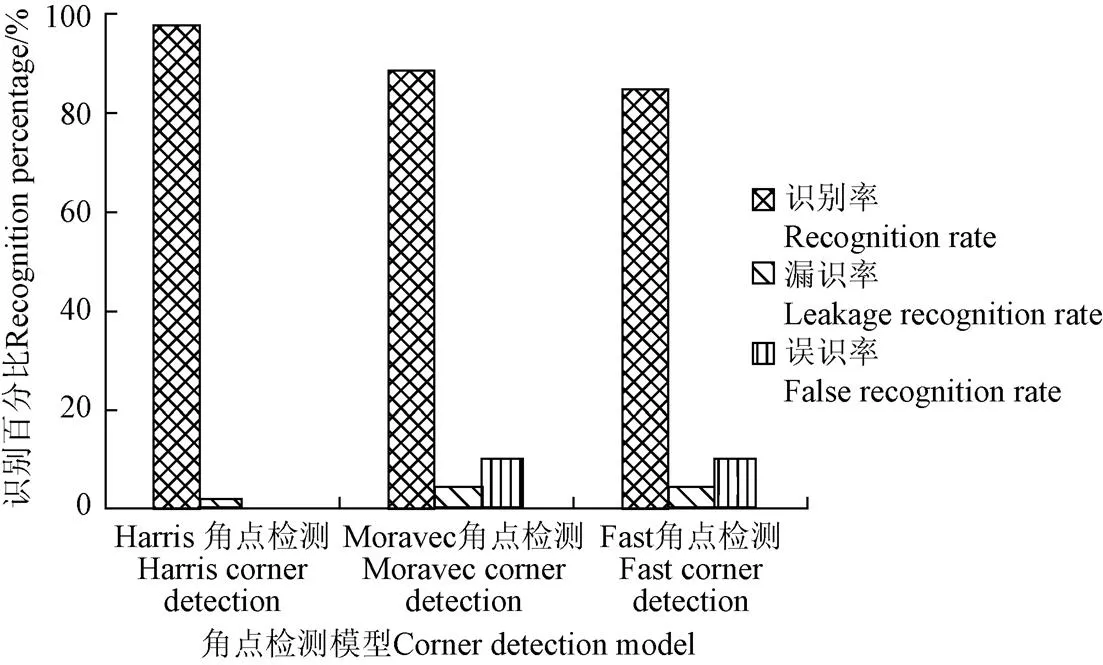

图7为不同角点检测方法对结果准确性的影响。由图7可知,Moravec角点检测对边缘进行检测而Fast角点检测主要依据识别窗口灰度差值进行识别,因此这两种角点检测对于骨架折线图没有良好的适用性,精度较低。本文得到的影像识别结果,从误差的角度上分为误识率和漏识率两部分。将识别提取出的玉米苗位置与无人机原始影像位置进行目视匹配,统计各小区错分入(误识率)与错分出(漏识率)的误差情况。同时考虑到小区域向大区域汇总时误差相互抵消问题,在验证本文方法可行性时,在不同影像范围下进行统计。其中Harris角点检测的漏识率为1.9%,误识率为0.3%;Moravec角点检测漏识率为4.4%,错识率为7.9%;Fast角点检测漏识率为4.9%,误识率为9.9%。从统计结果上看,Harris角点检测在漏识率与误识率上面误差较小,而Moravec与Fast角点检测算法的误差较大。在总体的识别率上,Harris角点检测精度达到了97.8%,平均每个育种材料小区的处理时间为0.646 s,Moravec角点检测识别率为87.4%,处理时间为0.984 9 s,而Fast角点检测识别精度为85.8%,时间效率为0.3121 s。Fast角点检测虽然时间效率最高,但精度最低。综上所述,Harris角点检测对于田间玉米苗期株数识别精度最高,也最为适用,因此最终采用Harris角点检测对育种材料小区进行分析。

图7 不同角点检测方法对结果准确性的影响

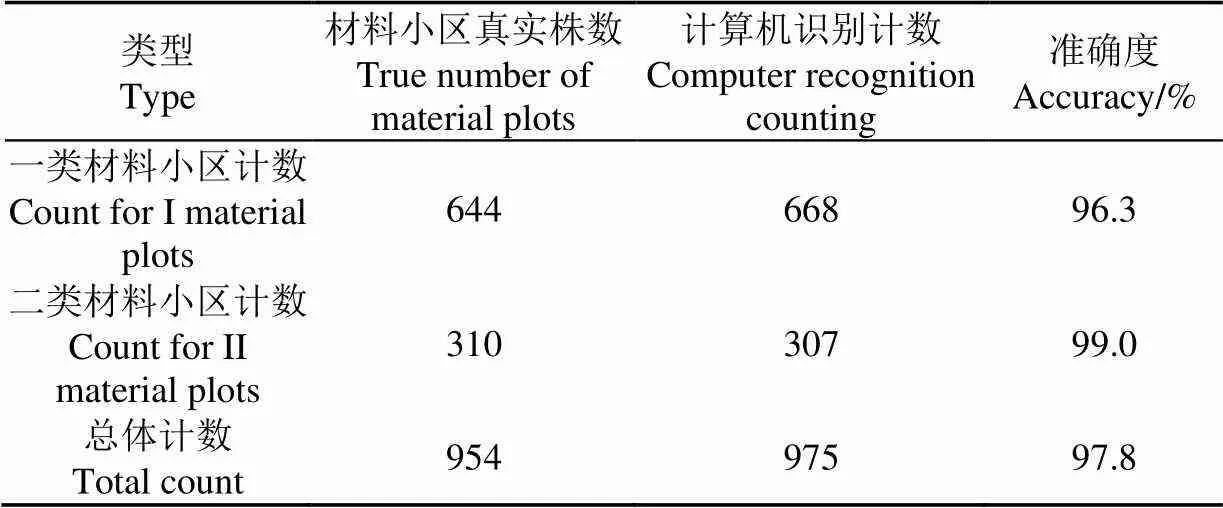

本试验根据作物生长情况不同,采用Harris角点检测算法,将40个材料小区作为样本反复试验分析,确定2类影像尺度缩放比例系数,最终确定准确值。同时另选40个作物小区作为验证集,同样将材料小区分为2类,一类材料小区有26个,实际作物株数为644株,计算机自动识别提取作物数目为668株,准确度为96.3%。二类材料小区有14个,材料小区作物株数为310株,计算机识别作物为307株,准确度为99%。40个材料小区总体实际株数为954株,计算机识别作物为975株,总体准确度可达到97.8%,误差控制在5%以下,精度可靠。统计结果如表3所示。

表3 材料小区与总体计数精度统计表

经精度验证,对比Shrestha等的方法,采用影像尺度缩放的方式,将整体精度上提升了约3%,尤其在处理多叶单株的情况时,精度可以达到99%(总株数为310)。在苗期叶片重叠覆盖的情况下,本文的研究方法有良好的适用性,依然可以得到高准确度的玉米作物株数。在试验设计上,相较于温室单株盆栽研究及其他无人机试验的飞行高度于3、5和7 m等情况,本文无人机的飞行高度为40 m,对于大面积影像玉米信息快速准确提取有明显优势。同时,根据不同地点,不同气候影响等情况的出现,结合田间实际玉米苗情,可以灵活的进行分析处理,得到高精度的玉米株数识别统计结果。

从整体上看,根据出叶状况,有2叶到6叶不等,因此从物候的角度来说测区大部分玉米处于出苗期。本研究只针对玉米出苗期作为研究对象,分析苗期出苗情况,可以粗略测定各个材料品种之间不同的出苗率,对育种品种的甄选提供依据。同时在玉米出苗期时,作物植株结构简单,相连的玉米苗之间有较小的重叠度,避免了大面积叶片粘连,图像无法分离的状况。按照试验方案设计要求,不同玉米育种材料在相同的水肥条件下自然生长。但在大田种植的条件下,无法精准控制材料小区长势情况,因此存在明显的长势差异。按照玉米苗期出苗长势情况,无人机数码影像数据处理时按照相同影像缩放系数提取株数信息,但是处理出的结果不理想,识别率仅有90.6%。因此需要按照不同长势差异将玉米育种材料人为划分为双叶型与多叶型进行分类处理,以提高识别率。本文方法主要以玉米苗期的骨架形态信息作为切入点进行提取研究,当玉米过了苗期进入其他生育期时,叶片开始变大,重叠现象加剧,很难从影像上进行单株骨架提取,因此本研究只适用于玉米苗期图像处理,对于玉米其他生育期未能有后续的研究。

本试验采用800个不同的玉米品种,在相同条件下,长势有明显差异。同时测区地面中间部分地势低,相较于两边地面土质潮湿,中间部分的长势较好,分叶明显叶片较大,其他区域的玉米长势较弱,因此产生了一部分材料不均匀的误差。考虑其他的误差来源,一是当无人机按照预定设计路线飞行时,在有风情况下,摄影相机会有轻微晃动,导致局部影像纹理特征丢失,影像出现了模糊的情况。其次,试验田是在较理想的状态下进行识别的,田间杂草较少,但同时也会导致计数误差的存在。此外,利用Harris角点检测识别时,会有单株出现两个角点的情况出现,产生计数误差。在普通田地进行处理时,可以在前景影像与后景影像分离时,考虑使用杂草识别的方式,将土壤背景与杂草一块进行剔除,减少对影像识别的干扰。

本文的研究方法是基于像元的方式进行影像信息提取,尝试基于面向对象的方式进行作物独立块数的识别提取。但出现的问题是,影像产生了很多噪点斑块,同时对于长势较弱的植株,特征信息不明显,容易被识别为噪声斑块,导致在进行滤波处理时被错误删除,使得到的株数信息不准确。

3 结 论

本研究采用了数学形态学的原理,通过阈值分割得到的二值图,从RGB影像中直接分离出玉米苗期形态信息,利用影像尺度缩放变换,去除材料小区中大部分的噪声点及骨架分叉,使得识别精度大大提高,结果证明:

1)在不同面积材料小区中,本研究计算机自动识别株数与人工目视识别株数的相关系数2可以达到0.99,证明本研究在不同影像分辨率下的适用性。对比三种角点检测的方法,得到Harris角点检测精度最高,效果最好。同时在有少量重叠度的情况下,本文方法有良好适应性。

2)从无人机影像中获取玉米材料小区内作物的准确数目,将材料小区分为2类,各个材料小区内的平均株数约为24株,平均误差为2.25株,一类材料小区识别率为96.3%,二类识别率为99%,总体识别率为97.8%,将目前传统影像识别精度提高了约3%,精度可靠。

从无人机影像中直接读取玉米材料小区内的具体数目,节省了人力物力,为田间大面积测定出苗率及最终估产提供了有力的支持.

[1] Cao Q, He M R, Dai X L, et al. Effects of interaction between densityand nitrogen on grain yield and nitrogen use efficiency of winter wheat[J]. Plant Nutrition and FertilizerScience, 2011, 17: 815-822.

[2] Liu P, Guo W S, Xu Y, et al. Effect of planting density ongrain yield and quality of weak-gluten and medium-gluten wheat[J]. Journal of Triticeae Crops, 2006, 26: 117-121.

[3] Floreano D, Wood R J. Science, technology and the future of small autonomous drones[J]. Nature, 2015, 521(7553): 460-466.

[4] Sankaran S, Khot L R, Espinoza C Z, et al. Low-altitude, high-resolution aerial imaging systems for row and field crop phenotyping: A review[J]. European Journal of Agronomy, 2015, 70: 112-123.

[5] Zhang C, Kovacs J M. The application of small unmanned aerial systems for precision agriculture: A review[J]. Precision Agriculture, 2012, 13(6): 693-712.

[6] Peña J M, Torres-Sánchez J, de Castro A I, et al. Weed mapping in early-season maize fields using object-based analysis of unmanned aerial vehicle (UAV) images[J]. Plos One, 2013, 8(10): e77151.

[7] Tripicchio P, Satler M, Dabisias G, et al. Towards smart farming and sustainable agriculture with drones[C]// International Conference on Intelligent Environments, IEEE, 2015: 140-143.

[8] Rez-Ortiz M, Jos A, Manuel, et al. Selecting patterns and features for between- and within- crop-row weed mapping using UAV-imagery[J]. Expert Systems with Applications An International Journal, 2016, 47(C): 85-94.

[9] 刘建刚,赵春江,杨贵军,等. 无人机遥感解析田间作物表型信息研究进展[J]. 农业工程学报,2016,32(24):98-106.

Liu Jiangang, Zhao Chunping, Yang Guijun, et al. Review of field-based phenotyping by unmanned aerial vehicle remote sensing platform[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(24): 98-106. (in Chinese with English abstract)

[10] 杨有新,杨泽茂,吴才军,等. 植物表型组学研究进展[J]. 江西农业大学学报,2015,37(6):1105-1112.

Yang Youxin, Yang Zemao, Wu Caijun, et al. Advances in plant phenomics research[J]. Acta Agriculture Universitatis Jiangxiensis, 2015, 37(6): 1105-1112. (in Chinese with English abstract)

[11] Geesing D, Diacono M, Schmidhalter U. Site-specific effects of variable water supply and nitrogen fertilisation on winter wheat[J]. Journal of Plant Nutrition and Soil Science/ Zeitschrift fuer Pflanzenernaehrung und Bodenkunde, 2014, 177(4): 509-523.

[12] Fu Y, Yang G, Wang J, et al. Winter wheat biomass estimation based on spectral indices, band depth analysis and partial least squares regression using hyperspectral measurements[J]. Computers & Electronics in Agriculture, 2014, 100(2): 51-59.

[13] Pajares G. Overview and current status of remote sensing applications based on unmanned aerial vehicles (UAVs)[J]. Photogrammetric Engineering & Remote Sensing, 2015, 81(4): 281-329.

[14] Grosskinsky D K, Svensgaard J, Christensen S, et al. Plant phenomics and the need for physiological phenotyping across scales to narrow the genotype-to-phenotype knowledge gap[J]. Journal of Experimental Botany, 2015, 66(18): 5429-5440.

[15] Barabaschi D, Tondelli A, Desiderio F, et al. Next generation breeding[J]. Plant Science an International Journal of Experimental Plant Biology, 2016, 242: 3-13.

[16] Cobb J N, Declerck G, Greenberg A, et al. Next-generation phenotyping: requirements and strategies for enhancing our understanding of genotype–phenotype relationships and its relevance to crop improvement[J]. Theoretical & Applied Genetics, 2013, 126(4): 867-887.

[17] Burgos-Artizzu X P, Ribeiro A, Guijarro M, et al. Original paper: Real-time image processing for crop/weed discrimination in maize fields[J]. Computers & Electronics in Agriculture, 2011, 75(2): 337-346.

[18] Shi Y, Wang N, Taylor R K, et al. Improvement of a ground-LiDAR-based corn plant population and spacing measurement system[J]. Computers & Electronics in Agriculture, 2015, 112(C): 92-101.

[19] Shrestha D S, Steward B L. Automatic corn plant population measurement using machine vision[J]. Transactions of the Asae American Society of Agricultural Engineers, 2003, 46(2): 559-565.

[20] Shrestha D S, Steward B L. Shape and size analysis of corn plant canopies for plant population and spacing sensing[J]. Applied Engineering in Agriculture, 2005, 21(2): 295-306.

[21] Gnädinger F, Schmidhalter U. Digital counts of maize plants by unmanned aerial vehicles (UAVs)[J]. Remote Sensing, 2017, 9(6): 544.

[22] Jin X, Liu S, Baret F, et al. Estimates of plant density of wheat crops at emergence from very low altitude UAV imagery[J]. Remote Sensing of Environment, 2017, 198(9):105-114.

[23] Gitelson A A, Viña A, Arkebauer T J, et al. Remote estimation of leaf area index and green leaf biomass in maize canopies[J]. Geophysical Research Letters, 2003, 30(30): 335-343.

[24] Nieuwenhuizen A T, Tang L, Hofstee J W, et al. Colour based detection of volunteer potatoes as weeds in sugar beet fields using machine vision[J]. Precision Agriculture, 2007, 8(6): 267-278.

[25] Meyer G E, Neto J C. Verification of color vegetation indices for automated crop imaging applications[J]. Computers & Electronics in Agriculture, 2008, 63(2): 282-293.

[26] Khojastehnazhand M, Omid M, Tabatabaeefar A. Determination of orange volume and surface area using image processing technique[J]. International Agrophysics, 2009, 23(3): 237-242.

[27] Montes J M, Technow F, Dhillon B S, et al. High-throughput non-destructive biomass determination during early plant development in maize under field conditions[J]. Field Crops Research, 2011, 121(2): 268-273.

[28] Araus J L, Cairns J E. Field high-throughput phenotyping: The new crop breeding frontier[J]. Trends in Plant Science, 2014, 19(1): 52-61.

[29] Kazmi W, Garcia-Ruiz F J, Nielsen J, et al. Detecting creeping thistle in sugar beet fields using vegetation indices[J]. Computers & Electronics in Agriculture, 2015, 112: 10-19.

[30] 赵春江. 农业遥感研究与应用进展[J]. 农业机械学报,2014,45(12):277-293.

Zhao Chunjiang. The development of agricultural remote sensing research and application[J]. Journal of Agricultural Machinery, 2014, 45(12): 277-293. (in Chinese with English abstract)

[31] Brichet N, Fournier C, Turc O, et al. A robot-assisted imaging pipeline for tracking the growths of maize ear and silks in a high-throughput phenotyping platform[J]. Plant Methods, 2017, 13(1): 96-108.

[32] Shaik K B, Ganesan P, Kalist V, et al. Comparative study of skin color detection and segmentation in hsv and YCbCr color space[J]. Procedia Computer Science, 2015, 57: 41-48.

[33] Lien J J, Kanade T, Cohn J F, et al. Detection, tracking, and classification of action units in facial expression[J]. Robotics & Autonomous Systems, 2000, 31(3):131-146.

[34] Huang W, Kim K Y, Yang Y, et al. Automatic shadow removal by illuminance in HSV color space[J]. Comput. Sci. Inf. Technol, 2015, 3(3): 70-75.

[35] 张远,蒋浩,朱登明,等. 基于骨架匹配的人体轮廓线提取[J]. 系统仿真学报,2017(11):2774-2781.

Zhang Yuan, Jiang Hao, Zhu Dengming, et al. Human contour extraction based on skeleton matching[J]. Journal of System Simulation, 2017(11): 2774-2781. (in Chinese with English abstract)

[36] 宋靓. 浅述骨架提取算法及举例[J]. 中国高新技术企业,2011(13):29-31.

Song Liang. Brief introduction of Skeleton extraction algorithm and example[J]. China High Technology Enterprises, 2011(13): 29-31. (in Chinese with English abstract)

[37] Moravec H P. Towards automatic visual obstacle avoidance[C]// International Joint Conference on Artificial Intelligence. Morgan Kaufmann Publishers Inc. 1977:584.

[38] Moravec H P. Visual mapping by a robot rover[C]// International Joint Conference on Artificial Intelligence. Morgan Kaufmann Publishers Inc. 1979:598-600.

[39] 牛磊磊. 小麦条锈菌孢子的在线图像获取与计数方法研究[D]. 杨凌:西北农林科技大学,2017.

Niu Leilei. Online Image Acquisition and Counting of Wheat Stripe Rust Spores[D].Yangling: Northwest A&F University, 2017. (in Chinese with English abstract)

[40] Smith S M, Brady J M. SUSAN—A new approach to low level image processing[J]. International Journal of Computer Vision, 1997, 23(1):45-78.

[41] 梁艳. 角点检测理论及算法研究[D]. 武汉:华中科技大学,2010.

Liang Yan. Research on Primary Corner Detection Algorithm[D]. Wuhan: Huazhong University of Science and Technology, 2010. (in Chinese with English abstract)

[42] 刘涛,孙成明,王力坚,等. 基于图像处理技术的大田麦穗计数[J]. 农业机械学报,2014,45(2):282-290.

Liu Tao, Sun Chengming, Wang Lijian, et al. In-field wheatear counting based on image processing technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(2): 282-290. (in Chinese with English abstract)

Extraction of maize seedling number information based on UAV imagery

Liu Shuaibing1,2, Yang Guijun2,3※, Zhou Chengquan2,3,4, Jing Haitao1, Feng Haikuan2,3,4, Xu Bo2,3, Yang Hao3,4

(1.454000,; 2.,100097,; 3.100097,; 4.100097,)

Accurate and rapid acquisition of maize seedling number plays an important role in early decision-making of breeding. The aim of this work was to use the UAV images collected in Xiaotang mountain, Beijing in June 2017, to recognize and extract the number of maize at seedling stage by establishing a set of digital morphological process. The UAV was flying at a height of about 40 m, and the image data were collected under clear and wind-free conditions. Four color space transformation models (RGB, HSV, YCbCr and L*A*B) were compared and analyzed. The model which showed minimum noise and maintains more pixels was selected to divide image. The foreground (crop) and background (soil) were separated to obtain binary graph. Based on the image scale transformation principle, the images were divided into two types according to the number of leaves. According to the experimental design requirements, different maize breeding materials were growing naturally under the same water and fertilizer conditions. However, it was difficult to control the growth situation of the material area accurately, so there was obvious growth difference between different varieties. When the UAV digital image data were processed, the number of plants was extracted at the same scale, but the result was not ideal, and the recognition rate was only 90.6%. In order to improve the recognition rate, maize breeding materials were classified into two leaf type and multi leaf type according to different growth potential. The skeleton extraction algorithm and multiple deburring processes were utilized to extract crop shape skeleton with high accuracy. Finally, the corner detection results of Harris, Moravec and Fast were compared regarding recognition rate, the leakage recognition rate, the error recognition rate and the operation efficiency. Finally, the Harris corner detection algorithm was used to better extract the number of the maize seedling. Considering that there would be some overlapping leaves in the images, this study showed a comparison between computer identification and actual plant growth. The results showed that this method was still reliable under leaf overlapping conditions. At the same time, the possible errors were analyzed: 1) the influence of the wind during UAV flight; 2) the impact of weeds in the field; 3) the wrongful identification of a single plant as two, but the overall accuracy was still reliable. Through accuracy verification, the leaf recognition rate reached 96.3%, the multi-leaf recognition rate reached 99%, and the overall recognition rate was 97.8%, which proved that it was feasible and reliable to extract corn seedlings from UAV images. This research adopted the principle of mathematical morphology, obtained the binary image by HSV color space transform, recognized and extracted the maize seedling morphological information of UAV images, removed most of the material in the cell skeleton recognition accuracy optimization noise by using image zoom scale transform. By using image zoom scale transform, the recognition accuracy was greatly improved, directly distinguished the specific number of maize materials within the UAV image. This method saved the manpower and material resources and provided strong support for the field of large area determination of germination rate and final yield.

unmanned aerial vehicle; crops; remote sensing; maize; plant number; color space; skeleton extraction; corner detection

刘帅兵,杨贵军,周成全,景海涛,冯海宽,徐 波,杨 浩. 基于无人机遥感影像的玉米苗期株数信息提取[J]. 农业工程学报,2018,34(22):69-77. doi:10.11975/j.issn.1002-6819.2018.22.009 http://www.tcsae.org

Liu Shuaibing, Yang Guijun, Zhou Chengquan, Jing Haitao, Feng Haikuan, Xu Bo, Yang Hao. Extraction of maize seedling number information based on UAV imagery[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(22): 69-77. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.22.009 http://www.tcsae.org

2018-05-07

2018-09-05

国家重点研发计划(2016YFD0300602);国家自然科学基金(61661136003,41471351);中国测绘科学研究院基本科研业务费(7771814)

刘帅兵,助理研究员,主要从事数字图像处理。 Email:463543329@qq.com

杨贵军,研究员,主要从事定量遥感机理及应用研究。Email:yanggj@nercita.org.cn

10.11975/j.issn.1002-6819.2018.22.009

TP75

A

1002-6819(2018)-22-0069-09